Natureの論文「Deep learning」の日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Natureの論文「Deep learning」の日本語訳を紹介します.

Deep learningを提案したトロント大学のジェフリー・ヒントン教授の論文ですので,是非読みましょう!

引用数62,000以上のスター論文です!

※図表を含む論文の著作権はNatureに帰属します.

論文中に章番号はないですが,わかりやすくするためにDeep learningの目次は以下のように設定しました.

- Abstract

- 1章:Introduction(論文中に章のタイトルはないですが,わかりやすくするために追加)

- 2章:Supervised learning

- 3章:Backpropagation to train multilayer architectures

- 4章:Convolutional neural networks

- 5章:Image understanding with deep convolutional networks

- 6章:Distributed representations and language processing

- 7章:Recurrent neural networks

- 8章:The future of deep learning

- References

- Acknowledgements

- Author Information

Deep learningを解説しつつ,私の考えも語ります.

Deep learningの概要と私の日本語訳は以下になります.

Deep learning allows computational models that are composed of multiple processing layers to learn representations of data with multiple levels of abstraction.

ディープラーニングは,複数の処理層で構成される計算モデルが,複数の抽象度を持つデータの表現を学習することを可能にする.These methods have dramatically improved the state-of-the-art in speech recognition, visual object recognition, object detection and many other domains such as drug discovery and genomics.

これらの手法は,音声認識,視覚的物体認識,物体検出のほか,創薬やゲノム解析など多くの領域で最先端技術を劇的に向上させている.Deep learning discovers intricate structure in large data sets by using the backpropagation algorithm to indicate how a machine should change its internal parameters that are used to compute the representation in each layer from the representation in the previous layer.

ディープラーニングは,バックプロパゲーションアルゴリズムを用いて,前の層の表現から各層の表現を計算するために使用される内部パラメータを機械がどのように変更すべきかを示すことにより,大規模データセットの複雑な構造を発見する.Deep convolutional nets have brought about breakthroughs in processing images, video, speech and audio, whereas recurrent nets have shone light on sequential data such as text and speech.

Deep Convolutional Netsは,画像,映像,音声,スピーチなどの処理に画期的な進歩をもたらし,Recurrent Netsは,テキストやスピーチなどのシーケンシャルデータに光を当てている.https://www.cs.toronto.edu/~hinton/absps/NatureDeepReview.pdf

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Acknowledgements」(謝辞)とAuthor Information(著者情報)は省略していること

- 本文中に登場する表記「[1–4]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Deep learningの本文を読みすすめましょう!

目次

1章:Introduction(はじめに)

機械学習技術は,ウェブ検索,ソーシャルネットワーク上のコンテンツフィルタリング,Eコマースサイトのレコメンデーションなど,現代社会のさまざまな場面で力を発揮し,カメラやスマートフォンなどのコンシューマ製品への搭載も進んでいる.

機械学習システムは,画像内のオブジェクトの識別,音声のテキスト化,ニュースアイテムや投稿,商品とユーザの興味とのマッチング,検索結果の関連性の選択などに使用されている.

これらのアプリケーションでは,ディープラーニングと呼ばれる一群の技術がますます活用されている.

従来の機械学習技術では,自然データを生のまま処理する能力に限界があった.

何十年もの間,パターン認識システムや機械学習システムを構築するには,生データ(画像のピクセル値など)を適切な内部表現または特徴ベクトルに変換する特徴抽出器を設計し,そこから学習サブシステム(しばしば分類器)が入力のパターンを検出または分類できるように,注意深いエンジニアリングとかなりの領域専門知識を必要としていた.

表現学習とは,機械に生データを与え,検出や分類に必要な表現を自動的に発見することを可能にする一連の手法である.

ディープラーニングは,複数のレベルの表現を持つ表現学習法であり,あるレベル(生の入力から始まる)の表現を,より高い,少し抽象的なレベルの表現に変換する単純だが非線形なモジュールをそれぞれ構成することによって得られる.

このような変換を十分に組み合わせることで,非常に複雑な機能を学習することができる.

分類タスクでは,より高いレベルの表現が,識別に重要な入力の側面を増幅し,無関係なバリエーションを抑制する.

例えば,画像は画素値の配列の形をしており,第1層の学習された特徴は,画像内の特定の方向と位置におけるエッジの有無を表すのが普通である.

第2層は,典型的には,エッジの位置の小さな変化に関係なく,エッジの特定の配置をスポットすることによってモチーフを検出する.

第3層は,モチーフをより大きな組み合わせに組み立て,身近な物体のパーツに対応させ,後続の層はこれらのパーツの組み合わせとして物体を検出する.

ディープラーニングの重要な点は,これらの特徴量の層は人間のエンジニアが設計したものではなく,汎用的な学習手順でデータから学習させるという点である.

ディープラーニングは,長年にわたって人工知能コミュニティの最善の試みに抵抗してきた問題の解決に大きな進歩をもたらしている.

ディープラーニングは,高次元データの複雑な構造を発見することに非常に優れているため,科学,ビジネス,政府の多くの領域に適用できることが判明している.

画像認識[1-4]や音声認識[5-7]の記録を塗り替えるだけでなく,潜在的な薬剤分子の活性予測[8],粒子加速器データの解析[9,10],脳回路の再構築[11],非コードDNAの変異が遺伝子発現や病気に及ぼす影響予測[12,13]でも他の機械学習技術より優れている.

さらに驚くべきことに,ディープラーニングは自然言語理解[14]の様々なタスク,特にトピック分類,感情分析,質問応答[15],言語翻訳[16, 17]において極めて有望な結果を出している.

ディープラーニングは,手作業によるエンジニアリングをほとんど必要としないため,利用可能な計算量やデータ量の増加を容易に利用できることから,近い将来,さらに多くの成功を収めるだろうと考えている.

現在開発されているディープニューラルネットワークの新しい学習アルゴリズムやアーキテクチャは,この進歩をさらに加速させるだろう.

2章:Supervised learning(教師あり学習)

機械学習の最も一般的な形態は,ディープであろうとなかろうと,教師あり学習である.

例えば,画像を家,車,人,ペットのいずれかに分類できるシステムを構築したいとする.

まず,家,車,人,ペットの画像からなる大規模なデータセットを収集し,それぞれにカテゴリーをラベル付けする.

訓練では,機械に画像を見せ,各カテゴリーに1つずつ,スコアのベクトルという形で出力を生成する.

目的のカテゴリーが全カテゴリーの中で最も高いスコアを持つようにしたいが,訓練前にそうなることはまずない.

出力されたスコアと希望するスコアのパターンとの間の誤差(または距離)を測定する目的関数を計算する.

そして,この誤差を減らすために,機械は内部の調整可能なパラメータを変更する.

この調整可能なパラメータは,しばしば重みと呼ばれ,機械の入出力関数を定義する「knobs」と見なすことができる実数である.

典型的なディープラーニングシステムでは,この調整可能な重みが何億個もあり,機械を訓練するために何億ものラベル付けされた例が存在することがある.

重みベクトルを適切に調整するために,学習アルゴリズムは,各重みについて,その重みをほんの少し増やした場合に誤差がどの程度増減するかを示す勾配ベクトルを算出する.

そして,重みベクトルは勾配ベクトルとは逆の方向に調整される.

すべての学習例で平均化された目的関数は,重み値の高次元空間における一種の丘陵風景として見ることができる.

負の勾配ベクトルは,この地形の中で最も急降下する方向を示し,出力誤差が平均的に低くなる最小値に近づける.

実際には,ほとんどの実務家が確率的勾配降下法(SGD:Stochastic Gradient Descent)と呼ばれる手順を使用している.

これは,いくつかの例について入力ベクトルを示し,出力と誤差を計算し,それらの例について平均勾配を計算し,それに応じて重みを調整している.

このプロセスは,目的関数の平均が減少しなくなるまで,訓練セットから多くの小さなサンプルセットに対して繰り返される.

それぞれの小さな例の集合が,すべての例における平均勾配のノイズの多い推定値を与えるので,確率的と呼ばれている.

この単純な手順は,はるかに精巧な最適化技術と比較すると,通常,驚くほど早く良い重みのセットを見つけることができる[18].

訓練後,システムの性能は,テストセットと呼ばれる別の例集合で測定される.

これは,機械の汎化能力,つまり,訓練中に見たことのない新しい入力に対して賢明な答えを出す能力をテストするためのものである.

現在の機械学習の実用的なアプリケーションの多くは,手作業で設計された特徴の上に線形分類器を用いている.

2クラス線形分類器は,特徴ベクトル成分の加重和を計算する.

加重和が閾値以上であれば,入力は特定のカテゴリーに属すると分類される.

1960年代から,線形分類器は入力空間を非常に単純な領域,すなわち超平面によって区切られた半空間にしか切り分けられないことが知られている[19].

しかし,画像認識や音声認識のような問題では,物体の位置や向き,照度の変化,音声のピッチやアクセントの変化など,入力の無関係な変化に対して入出力関数が鈍感であることが求められる.

一方,特定の微細な変化(例えば,白いオオカミとオオカミに似た白い犬種であるサモエドとの違い)には非常に敏感である.

ピクセルレベルでは,異なる姿勢で異なる環境にいる2匹のサモエドの画像は互いに大きく異なるかもしれないが,同じ姿勢で同様のバックグラウンドにいるサモエドとオオカミの2つの画像は互いに非常に似ているかもしれない.

線形分類器や,生のピクセルで動作する他の「浅い」分類器では,後者の2つを区別することはできず,前者の2つを同じカテゴリーに分類してしまう.

このため,浅い分類器には,選択性-不変性のジレンマを解決する優れた特徴抽出器が必要である.

つまり,識別に重要な画像の側面を選択的に表現し,動物のポーズなどの無関係な側面には不変な表現を生成する.

分類器をより強力にするために,カーネル法[20]のように一般的な非線形特徴を使うことができるが,ガウスカーネルで生じるような一般的な特徴は,学習者が訓練例から遠く離れたところでうまく汎化することができない[21].

従来は,優れた特徴抽出器を手作業で設計することが一般的でしたが,これにはかなりの技術力と専門知識が必要とされる.

しかし,汎用的な学習手順を使って優れた特徴を自動的に学習できれば,このような事態はすべて避けられる.

これがディープラーニングの大きな特徴である.

深層学習アーキテクチャは,単純なモジュールの多層スタックであり,そのすべて(またはほとんど)が学習の対象となり,その多くが非線形の入出力マッピングを計算する.

スタック内の各モジュールは,表現の選択性と不変性の両方を高めるために入力を変換する.

複数の非線形レイヤ,例えば5~20の深さのレイヤがあれば,システムは入力に対して非常に複雑な機能を実装することができる.

この機能は,サモエドと白いオオカミを区別するような細かいディテールに敏感であると同時に,バックグラウンド,姿勢,照明,周囲のオブジェクトなどの大きな無関係な変動に鈍感であることを示している.

3章:Backpropagation to train multilayer architectures(多層アーキテクチャを訓練するためのバックプロパゲーション)

パターン認識の初期[22, 23]から,研究者の目的は,手作業で作られた特徴を訓練可能な多層ネットワークに置き換えることだが,その単純さにもかかわらず,1980年代半ばまでその解決策が広く理解されることはなかった.

結論から言うと,多層アーキテクチャは単純な確率的勾配降下によって訓練することができる.

モジュールが入力と内部重みの比較的滑らかな関数である限り,バックプロパゲーションの手順で勾配を計算できる.

この方法は,1970年代から1980年代にかけて,いくつかの異なるグループによって独自に発見された[24-27].

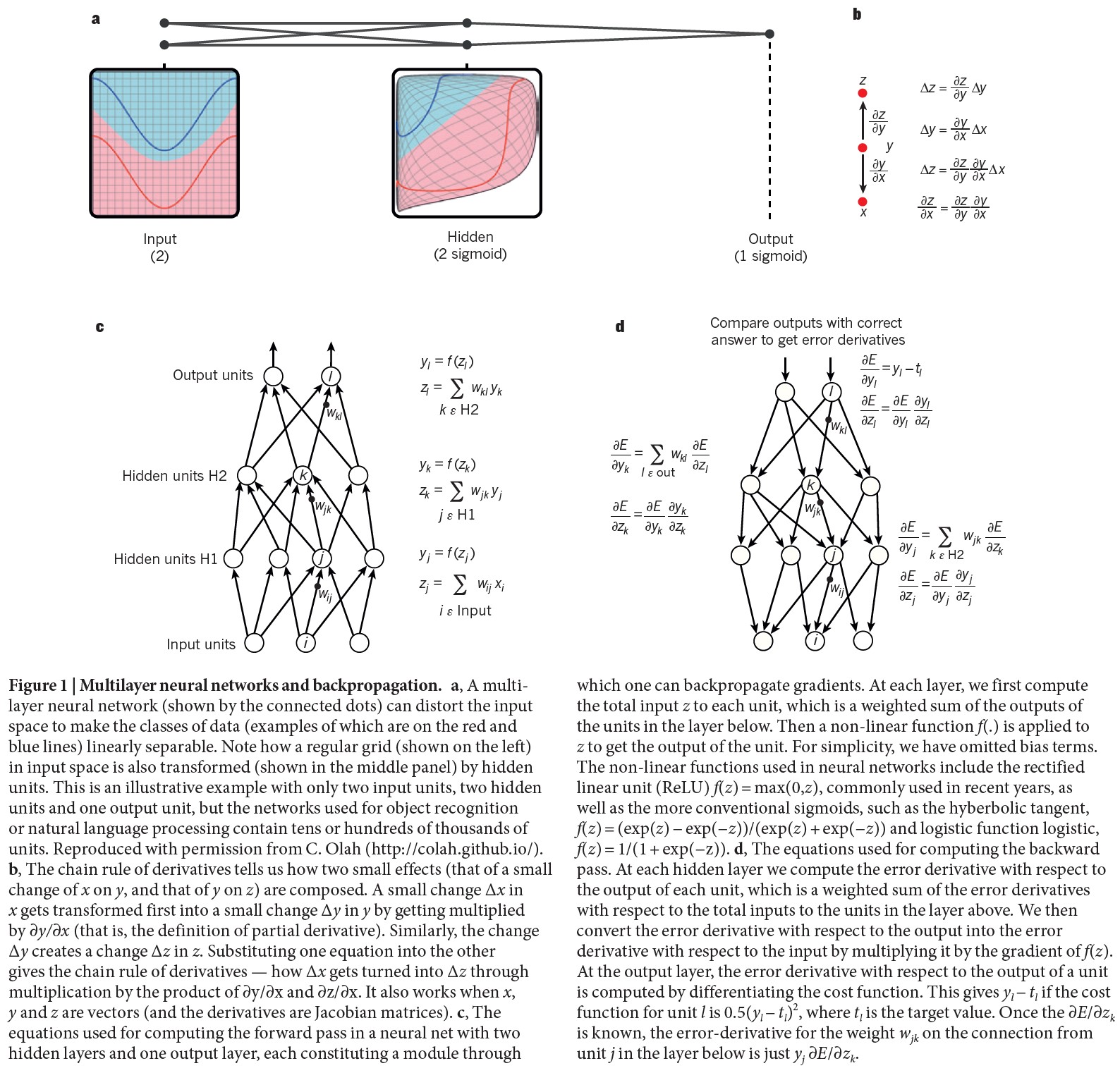

(a)多層ニューラルネットワーク(つながった点で示す)は,入力空間を歪めて,データのクラス(赤線と青線に例を示す)を線形分離可能にする.入力空間の規則的なグリッド(左図)が,隠れユニットによってどのように変換されるのか(中図)にも注意されたい.これは2つの入力ユニット,2つの隠れユニット,1つの出力ユニットを持つ例であるが,物体認識や自然言語処理に用いられるネットワークは数万から数十万のユニットを持つ.C. Olah (https://colah.github.io/)の許可を得て複製した.

(b)微分の連鎖法則は,2つの小さな効果(xの小さな変化がyに及ぼす効果とyのzに及ぼす効果)がどのように構成されるかを教えてくれる.xの小さな変化\(\Delta x\)は,\(\partial y/ \partial x\)を掛けられることによって,まずyの小さな変化\(\Delta y\)に変換される(つまり,偏微分の定義である).同様に,変化量\(\Delta y\)はzに変化量\(\Delta z\)を生じさせる.一方の式を他方の式に代入すると,導関数の連鎖法則,つまり,\(\partial y/ \partial x\)と\(\partial x\)の積の乗算によって,\(\Delta x\)が\(\Delta z\)に変化する様子がわかる.また,x,y,zがベクトル(導関数がヤコビ行列)の場合にも有効である.

(c)2つの隠れ層と1つの出力層を持つニューラルネットのフォワードパスの計算に使用する方程式.各層では,まず各ユニットへの総入力zを計算し,これは下の層のユニットの出力の加重和となる.次に,非線形関数f(.)をzに適用して,ユニットの出力を得る.簡単のため,バイアス項は省略した.ニューラルネットワークで用いられる非線形関数には,近年よく用いられるReLU(rectified linear unit) \(f(z)=max(0, z)\)のほか,従来からあるシグモイド,例えばハイバーボリックタンジェント, \(f(z)=(exp(z)-exp(-z))/(exp(z)+exp(-z))\)やロジカル関数logistic, \(f(z)=1/(1+exp(-z))\)などもある.

(d)バックワードパスの計算に使用する方程式.各隠れ層において,各ユニットの出力に関する誤差導関数を計算するが,これは上の層のユニットへの総入力に関する誤差導関数の加重和である.そして,出力に関する誤差導関数にf(z)の勾配を乗じることで,入力に関する誤差導関数に変換する.出力層では,コスト関数を微分することで,ユニットの出力に関する誤差導関数が計算される.これは,ユニットlのコスト関数が\(0.5(y_l - t_l)^2\)であれば\(y_l - t_l\)を与え,\(t_l\)は目標値である.一旦,\(\partial E /\partial z_k\)が分かれば,下の層のユニットjからの接続の重み\(w_{jk}\)の誤差微分は,\(y_j \partial E / \partial z_k\)だけである.

多層モジュールの重みに対する目的関数の勾配を計算するバックプロパゲーションは,導関数の連鎖法則の実用化に他ならない.

重要なのは,あるモジュールの入力に対する目的関数の導関数(または勾配)は,そのモジュールの出力(または後続モジュールの入力)に対する勾配から逆算して計算できる,ということである(図1).

バックプロパゲーション方程式を繰り返し適用することで,すべてのモジュールに勾配を伝搬させることができる.

上部の出力(ネットワークが予測を行う場所)から始まり,下部(外部入力が供給される場所)に至るまで,勾配が伝搬する.

これらの勾配が計算されたら,各モジュールの重みに関する勾配を計算するのは簡単である.

ディープラーニングの多くのアプリケーションでは,フィードフォワードニューラルネットワークアーキテクチャ(図1)を使用しており,固定サイズの入力(例えば,画像)を固定サイズの出力(例えば,いくつかのカテゴリーごとの確率)にマッピングすることを学習する.

ある層から次の層へ移動するには,一組のユニットが前の層からの入力の加重和を計算し,その結果を非線形関数に通す.

現在,最も一般的な非線形関数は整流線形ユニット(ReLU:Rectified Linear Unit)であり,これは単に半波整流器\(f(z)=max(z, 0)\)である.

過去数十年間,ニューラルネットは\(tanh(z)\)や\(1/(1 + exp(-z))\)などの滑らかな非線形関数を使用していたが,ReLUは通常,多くの層を持つネットワークにおいてはるかに速く学習し,教師なし事前訓練なしに深い教師ありネットワークの学習を可能にする[28].

入力層や出力層にないユニットは,従来は隠れユニットと呼ばれていた.

隠れ層は,最後の層でカテゴリーが線形に分離できるように,入力を非線形に歪めると見ることができる(図1).

1990年代後半,ニューラルネットとバックプロパゲーションは,機械学習コミュニティから見放され,コンピュータビジョンと音声認識のコミュニティからも無視されていた.

予備知識をほとんど持たずに有用な多段式の特徴抽出器を学習することは不可能であると広く考えられていた.

特に,単純な勾配降下法では,貧弱なローカルミニマム(平均誤差を小さくすることができない重みの構成)に陥ってしまうと考えられていた.

実際には,大規模なネットワークでは,貧弱な局所最小値が問題になることはほとんどない.

初期条件に関係なく,システムはほぼ常に非常に似た品質の解に到達する.

最近の理論的・経験的な結果は,一般に局所極小は深刻な問題ではないことを強く示唆している.

その代わりに,ランドスケープには,勾配がゼロとなり,ほとんどの次元で表面がカーブアップし,残りの次元でカーブダウンする,組み合わせ的に多数の鞍点が詰まっている[29, 30].

この解析では,下方に湾曲する方向が数本しかない鞍点が非常に多く存在するが,そのほとんどすべてが目的関数の値が非常に似ていることがわかる.

したがって,アルゴリズムがどの鞍点で行き詰まるかはあまり重要ではない.

ディープフィードフォワードネットワークへの関心は,2006年頃,カナダ高等研究院(CIFAR:Canadian Institute for Advanced Research)が集めた研究者グループによって復活した(文献[31-34]).

研究者たちは,ラベル付けされたデータを必要とせずに,特徴検出器の層を作ることができる教師なし学習方法を紹介した.

各特徴検出器の層を学習する目的は,下の層の特徴検出器(または生入力)の活動を再構築またはモデル化できるようにすることであった.

この再構築の目的を用いて,徐々に複雑になっていく特徴検出器のいくつかの層を「事前訓練」することで,ディープネットワークの重みを適切な値に初期化できる.

その後,出力ユニットの最終層をネットワークの上部に追加し,標準的なバックプロパゲーション[33-35]を使用して,ディープシステム全体をファインチューニングできる.

この方法は,手書きの数字を認識したり,歩行者を検出したりする際に,特にラベル付けされたデータの量が非常に限られている場合に,顕著な効果を発揮した[36].

この事前訓練アプローチの最初の主要な応用は音声認識であり,プログラミングに便利な高速GPUの出現によって可能になり[37],研究者はネットワークを10倍から20倍速く訓練できるようになった.

2009年,このアプローチは,音波から抽出された係数の短い時間窓を,窓の中央にあるフレームで表現される可能性のある様々な音声の断片の確率のセットに対応付けるために使用された.

このディープネットは,語彙の少ない標準的な音声認識ベンチマークで記録的な結果を達成し[38],大語彙のタスクで記録的な結果を得るためにすぐに開発された[39].

2012年までに,2009年に開発されたディープネットのバージョンは,多くの主要な音声認識グループによって開発され[6],すでにAndroid携帯に導入されている.

より小さなデータセットの場合,教師なし事前訓練はオーバーフィッティングを防ぐのに役立ち[40],ラベル付けされた例の数が少ない場合や,ある「ソース」タスクでは多くの例があるがある「ターゲット」タスクでは非常に少ないという転送設定において,著しく優れた汎化を導く.

ディープラーニングが復活すると,事前訓練段階は小さなデータセットにのみ必要であることが判明した.

しかし,ある特定のタイプの深いフィードフォワードネットワークがあり,隣接する層間の完全な接続性を持つネットワークよりもはるかに訓練が容易で,はるかに優れた汎化が可能であった.

それが畳み込みニューラルネットワーク(ConvNet)であった[41, 42].

ConvNetは,ニューラルネットワークが不人気だった時期に多くの実用的な成功を収め,最近ではコンピュータビジョンのコミュニティで広く採用されるようになった.

4章:Convolutional neural networks(畳み込みニューラルネットワーク)

ConvNetsは,例えば,3つのカラーチャンネルのピクセル強度を含む3つの2Dアレイからなるカラー画像のように,複数のアレイの形で来るデータを処理するように設計されている.

多くのデータモダリティは,複数の配列の形をしている.

言語などの信号やシーケンスは1D,画像や音声のスペクトログラムは2D,動画や体積画像は3Dである.

自然信号の特性を利用したConvNetsには,局所接続,共有重み,プーリング,多層の使用という4つの重要な考え方がある.

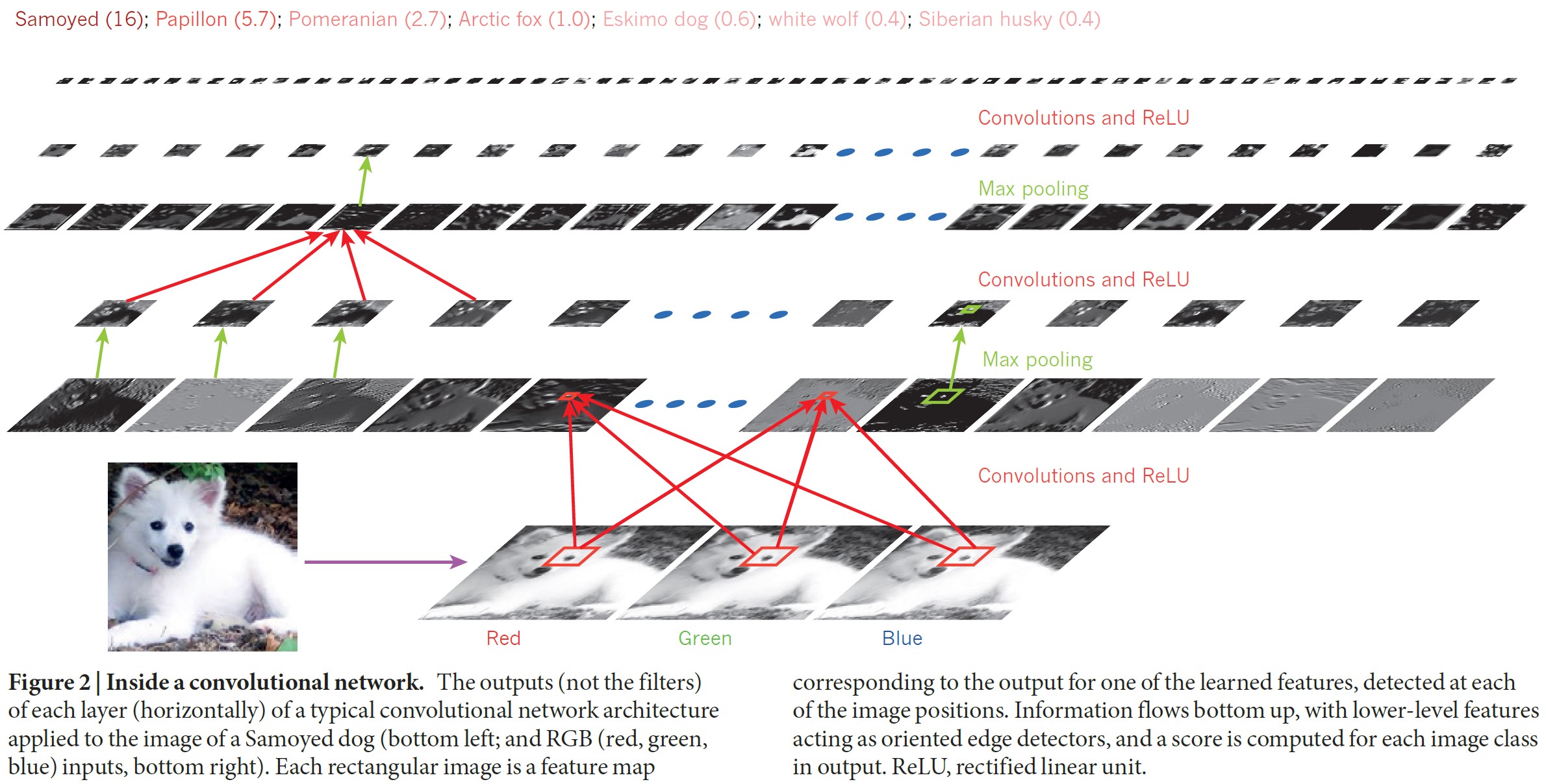

典型的なConvNetのアーキテクチャ(図2)は,一連のステージとして構成されている.

最初の数ステージは,畳み込み層とプーリング層という2種類の層で構成されている.

畳み込み層のユニットは特徴マップに編成され,その中で各ユニットはフィルターバンクと呼ばれる重みのセットを介して,前の層の特徴マップのローカルパッチに接続される.

この局所的な加重和の結果は,次にReLUのような非線形に通される.

特徴マップのすべてのユニットは,同じフィルターバンクを共有する.

レイヤ内の異なるフィーチャーマップは,異なるフィルターバンクを使用する.

このアーキテクチャを採用した理由は2つある.

第1に,画像などの配列データでは,局所的な値群の相関が高いことが多く,特徴的な局所モチーフが形成され,容易に検出される.

第2に,画像やその他の信号の局所的な統計は,場所に対して不変である.

つまり,あるモチーフが画像のある部分に現れることがあれば,それはどこにでも現れる可能性がある.

それゆえ,異なる場所にあるユニットが同じ重みを共有し,配列の異なる部分で同じパターンを検出するというアイデアが生まれた.

数学的には,特徴マップが行うフィルタリング操作は離散畳み込みであり,これが名前の由来である.

畳み込み層の役割は,前の層の特徴の局所的な結合を検出することであるが,プーリング層の役割は,意味的に類似した特徴を1つに統合することである.

モチーフを形成する特徴の相対的な位置は多少変化するので,各特徴の位置を粗くすることでモチーフを確実に検出することができる.

典型的なプーリングユニットは,1つの特徴マップ(またはいくつかの特徴マップ)内のユニットの局所パッチの最大値を計算する.

隣接するプーリングユニットは,1行または1列以上シフトしたパッチから入力を受け,それによって表現の次元を下げ,小さなシフトや歪みに対する不変性を作り出している.

畳み込み,非線形,プーリングの2段階または3段階が積み重ねられ,さらに畳み込み層と完全連結層が続く.

ConvNetで勾配をバックプロパゲートすることは,通常のディープネットワークと同様に簡単で,すべてのフィルターバンクのすべての重みを学習させることができるようになる.

ディープニューラルネットワークは,多くの自然信号が,下位の特徴を組み合わせることで上位の特徴が得られる構成階層であるという性質を利用している.

画像では,エッジの局所的な組み合わせがモチーフを形成し,モチーフがパーツに集合し,パーツがオブジェクトを形成する.

音声やテキストでも,音から電話,音素,音節,単語,文に至るまで,同様の階層が存在する.

プーリングにより,前の層の要素が位置や外観を変えても,表現はほとんど変化しない.

ConvNetsの畳み込み層とプーリング層は,視覚神経科学における単純細胞と複雑細胞という古典的な概念に直接触発されており[43],全体のアーキテクチャは,視覚野腹道におけるLGN-V1-V2-V4-IT階層を彷彿させる[44].

ConvNetモデルとサルに同じ絵を見せると,ConvNetの高レベルユニットの活性化は,サルの側頭下皮質における160個のニューロンのランダムセットの分散の半分を説明する[45].

ConvNetsのルーツはネオコグニトロン[46]で,そのアーキテクチャはある程度似ていたが,バックプロパゲーションのようなエンドツーエンドの教師あり学習アルゴリズムは持っていなかった.

時間遅延ニューラルネットと呼ばれる原始的な1次元ConvNetは,音素や単純な単語の認識に用いられた[47, 48].

畳み込みネットワークの応用は1990年代前半まで遡り,音声認識[47]や文書読み取り[42]のための時間遅延型ニューラルネットワークから始まっている.

文書読解システムは,言語制約を実装した確率モデルと共同で学習したConvNetを使用していた.

1990年代後半までに,このシステムは米国内の小切手の10%以上を読み取ることができた.

その後,ConvNetベースの光学式文字認識と手書き文字認識システムの多くがMicrosoft社によって展開された[49].

ConvNetsはまた,1990年代前半に,顔や手などの自然画像における物体検出[50, 51]や,顔認識[52]のために実験された.

5章:Image understanding with deep convolutional networks(深層畳み込みネットワークを用いた画像理解)

2000年代初頭から,ConvNetsは画像中のオブジェクトや領域の検出,セグメンテーション,認識に適用され,大きな成功を収めてきた.

これらは,交通標識の認識[53],生物学的画像のセグメンテーション[54],特にコネクトミクス[55],自然画像における顔,テキスト,歩行者,人体の検出[36, 50, 51, 56-58]など,いずれもラベル付きデータが比較的豊富なタスクである.

ConvNetsの最近の主な実用的成功例は,顔認識[59]である.

重要なのは,画像をピクセルレベルでラベル付けできることで,自律移動ロボットや自動運転車などの技術への応用が期待できる[60, 61].

Mobileye社やNVIDIA社などの企業は,今後開発する自動車用ビジョンシステムで,このようなConvNetベースの手法を使用している.

その他,自然言語理解[14]や音声認識[7]など,重要性を増しているアプリケーションもある.

このような成功にもかかわらず,ConvNetsは2012年のImageNetコンペティションまで,主流のコンピュータビジョンと機械学習コミュニティからほとんど見放されていた.

1,000の異なるクラスが含まれるウェブ上の約100万枚の画像のデータセットに深層畳み込みネットワークを適用したところ,競合する最良のアプローチのエラーレートをほぼ半減させるという驚くべき結果を達成した[1].

この成功は,GPUs,ReLUs,ドロップアウト[62]と呼ばれる新しい正則化技術,既存の例を変形させてより多くの訓練例を生成する技術などを効率的に利用したことである.

この成功はコンピュータビジョンに革命をもたらし,ConvNetsは現在,ほとんどすべての認識・検出タスク[4, 58, 59, 63-65]の主流となっており,いくつかのタスクでは人間の性能に近づいている.

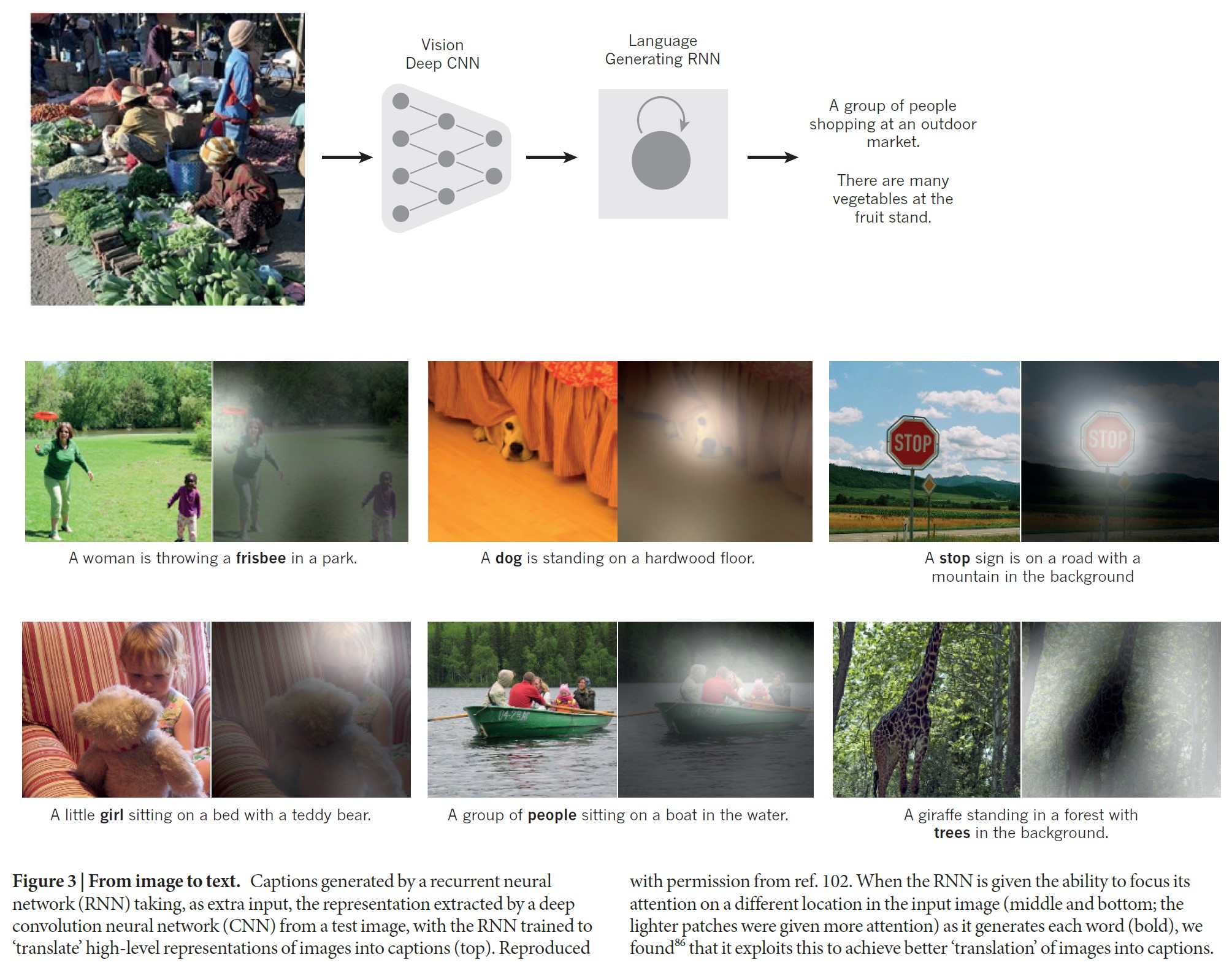

最近,画像のキャプションを生成するために,ConvNetsとリカレントネットモジュールを組み合わせた見事なデモンストレーションが行われた(図3).

最近のConvNetは,10層から20層のReLU,数億の重み,数十億のユニット間接続を持つアーキテクチャである.

このような大規模なネットワークの訓練には,わずか2年前までは数週間かかっているが,ハードウェア,ソフトウェア,アルゴリズムの並列化の進展により,学習時間は数時間に短縮された.

ConvNetベースのビジョンシステムの性能は,Google,Facebook(現在:Meta),Microsoft,IBM,Yahoo!,Twitter(現在:X),Adobeなどの主要なテクノロジー企業や,急速に増加する新興企業の多くが研究開発プロジェクトを開始し,ConvNetベースの画像理解製品およびサービスを展開する原因となった.

ConvNetsは,チップやフィールドプログラマブルゲートアレイでの効率的なハードウェア実装に容易に対応できる[66, 67].

NVIDIA,Mobileye,Intel,Qualcomm,Samsungなどの多くの企業が,スマートフォン,カメラ,ロボット,自動運転車などのリアルタイムビジョンアプリケーションを実現するためにConvNetチップを開発している.

6章:Distributed representations and language processing(分散表現と言語処理)

ディープラーニングの理論では,ディープネットは分散表現を用いない古典的な学習アルゴリズムに対して,2つの異なる指数関数的な利点を持つことが示されている[21].

これらの利点はいずれも合成の力から生じるものであり,基礎となるデータ生成分布が適切な成分構造を持つことに依存する[40].

第1に,分散表現を学習することで,学習した特徴の値の新しい組み合わせへの汎化が可能になる(例えば,n個の2値特徴で\(2^n\)の組み合わせが可能)[68, 69].

第2に,ディープネットで表現の層を構成することで,別の指数関数的な利点[70](深さにおいて指数関数的)が得られる可能性がある.

多層ニューラルネットの隠れ層は,ターゲット出力を容易に予測できるような方法でネットワークの入力を表現することを学習する.

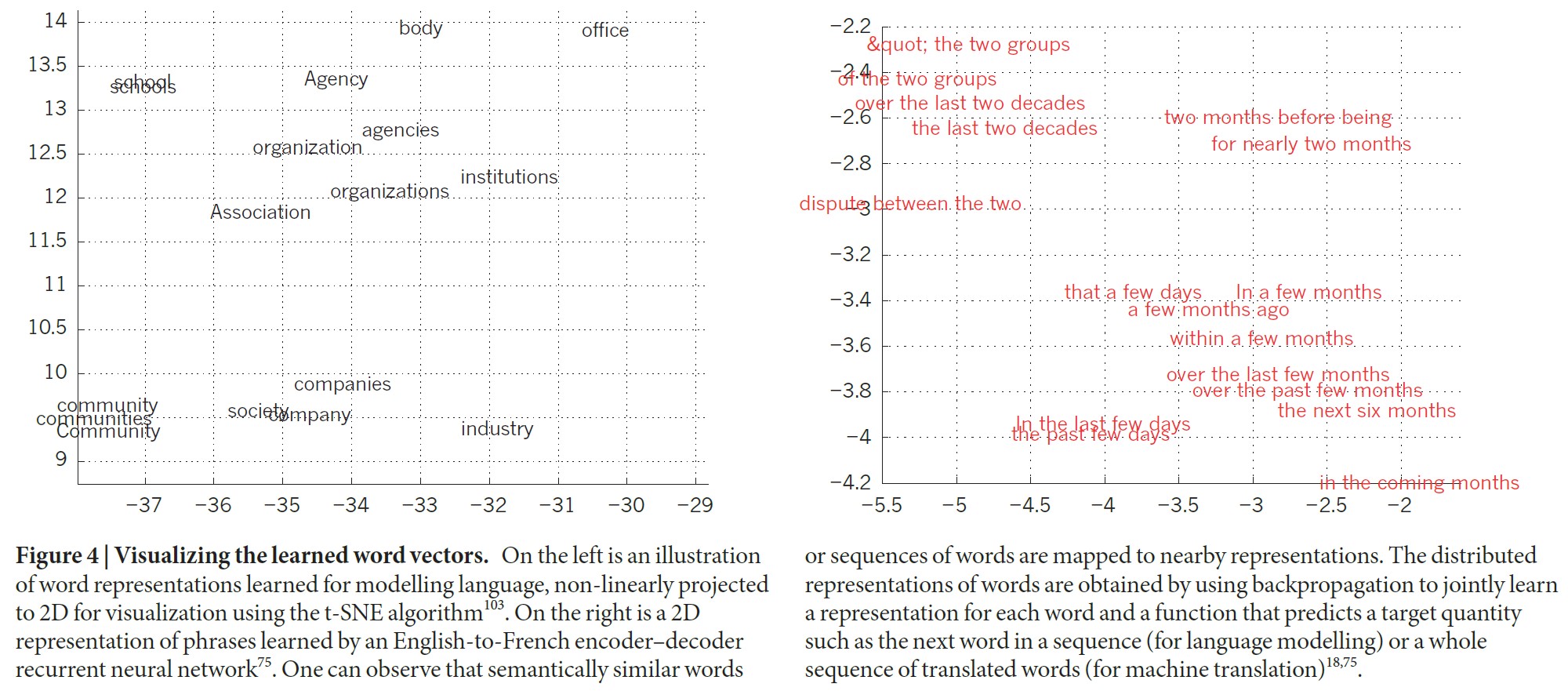

このことは,多層ニューラルネットを訓練して,前の単語の局所的な文脈から連続する単語の次の単語を予測することで見事に実証されている[71].

コンテキスト内の各単語は,N分の1のベクトルとしてネットワークに提示される.

つまり,1つのコンポーネントの値が1で,残りは0である.

第1層では,各単語が異なる活性化パターン(単語ベクトル)を作成する(図4).

言語モデルでは,ネットワークの他の層は,入力された単語ベクトルを,予測される次の単語の出力単語ベクトルに変換するように学習する.

この単語ベクトルは,語彙内の任意の単語が次の単語として出現する確率を予測するために使用することができる.

このネットワークは,記号の分散表現を学習する文脈で初めて実証されたように,それぞれが単語の個別の特徴として解釈できる多くの有効成分を含む単語ベクトルを学習する[27].

これらの意味的特徴は,入力に明示的に存在するものではない.

これらは,入力と出力のシンボル間の構造化された関係を複数の「マイクロルール」に因数分解する良い方法として,学習手順によって発見されたものである.

単語ベクトルの学習は,単語列が実テキストの大規模なコーパスに由来し,個々のマイクロルールが信頼できない場合にも非常にうまく機能することが判明した[71].

例えば,ニュース記事の次の単語を予測するように学習した場合,火曜日と水曜日の学習済み単語ベクトルは非常に似ており,スウェーデンとノルウェーの単語ベクトルも同様である.

このような表現は,その要素(特徴量)が相互に排他的でなく,その多くの構成が観測データに見られるバリエーションに対応することから,分散表現と呼ばれる.

これらの単語ベクトルは,専門家が前もって決定したものではなく,ニューラルネットワークが自動的に発見した学習済み特徴で構成されている.

テキストから学習された単語のベクトル表現は,現在,自然言語アプリケーションで非常に広く使われている[14, 17, 72-76].

この表現という問題は,論理学に基づく認知のパラダイムと神経回路に基づく認知のパラダイムの間の議論の中心にある.

論理に基づくパラダイムでは,記号のインスタンスは,他の記号のインスタンスと同一か非同一かという唯一の特性を持つものである.

記号は,その使用に関連する内部構造を持たず,記号を使った推論を行うには,慎重に選ばれた推論ルールで変数と結びつけなければならない.

これに対して,ニューラルネットワークは,大きな活動ベクトル,大きな重み行列,スカラー非線形を用いるだけで,楽な常識的推論を支える高速な「直感的」推論を実行することができる.

ニューラル言語モデル[71]が登場する以前は,言語の統計的モデリングの標準的なアプローチは,分散表現を利用するものではなかった.

それは,長さがNまでの短い記号列(N-gramと呼ばれる)の出現頻度をカウントすることに基づいていた.

N-gramの数は,\(V^N\)(Vは語彙の大きさ)のオーダーであるため,一握りの単語以上の文脈を考慮するためには,非常に大きな学習コーパスが必要となる.

N-gramは各単語を原子単位として扱うため,意味的に関連する単語の連続を汎化することができない.

しかし,ニューラル言語モデルでは,各単語を実数値の特徴量ベクトルに関連付け,そのベクトル空間において意味的に関連する単語が互いに接近しているため,このようなことが可能である(図4).

7章:Recurrent neural networks(リカレントニューラルネットワーク)

バックプロパゲーションが導入された当初は,リカレントニューラルネットワーク(RNNs:Recurrent Neural Networks)の訓練に最もエキサイティングな使い方がされていた.

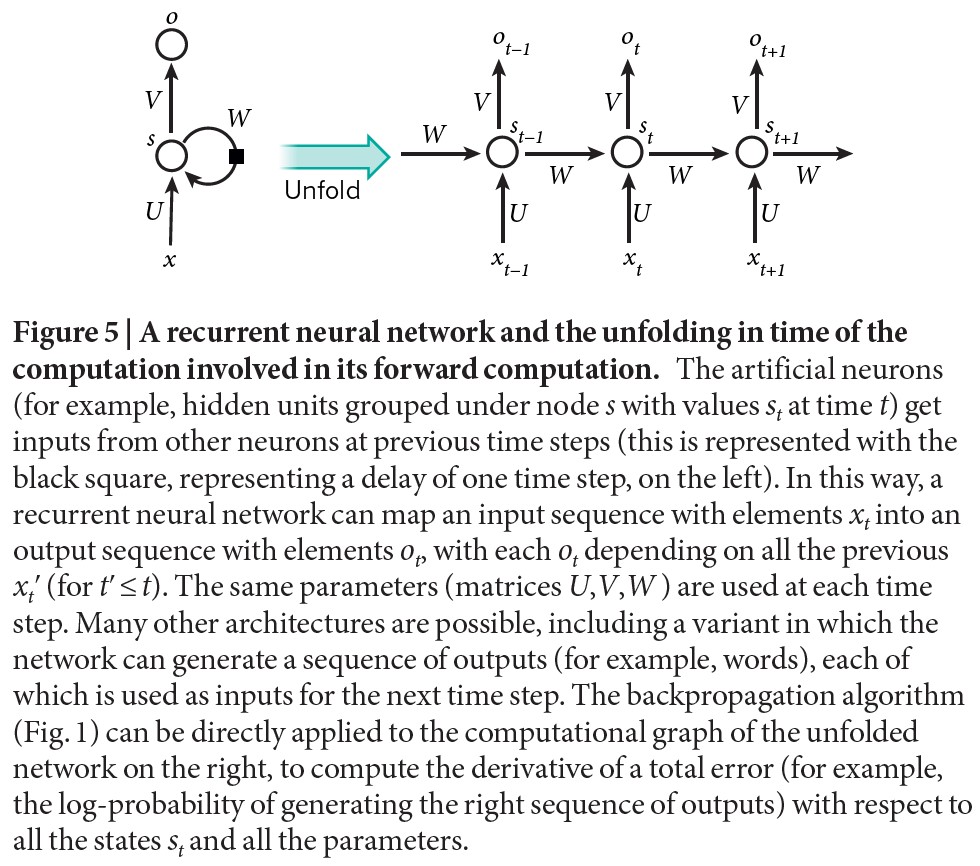

音声や言語のような連続した入力を伴うタスクでは,RNNsを使用した方が良い場合が多い(図5).

RNNsは,入力されたシーケンスを1つずつ処理し,その隠れユニットには,シーケンスの過去のすべての要素の履歴に関する情報を暗黙のうちに含む「状態ベクトル」を保持する.

異なる離散的な時間ステップにおける隠れユニットの出力を,深層多層ネットワークの異なるニューロンの出力であるかのように考えると(図5右),バックプロパゲーションを適用してRNNsを学習する方法が明らかになる.

RNNsは非常に強力な動的システムだが,バックプロパゲートされた勾配が各時間ステップで成長または縮小するため,多くの時間ステップで爆発または消滅するのが普通であるため,RNNsの訓練には問題があることが判明した[77, 78].

アーキテクチャ[79, 80]や学習方法[81, 82]の進歩により,RNNsはテキストの次の文字[83]やシーケンスの次の単語[75]を予測するのに非常に優れていることが判明しているが,より複雑なタスクにも使用することが可能である.

例えば,英語の文章を1単語ずつ読んだ後,英語の「エンコーダ」ネットワークを訓練して,その隠れユニットの最終状態ベクトルが,文章で表現された思考をうまく表現できる.

この思考ベクトルを,共同で学習したフランス語の「デコーダ」ネットワークの初期状態として(あるいは追加入力として)使用し,フランス語訳の最初の単語の確率分布を出力させることができる.

この分布から特定の最初の単語が選ばれ,デコーダネットワークの入力として提供されると,デコーダネットワークは翻訳の2番目の単語の確率分布を出力し,フルストップが選ばれるまで続く[17, 72, 76].

全体として,このプロセスは,英語文に依存する確率分布に従って,フランス語の単語のシーケンスを生成する.

このような素朴な方法で機械翻訳を行うことは,すぐに最先端技術と競合するようになった.

このことは,文章を理解するのに,推論ルールを使って操作される内部記号表現のようなものが必要かどうかについて,重大な疑念を抱かせる.

それよりも,日常的な推論には多くの類似性が同時に存在し,それぞれが結論に妥当性を与えるという考え方の方が,より適合的である[84, 85].

フランス語の文の意味を英語の文に翻訳する代わりに,画像の意味を英語の文に「翻訳」することを学習できる(図3).

エンコーダは深層ConvNetで,最後の隠れ層で画素を活動ベクトルに変換する.

デコーダは,機械翻訳や神経言語モデリングに使用されるものと同様のRNNである.

最近,このようなシステムへの関心が急増している(文献[86]で紹介されている例を参照).

RNNsは,時間的に展開すると(図5),すべての層が同じ重みを共有する非常に深いフィードフォワードネットワークとして見ることができる.

長期的な依存関係を学習するのが主な目的だが,理論的にも経験的にも,情報を非常に長く保存することを学習するのは困難であることが示されている[78].

これを修正するために,ネットワークを明示的な記憶で拡張することが1つのアイデアである.

この種の最初の提案は,特別な隠れユニットを使用する長期短期記憶(LSTM:Long Short-Term Memory)ネットワークであり,その自然な動作は,長い間入力を記憶することである[79].

メモリセルと呼ばれる特殊なユニットは,アキュムレータやゲート式リーキーニューロンのような働きをする.

次の時間ステップで自分自身との接続があり,重みが1であるため,自分自身の実数値の状態をコピーして外部信号を蓄積する.

しかし,この自己接続は,いつメモリの内容を消去するかを学習する別のユニットによって多重にゲートされる.

LSTMネットワークはその後,従来のRNNsよりも効果的であることが証明され,特に各時間ステップに複数の層を持つ場合[87],音響から文字列の転写に至るまで,音声認識システム全体を実現することができる.

また,LSTMネットワークやゲート型ユニットの関連形態は,現在,機械翻訳で非常に優れた性能を発揮するエンコーダとデコーダのネットワークに使用されている[17, 72, 76].

過去1年間,複数の著者が,RNNsをメモリモジュールで拡張するさまざまな提案を行ってきた.

この提案には,RNNが読み取りまたは書き込みを選択できる「テープ状」メモリによってネットワークを拡張するNeural Turing Machine[88]や,通常のネットワークを一種の連想メモリによって拡張するメモリネットワーク[89]が含まれる.

メモリネットワークは,標準的な質問回答ベンチマークで優れた性能を発揮している.

メモリは,ネットワークが後に質問に答えるよう求められるストーリーについて記憶するために使用される.

単純な記憶だけでなく,ニューラルチューリングマシンやメモリネットワークは,通常であれば推論や記号操作が必要なタスクに利用されている.

ニューラルチューリングマシンは,「アルゴリズム」を教えることができる.

特に,各シンボルがリスト内での優先順位を示す実数値を伴うソートされていないシーケンスからなる入力に対して,ソートされたシンボルのリストを出力することを学ぶことができる[88].

メモリネットワークは,テキストアドベンチャーゲームに似た設定で世界の状態を追跡するように訓練することができ,物語を読んだ後,複雑な推論を必要とする質問に答えることができる[90].

あるテスト例では,ネットワークに「指輪物語」の15-sentence version(15文のバージョン)を見せ,「フロドは今どこにいるのか」といった質問に正しく答えている[89].

※訳注:フロドは指輪物語の主人公です.

8章:The future of deep learning(ディープラーニングの未来)

教師なし学習[91-98]は,深層学習への関心を復活させる起爆剤となったが,その後,純粋な教師あり学習の成功によって影が薄くなっている.

本総説では取り上げていないが,教師なし学習の重要性は長期的にははるかに高くなると予想される.

人間や動物の学習は,そのほとんどが教師なし学習である.

我々は,すべての物体の名前を教えられるのではなく,世界を観察することで世界の構造を発見している.

人間の視覚は,小さな高解像度の窩と大きな低解像度の周囲を使用して,インテリジェントでタスク固有の方法で視神経配列を順次サンプリングするアクティブなプロセスである.

我々は,視覚における将来の進歩の多くは,エンドツーエンドで訓練され,強化学習を使用して見る場所を決定するConvNetsとRNNsを組み合わせたシステムから生まれると予想している.

深層学習と強化学習を組み合わせたシステムはまだ発展途上だが,分類タスクではすでに受動的なビジョンシステム[99]を上回り,さまざまなビデオゲームのプレイ学習でも素晴らしい結果を出している[100].

自然言語理解は,深層学習が今後数年間で大きな影響を与えることになるもう一つの分野である.

RNNsを使用して文章や文書全体を理解するシステムは,一度に1つの部分に選択的に注目する戦略を学ぶことで,より優れたものになると予想している[76, 86].

最終的に,人工知能の大きな進歩は,表現学習と複雑な推論を組み合わせたシステムによってもたらされるだろう.

音声認識や手書き文字認識では,深層学習と単純な推論が長く使われてきたが,記号式のルールベースの操作を,大きなベクトルに対する操作に置き換える新しいパラダイムが必要である[101].■

References(参考文献)

- Krizhevsky, A., Sutskever, I. & Hinton, G. ImageNet classification with deep convolutional neural networks. In Proc. Advances in Neural Information Processing Systems 25 1090–1098 (2012).

This report was a breakthrough that used convolutional nets to almost halve the error rate for object recognition, and precipitated the rapid adoption of deep learning by the computer vision community. - Farabet, C., Couprie, C., Najman, L. & LeCun, Y. Learning hierarchical features for scene labeling. IEEE Trans. Pattern Anal. Mach. Intell. 35, 1915–1929 (2013).

- Tompson, J., Jain, A., LeCun, Y. & Bregler, C. Joint training of a convolutional network and a graphical model for human pose estimation. In Proc. Advances in Neural Information Processing Systems 27 1799–1807 (2014).

- Szegedy, C. et al. Going deeper with convolutions. Preprint at https://arxiv.org/abs/1409.4842 (2014).

- Mikolov, T., Deoras, A., Povey, D., Burget, L. & Cernocky, J. Strategies for training large scale neural network language models. In Proc. Automatic Speech Recognition and Understanding 196–201 (2011).

- Hinton, G. et al. Deep neural networks for acoustic modeling in speech recognition. IEEE Signal Processing Magazine 29, 82–97 (2012).

This joint paper from the major speech recognition laboratories, summarizing the breakthrough achieved with deep learning on the task of phonetic classification for automatic speech recognition, was the first major industrial application of deep learning. - Sainath, T., Mohamed, A.-R., Kingsbury, B. & Ramabhadran, B. Deep convolutional neural networks for LVCSR. In Proc. Acoustics, Speech and Signal Processing 8614–8618 (2013).

- Ma, J., Sheridan, R. P., Liaw, A., Dahl, G. E. & Svetnik, V. Deep neural nets as a method for quantitative structure-activity relationships. J. Chem. Inf. Model. 55, 263–274 (2015).

- Ciodaro, T., Deva, D., de Seixas, J. & Damazio, D. Online particle detection with neural networks based on topological calorimetry information. J. Phys. Conf. Series 368, 012030 (2012).

- Kaggle. Higgs boson machine learning challenge. Kaggle https://www.kaggle.com/c/higgs-boson (2014).

- Helmstaedter, M. et al. Connectomic reconstruction of the inner plexiform layer in the mouse retina. Nature 500, 168–174 (2013).

- Leung, M. K., Xiong, H. Y., Lee, L. J. & Frey, B. J. Deep learning of the tissueregulated splicing code. Bioinformatics 30, i121–i129 (2014).

- Xiong, H. Y. et al. The human splicing code reveals new insights into the genetic determinants of disease. Science 347, 6218 (2015).

- Collobert, R., et al. Natural language processing (almost) from scratch. J. Mach. Learn. Res. 12, 2493–2537 (2011).

- Bordes, A., Chopra, S. & Weston, J. Question answering with subgraph embeddings. In Proc. Empirical Methods in Natural Language Processing https:// arxiv.org/abs/1406.3676v3 (2014).

- Jean, S., Cho, K., Memisevic, R. & Bengio, Y. On using very large target vocabulary for neural machine translation. In Proc. ACL-IJCNLP https://arxiv.org/abs/1412.2007 (2015).

- Sutskever, I. Vinyals, O. & Le. Q. V. Sequence to sequence learning with neural networks. In Proc. Advances in Neural Information Processing Systems 27 3104–3112 (2014).

This paper showed state-of-the-art machine translation results with the architecture introduced in ref. 72, with a recurrent network trained to read a sentence in one language, produce a semantic representation of its meaning, and generate a translation in another language. - Bottou, L. & Bousquet, O. The tradeoffs of large scale learning. In Proc. Advances in Neural Information Processing Systems 20 161–168 (2007).

- Duda, R. O. & Hart, P. E. Pattern Classification and Scene Analysis (Wiley, 1973).

- Schölkopf, B. & Smola, A. Learning with Kernels (MIT Press, 2002).

- Bengio, Y., Delalleau, O. & Le Roux, N. The curse of highly variable functions for local kernel machines. In Proc. Advances in Neural Information Processing Systems 18 107–114 (2005).

- Selfridge, O. G. Pandemonium: a paradigm for learning in mechanisation of thought processes. In Proc. Symposium on Mechanisation of Thought Processes 513–526 (1958).

- Rosenblatt, F. The Perceptron — A Perceiving and Recognizing Automaton. Tech. Rep. 85-460-1 (Cornell Aeronautical Laboratory, 1957).

- Werbos, P. Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences. PhD thesis, Harvard Univ. (1974).

- Parker, D. B. Learning Logic Report TR–47 (MIT Press, 1985).

- LeCun, Y. Une procédure d’apprentissage pour Réseau à seuil assymétrique in Cognitiva 85: a la Frontière de l’Intelligence Artificielle, des Sciences de la Connaissance et des Neurosciences [in French] 599–604 (1985).

- Rumelhart, D. E., Hinton, G. E. & Williams, R. J. Learning representations by back-propagating errors. Nature 323, 533–536 (1986).

- Glorot, X., Bordes, A. & Bengio. Y. Deep sparse rectifier neural networks. In Proc. 14th International Conference on Artificial Intelligence and Statistics 315–323 (2011).

This paper showed that supervised training of very deep neural networks is much faster if the hidden layers are composed of ReLU. - Dauphin, Y. et al. Identifying and attacking the saddle point problem in highdimensional non-convex optimization. In Proc. Advances in Neural Information Processing Systems 27 2933–2941 (2014).

- Choromanska, A., Henaff, M., Mathieu, M., Arous, G. B. & LeCun, Y. The loss surface of multilayer networks. In Proc. Conference on AI and Statistics https://arxiv.org/abs/1412.0233 (2014).

- Hinton, G. E. What kind of graphical model is the brain? In Proc. 19th International Joint Conference on Artificial intelligence 1765–1775 (2005).

- Hinton, G. E., Osindero, S. & Teh, Y.-W. A fast learning algorithm for deep belief nets. Neural Comp. 18, 1527–1554 (2006).

This paper introduced a novel and effective way of training very deep neural networks by pre-training one hidden layer at a time using the unsupervised learning procedure for restricted Boltzmann machines. - Bengio, Y., Lamblin, P., Popovici, D. & Larochelle, H. Greedy layer-wise training of deep networks. In Proc. Advances in Neural Information Processing Systems 19 153–160 (2006).

This report demonstrated that the unsupervised pre-training method introduced in ref. 32 significantly improves performance on test data and generalizes the method to other unsupervised representation-learning techniques, such as auto-encoders. - Ranzato, M., Poultney, C., Chopra, S. & LeCun, Y. Efficient learning of sparse representations with an energy-based model. In Proc. Advances in Neural Information Processing Systems 19 1137–1144 (2006).

- Hinton, G. E. & Salakhutdinov, R. Reducing the dimensionality of data with neural networks. Science 313, 504–507 (2006).

- Sermanet, P., Kavukcuoglu, K., Chintala, S. & LeCun, Y. Pedestrian detection with unsupervised multi-stage feature learning. In Proc. International Conference on Computer Vision and Pattern Recognition https://arxiv.org/abs/1212.0142 (2013).

- Raina, R., Madhavan, A. & Ng, A. Y. Large-scale deep unsupervised learning using graphics processors. In Proc. 26th Annual International Conference on Machine Learning 873–880 (2009).

- Mohamed, A.-R., Dahl, G. E. & Hinton, G. Acoustic modeling using deep belief networks. IEEE Trans. Audio Speech Lang. Process. 20, 14–22 (2012).

- Dahl, G. E., Yu, D., Deng, L. & Acero, A. Context-dependent pre-trained deep neural networks for large vocabulary speech recognition. IEEE Trans. Audio Speech Lang. Process. 20, 33–42 (2012).

- Bengio, Y., Courville, A. & Vincent, P. Representation learning: a review and new perspectives. IEEE Trans. Pattern Anal. Machine Intell. 35, 1798–1828 (2013).

- LeCun, Y. et al. Handwritten digit recognition with a back-propagation network. In Proc. Advances in Neural Information Processing Systems 396–404 (1990).

This is the first paper on convolutional networks trained by backpropagation for the task of classifying low-resolution images of handwritten digits. - LeCun, Y., Bottou, L., Bengio, Y. & Haffner, P. Gradient-based learning applied to document recognition. Proc. IEEE 86, 2278–2324 (1998).

This overview paper on the principles of end-to-end training of modular systems such as deep neural networks using gradient-based optimization showed how neural networks (and in particular convolutional nets) can be combined with search or inference mechanisms to model complex outputs that are interdependent, such as sequences of characters associated with the content of a document. - Hubel, D. H. & Wiesel, T. N. Receptive fields, binocular interaction, and functional architecture in the cat’s visual cortex. J. Physiol. 160, 106–154 (1962).

- Felleman, D. J. & Essen, D. C. V. Distributed hierarchical processing in the primate cerebral cortex. Cereb. Cortex 1, 1–47 (1991).

- Cadieu, C. F. et al. Deep neural networks rival the representation of primate it cortex for core visual object recognition. PLoS Comp. Biol. 10, e1003963 (2014).

- Fukushima, K. & Miyake, S. Neocognitron: a new algorithm for pattern recognition tolerant of deformations and shifts in position. Pattern Recognition 15, 455–469 (1982).

- Waibel, A., Hanazawa, T., Hinton, G. E., Shikano, K. & Lang, K. Phoneme recognition using time-delay neural networks. IEEE Trans. Acoustics Speech Signal Process. 37, 328–339 (1989).

- Bottou, L., Fogelman-Soulié, F., Blanchet, P. & Lienard, J. Experiments with time delay networks and dynamic time warping for speaker independent isolated digit recognition. In Proc. EuroSpeech 89 537–540 (1989).

- Simard, D., Steinkraus, P. Y. & Platt, J. C. Best practices for convolutional neural networks. In Proc. Document Analysis and Recognition 958–963 (2003).

- Vaillant, R., Monrocq, C. & LeCun, Y. Original approach for the localisation of objects in images. In Proc. Vision, Image, and Signal Processing 141, 245–250 (1994).

- Nowlan, S. & Platt, J. in Neural Information Processing Systems 901–908 (1995).

- Lawrence, S., Giles, C. L., Tsoi, A. C. & Back, A. D. Face recognition: a convolutional neural-network approach. IEEE Trans. Neural Networks 8, 98–113 (1997).

- Ciresan, D., Meier, U. Masci, J. & Schmidhuber, J. Multi-column deep neural network for traffic sign classification. Neural Networks 32, 333–338 (2012).

- Ning, F. et al. Toward automatic phenotyping of developing embryos from videos. IEEE Trans. Image Process. 14, 1360–1371 (2005).

- Turaga, S. C. et al. Convolutional networks can learn to generate affinity graphs for image segmentation. Neural Comput. 22, 511–538 (2010).

- Garcia, C. & Delakis, M. Convolutional face finder: a neural architecture for fast and robust face detection. IEEE Trans. Pattern Anal. Machine Intell. 26, 1408–1423 (2004).

- Osadchy, M., LeCun, Y. & Miller, M. Synergistic face detection and pose estimation with energy-based models. J. Mach. Learn. Res. 8, 1197–1215 (2007).

- Tompson, J., Goroshin, R. R., Jain, A., LeCun, Y. Y. & Bregler, C. C. Efficient object localization using convolutional networks. In Proc. Conference on Computer Vision and Pattern Recognition https://arxiv.org/abs/1411.4280 (2014).

- Taigman, Y., Yang, M., Ranzato, M. & Wolf, L. Deepface: closing the gap to human-level performance in face verification. In Proc. Conference on Computer Vision and Pattern Recognition 1701–1708 (2014).

- Hadsell, R. et al. Learning long-range vision for autonomous off-road driving. J. Field Robot. 26, 120–144 (2009).

- Farabet, C., Couprie, C., Najman, L. & LeCun, Y. Scene parsing with multiscale feature learning, purity trees, and optimal covers. In Proc. International Conference on Machine Learning https://arxiv.org/abs/1202.2160 (2012).

- Srivastava, N., Hinton, G., Krizhevsky, A., Sutskever, I. & Salakhutdinov, R. Dropout: a simple way to prevent neural networks from overfitting. J. Machine Learning Res. 15, 1929–1958 (2014).

- Sermanet, P. et al. Overfeat: integrated recognition, localization and detection using convolutional networks. In Proc. International Conference on Learning Representations https://arxiv.org/abs/1312.6229 (2014).

- Girshick, R., Donahue, J., Darrell, T. & Malik, J. Rich feature hierarchies for accurate object detection and semantic segmentation. In Proc. Conference on Computer Vision and Pattern Recognition 580–587 (2014).

- Simonyan, K. & Zisserman, A. Very deep convolutional networks for large-scale image recognition. In Proc. International Conference on Learning Representations https://arxiv.org/abs/1409.1556 (2014).

- Boser, B., Sackinger, E., Bromley, J., LeCun, Y. & Jackel, L. An analog neural network processor with programmable topology. J. Solid State Circuits 26, 2017–2025 (1991).

- Farabet, C. et al. Large-scale FPGA-based convolutional networks. In Scaling up Machine Learning: Parallel and Distributed Approaches (eds Bekkerman, R., Bilenko, M. & Langford, J.) 399–419 (Cambridge Univ. Press, 2011).

- Bengio, Y. Learning Deep Architectures for AI (Now, 2009).

- Montufar, G. & Morton, J. When does a mixture of products contain a product of mixtures? J. Discrete Math. 29, 321–347 (2014).

- Montufar, G. F., Pascanu, R., Cho, K. & Bengio, Y. On the number of linear regions of deep neural networks. In Proc. Advances in Neural Information Processing Systems 27 2924–2932 (2014).

- Bengio, Y., Ducharme, R. & Vincent, P. A neural probabilistic language model. In Proc. Advances in Neural Information Processing Systems 13 932–938 (2001).

This paper introduced neural language models, which learn to convert a word symbol into a word vector or word embedding composed of learned semantic features in order to predict the next word in a sequence. - Cho, K. et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation. In Proc. Conference on Empirical Methods in Natural Language Processing 1724–1734 (2014).

- Schwenk, H. Continuous space language models. Computer Speech Lang. 21, 492–518 (2007).

- Socher, R., Lin, C. C-Y., Manning, C. & Ng, A. Y. Parsing natural scenes and natural language with recursive neural networks. In Proc. International Conference on Machine Learning 129–136 (2011).

- Mikolov, T., Sutskever, I., Chen, K., Corrado, G. & Dean, J. Distributed representations of words and phrases and their compositionality. In Proc. Advances in Neural Information Processing Systems 26 3111–3119 (2013).

- Bahdanau, D., Cho, K. & Bengio, Y. Neural machine translation by jointly learning to align and translate. In Proc. International Conference on Learning Representations https://arxiv.org/abs/1409.0473 (2015).

- Hochreiter, S. Untersuchungen zu dynamischen neuronalen Netzen [in German] Diploma thesis, T.U. Münich (1991).

- Bengio, Y., Simard, P. & Frasconi, P. Learning long-term dependencies with gradient descent is difficult. IEEE Trans. Neural Networks 5, 157–166 (1994).

- Hochreiter, S. & Schmidhuber, J. Long short-term memory. Neural Comput. 9, 1735–1780 (1997).

This paper introduced LSTM recurrent networks, which have become a crucial ingredient in recent advances with recurrent networks because they are good at learning long-range dependencies. - ElHihi, S. & Bengio, Y. Hierarchical recurrent neural networks for long-term dependencies. In Proc. Advances in Neural Information Processing Systems 8 https://papers.nips.cc/paper/1102-hierarchical-recurrent-neural-networks-forlong-term-dependencies (1995).

- Sutskever, I. Training Recurrent Neural Networks. PhD thesis, Univ. Toronto (2012).

- Pascanu, R., Mikolov, T. & Bengio, Y. On the difficulty of training recurrent neural networks. In Proc. 30th International Conference on Machine Learning 1310– 1318 (2013).

- Sutskever, I., Martens, J. & Hinton, G. E. Generating text with recurrent neural networks. In Proc. 28th International Conference on Machine Learning 1017– 1024 (2011).

- Lakoff, G. & Johnson, M. Metaphors We Live By (Univ. Chicago Press, 2008).

- Rogers, T. T. & McClelland, J. L. Semantic Cognition: A Parallel Distributed Processing Approach (MIT Press, 2004).

- Xu, K. et al. Show, attend and tell: Neural image caption generation with visual attention. In Proc. International Conference on Learning Representations https:// arxiv.org/abs/1502.03044 (2015).

- Graves, A., Mohamed, A.-R. & Hinton, G. Speech recognition with deep recurrent neural networks. In Proc. International Conference on Acoustics, Speech and Signal Processing 6645–6649 (2013).

- Graves, A., Wayne, G. & Danihelka, I. Neural Turing machines. https://arxiv.org/abs/1410.5401 (2014).

- Weston, J. Chopra, S. & Bordes, A. Memory networks. https://arxiv.org/abs/1410.3916 (2014).

- Weston, J., Bordes, A., Chopra, S. & Mikolov, T. Towards AI-complete question answering: a set of prerequisite toy tasks. https://arxiv.org/abs/1502.05698 (2015).

- Hinton, G. E., Dayan, P., Frey, B. J. & Neal, R. M. The wake-sleep algorithm for unsupervised neural networks. Science 268, 1558–1161 (1995).

- Salakhutdinov, R. & Hinton, G. Deep Boltzmann machines. In Proc. International Conference on Artificial Intelligence and Statistics 448–455 (2009).

- Vincent, P., Larochelle, H., Bengio, Y. & Manzagol, P.-A. Extracting and composing robust features with denoising autoencoders. In Proc. 25th International Conference on Machine Learning 1096–1103 (2008).

- Kavukcuoglu, K. et al. Learning convolutional feature hierarchies for visual recognition. In Proc. Advances in Neural Information Processing Systems 23 1090–1098 (2010).

- Gregor, K. & LeCun, Y. Learning fast approximations of sparse coding. In Proc. International Conference on Machine Learning 399–406 (2010).

- Ranzato, M., Mnih, V., Susskind, J. M. & Hinton, G. E. Modeling natural images using gated MRFs. IEEE Trans. Pattern Anal. Machine Intell. 35, 2206–2222 (2013).

- Bengio, Y., Thibodeau-Laufer, E., Alain, G. & Yosinski, J. Deep generative stochastic networks trainable by backprop. In Proc. 31st International Conference on Machine Learning 226–234 (2014).

- Kingma, D., Rezende, D., Mohamed, S. & Welling, M. Semi-supervised learning with deep generative models. In Proc. Advances in Neural Information Processing Systems 27 3581–3589 (2014).

- Ba, J., Mnih, V. & Kavukcuoglu, K. Multiple object recognition with visual attention. In Proc. International Conference on Learning Representations https:// arxiv.org/abs/1412.7755 (2014).

- Mnih, V. et al. Human-level control through deep reinforcement learning. Nature 518, 529–533 (2015).

- Bottou, L. From machine learning to machine reasoning. Mach. Learn. 94, 133–149 (2014).

- Vinyals, O., Toshev, A., Bengio, S. & Erhan, D. Show and tell: a neural image caption generator. In Proc. International Conference on Machine Learning https://arxiv.org/abs/1502.03044 (2014).

- van der Maaten, L. & Hinton, G. E. Visualizing data using t-SNE. J. Mach. Learn. Research 9, 2579–2605 (2008).

まとめ

Natureの論文「Deep learning」の日本語訳を紹介しました.

Deep learningの本質を理解するために,何度も読み込みましょう!

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.