Lumiere: A Space-Time Diffusion Model for Video Generationの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Assembler (x64,ARM).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Lumiere: A Space-Time Diffusion Model for Video Generationの日本語訳を紹介します.

グーグルのLumiereがわかります.

LumiereのWebサイトはこちらです.

※図表を含む論文の著作権はLumiere: A Space-Time Diffusion Model for Video Generationの著者に帰属します.

Lumiere: A Space-Time Diffusion Model for Video Generationの目次は以下になります.

- Abstract

- 1章:Introduction

- 2章:Related work

- 3章:Lumiere

- 4章:Applications

- 5章:Evaluation and Comparisons

- 6章:Conclusion

- 7章:Societal Impact

- Acknowledgments

- References

- Appendix

Lumiere: A Space-Time Diffusion Model for Video Generationを解説しつつ,私の考えも語ります.

Lumiere: A Space-Time Diffusion Model for Video Generationの概要と私の日本語訳は以下になります.

We introduce Lumiere – a text-to-video diffusion model designed for synthesizing videos that portray realistic, diverse and coherent motion – a pivotal challenge in video synthesis.

動画合成における極めて重要な課題である,リアルで多様かつ一貫性のある動きを描写する動画を合成するために設計された,text-to-videoの拡散モデルであるLumiereを紹介する.To this end, we introduce a Space-Time U-Net architecture that generates the entire temporal duration of the video at once, through a single pass in the model.

この目的を達成するために,我々はSpace-Time U-Netアーキテクチャを導入し,モデルのシングルパスを通して,動画の全時間的持続時間を一度に生成する.This is in contrast to existing video models which synthesize distant keyframes followed by temporal super-resolution – an approach that inherently makes global temporal consistency difficult to achieve.

これは,離れたキーフレームを合成し,その後に時間的超解像を行う既存の動画モデルとは対照的である.このアプローチは,本質的にグローバルな時間的一貫性を達成することを困難にする.By deploying both spatial and (importantly) temporal down- and up-sampling and leveraging a pre-trained text-to-image diffusion model, our model learns to directly generate a fullframe-rate, low-resolution video by processing it in multiple space-time scales.

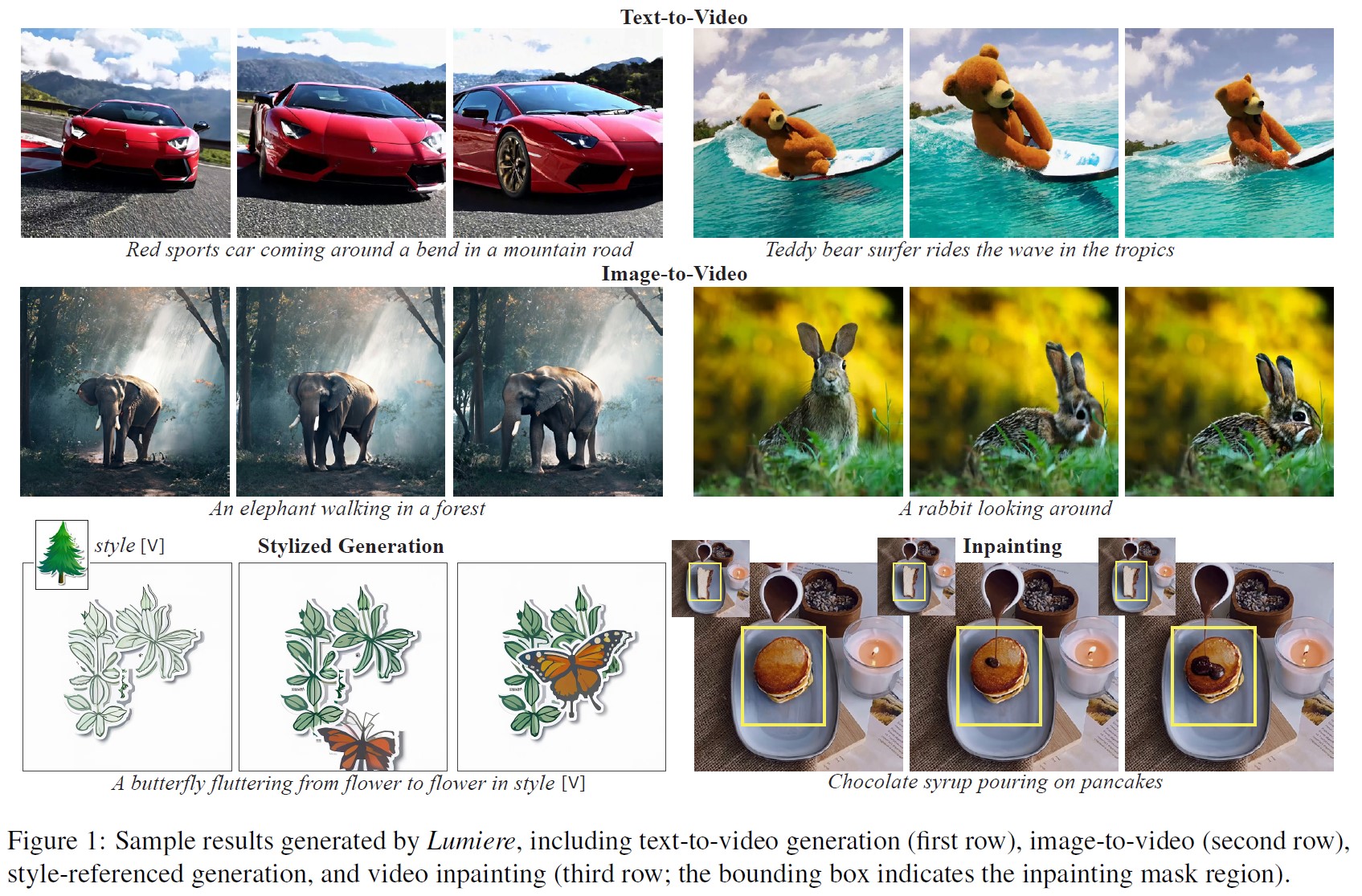

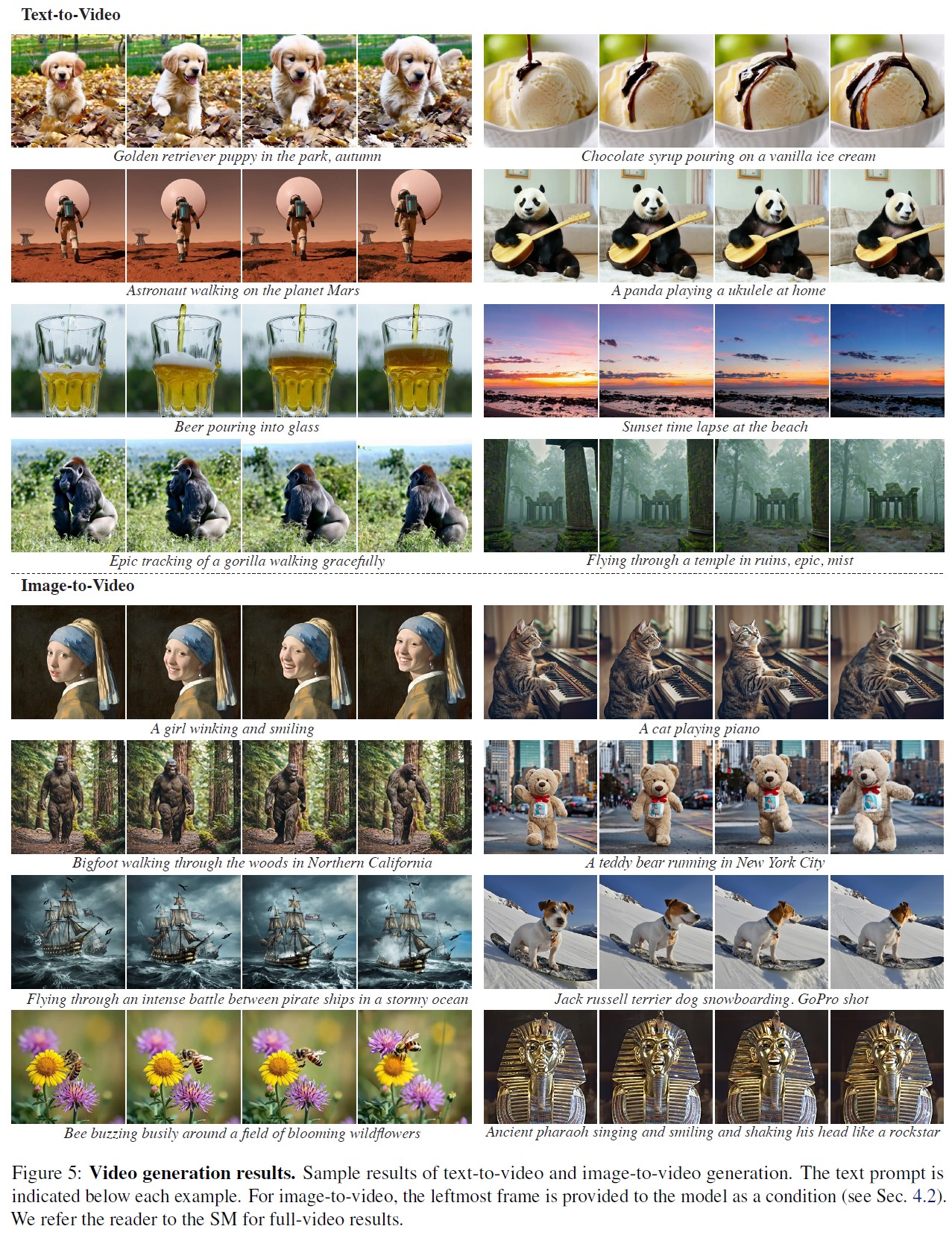

空間的および(重要な)時間的ダウンサンプリングとアップサンプリングの両方を導入し,事前訓練されたtext-to-imageの拡散モデルを活用することで,我々のモデルは,複数の時空間スケールで処理することにより,フルフレームレートの低解像度動画を直接生成することを学習する.We demonstrate state-of-the-art text-to-video generation results, and show that our design easily facilitates a wide range of content creation tasks and video editing applications, including image-to-video, video inpainting, and stylized generation.

我々は,最先端のtext-to-videoの生成結果を実証し,我々の設計が,image-to-video,動画のインペインティング,定型化された生成など,幅広いコンテンツ作成タスクや動画編集アプリケーションを容易に促進することを示す.https://arxiv.org/abs/2401.12945

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Acknowledgements」(謝辞)は省略していること

- 本文中に登場する表記「(Saharia et al., 2022b; Ramesh et al., 2022; Rombach et al., 2022)」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Lumiere: A Space-Time Diffusion Model for Video Generationの本文を読みすすめましょう!

1章:Introduction(はじめに)

画像の生成モデルは,近年著しい進歩を遂げている.

最先端のtext-to-image(T2I)拡散モデルは現在,複雑なテキストプロンプトに従う高解像度のフォトリアリスティック画像を合成することが可能であり(Saharia et al., 2022b; Ramesh et al., 2022; Rombach et al., 2022),幅広い画像編集機能(Po et al., 2023)やその他の下流での利用を可能にしている.

しかし,大規模なtext-to-video(T2V)基礎モデルの訓練は,動きがもたらす複雑さのために,依然として未解決の課題である.

自然な動きをモデル化する際にエラーの影響を受けやすいだけでなく,時間的なデータ次元が追加されることで,メモリと計算要件,さらにこの複雑な分布を学習するために必要な訓練データの規模という点で,大きな課題が生じる.

その結果,T2Vモデルは急速に改善されつつあるが,既存のモデルは,動画時間,全体的なビジュアル品質,および生成できるリアルな動きの程度という点で,まだ制限されている.

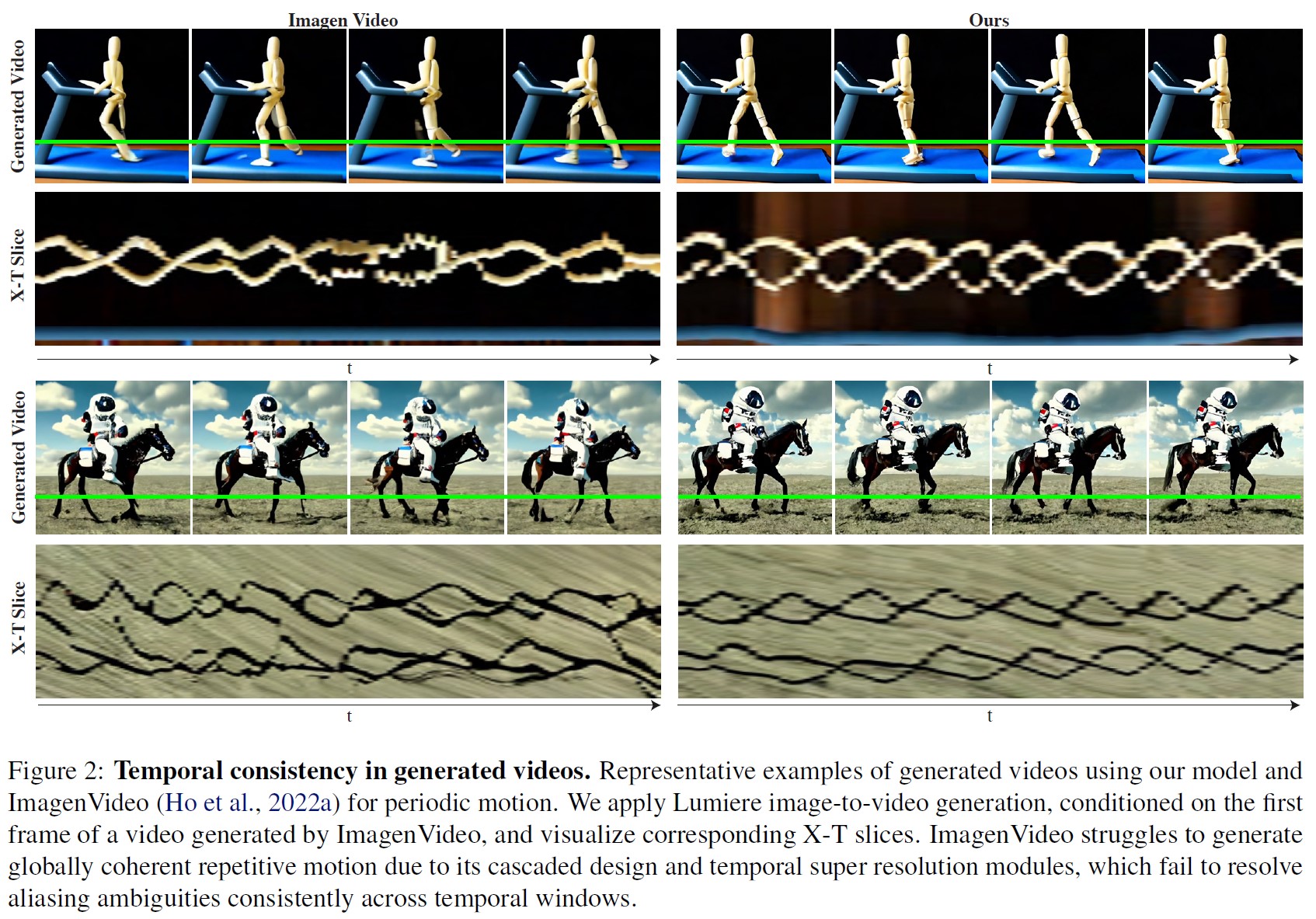

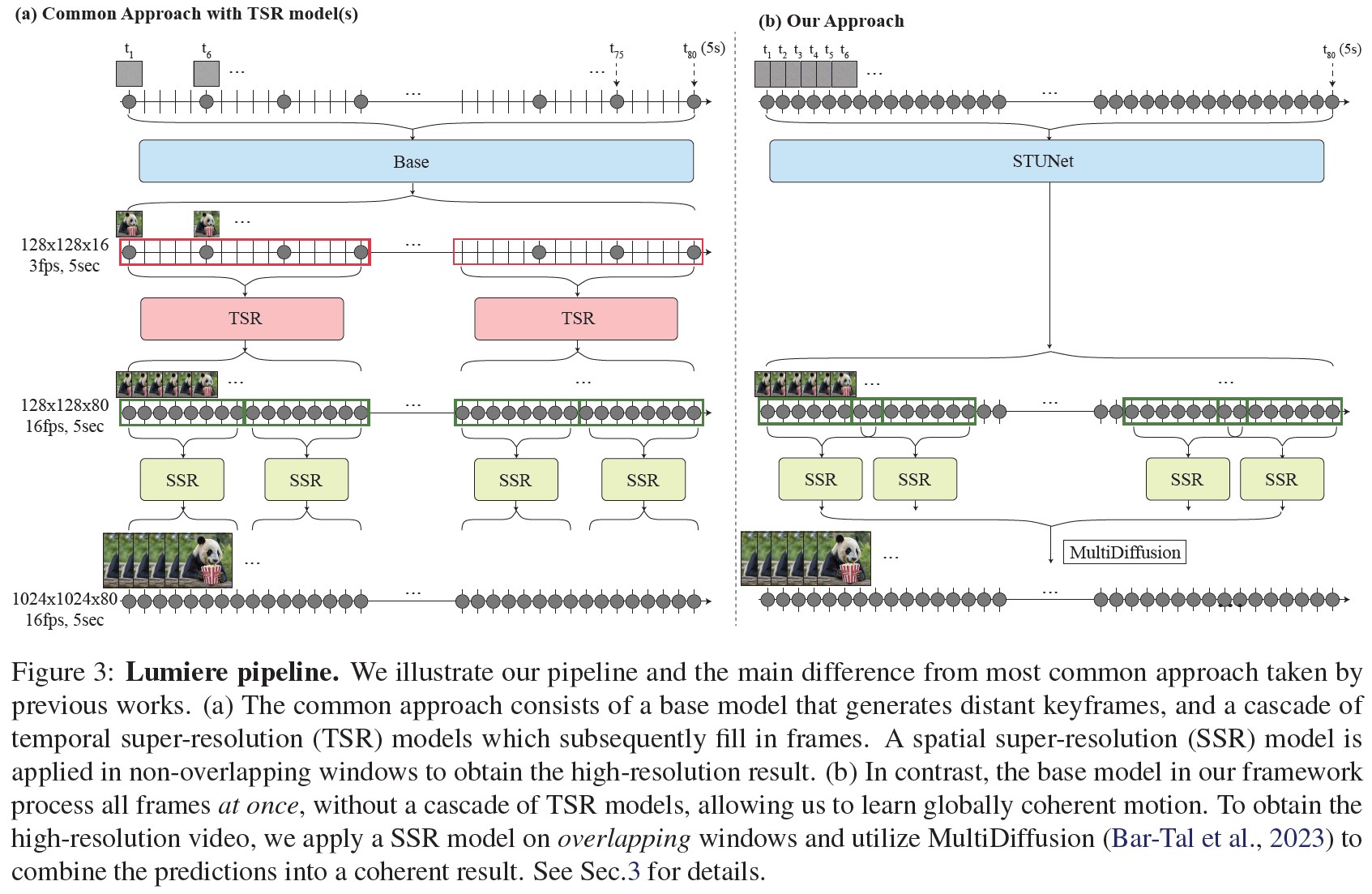

既存のT2Vモデルの一般的なアプローチは,ベースモデルが離れたキーフレームを生成し,後続の時間的超解像(TSR:Temporal Super-Resolution)モデルがキーフレーム間の欠損データを非重複セグメントで生成するカスケード設計を採用することである.

メモリ効率は良いが,時間的カスケードを使用してグローバルに一貫性のある動きを生成する能力は,以下の理由により本質的に制限される.

- ベースモデルは,積極的にサブサンプリングされたキーフレームのセットを生成するため,速い動きが時間的にエイリアスになり,あいまいになる.

- TSRモジュールは固定された小さな時間コンテキストウィンドウに制約されるため,動画の全期間にわたって一貫してエイリアシングのあいまいさを解決することができない(図2に歩行などの周期的な動きを合成する場合を示す).

- カスケード訓練法は一般的にドメインギャップに悩まされる.TSRモデルはダウンサンプリングされた実際の動画フレームで訓練されるが,推論時には生成されたフレームを補間するために使用されるため,誤差が蓄積される.

ここでは,動画の全時間的持続時間を一度に生成する新しいT2V拡散フレームワークを導入することで,異なるアプローチをとる.

これは,空間と時間の両方で信号をダウンサンプリングすることを学習し,その計算の大部分をコンパクトな時空間表現で実行するSpace Time U-Net(STUNet)アーキテクチャを使用することによって達成される.

このアプローチにより,1つのベースモデルで16fps(または5秒,これは多くのメディアにおける平均的なショット時間(Cutting & Candan, 2015)よりも長い)で80フレームを生成することができ,先行研究と比較してよりグローバルに一貫性のある動きにつながる.

驚くべきことに,この設計上の選択は,これまでのT2Vモデルでは見過ごされてきた.

T2Vモデルは,空間的なダウンサンプリング・アップサンプリング操作のみをアーキテクチャに含み,ネットワーク全体にわたって一定の時間分解能を維持するという慣例に従っている(Ho et al., 2022b; Ho et al., 2022a; Singer et al., 2022; Ge et al., 2023; Blattmann et al., 2023b; Wang et al., 2023a; Guo et al., 2023; Zhang et al., 2023a; Girdhar et al., 2023; Po et al., 2023).

T2Iモデルの強力な生成的事前分布を利用するため,我々は,事前訓練された(そして固定された)T2Iモデルの上にLumiereを構築するというトレンドに従う(Hong et al., 2022; Singer et al., 2022; Saharia et al., 2022b).

我々の場合,T2Iモデルはピクセル空間で動作し,ベースモデルに続いて空間超解像(SSR:Spatial Super-Resolution)カスケードで構成される.

SSRネットワークは高空間解像度で動作するため,それを動画時間全体に適用することは,メモリ要件の点で実行不可能である.

一般的なSSRソリューションは,動画を重複しないセグメントに分割し,結果をつなぎ合わせる時間的ウィンドウアプローチを使用する.

しかし,これではウィンドウ間の境界で見た目に矛盾が生じる可能性がある(Girdhar et al., 2023).

我々は,パノラマ画像生成における大域的連続性を達成するために提案されたアプローチであるMultidiffusion(Bar-Tal et al., 2023)を時間領域に拡張することを提案しする.

時間ウィンドウの空間超解像を計算し,結果を動画クリップ全体にわたる大域的に一貫性のある解に集約する.

※訳注:図5がここで参照されているため,番号順ではないですが,こちらに記載します.

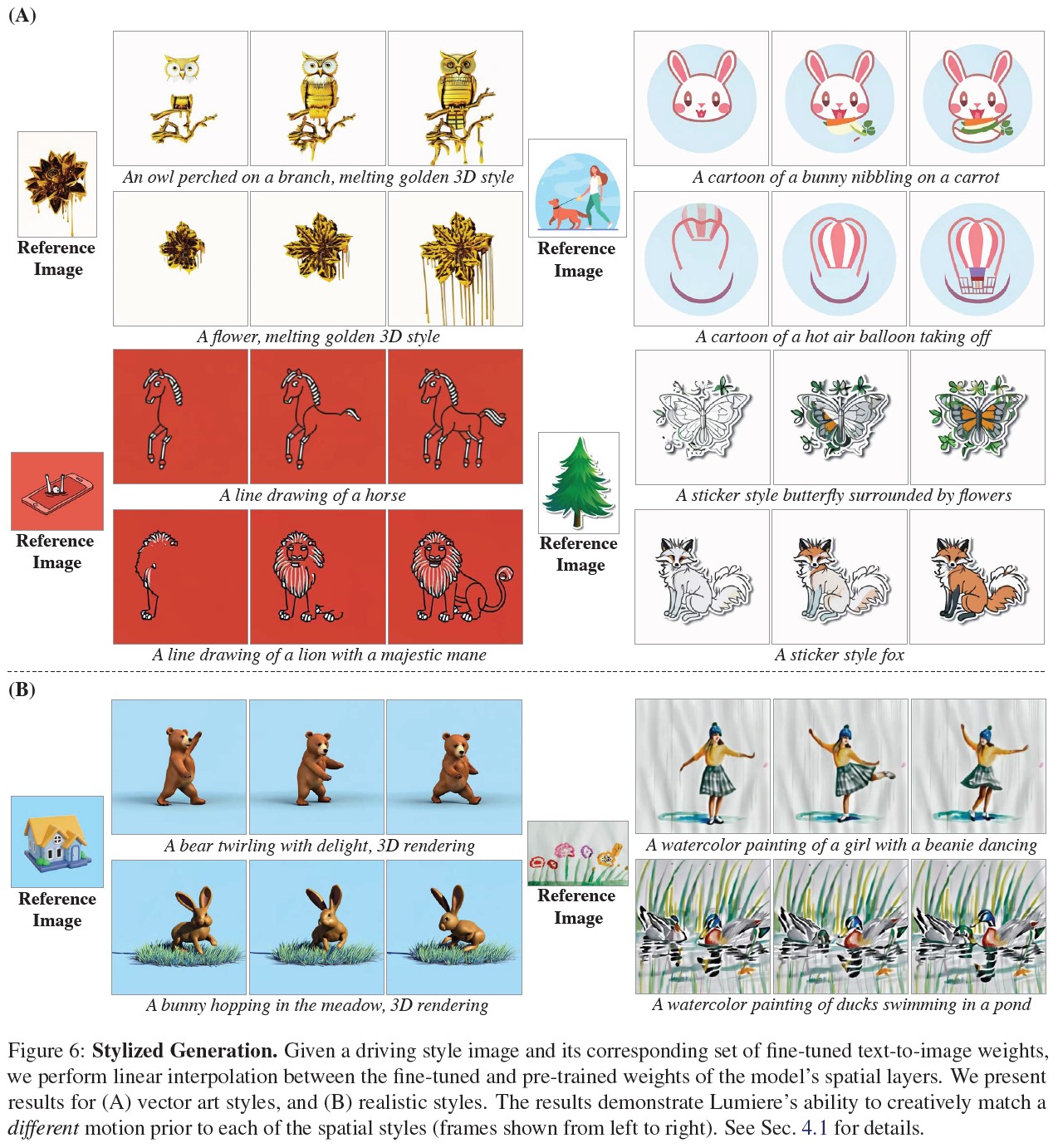

我々は,最先端の動画生成結果を示し,動画のインペインティング(図7),image-to-videoの生成(図5),または与えられたスタイル画像に準拠したスタイル化された動画の生成(図6)を含む,多くの動画コンテンツ作成タスクにLuimereを簡単に適応させる方法を示す.

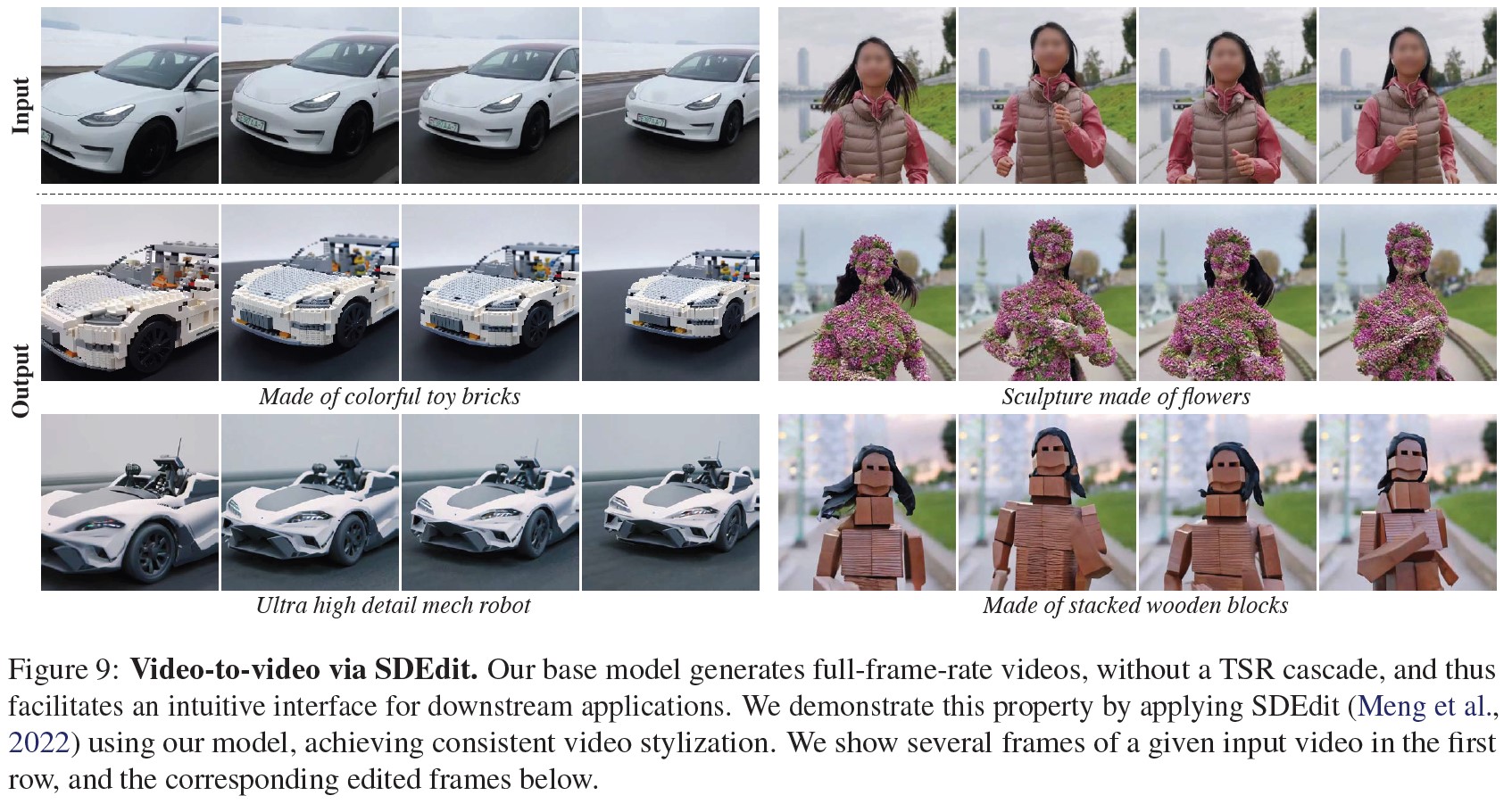

最後に,動画全体を一度に生成することで,市販の編集方法を簡単に呼び出して一貫した編集を行うことができることを示す(図9).

2章:Related work(関連研究)

text-to-imageの生成:

text-to-image(T2I)生成のための一般的なアプローチのほとんどは,拡散モデルに基づいている(Sohl-Dickstein et al., 2015; Ho et al., 2020; Song et al., 2020).

このうち,DALL-E2(Ramesh et al., 2022)とImagen(Saharia et al., 2022b)は,カスケード拡散モデルを用いてフォトリアリスティックなtext-to-imageの生成を実現し,Stable Diffusion(Rombach et al., 2022)は,圧縮された低次元の潜在空間での生成を行う.

有望な一連の研究は,空間的超解像カスケードシステムや固定された事前訓練潜在空間なしで,高解像度画像をエンドツーエンドで生成するT2I拡散モデルを設計している(Hoogeboom et al., 2023; Gu et al., 2023; Chen, 2023).

ここでは,T2Vモデルで一般的な時間的カスケードを避け,一度に全フレーム期間を生成するT2Vモデルを設計する.

text-to-videoの生成:

近年,自己回帰Transformer(例:(Villegas et al., 2023; Wu et al., 2022; Hong et al., 2022; Kondratyuk et al., 2023))や拡散モデル(例:(Ho et al., 2022a; Ho et al., 2022b))を用いて,大規模なT2Vモデルを大規模なデータセットで訓練する取り組みが活発に行われている.

T2V生成のための著名なアプローチは,そのアーキテクチャに時間層を挿入することによって,事前訓練されたT2Iモデルを「膨張」させ,動画データ上で,それらのみ,またはオプションとしてモデル全体をファインチューニングすることである(Singer et al., 2022; Blattmann et al., 2023b; Girdhar et al., 2023; Ge et al., 2023; Yuan et al., 2024).

PYoCo(Ge et al., 2023)は動画ノイズの事前分布を注意深く設計し,動画生成のためのT2Iモデルをファインチューニングするためのより良い性能を得る.

VideoLDM(Blattmann et al., 2023b)とAnimateDiff (Guo et al., 2023)は,StableDiffusion(Rombach et al., 2022)を膨張させ,新たに追加された時間層のみを訓練し,パーソナライズされたT2Iモデルの重みと組み合わせることができることを示している.

興味深いことに,既存のインフレーションスキームでは,ネットワーク全体で一定の時間分解能を維持することが一般的であるため,フルレングスのクリップを処理する能力が制限される.

この研究では,空間と時間の両方で動画をダウンサンプリングする学習と,ネットワークの圧縮された時空間特徴空間で計算の大部分を実行することを含む,新しいインフレーションスキームを設計する.

我々はImagen T2I(Saharia et al., 2022b)を拡張しているが,我々のアーキテクチャの貢献は潜在拡散にも利用可能であり,拡散ノイズスケジューラ(Ge et al., 2023)や動画データキュレーション(Blattmann et al., 2023a)の改良の可能性とは直交するものである.

3章:Lumiere

我々は生成アプローチとして拡散確率モデルを利用する(Sohl-Dickstein et al., 2015; Croitoru et al., 2023a; Dhariwal & Nichol, 2021; Ho et al., 2020; Nichol & Dhariwal, 2021).

これらのモデルは,一連のノイズ除去ステップを通じて,データ分布(我々の場合,動画上の分布)を近似するように訓練される.

ガウシアン独立同一分布のノイズサンプルからスタートし,近似されたターゲット分布から引き出されたクリーンサンプルに到達するまで,拡散モデルは徐々にノイズ除去を行う.

拡散モデルは,テキスト埋め込みや空間条件付け(例えば,深度マップ)などの追加的なガイド信号を組み込むことによって,条件付き分布を学習することができる(Dhariwal & Nichol, 2021; Saharia et al., 2022a; Croitoru et al., 2023b; Zhang et al., 2023b).

(a)一般的なアプローチは,離れたキーフレームを生成するベースモデルと,その後にフレームを埋める時間的超解像(TSR:Temporal Super-Resolution)モデルのカスケードから構成される.空間超解像(SSR:Spatial Super-Resolution)モデルは,高解像度の結果を得るために,重ならないウィンドウで適用される.

(b)対照的に,我々のフレームワークの基本モデルは,TSRモデルのカスケードなしで,全てのフレームを一度に処理する.これにより,グローバルに一貫性のある動きを学習することができる.高解像度の動画を得るために,重なり合ったウィンドウにSSRモデルを適用し,MultiDiffusion(Bar-Tal et al., 2023)を利用して,予測を一貫性のある結果にまとめる.

詳細は3章を参照されたい.

我々のフレームワークはベースモデルと空間超解像(SSR:Spatial Super-Resolution)モデルから構成される.

図3bに示すように,ベースモデルは粗い空間分解能でフルクリップを生成する.

ベースモデルの出力は,時間を考慮したSSRモデルを用いて空間的にアップサンプリングされ,高解像度の動画となる.

次に,我々のアーキテクチャにおける主要な設計上の選択について説明し,様々なダウンストリームアプリケーションに対する我々のフレームワークの適用可能性を示す.

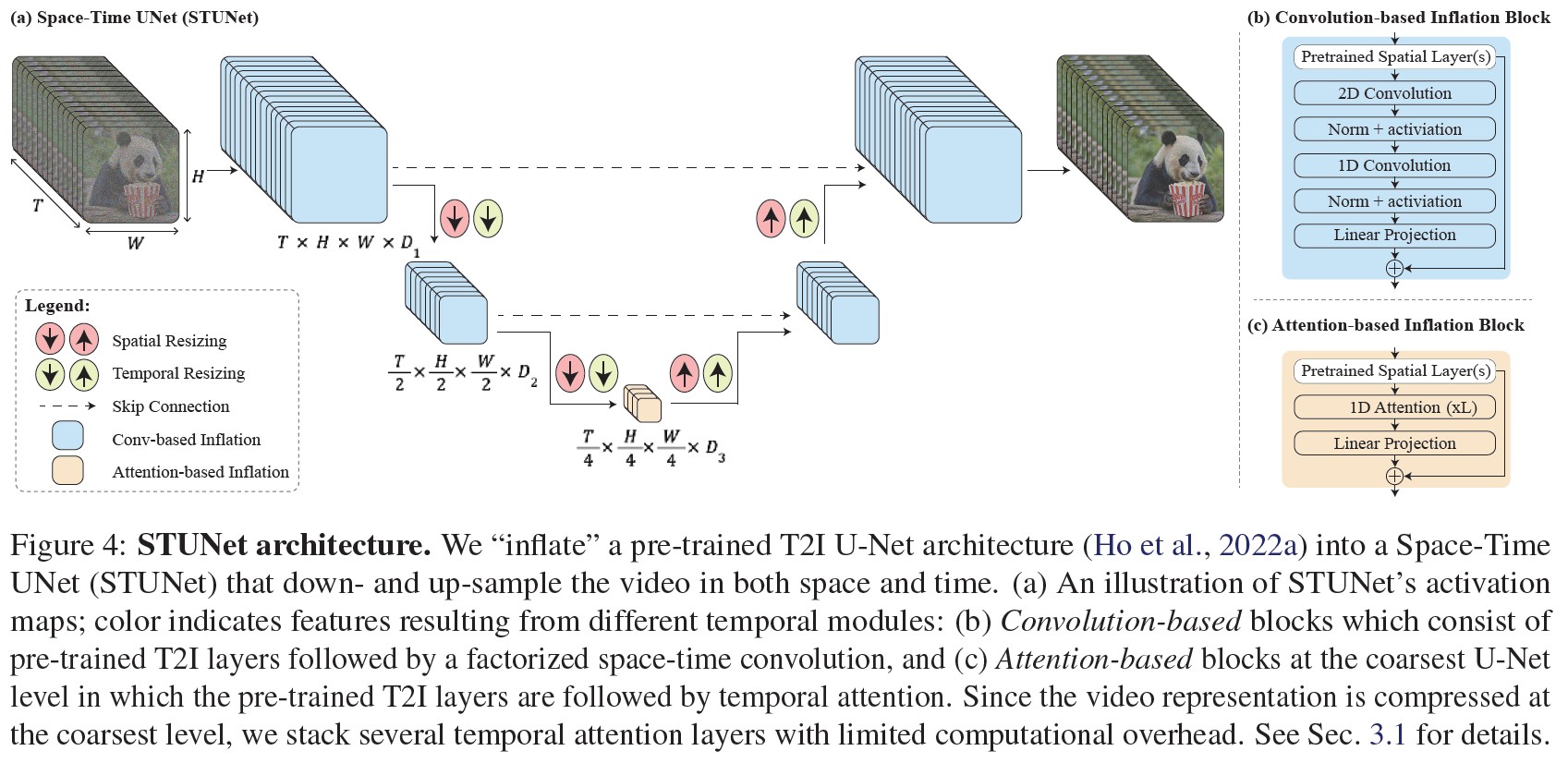

3.1節:Space-Time U-Net(STUnet)

我々の問題を計算しやすくするために,入力信号を空間的にも時間的にもダウンサンプリングし,このコンパクトな時空間表現で計算の大部分を実行するSpace-Time U-Netの使用を提案する.

(Cicek et al., 2016)は,U-Netアーキテクチャ(Ronneberger et al., 2015)を一般化し,3Dプーリング演算を含めることで,ボリュームメトリックなバイオメディカルデータの効率的な処理を実現している.

(a)STUNetの活性化マップの説明図.色は異なる時間モジュールから得られる特徴を示す.

(b)畳み込みベースのブロックは,事前訓練されたT2I層と,それに続く因数分解された時空間畳み込みで構成される.

(c)最も粗いU-NetレベルのAttentionベースのブロックでは,事前訓練されたT2I層の後にTemporal Attentionが続く.

動画表現は最も粗いレベルで圧縮されるため,計算オーバーヘッドを抑えながら複数のTemporal Attentionを積み重ねる.詳細は3.1節を参照されたい.

我々のアーキテクチャを図4に示す.

T2Iアーキテクチャでは,時間ブロックをインターリーブし,事前訓練された各空間リサイジングモジュールに続いて,時間ダウンサンプリングモジュールと時間アップサンプリングモジュールを挿入する(図4a).

時間ブロックには,Temporal Convolution(図4b)とTemporal Attention(図4c)が含まれる.

具体的には,最も粗いレベルを除くすべてのレベルにおいて,因数分解された時空間畳み込み(図4b)を挿入する.

これにより,計算コストを削減しながら,完全3次元畳み込みと比較してネットワークの非線形性を増加させ,1次元畳み込みと比較して表現力を増加させることができる(Tran et al., 2018).

Temporal Attentionの計算要件はフレーム数に対して2次関数的にスケールするため,動画の時空間圧縮表現を含む最も粗い解像度でのみTemporal Attentionを取り入れる.

低次元の特徴マップ上で動作することで,限られた計算オーバーヘッドで複数のTemporal Attentionブロックを積み重ねることができる.

(Blattmann et al., 2023b; Guo et al., 2023)と同様に,新たに追加されたパラメータを訓練し,事前訓練されたT2Iの重みは固定する.

注目すべきは,一般的なインフレーションアプローチでは,初期化時にT2Vモデルが事前訓練済みT2Iモデルと等価であること,すなわち,独立した画像サンプルの集まりとして動画を生成することが保証されることである.

しかし,我々の場合,時間的なダウンサンプリングモジュールとアップサンプリングモジュールのため,この性質を満たすことは不可能である.

我々は経験的に,これらのモジュールが最近傍ダウンサンプリングとアップサンプリング操作を行うように初期化することで,(損失関数の観点から)良い出発点が得られることを発見した.

3.2節:Multidiffusion for Spatial-Super Resolution(空間超解像のための多重拡散)

メモリ制約のため,膨張したSSRネットワークは動画の短いセグメントでしか動作しない.

時間的境界のアーチファクトを避けるため,時間軸に沿ってMultidiffusion(Bar-Tal et al., 2023)を用いることで,時間セグメント間のスムーズな遷移を実現する.

各生成ステップで,ノイズの多い入力動画\(J \in \mathbb{R}^{H*W*T*3}\)を,重複するセグメント\(\{J_i\}_{i=1}^N\)に分割する.

ここで,\(J \in \mathbb{R}^{H*W*T'*3}\)は,時間的持続時間\(T'<T\)を持つi番目のセグメントである.

セグメントごとのSSR予測\(\{\Phi(J_i)\}_{i =1}^N\)を調整するために,ノイズ除去ステップの結果を最適化問題の解と定義する.

$$\underset{J'}{\arg \min} \sum_{i=1}^n ||J' - \Phi (J_i) ||^2$$

この問題に対する解は,重複するウィンドウ上の予測値を線形結合することによって与えられる.

4章:Applications(アプリケーション)

TSRカスケードがないことで,Lumiereを下流のアプリケーションに拡張することが容易になる.

特に,我々のモデルは,既製のT2Vモデルを必要とするダウンストリームアプリケーションに直感的なインターフェースを提供する(例:(Meng et al., 2022; Poole et al., 2023; Gal et al., 2023)).

SDEdit(Meng et al., 2022)を使ってvideo-to-videoの編集を行うことで,この特性を実証する(図9参照).

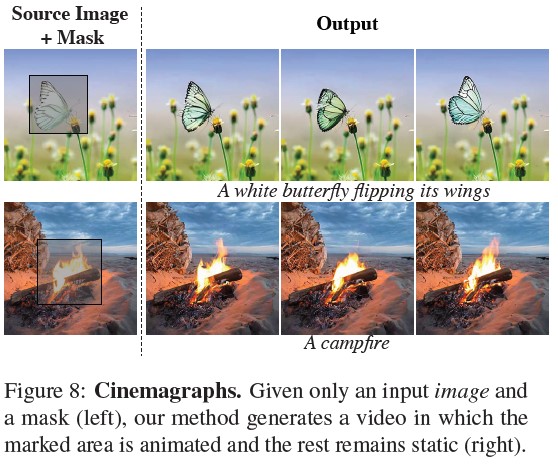

次に,スタイル条件付き生成,image-to-video,インペインティングとアウトペインティング,シネマグラフなど,このようなアプリケーションの数々について説明する.

図6~9に例となるフレームを示し,完全な動画結果については我々のウェブページの補足資料(SM:Supplementary Material)を参照されたい.

4.1節:Stylized Generation(スタイライズされた生成)

新たに追加された時間層のみを訓練し,事前訓練されたT2I重みは固定したままであることを思い出してほしい.

以前の研究では,T2I重みを特定のスタイル用にカスタマイズされたモデルで置き換えることで,希望するスタイルの動画を生成できることが示されている(Guo et al., 2023).

この単純な「プラグアンドプレイ」アプローチでは,歪んだ動画や静的な動画が生成されることが多く(SM参照),これは時間層への入力の分布が,ファインチューニングされた空間層から大きくずれていることが原因であると仮説を立てている.

GANベースの補間アプローチ(Pinkney & Adler, 2020)の成功に触発され,ファインチューニングされたT2I重み\(W_{style}\)と元のT2I重み\(W_{orig}\)の間を線形補間することで,スタイルと動きのバランスをとることを選択する.

具体的には,\(W_{interpolate} = \alpha \cdot W_{style} + (1 - \alpha) \cdot W_{orig}\)として補間ウェイトを構成する.

補間係数\(\alpha \in [0.5, 1]\)は,スタイルに忠実で,もっともらしい動きを描写する動画を生成するために,実験では手動で選択する.

図6は,(Sohn et al., 2023)の様々なスタイルに対するサンプル結果を示している.

「水彩画」のようなより現実的なスタイルが現実的な動きをもたらす一方で,ベクトルアートスタイルに由来する他の,より現実的でない空間的事前分布は,対応する独特の非現実的な動きをもたらす.

例えば,「線画」スタイルでは,鉛筆のストロークが描写されたシーンを「描く」ようなアニメーションになり,「カートゥーン」スタイルでは,コンテンツが徐々に「飛び出して」シーンを構成するようなアニメーションになる(完全な動画はSMを参照).

4.2節:Conditional Generation(条件付き生成)

(Blattmann et al., 2023b; Wang et al., 2023b)と同様に,追加入力信号(例えば画像やマスク)を条件とする動画生成に我々のモデルを拡張する.

これは,ノイジー動画\(J \in \mathbb{R}^{T*H*W*3}\)と駆動テキストプロンプトに加えて,2つの信号を入力とするようにモデルを修正することで実現する.

具体的には,マスクされたコンディショニング動画\(C \in \mathbb{R}^{T*H*W*3}\)とそれに対応するバイナリマスク\(M \in \mathbb{R}^{T*H*W*1}\)を追加し,モデルへの全体的な入力が連結テンソル\(\langle J, C, M \rangle \in \mathbb{R}^{T*H*W*7}\)となるようにする.

変更された入力形状に対応するため,第一畳み込み層のチャンネル次元を3から7に拡張し,C,Mに基づいてJをノイズ除去するようにベースT2Vモデルをファインチューニングする.

このファインチューニングの過程で,Jを訓練動画のノイズバージョンとし,Cをクリーン動画のマスクバージョンとする.

これにより,モデルは,Cのマスクされていない情報を出力動画にコピーする一方で,マスクされたコンテンツのみをアニメーション化することを学習するようになる.

image-to-video:

この場合,動画の最初のフレームが入力として与えられる.

コンディショニング信号Cは,この最初のフレームと,残りの動画のブランクフレームを含む.

対応するマスクMは,最初のフレームに対して1(すなわちマスクされていないコンテンツ)を含み,残りの動画に対して0(すなわちマスクされたコンテンツ)を含む.

図1と図5は画像条件付き生成のサンプル結果である(詳細な結果はSMを参照).

我々のモデルは,所望の最初のフレームで始まり,動画の持続時間全体にわたって複雑な一貫性のある動きを示す動画を生成する.

インペインティング:

ここで,条件付け信号は,ユーザから提供された動画Cと,動画の補完領域を記述するマスクMである.

インペインティングアプリケーションは,オブジェクトの置換/挿入(図1)だけでなく,局所的な編集(図7)にも使用できることに注意されたい.

その結果,マスクされた領域はシームレスかつ自然に完成し,その内容はテキストプロンプトによってガイドされる.

インペインティングとアウトペインティングの例については,SMを参照されたい.

シネマグラフ:

さらに,ユーザが指定した特定の領域内だけで,画像の内容をアニメーション化する応用も考える.

コンディショニング信号Cは,動画全体にわたって複製された入力画像である.

一方,マスクMは,最初のフレーム全体について1を含み(つまり,最初のフレームはマスクされていない),他のフレームについては,マスクは,ユーザが提供した領域の外側にのみ1を含む(つまり,他のフレームは,アニメーションしたい領域の内側でマスクされている).

図8とSMにサンプル結果を示す.

最初のフレームはマスクされないままなので,アニメーションされたコンテンツは,コンディショニング画像からの外観を維持するように促される.

5章:Evaluation and Comparisons(評価と比較)

30Mの動画とそのテキストキャプションを含むデータセットでT2Vモデルを訓練する.

動画の長さは80フレーム,16fps(5秒)である.

ベースモデルは128*128で学習され,SSRは1024*1024フレームを出力する.

多様なオブジェクトとシーンを説明する113のテキストプロンプトのコレクションで我々のモデルを評価する.

このプロンプトリストは,我々が組み立てた18のプロンプトと,先行研究(Singer et al., 2022; Ho et al., 2022a; Blattmann et al., 2023b)で使用された95のプロンプトから構成される(付録B参照).

さらに,5.2節で詳述するように,UCF101データセット(Soomro et al., 2012)のZero-Shot評価プロトコルを採用する.

図1と図5にtext-to-videoの生成を示す.

本手法は,複雑な物体の動き(例:図5の歩く宇宙飛行士)と一貫性のあるカメラの動き(例:図1の車の例)の両方を描写する高品質な動画を生成する.

フル動画の結果についてはSMを参照されたい.

ベースライン:

本手法を著名なT2V拡散モデルと比較する.

(i)ImagenVideo(Ho et al., 2022a)は,ピクセル空間で動作し,7つのモデル(ベースモデル,3つのTSRモデル,3つのSSRモデル)のカスケードで構成されている.(ii)AnimateDiff(Guo et al., 2023),(iii)StableVideoDiffusion(SVD)(Blattmann et al., 2023a),および(iv)ZeroScope(Wang et al., 2023a)は,Stable Diffusion (Rombach et al., 2022)を膨張させ,動画データで訓練する.

AnimateDiffは16フレーム,ZeroScopeは36フレームしか出力しないことに注意されたい.

SVDはimage-to-videoモデルのみをリリースしており,これは25フレームを出力し,テキストを条件としていない.

さらに,APIが利用可能な(v)Pika(Pika labs, 2023)と,(vi)Gen- 2(RunwayML, 2023)の商用T2Vモデルと比較する.

さらに,5.2節でクローズドソースのT2Vモデルとも定性的に比較する.

5.1節:Qualitative Evaluation(定性的評価)

図11に,我々のモデルとベースラインとの定性的比較を示す.

Gen-2(RunwayML, 2023)とPika(Pika labs, 2023)は,フレームごとの視覚的品質が高いことを確認した.

しかし,それらの出力は,非常に限られた動きの量によって特徴付けられ,しばしば静止画に近い動画になる.

ImagenVideo(Ho et al., 2022a)は,それなりの量の動きを生成するが,全体的なビジュアル品質は低い.

AnimateDiff(Guo et al., 2023)とZero-Scope(Wang et al., 2023a)は,顕著な動きを見せるが,視覚的なアーチファクトが発生しやすい.

さらに,それぞれ2秒と3.6秒という短い時間の動画を生成する.

対照的に,我々の方法は,時間的な一貫性と全体的な品質を維持しながら,より高い動きの大きさを持つ5秒間の動画を生成する.

5.2節:Quantitative Evaluation(定量的評価)

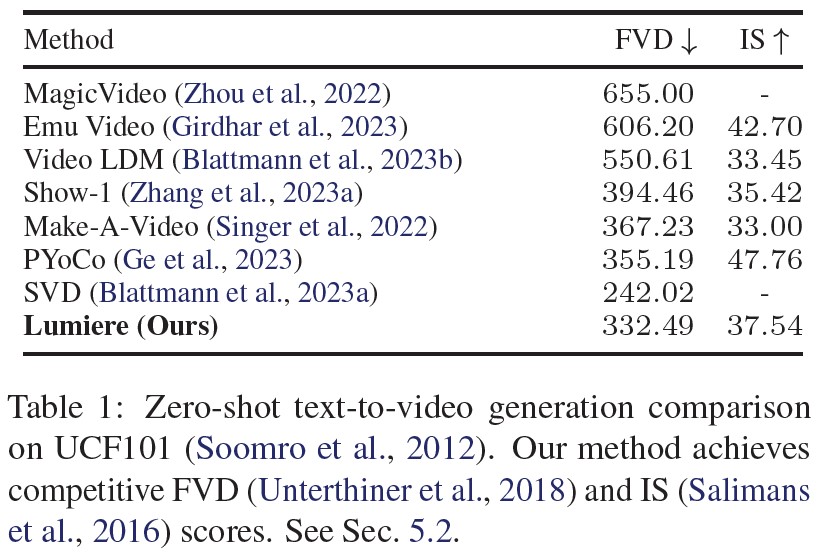

UCF101でのZero-Shot評価:

(Blattmann et al., 2023a)と(Ge et al., 2023)の評価プロトコルに従い,UCF101(Soomro et al., 2012)上でZero-Shot text-to-videoの生成のための我々の方法を定量的に評価する.

表1は我々の手法と先行研究のFrechet Video Distance(FVD)(Unterthiner et al., 2018)とInception Score(IS)(Salimans et al., 2016)を報告する.

我々は競争力のあるFVDとISスコアを達成する.

しかしながら,先行研究(例:(Girdhar et al., 2023; Ho et al., 2022a; Chong & Forsyth, 2020))で議論されているように,これらのメトリクスは人間の知覚を忠実に反映しておらず,低レベルの詳細(Parmar et al., 2022)や参照UCF101データとT2V訓練データ間の分布シフト(Girdhar et al., 2023)によって大きく影響を受ける可能性がある.

さらに,このプロトコルは生成された動画から16フレームのみを使用するため,長時間の動きを捉えることができない.

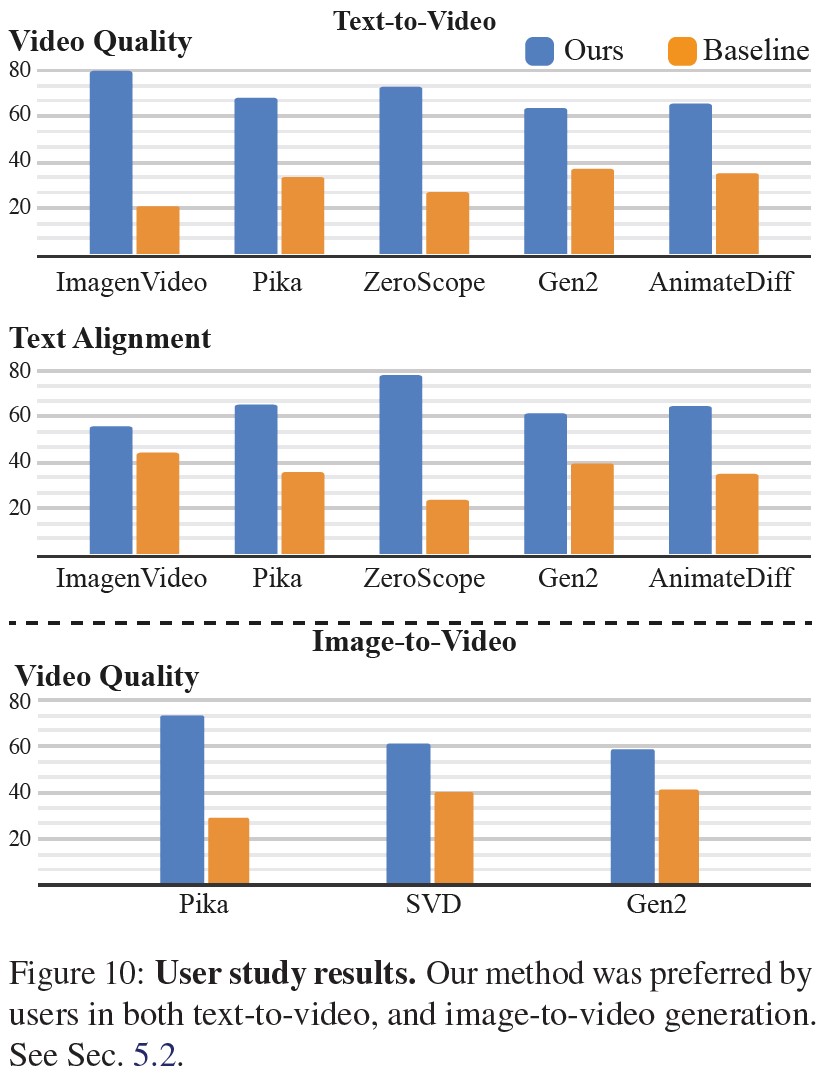

ユーザ調査:

我々は,先行研究(Kolkin et al., 2019; Zhang et al., 2018; Blattmann et al., 2023a; Rombach et al., 2022)で使用されている2代替強制選択(Two-alternative Forced Choice: 2AFC)プロトコルを採用した.

このプロトコルでは,参加者は無作為に選択された1組の動画を提示された.

1つは我々のモデルによって生成され,もう1つはベースライン手法の1つによって生成された.

そして参加者は,視覚的な品質と動きの点でより良いと思われる動画を選択するよう求められた.

さらに,より正確にターゲットテキストプロンプトと一致する動画を選択するよう求められた.

我々は,Amazon Mechanical Turk(AMT)プラットフォームを利用して,各ベースラインと質問について約400人のユーザの判断を収集した.

図10に示すように,我々の方法は,すべてのベースラインよりもユーザに好まれ,テキストプロンプトとのより良い整合を示した.

ZeroScopeとAnimateDiffは,それぞれ3.6秒と2秒の動画しか生成しないことに注意されたい.

そのため,ビデオと比較するときは,ビデオの再生時間に合わせてトリミングする.

さらに,Pika(Pika labs, 2023),StableVideoDiffusion(SVD)(Blattmann et al., 2023a),Gen2(RunwayML, 2023)に対して,我々のimage-to-videoモデル(4.2節参照)を比較するためのユーザ調査を実施する.

SVD image-to-videoモデルはテキストを条件としていないことに注意されたい.

従って,今回の調査は動画の質に焦点を当てる.

図10に見られるように,我々の方法はベースラインと比較してユーザに好まれた.

全評価プロトコルの詳細については,付録Bを参照されたい.

6章:Conclusion(結論)

我々は,事前訓練されたtext-to-imageの拡散モデルを利用した,新しいtext-to-videoの生成フレームワークを発表した.

我々は,まず離れたキーフレームを生成し,その後に時間的超解像モデルのカスケードを用いてそれらを補間するという一般的なアプローチにおいて,グローバルに一貫性のある動きを学習する際の固有の限界を特定した.

この課題に取り組むため,空間的,時間的ダウンサンプリングとアップサンプリングモジュールの両方を組み込むことで,フルフレームレートの動画クリップを直接生成するSpace-Time U-Netアーキテクチャ設計を導入した.

我々は,最先端の生成結果を実証し,image-to-video,動画のインペインティング,様式化された生成など,幅広いアプリケーションへの我々のアプローチの適用可能性を示した.

※訳注:原文のinapaintingはinpaintingの間違い.

限界としては,我々の方法は,複数のショットで構成される動画や,シーン間のトランジションを伴う動画を生成するようには設計されていない.

このようなコンテンツを生成することは,今後の研究課題である.

さらに,画素空間で動作するT2Iモデルの上に我々のモデルを構築したため,高解像度画像を生成するための空間超解像モジュールが必要となる.

とはいえ,我々の設計原理は潜在動画拡散モデル(Rombach et al., 2022)に適用可能であり,text-to-videoのモデル設計における更なる研究の引き金となり得る.

7章:Societal Impact(社会的影響)

我々の主な目標は,初心者ユーザが創造的かつ柔軟な方法でビジュアルコンテンツを生成できるようにすることである.

しかし,我々の技術には,偽のコンテンツや有害なコンテンツを作成するための悪用のリスクがあり,安全で公正な使用を保証するために,偏見や悪意のあるユースケースを検出するためのツールを開発し,適用することが重要であると考えている.

References(参考文献)

- (Bar-Tal et al., 2023) Bar-Tal, O., Yariv, L., Lipman, Y., and Dekel, T. Multi-Diffusion: Fusing diffusion paths for controlled image generation. In ICML, 2023.

- (Blattmann et al., 2023a) Blattmann, A., Dockhorn, T., Kulal, S., Mendelevitch, D., Kilian, M., Lorenz, D., Levi, Y., English, Z., Voleti, V., Letts, A., et al. Stable video diffusion: Scaling latent video diffusion models to large datasets. arXiv preprint arXiv:2311.15127, 2023a.

- (Blattmann et al., 2023b) Blattmann, A., Rombach, R., Ling, H., Dockhorn, T., Kim, S. W., Fidler, S., and Kreis, K. Align your latents: Highresolution video synthesis with latent diffusion models. In CVPR, 2023b.

- (Carreira & Zisserman, 2017) Carreira, J. and Zisserman, A. Quo vadis, action recognition? A new model and the kinetics dataset. In CVPR, pp. 6299–6308, 2017.

- (Chen, 2023) Chen, T. On the importance of noise scheduling for diffusion models. arXiv preprint arXiv:2301.10972, 2023.

- (Chong & Forsyth, 2020) Chong, M. J. and Forsyth, D. Effectively unbiased FID and Inception Score and where to find them. In CVPR, pp. 6070–6079, 2020.

- (Cicek et al., 2016) Cicek, O., Abdulkadir, A., Lienkamp, S. S., Brox, T., and Ronneberger, O. 3d u-net: learning dense volumetric segmentation from sparse annotation. In MICCAI, pp. 424–432. Springer, 2016.

- (Croitoru et al., 2023a) Croitoru, F.-A., Hondru, V., Ionescu, R. T., and Shah, M. Diffusion models in vision: A survey. IEEE T. Pattern Anal. Mach. Intell., 2023a.

- (Croitoru et al., 2023b) Croitoru, F.-A., Hondru, V., Ionescu, R. T., and Shah, M. Diffusion models in vision: A survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023b.

- (Cutting & Candan, 2015) Cutting, J. E. and Candan, A. Shot durations, shot classes, and the increased pace of popular movies, 2015.

- (Dhariwal & Nichol, 2021) Dhariwal, P. and Nichol, A. Diffusion models beat gans on image synthesis. NeurIPS, 2021.

- (Gal et al., 2023) Gal, R., Vinker, Y., Alaluf, Y., Bermano, A. H., Cohen- Or, D., Shamir, A., and Chechik, G. Breathing life into sketches using text-to-video priors. arXiv preprint arXiv:2311.13608, 2023.

- (Ge et al., 2023) Ge, S., Nah, S., Liu, G., Poon, T., Tao, A., Catanzaro, B., Jacobs, D., Huang, J.-B., Liu, M.-Y., and Balaji, Y. Preserve your own correlation: A noise prior for video diffusion models. In ICCV, pp. 22930–22941, 2023.

- (Girdhar et al., 2023) Girdhar, R., Singh, M., Brown, A., Duval, Q., Azadi, S., Rambhatla, S. S., Shah, A., Yin, X., Parikh, D., and Misra, I. Emu Video: Factorizing text-to-video generation by explicit image conditioning. arXiv preprint arXiv:2311.10709, 2023.

- (Gu et al., 2023) Gu, J., Zhai, S., Zhang, Y., Susskind, J., and Jaitly, N. Matryoshka diffusion models. arXiv preprint arXiv:2310.15111, 2023.

- (Guo et al., 2023) Guo, Y., Yang, C., Rao, A., Wang, Y., Qiao, Y., Lin, D., and Dai, B. AnimateDiff: Animate your personalized text-to-image diffusion models without specific tuning. arXiv preprint arXiv:2307.04725, 2023.

- (Ho et al., 2020) Ho, J., Jain, A., and Abbeel, P. Denoising diffusion probabilistic models. NeurIPS, 33:6840–6851, 2020.

- (Ho et al., 2022a) Ho, J., Chan,W., Saharia, C., Whang, J., Gao, R., Gritsenko, A., Kingma, D. P., Poole, B., Norouzi, M., Fleet, D. J., et al. Imagen video: High definition video generation with diffusion models. arXiv preprint arXiv:2210.02303, 2022a.

- (Ho et al., 2022b) Ho, J., Salimans, T., Gritsenko, A., Chan, W., Norouzi, M., and Fleet, D. J. Video diffusion models, 2022b.

- (Hong et al., 2022) Hong, W., Ding, M., Zheng, W., Liu, X., and Tang, J. CogVideo: Large-scale pretraining for text-tovideo generation via transformers. arXiv preprint arXiv:2205.15868, 2022.

- (Hoogeboom et al., 2023) Hoogeboom, E., Heek, J., and Salimans, T. Simple diffusion: End-to-end diffusion for high resolution images. In ICML, 2023.

- (Kolkin et al., 2019) Kolkin, N., Salavon, J., and Shakhnarovich, G. Style transfer by relaxed optimal transport and self-similarity. In CVPR, pp. 10051–10060, 2019.

- (Kondratyuk et al., 2023) Kondratyuk, D., Yu, L., Gu, X., Lezama, J., Huang, J., Hornung, R., Adam, H., Akbari, H., Alon, Y., Birodkar, V., et al. VideoPoet: A large language model for zeroshot video generation. arXiv preprint arXiv:2312.14125, 2023.

- (Meng et al., 2022) Meng, C., He, Y., Song, Y., Song, J., Wu, J., Zhu, J.-Y., and Ermon, S. SDEdit: Guided image synthesis and editing with stochastic differential equations. In ICLR, 2022.

- (Nichol & Dhariwal, 2021) Nichol, A. Q. and Dhariwal, P. Improved denoising diffusion probabilistic models. In ICML, pp. 8162–8171, 2021.

- (Parmar et al., 2022) Parmar, G., Zhang, R., and Zhu, J.-Y. On aliased resizing and surprising subtleties in gan evaluation. In CVPR, 2022.

- (Pika labs, 2023) Pika labs. https://www.pika.art/, 2023.

- (Pinkney & Adler, 2020) Pinkney, J. N. and Adler, D. Resolution dependent GAN interpolation for controllable image synthesis between domains. In Machine Learning for Creativity and Design NeurIPS 2020 Workshop, 2020.

- (Po et al., 2023) Po, R., Yifan, W., Golyanik, V., Aberman, K., Barron, J. T., Bermano, A. H., Chan, E. R., Dekel, T., Holynski, A., Kanazawa, A., et al. State of the art on diffusion models for visual computing. arXiv preprint arXiv:2310.07204, 2023.

- (Poole et al., 2023) Poole, B., Jain, A., Barron, J. T., and Mildenhall, B. Dream- Fusion: Text-to-3D using 2D diffusion. In ICLR, 2023.

- (Ramesh et al., 2022) Ramesh, A., Dhariwal, P., Nichol, A., Chu, C., and Chen, M. Hierarchical text-conditional image generation with CLIP latents. arXiv preprint arXiv:2204.06125, 2022.

- (Rombach et al., 2022) Rombach, R., Blattmann, A., Lorenz, D., Esser, P., and Ommer, B. High-resolution image synthesis with latent diffusion models. In CVPR, pp. 10684–10695, 2022.

- (Ronneberger et al., 2015) Ronneberger, O., Fischer, P., and Brox, T. U-Net: Convolutional networks for biomedical image segmentation. In MICCAI, pp. 234–241. Springer, 2015.

- (RunwayML, 2023) RunwayML. Gen-2. https://research.runwayml.com/gen2, 2023.

- (Saharia et al., 2022a) Saharia, C., Chan, W., Chang, H., Lee, C., Ho, J., Salimans, T., Fleet, D., and Norouzi, M. Palette: Image-to-image diffusion models. In ACM SIGGRAPH 2022 Conference Proceedings, pp. 1–10, 2022a.

- (Saharia et al., 2022b) Saharia, C., Chan,W., Saxena, S., Li, L., Whang, J., Denton, E. L., Ghasemipour, K., Gontijo Lopes, R., Karagol Ayan, B., Salimans, T., et al. Photorealistic text-to-image diffusion models with deep language understanding. NeurIPS, 35:36479–36494, 2022b.

- (Saito et al., 2020) Saito, M., Saito, S., Koyama, M., and Kobayashi, S. Train sparsely, generate densely: Memory-efficient unsupervised training of high-resolution temporal GAN. Int. J. Comput. Vision, 128(10-11):2586–2606, 2020.

- (Salimans et al., 2016) Salimans, T., Goodfellow, I., Zaremba, W., Cheung, V., Radford, A., and Chen, X. Improved techniques for training GANs. NIPS, 29, 2016.

- (Singer et al., 2022) Singer, U., Polyak, A., Hayes, T., Yin, X., An, J., Zhang, S., Hu, Q., Yang, H., Ashual, O., Gafni, O., et al. Make-a- Video: Text-to-video generation without text-video data. arXiv preprint arXiv:2209.14792, 2022.

- (Sohl-Dickstein et al., 2015) Sohl-Dickstein, J., Weiss, E., Maheswaranathan, N., and Ganguli, S. Deep unsupervised learning using nonequilibrium thermodynamics. In ICML, pp. 2256–2265, 2015.

- (Sohn et al., 2023) Sohn, K., Ruiz, N., Lee, K., Chin, D. C., Blok, I., Chang, H., Barber, J., Jiang, L., Entis, G., Li, Y., et al. StyleDrop: Text-to-image generation in any style. arXiv preprint arXiv:2306.00983, 2023.

- (Song et al., 2020) Song, Y., Sohl-Dickstein, J., Kingma, D. P., Kumar, A., Ermon, S., and Poole, B. Score-based generative modeling through stochastic differential equations. arXiv preprint arXiv:2011.13456, 2020.

- (Soomro et al., 2012) Soomro, K., Zamir, A. R., and Shah, M. UCF101: A dataset of 101 human actions classes from videos in the wild. arXiv preprint arXiv:1212.0402, 2012.

- (Tran et al., 2018) Tran, D., Wang, H., Torresani, L., Ray, J., LeCun, Y., and Paluri, M. A closer look at spatiotemporal convolutions for action recognition. In CVPR, pp. 6450–6459, 2018.

- (Unterthiner et al., 2018) Unterthiner, T., Van Steenkiste, S., Kurach, K., Marinier, R., Michalski, M., and Gelly, S. Towards accurate generative models of video: A new metric & challenges. arXiv preprint arXiv:1812.01717, 2018.

- (Villegas et al., 2023) Villegas, R., Babaeizadeh, M., Kindermans, P.-J., Moraldo, H., Zhang, H., Saffar, M. T., Castro, S., Kunze, J., and Erhan, D. Phenaki: Variable length video generation from open domain textual description. In ICLR, 2023.

- (Wang et al., 2023a) Wang, J., Yuan, H., Chen, D., Zhang, Y., Wang, X., and Zhang, S. Modelscope text-to-video technical report. arXiv preprint arXiv:2308.06571, 2023a.

- (Wang et al., 2023b) Wang, X., Yuan, H., Zhang, S., Chen, D., Wang, J., Zhang, Y., Shen, Y., Zhao, D., and Zhou, J. Videocomposer: Compositional video synthesis with motion controllability. arXiv preprint arXiv:2306.02018, 2023b.

- (Wu et al., 2022) Wu, C., Liang, J., Ji, L., Yang, F., Fang, Y., Jiang, D., and Duan, N. N¨uwa: Visual synthesis pre-training for neural visual world creation. In ECCV, pp. 720–736. Springer, 2022.

- (Yuan et al., 2024) Yuan, X., Baek, J., Xu, K., Tov, O., and Fei, H. Inflation with diffusion: Efficient temporal adaptation for text-tovideo super-resolution, 2024.

- (Zhang et al., 2023a) Zhang, D. J., Wu, J. Z., Liu, J.-W., Zhao, R., Ran, L., Gu, Y., Gao, D., and Shou, M. Z. Show-1: Marrying pixel and latent diffusion models for text-to-video generation. arXiv preprint arXiv:2309.15818, 2023a.

- (Zhang et al., 2023b) Zhang, L., Rao, A., and Agrawala, M. Adding conditional control to text-to-image diffusion models. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pp. 3836–3847, 2023b.

- (Zhang et al., 2018) Zhang, R., Isola, P., Efros, A. A., Shechtman, E., and Wang, O. The unreasonable effectiveness of deep features as a perceptual metric. In CVPR, pp. 586–595, 2018.

- (Zhou et al., 2022) Zhou, D., Wang, W., Yan, H., Lv, W., Zhu, Y., and Feng, J. MagicVideo: Efficient video generation with latent diffusion models. arXiv preprint arXiv:2211.11018, 2022.

Appendix

付録A:Qualitative Comparison(定性的比較)

我々の手法とベースラインの定性的な比較を行う(5.1節参照).

付録B:Evaluation Protocol(評価プロトコル)

付録B.1:User study(ユーザ調査)

text-to-video,image-to-videoの調査には,さまざまな対象や動作を含む113のテキストプロンプトを使用した.

95のプロンプトは,最近のさまざまなtext-to-videoの生成方法(Singer et al., 2022; Ho et al., 2022a; Blattmann et al., 2023b)から引用した.

残りのプロンプトは,複雑なシーンや動作を説明するために我々が作成したものである.

プロンプトの全リストは付録B.3を参照されたい.

各ベースラインメソッドについて,公式APIを通じてすべてのプロンプトの結果を生成した.

公平な比較を保証するために,我々のメソッドで結果を生成する際には,ランダムなシードを固定し,キュレーションなしで同じランダムなシードを使用してすべての結果を生成した.

さらに,(Girdhar et al., 2023)に従い,我々の動画の空間解像度と時間的持続時間をそれぞれのベースラインに合わせる.

空間的には,中央を切り取った後,512*512にリサイ ズし,時間的には,開始と終了をトリミングすることで,両動画の時間が最も短いものに一致するようにする.

参加者はそれぞれ,我々の方法とベースライン(ランダムに並べたもの)を10回並べて比較する.

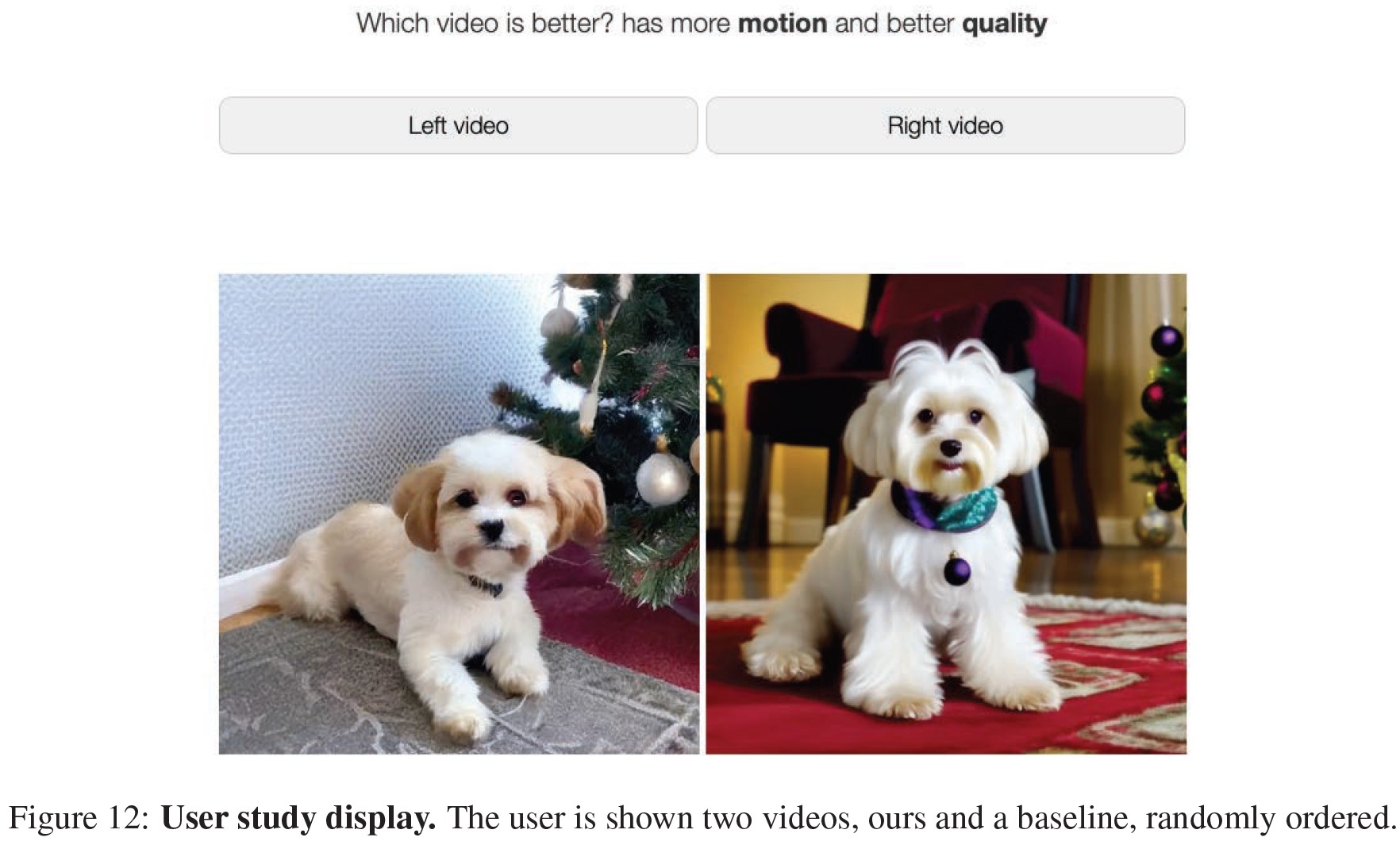

そして,参加者に「どちらの動画が次のテキストにマッチしますか?」と「どちらの動画が良いですか?より動きがあり,画質が良い.」と質問した.

ユーザが回答できるようにしたのは,動画をすべて見て,少なくとも3秒待って,「回答準備完了」というボタンを押した後である(図12).

信頼できる回答を保証するために,調査中にいくつかの警戒テストを行う.

- 実際の動画 vs. 完全なランダムノイズ

- 静止画像 vs. 実際の動画

付録B.2:Zero-shot evaluation on UCF101(UCF101のZero-Shot評価)

Frechet Video Distance(FVD)を計算するために,UCF101データセットのクラス分布に従って10,235本の動画を生成した.

動画の生成には(Ge et al., 2023)のプロンプトセットと同じものを用いる.

全ての動画を244*244の解像度にリサイズした後,動画の最初の16フレームのI3Dエンベッディング(Carreira & Zisserman, 2017)を抽出する.

そして,我々の動画のI3DエンベッディングとUCF101の動画のI3Dエンベッディングの間のFVDスコアを計算する.

Inception Score(IS)を計算するために,C3Dエンベッディング(Saito et al., 2020)を抽出するために,同じ生成動画を使用する.

付録B.3:List of prompts used for the user study evaluation(ユーザ調査の評価に使用したプロンプトのリスト)

- ”A bear is giving a presentation in classroom.”「教室でプレゼンテーションをするクマ.」

- ”A bear wearing sunglasses and hosting a talk show.”「サングラスをかけてトークショーの司会をするクマ.」

- ”A beautiful sunrise on mars, Curiosity rover. High definition, timelapse, dramatic colors.”「火星の美しい日の出,キュリオシティ探査機.高解像度,タイムラプス,ドラマチックな色彩.」

- ”A beautiful sunrise on mars. High definition, timelapse, dramatic colors.”「火星の美しい日の出.高解像度,タイムラプス,劇的な色彩.」

- ”A bicycle on top of a boat.”「ボートの上に乗った自転車.」

- ”A big moon rises on top of Toronto city.”「トロントの街の上に昇る大きな月.」

- ”A bigfoot walking in the snowstorm.”「吹雪の中を歩くビッグフット.」

- ”A burning volcano.”「燃え盛る火山.」

- ”A car moving slowly on an empty street, rainy evening, van Gogh painting.”「誰もいない道をゆっくり走る車,雨の夕方,ゴッホの絵.」

- ”A cat wearing sunglasses and working as a lifeguard at a pool.”「サングラスをかけ,プールでライフガードとして働く猫.」

- ”A confused grizzly bear in calculus class.”「微積分の授業で混乱するグリズリーベア.」

- ”A cute happy Corgi playing in park, sunset, 4k.”「公園で遊ぶ幸せそうなコーギー,夕焼け,4K.」

- ”A dog driving a car on a suburban street wearing funny sunglasses”「変なサングラスをかけて郊外の道路で車を運転する犬.」

- ”A dog swimming.”「泳ぐ犬.」

- ”A dog wearing a Superhero outfit with red cape flying through the sky.”「赤いマントのスーパーヒーローの服を着て空を飛ぶ犬.」

- ”A dog wearing virtual reality goggles in sunset, 4k, high resolution.”「夕焼けの中,バーチャルリアリティゴーグルを装着した犬,4K,高解像度.」

- ”A fantasy landscape, trending on artstation, 4k, high resolution.”「幻想的な風景,アートステーションのトレンド,4K,高解像度.」

- ”A fat rabbit wearing a purple robe walking through a fantasy landscape.”「幻想的な風景の中を歩く,紫のローブを着た太ったウサギ.」

- ”A fire dragon breathing, trending on artstation, slow motion.”「アートステーションでトレンド入りしている,スローモーションの火のドラゴン.」

- ”A fox dressed in suit dancing in park.”「公園で踊るスーツ姿のキツネ.」

- ”A giraffe underneath a microwave.”「電子レンジの下にいるキリン.」

- ”A glass bead falling into water with a huge splash. Sunset in the background.”「大きな水しぶきを上げて水の中に落ちるガラス玉.背景に夕日.」

- ”A golden retriever has a picnic on a beautiful tropical beach at sunset, high resolution.”「夕暮れの美しいトロピカルビーチでピクニックをするゴールデンレトリバー,高解像度.」

- ”A goldendoodle playing in a park by a lake.”「湖畔の公園で遊ぶゴールデンドゥードル.」

- ”A hand lifts a cup.”「カップを持ち上げる手.」

- ”A happy elephant wearing a birthday hat walking under the sea.”「誕生日の帽子をかぶった幸せそうな象が海の中を歩いている.」

- ”A horse galloping through van Gogh’s Starry Night.”「ゴッホの「星降る夜」を疾走する馬.」

- ”A hot air balloon ascending over a lush valley, 4k, high definition.”「緑豊かな渓谷を上昇する熱気球,4K,高解像度.」

- ”A koala bear playing piano in the forest.”「森の中でピアノを弾くコアラ.」

- ”A lion standing on a surfboard in the ocean in sunset, 4k, high resolution.”「夕暮れの海でサーフボードの上に立つライオン,4K,高解像度.」

- ”A monkey is playing bass guitar, stage background, 4k, high resolution.”「猿がベースを弾いている,ステージ背景,4K,高解像度.」

- ”A panda standing on a surfboard in the ocean in sunset, 4k, high resolution.”「夕暮れの海でサーフボードの上に立つパンダ,4K,高解像度.」

- ”A panda taking a selfie.”「自撮りするパンダ.」

- ”A polar bear is playing bass guitar in snow, 4k, high resolution.”「雪の中でベースを弾くシロクマ,4K,高解像度.」

- ”A raccoon dressed in suit playing the trumpet, stage background, 4k, high resolution.”「トランペットを吹くスーツ姿のアライグマ,ステージ背景,4K,高解像度.」

- ”Red sports car coming around a bend in a mountain road.”「山道のカーブを曲がってくる赤いスポーツカー.」

- ”A shark swimming in clear Carribean ocean.”「澄んだカリブ海を泳ぐサメ.」

- ”A sheep to the right of a wine glass.”「ワイングラスの右にいる羊.」

- ”A shiny golden waterfall flowing through glacier at night.”「夜の氷河を流れる金色に輝く滝.」

- ”A shooting star flying through the night sky over mountains.”「山々の夜空を飛ぶ流れ星.」

- ”A sloth playing video games and beating all the high scores.”「ビデオゲームに興じ,ハイスコアを叩き出すナマケモノ.」

- ”A small hand-crafted wooden boat taking off to space.”「宇宙へ飛び立つ小さな手作りの木造船.」

- ”A squirrel eating a burger.”「ハンバーガーを食べるリス.」

- ”A storm trooper riding a bike in sunset street, 4k, high resolution.”「夕焼け通りを自転車で走るストームトルーパー,4K,高解像度.」

- ”A storm trooper vacuuming the beach.”「ビーチに掃除機をかけるストームトルーパー.」

- ”A stunning aerial drone footage time lapse of El Capitan in Yosemite National Park at sunset.”「日没時のヨセミテ国立公園のエルキャピタンの見事なドローン空撮映像タイムラプス.」

- ”A swarm of bees flying around their hive.”「巣の周りを飛び回るミツバチの群れ.」

- ”A teddy bear is playing the electric guitar, high definition, 4k.”「エレキギターを弾くテディベア,高解像度,4K.」

- ”A teddy bear running in New York City.”「ニューヨークを走るテディベア.」

- ”A teddy bear skating in Times Square.”「タイムズスクエアでスケートするテディベア.」

- ”A video of the Earth rotating in space.”「宇宙で回転する地球の動画.」

- ”A video that showcases the beauty of nature, from mountains and waterfalls to forests and oceans.”「山や滝,森や海など,自然の美しさを紹介する動画.」

- ”Aerial view of a hiker man standing on a mountain peak.”「山頂に立つハイカー男性の空撮映像.」

- ”Aerial view of a lake in Switzerland”「スイスの湖の航空写真.」

- ”Aerial view of a snow-covered mountain.”「雪山の空撮.」

- ”Aerial view of a white sandy beach on the shores of a beautiful sea, 4k, high resolution.”「美しい海辺の白い砂浜の空撮,4K,高解像度.」

- ”An animated painting of fluffy white clouds moving in sky.”「ふわふわの白い雲が空を移動するアニメーション絵画.」

- ”An astronaut cooking with a pan and fire in the kitchen, high definition, 4k.”「キッチンでフライパンと火を使って料理をする宇宙飛行士,高解像度,4K.」

- ”An astronaut riding a horse, high definition, 4k.”「馬に乗る宇宙飛行士,高解像度,4K.」

- ”An astronaut riding a horse.”「馬に乗る宇宙飛行士.」

- ”An astronaut riding a horse in sunset, 4k, high resolution.”「夕焼けの中,馬に乗る宇宙飛行士,4K,高解像度.」

- ”Artistic silhouette of a wolf against a twilight sky, embodying the spirit of the wilderness..”「荒野の精神を体現する,黄昏の空を背景にした狼の芸術的シルエット...」

- ”Back view on young woman dressed in a yellow jacket walking in the forest.”「森の中を歩く黄色いジャケットを着た若い女性の後ろ姿.」

- ”Maltipoo dog on the carpet next to a Christmas tree in a beautiful living room.”「美しいリビングルームのクリスマスツリーの横のカーペットの上のマルチプー犬.」

- ”Beer pouring into glass, low angle video shot.”「グラスに注がれるビール,ローアングルの動画ショット.」

- ”Bird-eye view of a highway in Los Angeles.”「ロサンゼルスのハイウェイの鳥瞰図.」

- ”Campfire at night in a snowy forest with starry sky in the background.”「星空を背景にした,雪の森の夜のキャンプファイヤー.」

- ”Cartoon character dancing.”「踊る漫画のキャラクター.」

- ”Cherry blossoms swing in front of ocean view, 4k, high resolution.”「オーシャンビューの前で揺れる桜,4K,高解像度.」

- ”Chocolate syrup pouring on a vanilla ice cream”「バニラアイスにかけるチョコレートシロップ.」

- ”Close up of grapes on a rotating table. High definition.”「回転するテーブルの上のブドウのクローズアップ.高解像度.」

- ”Teddy bear surfer rides the wave in the tropics.”「南国で波に乗るテディベアサーファー.」

- ”Drone flythrough interior of sagrada familia cathedral.”「サグラダ・ファミリア大聖堂の内部をドローンで飛び回る.」

- ”Drone flythrough of a fast food restaurant on a dystopian alien planet.”「ディストピア異星にあるファーストフード店のドローンで飛び回る.」

- ”Drone flythrough of a tropical jungle covered in snow.”「雪に覆われた熱帯ジャングルのドローンで飛び回る.」

- ”Edge lit hamster writing code on a computer in front of a scifi steampunk machine with yellow green red and blue gears high quality dslr professional photograph”「黄色,緑,赤,青の歯車とSFスチームパンクマシンの前で,コンピュータにコードを書くエッジライトのハムスター,高品質なデジタル一眼レフのプロフェッショナル写真.」

- ”Epic tracking shot of a Powerful silverback gorilla male walking gracefully”,「優雅に歩くパワフルなシルバーバック・ゴリラの雄の壮大な追跡ショット.」

- ”Fireworks.”「花火.」

- ”Flying through a temple in ruins, epic, forest overgrown, columns cinematic, detailed, atmospheric, epic, mist, photo-realistic, concept art, volumetric light, cinematic epic, 8k”「廃墟と化した寺院を飛ぶ,壮大,生い茂る森,カラムシネマティック,詳細,大気,壮大,霧,フォトリアリスティック,コンセプトアート,ボリュームライト,シネマティックエピック,8K.」

- ”Flying through an intense battle between pirate ships in a stormy ocean.”「嵐の海で海賊船同士の激しい戦いを飛び回る.」

- ”Flying through fantasy landscapes, 4k, high resolution.”「幻想的な風景の中を飛び回る,4K,高解像度.」

- ”Pug dog listening to music with big headphones.”「大きなヘッドフォンで音楽を聴くパグ犬.」

- ”Horror house living room interior overview design, Moebius, Greg Rutkowski, Zabrocki, Karlkka, Jayison Devadas, Phuoc Quan, trending on Artstation, 8K, ultra wide angle, pincushion lens effect.”「ホラーハウスのリビングルームのインテリア概観デザイン,メビウス,グレッグ・ラトコウスキー,ザブロッキ,カールッカ,ジェイソン・デヴァダス,フオック・クアン,アートステーションのトレンド,8K,超広角,ピンクッション・レンズ効果.」

- ”Hulk wearing virtual reality goggles, 4k, high resolution.”「バーチャルリアリティゴーグルを装着したハルク,4K,高解像度.」

- ”Incredibly detailed science fiction scene set on an alien planet, view of a marketplace. Pixel art.”「エイリアンの惑星を舞台にした信じられないほど詳細なSFシーン,市場の眺め.ピクセルアート.」

- ”Ironman flying over a burning city, very detailed surroundings, cities are blazing, shiny iron man suit, realistic, 4k ultra high definition.”「燃え盛る都市の上を飛ぶアイアンマン,非常に詳細な周辺環境,都市は燃え盛る,光沢のあるアイアンマンのスーツ,リアル,4K超高解像度.」

- ”Jack russell terrier dog snowboarding. GoPro shot.”「ジャックラッセルテリア犬のスノーボード.GoPro撮影.」

- ”Low angle of pouring beer into a glass cup.”「ガラスコップにビールを注ぐローアングル.」

- ”Melting pistachio ice cream dripping down the cone.”「コーンに滴り落ちる溶けたピスタチオアイスクリーム.」

- ”Milk dripping into a cup of coffee, high definition, 4k.”「コーヒーカップに滴り落ちるミルク,高画質,4K.」

- ”Pouring latte art into a silver cup with a golden spoon next to it.「ラテアートをシルバーのカップに注ぐ,その横には金色のスプーン.」

- ”Shoveling snow.”「雪かき.」

- ”Studio shot of minimal kinetic sculpture made from thin wire shaped like a bird on white background.”「白い背景に鳥の形をした細いワイヤーで作られた最小限のキネティック彫刻のスタジオショット.」

- ”Sunset time lapse at the beach with moving clouds and colors in the sky, 4k, high resolution.”「動く雲と空の色を使ったビーチでのサンセットタイムラプス,4K,高解像度.」

- ”Teddy bear walking down 5th Avenue, front view, beautiful sunset, close up, high definition, 4k.”「5番街を歩くテディベア,前面展望,美しい夕日,クローズアップ,高解像度,4K.」

- ”The Orient Express driving through a fantasy landscape, animated oil on canvas.”「幻想的な風景の中を走るオリエント急行,キャンバスに油絵のアニメーション.」

- ”Time lapse at a fantasy landscape, 4k, high resolution.”「幻想的な風景でのタイムラプス,4K,高解像度.」

- ”Time lapse at the snow land with aurora in the sky, 4k, high resolution.”「空にオーロラが輝く雪原でのタイムラプス,4K,高解像度.」

- ”Tiny plant sprout coming out of the ground.”「地面から出てくる小さな植物の芽.」

- ”Toy Poodle dog rides a penny board outdoors”「屋外でペニーボードに乗るトイ・プードル犬.」

- ”Traveler walking alone in the misty forest at sunset.”「夕暮れの霧の森を一人歩く旅人.」

- ”Turtle swimming in ocean.”「海で泳ぐ亀.」

- ”Two pandas discussing an academic paper.”「学術論文について議論する2匹のパンダ.」

- ”Two pandas sitting at a table playing cards, 4k, high resolution.”「テーブルに座ってトランプをする2匹のパンダ,4K,高解像度.」

- ”Two raccoons are playing drum kit in NYC Times Square, 4k, high resolution.”「ニューヨーク・タイムズスクエアでドラムキットを演奏する2匹のアライグマ,4K,高解像度.」

- ”Two raccoons reading books in NYC Times Square.”「ニューヨーク・タイムズスクエアで本を読む2匹のアライグマ.」

- ”US flag waving on massive sunrise clouds in bad weather. High quality, dynamic, detailed, cinematic lighting”「悪天候の中,巨大な日の出雲に揺れるアメリカ国旗.高品質,ダイナミック,詳細,映画のような照明.」

- ”View of a castle with fantastically high towers reaching into the clouds in a hilly forest at dawn.”「夜明けの丘陵地帯の森の中,雲に向かって伸びる幻想的な高さの塔を持つ城の眺め.」

- ”Waves crashing against a lone lighthouse, ominous lighting.”「一軒の灯台に打ち寄せる波,不吉な照明.」

- ”Woman in white dress waving on top of a mountain.”「山の頂上で手を振る白いドレスの女性.」

- ”Wood on fire.”「燃えている木.」

- ”Wooden figurine surfing on a surfboard in space.”「宇宙でサーフボードに乗ってサーフィンをする木の置物.」

- ”Yellow flowers swing in wind.”「風に揺れる黄色い花.」

参考:Lumiere: A Space-Time Diffusion Model for Video Generationの解説動画

Lumiere: A Space-Time Diffusion Model for Video Generationの解説動画です.

まとめ

Lumiere: A Space-Time Diffusion Model for Video Generationの日本語訳を紹介しました.

グーグルのLumiereがわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.