Wide & Deep Learning for Recommender Systemsの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Wide & Deep Learning for Recommender Systemsの日本語訳を紹介します.

グーグルのWide & Deep Learningがわかります.

※図表を含む論文の著作権はWide & Deep Learning for Recommender Systemsの著者に帰属します.

Wide & Deep Learning for Recommender Systemsの目次は以下になります.

- Abstract

- 1章:INTRODUCTION

- 2章:RECOMMENDER SYSTEM OVERVIEW

- 3章:WIDE & DEEP LEARNING

- 4章:SYSTEM IMPLEMENTATION

- 5章:EXPERIMENT RESULTS

- 6章:RELATED WORK

- 7章:CONCLUSION

- 8章:REFERENCES

Wide & Deep Learning for Recommender Systemsを解説しつつ,私の考えも語ります.

Wide & Deep Learning for Recommender Systemsの概要と私の日本語訳は以下になります.

Generalized linear models with nonlinear feature transformations are widely used for large-scale regression and classification problems with sparse inputs.

非線形特徴量変換を用いた汎化線形モデルは,疎な入力を持つ大規模な回帰や分類の問題に広く用いられている.Memorization of feature interactions through a wide set of cross-product feature transformations are effective and interpretable, while generalization requires more feature engineering effort.

クロス積特徴量変換の幅広いセットによる特徴量の相互作用の記憶は効果的で解釈可能であるが,汎化にはより多くの特徴量工学の労力が必要である.With less feature engineering, deep neural networks can generalize better to unseen feature combinations through low-dimensional dense embeddings learned for the sparse features.

より少ない特徴量工学で,ディープニューラルネットワークは,疎な特徴量に対して学習された低次元の密な埋め込みを通じて,未知の特徴量の組み合わせに対してより良く汎化できる.However, deep neural networks with embeddings can over-generalize and recommend less relevant items when the user-item interactions are sparse and high-rank.

しかし,埋め込みを用いたディープニューラルネットワークは,ユーザとアイテムの相互作用が疎で高ランクの場合,過剰に汎化して関連性の低いアイテムを推奨することがある.In this paper, we present Wide & Deep learning---jointly trained wide linear models and deep neural networks---to combine the benefits of memorization and generalization for recommender systems.

本論文では,推薦システムのために,記憶と汎化の利点を組み合わせるために,Wide & Deep learning---共同学習されたワイド線形モデルとディープニューラルネットワーク---を提案する.We productionized and evaluated the system on Google Play, a commercial mobile app store with over one billion active users and over one million apps.

我々は,10億人以上のアクティブユーザと100万以上のアプリを持つ商用モバイルアプリストアであるGoogle Play上でシステムを製作し評価した.Online experiment results show that Wide & Deep significantly increased app acquisitions compared with wide-only and deep-only models.

オンライン実験の結果,Wide & Deepは,WideのみのモデルやDeepのみのモデルと比較して,アプリの獲得数を大幅に増加させることができた.We have also open-sourced our implementation in TensorFlow.

また,TensorFlowでの実装をオープンソース化した.https://arxiv.org/abs/1606.07792

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 本文中に登場する表記「[5]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Wide & Deep Learning for Recommender Systemsの本文を読みすすめましょう!

目次

1章:INTRODUCTION(はじめに)

推薦システムは,検索ランキングシステムとみなすことができ,入力クエリはユーザと文脈情報のセットであり,出力はアイテムのランク付けリストである.

クエリが与えられた場合,推薦タスクは,データベース内の関連アイテムを見つけ,クリックや購入などの特定の目的に基づいてアイテムをランク付けすることである.

推薦システムにおける一つの課題は,一般的な検索ランキング問題と同様に,記憶(memorization)と汎化(generalization)の両方を達成することである.

記憶とは,アイテムや特徴量の頻繁な共起を学習し,過去のデータで利用可能な相関を利用することだと緩やかに定義できる.

一方,汎化とは,相関の推移性に基づき,過去に一度も発生したことがない,あるいはほとんど発生しなかった新しい特徴量の組み合わせを探索することである.

記憶に基づく推薦は,通常,より話題性が高く,ユーザが既にアクションを起こしたアイテムに直接関連するものである.

汎化は,記憶と比較して,推薦アイテムの多様性を向上させる傾向がある.

本論文では,Google Playストアのアプリ推薦問題に焦点を当てるが,このアプローチは一般的な推薦システムにも適用できるはずである.

大規模なオンライン推薦システムやランキングシステムでは,ロジスティック回帰のような汎化線形モデルが,シンプルでスケーラブルかつ解釈しやすいため,広く使用されている.

このモデルは,2値化された疎な特徴量をone-hotエンコーディングで訓練させることが多い.

例えば,「"user_installed_app=netflix"」という2値特徴量は,ユーザがNetflixをインストールした場合,値1を持つ.

AND("user_installed_app=netflix, impression_app=pandora")は,Netflixをインストールし,その後Pandoraを見せられた場合に値が1になるように,疎な特徴量に対してクロス積変換を行うことで効果的に記憶ができる.

このように,特徴量ペアの共起度とターゲットラベルの相関を説明することができる.

AND(user_installed_category=video, impression_category=music)のように,より粒度の小さい特徴量を用いることで汎化を図ることができるが,手作業による特徴量設計が必要となることが多い.

クロス積変換の限界の一つは,訓練データに現れていないクエリとアイテムの特徴量ペアに汎化できないことである.

因数分解マシン[5]やディープニューラルネットワークのような埋め込みベースのモデルは,各クエリやアイテムの特徴に対して低次元で密な埋め込みベクトルを学習することにより,特徴量工学の負担が少なく,これまで見たことのないクエリ-アイテム特徴量のペアに汎化できる.

しかし,特定の好みを持つユーザや訴求範囲の狭いニッチなアイテムのように,クエリ-アイテム行列が疎で高ランクである場合,クエリ-アイテムの効果的な低次元表現を学習することは困難である.

このような場合,ほとんどのクエリ-アイテムのペアには相互作用がないはずだが,密な埋め込みはすべてのクエリ-アイテムのペアに対して非ゼロの予測を導くため,過剰に汎化して関連性の低い推薦を行うことができる.

一方,クロス積特徴量変換を用いた線形モデルは,より少ないパラメータでこれらの「例外ルール」を記憶することができる.

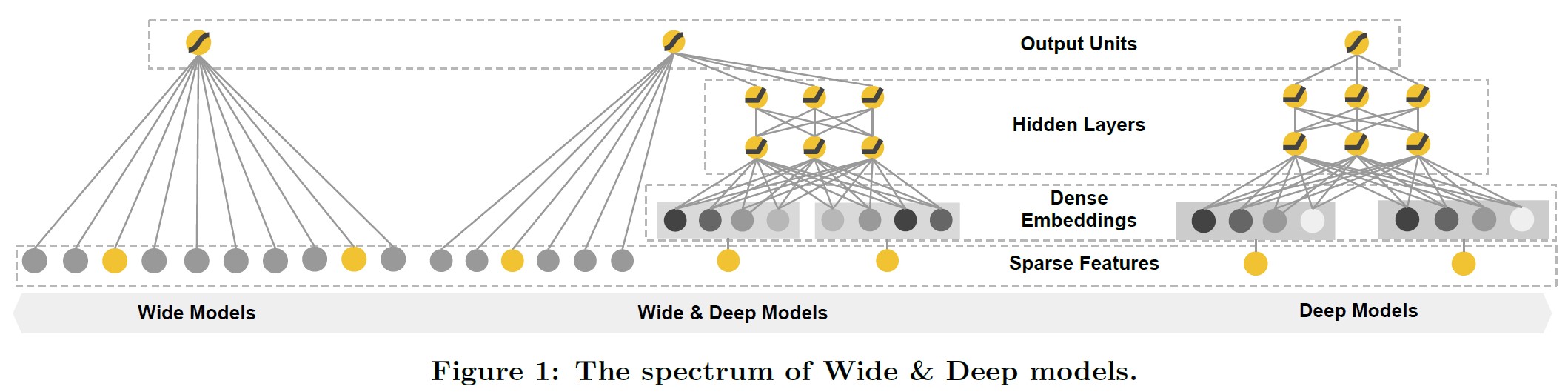

本論文では,図1に示すように線形モデルコンポーネントとニューラルネットワークコンポーネントを共同学習させることで,1つのモデルで記憶と汎化の両方を実現するWide & Deep learningフレームワークを紹介する.

本論文の主な貢献は以下の通りである.

- 疎な入力を持つ汎用推薦システムのために,埋め込みを持つフィードフォワードニューラルネットワークと特徴量変換を持つ線形モデルを共同学習するためのWide & Deep learningフレームワークを提案したこと.

- 10億人以上のアクティブユーザと100万以上のアプリを持つモバイルアプリストアであるGoogle Playで,Wide & Deep推薦システムの実装と評価が行ったこと.

- 我々は,TensorFlowの高レベルのAPIとともに,その実装をオープンソース化したこと.

アイデアはシンプルだが,Wide & Deepフレームワークが,訓練と提供速度の要件を満たしながら,モバイルアプリストアでのアプリ取得率を大幅に向上させることを示した.

2章:RECOMMENDER SYSTEM OVERVIEW(推薦システムの概要)

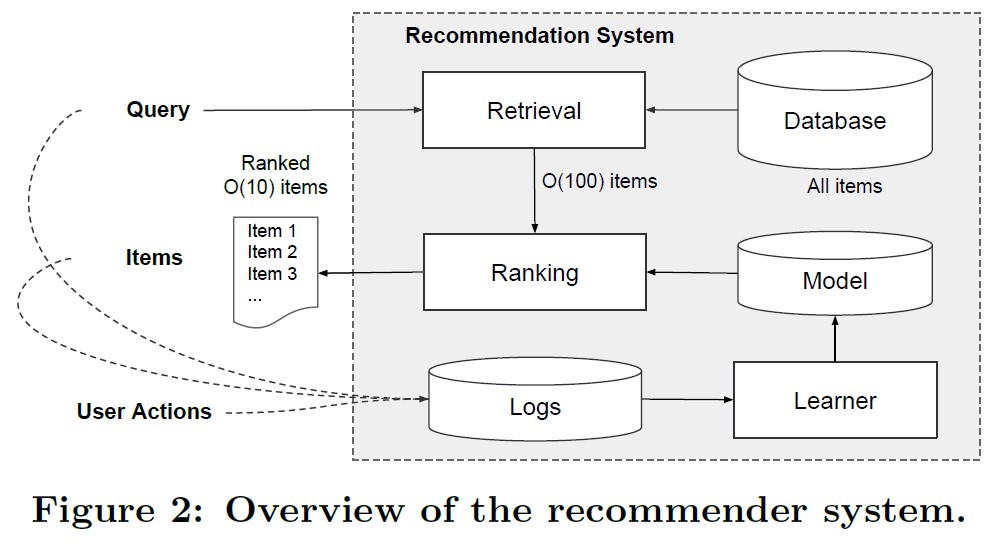

アプリ推薦システムの概要を図2に示す.

ユーザがアプリストアにアクセスすると,様々なユーザや文脈の特徴量を含むクエリが生成される.

推薦システムは,ユーザがクリックや購入などの特定のアクションを行うことができるアプリのリスト(インプレッションとも呼ばれる)を返す.

これらのユーザアクションは,クエリやインプレッションとともに,学習者の訓練データとしてログに記録される.

データベースには100万以上のアプリが存在するため,すべてのクエリに対してすべてのアプリを網羅的にスコアリングすることは,サービスレイテンシ要件(多くの場合\(\mathcal{O}(10)\)ミリ秒)内で実行不可能である.

そのため,クエリを受信した際の最初のステップは検索である.

検索システムは,様々なシグナル(通常は機械学習モデルと人間が定義したルールの組み合わせ)を使って,クエリに最もマッチするアイテムの短いリストを返す.

候補プールを縮小した後,ランキングシステムはすべてのアイテムをそのスコアでランク付けする.

スコアとは,通常\(P(y|{\mathbf{x}})\)のことで,ユーザの特徴量(例:国,言語,人口統計),文脈の特徴量(例:デバイス,時間帯,曜日),印象の特徴量(例:アプリ年齢,アプリの履歴統計)を含む特徴量xを与えられたユーザがアクションラベルyを付ける確率のことである.

本論文では,Wide & Deep learningフレームワークを使用したランキングモデルに焦点を当てる.

3章:WIDE & DEEP LEARNING

3.1節:The Wide Component(Wideコンポーネント)

Wideコンポーネントは,図1(左)に示すように,\(y={\mathbf{w}}^T {\mathbf{x}}+b\)の形の汎化線形モデルである.

yは予測値,\(\mathbf{x} = [x_1, x_2, …, x_d]\)はd個の特徴量のベクトル,\({\mathbf{w}} = [w_1, w_2, …, w_d]\)はモデルパラメータ,bはバイアスである.

特徴量セットには,生の入力特徴量と変換された特徴量が含まれる.

最も重要な変換の1つはクロス積変換であり,これは次のように定義される.

$$\phi_k(\mathbf{x}) = \prod_{i=1}^d x_i^{c_{ki}} \ \ \ c_{ki} \in \{0, 1\}$$

ここで,\(c_{ki}\)はブール変数で,i番目の特徴量がk番目の変換の一部である場合に1,そうでない場合に0となる.

バイナリ特徴量に対して,クロス積変換(例えば,"AND(gender=female, language=en)")は,構成特徴量("gender=female"と"language=en")が全て1の場合にのみ1となり,それ以外は0になる.

これにより,2値特徴量間の相互作用を捉え,汎化線形モデルに非線形性を付加している.

3.2節:The Deep Component(Deepコンポーネント)

Deepコンポーネントは,図1(右)に示すように,フィードフォワードニューラルネットワークである.

カテゴリカルな特徴量の場合,もともとの入力は特徴量文字列(例えば,"language=en")である.

これらの疎な高次元カテゴリカル特徴量は,まず低次元で密な実数値ベクトルに変換される(しばしば埋め込みベクトルと呼ばれる).

埋め込みベクトルの密度は,通常\(\mathcal{O}(10)\)から\(\mathcal{O}(100)\)のオーダーである.

埋め込みベクトルはランダムに初期化され,その後,モデル訓練時に最終的な損失関数を最小化するように値が訓練される.

これらの低次元で密な埋め込みベクトルは,次にフォワードパスでニューラルネットワークの隠れ層に供給される.

具体的には,各隠れ層は以下の計算を行う.

$$a^{(l+1)} = f(W^{(l)} a^{(l)} + b^{(l)})$$

ここで,lは層数,fは活性化関数であり,多くの場合Rectified Linear Units(ReLUs)である.

\(a^{(l)}\),\(b^{(l)}\),\(W^{(l)}\)はl番目の層の活性化関数,バイアス,モデルの重みである.

3.3節:Joint Training of Wide & Deep Model(Wide & Deep Modelの合同訓練)

WideコンポーネントとDeepコンポーネントは,それぞれの出力ログオッズの加重和を予測として使用し,それを共通のロジスティック損失関数に与えて共同学習を行う.

共同学習とアンサンブルは区別される.

アンサンブルでは,個々のモデルはお互いを知ることなく別々に訓練され,その予測値は推論時のみ結合され,訓練時には結合されない.

一方,共同学習では,広い部分と深い部分の両方,およびそれらの合計の重みを訓練時に考慮することで,すべてのパラメータを同時に最適化する.

モデルサイズにも影響がある.

アンサンブルの場合,訓練がバラバラなので,アンサンブルの妥当な精度を得るためには,通常,個々のモデルサイズを大きくする必要がある(例えば,より多くの特徴量や変換を行うなど).

これに対して,共同学習では,WideモデルはフルサイズのWideモデルではなく,少数のクロス積特徴量変換でDeepパートの弱点を補完すればよい.

Wide & Deep Modelの共同学習は,ミニバッチのストキャスティック最適化を用いて,出力からの勾配をワイドとディープの両方に同時にバックプロパゲーションすることで行われる.

実験では,Wide Modelのオプティマイザとして\(L_1\)正則化を用いたFollow-The-Regularized-Leader(FTRL)アルゴリズム[3]を,Deep ModelのオプティマイザとしてAdaGrad[1] を使用した.

その結合モデルを図1(中央)に示す.

ロジスティック回帰の問題では,モデルの予測値は以下になる.

$$P(Y = 1|\mathbf{x}) = \sigma(\mathbf{w}_{wide}^T [\mathbf{x}, \phi(\mathbf{x})] + \mathbf{w}_{deep}^T a^{(l_f)} + b)$$

ここで,Yは2値クラスラベル,\(\sigma(\cdot)\)はシグモイド関数,\(\phi(\mathbf{x})\)は元の特徴量\(\mathbf{x}\)のクロス積変換,bはバイアス項,\(\mathbf{w}_{wide}\)は全ての広いモデル重みのベクトル,\(\mathbf{w}_{deep}\)は最終活性化関数\(a^{(l_f)}\)にかかる重みである.

4章:SYSTEM IMPLEMENTATION(システム実装)

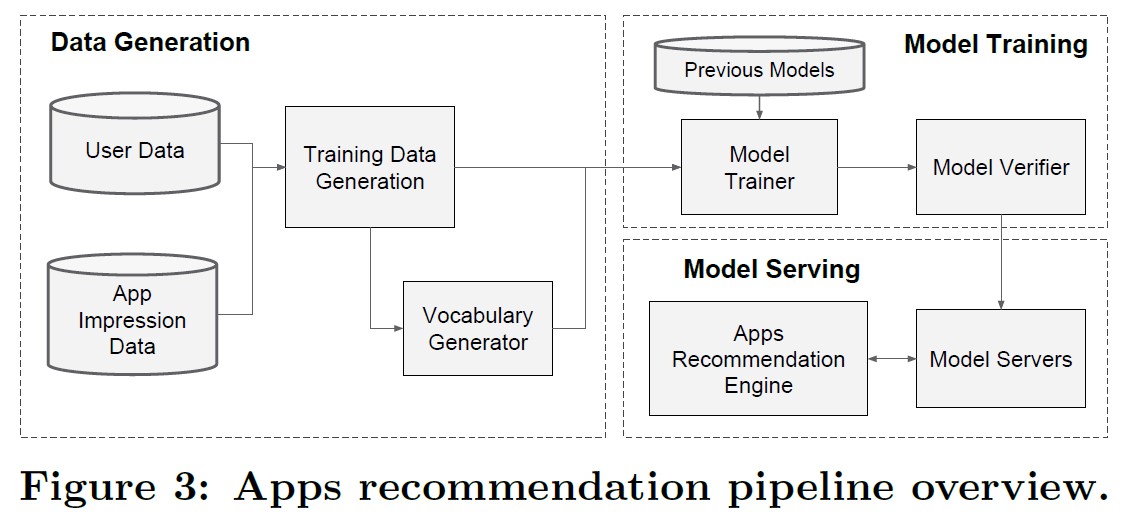

アプリ推薦パイプラインの実装は,図3に示すように,データ生成,モデル訓練,モデル提供の3つのステージで構成されている.

4.1節:Data Generation(データ生成)

この段階では,一定期間内のユーザとアプリの印象データを用いて訓練データを生成する.

各例は1つのインプレッションに対応する.

ラベルはアプリ取得である.

印象に残ったアプリがインストールされた場合は1,そうでない場合は0とする.

ボキャブラリーとは,カテゴリー化された特徴量の文字列と整数のIDを対応付けたテーブルのことで,この段階で生成される.

このシステムは,最小回数以上出現した文字列特徴のID空間をすべて計算する.

連続した実数値の特徴量は,特徴量xをその累積分布関数\(P(X \leq x)\)に対応させ,\(n_q\)個の分位数に分割することにより,[0, 1]に正規化する.

正規化された値は,i番目の分位数における値に対して\(\frac{i-1}{n_q-1}\)となる.

分位点境界はデータ生成時に計算される.

4.2節:Model Training(モデル訓練)

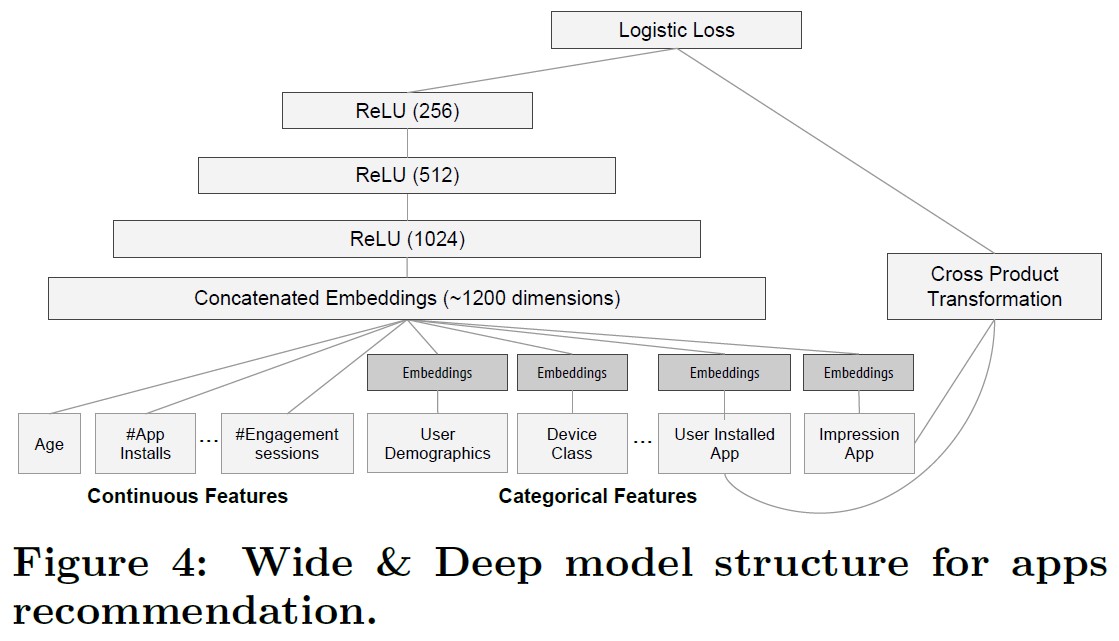

実験に使用したモデル構造を図4に示す.

訓練時には,入力層が学習データと語彙を取り込み,ラベルとともに疎と密の画像を生成する.

Wideコンポーネントは,ユーザがインストールしたアプリとインプレッションアプリのクロス積変換で構成されている.

Deep Modelでは,各カテゴリカル特徴に対して32次元の埋め込みベクトルを学習する.

すべての埋め込みベクトルを密な特徴と一緒に連結することで,約1200次元の密なベクトルを得る.

連結されたベクトルは,3つのReLU層,そして最後にロジスティック出力ユニットに供給される.

Wide & Deep Modelは,5,000億以上の例で訓練されている.

新しい訓練データセットが到着するたびに,モデルを再訓練する必要がある.

しかし,毎回ゼロから再訓練を行うのは計算量が多く,データ到着から更新されたモデルを提供するまでの時間を遅らせることになる.

この課題に対処するため,我々は,新しいモデルを,前のモデルからの埋め込みと線形モデルの重みで初期化するウォームスタートシステムを実装した.

モデルをモデルサーバにロードする前に,モデルのドライランを行い,ライブトラフィックを提供する際に問題が発生しないことを確認する.

サニティチェックとして,以前のモデルに対して経験的にモデル品質を検証する.

4.3節:Model Serving(モデルサービス)

モデルの訓練と検証が完了したら,それをモデルサーバにロードする.

各リクエストに対して,サーバはアプリ検索システムからアプリ候補のセットを受け取り,各アプリをスコアリングするためにユーザの特徴量を受け取る.

そして,スコアの高いものから低いものへとアプリをランク付けし,この順番でユーザにアプリを表示する.

スコアは,Wide & Deep Modelに対して前方推論パスを実行することで算出される.

各リクエストを10msのオーダーで処理するために,すべての候補アプリを1回のバッチ推論ステップでスコアリングするのではなく,より小さなバッチを並行して実行することでマルチスレッドの並列性を利用して性能を最適化した.

5章:EXPERIMENT RESULTS(実験結果)

実際の推薦システムにおけるWide & Deep learningの有効性を評価するため,ライブ実験を行い,アプリの獲得数とサービス性能という2つの側面からシステムを評価した.

5.1節:App Acquisitions(アプリの取得)

A/Bテストフレームワークで3週間のライブオンライン実験を実施した.

対照群では,1%のユーザが無作為に選ばれ,高度に最適化されたWideのみのロジスティック回帰モデルであり,豊富なクロス積特徴量変換を持つ旧バージョンのランキングモデルによって生成された推薦が提示された.

実験グループには,1%のユーザが,同じ特徴量セットで学習させたWide & Deep Modelによって生成された推薦文を提示された.

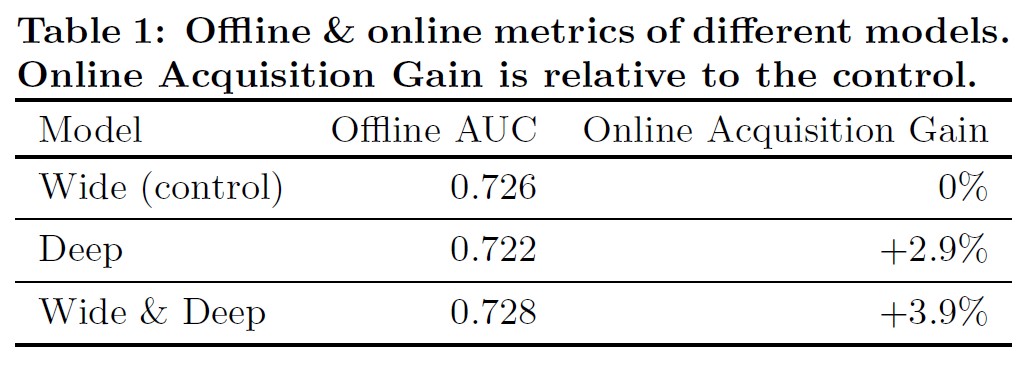

表1に示すように,Wide & Deep Modelは,アプリストアのメインランディングページでのアプリ取得率を,コントロールグループと比較して+3.9%向上させた(統計的に有意).

また,同じ特徴量とニューラルネットワーク構造を持つDeepのみのモデルを使用した別の1%グループと比較したところ,Wide & Deep ModelはDeepのみのモデルに対して+1%向上した(統計的に有意).

オンライン実験の他に,オフラインのホールドアウトセットでのArea Under Receiver Operator Characteristic Curve(AUC)も示している.

Wide & DeepはオフラインのAUCが若干高いものの,その影響はオンラインのトラフィックでより大きくなっている.

その理由として,オフラインのデータセットでは印象やラベルが固定されているのに対し,オンラインシステムでは汎化と記憶の融合により新しい探索的な推奨を生成し,新しいユーザの回答から学習できると考えられる.

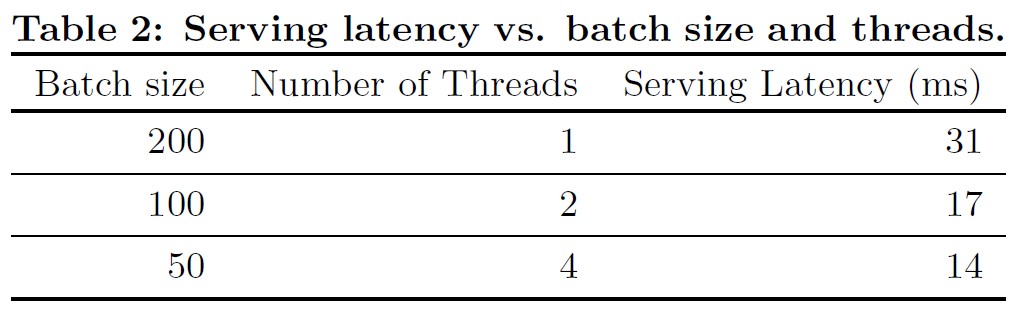

5.2節:Serving Performance(サービス性能)

高いスループットと低いレイテンシでサービスを提供することは,我々の商用モバイルアプリストアが直面する高いレベルのトラフィックに挑戦している.

ピーク時のトラフィックでは,推薦サーバは1秒間に1,000万以上のアプリをスコアリングしている.

シングルスレッドでは,1つのバッチですべての候補をスコアリングするのに31ミリ秒かかる.

我々はマルチスレッドを実装し,各バッチを小さなサイズに分割した.

その結果,表2に示すように,クライアント側の待ち時間は14ミリ秒に大幅に短縮された(サービスオーバーヘッドを含む).

6章:RELATED WORK(関連研究)

クロス積による特徴量変換を行うワイド線形モデルと,密な埋め込みを行うディープニューラルネットワークを組み合わせるというアイデアは,2つの変数間の相互作用を2つの低次元埋め込みベクトル間のドット積として因数分解することにより線形モデルに一般性を付加する因数分解マシン[5]など,これまでの研究にヒントを得ている.

本論文では,ドット積の代わりにニューラルネットワークを介して埋め込み間の非線形性の高い相互作用を学習することで,モデル容量を拡大した.

言語モデルにおいては,n-gram特徴量を用いたリカレントニューラルネットワーク(RNNs:Recurrent Neural Networks)と最大エントロピーモデルの共同学習が提案されており,入出力間の直接重みを学習することでRNNの複雑さ(隠れ層サイズなど)を大幅に低減している[4].

コンピュータビジョンでは,深層残差学習[2]を用いて,1つ以上の層をスキップするショートカット接続により,より深いモデルの学習の難易度を下げ,精度を向上させることが行われている.

また,ニューラルネットワークとグラフィカルモデルの共同学習は,画像からの人間の姿勢推定に応用されている[6].

本研究では,疎な入力データを持つ一般的な推薦・ランキング問題に対して,疎な特徴量と出力ユニット間の直接接続を持つフィードフォワードニューラルネットワークと線形モデルの共同学習について検討した.

推薦システムの文献では,コンテンツ情報のための深層学習と評価行列のための協調フィルタリング(CF:Collaborative Filtering)を結合することによって,協調深層学習が探求されている[7].

また,ユーザのアプリ利用記録に対してCFを用いたAppJoyなど,モバイルアプリの推薦システムに関する先行研究もある[8].

先行研究のCFベースやコンテンツベースのアプローチとは異なり,我々はアプリ推薦システムのために,ユーザデータと印象データに対してWide & Deep Modelを共同学習する.

7章:CONCLUSION(結論)

推薦システムには,記憶と汎化の両方が重要である.

ワイド線形モデルは,クロス積特徴量変換を用いて疎な特徴量の相互作用を効果的に記憶することができ,ディープニューラルネットワークは,低次元の埋め込みによって以前に見たことのない特徴量の相互作用に汎化することができる.

我々は,この2種類のモデルの長所を組み合わせるために,Wide & Deep learningフレームワークを提案した.

我々は,大規模な商用アプリストアであるGoogle Playの推薦システム上でフレームワークを製作し,評価した.

オンライン実験の結果,Wide & Deep Modelは,WideのみのモデルやDeepのみのモデルと比較して,アプリの獲得に大きな改善をもたらすことが示された.

8章:REFERENCES(参考文献)

- J. Duchi, E. Hazan, and Y. Singer. Adaptive subgradient methods for online learning and stochastic optimization. Journal of Machine Learning Research, 12:2121-2159, July 2011.

- K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. Proc. IEEE Conference on Computer Vision and Pattern Recognition, 2016.

- H. B. McMahan. Follow-the-regularized-leader and mirror descent: Equivalence theorems and l1 regularization. In Proc. AISTATS, 2011.

- T. Mikolov, A. Deoras, D. Povey, L. Burget, and J. H. Cernocky. Strategies for training large scale neural network language models. In IEEE Automatic Speech Recognition & Understanding Workshop, 2011.

- S. Rendle. Factorization machines with libFM. ACM Trans. Intell. Syst. Technol., 3(3):57:1-57:22, May 2012.

- J. J. Tompson, A. Jain, Y. LeCun, and C. Bregler. Joint training of a convolutional network and a graphical model for human pose estimation. In Z. Ghahramani, M. Welling, C. Cortes, N. D. Lawrence, and K. Q. Weinberger, editors, NIPS, pages 1799-1807. 2014.

- H. Wang, N. Wang, and D.-Y. Yeung. Collaborative deep learning for recommender systems. In Proc. KDD, pages 1235-1244, 2015.

- B. Yan and G. Chen. AppJoy: Personalized mobile application discovery. In MobiSys, pages 113-126, 2011.

参考:Wide & Deep Learning for Recommender Systemsの解説動画

Wide & Deep Learning for Recommender Systemsの解説動画です.

まとめ

Wide & Deep Learning for Recommender Systemsの日本語訳を紹介しました.

グーグルのWide & Deep Learningがわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.