The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの日本語訳を紹介します.

Microsoftの1-bit LLMs(BitNet b1.58)による「1ビットLLM時代」がわかります.

※図表を含む論文の著作権はThe Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの著者に帰属します.

プロジェクトのWebサイトはこちらです.

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの目次は以下になります.

- Abstract

- 1章:The Era of 1-bit LLM

- 2章:BitNet b1.58

- 3章:Results

- 4章:Discussion and Future Work

- References

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsを解説しつつ,私の考えも語ります.

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの概要と私の日本語訳は以下になります.

Recent research, such as BitNet, is paving the way for a new era of 1-bit Large Language Models (LLMs).

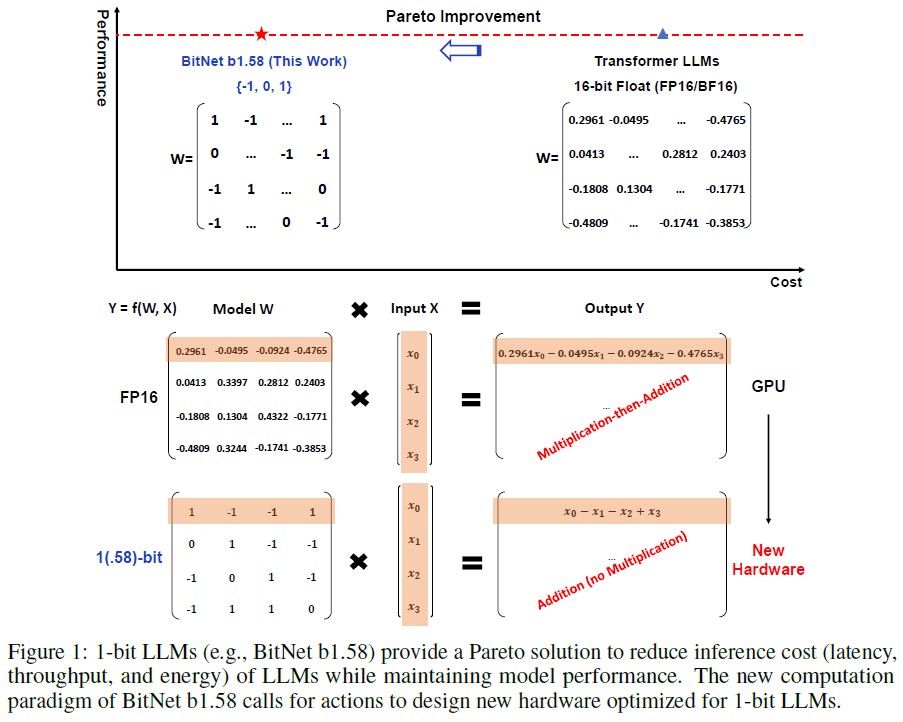

BitNetのような最近の研究は,1ビット大規模言語モデル(LLMs:Large Language Models)の新しい時代への道を開いている.In this work, we introduce a 1-bit LLM variant, namely BitNet b1.58, in which every single parameter (or weight) of the LLM is ternary {-1, 0, 1}.

本論文では,LLMの全てのパラメータ(重み)が3値{-1, 0, 1}である1ビットLLM,すなわちBitNet b1.58を紹介する.It matches the full-precision (i.e., FP16 or BF16) Transformer LLM with the same model size and training tokens in terms of both perplexity and end-task performance, while being significantly more cost-effective in terms of latency, memory, throughput, and energy consumption.

このLLMは,モデルサイズと訓練トークンが同じで,全精度(FP16またはBF16)のTransformer LLMとパープレキシティとエンドタスク性能の両面で一致し,レイテンシ,メモリ,スループット,エネルギー消費の点で大幅にコスト効率が高い.More profoundly, the 1.58-bit LLM defines a new scaling law and recipe for training new generations of LLMs that are both high-performance and cost-effective.

さらに深いことに,1.58ビットLLMは,高性能でコスト効率に優れた新世代のLLMを訓練するための新しいスケーリング則とレシピを定義している.Furthermore, it enables a new computation paradigm and opens the door for designing specific hardware optimized for 1-bit LLMs.

さらに,新しい計算パラダイムを可能にし,1ビットLLMに最適化された特定のハードウェアを設計するための扉を開く.https://arxiv.org/abs/2402.17764

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 本文中に登場する表記「[XLS+23, FAHA23, CCKS23, TCS+24]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの本文を読みすすめましょう!

目次

1章:The Era of 1-bit LLM(1ビットLLM時代)

※訳注:図1は原文では参照されていませんが,こちらに置いておきます.

近年,AIの分野では,大規模言語モデル(LLMs:Large Language Models)のサイズと機能が急速に拡大している.

これらのモデルは,幅広い自然言語処理タスクにおいて目覚ましい性能を発揮しているが,サイズが大きくなるにつれて,そのデプロイに課題が生じ,高いエネルギー消費による環境や経済への影響が懸念されている.

このような課題に対処する1つのアプローチとして,事後訓練の量子化を利用して推論用の低ビットモデルを作成する方法がある[XLS+23, FAHA23, CCKS23, TCS+24].

このテクニックは重みと活性化の精度を下げ,LLMのメモリと計算機要件を大幅に削減する.

傾向として,16ビットから4ビット[FAHA23, LTT+23]のような低ビットへ移行している.

しかし,事後訓練の量子化は,業界のLLMで広く使われているにもかかわらず,最適とは言えない.

BitNet[WMD+23]などの1ビットモデルアーキテクチャに関する最近の研究は,LLMの性能を維持しながらコストを低減する有望な方向性を示している.

Vanilla LLMは16ビット浮動小数点値(FP16またはBF16)であり,LLMの大部分は行列の乗算である.

したがって,主な計算コストは浮動小数点の加算演算と乗算演算に由来する.

これに対してBitNetの行列乗算は整数加算のみであり,LLMのエネルギーコストは桁違いに節約できる.

多くのチップにおける計算性能の基本的な限界は電力であるため,エネルギーの節約は計算の高速化にもつながる.

計算に加えて,推論中にモデルパラメータをDRAMからオンチップアクセラレータのメモリ(SRAMなど)に転送するプロセスにもコストがかかる.

スループットを向上させるためにSRAMを大容量化する試みも行われているが,これはDRAMよりも著しく高いコストをもたらす.

全精度モデルと比較すると,1ビットLLMは,容量と帯域幅の両方の観点から,メモリフットプリントがはるかに小さい.

これにより,DRAMから重みをロードするコストと時間を大幅に削減でき,より高速で効率的な推論が可能になる.

この研究では,BitNet b1.58と呼ばれる重要な1ビットLLM Variantを紹介する.

このVariantでは,すべてのパラメータが3値であり,{-1, 0, 1}の値をとる.

元の1ビットBitNetに0を追加し,2進数で1.58ビットになった.

BitNet b1.58はオリジナルの1ビットBitNetの利点をすべて保持しており,その新しい計算パラダイムは行列乗算のための乗算演算をほとんど必要とせず,高度に最適化することができる.

さらに,オリジナルの1ビットBitNetと同じエネルギー消費量であり,FP16 LLMベースラインと比較して,メモリ消費量,スループット,レイテンシの点ではるかに効率的である.

さらに,BitNet b1.58には2つの利点がある.

第一に,モデルの重みに0を含めることで可能となる特徴フィルタリングを明示的にサポートしているため,モデリング能力が強化され,1ビットLLMの性能を大幅に向上させることができる.

第二に,我々の実験によると,BitNet b1.58は,同じ構成(モデルサイズ,訓練トークンなど)を使用した場合,3Bサイズから始めて,全精度(すなわち,FP16)ベースラインとプレプレキシティとエンドタスクパフォーマンスの両方で一致することができる.

2章:BitNet b1.58

BitNet b1.58はBitNetアーキテクチャに基づいており,nn.LinearをBitLinearに置き換えたTransformerである.

1.58ビットの重みと8ビットの活性化でゼロから訓練される.

オリジナルのBitNetと比較すると,以下に要約するいくつかの変更が導入されている.

量子化関数:

重みを-1, 0, +1に拘束するために,absmean量子化関数を採用する.

これはまず重み行列をその平均絶対値でスケーリングし,次に各値を{-1, 0, +1}の中で最も近い整数に丸める.

\begin{eqnarray}

\widetilde{W} &=& {\rm RoundClip}(\frac{W}{\gamma + \epsilon}, -1, 1), \\

{\rm RoundClip}(x, a, b) &=& \max(a, \min(b, {\rm round}(x))), \\

\gamma &=& \frac{1}{nm} \sum_{ij} | W_{ij} |.

\end{eqnarray}

活性化の量子化関数はBitNetの実装と同じだが,非線形関数の前の活性化を\([0,Q_b]\)の範囲にスケーリングしない点が異なる.

その代わり,ゼロ点量子化をなくすために,トークンごとにすべての活性度を\([-Q_b,Q_b]\)にスケーリングする.

これは,実装とシステムレベルの最適化の両方にとって,より便利で簡単である.

一方,我々の実験では性能への影響は無視できる.

LLaMAに似たコンポーネント:

LLaMA[TLI+23, TMS+23]のアーキテクチャは,オープンソースLLMの事実上のバックボーンとなっている.

オープンソースコミュニティを受け入れるために,BitNet b1.58のデザインはLLaMAと同様のコンポーネントを採用している.

具体的には,RMSNorm[ZS19],SwiGLU[Sha20],ロータリー埋め込み[SAL+24]を使用し,すべてのバイアスを除去する.

このように,BitNet b1.58は,最小限の労力で,一般的なオープンソースソフトウェア(例えば,Huggingface,vLLM [KLZ+23],llama.cpp)に統合することができる.

3章:Results(結果)

BitNet b1.58と我々のFP16 LLaMA LLMを様々なサイズで比較した.

公平な比較を行うため,RedPajamaデータセット[Com23]で1000億トークンの事前訓練を行った.

ARC-Easy[YBS19],ARC-Challenge[YBS19],Hellaswag[ZHB+19],Winogrande[SBBC20],PIQA[BZB+19],OpenbookQA[MCKS18],BoolQ[CLC+19]などの様々な言語タスクのZero-Shot性能を評価した.

また,WikiText2[MXBS16]およびC4[RSR+19]データセットでの検証パープレキシティも報告する.

LLaMA LLMとBitNet b1.58の実行時のGPUメモリとレイテンシを比較した.

結果は,GPUデバイス上のLLM推論レイテンシに最適化されたFasterTransformerコードベースを用いて測定した.

Ladder[WMC+23]の2ビットカーネルもBitNet b1.58用に統合されている.

推論の主要なコストであるため,出力トークンあたりの時間を報告した.

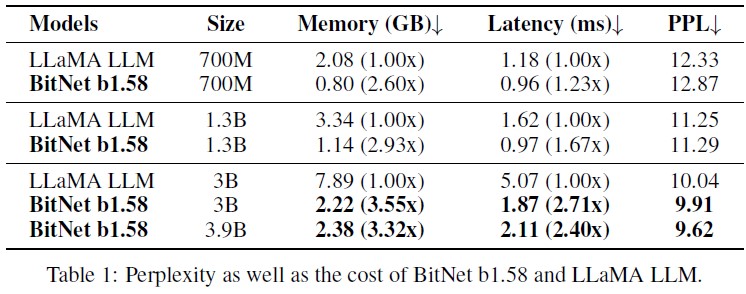

表1はBitNet b1.58とLLaMA LLMのパープレキシティとコストをまとめたものである.

これによると,BitNet b1.58はモデルサイズ3Bの時点で全精度のLLaMA LLMにプレプレキシティで匹敵するようになり,同時に2.71倍高速で,GPUメモリの使用量が3.55倍少ないことがわかる.

特に,モデルサイズ3.9BのBitNet b1.58は,2.4倍高速で,3.32倍少ないメモリを消費するが,LLaMA LLM 3Bよりも大幅に優れた性能を発揮する.

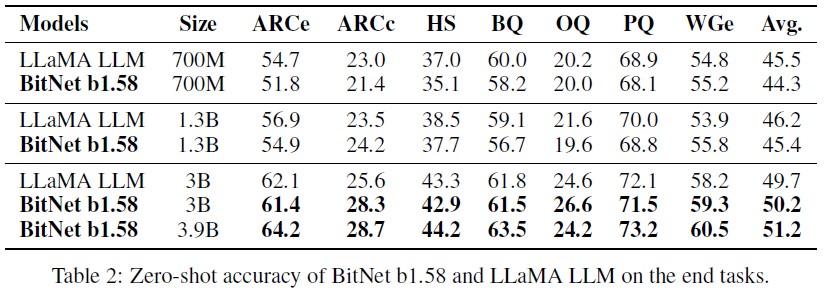

表2に,最終タスクのZero-Shot正解率の詳細な結果を示す.

lm-evaluation-harnessのパイプラインに従って評価を行った.

その結果,BitNet b1.58とLLaMA LLMの性能差はモデルサイズが大きくなるにつれて縮まることがわかった.

さらに重要なことに,BitNet b1.58は3Bサイズから全精度ベースラインの性能に匹敵することができる.

パープレキシティの観測と同様に,エンドタスクの結果は,BitNet b1.58 3.9BがLLaMA LLM 3Bをより低いメモリコストとレイテンシコストで上回ることを明らかにした.

これはBitNet b1.58が最先端のLLMモデルに対してパレート改善であることを示している.

メモリとレイテンシ:

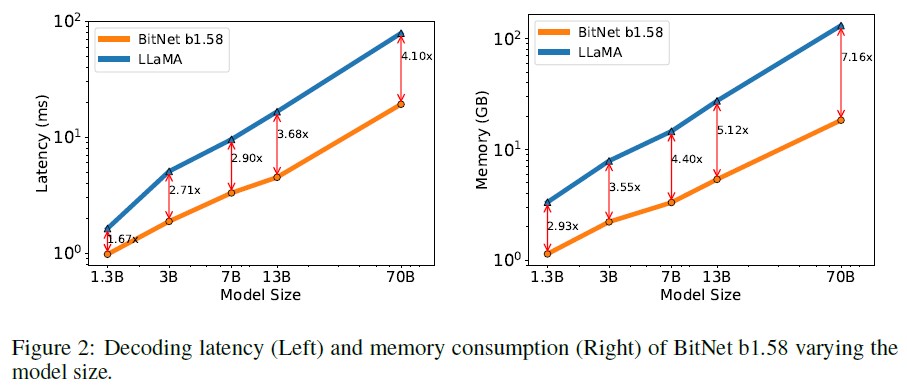

さらに,モデルサイズを7B,13B,70Bとスケールアップし,そのコストを評価した.

図2はレイテンシとメモリの傾向を示しており,モデルサイズがスケールアップするにつれて高速化が進むことを示している.

特にBitNet b1.58 70BはLLaMA LLMベースラインより4.1倍高速である.

これはnn.Linearの時間コストがモデルサイズとともに大きくなるためである.

メモリ消費量も同様の傾向で,埋め込みは全精度のままであり,そのメモリ比率はモデルが大きくなるほど小さくなるからである.

レイテンシとメモリはどちらも2ビットカーネルで測定されているため,さらにコストを削減するための最適化の余地はまだある.

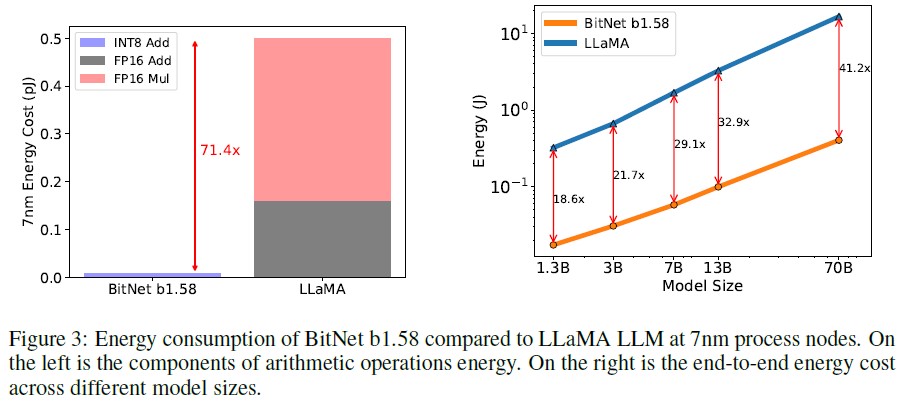

(左)演算エネルギーの構成要素.

(右)異なるモデルサイズにわたるエンドツーエンドのエネルギーコスト.

エネルギー:

BitNet b1.58とLLaMA LLMの算術演算エネルギー消費量も試算した.

行列の乗算はLLMのコストに最も寄与するため,主に行列の乗算に焦点を当てる.

図3はエネルギーコストの構成を示している.

BitNet b1.58の大部分はINT8の加算計算であり,LLaMA LLMはFP16の加算とFP16の乗算の両方で構成されている.

[Hor14, ZZL22]のエネルギーモデルによると,BitNet b1.58は7nmチップ上の行列乗算の算術演算のエネルギー消費を71.4倍節約できる.

さらに,512トークンを持つモデルのエンドツーエンドのエネルギーコストを報告した.

その結果,モデルサイズがスケールするにつれて,BitNet b1.58はFP16 LLaMA LLMベースラインと比較してエネルギー消費の点でますます効率的になることがわかった.

これは,nn.Linearの割合が,モデルサイズが大きくなるにつれて大きくなる一方,他のコンポーネントからのコストはモデルサイズが大きくなるほど小さくなるためである.

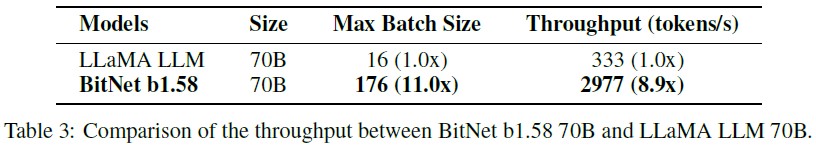

スループット:

LLaMA LLM 70Bがデバイス上で実行できるように,パイプライン並列[HCB+19]を使用して,2枚の80GB A100カード上でBitNet b1.58とLLaMA LLM 70Bパラメータのスループットを比較した.

シーケンス長を512として,GPUメモリの上限に達するまでバッチサイズを増やした.

表3は,BitNet b1.58 70BがLLaMA LLMの最大11倍のバッチサイズに対応でき,スループットが8.9倍向上することを示している.

BitNet b1.58はモデル性能と推論コストに関して新しいスケーリング則を可能にしている.

参考として,図2と図3の結果に基づき,1.58ビットと16ビットの異なるモデルサイズの間に以下の等価性を持たせることができる.

- 13B BitNet b1.58は,3B FP16 LLMよりもレイテンシ,メモリ使用量,エネルギー消費量の点で効率的である.

- 30B BitNet b1.58は,7B FP16 LLMよりもレイテンシ,メモリ使用量,エネルギー消費量の点で効率的である.

- 70B BitNet b1.58は,13B FP16 LLMよりもレイテンシ,メモリ使用量,エネルギー消費量の点で効率的である.

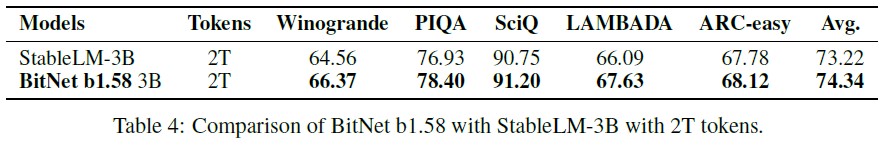

2Tトークンを使った訓練:

訓練トークンの数はLLMにとって非常に重要な要素である.

BitNet b1.58のトークン数のスケーラビリティをテストするために,最先端のオープンソース3BモデルであるStableLM-3B[TBMR]のデータレシピに従って,2TトークンでBitNet b1.58モデルを訓練した.

両モデルとも,Winogrande[SBBC20],PIQA[BZB+19],SciQ[WLG17],LAMBADA[PKL+16],ARC-easy[YBS19]からなるベンチマークで評価した.

表4にZero-Shot正解率を報告する.

正解率と正規化された正解率で測定されたタスクについては,2つの平均を取る.

2TトークンでのStableLM 3bの結果は,そのテクニカルレポートから直接引用した.

この結果から,BitNet b1.58はすべてのエンドタスクで優れた性能を達成し,1.58ビットLLMも強力な汎化能力を持つことがわかる.

4章:Discussion and Future Work(議論と今後の課題)

1ビット専門家混合(MoE:Mixture-of-Experts)LLMs:

Mixture-of-Experts(MoE)は,LLMにとって費用対効果の高いアプローチであることが証明されている.

MoEは計算FLOPを大幅に削減する一方で,メモリ消費量とチップ間通信のオーバーヘッドが大きいため,LLMのデプロイと応用が制限される.

これらの課題は,1.58ビットLLMで解決できる.

まず,メモリフットプリントの削減により,MoEモデルのデプロイに必要なデバイス数を削減できる.

さらに,ネットワークを介して活性化を転送するオーバーヘッドを大幅に削減する.

最終的には,モデル全体をシングルチップに配置できれば,オーバーヘッドはなくなる.

LLMにおける長いシーケンスのネイティブサポート:

LLMの時代において,長いシーケンスを処理する能力は重要な要求となっている.

長いシーケンスの推論における大きな課題の1つは,KVキャッシュによってもたらされるメモリ消費である.

BitNet b1.58は長いシーケンスのネイティブサポートに向けた大きな一歩を踏み出した.

活性化を16ビットから8ビットに削減することで,同じリソースでコンテキスト長を2倍にすることができる.

1.58ビットのLLMでは,これをさらに4ビット以下に可逆圧縮することができるが,これは今後の課題である.

エッジとモバイルのLLMs:

1.58ビットLLMの使用は,エッジデバイスやモバイルデバイスにおける言語モデルの性能を大幅に向上させる可能性を秘めている.

これらのデバイスは,メモリと計算能力によって制限されることが多く,LLMの性能とスケールが制限される可能性がある.

しかし,1.58ビットLLMのメモリとエネルギー消費量の削減により,これらのデバイスへのデプロイが可能になり,以前は不可能だった幅広いアプリケーションが可能になる.

これにより,エッジデバイスやモバイルデバイスの機能が大幅に向上し,LLMの新しくエキサイティングな応用が可能になる.

さらに,1.58ビットのLLMは,エッジデバイスやモバイルデバイスで使用される主要なプロセッサであるCPUデバイスに対してよりフレンドリーである.

これは,BitNet b1.58がこれらのデバイス上で効率的に実行され,その性能と能力がさらに向上することを意味する.

1ビットLLMのための新しいハードウェア:

Groqのような最近の研究は,LLMのための特定のハードウェア(例えばLPU)を構築するための有望な結果と大きな可能性を示している.

さらに一歩進んで,BitNet[WMD+23]で可能になった新しい計算パラダイムを考慮し,1ビットLLMに特化して最適化された新しいハードウェアとシステムを設計することを構想し,行動を呼びかける.

References(参考文献)

- [BZB+19] Yonatan Bisk, Rowan Zellers, Ronan Le Bras, Jianfeng Gao, and Yejin Choi. PIQA: reasoning about physical commonsense in natural language. CoRR, abs/1911.11641, 2019.

- [CCKS23] Jerry Chee, Yaohui Cai, Volodymyr Kuleshov, and Christopher De Sa. QuIP: 2-bit quantization of large language models with guarantees. CoRR, abs/2307.13304, 2023.

- [CLC+19] Christopher Clark, Kenton Lee, Ming-Wei Chang, Tom Kwiatkowski, Michael Collins, and Kristina Toutanova. Boolq: Exploring the surprising difficulty of natural yes/no questions. CoRR, abs/1905.10044, 2019.

- [Com23] Together Computer. Redpajama: an open dataset for training large language models, 2023.

- [FAHA23] Elias Frantar, Saleh Ashkboos, Torsten Hoefler, and Dan Alistarh. OPTQ: accurate quantization for generative pre-trained transformers. In The Eleventh International Conference on Learning Representations, 2023.

- [HCB+19] Yanping Huang, Youlong Cheng, Ankur Bapna, Orhan Firat, Dehao Chen, Mia Xu Chen, HyoukJoong Lee, Jiquan Ngiam, Quoc V. Le, Yonghui Wu, and Zhifeng Chen. Gpipe: Efficient training of giant neural networks using pipeline parallelism. In Advances in Neural Information Processing Systems, pages 103–112, 2019.

- [Hor14] Mark Horowitz. 1.1 computing’s energy problem (and what we can do about it). In 2014 IEEE International Conference on Solid-State Circuits Conference, ISSCC 2014, Digest of Technical Papers, San Francisco, CA, USA, February 9-13, 2014, pages 10–14, 2014.

- [KLZ+23] Woosuk Kwon, Zhuohan Li, Siyuan Zhuang, Ying Sheng, Lianmin Zheng, Cody Hao Yu, Joseph E. Gonzalez, Hao Zhang, and Ion Stoica. Efficient memory management for large language model serving with pagedattention. In Proceedings of the ACM SIGOPS 29th Symposium on Operating Systems Principles, 2023.

- [LTT+23] Ji Lin, Jiaming Tang, Haotian Tang, Shang Yang, Xingyu Dang, and Song Han. AWQ: activation-aware weight quantization for LLM compression and acceleration. CoRR, abs/2306.00978, 2023.

- [MCKS18] Todor Mihaylov, Peter Clark, Tushar Khot, and Ashish Sabharwal. Can a suit of armor conduct electricity? A new dataset for open book question answering. CoRR, abs/1809.02789, 2018.

- [MXBS16] Stephen Merity, Caiming Xiong, James Bradbury, and Richard Socher. Pointer sentinel mixture models, 2016.

- [PKL+16] Denis Paperno, Germán Kruszewski, Angeliki Lazaridou, Quan Ngoc Pham, Raffaella Bernardi, Sandro Pezzelle, Marco Baroni, Gemma Boleda, and Raquel Fernández. The LAMBADA dataset: Word prediction requiring a broad discourse context. In Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, ACL 2016, August 7-12, 2016, Berlin, Germany, Volume 1: Long Papers. The Association for Computer Linguistics, 2016.

- [RSR+19] Colin Raffel, Noam Shazeer, Adam Roberts, Katherine Lee, Sharan Narang, Michael Matena, Yanqi Zhou, Wei Li, and Peter J. Liu. Exploring the limits of transfer learning with a unified text-to-text transformer. CoRR, abs/1910.10683, 2019.

- [SAL+24] Jianlin Su, Murtadha H. M. Ahmed, Yu Lu, Shengfeng Pan, Wen Bo, and Yunfeng Liu. Roformer: Enhanced transformer with rotary position embedding. Neurocomputing, 568:127063, 2024.

- [SBBC20] Keisuke Sakaguchi, Ronan Le Bras, Chandra Bhagavatula, and Yejin Choi. Wino- Grande: an adversarial winograd schema challenge at scale. In The Thirty-Fourth AAAI Conference on Artificial Intelligence, pages 8732–8740, 2020.

- [Sha20] Noam Shazeer. GLU variants improve transformer. CoRR, abs/2002.05202, 2020.

- [TBMR] Jonathan Tow, Marco Bellagente, Dakota Mahan, and Carlos Riquelme. Stablelm 3b 4e1t.

- [TCS+24] Albert Tseng, Jerry Chee, Qingyao Sun, Volodymyr Kuleshov, and Christopher De Sa. Quip#: Even better LLM quantization with hadamard incoherence and lattice codebooks. CoRR, abs/2402.04396, 2024.

- [TLI+23] Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, Aurelien Rodriguez, Armand Joulin, Edouard Grave, and Guillaume Lample. LLaMA: open and efficient foundation language models. CoRR, abs/2302.13971, 2023.

- [TMS+23] Hugo Touvron, Louis Martin, Kevin Stone, Peter Albert, Amjad Almahairi, Yasmine Babaei, Nikolay Bashlykov, Soumya Batra, Prajjwal Bhargava, Shruti Bhosale, Dan Bikel, Lukas Blecher, Cristian Canton Ferrer, Moya Chen, Guillem Cucurull, David Esiobu, Jude Fernandes, Jeremy Fu, and et al. Llama 2: open foundation and fine-tuned chat models. CoRR, abs/2307.09288, 2023.

- [WLG17] Johannes Welbl, Nelson F. Liu, and Matt Gardner. Crowdsourcing multiple choice science questions. In Leon Derczynski, Wei Xu, Alan Ritter, and Tim Baldwin, editors, Proceedings of the 3rd Workshop on Noisy User-generated Text, NUT@EMNLP 2017, Copenhagen, Denmark, September 7, 2017, pages 94–106. Association for Computational Linguistics, 2017.

- [WMC+23] LeiWang, Lingxiao Ma, Shijie Cao, Ningxin Zheng, Quanlu Zhang, Jilong Xue, Ziming Miao, Ting Cao, , and Yuqing Yang. Ladder: Efficient tensor compilation on customized data format. In OSDI, 2023.

- [WMD+23] Hongyu Wang, Shuming Ma, Li Dong, Shaohan Huang, Huaijie Wang, Lingxiao Ma, Fan Yang, Ruiping Wang, Yi Wu, and Furu Wei. Bitnet: Scaling 1-bit transformers for large language models. CoRR, abs/2310.11453, 2023.

- [XLS+23] Guangxuan Xiao, Ji Lin, Mickaël Seznec, Hao Wu, Julien Demouth, and Song Han. SmoothQuant: accurate and efficient post-training quantization for large language models. In International Conference on Machine Learning, ICML 2023, 23-29 July 2023, Honolulu, Hawaii, USA, 2023.

- [YBS19] Vikas Yadav, Steven Bethard, and Mihai Surdeanu. Quick and (not so) dirty: Unsupervised selection of justification sentences for multi-hop question answering. In Kentaro Inui, Jing Jiang, Vincent Ng, and Xiaojun Wan, editors, EMNLP-IJCNLP, 2019.

- [ZHB+19] Rowan Zellers, Ari Holtzman, Yonatan Bisk, Ali Farhadi, and Yejin Choi. HellaSwag: can a machine really finish your sentence? In Proceedings of the 57th Conference of the Association for Computational Linguistics, pages 4791–4800, 2019.

- [ZS19] Biao Zhang and Rico Sennrich. Root mean square layer normalization. In Hanna M. Wallach, Hugo Larochelle, Alina Beygelzimer, Florence d’Alché-Buc, Emily B. Fox, and Roman Garnett, editors, Advances in Neural Information Processing Systems, pages 12360–12371, 2019.

- [ZZL22] Yichi Zhang, Zhiru Zhang, and Lukasz Lew. PokeBNN: A binary pursuit of lightweight accuracy. In IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 12465–12475. IEEE, 2022.

参考:The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの解説動画

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの解説動画です.

まとめ

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bitsの日本語訳を紹介しました.

Microsoftの1-bit LLMs(BitNet b1.58)による「1ビットLLM時代」がわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.