Gemma: Open Models Based on Gemini Research and Technologyの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Gemma: Open Models Based on Gemini Research and Technologyの日本語訳を紹介します.

グーグルのGemmaがわかります.

※図表を含む論文の著作権はGemma: Open Models Based on Gemini Research and Technologyの著者に帰属します.

Gemma: Open Models Based on Gemini Research and Technologyの目次は以下になります.

- Abstract

- 1章:Introduction

- 2章:Model Architecture

- 3章:Training Infrastructure

- 4章:Pretraining

- 5章:Instruction Tuning

- 6章:Evaluation

- 7章:Responsible Deployment

- 8章:Discussion and Conclusion

- Contributions and Acknowledgments

- References

※訳注:章番号がないので追加しました.

Gemma: Open Models Based on Gemini Research and Technologyを解説しつつ,私の考えも語ります.

Gemma: Open Models Based on Gemini Research and Technologyの概要と私の日本語訳は以下になります.

This work introduces Gemma, a family of lightweight, state-of-the art open models built fromthe research and technology used to create Gemini models.

Gemmaは,Geminiモデルを作成するために使用された研究と技術から構築された,軽量で最先端のオープンモデルファミリーである.Gemma models demonstrate strong performance across academic benchmarks for language understanding, reasoning, and safety.

Gemmaモデルは,言語理解,推論,安全性に関して,学術的なベンチマークで高い性能を実証している.We release two sizes of models (2 billion and 7 billion parameters), and provide both pretrained and fine-tuned checkpoints.

我々は2つのサイズのモデル(20億パラメータと70億パラメータ)をリリースし,事前訓練済みチェックポイントとファインチューニング済みチェックポイントの両方を提供している.Gemma outperforms similarly sized open models on 11 out of 18 text-based tasks, and we present comprehensive evaluations of safety and responsibility aspects of the models, alongside a detailed description of model development.

Gemmaは,18のテキストベースのタスクのうち11において,同規模のオープンモデルを凌駕しており,モデル開発の詳細な説明とともに,モデルの安全性と責任に関する包括的な評価を提示する.We believe the responsible release of LLMs is critical for improving the safety of frontier models, and for enabling the next wave of LLM innovations.

LLMの責任あるリリースは,フロンティアモデルの安全性を向上させ,LLMイノベーションの次の波を可能にするために非常に重要であると考えている.https://storage.googleapis.com/deepmind-media/gemma/gemma-report.pdf

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Contributions and Acknowledgments」(貢献と謝辞)は省略していること

- 本文中に登場する表記「(Gemini Team, 2023)」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Gemma: Open Models Based on Gemini Research and Technologyの本文を読みすすめましょう!

目次

1章:Introduction(はじめに)

我々は,グーグルのGeminiモデル(Gemini Team, 2023)をベースにしたオープンモデルのファミリーであるGemmaを紹介する.

Geminiモデルファミリーと同様のアーキテクチャ,データ,訓練レシピを用いて,最大6Tトークンのテキストに対してGemmaモデルを訓練した.

Geminiと同様に,これらのモデルは,テキストドメインにおける強力なジェネラリスト能力を,最先端の理解と推論スキルと共に,スケールで達成する.

本研究では,訓練済みチェックポイントとファインチューニング済みチェックポイントの両方を公開し,推論とサービスのためのオープンソースコードベースも公開する.

Gemmaには,GPUやTPU上での効率的なデプロイや開発向けの70億パラメータモデルと,CPUやオンデバイスアプリケーション向けの20億パラメータモデルの2つのサイズがある.

それぞれのサイズは,異なる計算制約,アプリケーション,開発者の要件に対応するように設計されている.

各スケールでは,事前訓練された生のチェックポイントと,対話,命令追従性,有用性,安全性のためにファインチューニングされたチェックポイントを公開している.

我々は,一連の定量的・定性的ベンチマークで,我々のモデルの欠点を徹底的に評価する.

事前訓練されたチェックポイントとファインチューニングされたチェックポイントの両方を公開することで,現在の命令チューニングレジームの影響に関する徹底的な調査と研究が可能になり,さらに安全で責任あるモデル開発手法の開発が可能になると考えている.

Gemmaは,自動化されたベンチマークと人間による評価の両方を含む広範なドメインにおいて,同等規模の(そしていくつかのより大規模な)オープンモデル(Almazrouei et al., 2023; Jiang et al., 2023; Touvron et al., 2023a; Touvron et al., 2023b)と比較して最先端の性能を向上させる.

例として,質問応答(Clark et al., 2019; Kwiatkowski et al., 2019),常識推論(Sakaguchi et al., 2019; Suzgun et al., 2022),数学と科学(Cobbe et al., 2021; Hendrycks et al., 2020),コーディング(Austin et al., 2021; Chen et al., 2021)などがある.

詳細は「評価」の章(※訳注:5章)を参照されたい.

Geminiと同様に,Gemmaはシーケンスモデル(Sutskever et al., 2014)とTransformer(Vaswani et al., 2017),ニューラルネットワークに基づくディープラーニング手法(LeCun et al., 2015),分散システムでの大規模学習のための技術(Barham et al., 2022; Dean et al., 2012; Roberts et al., 2023)に関する最近の研究を基盤としている.

Gemmaはまた,Word2Vec(Mikolov et al., 2013),Transformer(Vaswani et al., 2017),BERT(Devlin et al., 2018),T5(Raffel et al., 2019)とT5X(Roberts et al., 2022)を含む,グーグルのオープンモデルとエコシステムの長い歴史に基づいている.

LLMの責任あるリリースは,フロンティアモデルの安全性を向上させ,この画期的な技術への公平なアクセスを確保し,現在の技術の厳密な評価と分析を可能にし,次の革新の波を開発するために不可欠であると,我々は信じている.

すべてのGemmaモデルの徹底的なテストが実施されたとはいえ,テストはGemmaが使用される可能性のあるすべてのアプリケーションとシナリオをカバーすることはできない.

このことを念頭に置き,すべてのGemmaユーザの皆様は,デプロイや使用の前に,それぞれのユースケースに特化した厳格な安全性テストを実施する必要がある.

安全性に対する私たちのアプローチの詳細については,「責任あるデプロイ」の章(※訳注:7章)を参照されたい.

本テクニカルレポートでは,Gemmaのモデルアーキテクチャ,訓練インフラ,事前訓練レシピ,ファインチューニングレシピの詳細な概要を説明し,その後,標準的なアカデミックベンチマークと人間嗜好評価だけでなく,様々な定量的・定性的ベンチマークにおける全チェックポイントの徹底的な評価を行う.

次に,安全で責任あるデプロイに対する我々のアプローチについて詳述する.

最後に,Gemmaの広範な意味合い,その限界と利点,そして結論について概説する.

2章:Model Architecture(モデルアーキテクチャ)

Gemmaモデルのアーキテクチャは,Transformerデコーダ(Vaswani et al., 2017)に基づいている.

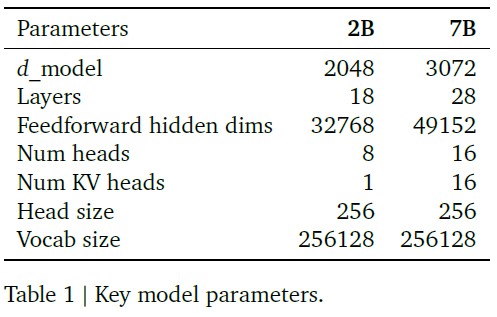

アーキテクチャのコアパラメータを表1にまとめた.

モデルは8192トークンのコンテキスト長で訓練される.

また,オリジナルのTransformer論文の後に提案されたいくつかの改良も利用している.

以下に,その改良点を列挙する.

Multi-Query Attention(Shazeer, 2019):

注目すべきは,7BモデルはMulti-Query Attentionを使用し,2BチェックポイントはMulti-Query Attention(\(num\_kv\_heads=1\))を使用することで,それぞれのAttention Variantsが各スケールでパフォーマンスを向上させることを明らかにしたアブレーション研究に基づいている(Shazeer, 2019).

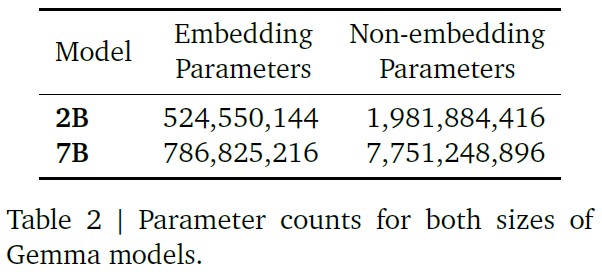

※訳注:表2は原文では参照されていませんが,こちらに置いておきます.

RoPE Embeddings(Su et al., 2021):

絶対位置埋め込みではなく,回転位置埋め込みを各レイヤで使用する.

また,モデルサイズを小さくするために,入力と出力で埋め込みを共有する.

GeGLU活性化(Shazeer, 2020):

標準的なReLUの非線形性をGeGLU活性化関数に置き換える.

ノーマライザの位置:

各変換サブレイヤの入力と出力の両方を正規化するが,これはどちらか一方のみを正規化する標準的なやり方からの逸脱である.

正規化層としてRMSNorm(Zhang and Sennrich, 2019)を使用する.

2.1節:Training Infrastructure(訓練インフラ)

TPUv5eを使ってGemmaモデルを訓練する.

TPUv5eは256チップのポッドにデプロイされ,16x16チップの2Dトーラスに構成される.

7Bモデルでは,16ポッド,合計4096 TPUv5eでモデルを訓練する.

2Bモデルでは,2つのポッド(合計512 TPUv5e)で事前訓練する.

1つのポッド内で,7Bモデルには16-wayのモデルシャーディングと16-wayのデータレプリケーションを使用する.

2Bモデルでは,単純に256-wayのデータレプリケーションを使用する.

オプティマイザの状態は,ZeRO-3と同様の手法でさらにシャーディングされる.

ポッドの外側では,Pathwaysのアプローチ(Barham et al., 2022)を用いて,データセンターネットワーク上でデータレプリカの削減を行う.

Geminiと同様に,Jax(Roberts et al., 2023)とPathways(Barham et al., 2022)の「シングルコントローラ」プログラミングパラダイムを活用し,単一のPythonプロセスで訓練実行全体をオーケストレーションできるようにすることで,開発プロセスを簡素化する.

また,訓練ステップの計算にGSPMDパーティショナ(Xu et al., 2021)とMegaScale XLAコンパイラ(XLA, 2019)を活用している.

2.2節:Carbon Footprint(カーボンフットプリント)

Gemmaモデルの事前訓練による炭素排出量は,∼\(131 tCO_2 eq\)と推定される.

この値は,TPUデータセンターから直接報告された1時間ごとのエネルギー使用量に基づいて計算されている.

また,データセンターの建設と維持に費やされた追加エネルギーを考慮し,この値をスケーリングすることで,訓練実験の総エネルギー使用量を算出した.

データセンターから報告された毎時のセルあたりの炭素排出量データに対して,毎時のエネルギー使用量を結合することで,総エネルギー使用量を炭素排出量に変換する.

さらに,グーグルのデータセンターは,エネルギー効率,再生可能エネルギーの購入,カーボンオフセットを組み合わせることでカーボンニュートラルを実現している.

このカーボンニュートラルは,我々の実験とその実行に使用されるマシンにも適用される.

3章:Pretraining(事前訓練)

3.1節:Training Data(訓練データ)

Gemma 2Bと7Bは,それぞれウェブ文書,数学,コードから得た2Tと6Tの主に英語のトークンで訓練される.

Geminiとは異なり,これらのモデルはマルチモーダルではなく,また,多言語タスクで最先端のパフォーマンスを発揮するために訓練されたものでもない.

互換性のためにGeminiのSentencePieceトークナイザ(Kudo and Richardson, 2018)のサブセットを使用する.

これは,桁を分割し,余分な空白を除去せず,未知のトークンのバイトレベルエンコーディングに依存し,(Chowdhery et al., 2022)と(Gemini Team, 2023)の両方で使用された技術に従っている.

語彙サイズは256kトークンである.

3.2節:Filtering(フィルタリング)

事前訓練データセットをフィルタリングして,不要な発言や安全でない発言のリスクを減らし,特定の個人情報やその他の機密データをフィルタリングする.

これには,ヒューリスティックとモデルベースの分類器の両方を使用して,有害または低品質のコンテンツを除去することが含まれる.

さらに,事前訓練データ混合からすべての評価セットをフィルタリングし,ターゲットのコンタミネーション(汚染)分析を実行して評価セットの漏洩をチェックし,機密出力の拡散を最小限に抑えることで暗唱のリスクを低減する.

最終的なデータ混合は,2Bと7Bの両モデルで一連のアブレーションを通して決定された.

(Gemini Team, 2023)で提唱されたアプローチと同様に,訓練の終盤に関連性の高い高品質なデータのウェイトを高めるために,訓練を通してコーパスの混合を変化させるように訓練を段階的に行った.

4章:Instruction Tuning(命令チューニング)

我々は,Gemma 2Bと7Bを,テキストのみ,英語のみの合成,および人間が生成したプロンプト回答のペアの混合に対する教師ありファインチューニング(SFT:Supervised Fine-Tuning)と,ラベル付けされた英語のみの嗜好データで訓練された報酬モデルと,高品質なプロンプトのセットに基づいたポリシーによる人間のフィードバックからの強化学習(RLHF:Reinforcement Learning from Human Feedback)を用いてファインチューニングする.

我々は,この2つの段階が,モデル出力のダウンストリームの自動評価と人間嗜好評価の性能向上に重要であることを発見した.

4.1節:Supervised Fine-Tuning(教師ありファインチューニング)

我々は,LMベースのサイドバイサイド評価(Zheng et al., 2023)に基づいて,教師ありのファインチューニングのためのデータ混合を選択した.

Hold-Outされたプロンプトのセットが与えられると,テストモデルから回答を生成し,ベースラインモデルから同じプロンプトに対する回答を生成し,これらをランダムにシャッフルし,より大きな高能力モデルに2つの回答間の嗜好を表現するよう求める.

異なるプロンプトセットは,命令に従うこと,事実に忠実であること,創造性,安全性など,特定の能力を強調するために構築される.

我々が使用しているLMベースの自動判定ツールは,人間の嗜好に合わせるために,思考連鎖型プロンプト(Wei et al., 2022)やルーブリックや規約(Bai et al., 2022)の使用など,多くの手法を採用している.

4.2節:Filtering(フィルタリング)

合成データを使用する場合,そのデータに対して数段階のフィルタリングを実行し,特定の個人情報を示す例,安全でないまたは有害なモデル出力,誤った自己識別データ,または重複する例を削除する.

Geminiに続いて,我々は,より良いコンテキスト内帰属,ヘッジ,幻覚を最小化するための拒否を促すデータのサブセットを含めることで,他の測定基準のモデル性能を低下させることなく,いくつかの事実性測定基準の性能を向上させることができることを発見した.

最終的なデータ混合と,調整されたハイパーパラメータを含む教師ありのファインチューニングレシピは,安全性と幻覚に関するモデルの害を最小限に抑えながら,有用性を向上させることを基準に選択された.

4.3節:Formatting(フォーマット)

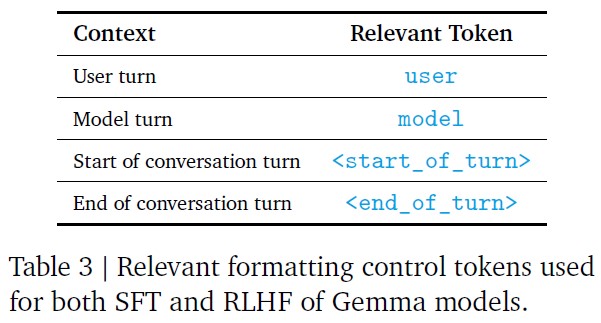

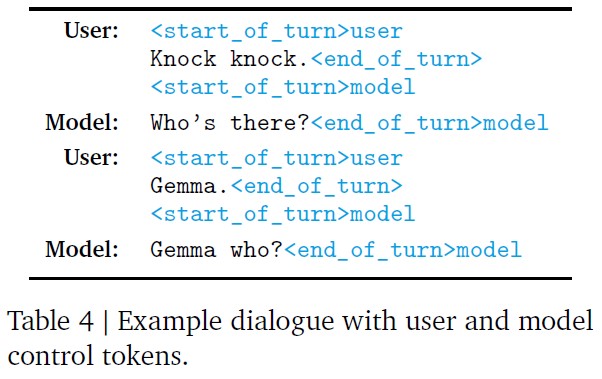

命令チューニングモデルは,訓練時と推論時の両方において,すべての命令チューニング例に余分な情報をアノテーションする特定のフォーマッターを使って訓練される.

これには2つの目的がある.

- 会話における役割(ユーザ役割など)を示すこと

- 会話におけるターンを区切ること(特に複数ターンの会話において)

この目的のために,トークナイザには特別な制御トークンが予約されている.

フォーマッターなしで首尾一貫した生成を得ることは可能だが,モデルの分布から外れてしまい,より悪い生成が作られる可能性が非常に高くなる.

関連するフォーマット制御トークンを表3に,対話例を表4に示す.

4.4節:Reinforcement Learning from Human Feedback(人間のフィードバックからの強化学習)

我々はさらに,RLHF(Christiano et al., 2017; Ouyang et al., 2022)を用いて教師付きファインチューニングモデルをファインチューニングした.

我々は人間の評価者から嗜好のペアを収集し,Geminiと同様にBradley-Terryモデル(Bradley and Terry, 1952)の下で報酬関数を訓練した.

ポリシーは,REINFORCE(Williams, 1992)のVariantを用い,最初にチューニングされたモデルに対するKullback-Leibler正則化項を用いて,この報酬関数を最適化するように訓練された.

SFT段階と同様に,ハイパーパラメータを調整し,さらに報酬ハッキングを緩和するために(Amodei et al., 2016; Skalse et al., 2022),自動評価者として高容量モデルに依存し,ベースラインモデルに対するサイドバイサイド比較を計算した.

5章:Evaluation(評価)

我々は,自動化されたベンチマークと人間による評価の両方を用いて,広範なドメインにわたってGemmaを評価する.

5.1節:Human Preference Evaluations(人間嗜好評価)

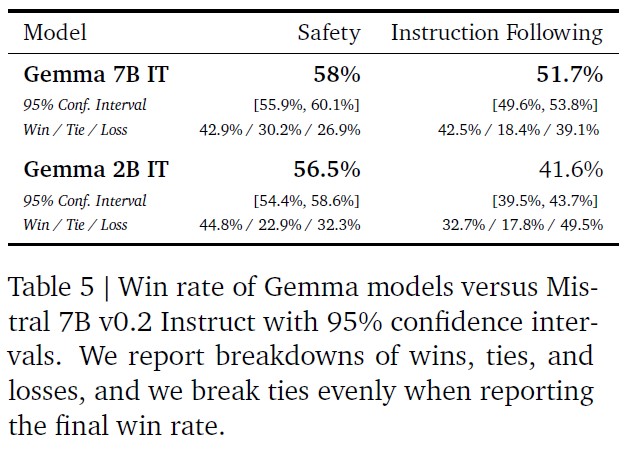

ファインチューニングされたモデルで標準的な学術的ベンチマークを実行することに加え,最終リリース候補を人間評価研究に送り,Mistral v0.2 7B Instructモデル(Jiang et al., 2023)と比較させた.

クリエイティブなライティングタスク,コーディング,命令に従うことをモデルに求めることを目的とした約1000のプロンプトのHold-Outコレクションにおいて,Gemma 7B ITはMistral v0.2 7B Instructに対して51.7%の勝率を示し,Gemma 2B ITは41.6%の勝率を示した.

基本的な安全プロトコルをテストすることを目的とした約400のプロンプトのHold-Outコレクションでは,Gemma 7B ITの勝率は58%であり,Gemma 2B ITの勝率は56.5%であった.

対応する数値を表5に示す.

5.2節:Automated Benchmarks(自動化されたベンチマーク)

我々は,Gemmaモデルの性能を以下のドメインなどで測定する.

- 物理的推論(Bisk et al., 2019)

- 社会的推論(Sap et al., 2019)

- 質問解答(Clark et al., 2019; Kwiatkowski et al., 2019)

- コーディング(Austin et al., 2021; Chen et al., 2021)

- 数学(Cobbe et al., 2021)

- 常識的推論(Sakaguchi et al., 2019)

- 言語モデリング(Paperno et al., 2016)

- 読解(Joshi et al., 2017)

ほとんどの自動ベンチマークについては,Geminiと同じ評価手法を使用している.

特に,Mistralと比較したパフォーマンスを報告するベンチマークについては,Mistralのテクニカルレポートに記載されている手法を可能な限り忠実に再現した.

具体的なベンチマークは以下の通りである

- ARC(Clark et al., 2018)

- CommonsenseQA(Talmor et al., 2019)

- Big Bench Hard(Suzgun et al., 2022)

- AGI Eval(英語のみ)(Zhong et al., 2023)

ライセンスが制限されているため,LLaMA-2で評価を実行することができず,以前に報告された測定基準のみを引用した(Touvron et al., 2023b).

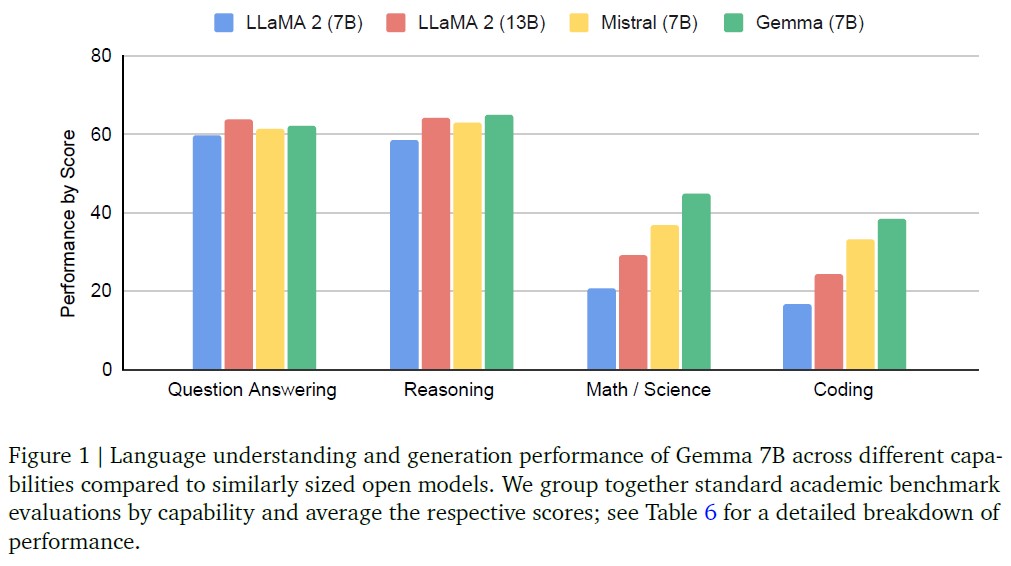

※訳注:図1は原文では参照されていませんが,こちらに置いておきます.

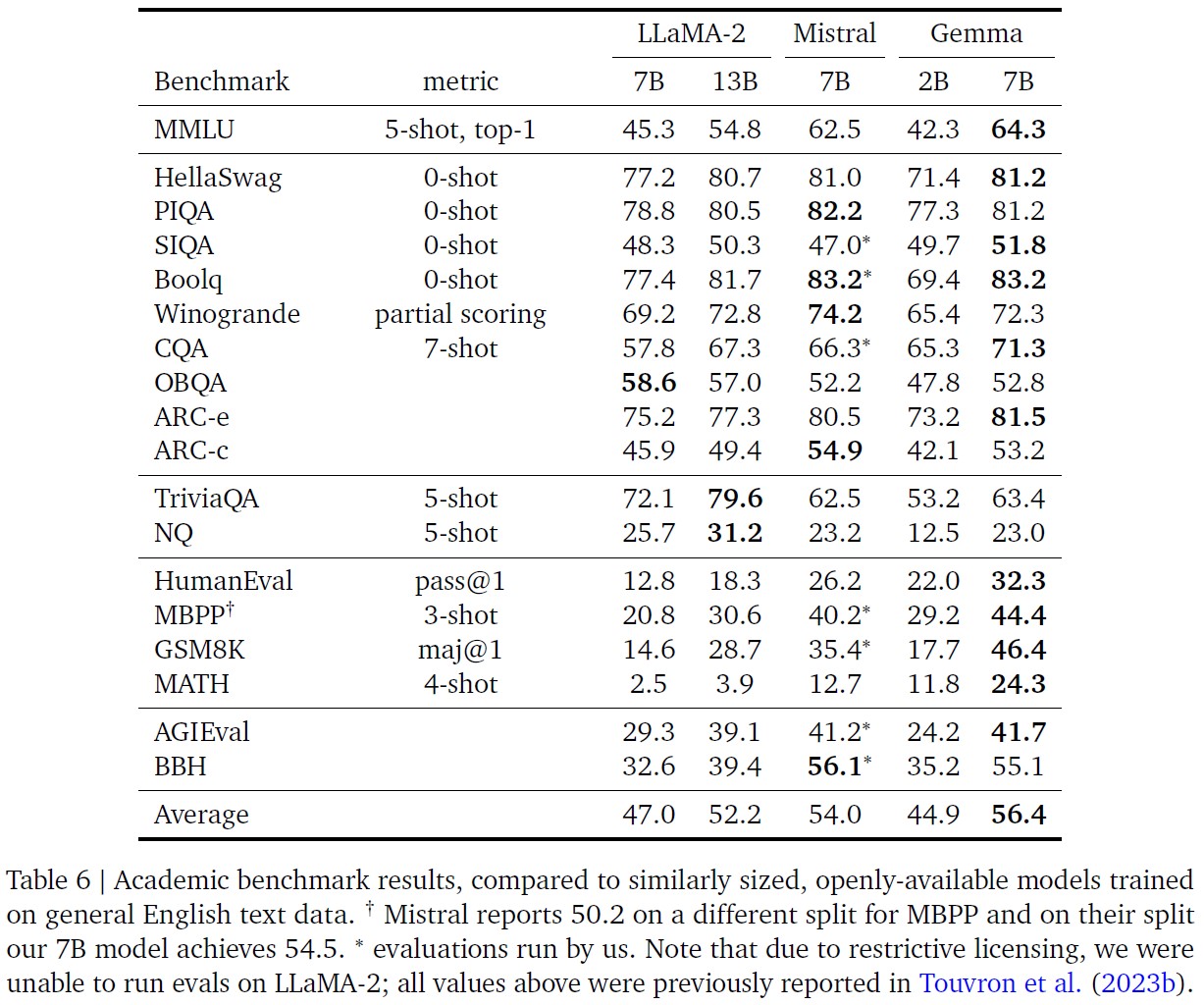

表6では,Gemma 2Bおよび7Bモデルを,一連のアカデミックベンチマークにおいて,いくつかの外部のオープンソース(OSS)のLLMと比較している.

MMLU(Hendrycks et al., 2020)では,Gemma 7Bは,同程度かそれ以下のスケールで,すべてのOSS代替モデルを上回った.

また,LLaMA2 13Bを含むいくつかのより大規模なモデルも上回っている.

しかし,人間の専門家の性能は,ベンチマーク作成者により89.8%と評価されている.

Gemini Ultraは,この閾値を超えた最初のモデルであるため,Geminiと人間レベルのパフォーマンスを達成するためには,継続的な改善の余地が大きい.

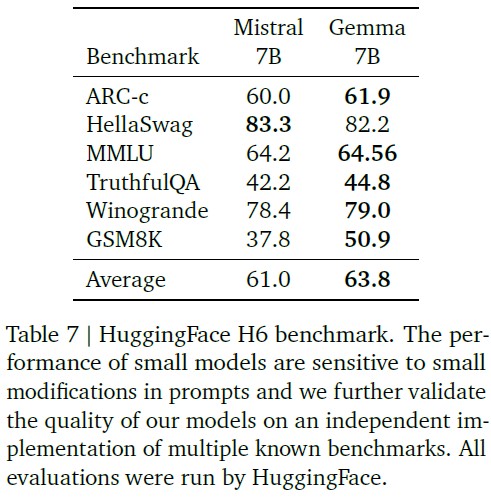

※訳注:表7は原文では参照されていませんが,こちらに置いておきます.

Gemmaモデルは,数学とコーディングのベンチマークで特に高い性能を示している.

モデルの一般的な分析能力のベンチマークによく使用される数学タスクにおいて,GemmaモデルはGSM8K(Cobbe et al., 2021)や,より難しいMATH(Hendrycks et al., 2021)ベンチマークで,他のモデルを少なくとも10ポイント上回っている.

同様に,HumanEval(Chen et al., 2021)では,他のオープンモデルを少なくとも6ポイント上回っている.

MBPPでは,コードファインチューニングされたCodeLLaMA-7Bモデルの性能さえ上回る(CodeLLaMAのスコアは41.4%,Gemma 7Bは44.4%).

5.3節:Memorization Evaluations(記憶評価)

最近の研究で,アライメントされたモデルは,アライメントをバイパスする新たな敵対的攻撃に対して脆弱である可能性が示された(Nasr et al., 2023).

これらの攻撃はモデルを発散させる可能性があり,その過程で記憶された訓練データを再利用することもある.

これは,モデルの記憶に関する妥当な上限値として機能し(Nasr et al., 2023),いくつかの研究で使用されている一般的な定義である(Anil et al., 2023; Carlini et al., 2022; Kudugunta et al., 2023).

(Anil et al., 2023)と同じ方法で,Gemmaの事前訓練済みモデルの記憶をテストする.

※我々が「記憶」(Memorization)という言葉を使うのは,https://blog.genlaw.org/explainers/files.htmlにある定義に依存している.

各コーパスから10,000文書をサンプリングし,最初の50トークンをモデルのプロンプトとして使用する.

モデルによって生成された後続の50個のトークンが,テキスト中のグランドトゥルースの継続と完全に一致する場合に,テキストを記憶したと分類する.

しかし,言い換えられた記憶の可能性をよりよく捉えるために,10%の編集距離閾値を用いた近似記憶(Ippolito et al., 2022)を含める.

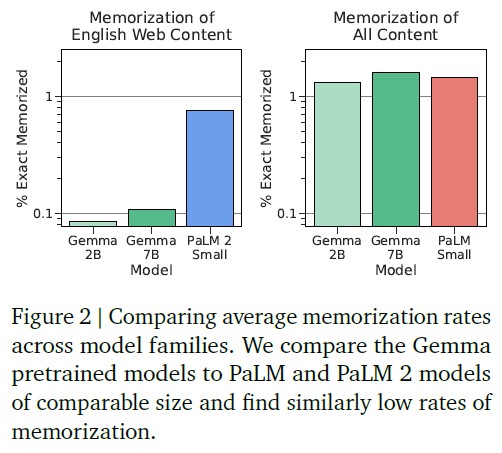

図2では,最も近いサイズのPaLM(Chowdhery et al., 2022)とPaLM 2モデル(Anil et al., 2023)との評価結果を比較している.

5.3.1項:Verbatim Memorization(逐語記憶)

PaLM 2は,PaLMと共通の訓練コーパスのサブセットで評価することで,PaLMと比較した.

しかし,Gemmaの事前訓練データとPaLMモデルの重複はさらに少ないため,この同じ方法を用いると,記憶率がはるかに低くなることがわかる(図2左).

その代わりに,事前訓練データセット全体の「総記憶量」(Total Memorization)を推定することで,より信頼性の高い推定値が得られることがわかる(図2右).

ここで,GemmaはPaLMに匹敵する割合で訓練データを記憶していることがわかる.

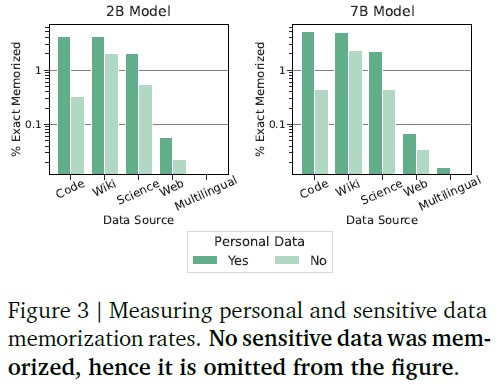

5.3.2項:Personal Data(個人データ)

おそらくより重要なのは,個人データが記憶される可能性があることである.

Gemmaの事前訓練されたモデルを安全で信頼できるものにする一環として,我々は自動化された技術を使って,訓練セットから特定の個人情報やその他の機密データをフィルタリングした.

個人データが発生する可能性を特定するために,Google Cloud Data Loss Prevention(DLP)ツールを使用している.

※https://cloud.google.com/security/products/dlpにある.

このツールは,個人データの多くのカテゴリー(例えば,名前,電子メールなど)に基づいて,3つの重大度レベルを出力する.

最も高い重要度を「機密」(Sensitive),残りの2つを単に「個人」(Personal)と分類する.

次に,いくつの記憶された出力に機密データや個人データが含まれているかを測定する.

図3に示すように,機密データを記憶するケースは観察されなかった.

我々は,上記のように潜在的に「個人」であると分類したいくつかのデータを,モデルが記憶していることを発見した.

しかし,その割合はかなり低い.

さらに,これらのツールは多くの偽陽性があることが知られており(パターンにマッチするだけで,コンテキストを考慮しないため),我々の結果は特定された個人データの量を過大評価している可能性が高いことに注意することが重要である.

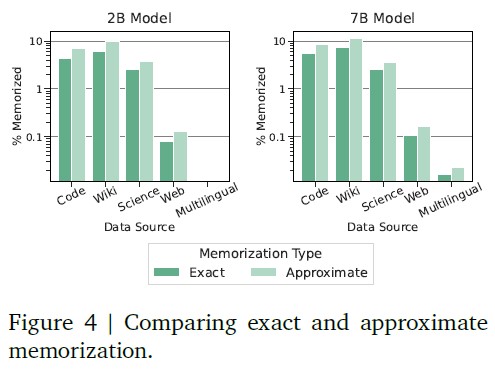

5.3.3項:Approximate Memorization(近似記憶)

図4では,およそ50%多くのデータが記憶され(対数目盛りに注意),これはデータセットの異なるサブカテゴリー間でほぼ一貫していることがわかる.

6章:Responsible Deployment(責任あるデプロイ)

グーグルのAI技術の過去のリリース(Gemini Team, 2023; Kavukcuoglu et al., 2022)と同様に,予見可能なダウンストリームの社会的影響を特定,測定,管理するために,モデルの責任ある開発とデプロイのための構造化されたアプローチに従っている.

最近のGeminiのリリースと同様に,これらは言語モデルのリスクに関する先行学術文献(Weidinger et al., 2021),業界全体で実施された同様の先行演習から得られた知見(Anil et al., 2023),社内外の専門家との継続的な関わり,新しいモデルの脆弱性を発見するための非構造的な試みから情報を得ている.

6.1節:Benefits(利点)

我々は,AIの科学と技術におけるオープン化が大きな利益をもたらすと信じている.

オープンソースは科学とイノベーションの重要な原動力であり,ほとんどの状況において責任ある行為である.

しかし,このことは,現在または将来において危害をもたらすツールを行為者に提供するリスクとのバランスをとる必要がある.

グーグルは,成功した研究イノベーション(GraphCast,Transformer,BERT,T5,Word2Vec)へのより広範なアクセスを提供することに長年コミットしており,GemmaをAI開発エコシステムにリリースすることで,ダウンストリームの開発者が科学,教育,芸術などの分野で多くの有益なアプリケーションを作成できるようになると信じている.

我々が提供する命令チューニングは,様々な開発者がGemmaのチャットとコード機能を活用し,自身の有益なアプリケーションをサポートすることを奨励するものであり,同時に特定のユースケース向けにモデルの機能を特化させるカスタムファインチューニングを可能にする.

Gemmaが幅広い開発者のニーズに対応できるよう,我々は異なる環境を最適にサポートする2つのモデルサイズをリリースし,これらのモデルを多くのプラットフォームで利用できるようにしている(詳細はKaggleを参照されたい).

このようにGemmaへの幅広いアクセスを提供することで,新しいベンチャー企業や独立系開発者がこれらの技術をワークストリームに取り入れる際に直面する経済的・技術的障壁を軽減することができるはずである.

開発者に我々の命令チューニングモデルを提供するだけでなく,対応するベースとなる事前訓練済みモデルへのアクセスも提供している.

そうすることで,さらなるAI安全性研究とコミュニティのイノベーションを促進し,開発者が利用できるモデルのプールを広げ,コミュニティがすでに恩恵を受けている透明性と解釈可能性の研究の様々な手法を構築することを意図している(Pacchiardi et al., 2023; Zou et al., 2023).

6.2節:Risks(リスク)

AI開発のエコシステムに利益をもたらすだけでなく,ディープフェイク画像の作成,AIが生成した偽情報,違法で不穏な資料の作成など,LLMの悪意のある利用が,個人レベルでも組織レベルでも被害をもたらす可能性があることを我々は認識している(Weidinger et al., 2021).

さらに,モデルをAPIで公開するのではなく,モデル重みへのアクセスを提供することは,責任あるデプロイのための新たな課題を提起する.

悪質な行為者がGemmaを使用する際には,Gemmaの使用禁止ポリシーに反する方法でのGemmaモデルの使用を禁止する利用規約が適用されるにも関わらず,第一に悪質な行為者が悪意を持ってGemmaをファインチューニングすることを防ぐことはできない.

しかし,オープンシステムの意図的な悪用に対するより強固な緩和戦略を構築するためには,さらなる取り組みが必要であることを認識しており,Google DeepMindは社内およびより広範なAIコミュニティとの協力のもと,引き続き検討を進めていく.

我々が直面している2つ目の課題は,有害な言葉の生成や差別的な社会的危害の永続化,モデルの幻覚,個人を特定できる情報の漏洩など,オープンモデルの意図しない行動から開発者やダウンストリームユーザを保護することである.

APIの背後にモデルを配置する場合,これらのリスクは様々なフィルタリング手法によって削減することがでる.

6.3節:Mitigations(緩和)

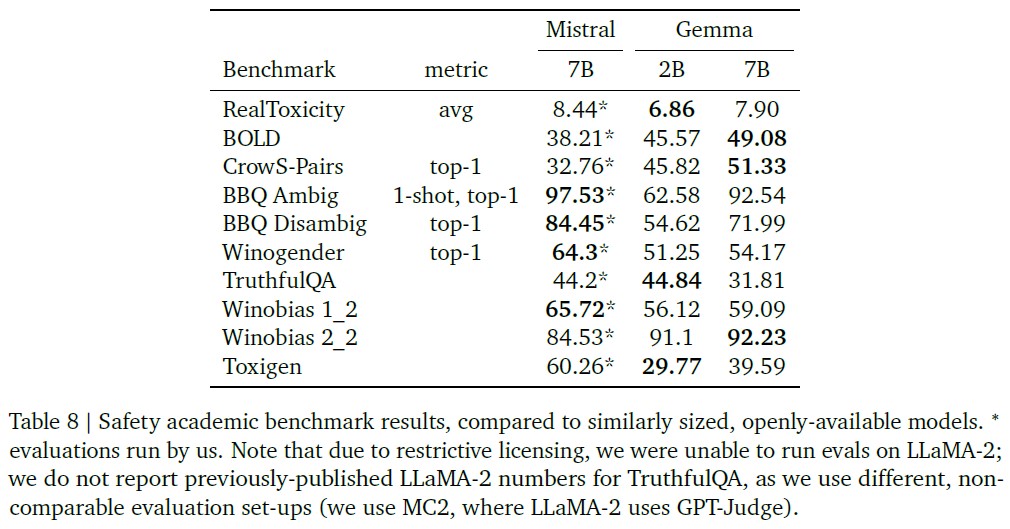

Gemmaのモデル群にはこのような防御層がないため,Geminiのアプローチに沿った事前訓練データのフィルタリングとバイアスの測定,標準化されたAIの安全性ベンチマークによる安全性の評価,Gemmaの外部使用に関連するリスクをよりよく理解するための社内レッドチーム活動,モデルを厳格な倫理・安全性評価にかけることで,これらのリスクから保護するよう努めた.

その結果を表8に示す.

我々はモデルの改良に多大な投資をしてきたが,その限界を認識している.

ダウンストリームユーザの透明性を確保するため,研究者にGemmaをより包括的に理解してもらうために,詳細なモデルカードを発表した.

我々はまた,開発者が責任を持ってAIを構築することを支援するためのGenerative AI Responsible Toolkitをリリースした.

このツールキットには,開発者が責任あるAIのベストプラクティスを設計・実施し,ユーザの安全を守るための一連のアセットが含まれている.

オープンウェイトモデルの公開が比較的斬新であるということは,これらのモデルの新たな使用法や悪用法がまだ発見されていないということであり,Google DeepMindが将来のモデル開発と並行して,強固な緩和戦略の継続的な研究開発に取り組んでいるのはそのためである.

6.4節:Assessment(アセスメント)

最終的には,既存のエコシステム内でアクセス可能なより大規模なシステムの能力を考慮すれば,GemmaのリリースがAIリスクポートフォリオ全体に与える影響はごくわずかであると考える.

この点を考慮し,また,研究,監査,ダウンストリームの製品開発におけるこれらのモデルの有用性を考慮すると,AIコミュニティにとってのGemmaの利益は,説明されたリスクを上回ると確信している.

6.5節:Going Forward(今後に向けて)

指針として,Google DeepMindは,我々のモデルによる潜在的なリスクに比例した評価と安全性の軽減を採用するよう努めている.

この場合,Gemmaモデルがコミュニティに正味の利益をもたらすと確信しているが,安全性を重視するのは,このリリースの不可逆的な性質に起因している.

オープンモデルから生じる害はまだ十分に定義されておらず,そのようなモデルに対する確立された評価の枠組みも存在しないため,我々は今後もこの前例に従い,オープンモデルの開発には慎重かつ慎重なアプローチを取っていく.

能力が進歩するにつれて,責任あるAI開発を保証するために,テストの延長,リリースの時期のずらし,あるいは代替のアクセスメカニズムを検討する必要が出てくるかもしれない.

エコシステムの進化に伴い,我々は,より広範なAIコミュニティに対し,単純化された「オープンかクローズドか」の議論を超えて,潜在的な危害を誇張したり最小化したりすることを避けるよう強く求める.

我々は,リスクと利益に対するニュアンスのある協調的なアプローチが不可欠であると考えているからである.

Google DeepMindでは,質の高い評価の開発に取り組んでおり,AIシステムをより深く理解するために,コミュニティがこの取り組みに参加することを求めている.

7章:Discussion and Conclusion(議論と結論)

Gemmaは,テキストとコードのための生成言語モデルファミリーである.

Gemmaは,オープンに利用可能な言語モデルの性能,安全性,責任ある開発の最先端を進める.

特に,我々の広範な安全性評価と緩和策を考慮すれば,Gemmaモデルがコミュニティにとって正味の利益をもたらすと確信している.

しかし,このリリースは不可逆的であり,オープンモデルから生じる害はまだ十分に定義されていないことを認識している.

そのため,これらのモデルの潜在的なリスクに見合った評価と安全性の緩和策を採用し続けている.

さらに,我々のモデルは,6つの標準的な安全性ベンチマークや,人間によるサイドバイサイド評価において,競合他社を凌駕している.

Gemmaモデルは,対話,推論,数学,コード生成を含む幅広い領域でパフォーマンスを向上させる.

MMLU(64.3%)とMBPP(44.4%)の結果は,Gemmaの高い性能と,オープンに利用可能なLLMの性能における継続的なヘッドルームの両方を実証している.

ベンチマークタスクにおける最先端の性能測定にとどまらず,コミュニティからどのような新しいユースケースが生まれ,我々が共にこの分野を発展させていく中で,どのような新しい機能が出現するのか,我々はわくわくしている.

我々は,研究者がGemmaを使って幅広い研究を加速させ,開発者が有益な新しいアプリケーションやユーザ体験,その他の機能を生み出すことを願っている.

Gemmaは,コード,データ,アーキテクチャ,命令チューニング,人間のフィードバックからの強化学習,評価など,Geminiモデルプログラムの多くの学習から恩恵を受けている.

Geminiのテクニカルレポートで議論されているように,LLMを使用する際の制限を網羅的ではない形で再掲する.

ベンチマークタスクで優れた性能を示したとしても,意図したとおりに確実に動作する,ロバストで安全なモデルを作成するためには,さらなる研究が必要である.

さらなる研究分野の例としては,事実性,アライメント,複雑な推論,敵対的入力に対する頑健性などが挙げられる.

Geminiが議論しているように,我々はより挑戦的で頑健なベンチマークの必要性に注目している.

References(参考文献)

- (Almazrouei et al., 2023) E. Almazrouei, H. Alobeidli, A. Alshamsi, A. Cappelli, R. Cojocaru, M. Debbah, Étienne Goffinet, D. Hesslow, J. Launay, Q. Malartic, D. Mazzotta, B. Noune, B. Pannier, and G. Penedo. The falcon series of open language models, 2023.

- (Amodei et al., 2016) D. Amodei, C. Olah, J. Steinhardt, P. Christiano, J. Schulman, and D. Mané. Concrete problems in AI safety. arXiv preprint, 2016.

- (Anil et al., 2023) R. Anil, A. M. Dai, O. Firat, M. Johnson, D. Lepikhin, A. Passos, S. Shakeri, E. Taropa, P. Bailey, Z. Chen, et al. Palm 2 technical report. arXiv preprint arXiv:2305.10403, 2023.

- (Austin et al., 2021) J. Austin, A. Odena, M. I. Nye, M. Bosma, H. Michalewski, D. Dohan, E. Jiang, C. J. Cai, M. Terry, Q. V. Le, and C. Sutton. Program synthesis with large language models. CoRR, abs/2108.07732, 2021. URL https: //arxiv.org/abs/2108.07732.

- (Bai et al., 2022) Y. Bai, S. Kadavath, S. Kundu, A. Askell, J. Kernion, A. Jones, A. Chen, A. Goldie, A. Mirhoseini, C. McKinnon, C. Chen, C. Olsson, C. Olah, D. Hernandez, D. Drain, D. Ganguli, D. Li, E. Tran-Johnson, E. Perez, J. Kerr, J. Mueller, J. Ladish, J. Landau, K. Ndousse, K. Lukosuite, L. Lovitt, M. Sellitto, N. Elhage, N. Schiefer, N. Mercado, N. DasSarma, R. Lasenby, R. Larson, S. Ringer, S. Johnston, S. Kravec, S. E. Showk, S. Fort, T. Lanham, T. Telleen-Lawton, T. Conerly, T. Henighan, T. Hume, S. R. Bowman, Z. Hatfield-Dodds, B. Mann, D. Amodei, N. Joseph, S. McCandlish, T. Brown, and J. Kaplan. Constitutional ai: Harmlessness from ai feedback, 2022.

- (Barham et al., 2022) P. Barham, A. Chowdhery, J. Dean, S. Ghemawat, S. Hand, D. Hurt, M. Isard, H. Lim, R. Pang, S. Roy, B. Saeta, P. Schuh, R. Sepassi, L. E. Shafey, C. A. Thekkath, and Y. Wu. Pathways: Asynchronous distributed dataflow for ml, 2022.

- (Bisk et al., 2019) Y. Bisk, R. Zellers, R. L. Bras, J. Gao, and Y. Choi. PIQA: reasoning about physical commonsense in natural language. CoRR, abs/1911.11641, 2019. URL https://arxiv.org/abs/1911.11641.

- (Bradley and Terry, 1952) R. A. Bradley and M. E. Terry. Rank analysis of incomplete block designs: I. the method of paired comparisons. Biometrika, 39, 1952.

- (Carlini et al., 2022) N. Carlini, D. Ippolito, M. Jagielski, K. Lee, F. Tramer, and C. Zhang. Quantifying memorization across neural language models. arXiv preprint arXiv:2202.07646, 2022.

- (Chen et al., 2021) M. Chen, J. Tworek, H. Jun, Q. Yuan, H. P. de Oliveira Pinto, J. Kaplan, H. Edwards, Y. Burda, N. Joseph, G. Brockman, A. Ray, R. Puri, G. Krueger, M. Petrov, H. Khlaaf, G. Sastry, P. Mishkin, B. Chan, S. Gray, N. Ryder, M. Pavlov, A. Power, L. Kaiser, M. Bavarian, C. Winter, P. Tillet, F. P. Such, D. Cummings, M. Plappert, F. Chantzis, E. Barnes, A. Herbert-Voss,W. H. Guss, A. Nichol, A. Paino, N. Tezak, J. Tang, I. Babuschkin, S. Balaji, S. Jain, W. Saunders, C. Hesse, A. N. Carr, J. Leike, J. Achiam, V. Misra, E. Morikawa, A. Radford, M. Knight, M. Brundage, M. Murati, K. Mayer, P. Welinder, B. McGrew, D. Amodei, S. McCandlish, I. Sutskever, and W. Zaremba. Evaluating large language models trained on code. CoRR, abs/2107.03374, 2021. URL https://arxiv.org/abs/2107.03374.

- (Chowdhery et al., 2022) A. Chowdhery, S. Narang, J. Devlin, M. Bosma, G. Mishra, A. Roberts, P. Barham, H. W. Chung, C. Sutton, S. Gehrmann, P. Schuh, K. Shi, S. Tsvyashchenko, J. Maynez, A. Rao, P. Barnes, Y. Tay, N. Shazeer, V. Prabhakaran, E. Reif, N. Du, B. Hutchinson, R. Pope, J. Bradbury, J. Austin, M. Isard, G. Gur-Ari, P. Yin, T. Duke, A. Levskaya, S. Ghemawat, S. Dev, H. Michalewski, X. Garcia, V. Misra, K. Robinson, L. Fedus, D. Zhou, D. Ippolito, D. Luan, H. Lim, B. Zoph, A. Spiridonov, R. Sepassi, D. Dohan, S. Agrawal, M. Omernick, A. M. Dai, T. S. Pillai, M. Pellat, A. Lewkowycz, E. Moreira, R. Child, O. Polozov, K. Lee, Z. Zhou, X. Wang, B. Saeta, M. Diaz, O. Firat, M. Catasta, J. Wei, K. Meier-Hellstern, D. Eck, J. Dean, S. Petrov, and N. Fiedel. Palm: Scaling language modeling with pathways, 2022.

- (Christiano et al., 2017) P. F. Christiano, J. Leike, T. Brown, M. Martic, S. Legg, and D. Amodei. Deep reinforcement learning from human preferences. Advances in Neural Information Processing Systems, 30, 2017.

- (Clark et al., 2019) C. Clark, K. Lee, M. Chang, T. Kwiatkowski, M. Collins, and K. Toutanova. Boolq: Exploring the surprising difficulty of natural yes/no questions. CoRR, abs/1905.10044, 2019. URL https://arxiv.org/abs/1905.10044.

- (Clark et al., 2018) P. Clark, I. Cowhey, O. Etzioni, T. Khot, A. Sabharwal, C. Schoenick, and O. Tafjord. Think you have solved question answering? try arc, the ai2 reasoning challenge, 2018.

- (Cobbe et al., 2021) K. Cobbe, V. Kosaraju, M. Bavarian, M. Chen, H. Jun, L. Kaiser, M. Plappert, J. Tworek, J. Hilton, R. Nakano, C. Hesse, and J. Schulman. Training verifiers to solve math word problems. CoRR, abs/2110.14168, 2021. URL https://arxiv.org/abs/2110.14168.

- (Dean et al., 2012) J. Dean, G. Corrado, R. Monga, K. Chen, M. Devin, M. Mao, M. a. Ranzato, A. Senior, P. Tucker, K. Yang, Q. Le, and A. Ng. Large scale distributed deep networks. In F. Pereira, C. Burges, L. Bottou, and K. Weinberger, editors, Advances in Neural Information Processing Systems, volume 25. Curran Associates, Inc., 2012. URL https://proceedings.neurips.cc/paper_files/paper/2012/file/6aca97005c68f1206823815f66102863-Paper.pdf.

- (Devlin et al., 2018) J. Devlin, M. Chang, K. Lee, and K. Toutanova. BERT: pre-training of deep bidirectional transformers for language understanding. CoRR, abs/1810.04805, 2018. URL https://arxiv.org/abs/1810.04805.

- (Gemini Team, 2023) Gemini Team. Gemini: A family of highly capable multimodal models, 2023.

- (Hendrycks et al., 2020) D. Hendrycks, C. Burns, S. Basart, A. Zou, M. Mazeika, D. Song, and J. Steinhardt. Measuring massive multitask language understanding. CoRR, abs/2009.03300, 2020. URL https://arxiv.org/abs/2009.03300.

- (Hendrycks et al., 2021) D. Hendrycks, C. Burns, S. Kadavath, A. Arora, S. Basart, E. Tang, D. Song, and J. Steinhardt. Measuring mathematical problem solving with the math dataset. NeurIPS, 2021.

- (Ippolito et al., 2022) D. Ippolito, F. Tramèr, M. Nasr, C. Zhang, M. Jagielski, K. Lee, C. A. Choquette-Choo, and N. Carlini. Preventing verbatim memorization in language models gives a false sense of privacy. arXiv preprint arXiv:2210.17546, 2022.

- (Jiang et al., 2023) A. Q. Jiang, A. Sablayrolles, A. Mensch, C. Bamford, D. S. Chaplot, D. de las Casas, F. Bressand, G. Lengyel, G. Lample, L. Saulnier, L. R. Lavaud, M.-A. Lachaux, P. Stock, T. L. Scao, T. Lavril, T. Wang, T. Lacroix, and W. E. Sayed. Mistral 7b, 2023.

- (Joshi et al., 2017) M. Joshi, E. Choi, D. S. Weld, and L. Zettlemoyer. Triviaqa: A large scale distantly supervised challenge dataset for reading comprehension. CoRR, abs/1705.03551, 2017. URL https://arxiv.org/abs/1705.03551.

- (Kavukcuoglu et al., 2022) K. Kavukcuoglu, P. Kohli, L. Ibrahim, D. Bloxwich, and S. Brown. How our principles helped define alphafold’s release, 2022.

- (Kudo and Richardson, 2018) T. Kudo and J. Richardson. SentencePiece: A simple and language independent subword tokenizer and detokenizer for neural text processing. In E. Blanco andW. Lu, editors, Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing: System Demonstrations, pages 66–71, Brussels, Belgium, Nov. 2018. Association for Computational Linguistics. doi: 10.18653/v1/D18-2012. URL https://aclanthology.org/D18-2012.

- (Kudugunta et al., 2023) S. Kudugunta, I. Caswell, B. Zhang, X. Garcia, C. A. Choquette-Choo, K. Lee, D. Xin, A. Kusupati, R. Stella, A. Bapna, et al. Madlad-400: A multilingual and document-level large audited dataset. arXiv preprint arXiv:2309.04662, 2023.

- (Kwiatkowski et al., 2019) T. Kwiatkowski, J. Palomaki, O. Redfield, M. Collins, A. Parikh, C. Alberti, D. Epstein, I. Polosukhin, J. Devlin, K. Lee, K. Toutanova, L. Jones, M. Kelcey, M.-W. Chang, A. M. Dai, J. Uszkoreit, Q. Le, and S. Petrov. Natural questions: A benchmark for question answering research. Transactions of the Association for Computational Linguistics, 7:452–466, 2019. doi: 10.1162/tacl_a_00276. URL https://aclanthology.org/Q19-1026.

- (LeCun et al., 2015) Y. LeCun, Y. Bengio, and G. Hinton. Deep learning. nature, 521(7553):436–444, 2015.

- (Mikolov et al., 2013) T. Mikolov, K. Chen, G. Corrado, and J. Dean. Efficient estimation of word representations in vector space. In Y. Bengio and Y. LeCun, editors, 1st International Conference on Learning Representations, ICLR 2013, Scottsdale, Arizona, USA, May 2-4, 2013, Workshop Track Proceedings, 2013. URL https://arxiv.org/abs/1301.3781.

- (Nasr et al., 2023) M. Nasr, N. Carlini, J. Hayase, M. Jagielski, A. F. Cooper, D. Ippolito, C. A. Choquette-Choo, E. Wallace, F. Tramèr, and K. Lee. Scalable extraction of training data from (production) language models. arXiv preprint arXiv:2311.17035, 2023.

- (Ouyang et al., 2022) L. Ouyang, J. Wu, X. Jiang, D. Almeida, C. Wainwright, P. Mishkin, C. Zhang, S. Agarwal, K. Slama, A. Ray, et al. Training language models to follow instructions with human feedback. Advances in Neural Information Processing Systems, 35, 2022.

- (Pacchiardi et al., 2023) L. Pacchiardi, A. J. Chan, S. Mindermann, I. Moscovitz, A. Y. Pan, Y. Gal, O. Evans, and J. Brauner. How to catch an ai liar: Lie detection in black-box llms by asking unrelated questions, 2023.

- (Paperno et al., 2016) D. Paperno, G. Kruszewski, A. Lazaridou, Q. N. Pham, R. Bernardi, S. Pezzelle, M. Baroni, G. Boleda, and R. Fernández. The LAMBADA dataset: Word prediction requiring a broad discourse context. CoRR, abs/1606.06031, 2016. URL https://arxiv.org/abs/1606.06031.

- (Raffel et al., 2019) C. Raffel, N. Shazeer, A. Roberts, K. Lee, S. Narang, M. Matena, Y. Zhou, W. Li, and P. J. Liu. Exploring the limits of transfer learning with a unified text-to-text transformer. CoRR, abs/1910.10683, 2019. URL https://arxiv.org/abs/1910.10683.

- (Roberts et al., 2022) A. Roberts, H. W. Chung, A. Levskaya, G. Mishra, J. Bradbury, D. Andor, S. Narang, B. Lester, C. Gaffney, A. Mohiuddin, C. Hawthorne, A. Lewkowycz, A. Salcianu, M. van Zee, J. Austin, S. Goodman, L. B. Soares, H. Hu, S. Tsvyashchenko, A. Chowdhery, J. Bastings, J. Bulian, X. Garcia, J. Ni, A. Chen, K. Kenealy, J. H. Clark, S. Lee, D. Garrette, J. Lee-Thorp, C. Raffel, N. Shazeer, M. Ritter, M. Bosma, A. Passos, J. Maitin-Shepard, N. Fiedel, M. Omernick, B. Saeta, R. Sepassi, A. Spiridonov, J. Newlan, and A. Gesmundo. Scaling up models and data with t5x and seqio, 2022.

- (Roberts et al., 2023) A. Roberts, H. W. Chung, G. Mishra, A. Levskaya, J. Bradbury, D. Andor, S. Narang, B. Lester, C. Gaffney, A. Mohiuddin, et al. Scaling up models and data with t5x and seqio. Journal of Machine Learning Research, 24(377):1–8, 2023.

- (Sakaguchi et al., 2019) K. Sakaguchi, R. L. Bras, C. Bhagavatula, and Y. Choi. WINOGRANDE: an adversarial winograd schema challenge at scale. CoRR, abs/1907.10641, 2019. URL https://arxiv.org/abs/1907.10641.

- (Sap et al., 2019) M. Sap, H. Rashkin, D. Chen, R. L. Bras, and Y. Choi. Socialiqa: Commonsense reasoning about social interactions. CoRR, abs/1904.09728, 2019. URL https://arxiv.org/abs/1904.09728.

- (Shazeer, 2019) N. Shazeer. Fast transformer decoding: One writehead is all you need. CoRR, abs/1911.02150, 2019. URL https://arxiv.org/abs/1911.02150.

- (Shazeer, 2020) N. Shazeer. GLU variants improve transformer. CoRR, abs/2002.05202, 2020. URL https://arxiv.org/abs/2002.05202.

- (Skalse et al., 2022) J. M. V. Skalse, N. H. R. Howe, D. Krasheninnikov, and D. Krueger. Defining and characterizing reward gaming. In NeurIPS, 2022.

- (Su et al., 2021) J. Su, Y. Lu, S. Pan, B. Wen, and Y. Liu. Roformer: Enhanced transformer with rotary position embedding. CoRR, abs/2104.09864, 2021. URL https://arxiv.org/abs/2104.09864.

- (Sutskever et al., 2014) I. Sutskever, O. Vinyals, and Q. V. Le. Sequence to sequence learning with neural networks. CoRR, abs/1409.3215, 2014. URL https://arxiv.org/abs/1409.3215.

- (Suzgun et al., 2022) M. Suzgun, N. Scales, N. Schärli, S. Gehrmann, Y. Tay, H. W. Chung, A. Chowdhery, Q. V. Le, E. H. Chi, D. Zhou, and J. Wei. Challenging big-bench tasks and whether chain-of-thought can solve them, 2022.

- (Talmor et al., 2019) A. Talmor, J. Herzig, N. Lourie, and J. Berant. Commonsenseqa: A question answering challenge targeting commonsense knowledge, 2019.

- (Touvron et al., 2023a) H. Touvron, T. Lavril, G. Izacard, X. Martinet, M.- A. Lachaux, T. Lacroix, B. Rozière, N. Goyal, E. Hambro, F. Azhar, A. Rodriguez, A. Joulin, E. Grave, and G. Lample. Llama: Open and efficient foundation language models, 2023a.

- (Touvron et al., 2023b) H. Touvron, L. Martin, K. Stone, P. Albert, A. Almahairi, Y. Babaei, N. Bashlykov, S. Batra, P. Bhargava, S. Bhosale, D. Bikel, L. Blecher, C. C. Ferrer, M. Chen, G. Cucurull, D. Esiobu, J. Fernandes, J. Fu, W. Fu, B. Fuller, C. Gao, V. Goswami, N. Goyal, A. Hartshorn, S. Hosseini, R. Hou, H. Inan, M. Kardas, V. Kerkez, M. Khabsa, I. Kloumann, A. Korenev, P. S. Koura, M.-A. Lachaux, T. Lavril, J. Lee, D. Liskovich, Y. Lu, Y. Mao, X. Martinet, T. Mihaylov, P. Mishra, I. Molybog, Y. Nie, A. Poulton, J. Reizenstein, R. Rungta, K. Saladi, A. Schelten, R. Silva, E. M. Smith, R. Subramanian, X. E. Tan, B. Tang, R. Taylor, A. Williams, J. X. Kuan, P. Xu, Z. Yan, I. Zarov, Y. Zhang, A. Fan, M. Kambadur, S. Narang, A. Rodriguez, R. Stojnic, S. Edunov, and T. Scialom. Llama 2: Open foundation and fine-tuned chat models, 2023b.

- (Vaswani et al., 2017) A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, L. Kaiser, and I. Polosukhin. Attention is all you need. CoRR, abs/1706.03762, 2017. URL https://arxiv.org/abs/1706.03762.

- (Wei et al., 2022) J. Wei, X. Wang, D. Schuurmans, M. Bosma, E. H. Chi, Q. Le, and D. Zhou. Chain of thought prompting elicits reasoning in large language models. CoRR, abs/2201.11903, 2022. URL https://arxiv.org/abs/2201.11903.

- (Weidinger et al., 2021) L. Weidinger, J. Mellor, M. Rauh, C. Griffin, J. Uesato, P. Huang, M. Cheng, M. Glaese, B. Balle, A. Kasirzadeh, Z. Kenton, S. Brown, W. Hawkins, T. Stepleton, C. Biles, A. Birhane, J. Haas, L. Rimell, L. A. Hendricks, W. Isaac, S. Legassick, G. Irving, and I. Gabriel. Ethical and social risks of harm from language models. CoRR, abs/2112.04359, 2021. URL https://arxiv.org/abs/2112.04359.

- (Williams, 1992) R. J. Williams. Simple statistical gradientfollowing algorithms for connectionist reinforcement learning. Machine learning, 8, 1992.

- (XLA, 2019) XLA. Xla: Optimizing compiler for tensorflow, 2019. URL https://www.tensorflow.org/xla.

- (Xu et al., 2021) Y. Xu, H. Lee, D. Chen, B. A. Hechtman, Y. Huang, R. Joshi, M. Krikun, D. Lepikhin, A. Ly, M. Maggioni, R. Pang, N. Shazeer, S. Wang, T. Wang, Y. Wu, and Z. Chen. GSPMD: general and scalable parallelization for ML computation graphs. CoRR, abs/2105.04663, 2021. URL https://arxiv.org/abs/2105.04663.

- (Zhang and Sennrich, 2019) B. Zhang and R. Sennrich. Root mean square layer normalization. CoRR, abs/1910.07467, 2019. URL https://arxiv.org/abs/1910.07467.

- (Zheng et al., 2023) L. Zheng, W.-L. Chiang, Y. Sheng, S. Zhuang, Z. Wu, Y. Zhuang, Z. Lin, Z. Li, D. Li, E. P. Xing, H. Zhang, J. E. Gonzalez, and I. Stoica. Judging llm-as-a-judge with mt-bench and chatbot arena, 2023.

- (Zhong et al., 2023) W. Zhong, R. Cui, Y. Guo, Y. Liang, S. Lu, Y. Wang, A. Saied, W. Chen, and N. Duan. Agieval: A human-centric benchmark for evaluating foundation models, 2023.

- (Zou et al., 2023) A. Zou, L. Phan, S. Chen, J. Campbell, P. Guo, R. Ren, A. Pan, X. Yin, M. Mazeika, A.-K. Dombrowski, S. Goel, N. Li, M. J. Byun, Z. Wang, A. Mallen, S. Basart, S. Koyejo, D. Song, M. Fredrikson, J. Z. Kolter, and D. Hendrycks. Representation engineering: A top-down approach to ai transparency, 2023.

参考:Gemma: Open Models Based on Gemini Research and Technologyの解説動画

Gemma: Open Models Based on Gemini Research and Technologyの解説動画です.

まとめ

Gemma: Open Models Based on Gemini Research and Technologyの日本語訳を紹介しました.

グーグルのGemmaがわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.