Welcome to the Era of Experienceの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Welcome to the Era of Experienceの日本語訳を紹介します.

グーグルが主張する「経験の時代へようこそ」の意味がわかります.

※図表を含む論文の著作権はWelcome to the Era of Experienceの著者に帰属します.

論文中に章番号はないですが,わかりやすくするためにWelcome to the Era of Experienceの目次は以下のように設定しました.

- Abstract

- 1章:The Era of Human Data

- 2章:The Era of Experience

- 3章:Why Now?

- 4章:Reinforcement Learning Methods

- 5章:Consequences

- 6章:Conclusion

- Acknowledgements

- References

Welcome to the Era of Experienceを解説しつつ,私の考えも語ります.

Welcome to the Era of Experienceの概要と私の日本語訳は以下になります.

We stand on the threshold of a new era in artificial intelligence that promises to achieve an unprecedented level of ability.

我々は,前例のないレベルの能力を達成することが約束された人工知能の新時代の入り口に立っている.A new generation of agents will acquire superhuman capabilities by learning predominantly from experience.

新世代のエージェントは,主に経験から学習することで,超人的な能力を身につけるだろう.This note explores the key characteristics that will define this upcoming era.

このノートでは,この来るべき時代を定義する重要な特徴を探る.

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Acknowledgements」(謝辞)は省略していること

- 本文中に登場する表記「[20]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Welcome to the Era of Experienceの本文を読みすすめましょう!

目次

1章:The Era of Human Data(人間データの時代)

人工知能(AI:Artificial Intelligence)は近年,人間が作成した膨大なデータで訓練し,専門家である人間の例や嗜好を用いて微調整を行うことで,目覚ましい進歩を遂げている.

このアプローチは,圧倒的な一般性を達成した大規模言語モデル(LLMs:Large Language Models)に代表される.

ひとつのLLMが,詩の作文や物理学の問題の解決から,医療問題の診断や法律文書の要約まで,幅広いタスクをこなせるようになった.

しかしながら,人間を模倣することは,多くの人間の能力を有能なレベルまで再現するのに十分であるが,このアプローチ単独では,多くの重要なトピックやタスクにわたって超人的な知能を達成することはできなかったし,おそらく達成することもできないだろう.

数学,コーディング,科学などの重要な領域では,人間のデータから抽出される知識は急速に限界に近づいている.

高品質なデータソースの大部分(強力なエージェントの性能を実際に向上させることができるもの)は,すでに消費されているか,間もなく消費されるかのどちらかである.

人間のデータからの教師あり学習のみによる進歩のペースは明らかに減速しており,新しいアプローチの必要性を示している.

さらに,新しい定理や技術,科学的なブレークスルーのような価値ある新しい洞察は,現在の人間の理解の境界を超えたところにあり,既存の人間のデータでは捉えることができない.

2章:The Era of Experience(経験の時代)

さらに大きく進歩するためには,新しいデータソースが必要である.

このデータは,エージェントが強くなるにつれて継続的に改善される方法で生成されなければならない.

データを合成的に生成するための静的な手順では,すぐに限界に達してしまう.

これは,エージェントが自身の経験,すなわちエージェントが環境と相互作用することによって生成されるデータから継続的に学習することによって達成することができる.

AIは,経験が改良の主要な媒体となり,最終的には今日のシステムで使用されている人間のデータの規模を凌駕するような,新しい時代の入り口に立っている.

人間中心のAIを象徴する大規模な言語モデルでさえ,この移行はすでに始まっているのかもしれない.

その一例が数学の能力である.

AlphaProof[20]は最近,国際数学オリンピックでメダルを獲得した最初のプログラムとなり,人間中心のアプローチ[27, 19]の性能を凌駕した.

AlphaProofの強化学習(RL:Reinforcement Learning)アルゴリズムは,人間の数学者が長年かけて作成した約10万の公式証明に最初に触れ,その後,公式証明システムとの継続的なインタラクションを通じて,さらに1億を生成した.

※RLアルゴリズムとは,試行錯誤によって,つまり環境との相互作用の経験から行動を適応させることによって,目標を達成することを学習するものである.適応は,例えばニューラルネットワークの重みを更新したり,環境からのフィードバックに基づいてインコテキストを適応させたりするなど,どのような手段によっても起こり得る.

このインタラクティブな経験に焦点を当てることで,AlphaProofは既存の形式証明の枠を超えて数学的可能性を探求し,斬新で挑戦的な問題の解を発見することができた.

インフォーマルな数学は,専門家が生成したデータを自己生成データに置き換えることでも成功を収めている.

例えば,DeepSeekの最近の研究は,「強化学習のパワーと美しさを強調している.問題の解き方を明示的にモデルに教えるのではなく,適切なインセンティブを与えるだけで,モデルは自律的に高度な問題解決戦略を開発する.」[10]

我々の主張は,体験学習の可能性がフルに活用されれば,信じられないような新しい能力が生まれるというものである.

この経験の時代は,膨大な量の経験データから学習することに加え,さらにいくつかの次元で人間中心のAIシステムの限界を突破するエージェントや環境によって特徴づけられるだろう.

- エージェントは,インタラクションの短い断片ではなく,経験のストリームに生息する.

- 彼らの行動や観察は,人間の対話だけで相互作用するのではなく,環境に豊かに根ざしている.

- 彼らの報酬は,人間の先入観から来るものではなく,彼らの環境に対する経験に基づく.

- 経験について,人間の言葉だけで推論するのではなく,計画を立てたり,推論したりする.

今日のテクノロジーは,適切に選択されたアルゴリズムによって,これらのブレークスルーを達成するための十分強力な基盤をすでに提供していると我々は信じている.

さらに,AIコミュニティがこのアジェンダを追求することで,AIを真に超人的なエージェントへと急速に進歩させる,こうした方向性の新たなイノベーションに拍車がかかるだろう.

2.1節:Streams(ストリーム)

経験型エージェントは,生涯を通じて学習し続けることができる.

人間データの時代には,言語ベースのAIは主に短い対話エピソードに焦点を当ててきた.

例えば,ユーザが質問し,(おそらくいくつかの思考ステップやツール使用アクションの後に)エージェントが応答する.

一般的に,1つのエピソードから次のエピソードに引き継がれる情報はほとんどなく,時間の経過に伴う適応を妨げる.

さらに,エージェントは,ユーザの質問に直接答えるなど,現在のエピソード内での結果のみを目標とする.

対照的に,人間(および他の動物)は,何年も続く行動と観察の継続的なストリームの中に存在する.

情報はストリーム全体にわたって伝達され,彼らの行動は過去の経験から適応し,自己修正と改善を行う.

さらに,目標は行動と観察という観点から特定されることがあり,それはストリームのはるか未来にまで及ぶ.

例えば,人間は健康状態を改善したり,言語を習得したり,科学的なブレークスルーを達成したりといった長期的な目標を達成するために行動を選択するかもしれない.

強力なエージェントは,人間のように長い時間スケールで進歩する経験の流れを持つべきである.

これにより,エージェントは将来の目標を達成するために行動を起こし,新しい行動パターンに時間をかけて継続的に適応することができる.

例えば,ユーザのウェアラブルに接続されたヘルス&ウェルネス・エージェントは,睡眠パターン,活動レベル,食習慣を何カ月にもわたってモニターすることができる.

そして,長期的な傾向とユーザの特定の健康目標に基づいて,パーソナライズされた推奨や励ましを提供し,指導を調整することができる.

同様に,パーソナライズされた教育エージェントは,ユーザの新しい言語学習の進捗状況を追跡し,知識のギャップを特定し,学習スタイルに適応させ,数ヶ月から数年にわたり教授方法を調整することができる.

さらに,科学エージェントは,新素材の発見や二酸化炭素の削減といった野心的な目標を追求することができる.

そのようなエージェントは,長期間にわたって実世界の観察を分析し,シミュレーションを開発・実行し,実世界での実験や介入を提案することができる.

それぞれの場合において,エージェントは,指定されたゴールに関して長期的な成功を最大化するように,一連のステップを踏む.

個々のステップは,すぐに利益をもたらさないかもしれないし,短期的には有害であるかもしれないが,それでも長期的な成功に総合的に貢献するかもしれない.

これは,現在のAIシステムが,その行動が環境に及ぼす将来の結果を測定したり最適化したりする能力を持たずに,要求に対して即座に応答を提供することと強く対照的である.

2.2節:Actions and Observations(行動と観察)

経験の時代のエージェントは,実世界で自律的に行動する.

人間データの時代のLLMは,主に人間に特権的な行動と観察に焦点を当て,ユーザにテキストを出力し,ユーザからエージェントにテキストを入力する.

これは,動物が運動制御やセンサーを通して環境と相互作用する自然知能とは著しく異なる.

動物,特に人間は,他の動物とコミュニケーションをとることがあるが,これは特権的なチャンネルではなく,他のセンサー運動制御と同じインターフェイスを通じて行われる.

LLMが,例えばAPIを呼び出すことによって,デジタル世界でのアクションを呼び出すことができることは,長い間認識されてきた(例えば,[43]を参照).

当初,このような能力は,エージェントの経験ではなく,人間がツールを使用した例から得たものが主であった.

しかしながら,コーディングとツールの使用能力は,エージェントが実際にコードを実行し,何が起こるかを観察する実行フィードバック[17, 7, 12]にますます依存している.

最近,プロトタイプエージェントの新しい波が,人間がコンピュータを操作するのと同じインターフェイスを使用することで,より一般的な方法でコンピュータと対話し始めた[3, 15, 24].

これらの変化は,人間優位のコミュニケーションから,エージェントが世界で自立的に行動できる,より自律的な相互作用への移行を予告している.

そのようなエージェントは,能動的に世界を探索し,変化する環境に適応し,人間には決して思いつかないような戦略を発見することができるだろう.

これらのリッチなインタラクションは,デジタル世界を自律的に理解しコントロールする手段を提供する.

エージェントは,ユーザとのコミュニケーションやコラボレーションを自然に促進するユーザインターフェースのような「人間に優しい」アクションや観察を使用することができる.

エージェントはまた,コードを実行したりAPIを呼び出したりする「機械に優しい」アクションを取ることもでき,エージェントはその目標のために自律的に行動することができる.

経験の時代には,エージェントはデジタルインターフェースを介して現実世界とも相互作用するようになる.

例えば,科学エージェントは,環境センサーを監視したり,望遠鏡を遠隔操作したり,実験室でロボットアームを制御して自律的に実験を行ったりすることができる.

2.3節:Rewards(報酬)

体験型エージェントが,人間の嗜好だけでなく,外部の出来事やシグナルから学ぶことができるとしたらどうだろうか?

人間中心のLLMは通常,人間の先入観に基づいて報酬を最適化する.

専門家はエージェントの行動を観察し,それが良い行動かどうかを判断したり,複数の選択肢の中から最適なエージェントの行動を選んだりする.

例えば,専門家は健康エージェントのアドバイス,教育アシスタントの指導,科学者エージェントの提案する実験などを判断する.

これらの報酬や選好が,それらの行動が環境に与える影響を測定するのではなく,その結果がない状態で人間によって決定されるという事実は,それらが世界の現実に直接根ざしていないことを意味する.

このように人間の先入観に頼ることは,通常,エージェントの性能に不可解な天井をもたらす.

エージェントは,人間の評価者によって過小評価されているより良い戦略を発見することができない.

既存の人間の知識を遥かに超える新しいアイデアを発見するためには,その代わりに,環境そのものから発生するシグナルである,根拠のある報酬を使用する必要がある.

例えば,健康アシスタントは,安静時の心拍数,睡眠時間,活動レベルなどのシグナルの組み合わせに基づく報酬に,ユーザの健康目標を根拠づけることができる.

一方,教育アシスタントは,言語学習の根拠となる報酬を提供するために,試験結果を使用することができる.

同様に,地球温暖化を減らすという目標を持つ科学エージェントは,二酸化炭素レベルの経験的観測に基づく報酬を使うかもしれない.

一方,より強い材料を発見するという目標は,引張強度やヤング率など,材料シミュレータからの測定値の組み合わせに基づくかもしれない.

根拠となる報酬は,エージェントの環境の一部である人間から得られるかもしれない.

※経験と人間のデータは正反対ではない.例えば,犬はすべて経験から学ぶが,人間との交流も経験の一部である.

例えば,人間のユーザは,ケーキが美味しいかどうか,運動後の疲労度,頭痛の痛みの程度などを報告することができ,アシスタントエージェントがより良いレシピを提供したり,フィットネスの提案を改良したり,推奨される薬を改善したりすることができる.

このような報酬は,彼らの環境内でのエージェントの行動の結果を測定し,最終的には,提案されたケーキのレシピ,運動プログラム,または治療プログラムを先入観で判断する人間の専門家よりも優れた支援につながるはずである.

人間のデータからでなければ,報酬はどこから来るのだろうか?

エージェントがリッチな行動・観察スペース(上記参照)を通じて世界とつながるようになれば,報酬の根拠となるシグナルには事欠かなくなるだろう.

実際,世界には,コスト,エラー率,飢餓,生産性,健康指標,気候指標,利益,売上,試験結果,成功,訪問,収穫,株式,「いいね!」,収入,喜び/痛み,経済指標,正確さ,パワー,距離,スピード,効率,エネルギー消費などの量があふれている.

さらに,特定のイベントの発生や,生の観察や行動のシーケンスから得られる特徴から生じる無数の追加シグナルがある.

原理的には,様々なエージェントを作成することができ,各エージェントは報酬として1つのシグナルを最適化する.

そのような報酬シグナルが1つでも,非常に効果的に最適化されていれば,広く有能な知性を誘導するのに十分かもしれないという議論がある[34].

※「報酬は十分である」という仮説は,知能とそれに関連する能力は,報酬の最大化から自然に生まれる可能性があることを示唆している.これには,人間との相互作用を含む環境や,人間からのフィードバックに基づく報酬が含まれるかもしれない.

なぜなら,複雑な環境で単純な目標を達成するためには,多くの場合,習得すべき多種多様なスキルが必要になるからである.

しかしながら,単一の報酬シグナルの追求は,表面的には,ユーザが望む任意の行動に向けて確実に操縦できる汎用AIの要件を満たしていないように見える.

したがって,根拠のある,人間以外の報酬シグナルを自律的に最適化することは,現代のAIシステムの要件に反するのだろうか?

我々は,このような要望を満たす可能性のあるアプローチを1つ紹介することで,必ずしもそうではないことを主張する.

他のアプローチも可能かもしれない.

このアイデアは,ユーザに導かれた方法で,根拠のあるシグナルに基づいて,報酬を柔軟に適応させることである.

例えば,報酬関数は,ユーザと環境の両方とのエージェントの相互作用を入力とし,スカラー報酬を出力するニューラルネットワークによって定義することができる.

これにより,報酬は,ユーザの目標に応じた方法で,環境からのシグナルを選択したり,組み合わせたりすることができる.

例えば,ユーザは「フィットネスを向上させる」といった大まかな目標を指定し,報酬関数はユーザの心拍数,睡眠時間,歩数の関数を返すかもしれない.

あるいは,ユーザは「スペイン語の勉強を手伝う」という目標を指定し,報酬関数はユーザのスペイン語試験の結果を返すかもしれない.

さらに,ユーザは学習プロセス中に満足度などのフィードバックを提供することができ,報酬関数を微調整するために使用することができる.

報酬関数は,時間の経過とともに適応し,シグナルの選択方法や組み合わせ方法を改善し,ずれを特定して修正することができる.

これは,ユーザのフィードバックをトップレベルの目標として最適化し,環境からのシグナルを低レベルで最適化する,2レベルの最適化プロセスとして理解することもできる.

※この場合,根拠ある人間のフィードバックは,エージェントの全体的な目的を形成する特異な報酬関数であり,豊富で根拠あるフィードバックに基づく内在的報酬関数[8]を構築し最適化することによって最大化されると考えることもできる.

このようにして,少量の人間のデータが大量の自律学習を促進する可能性がある.

2.4節:Planning and Reasoning(計画と推論)

経験の時代は,エージェントが計画を立て,推論する方法を変えるのだろうか?

最近,言語を使って推論,つまり「考える」ことができるLLM[23, 14, 10]を使って,応答を出力する前に思考の連鎖をたどることで,大きな進歩があった[16].

概念的には,LLMはユニバーサルコンピュータ[30]として動作することができる.

LLMは自身のコンテキストにトークンを追加することができ,最終結果を出力する前に任意のアルゴリズムを実行することができる.

人間データの時代において,これらの推論手法は人間の思考プロセスを模倣するように明確に設計されてきた.

例えば,LLMは人間のような思考の連鎖[16]を発したり,人間の思考の追跡[42]を模倣したり,人間の例と一致する思考のステップを強化するようにプロンプトされてきた[18].

推論プロセスはさらに微調整され,人間の専門家によって決定された正解に一致する思考の痕跡を生成することができる[44].

しかしながら,人間の言語が万能コンピュータの最適なインスタンスを提供するとはとても思えない.

例えば,記号計算,分散計算,連続計算,微分可能計算を利用するような,人間以外の言語を使った,より効率的な思考メカニズムが確実に存在する.

自己学習型システムは,経験から思考方法を学習することで,原理的にはそのようなアプローチを発見したり改善したりすることができる.

例えば,AlphaProofは人間の数学者とは全く異なる方法で複雑な定理を正式に証明することを学んだ[20].

さらに,ユニバーサルコンピュータの原理は,エージェントの内部計算にしか対応していない.

外界の現実と結びつけるものではない.

人間の思考を模倣するように,あるいは人間の専門家の回答と一致するように訓練されたエージェントは,欠陥のある仮定や固有のバイアスなど,そのデータに深く埋め込まれた誤った思考方法を受け継ぐ可能性がある.

例えば,あるエージェントが5,000年前の人間の思考や専門家の回答を使って推論するように訓練されていた場合,物理的な問題をアニミズムの観点から推論したかもしれない.

1,000年前なら,神道的な言葉で推論したかもしれない.

300年前はニュートン力学の観点から推論したかもしれない.

そして50年前は量子力学の観点から推論したかもしれない.

それぞれの思考法を超えて進歩するには,現実世界との相互作用が必要だった.

仮説を立て,実験を行い,結果を観察し,それに基づいて原理を更新する.

同様に,誤った思考法を覆すためには,エージェントは現実世界のデータに基づかなければならない.

このグラウンディングはフィードバックループを提供し,エージェントが受け継いだ仮定を現実と照らし合わせてテストし,現在の支配的な人間の思考様式に制限されない新しい原理を発見することを可能にする.

この根拠がなければ,エージェントはどんなに洗練されていても,既存の人間の知識の反響室になってしまう.

これを超えるためには,エージェントは積極的に世界と関わり,観察データを収集し,そのデータを使って繰り返し理解を深めていかなければならない.

これは,人類の科学的進歩の原動力となったプロセスを多くの点で反映している.

外界に直接思考を根付かせる1つの可能な方法は,報酬の予測を含む,エージェントの行動が世界に及ぼす結果を予測する世界モデル[37]を構築することである.

例えば,健康アシスタントは,地元のジムや健康ポッドキャストを推薦することを考えるかもしれない.

エージェントの世界モデルは,ユーザの心拍数や睡眠パターンがこの行動の後にどのように変化するかを予測するかもしれないし,ユーザとの将来の対話を予測するかもしれない.

これによってエージェントは,自身の行動とそれが世界に及ぼす因果的な影響について直接的に計画[36, 29]することができる.

エージェントが経験の流れを通して世界と相互作用し続けるとき,そのダイナミクスモデルは,予測におけるエラーを修正するために継続的に更新される.

世界モデルを与えられたエージェントは,エージェントの予測性能を向上させるスケーラブルな計画手法を適用することができる.

プランニングと推論方法は互いに排他的なものではない.

エージェントは,計画中に各アクションを選択するために内部LLM計算を適用することもできるし,それらのアクションの結果をシミュレートして評価することもできる.

3章:Why Now?(なぜ今なのか?)

経験からの学習は新しいものではない.

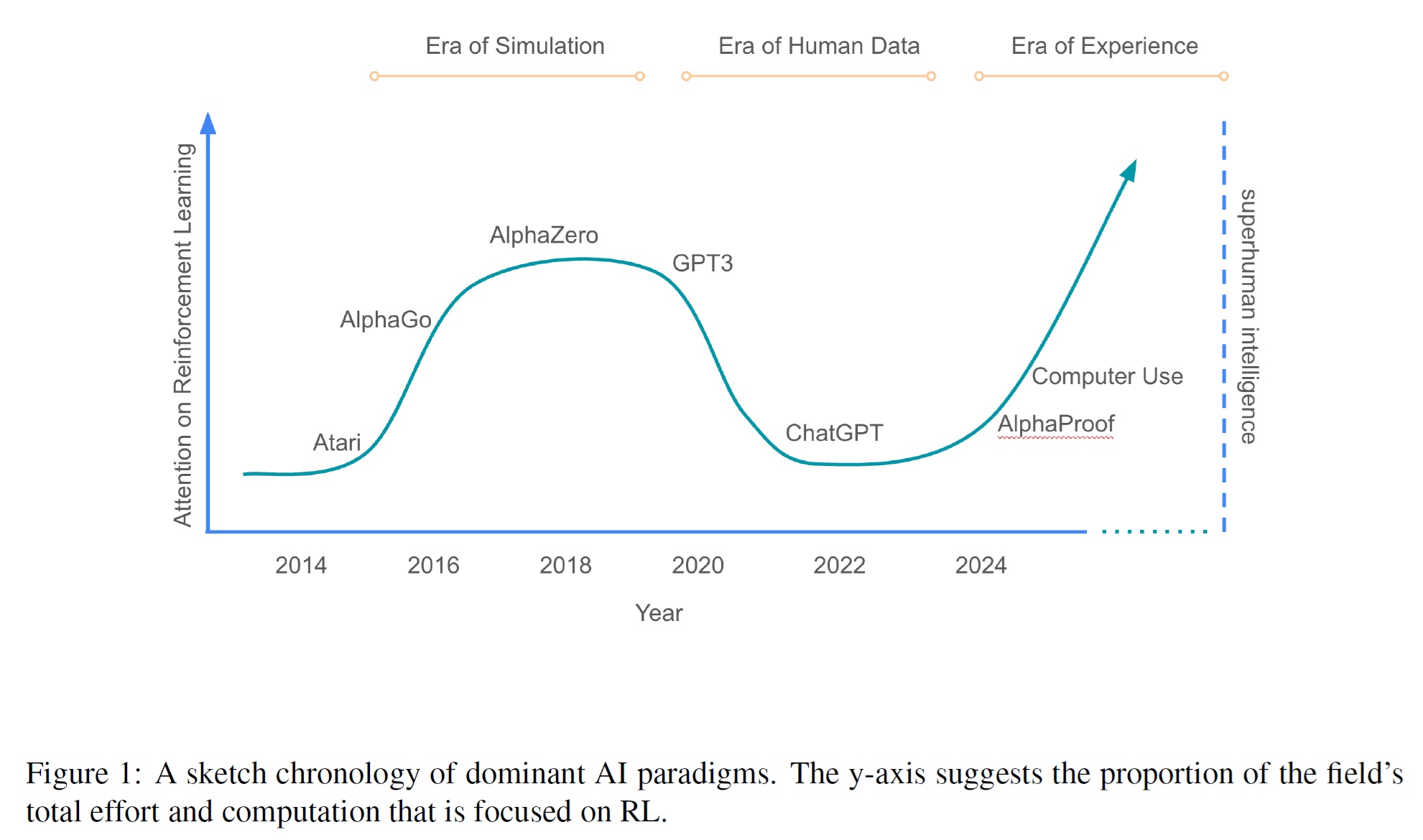

以前,強化学習システムは,明確な報酬シグナルのあるシミュレータで表現される複雑なタスクを数多くマスターしてきた(図1の「シミュレーションの時代」を参照).

例えば,バックギャモン[39],囲碁[31],チェス[32],ポーカー[22, 6],ストラテゴ[26]などのボードゲーム,アタリ[21],スタークラフトII[40],ドータ2[4],グランツーリスモ[41]などのビデオゲーム,ルービックキューブ[1]などの手先の器用な操作タスク,データセンターの冷却[13]などのリソース管理タスクなどにおいて,RL手法は人間の性能と同等か,それを上回る自己プレイを実現した.

さらに,AlphaZero [33]のような強力なRLエージェントは,ニューラルネットワークのサイズ,対話経験の量,思考時間の長さによって,印象的で無限のスケーラビリティを示す可能性がある.

しかしながら,このパラダイムに基づくエージェントは,シミュレーション(単数で正確に定義された報酬を伴うクローズドな問題)と現実(複数の非定義に見える報酬を伴うオープンエンドな問題)とのギャップを飛躍させることはできなかった.

人間データの時代は,魅力的な解決策を提供した.

膨大な人間データのコーパスには,多種多様なタスクに関する自然言語の例が含まれている.

このデータに基づいて訓練されたエージェントは,シミュレーション時代の狭い成功例と比較して,幅広い能力を達成した.

その結果,経験型RLの方法論は,より汎用的なエージェントに取って代わられ,人間中心のAIへの移行が広まった.

しかしながら,この移行で失われたもの,それはエージェントが自らの知識を自己発見する能力である.

例えば,AlphaZeroはチェスや囲碁の根本的に新しい戦略を発見し,人間がこれらのゲームをプレイする方法を変えた[28, 45].

経験の時代は,この能力と,人間のデータの時代に達成されたタスクジェネラリティのレベルを調和させるだろう.

これは,上述のように,エージェントが実世界の経験の流れの中で自律的に行動し,観察することができるようになり[11],その報酬が根拠のある実世界の豊富なシグナルのいずれかに柔軟に接続されるようになったときに可能になる.

複雑な実世界の行動空間[3, 15, 24]と相互作用する自律エージェントの出現は,豊かな推論空間[20, 10]でオープンエンドな問題を解決できる強力なRL手法と並んで,経験の時代への移行が差し迫っていることを示唆している.

4章:Reinforcement Learning Methods(強化学習法)

強化学習(RL:Reinforcement Learning)には,エージェントが環境との直接的な相互作用を通じて自ら学習する自律学習に深く根ざした豊かな歴史がある.

初期のRL研究は,一連の強力な概念とアルゴリズムを生み出した.

例えば,時間差学習[35]は,エージェントが将来の報酬を推定することを可能にし,バックギャモン[39]における超人的な性能のようなブレークスルーをもたらした.

楽観主義や好奇心を原動力とする探索技術は,エージェントが創造的な新しい行動を発見し,最適でないルーチンにはまり込まないようにするために開発された[2].

Dynaアルゴリズムのような手法は,エージェントが自分たちの世界のモデルを構築し,そこから学習することを可能にし,将来の行動について計画し,推論することを可能にした[36, 29].

オプションやオプション間/オプション内学習のような概念は,時間的抽象化を促進し,エージェントがより長い時間スケールで推論し,複雑なタスクを管理可能なサブゴールに分解することを可能にした[38].

しかしながら,人間中心のLLMの台頭により,焦点は自律学習から人間の知識を活用する方向にシフトした.

RLHF(Reinforcement Learning from Human Feedback)[9, 25]や,言語モデルを人間の推論と整合させる手法[44]のような技術は,非常に効果的であることが証明され,AI能力の急速な進歩を促した.

これらのアプローチは強力ではあるが,しばしばRLの中核概念を回避していた.

RLHFは,機械が推定した値の代わりに人間の専門家を呼び出すことで,値関数の必要性を回避し,人間のデータから得られる強力な事前分布を利用することで,探索への依存を減らし,人間中心の用語で推論することで,世界モデルや時間的抽象化の必要性を減らした.

しかしながら,パラダイムの転換は,赤子の手をひねるようなものだとも言える.

人間中心のRLは,前例のない幅広い行動を可能にした一方で,エージェントの性能に新たな上限を課した.

エージェントは既存の人間の知識を超えることはできないのだ.

さらに,人間データの時代は,根拠のない人間とのインタラクションの短いエピソードのために設計されたRL手法に主に焦点を当てており,根拠のある自律的なインタラクションの長いストリームには適していない.

経験の時代は,古典的なRLの概念を見直し,改善する機会を提供する.

この時代は,観察データに柔軟に基づいた報酬関数について考える新しい方法をもたらすだろう.

価値関数と,まだ不完全なシーケンスの長いストリームからそれを推定する方法が見直されるだろう.

人間の事前知識(human priors)とは根本的に異なる新しい行動を発見する,実世界探索のための原理的かつ実用的な方法がもたらされる.

根拠のある相互作用の複雑さを捉える世界モデルへの新しいアプローチが開発される.

時間的抽象化のための新しい手法により,エージェントは経験という観点から,これまで以上に長い時間軸にわたって推論することができるようになる.

RLの基礎を構築し,その基本原理をこの新しい時代の課題に適応させることで,自律学習の可能性を最大限に引き出し,真に超人的な知性への道を開くことができる.

5章:Consequences(結果)

AIエージェントが世界との相互作用から学習する「経験の時代」の到来は,これまでとは大きく異なる未来を約束する.

この新しいパラダイムは,計り知れない可能性を提供する一方で,以下の点を含むがこれに限定されない,慎重な検討を要する重要なリスクと課題も提示している.

ポジティブな面では,経験学習が前例のない能力を解き放つだろう.

日常生活では,パーソナライズされたアシスタントが,継続的な経験の流れを活用して,個人の健康,教育,職業上のニーズに適応し,数カ月から数年にわたる長期的な目標に向かうだろう.

おそらく最も大きな変革は,科学的発見の加速だろう.

AIエージェントは,材料科学,医学,ハードウェア設計などの分野で自律的に実験を設計し,実施するようになるだろう.

自らの実験結果から継続的に学習することで,これらのエージェントは知識の新たなフロンティアを迅速に探求し,これまでにないペースで新素材,新薬,新技術の開発につながる可能性がある.

しかしながら,この新時代は重大かつ斬新な課題も提示している.

人間の能力を自動化することで生産性の向上が約束される一方で,こうした向上は雇用の奪い合いにつながる可能性もある.

エージェントは,長期的な問題解決やイノベーション,現実世界の結果に対する深い理解など,これまでは人間のみの領域と考えられていた能力を発揮できるようになるかもしれない.

さらに,どのようなAIであっても悪用される可能性があるという一般的な懸念が存在する一方で,長期的な目標を達成するために長期間にわたって自律的に世界と相互作用できるエージェントには,より高いリスクが生じる可能性がある.

デフォルトでは,人間がエージェントの行動に介入したり仲介したりする機会が少なくなるため,高い信頼と責任が要求される.

人間のデータや人間の思考様式から離れることは,将来のAIシステムの解釈を難しくするかもしれない.

しかしながら,経験学習が安全上のリスクを増大させ,経験の時代への安全な移行を確実にするためにさらなる研究が必要であることを認める一方で,経験学習が安全上重要な利益をもたらす可能性があることも認識すべきである.

第一に,経験型エージェントは,自分が置かれている環境を認識しており,その行動は環境の変化に対して時間とともに適応することができる.

固定されたAIシステムを含め,あらかじめプログラムされたシステムは,その環境コンテキストに気づかず,デプロイされた世界の変化に不適応になる可能性がある.

例えば,重要なハードウェアが故障したり,パンデミックによって社会が急速に変化したり,新しい科学的発見によって急速な技術開発のカスケードが引き起こされたりする.

これとは対照的に,経験型エージェントは,故障したハードウェアを回避したり,急速な社会変化に適応したり,新しい科学技術を受け入れ,それを基に構築したりすることを観察し,学習することができる.

おそらくさらに重要なことは,エージェントは,その行動が人間の懸念,不満,苦痛を引き起こしていることを認識し,これらの否定的な結果を避けるために適応的にその行動を修正することができることである.

第二に,エージェントの報酬関数は,経験を通じて適応される可能性がある.

例えば,前述したバイレベル最適化(2.3節の「報酬」を参照)を使用する.

重要なことは,このことは、試行錯誤によって,ずれた報酬関数を徐々に修正することができることを意味する.

例えば,ペーパークリップの最大化[5]のようなシグナルをやみくもに最適化するのではなく,ペーパークリップの生産が地球の資源をすべて消費してしまう前に,人間の関心の指標に基づいて報酬関数を修正することができる.

これは,人間がお互いに目標を設定し,人々がシステムを悪用したり,長期的な幸福をないがしろにしたり,望ましくない否定的な結果を引き起こしたりするのを観察したら,その目標を修正する方法に似ている.

とはいえ,人間の目標設定と同じように,完璧に一致するという保証はない.

最後に,身体的経験に依存する進歩は,現実世界で行動を実行し,その結果を観察するのに要する時間によって本質的に制約を受ける.

例えば,新薬の開発には、たとえAIが支援する設計であっても,一朝一夕には完了しない実世界での試験が必要である.

これは,潜在的なAIの自己改善のペースに自然なブレーキをかけることになるかもしれない.

6章:Conclusion(結論)

経験の時代は,AIの進化における極めて重要な瞬間である.

今日の強固な基盤の上に,人間由来のデータの限界を超え,エージェントはますます世界との相互作用から学習するようになる.

エージェントは豊富な観察と行動を通じて,自律的に環境と相互作用するようになる.

エージェントは生涯にわたる経験の流れの中で適応し続ける.

エージェントの目標は,根拠となるシグナルのあらゆる組み合わせに向けられるようになることである.

さらに,エージェントは強力な非人間的推論を利用し,エージェントの行動が環境に及ぼす結果に基づいた計画を構築する.

最終的には,経験データは人間が生成したデータの規模と質を凌駕することになるだろう.

このパラダイムシフトは,RLにおけるアルゴリズムの進歩とともに,多くのドメインにおいて,人間の持つ能力を凌駕する新たな能力を解き放つだろう.

References(参考文献)

- I. Akkaya, M. Andrychowicz, M. Chociej, M. Litwin, B. McGrew, A. Petron, A. Paino, M. Plappert, G. Powell, R. Ribas, J. Schneider, N. Tezak, J. Tworek, P. Welinder, L. Weng, Q. Yuan, W. Zaremba, and L. Zhang. Solving Rubik’s cube with a robot hand, 2019.

- S. Amin, M. Gomrokchi, H. Satija, H. van Hoof, and D. Precup. A survey of exploration methods in reinforcement learning, 2021.

- Anthropic. Introducing computer use, a new Claude 3.5 Sonnet, and Claude 3.5 Haiku. https://www.anthropic.com/news/3-5-models-and-computer-use, 2024.

- C. Berner, G. Brockman, B. Chan, V. Cheung, P. Debiak, C. Dennison, D. Farhi, Q. Fischer, S. Hashme, C. Hesse, R. J´ozefowicz, S. Gray, C. Olsson, J. Pachocki, M. Petrov, H. P. d. O. Pinto, J. Raiman, T. Salimans, J. Schlatter, J. Schneider, S. Sidor, I. Sutskever, J. Tang, F. Wolski, and S. Zhang. Dota 2 with large scale deep reinforcement learning, 2019.

- N. Bostrom. Ethical issues in advanced artificial intelligence. https://nickbostrom.com/ethics/ai, 2003.

- N. Brown and T. Sandholm. Superhuman AI for heads-up no-limit poker: Libratus beats top professionals. Science, 359(6374):418–424, 2018.

- X. Chen, M. Lin, N. Sch¨arli, and D. Zhou. Teaching large language models to self-debug, 2023.

- N. Chentanez, A. Barto, and S. Singh. Intrinsically motivated reinforcement learning. In L. Saul, Y. Weiss, and L. Bottou, editors, Advances in Neural Information Processing Systems, volume 17. MIT Press, 2004.

- P. F. Christiano, J. Leike, T. Brown, M. Martic, S. Legg, and D. Amodei. Deep reinforcement learning from human preferences. In I. Guyon, U. V. Luxburg, S. Bengio, H. Wallach, R. Fergus, S. Vishwanathan, and R. Garnett, editors, Advances in Neural Information Processing Systems, volume 30. Curran Associates, Inc., 2017.

- DeepSeek AI. DeepSeek-R1: Incentivizing reasoning capability in LLMs via reinforcement learning. arXiv preprint arXiv:2501.12948, 2025.

- M. Elsayed, G. Vasan, and A. R. Mahmood. Streaming deep reinforcement learning finally works, 2024.

- J. Gehring, K. Zheng, J. Copet, V. Mella, Q. Carbonneaux, T. Cohen, and G. Synnaeve. Rlef: Grounding code llms in execution feedback with reinforcement learning, 2025.

- Google DeepMind. Deepmind AI reduces google data centre cooling bill by 40%. https://deepmind.google/discover/blog/deepmind-ai-reduces-google-data-centre-cooling-bill-by-40/, 2016.

- Google DeepMind. Gemini: Flash thinking. ttps://deepmind.google/technologies/gemini/flash-thinking/, 2024.

- Google DeepMind. Project Mariner. https://deepmind.google/technologies/project-mariner, 2024.

- T. Kojima, S. S. Gu, M. Reid, Y. Matsuo, and Y. Iwasawa. Large language models are zero-shot reasoners. In S. Koyejo, S. Mohamed, A. Agarwal, D. Belgrave, K. Cho, and A. Oh, editors, Advances in Neural Information Processing Systems, volume 35, pages 22199–22213. Curran Associates, Inc., 2022.

- H. Le, Y. Wang, A. D. Gotmare, S. Savarese, and S. C. H. Hoi. CodeRL: Mastering code generation through pretrained models and deep reinforcement learning, 2022.

- H. Lightman, V. Kosaraju, Y. Burda, H. Edwards, B. Baker, T. Lee, J. Leike, J. Schulman, I. Sutskever, and K. Cobbe. Let’s verify step by step, 2023.

- H. Mahdavi, A. Hashemi, M. Daliri, P. Mohammadipour, A. Farhadi, S. Malek, Y. Yazdanifard, A. Khasahmadi, and V. Honavar. Brains vs. bytes: Evaluating llm proficiency in olympiad mathematics, 2025.

- H. Masoom, A. Huang, M. Z. Horv´ath, T. Zahavy, V. Veeriah, E. Wieser, J. Yung, L. Yu, Y. Schroecker, J. Schrittwieser, O. Bertolli, B. Ibarz, E. Lockhart, E. Hughes, M. Rowland, G. Margand, A. Davies, D. Zheng, I. Beloshapka, I. von Glehn, Y. Li, F. Pedregosa, A. Velingker, G. ˇ Zuˇzi´c, O. Nash, B. Mehta, P. Lezeau, S. Mercuri, L. Wu, C. Soenne, T. Murrills, L. Massacci, A. Yang, A. Mandhane, T. Eccles, E. Ayg¨un, Z. Gong, R. Evans, S. Mokr´a, A. Barekatain, W. Shang, H. Openshaw, F. Gimeno, D. Silver, and P. Kohli. AI achieves silver-medal standard solving International Mathematical Olympiad problems. https://deepmind.google/discover/blog/ai-solves-imo-problems-at-silver-medal-level/, 2024.

- V. Mnih, K. Kavukcuoglu, D. Silver, A. A. Rusu, J. Veness, M. G. Bellemare, A. Graves, M. Riedmiller, A. K. Fidjeland, G. Ostrovski, S. Petersen, C. Beattie, A. Sadik, I. Antonoglou, H. King, D. Kumaran, D. Wierstra, S. Legg, and D. Hassabis. Human-level control through deep reinforcement learning. Nature, 518(7540):529–533, 2015.

- M. Moravˇc´ık, M. Schmid, N. Burch, V. Lis`y, D. Morrill, N. Bard, T. Davis, K. Waugh, M. Johanson, and M. Bowling. Deepstack: Expert-level artificial intelligence in heads-up no-limit poker. Science, 356(6337):508–513, 2017.

- OpenAI. Openai o1 mini: Advancing cost-efficient reasoning. https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/, 2024.

- OpenAI. Introducing Operator. https://openai.com/index/introducing-operator, 2025.

- L. Ouyang, J. Wu, X. Jiang, D. Almeida, C. L. Wainwright, P. Mishkin, C. Zhang, S. Agarwal, K. Slama, A. Ray, J. Schulman, J. Hilton, F. Kelton, L. Miller, M. Simens, A. Askell, P.Welinder, P. Christiano, J. Leike, and R. Lowe. Training language models to follow instructions with human feedback, 2022.

- J. Perolat, B. D. Vylder, D. Hennes, E. Tarassov, F. Strub, V. de Boer, P. Muller, J. T. Connor, N. Burch, T. Anthony, S. McAleer, R. Elie, S. H. Cen, Z. Wang, A. Gruslys, A. Malysheva, M. Khan, S. Ozair, F. Timbers, T. Pohlen, T. Eccles, M. Rowland, M. Lanctot, J.-B. Lespiau, B. Piot, S. Omidshafiei, E. Lockhart, L. Sifre, N. Beauguerlange, R. Munos, D. Silver, S. Singh, D. Hassabis, and K. Tuyls. Mastering the game of Stratego with model-free multiagent reinforcement learning. Science, 378(6623):990–996, 2022.

- I. Petrov, J. Dekoninck, L. Baltadzhiev, M. Drencheva, K. Minchev, M. Balunovi´c, N. Jovanovi´c, and M. Vechev. Proof or bluff? evaluating llms on 2025 usa math olympiad, 2025.

- M. Sadler and N. Regan. Game Changer. New in Chess, 2019.

- J. Schrittwieser, I. Antonoglou, T. Hubert, K. Simonyan, L. Sifre, S. Schmitt, A. Guez, E. Lockhart, D. Hassabis, T. Graepel, T. P. Lillicrap, and D. Silver. Mastering Atari, Go, chess and shogi by planning with a learned model. Nature, 588:604 – 609, 2019.

- D. Schurmanns. Memory augmented large language models are computationally universal. arXiv preprint arXiv:2501.12948, 2023.

- D. Silver, A. Huang, C. J. Maddison, A. Guez, L. Sifre, G. Van Den Driessche, J. Schrittwieser, I. Antonoglou, V. Panneershelvam, M. Lanctot, S. Dieleman, D. Grewe, J. Nham, N. Kalchbrenner, I. Sutskever, T. Lillicrap, M. Leach, K. Kavukcuoglu, T. Graepel, and D. Hassabis. Mastering the game of Go with deep neural networks and tree search. Nature, 529(7587):484–489, 2016.

- D. Silver, T. Hubert, J. Schrittwieser, I. Antonoglou, M. Lai, A. Guez, M. Lanctot, L. Sifre, D. Kumaran, T. Graepel, T. Lillicrap, K. Simonyan, and D. Hassabis. A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play. Science, 362(6419):1140–1144, 2018.

- D. Silver, J. Schrittwieser, K. Simonyan, I. Antonoglou, A. Huang, A. Guez, T. Hubert, L. Baker, M. Lai, A. Bolton, Y. Chen, T. Lillicrap, F. Hui, L. Sifre, G. van den Driessche, T. Grapel, and D. Hassabis. Mastering the game of go without human knowledge. Nature, 550(7676):354–359, 2017.

- D. Silver, S. Singh, D. Precup, and R. S. Sutton. Reward is enough. Artificial Intelligence, 299:103535, 2021.

- R. S. Sutton. Learning to predict by the methods of temporal differences. Machine Learning, 3:9–44, 1988.

- R. S. Sutton. Integrated architectures for learning, planning, and reacting based on approximating dynamic programming. In Proceedings of the Seventh International Conference on Machine Learning, pages 216–224. Morgan Kaufmann, 1990.

- R. S. Sutton and A. G. Barto. Reinforcement Learning: An Introduction. The MIT Press, second edition, 2018.

- R. S. Sutton, D. Precup, and S. Singh. Between mdps and semi-mdps: A framework for temporal abstraction in reinforcement learning. Artificial Intelligence, 112(1-2):181–211, 1999.

- G. Tesauro. TD-Gammon, a self-teaching backgammon program, achieves master-level play. Neural Computation, 6(2):215–219, 1994.

- O. Vinyals, I. Babuschkin, W. M. Czarnecki, M. Mathieu, A. Dudzik, J. Chung, D. Choi, R. Powell, T. Ewalds, P. Georgiev, J. Oh, D. Horgan, M. Kroiss, I. Danihelka, A. Huang, L. Sifre, T. Cai, J. P. Agapiou, M. Jaderberg, A. S. Vezhnevets, R. Leblond, T. Pohlen, V. Dalibard, D. Budden, Y. Sulsky, J. Molloy, T. L. Paine, C. Gulcehre, Z. Wang, T. Pfaff, Y. Wu, R. Ring, D. Yogatama, D. W¨unsch, K. McKinney, O. Smith, T. Schaul, T. P. Lillicrap, K. Kavukcuoglu, D. Hassabis, C. Apps, and D. Silver. Grandmaster level in StarCraft II using multi-agent reinforcement learning. Nature, 575:350 – 354, 2019.

- P. R. Wurman, S. Barrett, K. Kawamoto, J. MacGlashan, K. Subramanian, T. J. Walsh, R. Capobianco, A. Devlic, F. Eckert, F. Fuchs, L. Gilpin, P. Khandelwal, V. Kompella, H. Lin, P. MacAlpine, D. Oller, T. Seno, C. Sherstan, M. D. Thomure, H. Aghabozorgi, L. Barrett, R. Douglas, D. Whitehead, P. D¨urr, P. Stone, M. Spranger, and H. Kitano. Outracing champion Gran Turismo drivers with deep reinforcement learning. Nature, 602(7896):223–228, 2022.

- M. S. Yang, D. Schuurmans, P. Abbeel, and O. Nachum. Chain of thought imitation with procedure cloning. In S. Koyejo, S. Mohamed, A. Agarwal, D. Belgrave, K. Cho, and A. Oh, editors, Advances in Neural Information Processing Systems, volume 35, pages 36366–36381. Curran Associates, Inc., 2022.

- S. Yao, J. Zhao, D. Yu, N. Du, I. Shafran, K. Narasimhan, and Y. Cao. React: Synergizing reasoning and acting in large language models. In 11th International Conference on Learning Representations, 2023.

- E. Zelikman, J. M. Mu, N. D. Goodman, and G. Poesia. Star: Bootstrapping reasoning with reasoning. Advances in Neural Information Processing Systems, 35:24170–24184, 2022.

- Y. Zhou. Rethinking Opening Strategy: AlphaGo’s Impact on Pro Play. CreateSpace Independent, 2018.

まとめ

Welcome to the Era of Experienceの日本語訳を紹介しました.

グーグルが主張する「経験の時代へようこそ」の意味がわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.