Sora 2 System Cardの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Sora 2 System Cardの日本語訳を紹介します.

OpenAIの動画生成AI「Sora 2」がわかります.

※図表を含む論文の著作権はSora 2 System Cardの著者に帰属します.

Sora 2 System Cardの目次は以下になります.

- Abstract

- 1章:Overview of Sora 2

- 2章:Model Data & Data Filtering

- 3章:Safety: Safety Stack, Evaluations and Mitigations for Sora 2

- 4章:Red Teaming

- 5章:Safety Evaluations

- 6章:Continued work on safety, policy, & iterative deployment

- 7章:Acknowledgements

Sora 2 System Cardを解説しつつ,私の考えも語ります.

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Acknowledgements」(謝辞)は省略していること

それでは,Sora 2 System Cardの本文を読みすすめましょう!

目次

1章:Introduction(はじめに)

Sora 2は,我々が開発した最先端の動画・音声生成モデルである.

従来のSoraモデルを基盤としつつ,これまで他の動画生成モデルでは実現が困難だった高度な機能を実現している.

具体的には,より正確な物理演算,より高いリアリティ,音声と映像の完全な同期,より高度な操作可能性,そして表現スタイルの拡張範囲の拡大などが挙げられる.

このモデルはユーザの指示を高い精度で解釈し,想像力に富んだ内容でありながら現実世界の物理法則に忠実な動画の生成を可能にする.

Sora 2はストーリーテリングやクリエイティブ表現の可能性を広げるだけでなく,物理的世界の複雑性をより正確にシミュレートできるモデルへの重要な一歩でもある.

Sora 2はsora.com経由で利用可能となるほか,新たにリリースされるスタンドアロンのiOS版Soraアプリでも利用可能となる.

将来的にはAPI経由での提供も予定している.

Sora 2の高度な機能には,同意のない肖像利用や誤った情報生成といった新たな潜在的リスクへの対応が必要となる.

これらの課題に対処するため,社内のレッドチームと連携し,新たな課題を特定するとともに,それに応じた緩和策を検討した.

我々は安全性確保において反復的なアプローチを採用しており,特に文脈の理解が重要な領域や,リスクが依然として顕在化しつつあり完全には解明されていない領域に重点的に取り組んでいる.

我々の段階的な展開戦略では,限定招待制によるSora 2の初期アクセス提供を開始し,フォトリアリスティックな人物を特徴とする画像アップロードおよびすべての動画アップロードの使用を制限するとともに,未成年者を題材としたコンテンツに対しては厳格な保護措置とモデレーション基準を適用する.

今後も,ユーザによるSora 2の活用方法を継続的に検証し,安全性を確保しつつ,創造性を最大限に発揮できるシステムへと改良を重ねていく.

本システムカードでは,モデルの機能特性,想定されるリスク,およびOpenAIがSora 2の安全な展開のために構築した安全対策について詳細に説明する.

2章:Model Data & Data Filtering(モデルデータとデータフィルタリング)

Sora 2はOpenAIの他のモデルと同様,多様なデータセットで学習されている.

具体的には,インターネット上で公開されている情報,第三者パートナーを通じて取得した情報,ユーザや人間の訓練者・研究者が提供または生成した情報などが使用されている.

我々のデータ処理パイプラインには,データ品質を維持し潜在的なリスクを緩和するため,厳格なフィルタリングプロセスが組み込まれている,

さらに,有害なコンテンツやセンシティブな内容(未成年者を含む性的な表現などの露骨な内容を含む)の使用や生成を防止するため,複数の安全性分類器を組み合わせたシステムを採用している.

3章:Safety: Safety Stack, Evaluations and Mitigations for Sora 2(安全性:Sora 2の安全スタック,評価,緩和策)

3.1節:Safety Stack(安全スタック)

Sora 2を安全にデプロイするため,我々はSora 1の運用から得た知見を基盤としつつ,GPT-4o Image GenerationやDALL-Eといった他のOpenAIモデル・製品向けに開発された緩和策を取り入れ,さらにSora 2特有の安全対策を追加した堅牢な安全スタックを構築した.

具体的には以下の要素が含まれる.

- マルチモーダルなモデレーション分類器によるテキスト・画像の監視:入力プロンプト,出力動画フレーム,音声書き起こし,コメント,および出力シーン説明文は,以下の各種安全モデルによって処理される.

- 入力(プロンプト)ブロック機能:この対策では,テキスト分類器や画像分類器がプロンプトを我々のポリシー違反と判定した場合,ツールによる動画生成を自動的にブロックする.入力内容を事前検知してブロックすることで,許可されていないコンテンツが生成される事態を未然に防ぐことができる.

- 出力ブロック機能:この手法は動画生成後に適用されるもので,児童性的虐待コンテンツ(CSAM)分類器や安全性重視の推論モニターなどの制御機構を組み合わせて使用する.入力段階でのブロックを回避された場合でも,我々のポリシーに違反する動画の出力を防止する仕組みである.このモニターはマルチモーダル推論モデルであり,コンテンツポリシーに関する判断を独自に学習している.生成後の出力内容を評価することで,本戦略は我々のポリシーで禁止されているあらゆるコンテンツをブロックすることを目的としており,禁止コンテンツの生成に対する追加的な防御策として機能する.

- 未成年者に対する保護強化:18歳未満の可能性があるユーザに対しては,上記の緩和措置をより厳格に適用するとともに,年齢に不適切なコンテンツを含む特定のカテゴリーの作成権限を制限する.現在13歳未満のユーザは,OpenAIのすべての製品およびサービスの利用を禁止されている.

3.2節:Product and Usage Policies(製品および使用に関するポリシー)

モデルとシステムに組み込まれた違反コンテンツ生成防止機能に加え,新たなSoraアプリの各機能領域(動画コンテンツ,コメント,プロフィール情報,メッセージ機能)における誤用をさらに抑制するため,追加的な対策を講じている.

我々は,製品内および公開している利用規約1を通じて明確にポリシーガイドラインを伝達している.

これらの規約では,以下の行為を明確に禁止している.

※OpenAIの利用ポリシー:https://openai.com/policies/usage-policies/

- 他者のプライバシー侵害行為,特に本人の許可なく他者の肖像を使用すること

- 他者の安全・安心を侵害する行為(脅迫・嫌がらせ・名誉毀損を含む内容,同意のない性的画像,他者への暴力や苦痛を誘発する意図のあるコンテンツなど)にSoraを使用すること

- なりすまし,詐欺,不正行為によって他者を欺く行為

- 未成年者を搾取・危険にさらす,または性的対象として扱う目的でSoraを使用すること

Sora 1と同様に,これらの不正利用形態の一部は我々のモデルとシステムによる緩和策で対処可能だが,その他のケースはより文脈依存的であり,適切な評価のためには追加情報が必要となる.

規制強化を支援するため,我々ではアプリ内報告機能を提供するとともに,自動化システムと人的レビューを組み合わせ,不正利用のパターンを検出している.

違反が確認された場合には,罰則の適用やコンテンツの削除を実施する.

利用者には規制措置について通知を行い,意見を述べる機会を付与する.

これらの対策の有効性を継続的に追跡し,時間の経過とともに改善を図っていく.

Soraのソーシャルフィードでは,違反コンテンツや,若年層には不適切なコンテンツを除去するための措置も講じている.

3.3節:Provenance and Transparency Initiatives(出所証明と透明性推進イニシアチブ)

Sora 2における潜在的な問題点(肖像権の不正使用など)の多くは文脈依存性が高いため,我々は信頼性の高い出所証明ツールの開発と改良に継続的に投資してきた.

一般提供に向けて,我々の第三者由来安全性ツールキット(ファーストパーティ製品向け)には以下の機能が含まれる.

- すべてのアセットにC2PAメタデータを付与し,業界標準に準拠した検証可能なコンテンツの出所情報を提供する.

- sora.comまたはSoraアプリからダウンロードした動画には,視認可能な移動型ウォーターマークが表示される.

- 自社製品によって作成された特定の動画・音声コンテンツかどうかを判定するための内部検出ツールを提供する.

出所証明には唯一無二の解決策が存在しないことを認識しているが,我々は今後も出所証明エコシステムの改善を継続し,我々のツールで作成されるコンテンツの透明性向上に貢献していく.

3.4節:Specific Risk Areas & Mitigations(特定リスク領域と緩和策)

初期テストに加え,レッドチーム演習や安全性評価を通じて,いくつかの重点改善領域が明らかになった.

- 有害または不適切な出力:Sora 1と同様に,Sora 2にも緩和策が実装されていない場合,暴力描写,自傷行為,テロ関連コンテンツ,性的な内容など,有害または不適切なコンテンツを生成するリスクが存在する.これらのリスクに対処するため,Sora 2では動画フレーム,シーン説明,音声書き起こしを自動スキャンする検出システムを採用しており,我々のガイドラインに違反するコンテンツをブロックする機能を備えている.さらに,積極的な検出システム,不適切なコンテンツを報告するためのユーザ向け経路,Sora 2のソーシャルフィードに投稿されたコンテンツに対するより厳格な審査基準も導入している.我々は継続的にトレンドを監視し,新たなリスクが発生した際には速やかに緩和策を更新している.具体的なコンテンツ種別ごとの安全性評価については,「安全性評価」の章(※訳注:5章)を参照されたい.

- 肖像権の不正利用と欺瞞的コンテンツの生成:Sora 2が極めてリアルな動画・音声を生成できる能力は,肖像権の保護,不正利用,および欺瞞行為に関する重大な懸念を引き起こしている.前述の通り,我々はこれらの潜在的リスクを最小限に抑えるため,慎重かつ段階的な展開アプローチを採用している.初期リリース時の安全対策として以下の措置を講じている.(1)リリース当初は動画から動画への生成機能をサポートしない,(2)著名人を対象としたテキストから動画への生成機能をサポートしない,(3)Soraの「肖像権管理カメオ」機能を通じて同意を得たユーザ以外の実在人物を含む生成を禁止する,という措置である.さらに,カメオを通じた肖像権利用に関しては,明示的なオプトイン同意と制御メカニズムを導入している.実在人物が動画に登場する場合,追加のモデル保護策が適用される.これには,非同意のヌード描写や性的に露骨な内容,過激な暴力表現,あるいは特定の詐欺行為に利用される可能性のある出力を防止するための分類器が含まれる.また,一部の欺瞞的コンテンツは非常に文脈依存的であり,分類器による検出が容易でない場合もあるが,Soraの出所追跡機能はこうしたリスクをさらに緩和することを目的としている.

- 児童保護対策:OpenAIは,Soraを含むすべての製品において児童保護リスクへの対応に全力で取り組んでいる.我々は,児童性的虐待コンテンツ(CSAM)の生成防止,検出,報告を最優先課題としており,以下の対策を講じている.(1)データセットの責任ある調達によりCSAMを意図的に排除,(2)全米行方不明・被搾取児童センター(NCMEC)との協力体制の構築,(3)第三者提供を含むすべての入出力データに対する堅牢なスキャン処理の実施(ただし,顧客が厳格な削除基準を満たす場合はこの限りではない)である.CSAM生成を防止するため,我々はSora専用の安全システムを構築した.このシステムには,他の製品群で採用しているシステムレベルの緩和策に加え,Sora向けに特別に開発された追加的な安全対策が組み込まれている.具体的なCSAM安全対策の詳細については,Soraシステムカードを参照されたい.

※OpenAI Sora System Card:https://openai.com/index/sora-system-card/ - ティーンエイジャーの安全:Sora 2には,18歳未満のユーザを保護するための追加的な安全対策が数多く搭載されている.主な機能は以下の通りである.

- 未成年ユーザに対するモデル出力の制限:我々は,18歳未満である可能性があると判断したユーザに対して,追加のコンテンツ審査基準を適用している.さらに,分類システムがアップロードされた画像や動画(ソラのカメオ機能を通じて生成されたものを含む)に未成年者の存在を確認した場合,その画像・動画を基に生成される後続のコンテンツに対しては,より厳格な安全基準を適用し,潜在的に有害なコンテンツの生成をさらに防止する.ユーザの年齢にかかわらず,分類システムはソラの公開フィードに掲載されるコンテンツが,我々の「18歳未満向けポリシー」に合致し,ティーンユーザにとって適切な内容であることを保証するよう設計されている.

- プライバシー保護とペアレンタルコントロール:sora.comおよび新バージョンのSoraアプリを展開するにあたり,10代のユーザ向けにさらに厳格なプライバシー保護措置と初期設定を導入する.これには,肖像の使用範囲に関する制限や,成人からの望まない接触や発見を防ぐための保護機能が含まれる.さらに我々は,保護者向けの包括的な管理機能セットを新たに導入しており,詳細については我々のブログにて解説している.

※ファミリー向けに ChatGPT の使い方を工夫:http://chatgpt.com/parent-resources

前述の通り,本デプロイには反復的なアプローチを採用しており,具体的な緩和策は今後変更される可能性がある.

4章:Red Teaming(レッドチーム)

OpenAIは外部のテストチーム「Red Team Network」と協力し,Sora 2の性能評価,既存の安全性対策の検証,および新たなリスクに関するフィードバック収集を実施した.

レッドチームの専門家チームは新規の安全対策を評価し,今後のバージョンに向けた改善点を提案した.

コンテンツ生成におけるレッドチーム演習では,OpenAIの利用ポリシーで禁止されているカテゴリー(性的コンテンツ,ヌード,過激思想,自傷行為,不正行為,暴力・残虐描写,政治的勧誘など)に加え,青少年の安全性や肖像権使用に関する追加ポリシーについても検証を行った.

レッドチームはさらに,違反コンテンツのアップロード検知,メディア生成機能のテスト,安全システムの回避試行,製品レベルの保護機能に対するストレステストを実施した.

レッドチーム演習から得られた知見は,新たな安全対策の設計と既存対策の改善に反映され,プロンプトフィルターやブロックリスト,分類器の閾値設定などをさらに調整することで,モデルの安全性目標との整合性をより高めることに成功した.

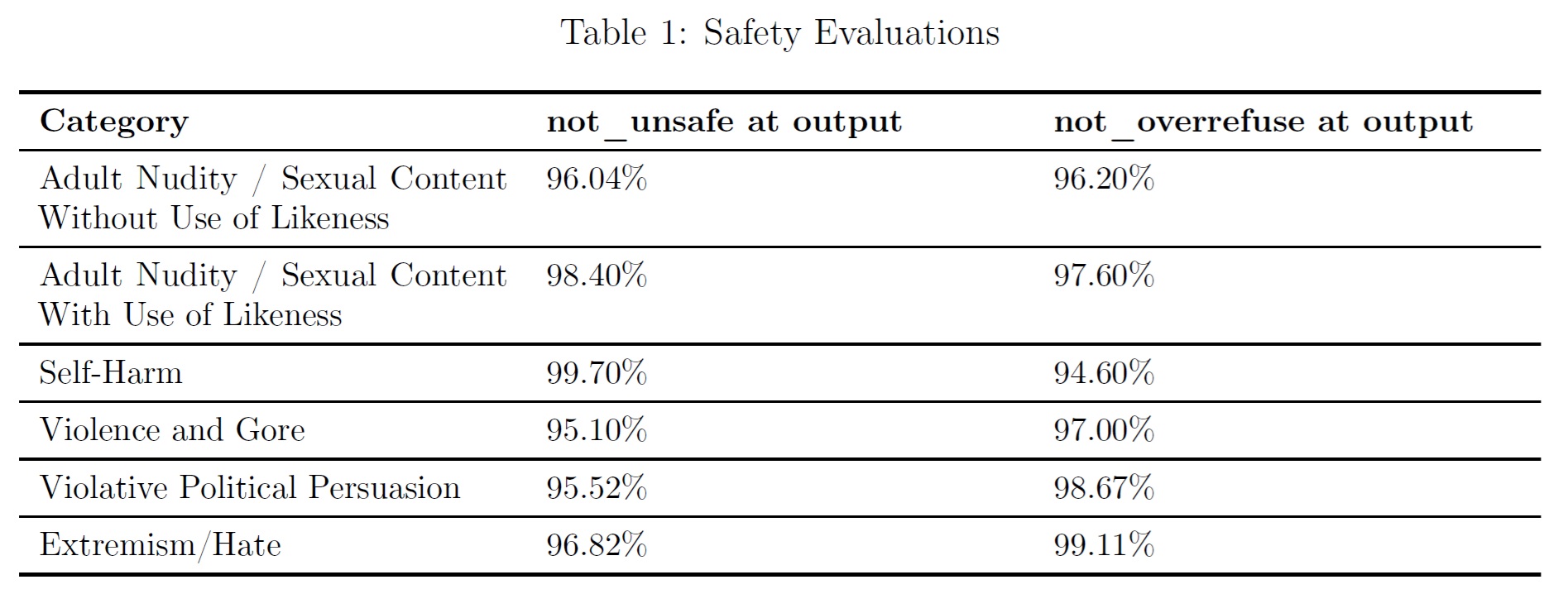

5章:Safety Evaluations(安全性評価)

OpenAIは,ターゲットのレッドチーム演習を通じて収集した数千種類の敵対的プロンプトを用いて,Sora 2の安全性スタックを評価した.

各プロンプトはユースケースとポリシー分野ごとに分類され,動画モデルの「有用性重視」バージョンに入力して出力を生成した後,評価スコアを付与して自動評価システムに変換した.

実際の運用環境で使用される安全性スタック(動画フレーム・キャプション・音声書き起こしをスキャンする機能)は,2つの主要指標についてテストを実施した.

「not_unsafe」(安全でないコンテンツの効果的なブロック率(再現率)を測定)と,「not_overrefuse」(無害なコンテンツが誤ってブロックされる頻度を測定)である.

以下に,各種ユースケースとポリシー分野を横断して集計した評価結果の概要を示す.

6章:Continued work on safety, policy, & iterative deployment(安全性・ポリシー策定・反復的なデプロイに関する継続的な取り組み)

我々は「Sora 2」を,ユーザが安全かつ自信を持って創作活動を行えるシステムとして構築することを使命としている.

安全性と創造性は密接に関連しており,人々は使用する製品に信頼を置ける時に最も創造的になれる.

多層的な安全対策を講じているものの,一部の有害な行為やポリシー違反は,こうした緩和策をすり抜けてしまう可能性がある.

保護機能を強化するため,年齢推定機能やさらなる来歴確認措置などの機能開発に投資を進めている.

安全性システムは,Sora 2の利用が進むにつれて,継続的なファインチューニングと機能改良を通じて進化を続けていく.

社内チームは動向を注視し,現在実施している緩和策の有効性を評価した上で,新たなリスクに対処するため必要に応じてポリシーや運用体制の見直しを行う.

参考:Sora 2 System Cardの解説動画

Sora 2 System Cardの解説動画です.

まとめ

Sora 2 System Cardの日本語訳を紹介しました.

OpenAIの動画生成AI「Sora 2」がわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.