Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの日本語訳を紹介します.

MicrosoftのPhi-3がわかります.

※図表を含む論文の著作権はPhi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの著者に帰属します.

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの目次は以下になります.

- Abstract

- 1章:Introduction

- 2章:Technical Specifications

- 3章:Academic benchmarks

- 4章:Safety

- 5章:Weakness

- References

- 付録A:Example prompt for benchmarks

- 付録B:Authors

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneを解説しつつ,私の考えも語ります.

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの概要と私の日本語訳は以下になります.

We introduce phi-3-mini, a 3.8 billion parameter language model trained on 3.3 trillion tokens, whose overall performance, as measured by both academic benchmarks and internal testing, rivals that of models such as Mixtral 8x7B and GPT-3.5 (e.g., phi-3-mini achieves 69% on MMLU and 8.38 on MT-bench), despite being small enough to be deployed on a phone.

phi-3-miniは3.3兆個のトークンで訓練された38億パラメータの言語モデルであり,学術的ベンチマークと内部テストの両方で測定された総合的な性能は,携帯電話上で展開できるほど小さいにもかかわらず,Mixtral 8x7BやGPT-3.5のようなモデルに匹敵する(例えば,phi-3-miniはMMLUで69%,MT-benchで8.38を達成している).The innovation lies entirely in our dataset for training, a scaled-up version of the one used for phi-2, composed of heavily filtered web data and synthetic data.

この革新的なモデルは訓練用データセットにあり,phi-2に使用されたものをスケールアップしたもので,大きくフィルタリングされたウェブデータと合成データから構成されている.The model is also further aligned for robustness, safety, and chat format.

モデルはまた,頑健性,安全性,チャット形式のためにさらに調整されている.We also provide some initial parameter-scaling results with a 7B and 14B models trained for 4.8T tokens, called phi-3-small and phi-3-medium, both significantly more capable than phi-3-mini (e.g., respectively 75% and 78% on MMLU, and 8.7 and 8.9 on MT-bench).

我々はまた,phi-3-smallとphi-3-mediumと呼ばれる4.8Tトークンのために訓練された7Bと14Bのモデルで,いくつかの初期パラメータスケーリング結果を提供し,両方がphi-3-miniよりも有意に有能である(例えば,それぞれMMLUで75%と78%,MT-benchで8.7と8.9).https://arxiv.org/abs/2404.14219

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Authors」(著者)は省略していること

- 本文中に登場する表記「[RWC+19]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの本文を読みすすめましょう!

目次

1章:Introduction(はじめに)

ここ数年のAIの目覚ましい進歩は,これまで以上に大規模なモデルやデータセットへのスケールアップに向けた世界中の大きな努力によるところが大きい.

大規模言語モデル(LLMs:Large Language Models)は,わずか5年前の10億パラメータ(GPT-2は15億パラメータ[RWC+19])から,今日では1兆パラメータへと着実にその規模を拡大している.

この努力の原動力は,大規模なモデルを訓練することで得られる,いわゆるスケーリング則[KMH+20, HBM+22, MRB+23]と呼ばれる,一見予測可能な改善にある.

しかしながら,これらの法則は「固定された」データソースを前提としている.

この仮定は現在,フロンティアLLMの存在によって大きく崩れている.

これにより,斬新な方法でデータを扱うことができる.

phiモデルに関する我々の以前の研究[GZA+23, LBE+23, JBA+23]では,LLMに基づくウェブデータのフィルタリングと,LLMで作成された合成データの組み合わせにより,通常はるかに大きなモデルでしか見られなかった性能が,より小さな言語モデルでも可能になることが示された.

例えば,このデータレシピで訓練された我々の以前のモデルphi-2(2.7Bパラメータ)は,通常のデータで訓練された25倍大きなモデルの性能に匹敵した.

本レポートでは,phi-2で使用されたデータセットのより大きく高度なバージョンで3.3Tトークンのために訓練された新しいモデル,phi-3-mini (3.8Bパラメータ)を紹介する.

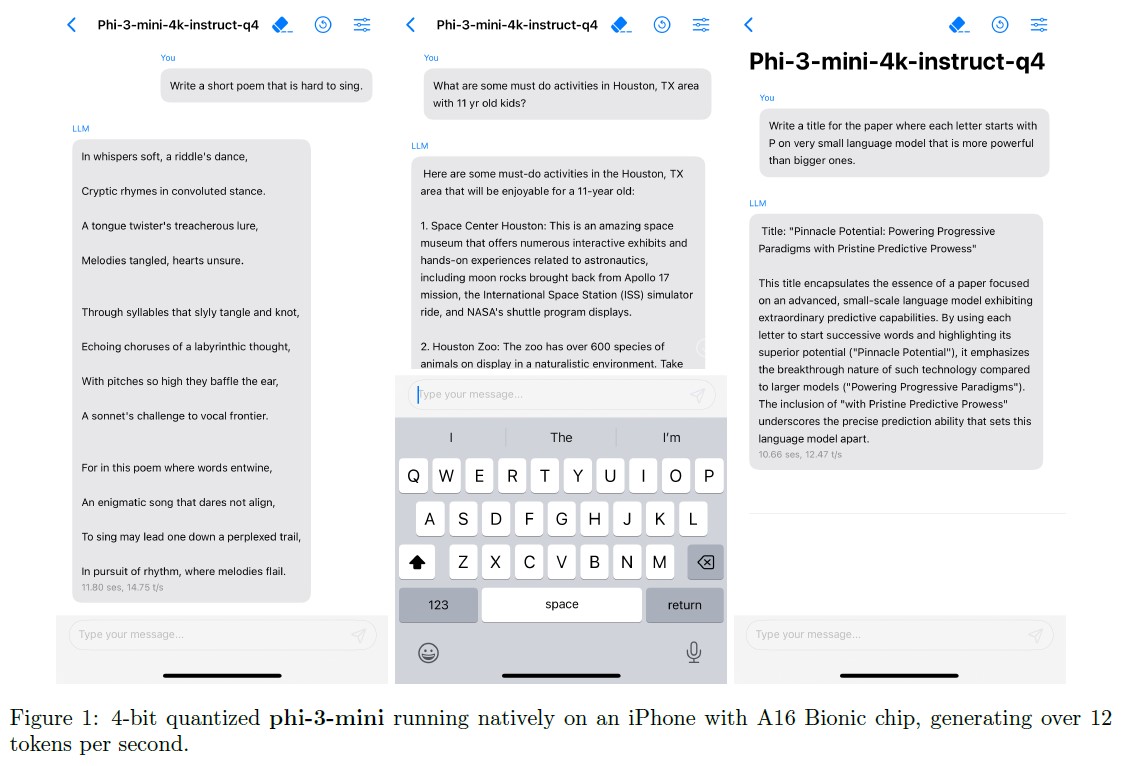

その小さなサイズにより,phi-3-miniは最新の携帯電話(図1参照)で簡単にローカルに推論することができ,しかもMixtral 8x7B [JSR+24]やGPT-3.5のようなモデルと同等の品質を達成している.

User: Explain why it is surprising that one can build a language model small enough to fit on a phone, yet almost as powerful as ChatGPT. Just use one funny sentence.

phi-3-mini: It’s like fitting a supercomputer in a flip phone, but instead of breaking the phone, it just breaks the internet with its tiny, yet mighty, linguistic prowess!

User: Okay now more serious answer, and note that this was achieved solely by changing the training data.

phi-3-mini: The development of a compact language model that rivals the capabilities of ChatGPT, while fitting on a phone, is a testament to the power of data-driven machine learning. By meticulously curating and optimizing the training dataset, researchers can significantly reduce the model’s size without compromising its performance. [...]

2章:Technical Specifications(技術仕様)

phi-3-miniモデルはTransformerデコーダアーキテクチャ[VSP+17]であり,デフォルトのコンテキスト長は4Kである.

また,LongRope [DZZ+24]を介して,コンテキスト長を128Kに拡張したロングコンテキストバージョンも導入しており,これをphi-3-mini-128Kと呼ぶ.

オープンソースコミュニティに最適なように,phi-3-miniはLlama-2[TLI+23]と同様のブロック構造で構築されており,32064の語彙サイズを持つ同じトークナイザーを使用している.

※BoSトークンを削除し,チャットテンプレート用にいくつかのトークンを追加した.

つまり,Llama-2ファミリーのモデル用に開発されたすべてのパッケージは,そのままphi-3-miniに適応させることができる.

このモデルは3072の隠れ次元,32ヘッド,32レイヤを使用する.

合計3.3Tトークンに対してbfloat16を使って訓練した.

このモデルは既にチャット向けにファインチューニングされており,チャットテンプレートは以下の通りである.

<|user|>/n Question <|end|>/n <|assistant|>

phi-3-smallモデル(7Bパラメータ)は,tiktokenトークナイザー(多言語トークン化のため)を活用し,語彙サイズは100352,デフォルトのコンテキスト長は8Kである.

7Bモデルクラスの標準的なデコーダアーキテクチャに従い,32層,4096の隠れサイズを持つ.

KVキャッシュのフットプリントを最小化するために,このモデルはGrouped-Query Attentionを利用し,4つのクエリで1つのキーを共有する.

さらに,phi-3-smallはDense Attentionと新しいブロックパースアテンションの代替レイヤを使用し,ロングコンテキスト検索性能を維持しながらKVキャッシュの節約をさらに最適化する.

このモデルにはさらに10%の多言語データも使用された.

携帯電話上でローカルに動作する高性能言語モデル:

その小さなサイズのおかげで,phi-3-miniは4ビットに量子化することができ,≈1.8GBのメモリしか占有しない.

我々は,A16 Bionicチップを搭載したiPhone 14上でphi-3-miniをネイティブに動作させ,完全オフラインで毎秒12トークン以上を達成することで,量子化されたモデルをテストした.

訓練方法論:

我々は,「Textbooks Are All You Need」[GZA+23]で開始された一連の研究を踏襲し,小規模言語モデルの性能を向上させるために高品質な学習データを利用し,標準的なスケーリング則から逸脱する.

本研究では,このような手法により,GPT-3.5やMixtralのような高性能モデルのレベルに,わずか3.8Bの総パラメータで到達できることを示す(一方,Mixtralは45Bの総パラメータを持つ).

我々の訓練データは,様々なオープンなインターネットソースから(「教育レベル」に応じて)厳重にフィルタリングされたウェブデータと,LLMが生成した合成データから構成される.

事前訓練は,2つの分離した連続したフェーズで実行される.

フェーズ1は,モデルの一般的な知識と言語理解を教えることを目的としたウェブソースから主に構成される.

フェーズ2は,さらに高度にフィルタリングされたウェブデータ(フェーズ1で使用されたサブセット)と,モデルに論理的推論と様々なニッチスキルを教える合成データをマージする.

データ最適領域(Data Optimal Regime):

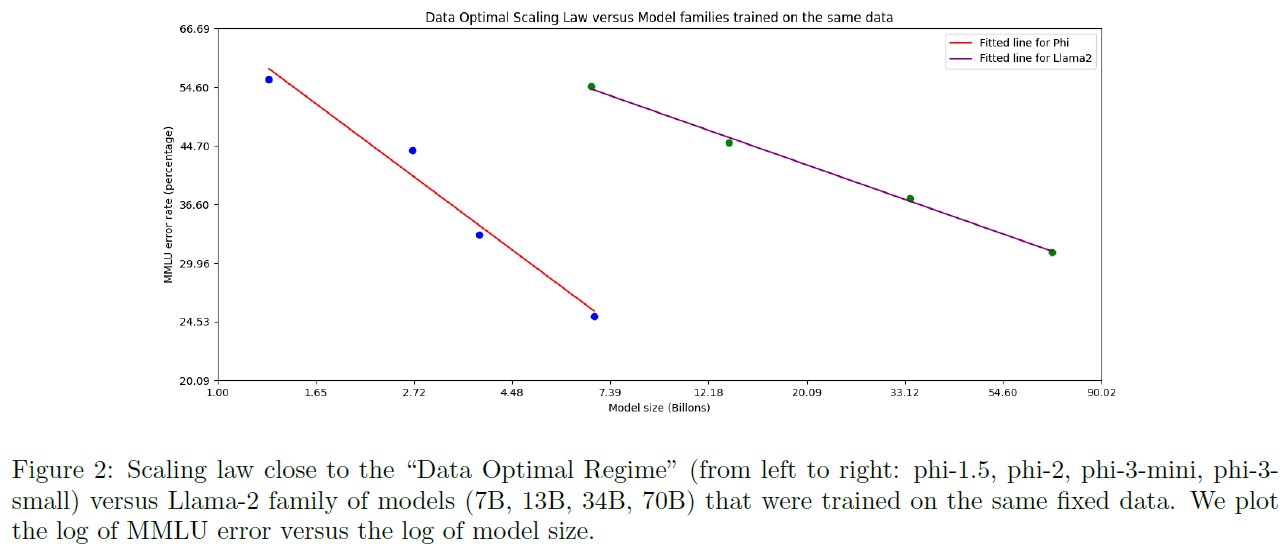

「計算最適領域」(Compute Optimal Regime)[HBM+22]や「過剰訓練領域」(Over-Train Regime)のいずれかで言語モデルを訓練する先行研究とは異なり,我々は主に与えられたスケールに対するデータの質に焦点を当てる.

※計算最適領域の場合と同様に「最適」(optimal)という用語は,データ最適領域の場合にも願望的な意味で使っている.我々は,与えられたスケールに対して証明可能な「最適な」データ混合を実際に見つけたということを意味しているのではない.

我々は,小さなモデルに対して「データ最適領域」に近づくように訓練データを較正することを試みる.

特に,適切なレベルの「知識」を含むようにウェブデータをフィルタリングし,モデルの「推論能力」を向上させる可能性のあるウェブページをより多く残す.

例として,ある日のプレミアリーグの試合結果は,フロンティアモデルにとっては良い訓練データかもしれないが,ミニサイズのモデルには「推論」のためのモデル容量をより多く残すために,そのような情報を取り除く必要がある.

図2で我々のアプローチとLlama-2を比較する.

より大きなサイズのモデルをテストするために,phi-3-miniと同じトークナイザーとアーキテクチャを使用し,14Bのパラメータを持つモデルであるphi-3-mediumも訓練した.

phi-3-mediumはphi-3-miniと同じトークナイザーとアーキテクチャを使用し,同じデータで少し多めのエポック(phi-3-smallと同じ4.8Tトークン)で訓練した.

このモデルには40のヘッドと40のレイヤがあり,埋め込み次元は5120である.

いくつかのベンチマークでは,3.8Bから7Bへの改善よりも,7Bから14Bへの改善の方がはるかに少ないことが観察され,おそらく我々のデータ混合が14Bパラメータモデルの「データ最適領域」に入るにはさらなる研究が必要であることを示している.

我々はまだいくつかのベンチマーク(HumanEvalの回帰を含む)を積極的に調査中であるため,phi-3-mediumの数値は「プレビュー」と考えるべきである.

事後訓練:

phi-3-miniの事後訓練は,教師付きファインチューニング(SFT:Supervised FineTuning)と直接選好最適化(DPO:Direct Preference Optimization)を含む2つの段階を経た.

SFTは,数学,コーディング,推論,会話,モデルの同一性,安全性など,多様な領域にわたって高度にキュレートされた高品質なデータを活用する.

SFTのデータミックスは,まず英語のみの例を使用する.

DPOデータは,チャット形式のデータ,推論,責任あるAI(RAI:Responsible AI)の取り組みをカバーしている.

我々はDPOを使用して,これらの出力を「拒否」応答として使用することで,不要な行動からモデルを誘導する.

数学,コーディング,推論,ロバスト性,安全性の向上に加え,事後訓練は言語モデルを,ユーザが効率的かつ安全に対話できるAIアシスタントに変える.

事後訓練プロセスの一環として,コンテキスト長の制限を4Kから128Kに拡大したロングコンテキストバージョンのphi-3-miniを開発した.

全体として,128Kのモデルの品質は4K長バージョンと同等であり,同時にロングコンテキストのタスクを扱うことができる.

ロングコンテキストの拡張は,ロングコンテキストの中間訓練と,SFTとDPOの両方を用いたロングショート混合事後訓練の2段階で行われた.

3章:Academic benchmarks(アカデミックベンチマーク)

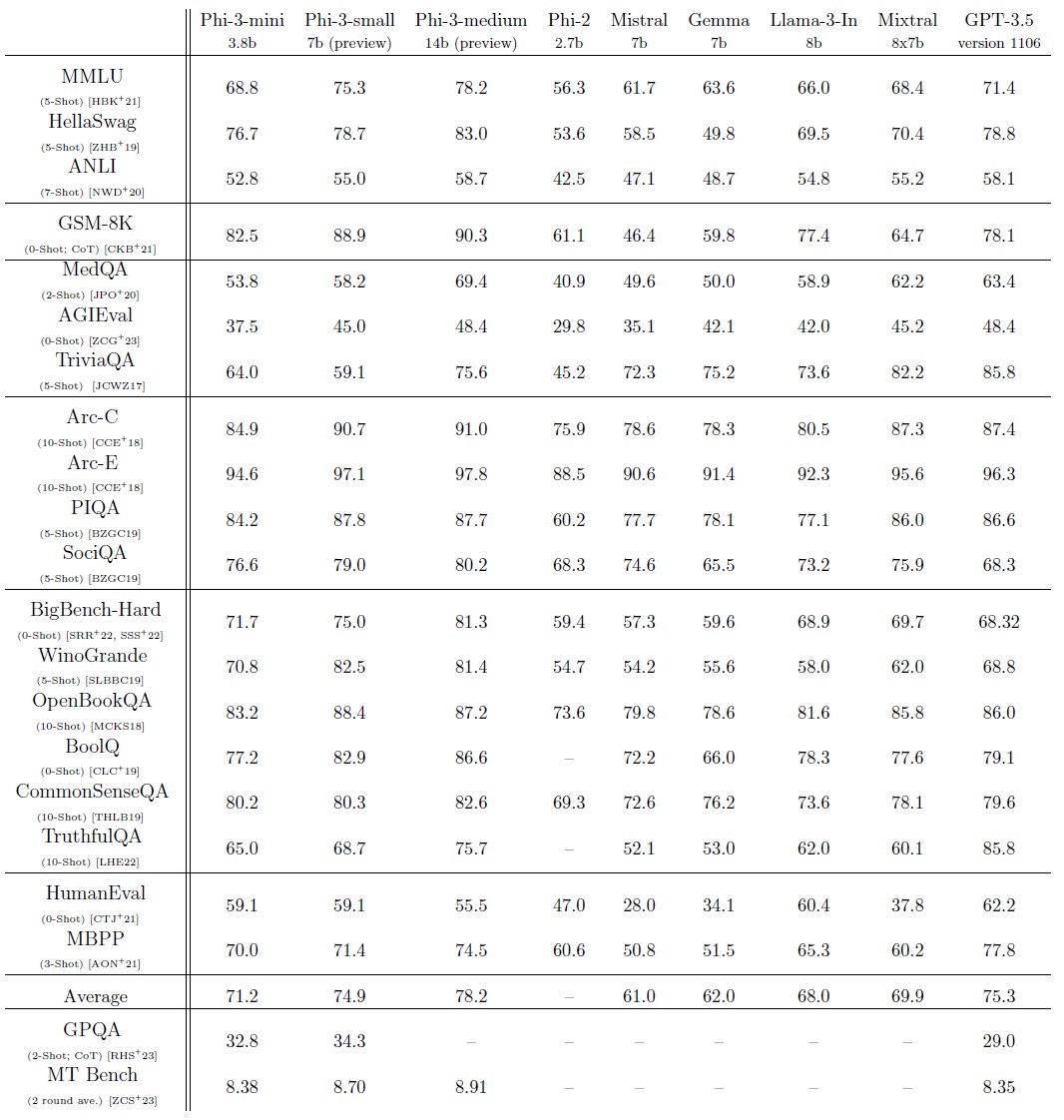

次のページ(※訳注:下表)では,モデルの推論能力(常識的推論と論理的推論の両方)を測定する標準的なオープンソースベンチマークにおけるphi-3-miniの結果を報告する.

phi-2[JBA+23],Mistral-7b-v0.1[JSM+23],Mixtral-8x7b[JSR+24],Gemma 7B[TMH+24],Llama-3-instruct-8b[AI23],GPT-3.5と比較している.

報告された数値はすべて,数値が比較可能であることを保証するために,まったく同じパイプラインで作成されている.

これらの数値は,評価におけるわずかな選択の違いにより,他の公表されている数値と異なる可能性がある.

現在標準となっているように,Temperature 0でのモデルの評価にはFew-Shotのプロンプトを使用する.

プロンプトとショットの数は,言語モデルを評価するためのMicrosoft社内のツールの一部であり,特にphi-3モデルについてはパイプラインの最適化は行っていない.

※例えば,「質問」の前に##を使用することで,多くのベンチマークでphi-3-miniの結果が顕著に改善されることがわかったが,プロンプトではそのような変更は行わなかった.

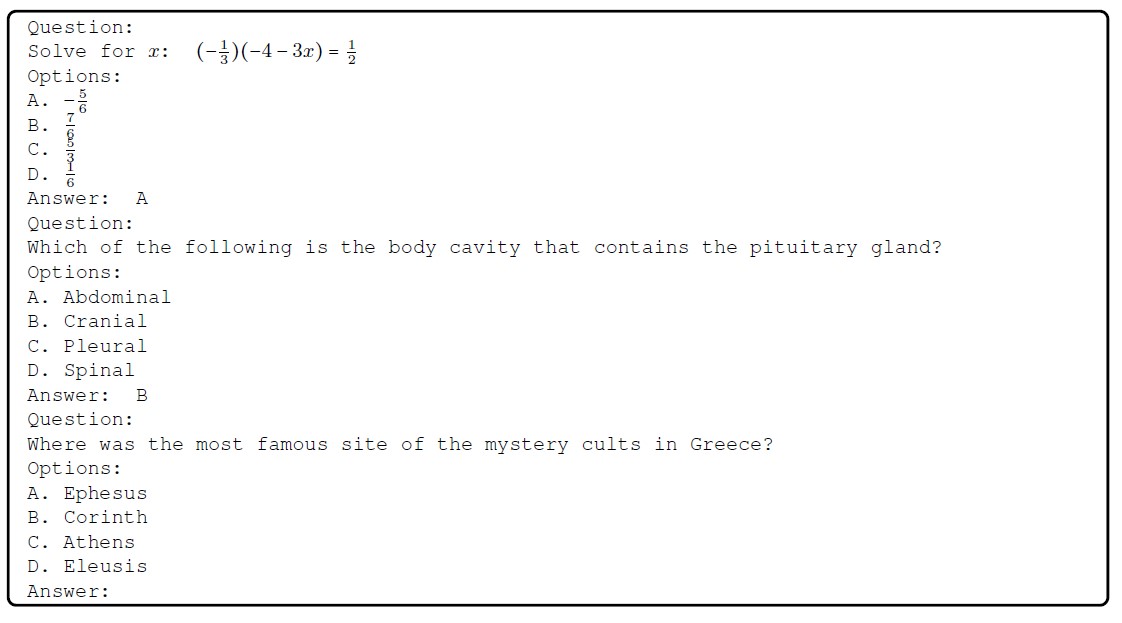

k-Shotの例数はベンチマークごとに記載されている.

2-Shotのプロンプトの例は付録Aに記載されている.

4章:Safety(安全性)

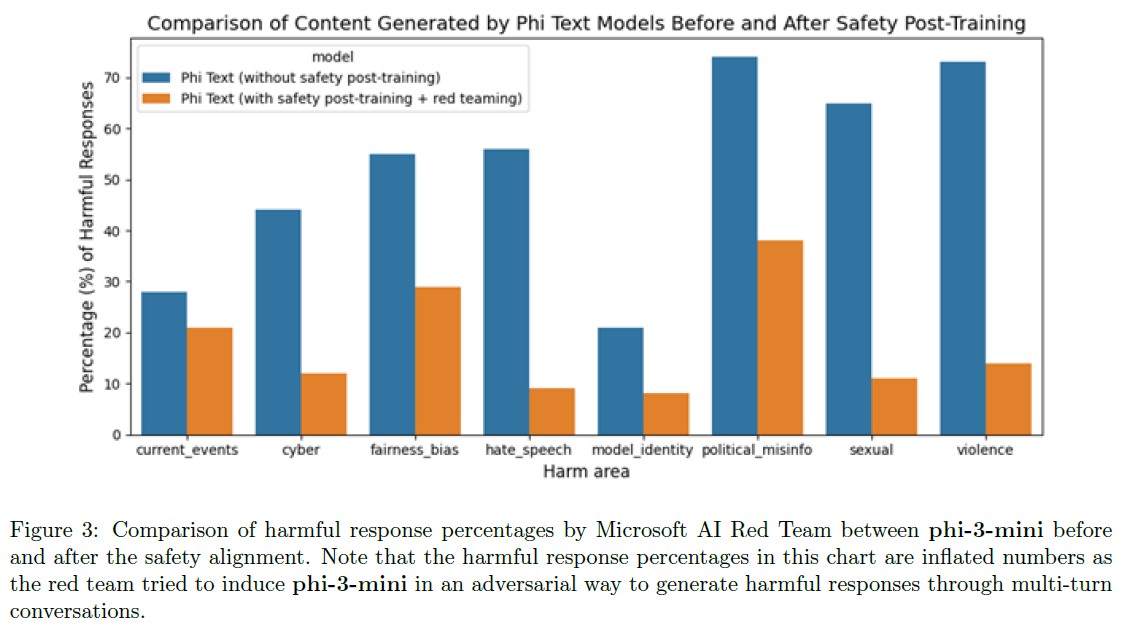

Phi-3-miniは,Microsoftの責任あるAI(RAI:Responsible AI)の原則に従って開発された.

全体的なアプローチは,事後訓練における安全性の調整,レッドチーム,自動テスト,および数十のRAI危害カテゴリーにわたる評価で構成された.

[BSA+24]に触発され修正された[BJN+22, JLD+23]の有用性と無害性嗜好データセットと,社内で生成された複数のデータセットが,安全性事後訓練におけるRAI危害カテゴリーに対処するために活用された.

Microsoftの独立したレッドチームは,事後訓練プロセスで改善すべき領域を特定するために,phi-3-miniを繰り返し調査した.

彼らのフィードバックに基づき,我々は彼らの洞察に対応するよう調整された追加データセットを作成し,事後訓練のデータセットを改良した.

このプロセスにより,図3に示すように,有害回答率が大幅に減少した.

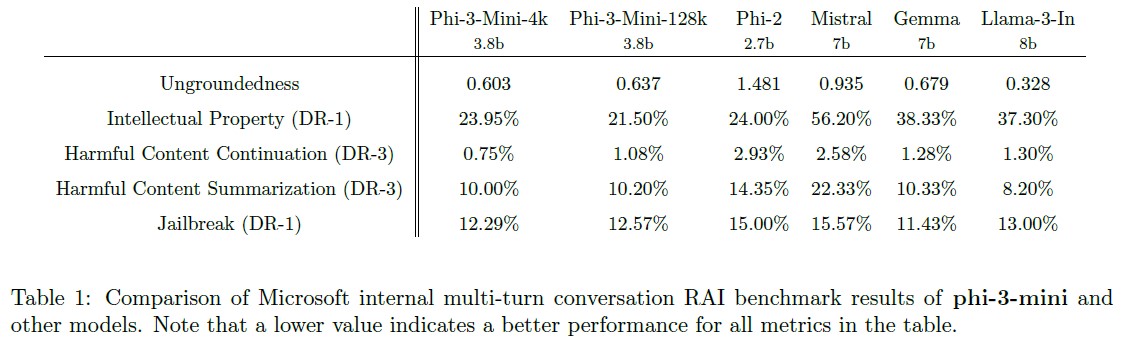

表1は,phi-3-mini-4kとphi-3-mini-128kの社内RAIベンチマークの結果を,phi-2[JBA+23],Mistral-7b-v0.1[JSM+23],Gemma 7b[TMH+24],Llama-3-instruct-8b[AI23]と比較したものである.

このベンチマークでは,GPT-4を利用して,5つの異なるカテゴリのマルチターン会話をシミュレートし,モデルの回答を評価した.

0(完全に根拠がある)から4(根拠がない)の間の根拠なしは,回答の情報が与えられたプロンプトに基づいているかどうかを測定する.

その他のカテゴリーでは,回答は0(害なし)から7(極度の害)までの害の重大度の観点から評価され,欠陥率(DR-x)は,重大度スコアがx以上であるサンプルの割合として計算された.

5章:Weakness(弱点)

LLMの能力という点では,phi-3-miniモデルははるかに大きなモデルと同程度の言語理解と推論能力を達成しているものの,特定のタスクではそのサイズによって根本的に制限されている.

このモデルには,あまり多くの「事実知識」を蓄える能力がない.

このことは,例えばTriviaQAの成績の低さからも見て取れる.

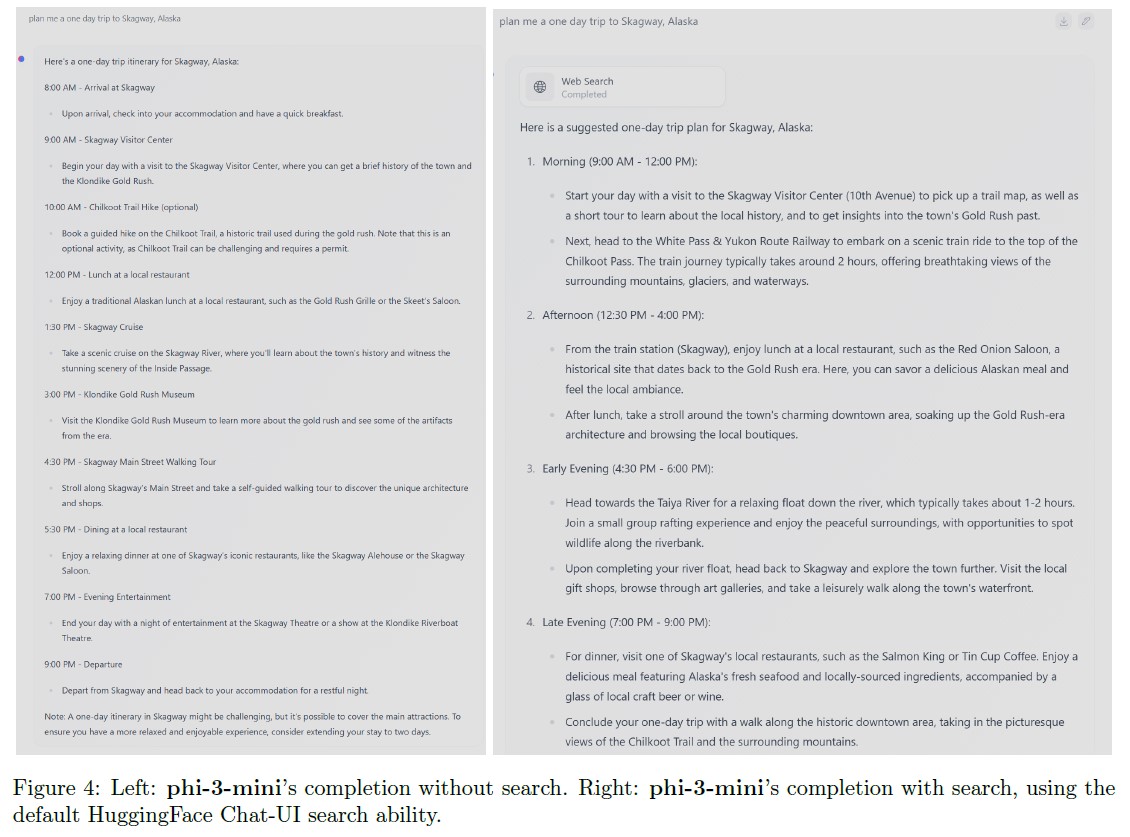

しかしながら,このような弱点は,検索エンジンで拡張することで解決できると考えている.

図4に,HuggingFaceのデフォルトのチャットUIとphi-3-miniを使った例を示す.

モデルの能力に関するもう一つの弱点は,言語をほとんど英語に限定していることである.

小規模言語モデルの多言語能力を探求することは重要な次のステップである.

より多くの多言語データを含めることで,phi-3-smallでいくつかの初期有望な結果が得られている.

我々の熱心なRAI努力にもかかわらず,ほとんどのLLMと同様に,事実誤認(または幻覚),バイアスの再現または増幅,不適切なコンテンツ生成,安全性の問題などの課題が残っている.

入念に管理された訓練データ,的を絞った事後訓練,そしてレッドチームによる洞察からの改善を用いることで,あらゆる次元でこれらの問題は大幅に軽減される.

しかしながら,これらの課題に完全に対処するには,大きな課題が残されている.

References(参考文献)

- [AI23] Meta AI. Introducing meta llama 3: The most capable openly available llm to date, 2023.

- [AON+21] Jacob Austin, Augustus Odena, Maxwell Nye, Maarten Bosma, Henryk Michalewski, David Dohan, Ellen Jiang, Carrie Cai, Michael Terry, Quoc Le, and Charles Sutton. Program synthesis with large language models. arXiv preprint arXiv:2108.07732, 2021.

- [BJN+22] Yuntao Bai, Andy Jones, Kamal Ndousse, Amanda Askell, Anna Chen, Nova DasSarma, Dawn Drain, Stanislav Fort, Deep Ganguli, Tom Henighan, Nicholas Joseph, Saurav Kadavath, Jackson Kernion, Tom Conerly, Sheer El-Showk, Nelson Elhage, Zac Hatfield-Dodds, Danny Hernandez, Tristan Hume, Scott Johnston, Shauna Kravec, Liane Lovitt, Neel Nanda, Catherine Olsson, Dario Amodei, Tom Brown, Jack Clark, Sam McCandlish, Chris Olah, Ben Mann, and Jared Kaplan. Training a helpful and harmless assistant with reinforcement learning from human feedback, 2022.

- [BSA+24] Federico Bianchi, Mirac Suzgun, Giuseppe Attanasio, Paul R¨ottger, Dan Jurafsky, Tatsunori Hashimoto, and James Zou. Safety-tuned llamas: Lessons from improving the safety of large language models that follow instructions, 2024.

- [BZGC19] Yonatan Bisk, Rowan Zellers, Jianfeng Gao, and Yejin Choi. Piqa: Reasoning about physical commonsense in natural language. arXiv preprint arXiv:1911.11641, 2019.

- [CCE+18] Peter Clark, Isaac Cowhey, Oren Etzioni, Tushar Khot, Ashish Sabharwal, Carissa Schoenick, and Oyvind Tafjord. Think you have solved question answering? try arc, the ai2 reasoning challenge, 2018.

- [CKB+21] Karl Cobbe, Vineet Kosaraju, Mohammad Bavarian, Mark Chen, Heewoo Jun, Lukasz Kaiser, Matthias Plappert, Jerry Tworek, Jacob Hilton, Reiichiro Nakano, Christopher Hesse, and John Schulman. Training verifiers to solve math word problems. arXiv preprint arXiv:2110.14168, 2021.

- [CLC+19] Christopher Clark, Kenton Lee, Ming-Wei Chang, Tom Kwiatkowski, Michael Collins, and Kristina Toutanova. Boolq: Exploring the surprising difficulty of natural yes/no questions. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), pages 2924–2936, 2019.

- [CTJ+21] Mark Chen, Jerry Tworek, Heewoo Jun, Qiming Yuan, Henrique Ponde de Oliveira Pinto, Jared Kaplan, Harri Edwards, Yuri Burda, Nicholas Joseph, Greg Brockman, Alex Ray, Raul Puri, Gretchen Krueger, Michael Petrov, Heidy Khlaaf, Girish Sastry, Pamela Mishkin, Brooke Chan, Scott Gray, Nick Ryder, Mikhail Pavlov, Alethea Power, Lukasz Kaiser, Mohammad Bavarian, Clemens Winter, Philippe Tillet, Felipe Petroski Such, Dave Cummings, Matthias Plappert, Fotios Chantzis, Elizabeth Barnes, Ariel Herbert-Voss, William Hebgen Guss, Alex Nichol, Alex Paino, Nikolas Tezak, Jie Tang, Igor Babuschkin, Suchir Balaji, Shantanu Jain, William Saunders, Christopher Hesse, Andrew N. Carr, Jan Leike, Josh Achiam, Vedant Misra, Evan Morikawa, Alec Radford, Matthew Knight, Miles Brundage, Mira Murati, Katie Mayer, Peter Welinder, Bob McGrew, Dario Amodei, Sam McCandlish, Ilya Sutskever, and Wojciech Zaremba. Evaluating large language models trained on code, 2021.

- [DZZ+24] Yiran Ding, Li Lyna Zhang, Chengruidong Zhang, Yuanyuan Xu, Ning Shang, Jiahang Xu, Fan Yang, and Mao Yang. Longrope: Extending llm context window beyond 2 million tokens, 2024.

- [GZA+23] Suriya Gunasekar, Yi Zhang, Jyoti Aneja, Caio C´esar Teodoro Mendes, Allie Del Giorno, Sivakanth Gopi, Mojan Javaheripi, Gustavo de Rosa Piero Kauffmann, Olli Saarikivia, Adil Salim, Shital Shah, Harkirat Singh Behl, Xin Wang, S´ebastien Bubeck, Ronen Eldan, Adam Tauman Kalai, Yin Tat Lee, and Yuanzhi Li. Textbooks are all you need. arXiv preprint arXiv:2306.11644, 2023.

- [HBK+21] Dan Hendrycks, Collin Burns, Saurav Kadavath, Akul Arora, Steven Basart, Eric Tang, Dawn Song, and Jacob Steinhardt. Measuring mathematical problem solving with the MATH dataset, 2021.

- [HBM+22] Jordan Hoffmann, Sebastian Borgeaud, Arthur Mensch, Elena Buchatskaya, Eliza Rutherford Trevor Cai, Diego de Las Casas, Lisa Anne Hendricks, Johannes Welbl, Aidan Clark, Tom Hennigan, Eric Noland, Katie Millican, George van den Driessche, Bogdan Damoc, Aurelia Guy, Simon Osindero, Karen Simonyan, Erich Elsen, Jack W. Rae, Oriol Vinyals, and Laurent Sifre. Training compute-optimal large language models. arXiv preprint arXiv:2203.15556, 2022.

- [JBA+23] Mojan Javaheripi, S´ebastien Bubeck, Marah Abdin, Jyoti Aneja, Caio C´esar Teodoro Mendes, Weizhu Chen, Allie Del Giorno, Ronen Eldan, Sivakanth Gopi, Suriya Gunasekar, Piero Kauffmann, Yin Tat Lee, Yuanzhi Li, Anh Nguyen, Gustavo de Rosa, Olli Saarikivi, Adil Salim, Shital Shah, Michael Santacroce, Harkirat Singh Behl, Adam Taumann Kalai, Xin Wang, Rachel Ward, Philipp Witte, Cyril Zhang, and Yi Zhang. Phi-2: The surprising power of small language models. Microsoft Research Blog, 2023.

- [JCWZ17] Mandar Joshi, Eunsol Choi, Daniel S. Weld, and Luke Zettlemoyer. Triviaqa: A large scale distantly supervised challenge dataset for reading comprehension, 2017.

- [JLD+23] Jiaming Ji, Mickel Liu, Juntao Dai, Xuehai Pan, Chi Zhang, Ce Bian, Chi Zhang, Ruiyang Sun, Yizhou Wang, and Yaodong Yang. Beavertails: Towards improved safety alignment of llm via a human-preference dataset, 2023.

- [JPO+20] Di Jin, Eileen Pan, Nassim Oufattole, Wei-Hung Weng, Hanyi Fang, and Peter Szolovits. What disease does this patient have? a large-scale open domain question answering dataset from medical exams, 2020.

- [JSM+23] Albert Q. Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lucile Saulnier, L´elio Renard Lavaud, Marie-Anne Lachaux, Pierre Stock, Teven Le Scao, Thibaut Lavril, Thomas Wang, Timoth´ee Lacroix, and William El Sayed. Mistral 7b, 2023.

- [JSR+24] Albert Q. Jiang, Alexandre Sablayrolles, Antoine Roux, Arthur Mensch, Blanche Savary, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Emma Bou Hanna, Florian Bressand, Gianna Lengyel, Guillaume Bour, Guillaume Lample, L´elio Renard Lavaud, Lucile Saulnier, Marie-Anne Lachaux, Pierre Stock, Sandeep Subramanian, Sophia Yang, Szymon Antoniak, Teven Le Scao, Th´eophile Gervet, Thibaut Lavril, Thomas Wang, Timoth´ee Lacroix, and William El Sayed. Mixtral of experts, 2024.

- [KMH+20] Jared Kaplan, Sam McCandlish, Tom Henighan, Tom B Brown, Benjamin Chess, Rewon Child, Scott Gray, Alec Radford, Jeffrey Wu, and Dario Amodei. Scaling laws for neural language models. arXiv preprint arXiv:2001.08361, 2020.

- [LBE+23] Yuanzhi Li, S´ebastien Bubeck, Ronen Eldan, Allie Del Giorno, Suriya Gunasekar, and Yin Tat Lee. Textbooks are all you need ii: phi-1.5 technical report. arXiv preprint arXiv:2309.05463, 2023.

- [LHE22] Stephanie Lin, Jacob Hilton, and Owain Evans. Truthfulqa: Measuring how models mimic human falsehoods, 2022.

- [MCKS18] Todor Mihaylov, Peter Clark, Tushar Khot, and Ashish Sabharwal. Can a suit of armor conduct electricity? a new dataset for open book question answering, 2018.

- [MRB+23] Niklas Muennighoff, Alexander M Rush, Boaz Barak, Teven Le Scao, Aleksandra Piktus, Nouamane Tazi, Sampo Pyysalo, Thomas Wolf, and Colin Raffel. Scaling data-constrained language models. arXiv preprint arXiv:2305.16264, 2023.

- [NWD+20] Yixin Nie, Adina Williams, Emily Dinan, Mohit Bansal, Jason Weston, and Douwe Kiela. Adversarial nli: A new benchmark for natural language understanding, 2020.

- [RHS+23] David Rein, Betty Li Hou, Asa Cooper Stickland, Jackson Petty, Richard Yuanzhe Pang, Julien Dirani, Julian Michael, and Samuel R. Bowman. Gpqa: A graduate-level google-proof q&a benchmark, 2023.

- [RWC+19] Alec Radford, Jeffrey Wu, Rewon Child, David Luan, Dario Amodei, and Ilya Sutskever. Language models are unsupervised multitask learners. OpenAI blog, 1(8):9, 2019.

- [SLBBC19] Keisuke Sakaguchi, Ronan Le Bras, Chandra Bhagavatula, and Yejin Choi. Winogrande: An adversarial winograd schema challenge at scale. arXiv preprint arXiv:1907.10641, 2019.

- [SRR+22] Aarohi Srivastava, Abhinav Rastogi, Abhishek Rao, Abu Awal Md Shoeb, Abubakar Abid, Adam Fisch, Adam R Brown, Adam Santoro, Aditya Gupta, Adria Garriga-Alonso, et al. Beyond the imitation game: Quantifying and extrapolating the capabilities of language models. arXiv preprint arXiv:2206.04615, 2022.

- [SSS+22] Mirac Suzgun, Nathan Scales, Nathanael Sch¨arli, Sebastian Gehrmann, Yi Tay, Hyung Won Chung, Aakanksha Chowdhery, Quoc V. Le, Ed H. Chi, Denny Zhou, and Jason Wei. Challenging big-bench tasks and whether chain-of-thought can solve them, 2022.

- [THLB19] Alon Talmor, Jonathan Herzig, Nicholas Lourie, and Jonathan Berant. Commonsenseqa: A question answering challenge targeting commonsense knowledge, 2019.

- [TLI+23] Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timoth´ee Lacroix, Baptiste Roziere, Naman Goyal, Eric Hambro, Faisal Azhar, Aurelien Rodriguez, Armand Joulin, Edouard Grave, and Guillaume Lample. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971, 2023.

- [TMH+24] Gemma Team, Thomas Mesnard, Cassidy Hardin, Robert Dadashi, Surya Bhupatiraju, Shreya Pathak, Laurent Sifre, Morgane Rivi`ere, Mihir Sanjay Kale, Juliette Love, et al. Gemma: Open models based on gemini research and technology, 2024.

- [VSP+17] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, L ukasz Kaiser, and Illia Polosukhin. Attention is all you need. In Advances in Neural Information Processing Systems, volume 30, 2017.

- [ZCG+23] Wanjun Zhong, Ruixiang Cui, Yiduo Guo, Yaobo Liang, Shuai Lu, Yanlin Wang, Amin Saied, Weizhu Chen, and Nan Duan. Agieval: A human-centric benchmark for evaluating foundation models, 2023.

- [ZCS+23] Lianmin Zheng, Wei-Lin Chiang, Ying Sheng, Siyuan Zhuang, Zhanghao Wu, Yonghao Zhuang, Zi Lin, Zhuohan Li, Dacheng Li, Eric Xing, et al. Judging llm-as-a-judge with mt-bench and chatbot arena. arXiv preprint arXiv:2306.05685, 2023.

- [ZHB+19] Rowan Zellers, Ari Holtzman, Yonatan Bisk, Ali Farhadi, and Yejin Choi. Hellaswag: Can a machine really finish your sentence? In Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, pages 4791–4800, 2019.

付録A:Example prompt for benchmarks(ベンチマークのプロンプト例)

参考:Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの解説動画

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの解説動画です.

まとめ

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phoneの日本語訳を紹介しました.

MicrosoftのPhi-3がわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.