Language models can explain neurons in language modelsの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Language models can explain neurons in language modelsの日本語訳を紹介します.

OpenAIの「言語モデルのニューロンを言語モデルで説明できる」という主張がわかります.

※図表を含む論文の著作権はLanguage models can explain neurons in language modelsの著者に帰属します.

論文中に章番号はないですが,わかりやすくするためにLanguage models can explain neurons in language modelsの目次は以下のように設定しました.

※概要はありません.

- 1章:Introduction

- 2章:Methods

- 3章:Results

- 4章:Discussion

- References

Language models can explain neurons in language modelsを解説しつつ,私の考えも語ります.

私の日本語訳の注意点は以下になります.

- 本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Contributions」(貢献)と「Acknowledgements」(謝辞)は省略していること

- 本文中に登場する表記「[1]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Language models can explain neurons in language modelsの本文を読みすすめましょう!

目次

1章:Introduction(はじめに)

言語モデルはより高性能になり,より広くデプロイされるようになったが,その仕組みは理解されていない.

最近の研究では,少数の回路や狭い動作の理解は進んでいるが[1][2],言語モデルを完全に理解するには,数百万のニューロンを分析する必要がある.

本論文では,大規模な言語モデルのすべてのニューロンに対して解釈可能性技術を拡張する問題に,自動化を適用する.

解釈可能性を自動化するこのアプローチ[3][4][5]を基に,デプロイ前のモデルの安全性を包括的に監査できるようになることが期待される.

我々の技術は,テキスト中のどのようなパターン[6][7]がニューロンの活性化を引き起こすかをExplanationしようとするものである.

※訳注:「Explanation」は日本語では「説明」の意味ですが,Explainable AI(説明可能なAI)の指標として利用されるため,本記事では専門用語として「Explanation」と表記します.

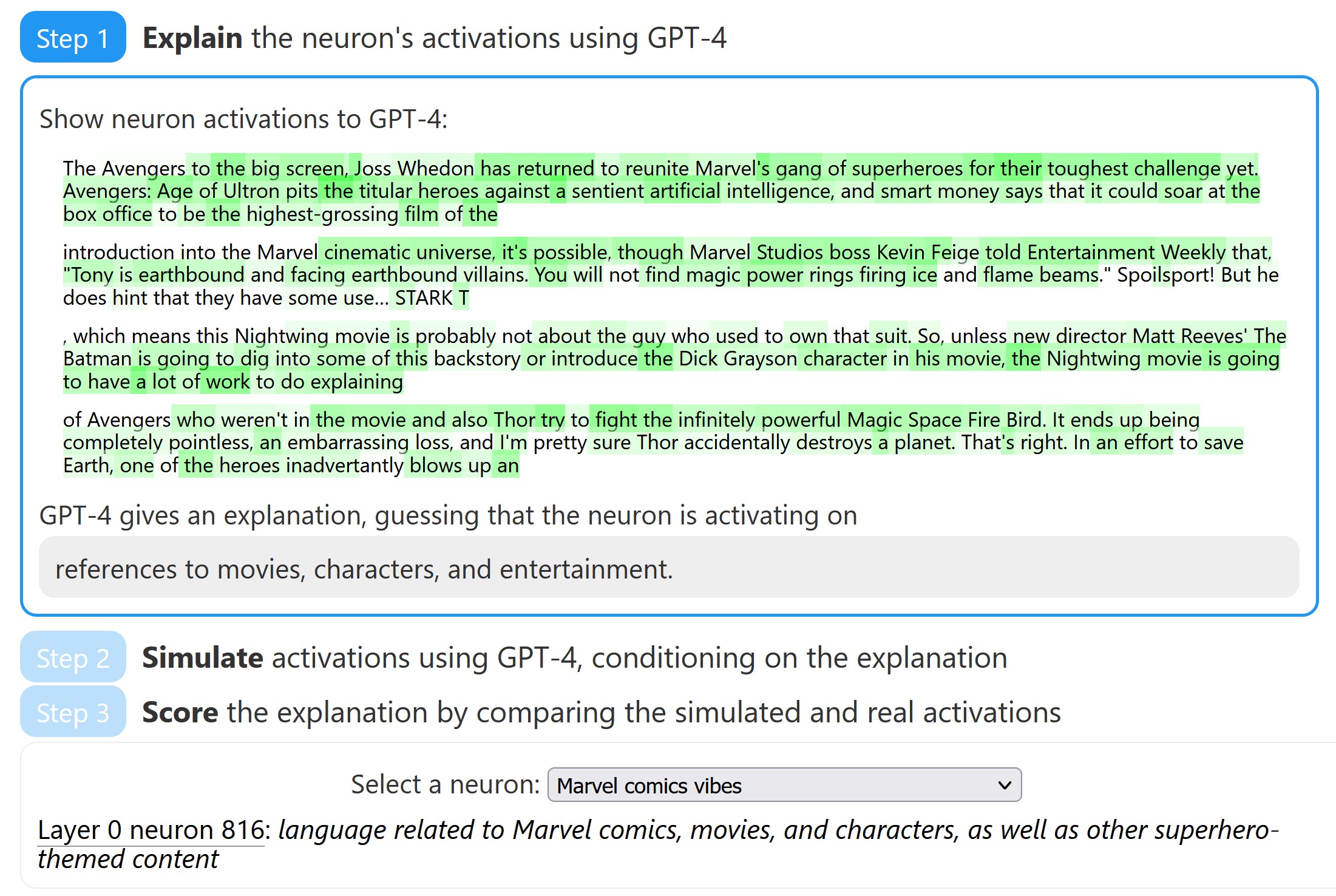

以下の3つのステップで構成されている.

- GPT-4を用いたニューロンの活性化についてExplanationする.

- Explanationの条件付けを行い,GPT-4を使って活性化をシミュレーションする.

- シミュレーションと実際の活性化を比較することで,Explanationをスコアする.

※訳注:原文のWebサイトのデモを実際に使ってみましょう!

この技術により,GPT-4[8]を活用して,「Explanationスコア」(説明スコア)と呼ぶ解釈可能性の定量的概念[9][10]を定義し,自動的に測定することができる.

これは,自然言語を用いてニューロンの活性化を圧縮・再構成する言語モデルの能力を示す指標である[11].

このフレームワークは定量的であるため,ニューラルネットワークの計算を人間に理解できるようにするという目標に対する進捗を測定することができる.

ベースラインの方法論では,Explanationsは人間のコントラクターの性能のレベルに近いスコアが得られている.

我々は,以下の方法で性能をさらに向上できることを発見した.

- Explanationsの繰り返し.GPT-4に反例となりそうなものを出してもらい,その活性化を踏まえてExplanationsを改訂してもらった.

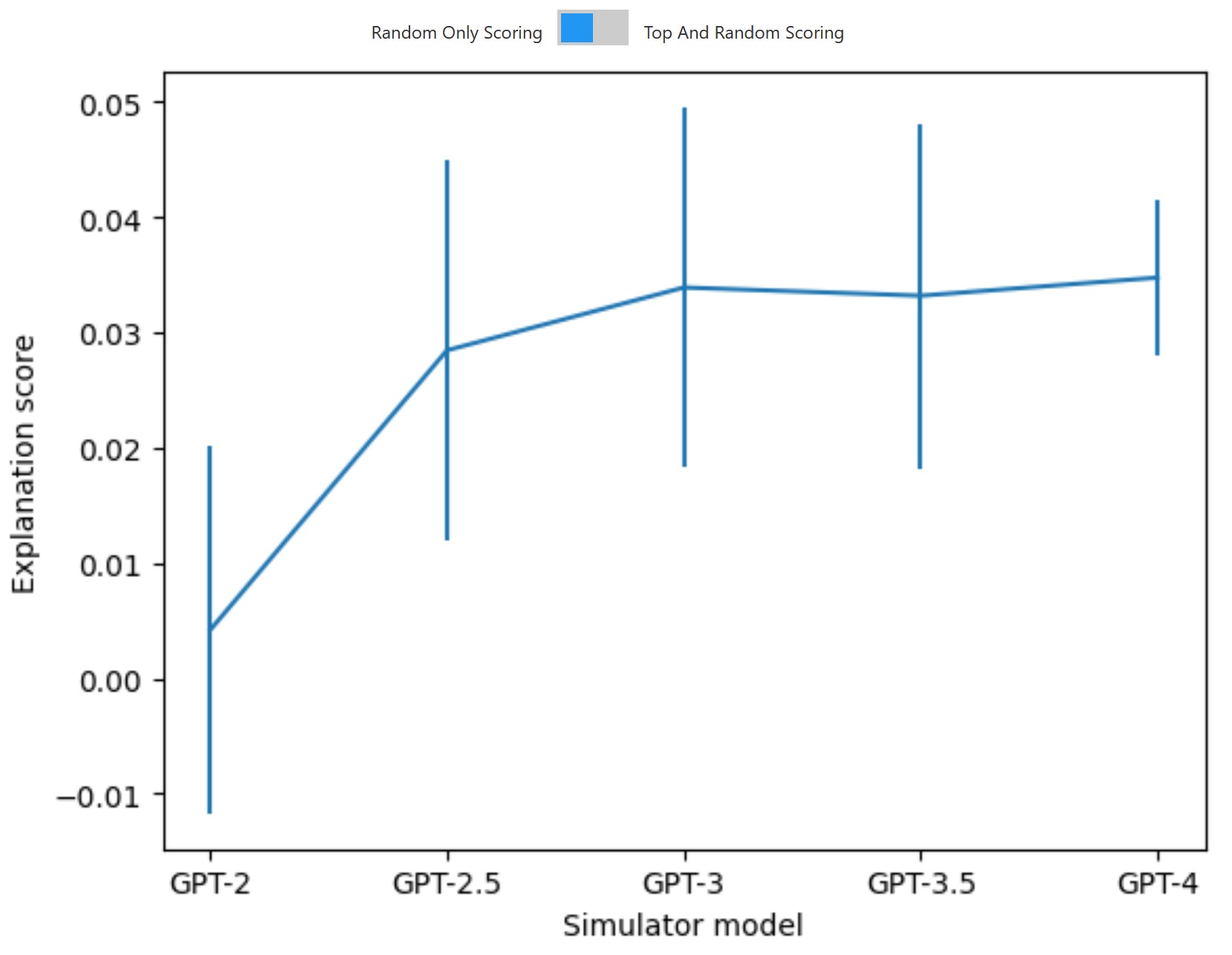

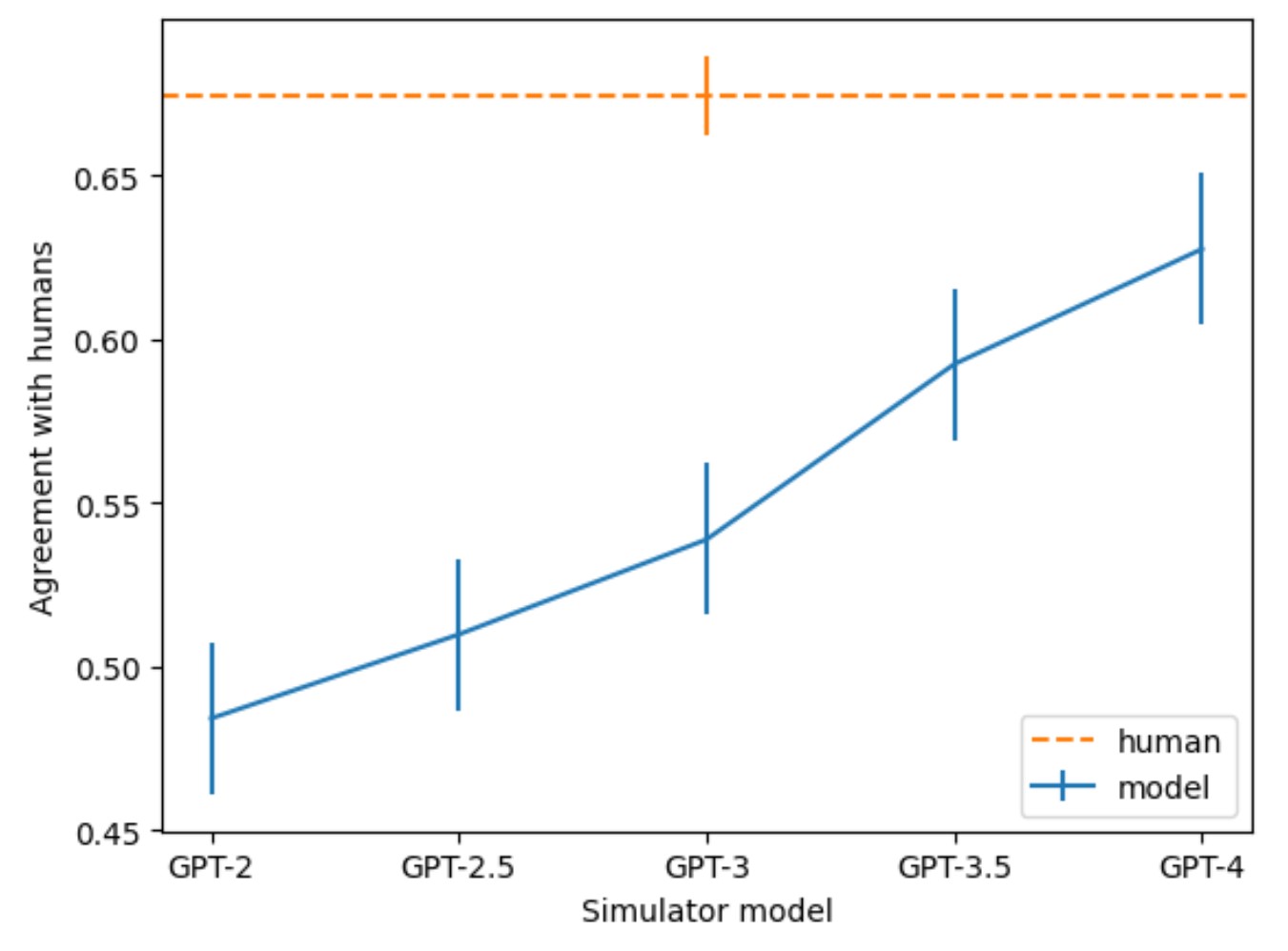

- より高性能なモデルを使ってExplanationsを与える.Explainerモデルの能力が高いほど平均点が上がり,GPT-4が最も高い点数を獲得している.

- より高性能なモデルを使って,Explanationの条件となる活性化をシミュレーションする.シミュレータモデルの能力が高いほど,平均スコアと人間との比較の一致度が高くなり,GPT-4が最も高いスコアを獲得している.

しかし,GPT-4ベースのExplanationsも,人間のコントラクターのExplanationsも,絶対値ではまだスコアが低いことがわかった.

また,ニューロンを見ると,典型的なニューロンはかなり多義的に見えることがわかった.

これは,Explanationsする内容を変えるべきことを示唆している.

予備実験では,次のようなことを試みた.

- Explainerモデルのアーキテクチャを変更する.異なる活性化関数で訓練させたモデルで,より高いExplanationスコアを達成した[12].

- よりExplainableな方向性を探す.スコアの直接最適化に関する予備的な調査から,いくつかのよくExplanationsできるニューロンの線形結合を見つけられることがわかった.

GPT-2 XLのすべてのMLPニューロンに本手法を適用した[13].

GPT-4によると,少なくとも0.8をスコアしたExplanationsであり,ニューロンのトップ活性化行動のほとんどを解説していることを意味する1,000以上のニューロンを発見した.

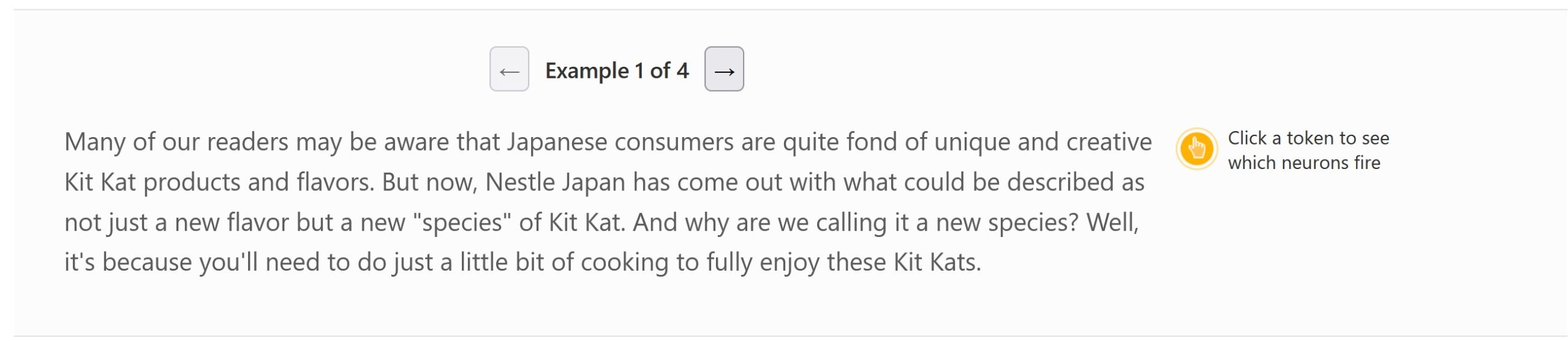

これらのExplanationsを用いて,モデルを理解するための新しいユーザインターフェースを構築した[14][15][16].

例えば,特定のデータセット例でどのニューロンが活性化し,それらのニューロンが何を行うかを素早く確認することができる.

※訳注:原文のWebサイトのデモを実際に使ってみましょう!

GPT-2 XLの全ニューロンに対するExplanationsのデータセット,Explanationのためのコードやスコアをオープンソース化し,より良いExplanationsを生み出すための研究を促進する.

また,このデータセットを利用したニューロンビューアも公開する.

よくExplanationsされたニューロンの多くはあまり面白くないが,GPT-4が理解できなかった多くの興味深いニューロンを発見した.

これにより,我々の研究の上に他の人がより簡単に構築できるようになることを期待している.

今後,より良いExplanationsとツールがあれば,モデル計算の興味深い定性的理解を素早く発見できるようになるかもしれない.

2章:Methods(方法)

2.1節:Setting(設定)

我々の方法論では,複数の言語モデルを使用する.

- 対象モデル(Subject Model)は,我々が解釈しようとするモデルである.

- 説明者モデル(Explainer Model)は,対象モデルの行動に関する仮説を考え出す.

※対象とExplainerは同じモデルでも構わないが,我々の実験では通常,より小さなモデルを対象として使い,最も強いモデルをExplainerとして使っている.長期的には,対象が最強のモデルであっても,それをアシスタントとして信頼しない場合は,状況が反転する可能性がある. - シミュレータモデル(Simulator Model)は,仮説に基づき予測を行う.予測が現実にどれだけ合致しているかで,仮説の質を判断することができる.シミュレータモデルは,理想化された人間と同じように仮説を解釈する必要がある.

※したがって,ExplainerモデルはRLを使って(シミュレータモデルを訓練信号として)できるだけ役に立つように訓練する必要があるが,シミュレータは人間を模倣するように訓練する必要がある.もしシミュレータモデルが人間が反対するような予測をすることで性能を向上させた場合,Explanationsが人間に理解されなくなる危険性がある.

本論文では,中間層の活性化関数と相関のあるテキスト入力の特性を特定するという最も簡単なケースから始めることにする[17][18][19].

最終的には,この方法を拡張して,対象モデルの計算に関する任意の仮説を探索したいと考えている.

言語モデルの場合,入力はテキストパッセージである.

中間層の活性化関数については,MLP層のニューロンに注目する.

本論文の残りの部分では,活性化とは,\(a = f(W_{in} \cdot x + b)\)として計算されたMLPの活性化後の値を指す.

ここでfは非線形活性化関数(特にGPT-2のGELU[20])である.

そして,ニューロンの活性化は,\(a \cdot W_{out}\)を追加することによって残差ストリームを更新するために使用される.

あるニューロンについて仮説的なExplanationがある場合,その仮説は,その特性を持つトークンでニューロンが活性化するというもので,その特性には文脈として前のトークンが含まれることもある.

2.2節:Overall algorithm(全体のアルゴリズム)

高レベルには,我々のニューロン解釈のプロセスは,以下のアルゴリズムを使用する.

- 説明する(Explain):テキスト抜粋に対するニューロンの反応から,Explainerモデル(トークン,活性化)のペアを示すことで,ニューロンの動作のExplanationを生成する.

- シミュレーションする(Simulate):シミュレータのモデルを使い,Explanationに基づいてニューロンの活性化をシミュレーションする.

- スコアをする(Score):シミュレーションされた活性化と実際の活性化の一致度合いに基づいて,Explanationを自動的にスコアする.

Explanationの生成とシミュレーションには,常に別々のドキュメントを使用している.

※しかし,得られたテキストの抜粋が重なっていないことを明示的に確認することはしなかった.原理的には,訓練セットにおける対象モデルの動作の大部分を駆動する程度に,Explanationが動作を「記憶」することは合理的だが,それがハイスコアの主な要因であるとすれば,あまり興味深いことではない.テキストを抜粋した簡単なチェックによると,少なくとも99.8%のニューロンでは,この問題はなかった.

Explanationsの生成,ニューロンのシミュレーション,Explanationsのスコアを行うコードは,こちらで公開している.

step

1ニューロンの動作のExplanationsを生成する

このステップでは,ニューロンの動作に関する1つまたは複数のExplanationsを生成するために,Explainerモデルに送信されるプロンプトを作成する.

プロンプトは,他の実際のニューロンのfew-shot例と,テキストの抜粋と研究者が書いたExplanationsのタブ区切り(トークン,活性化)のペアで構成されている.

最後に,few-shot例には,解釈されるニューロンに関するテキストの抜粋からタブ区切られた(トークン,活性化)のペアが含まれている.

※すべてのプロンプトは省略された形式で表示され,構造化チャット補完APIを使用する場合は多少修正される.詳細については,コードベースを参照されたい.

Explanation生成プロンプトの省略版は以下になる.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 |

We're studying neurons in a neural network. Each neuron looks for some particular thing in a short document. Look at the parts of the document the neuron activates for and summarize in a single sentence what the neuron is looking for. Don't list examples of words. The activation format is token<tab>activation. Activation values range from 0 to 10. A neuron finding what it's looking for is represented by a non-zero activation value. The higher the activation value, the stronger the match. Neuron 1 Activations: <start> the 0 sense 0 of 0 together 3 ness 7 in 0 our 0 town 1 is 0 strong 0 . 0 <end> <start> [prompt truncated …] <end> Same activations, but with all zeros filtered out: <start> together 3 ness 7 town 1 <end> <start> [prompt truncated …] <end> Explanation of neuron 1 behavior: the main thing this neuron does is find phrases related to community [prompt truncated …] Neuron 4 Activations: <start> Esc 0 aping 9 the 4 studio 0 , 0 Pic 0 col 0 i 0 is 0 warmly 0 affecting 3 <end> <start> [prompt truncated …] <end> Same activations, but with all zeros filtered out: <start> aping 9 the 4 affecting 3 <end> <start> [prompt truncated …] <end> [prompt truncated …] Explanation of neuron 4 behavior: the main thing this neuron does is find |

活性化は0~10のスケールで正規化され,負の活性化を0,そのニューロンで観測された最大の活性化を10とする整数値に離散化される.

ニューロンの活性化がまばらなシーケンス(非ゼロが20%未満)では,トークンの全リストの後に非ゼロの活性化を持つトークンと活性化のペアを追加で繰り返し,モデルが関連するトークンに集中するのを助けることが有用であることがわかった.

step

2Explanationsを使ってニューロンの動作をシミュレーションする

この方法では,提案されたExplanationがニューロンの動作を正確かつ包括的にExplanationすると仮定した場合,特定のシーケンスの各トークンに対してそのニューロンがどのように活性化するかという疑問に答えることを目的としている.

そのために,シミュレータモデルを用いて,提案されたExplanationを条件として,各対象モデルのトークンに対するニューロンの活性化をシミュレーションする.

各対象モデルのトークンに対して,0~10の整数を出力するようシミュレータモデルに促す.

予測された各活性化位置について,各数値("0","1",...,"10")に割り当てられた確率を調べ,それらを用いて出力の期待値を計算する.

その結果,シミュレーションされたニューロンの値は,[0, 10]のスケールで表示される.

我々の最もシンプルな方法は,「one at a time」(一度に一つずつ)と呼ばれる方法である.

プロンプトはいくつかのfew-shot例と,個々のトークンの起動を予測するsingle-shot例で構成されている.

「one at a time」プロンプトの省略版は以下になる.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 |

We're studying neurons in a neural network. Each neuron looks for some particular thing in a short document. Look at an explanation of what the neuron does, and try to predict its activations on a particular token. The activation format is token<tab>activation, and activations range from 0 to 10. Most activations will be 0. Neuron 1 Explanation of neuron 1 behavior: the main thing this neuron does is find phrases related to community Activations: <start> the 0 sense 0 of 0 together 3 ness 7 in 0 our 0 town 1 is 0 strong 0 . 0 <end> <start> [prompt truncated …] Neuron 4 Explanation of neuron 4 behavior: the main thing this neuron does is find present tense verbs ending in 'ing' Text: Starting from a position of Last token in the text: of Last token activation, considering the token in the context in which it appeared in the text: |

残念ながら,「one at a time」方式では,シミュレーションされたトークンごとに1回のフォワードパスが必要なため,かなり時間がかかる.

我々は,活性化がシーケンスのランダムな位置で「unknown」(未知)から「実際の値」に切り替わるfew-shot例を用意することで,すべてのトークンにわたる確率予測を並列化するトリックを使用する.

このようにすると,「unknown」トークンのlogprobsを調べてモデル予測を引き出す一方で,コンテキストに「unknown」を含むニューロンをシミュレーションすることができ,モデルが関連ニューロンの実際の活性化を観察することはない.

これを「all at once」方式と呼ぶ.

「all at once」プロンプトの省略版は以下になる.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 |

We're studying neurons in a neural network. Each neuron looks for some particular thing in a short document. Look at an explanation of what the neuron does, and try to predict how it will fire on each token. The activation format is token<tab>activation, activations go from 0 to 10, "unknown" indicates an unknown activation. Most activations will be 0. Neuron 1 Explanation of neuron 1 behavior: the main thing this neuron does is find phrases related to community Activations: <start> the unknown sense unknown of 0 together 3 ness 7 in 0 our 0 town 1 is 0 strong 0 . 0 <end> <start> [prompt truncated …] <end> [prompt truncated …] Neuron 4 Explanation of neuron 4 behavior: the main thing this neuron does is find present tense verbs ending in 'ing' Activations: <start> Star unknown ting unknown from unknown a unknown position unknown of unknown strength unknown <end> |

速度の優位性から,本論文の残りの部分では,小規模な定性的な結果の一部を除き,「all at once」スコアを使用している.

※今回の実験ではGPT-4をシミュレータモデルとして使用したが,GPT-4やGPT-3.5-turboのような新しいチャットベースのモデルのlogprobsを返すことは,OpenAI公開APIではサポートされていない.オリジナルのGPT-3.5のような古いモデルはlogprobsをサポートしている.

より高速になったことに加え,「all at once」方式で計算されたスコアは,「one at a time」方式と同程度の正解率で,Explanations間の人間の好みを予測することができることが明らかになった.

※「all at once」は,「one at a time」を実際に上回ったが,その効果はノイズの範囲内であり,研究者は比較的小さなサンプルサイズで,主観的に「one at a time」が良いと考えた.

step

3シミュレーションと実際のニューロン動作を比較して,Explanationsをスコアする

概念的には,Explanationとシミュレーションの戦略が与えられ,我々はsimulated neuronを,任意のテキスト抜粋に対する活性化を予測することができる「ニューロン」とする.

Explanationをスコアするには,このシミュレーションされたニューロンを,そのExplanationが生成された実際のニューロンと比較する.

つまり,以下の2つの値のリストを比較する.

- 複数のテキスト抜粋に対するExplanationでシミュレーションされた活性化

- 同じテキスト抜粋に対する実ニューロンの実際の活性化

概念的に簡単な方法は,全トークンにおいて,シミュレーションされた活性化による真の活性化のExplained Variance(説明分散)を使用することである.

すなわち,\(1 - \frac{\mathbb{E}_t[(s(t) - a(t))^2]}{\mathrm{Var}_t(a(t))}\)を計算できる.

ここでs(t)はExplanationを受けたシミュレーションされた活性化を, a(t)は真の活性化を示し,期待値は選択したテキスト抽出の全トークンにわたる.

※分母にもサンプルを使っているため,これは真の説明分散の不偏推定値ではないことに注意されたい.分散項を推定するためにもっと大きなサンプルを使用することで,我々のアプローチを改善することができる.

しかし,我々がシミュレーションした活性化は[0, 10]のスケールであり,実際の活性化はある任意の分布を持つことになる.

したがって,シミュレーションされたニューロンの活性化分布を,実際のニューロンの分布にキャリブレーションする能力を想定している.

我々は,スコアされるテキスト抜粋に対して,単純に線形にキャリブレーションすることを選択した.

※キャリブレーションを行うために,より複雑な方法を検討したが,一般的に多くのシミュレーションが必要であり,入手にはコストがかかる.

※概念的には,キャリブレーションは理想的には異なるテキストの抜粋セットで行われるべきで,真の平均と分散を使用することで「不正」(cheating)をしているわけではない.我々は,異なるサンプルサイズについてこの不正行為の効果を経験的に研究し,実際には小さいと信じている.

真の活性化とシミュレーションされた活性化の相関係数を\(\rho\)とすると,シミュレーションの平均が真の活性化と一致し,標準偏差が真の活性化の標準偏差の\(\rho\)倍となるようにシミュレーションする.

これにより,説明分散の最大値は\(\rho^2\)となる.

※標準偏差を合わせることで,説明分散は\(2 \rho - 1 < \rho^2\)となっている.また,アブレーションに基づくスコアでは,より悪い結果が得られることが経験的に分かっている.

このため,我々の主なスコア方法である相関スコアは,単に\(\rho\)を報告するだけでよいことになる.

シミュレーションされたニューロンが実際のニューロンと同じように振る舞う場合,スコアは1であることに注意されたい.

シミュレーションされたニューロンの挙動がランダムな場合,例えば,Explanationがニューロンの挙動と無関係な場合,スコアは0前後になる傾向がある.

アブレーションスコアに対する検証

ネットワークを理解するもう一つの方法は,フォワードパス中にその内部値に摂動(perturb)を与え,その影響を観察することである[21][22][10].

これは,実ニューロンをシミュレーションされたニューロンに置き換え(つまり,その活性化をシミュレーションされた活性化にアブレーションし),ネットワークの挙動が保たれているかどうかをチェックするという,より高価なスコアのアプローチを示唆している.

アブレーションからシミュレーションへの行動変化の程度を測定するために,すべてのトークンにわたって平均化された摂動モデルとオリジナルモデルの出力logprobs間のJensen-Shannon divergenceを使用する.

比較のためのベースラインとして,2回目の摂動を行い,ニューロンの活性化を全トークンの平均値になるようにアブレーションした.

各ニューロンについて,シミュレーションに対するアブレーションの発散を,平均値に対するアブレーションの発散で正規化する.

したがって,アブレーションスコアを\(1 - \frac{\mathbb{E}_x[\textrm{AvgJSD}(m(x, n=s(x))) || m(x))]}{\mathbb{E}_x[\textrm{AvgJSD}(m(x, n=\mu) || m(x))]}\)のように表現する.

ここで,\(m(x, n=\ldots)\)は,ニューロンを除去したテキスト抜粋xに対してモデルを実行し,各トークンにおける予測分布を返すことを示す.

\(\textrm{AvgJSD}\)は各トークンでのJensen-Shannon divergencesをとって平均し,s(x)はシーケンス上のシミュレーションされたニューロン値の線形キャリブレーションベクトル,\(\mu\)は全トークンでのニューロンの平均活性化である.

なお,このアブレーションスコアは,相関スコアと同様に,偶然性があれば0.0,完全性があれば1.0となる.

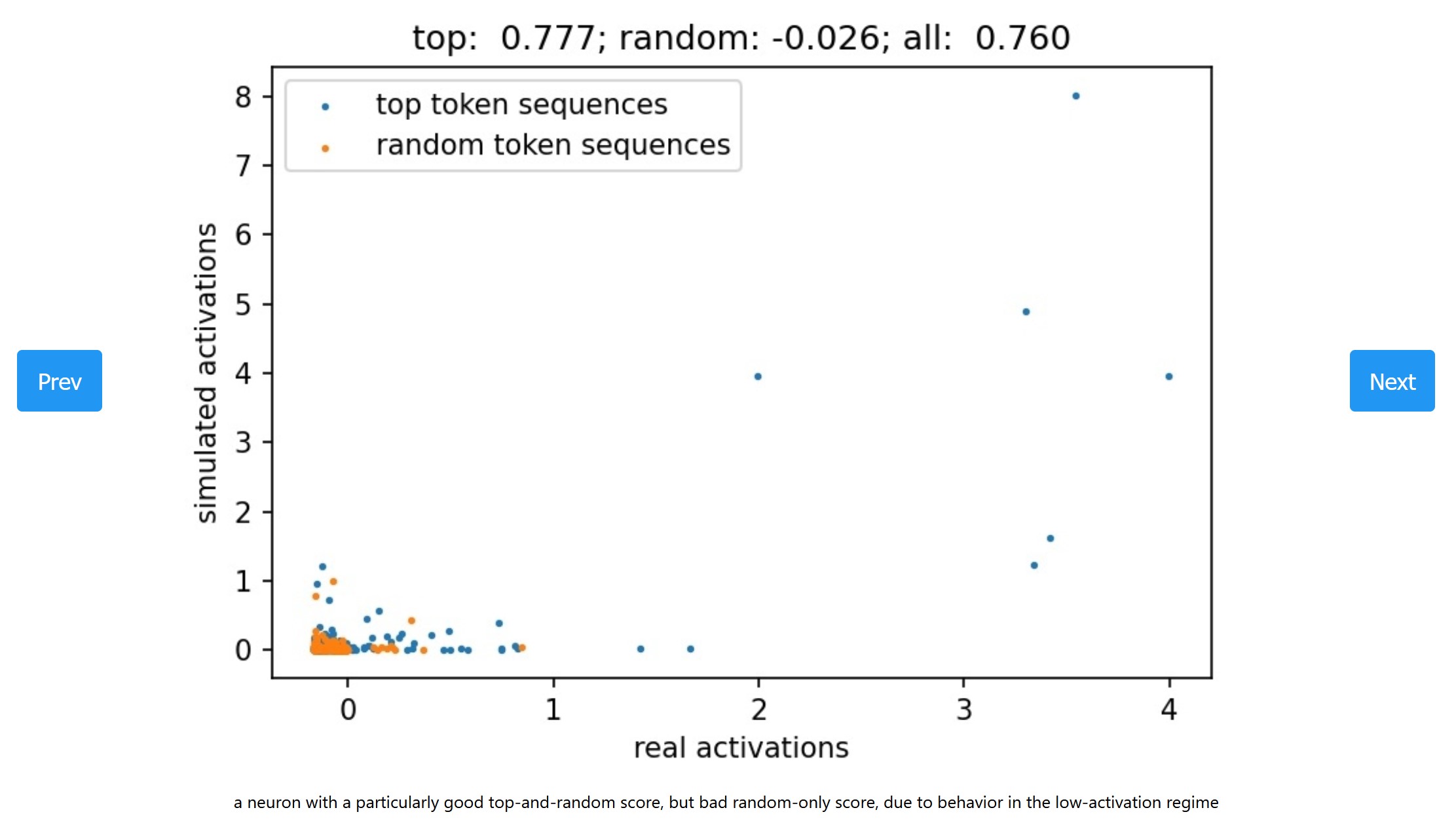

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

相関スコアとアブレーションスコアは,平均して明確な関係を持つことがわかった.

したがって,本論文の残りの部分では,計算がより簡単な相関スコアを用いることにする.

しかし,相関スコアは,アブレーションスコアによって明らかになったシミュレーションされたExplanationsの欠点をすべて捉えているわけではないようである.

特に,相関スコアが0.9であっても,平均して比較的低いアブレーションスコアになる(random-onlyのテキスト抜粋に対するスコアでは0.3,top-and-randomでは0.6,テキスト抜粋の選択方法については後述).

※これは,あるニューロンの活性化の微妙な変化(例えば,相関スコアが0.9と1.0の違い)が,ネットワーク内での機能において大きな役割を果たす場合に起こるかもしれない.

人間のスコアに対する検証

シミュレーションベースのスコアが,実際には人間のExplanationsに対する評価を反映していないという心配がある(詳しくはこちらを参照されたい).

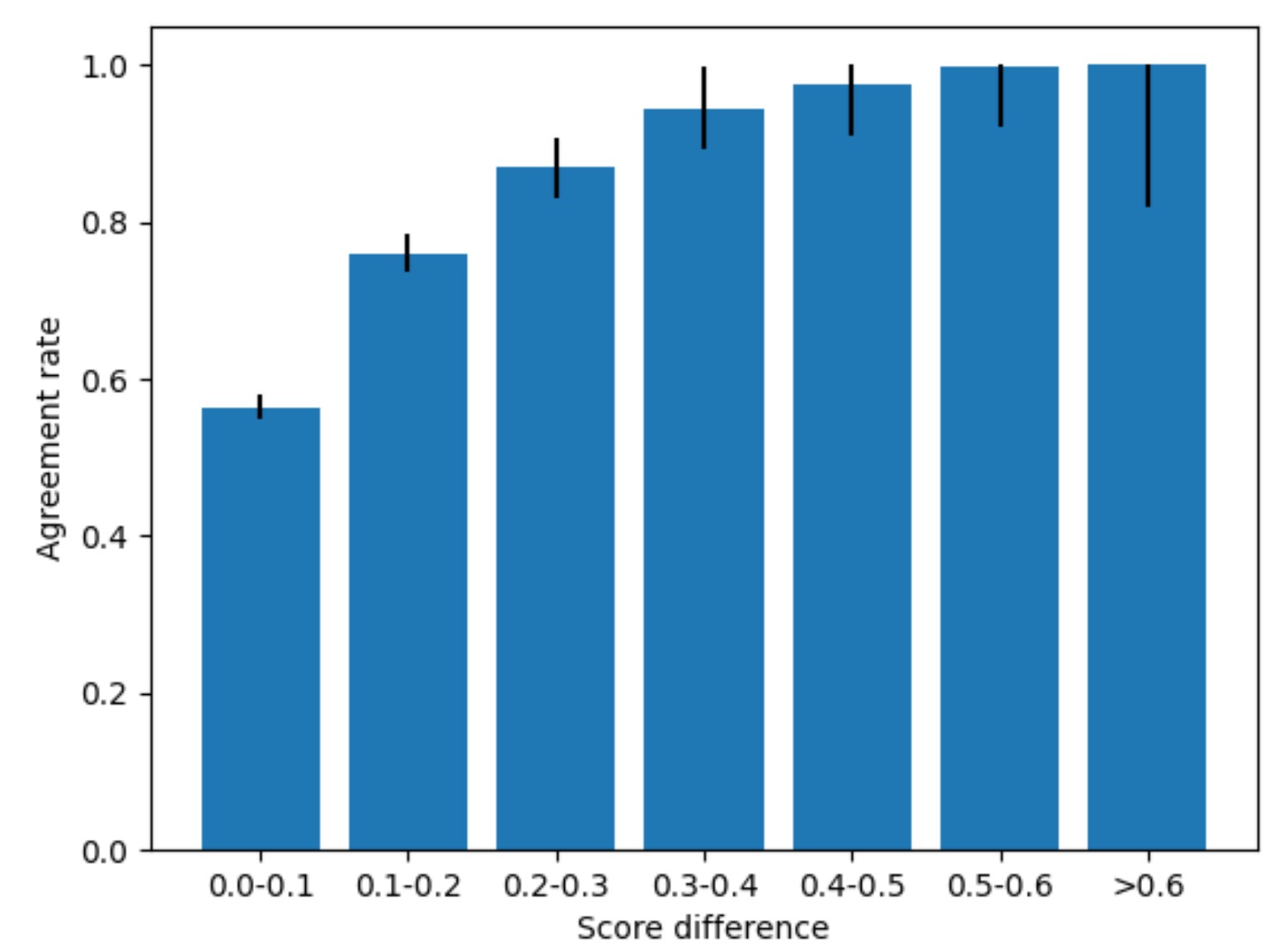

我々は,Explanationの質に関する人間の評価を集め,それがスコアベースの評価と一致するかどうかを確認した.

人間のラベラーに,シミュレータモデル(トップ活性化,ランダムともに)と同じテキスト抜粋と活性化(カラーハイライトで表示)を見てもらい,それらのExplanationsが活性化パターンをどれだけよく捉えているかを基準に,5つの提案されたExplanationsを評価し,ランク付けしてもらうタスクを行った.

ExplainerモデルのExplanationsは多様性に欠けるため,Explanation生成プロンプトで使用するfew-shot例を変えたり,Explainerモデルに1回の入力で可能なExplanationsの番号付きリストを求めたりする修正プロンプトを使用することでExplanationの多様性を向上させた.

我々の結果では,人間はロースコアのExplanationsよりもハイスコアのExplanationsを好む傾向があり,その一貫性はスコア差が大きくなるにつれて高くなることがわかった.

アルゴリズムのパラメータと詳細

本研究では,特に指定がない限り,対象モデルとしてGPT-2事前訓練済みモデルを使用し,ExplainerモデルとシミュレータモデルにはGPT-4を使用している.

※GPT-4はGPT-2とは異なり,RLHFによる命令に従うように訓練されたモデルである[23].

Explanationsの生成とシミュレーションの両方において,対象モデルの事前訓練データセット(GPT-2モデルの場合はWebTextなど)の訓練分割からテキストを抜粋する.

文書の64個のトークンが連続する部分をランダムに選び,文書の境界を越えないという例外を除いて,モデルの訓練方法と同じフォーマットでテキスト抜粋を作成する.

※なお,GPT-2はバイトペアエンコーダを使用しているため,テキストに文字化けが発生することがある.詳しくはこちらを参照されたい.

※GPT-2は,特別なテキスト終了トークンで区切られた複数のドキュメントを見ることができるように訓練されている.我々の研究では,64個のトークンがすべて同じ文書内にあることを保証する.

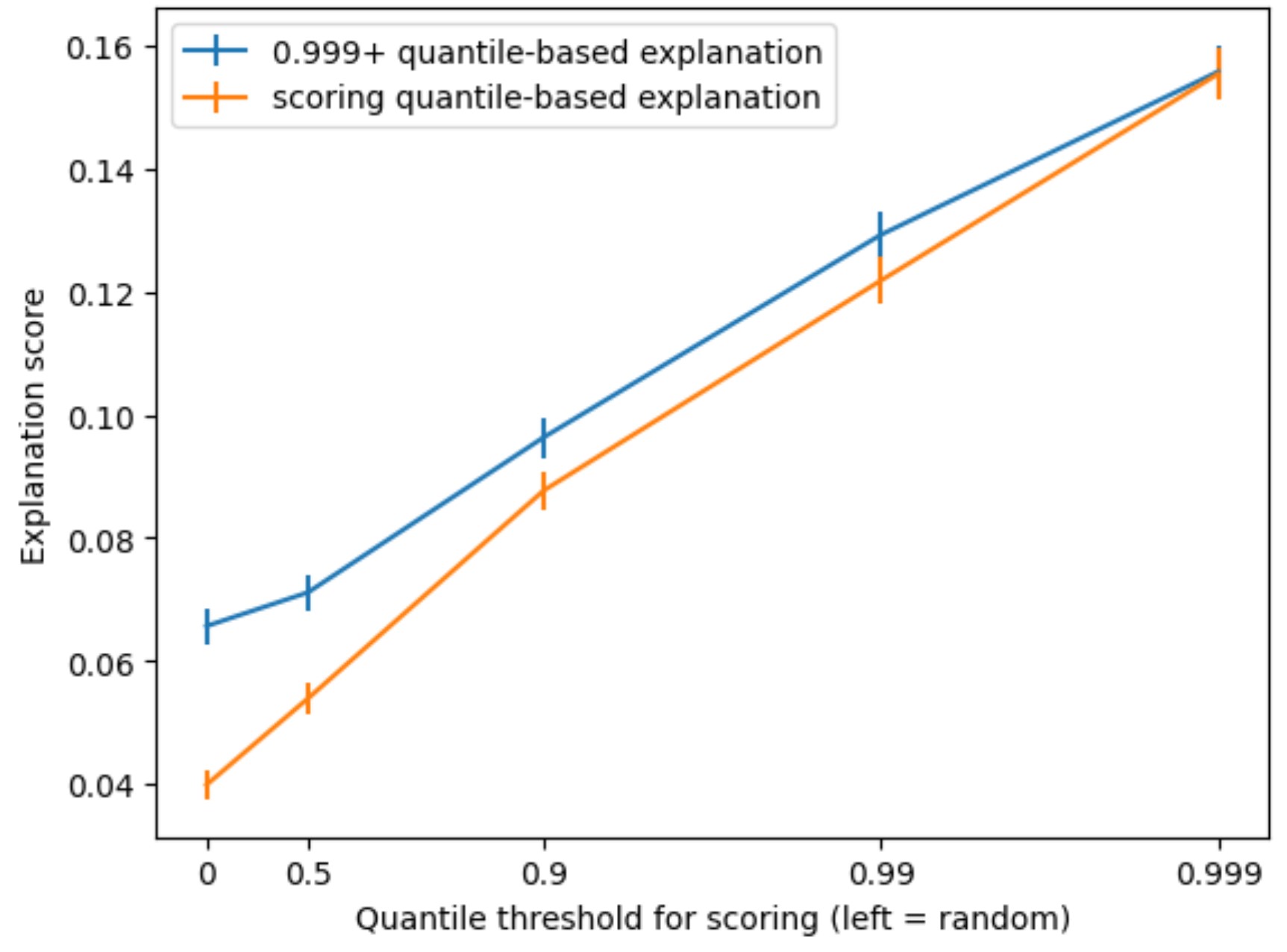

Explanationsの生成には,最大活性化のクォンタイル(quantile)で決まる活性化が極めて大きいトークンを少なくとも1つ持つ「トップ活性化」のテキストを5つ使用した.

この理由は,以下のことが経験的にわかったからである.

- Explanation生成プロンプトでトップ活性化シーケンスのみを使用した場合,ランダムシーケンスや下位クォンタイルでの活性化シーケンスに対してのみスコアした場合でも,最高のExplanationスコアを得ることができた(下図参照).実際,20,000分の1のテキストから60,000分の1のテキストに変更した場合でも,顕著な効果が見られた.

- スコアに使用するシーケンスが長くても,16~64トークンのテキスト抜粋を使用した場合に,Explanationスコアが最も高くなった.

- Explanation生成に5~10個以上のテキスト抜粋を使用しても,スコアに大きな影響はない(ただし,シーケンスの長さとの相互作用はある).

- Explanation生成プロンプトにランダムまたは下位クォンタイルのシーケンスの例を含めると,Explanationスコアが低下した.

- 最大負の活性化シーケンスの解釈も,Explanationのスコアが極端に低かった.

※GeGLU[24]のような他の活性化関数では,これは真実ではない可能性が高く,正と負の活性化を別々にExplanationする必要がある.

したがって,本論文の残りの部分では,特に断りのない限り,Explanationsは常に5つのトップ活性化シーケンスから生成される.

我々は,50,000の総シーケンスのうち,最も高い活性化を含む20のシーケンスを取り出し,0.9996のトップクォンタイルの閾値を設定した.

temperatureは1でExplanationsをサンプリングする.

シミュレーションとスコアのために,一様にランダムな5つのテキスト抜粋(「random-only」)を報告する.

random-onlyスコアは,事前訓練の分布におけるニューロンの特徴量表現を捉えるExplanationsの能力として考えることができる.

random-onlyスコアは概念的に解釈しやすいが,5つのトップ活性化と5つのランダムテキストを混合したスコア(「top-and-random」)も報告している.

top-and-randomスコアは,(トップテキストの抜粋から)ニューロンの最も強く表現された特徴量を捉えるExplanationsの能力と考えることができ,(ランダムテキストの抜粋から)過度に広いExplanationsにはペナルティが課される.

top-and-randomスコアには,random-onlyと比較して実用的な利点がいくつかある.

- ランダムなテキストを抜粋すると,分散スコアが有意に高くなる.経験的に,random-onlyスコアでうまくいくニューロンは,密に活性化するニューロンであることがわかった.ほとんどのニューロンはかなりスパースであり,多数のニューロン間の平均は有益である可能性が高いが,個々のニューロンのスコアは一般に有益ではない.

- 多義性を考慮すると[25][26],ニューロンは非常に長い/接続詞的なExplanationsを必要とする可能性がある.ある特徴に対応するニューロンであっても,他の特徴からかなりの干渉を受ける可能性がある.極端な挙動だけをExplanationsすることは,よりきれいな特徴を得るための合理的な方法であり,長期的にExplanationsすることを望むものに近いと思われる.

- 我々は,例えば,Explanationsの改訂のために敵対的に選ばれたテキストの抜粋に対してスコアをつけられるようにしたかった.一律に事前訓練を上回る解釈を維持しながらこれを行うことは,より困難だった.さらに,完全な相関(またはExplanationsされた分散)が1であっても,やはり同様の解釈をすることができる.

※長期的には,ディベート[27]のように,スコアが期待値よりもミニマックスに近いものに移行したいと考えている.つまり,あるモデルがExplanationsを考え,別のモデルが反例を考えるというイメージである.スコアでは,全体の記録を考慮することで,仮説がどれだけ頑健であるかを測ることができる.

サンプルサイズが小さいrandom-onlyスコアでは,シミュレーションで高い活性化を示したトークンと実際に高い活性化を示したトークンの両方が欠けているため,行動を捉えられない可能性があることに留意する.

top-and-randomスコアは,後者に対処するものだが,偽の高い活性化のシミュレーションよりも偽の低い活性化のシミュレーションにペナルティを与えることになるため,過度に広いExplanationsを受け入れてしまう傾向がある.

両者の長所を生かすより原則的なアプローチは,random-onlyスコアにこだわるが,random-onlyテキスト抜粋の数を増やし,分散削減戦略として重要度サンプリングを使用することである.

※残念ながら,テキスト抜粋の数を適度に増やすという最初の試みは,有用であることが証明されなかった.

以下では,ニューロンスコアのプロトタイプの例をいくつか示す.

※訳注:原文の図のPrevとNextボタンを押すとグラフが変わります!

3章:Results(結果)

解釈に関する注意事項:

本章では,若干異なる方法論(例:異なるExplainerモデル,異なるプロンプトなど)を用いて結果を得ている場合がある.

そのため,グラフ間でスコアが必ずしも比較できるわけではない.

すべてのプロットにおいて,エラーバーは平均値の95%信頼区間に相当する.

※多くの場所では,平均値の標準誤差(SEM:Standard Error of the Mean)の1.96倍,または厳密にはより保守的な統計量を用いて計算される.必要であれば,ブートストラップのリサンプリング法を用いて推定する.

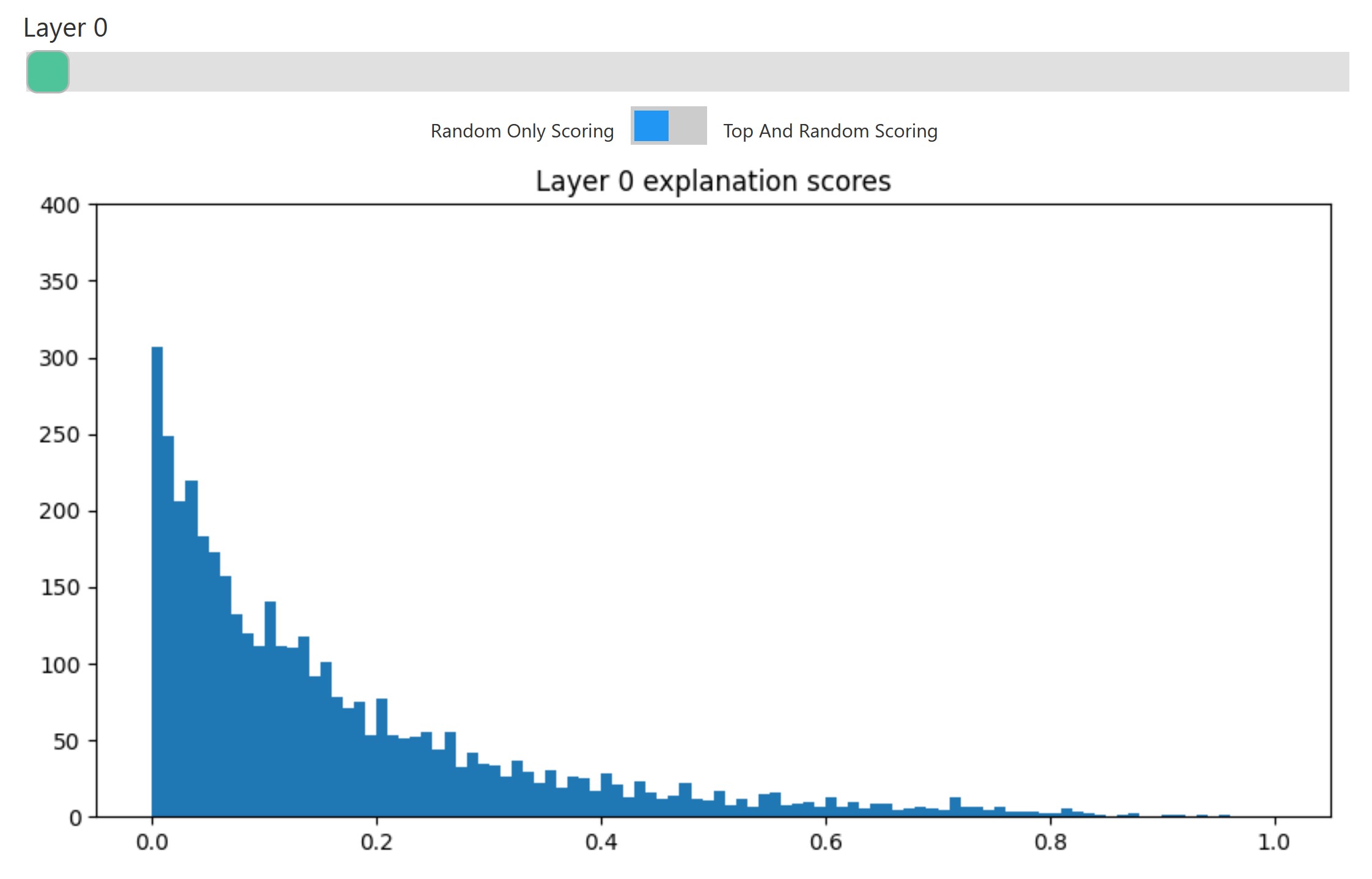

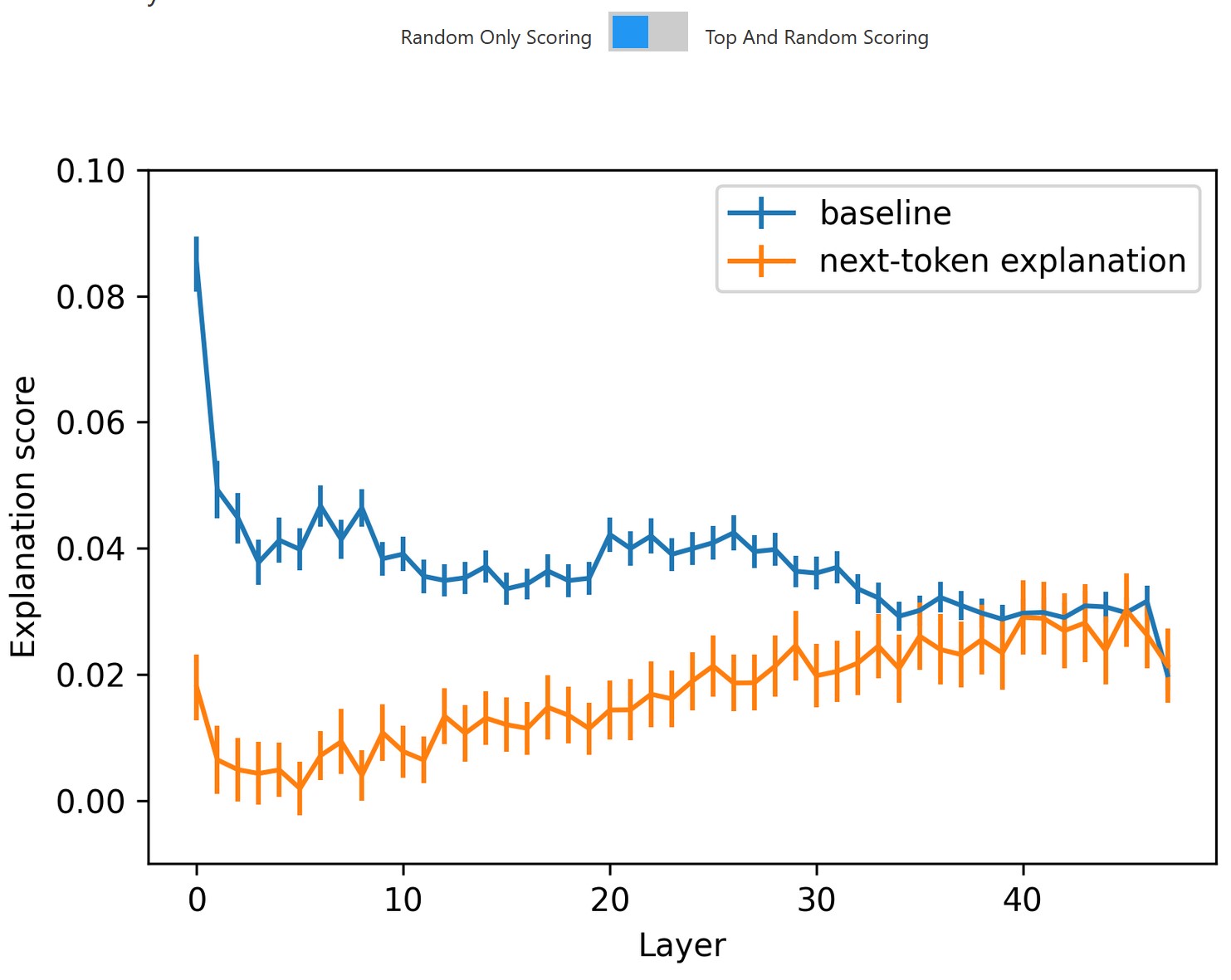

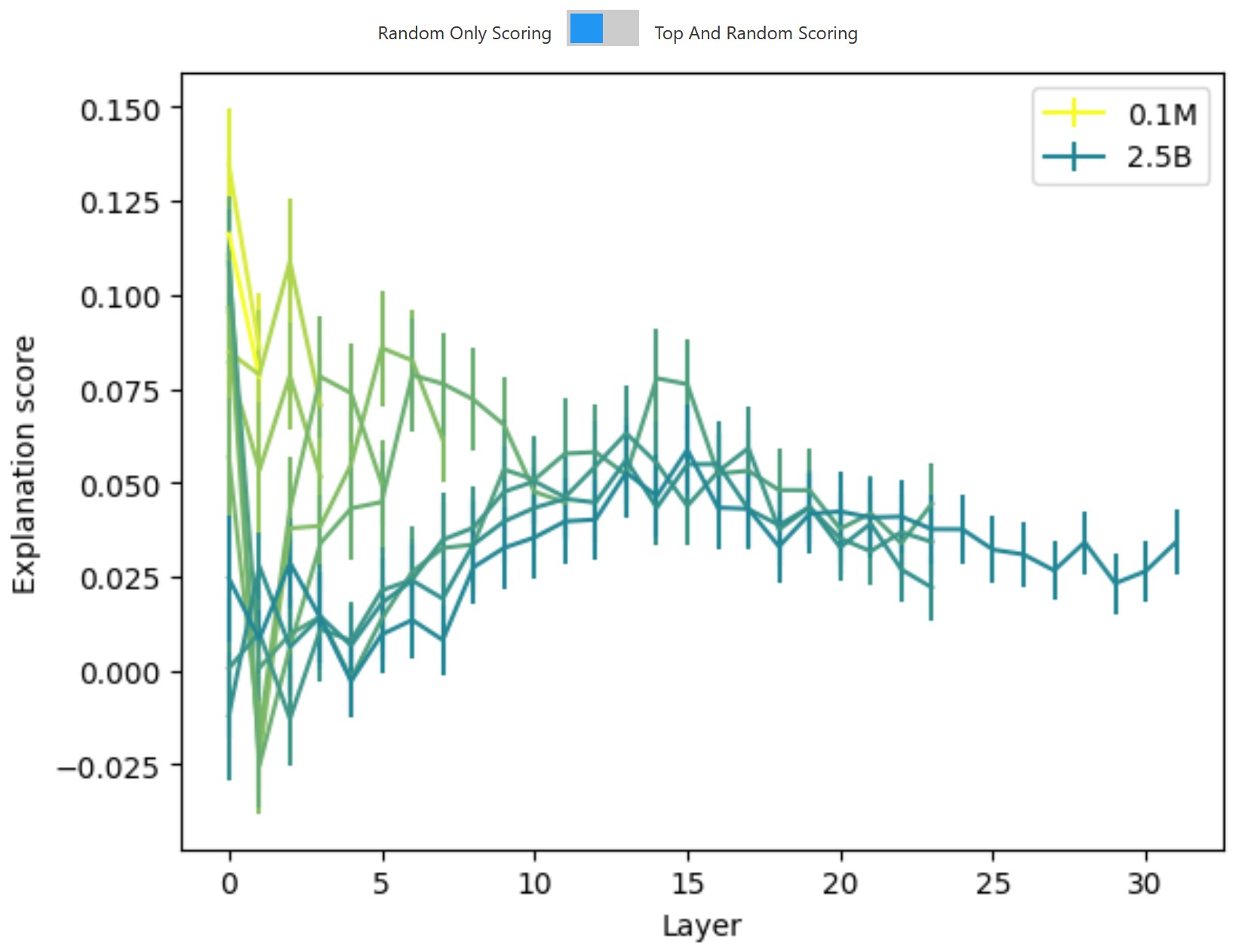

GPT-2では,top-and-randomスコアの平均スコアは0.151,random-onlyスコアの平均スコアは0.037となった.

また,上位層へ行くほどスコアは低下している.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

ニューロンの個々のスコアは,特にrandom-onlyスコアの場合,ノイズが多い可能性があることに注意されたい.

この点を考慮し,307,200個のニューロンのうち,デフォルトの方法論でtop-and-randomスコアが0.7を超える(分散の約半分をExplanationsする)のは5,203個(1.7%)であることを示す.

random-onlyスコアの場合,これは732ニューロン(0.2%)に減少する.

top-and-randomスコアが0.9を超えるのは189ニューロン(0.06%),random-onlyスコア0.9を超えるのは86ニューロン(0.03%)にとどまる.

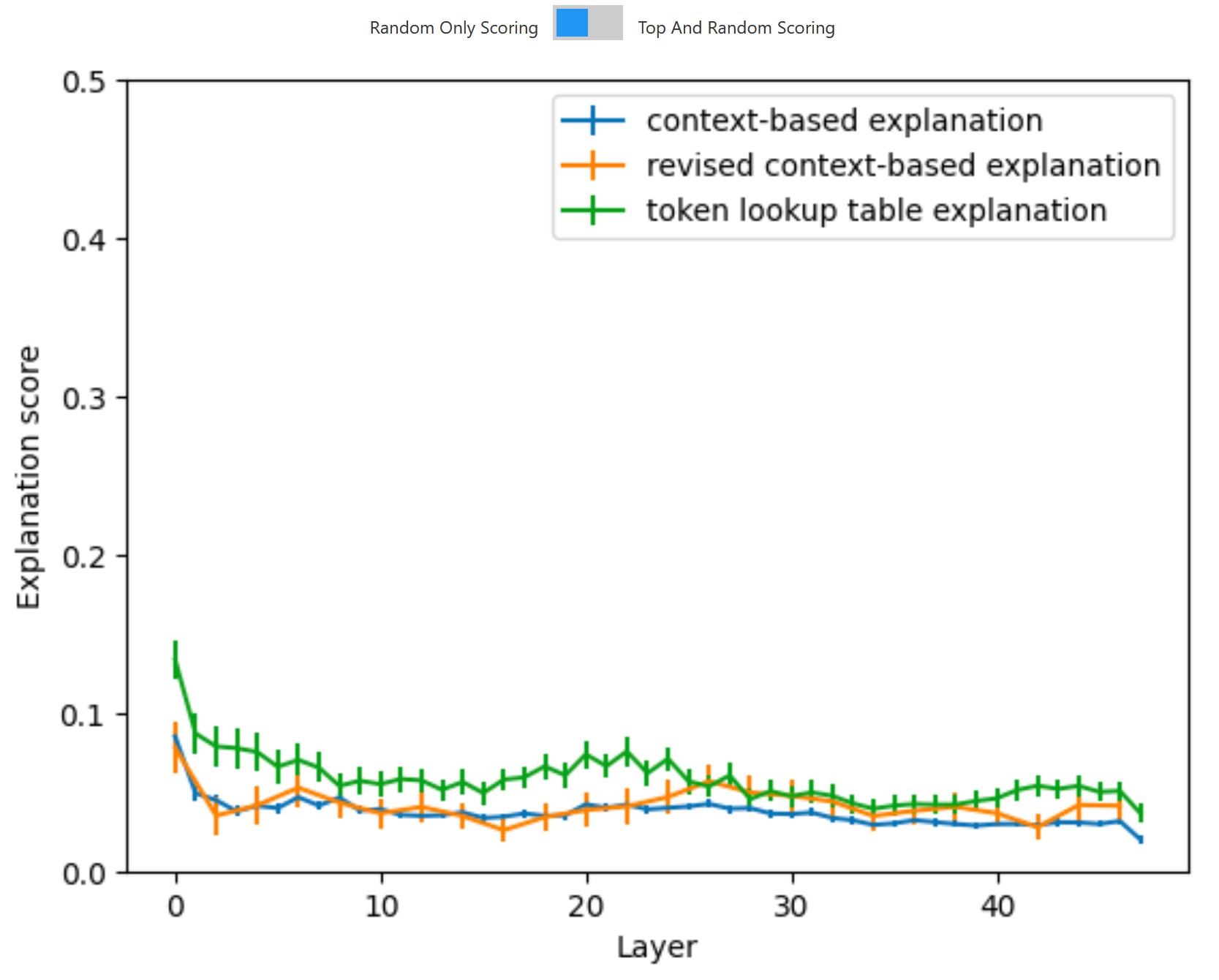

3.1節:Unigram baselines(Unigramベースライン)

我々のExplanationsの質を絶対的に理解するためには,活性化の要約やシミュレーションする言語モデルの能力に依存しないベースラインと比較することは有用である.

このため,モデルの重み,または保持されたテキストに集約された活性化データのいずれかを使用して,単一のトークンをベースに活性化を直接予測するいくつかのベースラインの方法を検討する.

これらの方法は,各ニューロンについて,語彙のトークンごとに1つの予測された活性化を与えるが,これは,言語モデルが生成する短い自然言語Explanationよりも実質的に多くの情報に相当する.

そのため,言語モデルを用いて活性化のリストを簡単に要約し,典型的なシミュレーションパイプラインのExplanationとして使用することもある.

「token explanation」プロンプトの省略版は以下になる.

|

1 2 3 4 5 6 7 8 9 |

We're studying neurons in a neural network. Each neuron looks for some particular kind of token (which can be a word, or part of a word). Look at the tokens the neuron activates for (listed below) and summarize in a single sentence what the neuron is looking for. Don't list examples of words. Tokens: 'the', 'cat', 'sat', 'on', 'the', 'mat' Explanation: This neuron is looking for |

3.1.1項:Token-based prediction using weights(重みを利用したトークンベースの予測)

ロジットレンズと関連する手法[28][29]は,ニューロンの重みをトークンに関連付け,ニューロンを活性化させるトークン,またはニューロンがモデルにサンプリングさせるトークンの観点から解釈することを試みる.

基本的に,これらの手法は,ニューロンの入力または出力重みに,埋め込み行列または非埋め込み行列を乗じることに依存する.

各トークンの活性化を線形に予測するために,各トークンの埋め込みにMLP前の層のノルムゲインとニューロン入力重み(\(W_{in}\))を乗じる.

この方法論により,語彙の各トークンに単一のスカラー値を割り当てることができる.

この方法による予測活性化は,現在のトークンのみに依存し,先行するコンテキストには依存しない.

これらのスカラー値は,各トークンの活性化を予測するために直接使用され,要約は行われない.

これらの重みに基づく線形予測は,重みがニューロンの入力パターンに直接影響し,その結果,ニューロンの活性化パターンに影響するという点で,機械論的または「因果的」なExplanationsである.

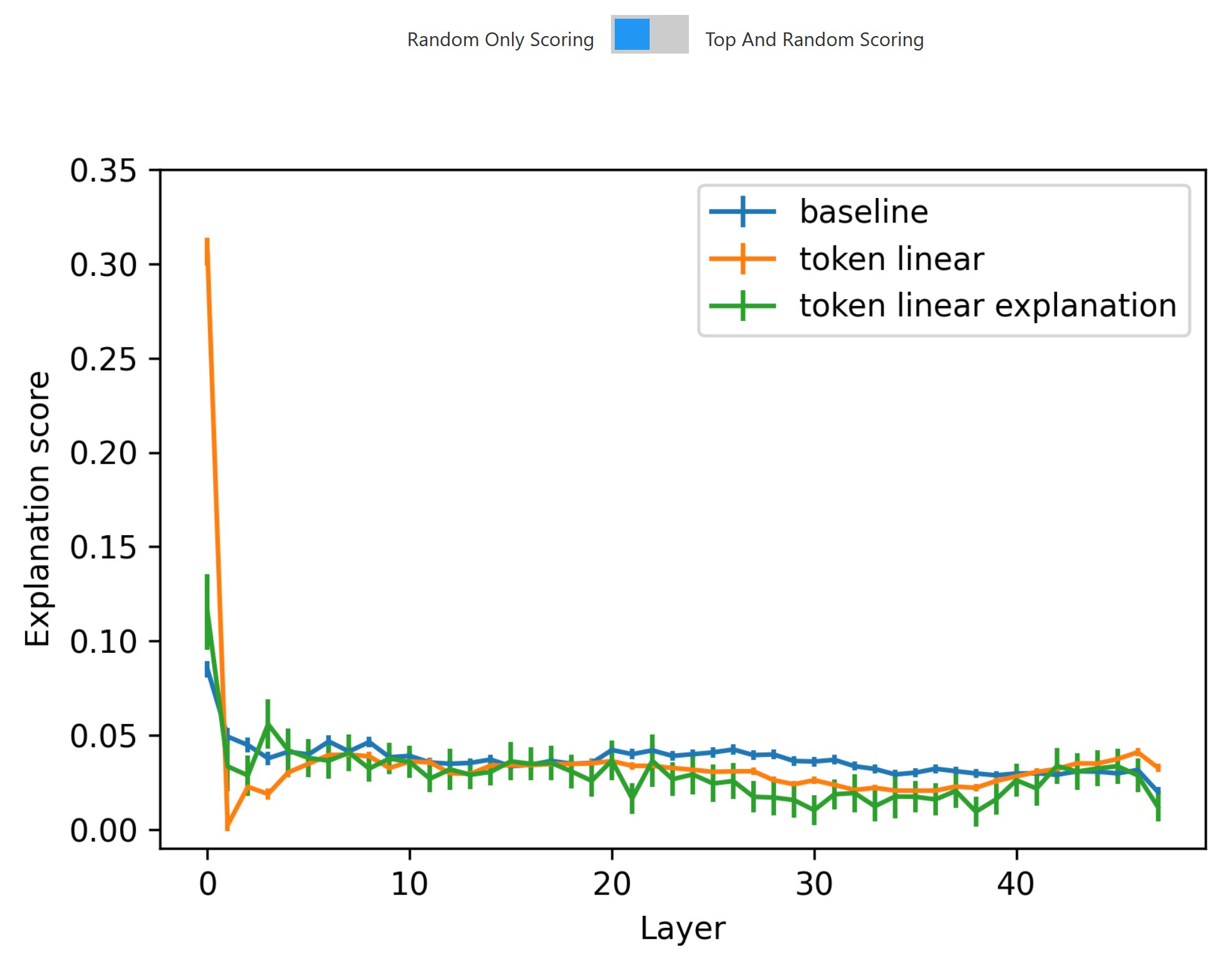

線形トークンベースの予測ベースラインは,第1層では活性化ベースのExplanationとスコアを上回り,活性化をほぼ完璧に予測する(埋め込みと第1MLP層の間に第1Attention層だけが介在することを考えると,当然といえば当然).

それ以降の層では,GPT-4ベースのExplanationとスコアが,線形トークンベースの予測ベースラインよりも活性化を予測する.

※また,テキスト抜粋の各位置の位置埋め込みとトークン埋め込みを含む線形予測も試した.この線形のトークンと位置の予測のベースラインでは,量的な改善は非常に小さく,質的な変化はなかった.

線形トークンベースの予測ベースラインは,語彙のトークンごとに1つのスカラー値という「Explanationの長さ」がGPTベースの自然言語によるExplanationsよりも大幅に長いため,やや不公平な比較となっている.

言語モデルを用いてこの情報を短いExplanationに圧縮し,そのExplanationをシミュレーションすることは,予測される活性化の正解率に影響を与える「情報ボトルネック」として機能するかもしれない.

これを制御するために,GPT-4ベースのExplanationを,トップ活性化ではなく,線形予測活性化が最も高いトークンのリスト(トップ100の値のうち50に相当)に適用するという,ハイブリッドアプローチを試した.

これらのExplanationsは,線形トークンベースの予測または活性化ベースのExplanationsのいずれよりもスコアが悪い.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

3.1.2項:Token-based prediction using lookup tables(ルックアップテーブルを用いたトークンベースの予測)

トークンベースの線形予測ベースラインは,いくつかの理由のうちの1つで,活性化ベースのベースラインを下回るかもしれない.

第1に,複数トークンの文脈が重要であるため(例えば,多くのニューロンは複数トークンのフレーズに敏感である),失敗する可能性がある.

第2に,トークン埋め込みと\(W_{in}\)の間の中間処理ステップが重要であり,線形予測はニューロンの活動に対するトークンの真の因果的影響の表現に乏しいため,失敗する可能性がある.

2番目の可能性を評価するために,2番目の「相関的」ベースラインを構築した.

このベースラインでは,hold-outなインターネット上のテキストの大規模なコーパスについて,トークンごと,ニューロンごとの平均活性化を計算する.

次に,この情報を使ってルックアップテーブルを作成する.

テキスト抜粋の各トークンと各ニューロンについて,先行するトークンとは無関係に,トークンルックアップテーブルを使用してニューロンの活性化を予測する.

ここでも,このルックアップテーブルの内容を要約したり,言語モデルを使用して活性化をシミュレーションすることはない.

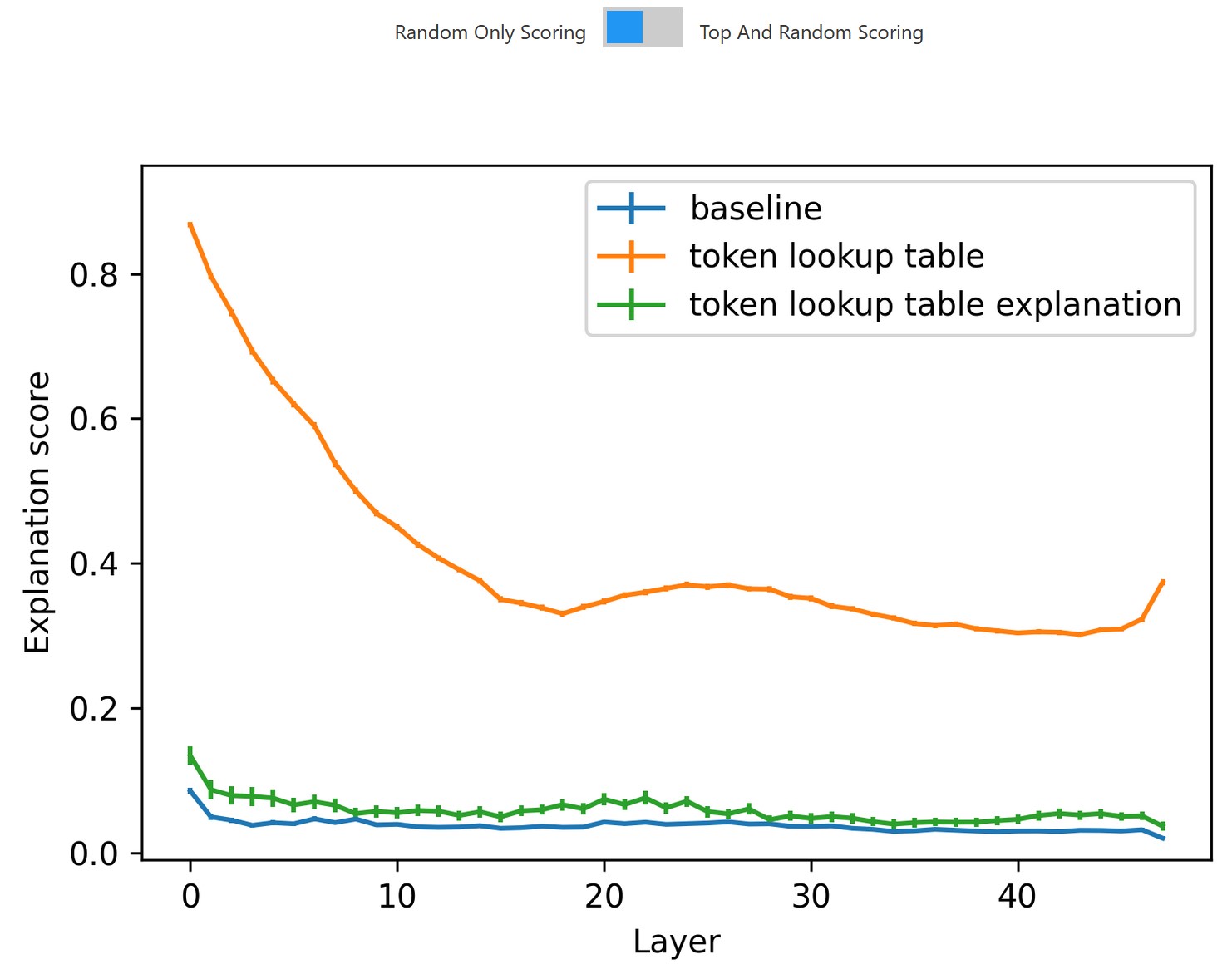

トークンルックアップテーブルベースラインは,トークンベースの線形予測ベースラインよりもはるかに強く,活性化ベースのExplanationとシミュレーションを平均して大幅に上回ることができた.

GPT-4を用いたExplanationとシミュレーションによる情報ボトルネックが,予測される活性化の正解率にどのように影響するかを測定するために,トークンベースの線形ベースラインと同じExplanation手法を適用する.

その結果,トークンルックアップテーブルベースのExplanationは,top-and-randomスコアでは活性化ベースのExplanationと同様のスコアとなり,random-onlyスコアでは活性化ベースのExplanationを上回った.

しかし,我々は,単一のトークンよりも,複数のトークンの文脈の複雑なパターンをエンコードするニューロンに最も関心がある.

平均的な性能は低いものの,活性化ベースのExplanationsがトークンルックアップテーブルベースのExplanationsより優れている多くの興味深いニューロンを見つけることができた.

また,Explanationsを改訂することで,トークンルックアップテーブルベースのExplanationsよりも改善することができる.

長期的には,トークンベースと活性化ベースの両方の情報を組み合わせた方法を使う予定である.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

3.2節:Next-token-based explanations(次のトークンベースのExplanations)

特に後段の層で,現在のトークンではなく,予測される次のトークンをエンコードしているように見えるニューロンがあることに気づいた(後述の「from」-予測ニューロン参照).

GPT-4に(先行トークン,活性化)のペアを要求する我々のベースライン手法では,この挙動を捉えることができない.

そこで,GPT-4は,(次のトークン,活性化)のペアを用いて,ニューロンの活性化を,その最も高い活性化に続くトークンに基づいてExplanationsし,シミュレーションするようにプロンプトする.

この方法は,ニューロンの一部,特に後半の層でより成功し,最後の数層ではベースラインの方法と平均して同様のスコアを達成する.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

3.3節:Revising explanations(Explanationsの改訂)

Explanationの質は,1つのExplanationプロンプトに表示されるテキストの抜粋と活性化の小さなセットによって基本的にボトルネックとなり,ニューロンの動作をExplanationsするには必ずしも十分ではない.

Explanationsを繰り返すことで[7],より多くの情報を効果的に活用できる可能性があり,テスト時に回答を改善するために推論を使用する大規模言語モデルの創発的な能力に依存する[30][31].

※前述のように,非反復設定では,Explainerモデルは文脈の中で追加のテキスト抜粋を効果的に利用することができないことがわかる.

特に問題なのは,過度に広範なExplanationsをすると,上位の活性化シーケンスと一致する傾向がある.

例えば,「not all」というフレーズと関連するフレーズで活性化する「not all」ニューロンを発見した.

しかし,Explanationのために選ばれたトップ活性化テキストの抜粋は,このニューロンが「all」というフレーズで活性化するという,より単純な仮説を否定するものではない.

このため,モデルは「「all」という用語と関連する文脈上のフレーズ」という,広すぎるExplanationを生成している.

※我々のうちの一人がこのニューロンを注意深く見てみると,我々もこの結論に達した.「すべての学生は月曜日までに最終論文を提出しなければならない」(All students must turn in their final papers by Monday)というようなシーケンスの例を試してみて初めて,最初のExplanationが広すぎることに気づいたのである.

しかし,異なる文脈で「all」を含むテキストの抜粋に対する活性化を観察すると,ニューロンは実際に「all」に対して活性化しているが,「not all」というフレーズの一部である場合にのみ活性化していることが明らかになった.

この例や他の類似の例から,我々は,top-and-randomな活性化シーケンス以外の新しい証拠を調達することが,いくつかのニューロンをより完全にExplanationsするのに役立つと結論付けた.

さらに悪いことに,我々のExplainer技術では,否定的な証拠(ある仮説を否定する発火しないニューロンの例)を考慮しないことが多いことがわかった.

「not all」ニューロンでは,Explainerの文脈に否定的な証拠(活性化ゼロの「all」を含むシーケンス)を手動で追加しても,Explainerはこれらを無視し,同じように広すぎるExplanationsを作成する.

Explainerモデルは,1回のフォワードパスでプロンプトのすべての面に注意を向けることができないのかもしれない.

これらの問題を解決するために,2段階の改訂プロセスを適用している.

最初のステップは,新しい証拠を調達することである.

GPT-4でfew-shotプロンプトを使い,既存のExplanationと一致する文章を10個生成する.

例えば,「not all」ニューロンに対しては,GPT-4は「all」という単語を否定的でない文脈で使用する文章を生成する.

「sentence generation」プロンプトは以下になる.

|

1 2 3 4 5 6 7 8 9 10 11 12 |

The task format is as follows. description :: <answer>example sentence that fits that description</answer> The answer is always at least one full sentence, not just a word or a phrase. The following tasks have only one answer each enclosed in <answer></answer> tags. negation of instances of the word "stop" or conceptually similar words (e.g. "kept", "warrant") that imply something coming to an end or being prevented. :: <answer>been that way for more than 30 years but that doesn't stop successive governments in countries around the globe</answer> words related to providing or contributing something (e.g. "contribute," "contributor," "contribution"). :: <answer>The new information showed that during the last three month of the year the CPI fell by 0.3 percent. The drop was largely contributed to a 25 percent decrease in the price of vegetables over</answer> language related to leadership or administrative roles (e.g. "treasurer," "governor") as well as language related to game mechanics or design (e.g. "mechanics"). :: <answer>King Roo, after a rather disastrous incident involving some of his Dice-a-Roo prizes, is hiring a new treasurer! Before getting the</answer> references to prominent figures in the hip hop music industry (e.g. artist names, album titles, song titles). :: <answer>The album was released on October 22, 2002, by Ruff Ryders Entertainment and Interscope Records. The album debuted at number one on the US Billboard 200 chart, selling 498,000 copies in its first week.</answer> This next task has exactly 10 answer(s) each enclosed in <answer></answer> tags. Remember, the answer is always at least one full sentence, not just a word or a phrase. positions in the sentence where the next word is likely to be "an" :: |

希望としては,オリジナルのExplanationのための偽陽性を見つけることである.

つまり,ニューロンの実際の活性化は低いが,シミュレーションの活性化が高いトークンを含む文である.

しかし,この条件に対して生成された文章をフィルタリングすることはしない.

実際には,生成されたシーケンスのおよそ42%が,それらのExplanationsのために偽陽性となる.

86%のニューロンでは,10個のシーケンスのうち少なくとも1個が偽陽性になった.

これは,我々のExplanationsがしばしば包括的すぎるという独立したシグナルを提供する.

生成された10個の文章を,改訂用5個とスコア用5個の2つのセットに分けた.

新しい文章を生成したら,対象モデルを用いて推論を行い,ターゲットニューロンの活性化を記録する.

第2段階は,GPT-4によるfew-shotプロンプトを使用して,オリジナルのモデルのExplanationを改訂することである.

このプロンプトには,オリジナルのExplanationを生成するために使用された証拠,オリジナルのExplation,新しく生成された文,それらの文に対するグランドトゥルースの活性化が含まれている.

改訂されたExplanationを得たら,オリジナルのExplanationをスコアするために使用したのと同じシーケンスセットでスコアする.

また,オリジナルのExplanationと改訂されたExplanationを,新しい証拠のスコア分割で拡張された同じセットでスコアする.

Explanation改訂プロンプトの省略版は以下になる.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 |

The following solutions are the output of a Bayesian reasoner which is optimized to explain the function of neurons in a neural network using limited evidence. Each neuron looks for some particular thing in a short passage. Neurons activate on a word-by-word basis. Also, neuron activations can only depend on words before the word it activates on, so the explanation cannot depend on words that come after, and should only depend on words that come before the activation. The reasoner is trying to revise the explanation for neuron A. The neuron activates on the following words (activating word highlighted with **): """ But that didn't **stop** it becoming one of the most popular products on the shelf. Technology has changed quite a bit over Vernon Cook's lifetime, but that hasn't **stopped** him from embracing the advance. The Storm and Sharks don't have the same storied rivalry as some of the grand finalists in years gone by, but that hasn't **halted** their captivating contests in recent times. """ The current explanation is: the main thing this neuron does is find language related to something being stopped, prevented, or halted. The reasoner receives the following new evidence. Activating words are highlighted with **. If no words are highlighted with **, then the neuron does not activate on any words in the sentence. """ But that stopped it becoming one of the most popular products on the shelf. Technology has changed quite a bit over Vernon Cook's lifetime, and that stopped him from embracing the advance. I have to stop before I get there. """ In light of the new evidence, the reasoner revises the current explanation to: the main thing this neuron does is find the negation of language related to something being stopped, prevented, or halted (e.g. "didn't stop") [prompt truncated …] The reasoner is trying to revise the explanation for neuron D. The neuron activates on the following words (activating word highlighted with **): """ Kiera wants to make sure she has strong bones, so she drinks 2 liters of milk every week. After 3 weeks, how many liters of milk will Kiera drink? Answer: After 3 weeks, Kiera will drink **4** liters of milk. Ariel was playing basketball. 1 of her shots went in the hoop. 2 of her shots did not go in the hoop. How many shots were there in total? Answer: There were **2** shots in total. The restaurant has 175 normal chairs and 20 chairs for babies. How many chairs does the restaurant have in total? Answer: **295** Lily has 12 stickers and she wants to share them equally with her 3 friends. How many stickers will each person get? Answer: Each person will get **5** stickers. """ The current explanation is: the main thing this neuron does is find numerical answers in word problems.. The reasoner receives the following new evidence. Activating words are highlighted with **. If no words are highlighted with **, then the neuron does not activate on any words in the sentence. """ Kiera wants to make sure she has strong bones, so she drinks 2 liters of milk every week. After 3 weeks, how many liters of milk will Kiera drink? Answer: After 3 weeks, Kiera will drink 6 liters of milk. Ariel was playing basketball. 1 of her shots went in the hoop. 2 of her shots did not go in the hoop. How many shots were there in total? Answer: There were 3 shots in total. The restaurant has 175 normal chairs and 20 chairs for babies. How many chairs does the restaurant have in total? Answer: 195 Lily has 12 stickers and she wants to share them equally with her 3 friends. How many stickers will each person get? Answer: Each person will get 4 stickers. """ In light of the new evidence, the reasoner revises the current explanation to: the main thing this neuron does is find |

その結果,オリジナルのスコアセットと拡張されたスコアセットの両方において,改訂されたExplanationsがオリジナルのExplanationsよりも良いスコアを獲得していることがわかった.

予想通り,オリジナルのExplanationsのスコアは,オリジナルのスコアセットよりも拡張されたスコアセットで顕著に悪くなっている.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

改訂が重要であることがわかる.

新しい文章で再説明を行うベースライン(「reexplanation」)では,古いExplanationへのアクセスがないため,ベースラインより改善されない.

続いて,活性化がゼロでない文のランダムサンプル("revision_rand")を用いて,改訂を試みた.

その結果,生成された文章を用いた改訂とほぼ同程度に,Explanationスコアが向上することがわかった.

これは,ランダムな文が初期Explanationsの誤認識の原因となりやすいためと考えられる.

ランダムな文の約13%は,オリジナルのモデルのExplanationsに対する偽陽性の活性化を含んでいる.

全体として,改訂は,top-and-randomのトークンルックアップテーブルのExplanationsのスコアを上回ることができるが,random-onlyスコアの場合は,改善が限定的である.

※我々の改訂プロセスは,どのようなExplanationから始めるかにも依存しないので,強力なunigramベースラインから始めて,関連する文に基づいて改訂することも可能である.このような手法は,既存の結果を上回ると思われるので,今後試していく予定である.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

定性的には,オリジナルのExplanationが広すぎ,改訂されたExplanationが狭すぎるが,改訂されたExplanationがより真実に近いというパターンが主に観察される.

例えば,第0層のニューロン4613の場合,オリジナルのExplanationは「words related to cardinal directions and ordinal numbers」(基数方向と序数に関する単語)であった.

GPT-4はこのExplanationに基づいて10個の文章を生成したが,その中には「third」(3番目),「eastward」(東方向),「southwest」(南西方向)など,最終的に有意な活性化を欠く単語が多く含まれていた.

そこで,「this neuron activates for references to the ordinal number 'Fourth'」(このニューロンは,序数「4番目」に言及したときに活性化する)というExplanationに改訂したところ,誤検出が大幅に減少した.

とはいえ,「Netherlands」(オランダ)や「white」(白)など,4番目以外の単語に対してもいくつかの活性化が見られるため,改訂されたExplanationはニューロンの挙動を完全に捉えているとは言えない.

また,オリジナルのExplanation手法の問題点をターゲットにした,改訂によって可能になったいくつかの有望な改善点も観察された.

例えば,一般的なニューロンの活性化パターンは,ある単語に対して活性化するが,非常に特殊な文脈でのみ活性化することである.

この例として,「had」(持っていた)という単語に対して活性化する「hypothetical had」(仮説的に持っていた)ニューロンが挙げられる.

ただし,仮説の話や違った形で起こったかもしれない状況(例えば,「I would have shut it down forever had I the power to do so.」(私にそうする力があれば,永遠にシャットダウンしただろう.))の文脈でのみ活性化する.

オリジナルのモデルのExplanationでは,このパターンを拾うことができず,「「had」という単語とその諸文脈」という広すぎるExplanationを生成してしまう.

しかし,偽陽性活性化を含む文(例えば,「He had dinner with his friends last night」(彼は昨夜友人と夕食をとった))が与えられると,改訂者は真のパターンを拾い上げ,改訂されたExplanationを作成することができる.

このほか,「「together」という単語は,「get」という単語が先行する場合のみ」(例:「get together」,「got together」),「「because」という単語は,「just because」文法構造の一部の場合のみ」(例えば,「just because something looks real, doesn't mean it is」(何かが本物らしく見えるからといって,それが本物だとは限らない))などのニューロン活性化パターンを,オリジナルのExplanationが捉えられなかったが改訂されたExplanationでは解説できるニューロン活性化パターンとしてある.

今後は,偽陰性のソーシング,思考連鎖(chain-of-thought)法の適用,ファインチューニングなど,エビデンスソーシングと改訂を改善するためのさまざまな手法を探求していく予定である.

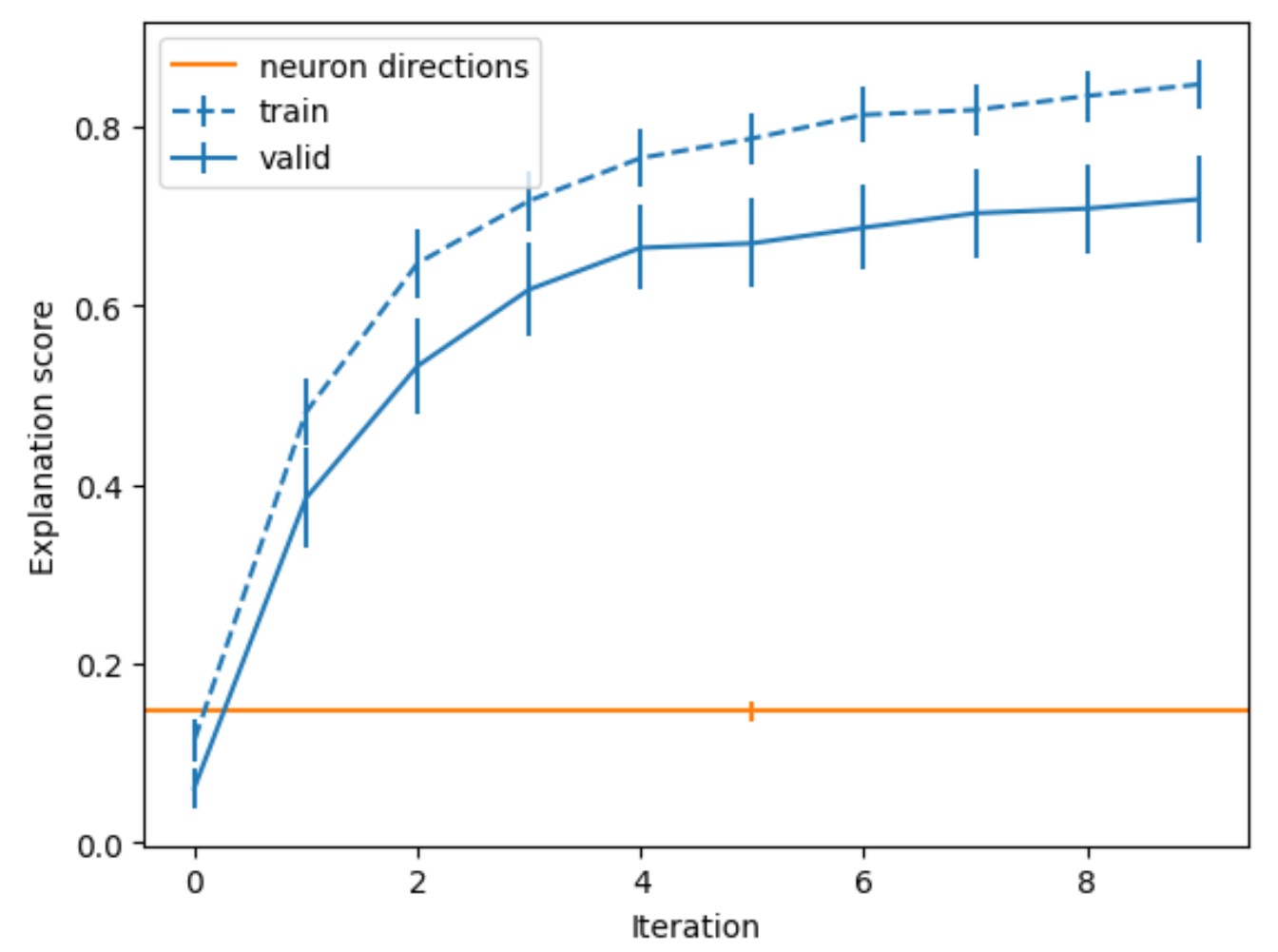

3.4節:Finding explainable directions(Explainableな方向の発見)

Explanationの質は,ニューロンが自然言語でどの程度簡潔にExplainable(説明可能)かによってもボトルネックになる.

我々は,検査したニューロンの多くが多義的であることを発見し,潜在的に重ね合わせによるものであると考えた[26][32].

このことは,Explanationsする内容を改善することで,Explanationsを改善する別の方法を示唆している.

我々は,重ね合わせに対する可能な攻撃角度のために,我々の自動化された方法論を用いて,この直感を活用する簡単なアルゴリズムを探求する.

高レベルのアイデアは,ニューロンの線形結合を最適化することである.

※この方法は,特権的な基礎を全く想定していないため,残差ストリームにも適用できる.

活性化ベクトルaと単位ベクトル(方向)\(\theta\)が与えられたとき,活性化\(a_\theta=a^T \sum^{-1/2}\theta\)を持つ仮想ニューロンを定義し,ここで\(\sum\)はaの共分散行列である.

※初期の実験では,\(\sum^{-1/2}\)の再パラメータ化を行わないと,高い分散のニューロンが選択されたベクトルを不均衡に支配し,サンプルの多様性が低下することがわかった.\(\sum^{-1/2}\)を利用する再パラメータ化は,初期化で低分散の方向が有利になり,ステップサイズが適切にスケールされるようになった.再パラメータ化にもかかわらず,まだ若干の崩壊が観察される.

一様にランダムな方向\(\theta\)からスタートし,以下のステップを交互に繰り返しながら,座標上昇法(coordinate ascent)で最適化する.

- Explanationステップ:\(a_\theta\)をよくExplanationsする(高いExplanationスコアを達成する)Explanationを検索し,Explanationsの最適化を行う.

- 更新ステップ:スコアの勾配を計算し,勾配上昇を行うことで,\(\theta\)を最適化する.なお,この相関スコアは,Explanationとシミュレーションの値が固定されている限り,\(\theta\)に関して微分可能である.

Explanationステップでは,最も単純なベースラインは,典型的なトップ活性化ベースのExplanation方法(活性化は各ステップの仮想ニューロンに対するもの)を単純に使用することである.

しかし,Explanationステップの品質を向上させるために,否定語を生成した改訂版を使用し,さらに前のステップでハイスコアを得たExplanationsを再利用する.

このアルゴリズムをGPT-2 smallの第10層(MLPの一番下の層)で実行したところ,3072個のニューロンがあった.

各3072次元の方向について,10ラウンドの座標上昇法を実行した.

勾配上昇には,学習率1e-2のAdamを使用し,\(\beta_1\)は0.9,\(\beta_2\)は0.999とした.

また,各反復で単位ノルムになるように\(\theta\)を再スケーリングしている.

10回繰り返した後のtop-and-randomスコアの平均は0.718で,この層のランダムニューロンの平均スコア(0.147)を大幅に上回り,最適化前のランダム方向の平均スコア(0.061)よりも高いことがわかる.

この方法の潜在的な問題は,多様な局所最大値を見つけるのではなく,同じExplainableな方向に繰り返し収束してしまうことがある.

その程度を確認するために,結果の方向が互いに非常に低いコサイン類似度を持つことを測定し,発見する.

また,\(\sum^{-1/2} \theta\)に最も寄与するニューロンを調べると,全く意味的に関係のないものが多いことが定性的に観察され,見つかった方向は特定のニューロンや意味的に似たニューロンの小さな組み合わせだけではないことが示唆された.

その活性化と方向性の活性化の相関によってトップn個のニューロンだけに切り捨てると,スコアを回復するために非常に多くのニューロンが必要であることがわかる(Explanationは固定).

※また,係数の大きさで切り捨てることも試したが,さらにスコアが悪くなってしまった.

この方法の大きな限界は,説明可能性(Explainability)の学習済みプロキシを最適化する際に注意が必要であることである[33][34].

また,モデル内の方向性を忠実に人間に理解できるようにExplanationsできる範囲には,理論的な限界があるかもしれない[35].

3.5節:Assistant model trends(アシスタントモデルの傾向)

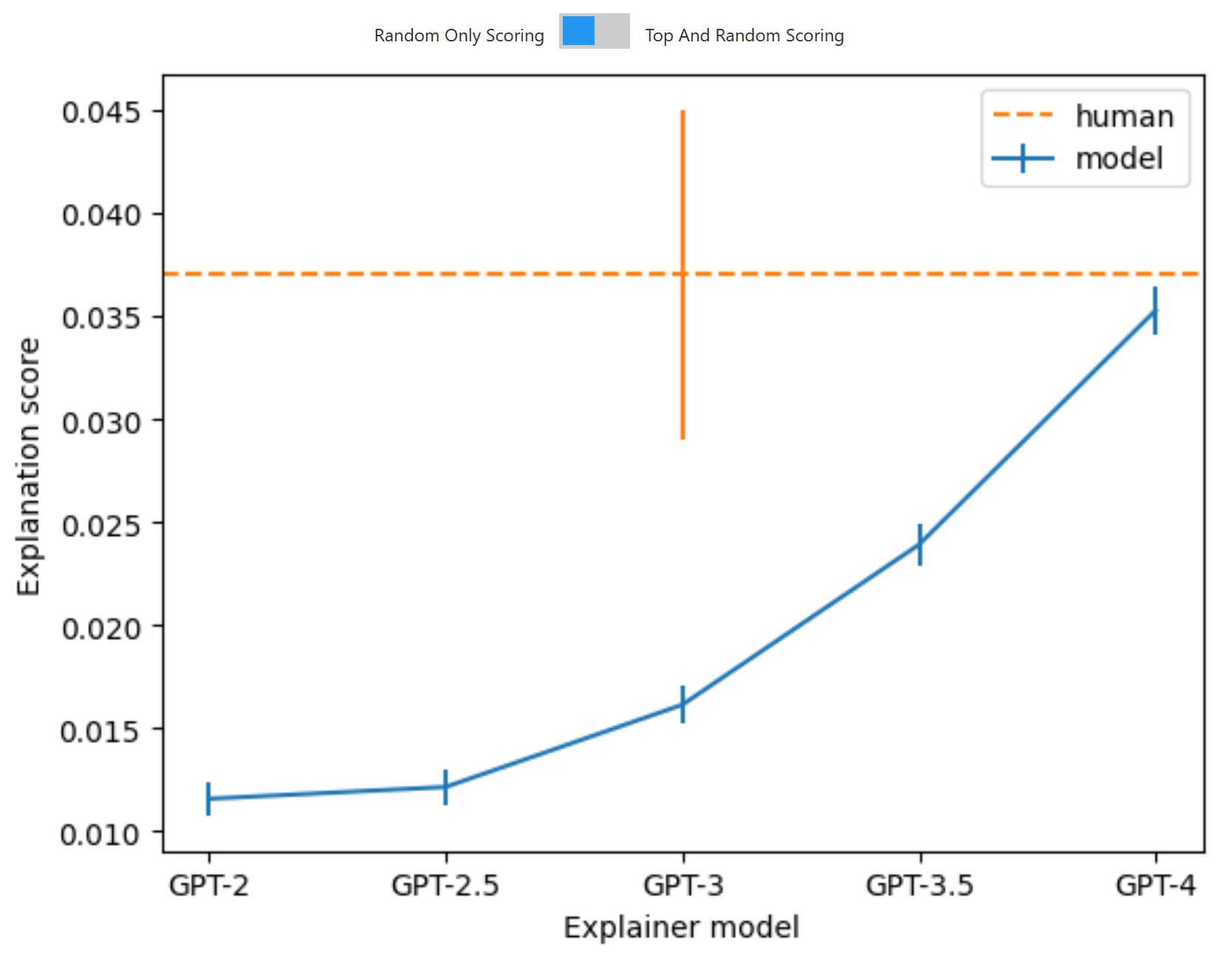

3.5.1項:Explainer model scaling trends(Explainerモデルのスケーリングの傾向)

重要な希望の一つは,我々のアシスタントが良くなるにつれて,Explanationsも良くなることである.

ここでは,シミュレータのモデルをGPT-4に固定したまま,様々なExplainerモデルを実験した.

その結果,Explainerモデルの能力に応じてExplanationsがスムーズに改善され,層間で比較的均等に改善されることがわかった.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

また,Explainerモデルが使用するのと同じ5つのトップ活性化テキストのセットを使用して,ゼロからExplanationsを書くよう求められたラベラーから,人間のベースラインを得た.

ラベラーは専門家ではなく,命令と研究者が書いたいくつかの例文を受け取ったが,ニューラルネットワークや関連トピックに関する深い訓練は受けていない.

人間の性能はGPT-4の性能を上回っているが,大きな差はないことがわかる.

また,人間の性能は絶対値でも低く,Explanationsの向上の主な障壁は,単にExplainerモデルの能力だけではないことが示唆される.

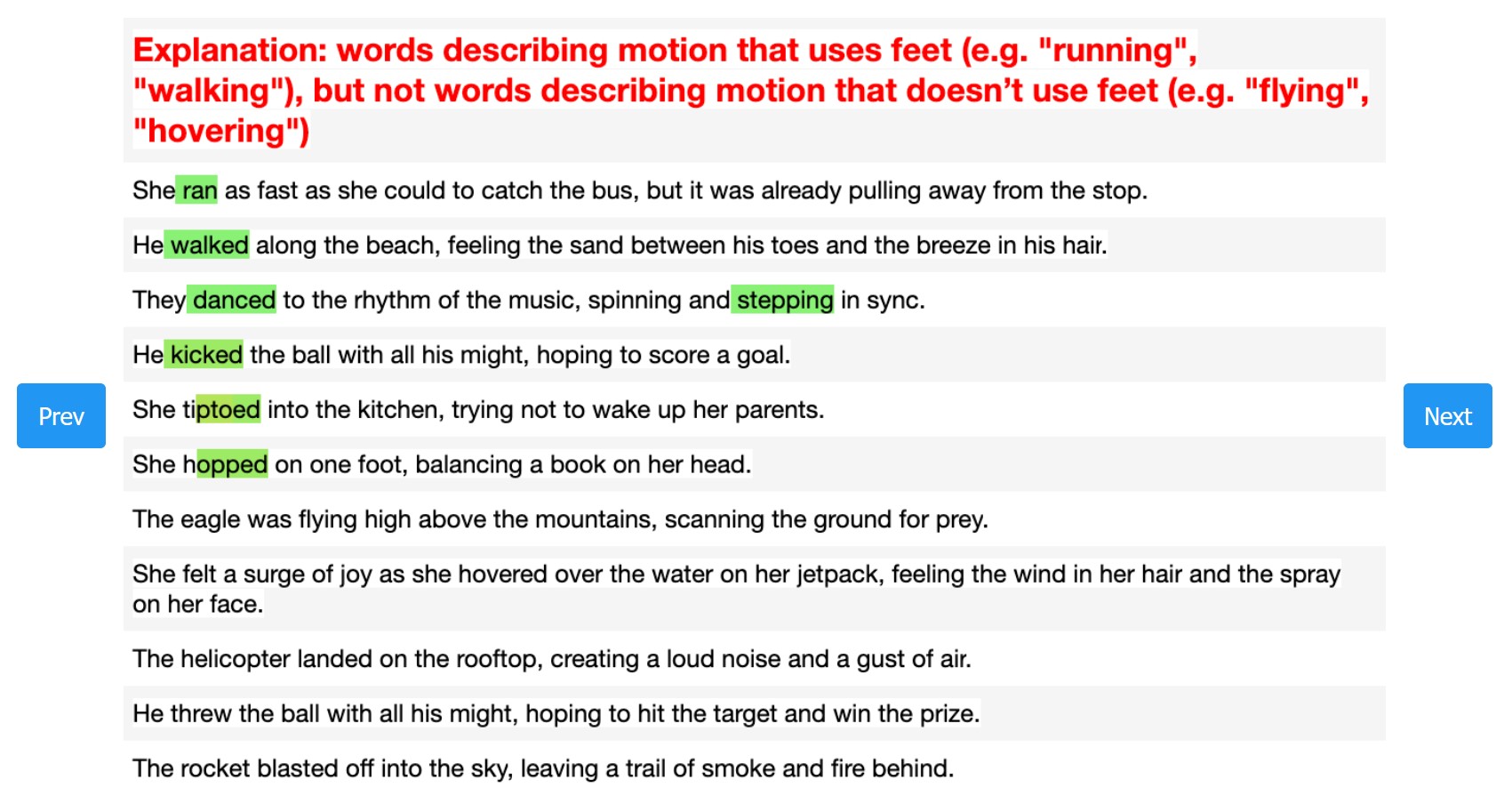

3.5.2項:Simulator model scaling trends(シミュレータモデルのスケーリングの傾向)

シミュレータの性能が低いと,非常に優れたExplanationでもロースコアになる.

シミュレータの品質を知るために,Explanationスコアをシミュレータのモデル性能の関数として見てみた.

top-and-randomスコアでは急勾配な結果が得られ,random-onlyスコアではスコアが頭打ちになることがわかる.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

もちろん,シミュレーションの品質はスコアで測定することはできない.

しかし,先述した人間比較データを用いて,より大きなシミュレータからのスコアによる比較が,より人間と一致することを確認することもできる.

ここで,人間のベースラインは,人間-人間の一致率に由来する.

GPT-4をシミュレータモデルとして使用したスコアは,他の人間との一致率で人間レベルに近づいているが,まだやや低い.

3.6節:Subject model trends(対象モデルの傾向)

この方法論は,対象モデルのどのような側面がExplanationスコアを増加させ,あるいは減少させるかについて,すぐに洞察を与えることができる.

なお,これらの傾向の一部は,対象モデルのニューロンが「解釈可能」,つまり人間が適度な努力をすれば理解できる程度ではなく,我々の特定のExplanation方法の長所と短所を反映している可能性がある.

もし我々のExplanation方法論が十分に改善されれば,このアプローチによって,モデルのどのような点が解釈可能性を高め,あるいは低下させるかを知ることができるかもしれない.

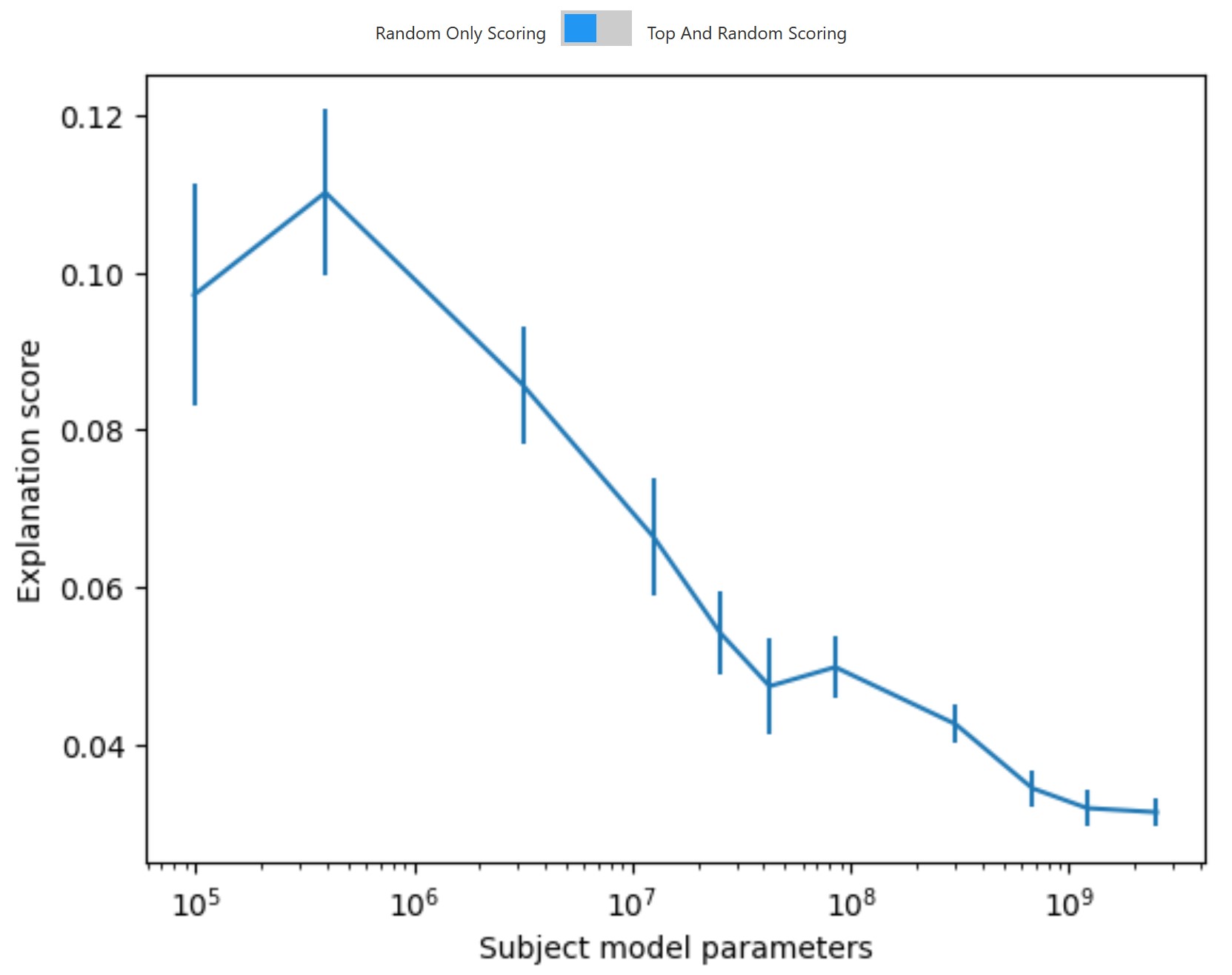

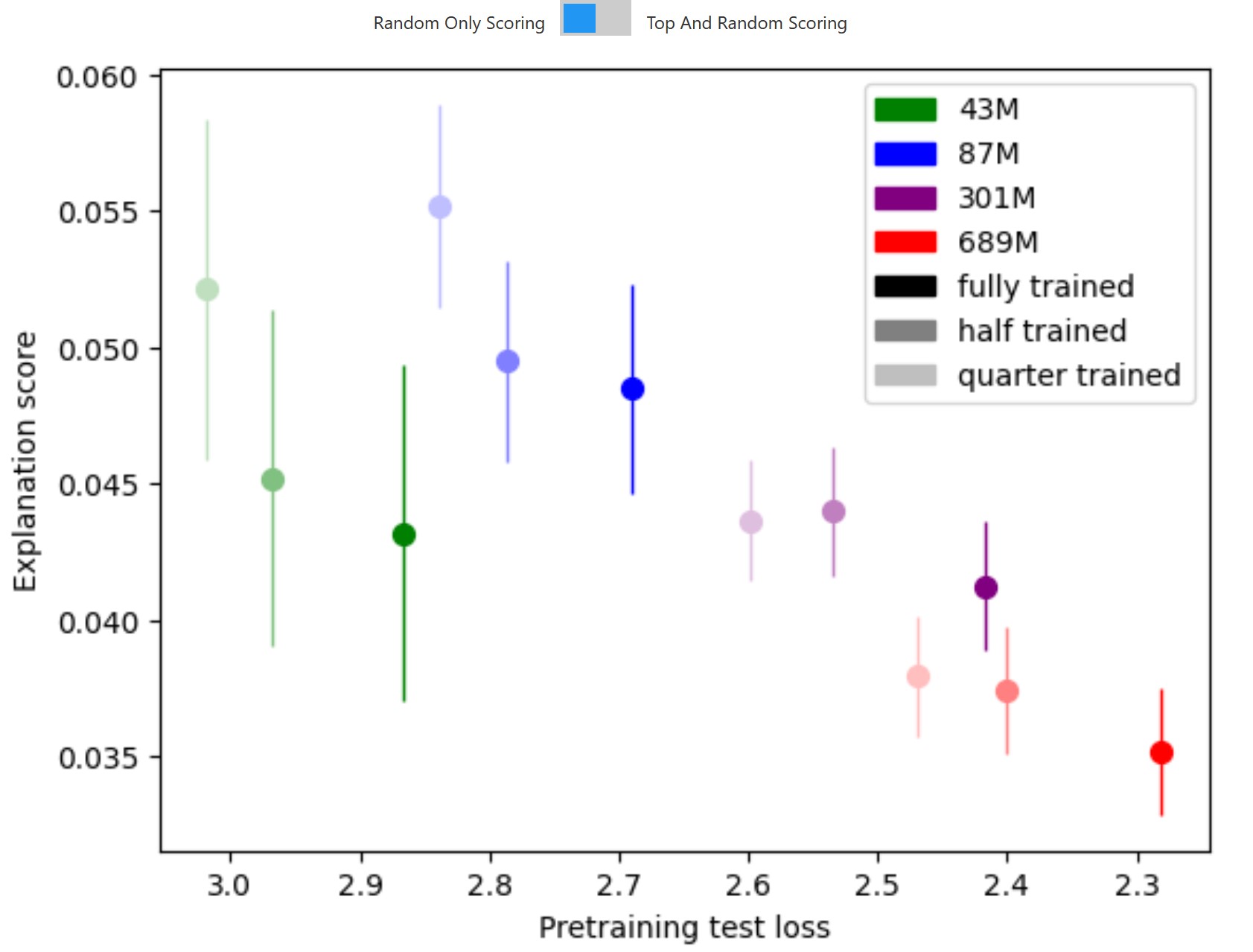

3.6.1項:Subject model size(対象モデルのサイズ)

このような場合,より高性能な大型モデルは小型モデルよりも理解しにくいのか,あるいは理解しにくいのか,というのは当然の疑問である[36].

そこで,GPT-3シリーズ[37]の98Kから6.7Bのパラメータを持つ対象モデルについて,Explanationスコアを測定した.

一般に,我々の方法を用いると,モデルサイズが大きくなるにつれてニューロンのExplainabilityが低下する傾向が見られ,特にrandom-onlyスコアでは明確な傾向が見られる.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

この傾向の基礎を理解するために,層別のExplainabilityを検証した.

第16層以降では,top-and-randomスコアとrandom-onlyスコアの両方を用いた場合,深さが増すにつれて平均的なExplanationスコアは強固に低下する.

より浅い層では,top-and-randomスコアも深度が増すにつれて減少し,random-onlyスコアは主にモデルサイズの増加とともに減少する.

※しかし,多くの大規模モデルの第2層(第1層)は非常に低いスコアであることがわかり,多くの死んだニューロンを含んでいるという事実が関係している可能性がある.

モデルサイズが大きいと層数が多くなるため,これらの傾向は,モデルサイズが大きくなるにつれてExplanationスコアが低下することを意味する.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

これらの傾向は,現在のExplanation生成手法の限界を反映しているという意味で,人為的なものである可能性があることに注意されたい.

我々が行った「次のトークン」ベースのExplanationの実験は,より大きなモデルのより後の層には,その振る舞いは理解できるが,現在の手法ではExplanationsが難しいニューロンがあるという仮説の信憑性を高めている.

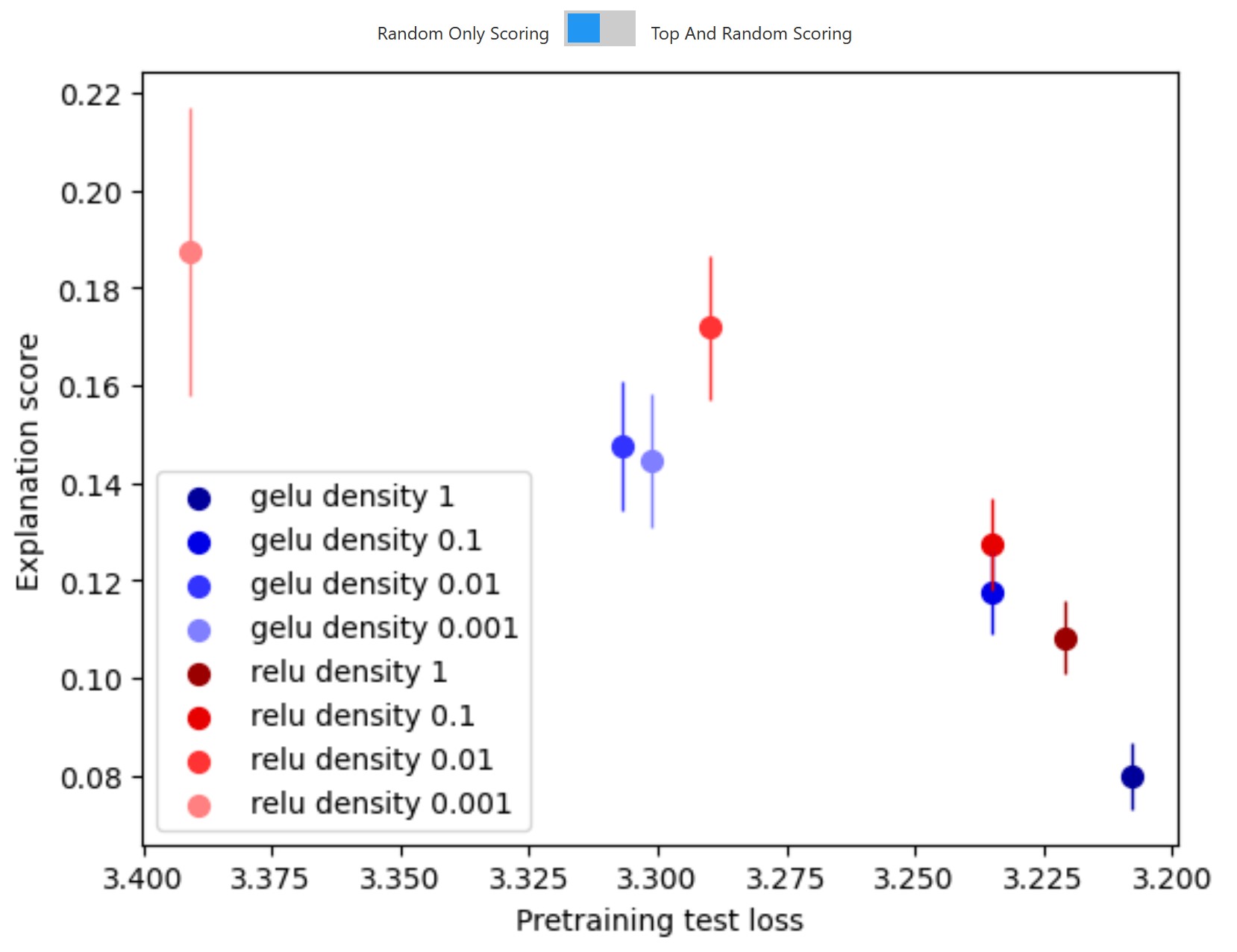

3.6.2項:Subject model activation function(対象モデルの活性化関数)

モデルのアーキテクチャが解釈可能性に影響を与えるかどうか[38][39][12],特にモデルのスパース性に関して興味深い疑問がある[40][41].

これを研究するために,スパース活性化関数を用いて,いくつかの小さな(〜3Mパラメータ)モデルをゼロから訓練する.

これは,標準的な活性化関数を適用するものの,各層のトップ活性化数だけを一定に保ち,残りはゼロに設定する.

1(ベースライン),0.1,0.01,0.001(トップ2ニューロン)という異なるレベルの活性化密度で試してみた.

活性化スパース性が極端な多義性を抑制することを期待している.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

活性化スパース性を高めると,Explanationスコアは一貫して向上するが,事前訓練の損失は増加する.

※パラメータが2倍になるごとに約0.17natsの損失が発生するため,0.1スパースモデルは約8.5%,0.01スパースモデルは約40%パラメータ効率が悪くなる.この「explainability tax」(説明可能性税)を軽減するためのlow hanging fruit(※訳注:直訳は「低いところにある果実」で,意訳すると「簡単な目標」の意味)があることを期待している.

また,RELUはGeLUよりも一貫して良いExplanationスコアをもたらすことがわかった.

3.6.3項:Subject model training time(対象モデルの訓練時間)

もう一つの疑問は,固定されたモデルアーキテクチャにおいて,訓練時間がExplanationスコアにどのような影響を与えるかということである.

そこで,GPT-3シリーズのモデルの中間チェックポイント(訓練の半分と4分の1に相当する部分)のExplanationスコアを調べてみた.

※これらのモデルは,それぞれ合計300Bトークンに対して訓練された.

※訳注:原文の図の上部のボタンを押すとグラフが変わります!

より多く訓練すると,top-and-randomスコアは向上するが,random-onlyスコアは低下する傾向がある.

※極めて推測的なExplanationとしては,訓練が進むにつれて特徴が改善される(top-and-randomスコアが上昇する),重ね合わせにより干渉する特徴も増える(random-onlyスコアが低下する),というものがある.

※訳注:原文のrandom-and-topはtop-and-randomの間違い.

損失に対する性能が一定レベルであれば,小さなモデルの方がExplanationスコアが高くなる傾向があるのかもしれない.

また,同じ訓練実行の異なるチェックポイント間で,Explanationsの有意な正の転移を発見した.

例えば,1/4訓練モデルのスコアは,フル訓練モデルのExplanationsを使用すると25%未満低下し,その逆も同様である.

このことは,特徴量とニューロンの対応関係が比較的安定していることを示唆している.

3.7節:Qualitative results(定性的結果)

3.7.1項:Interesting neurons(興味深いニューロン)

プロジェクトを通して,我々は多くの興味深いニューロンを発見した.

GPT-4は,「simile」ニューロン,確実性や自信に関連するフレーズのニューロン,物事が正しく行われるためのニューロンなど,見ていて妥当だと思うような自明でないニューロンに対するExplanationsを見つけることができた.

興味深いニューロンを見つけるための一つの成功戦略は,トークン空間のExplanationsでは,活性化ベースのExplanationsと比較してExplanationsが不十分なニューロンを探すことであった.

これにより,特定の文脈で密に活性化する文脈ニューロン[32]と,文書の冒頭の特定の単語で活性化する多くのニューロンを同時に発見することができた.

※我々は特定の文脈で密に活性化する文脈ニューロンを「vibe」(バイブ)ニューロンと呼んでいる.

Explanationの質に依存しないもう一つの関連戦略は,文脈が切り詰められたときに異なる活性化を示す文脈感応性ニューロンを探すことであった.

その結果,現在進行中のリストで確立されたパターンを破るトークンに対して活性化するpattern-breakニューロン(以下,いくつかの文について示す)と,奇妙な単語や切り詰められた単語の後にしばしば活性化するpost-typoニューロンを発見することができた.

我々のExplainerモデルは,興味深い文脈に敏感なニューロンについて正しいExplanationを得ることができない.

例えば,次のトークンが「from」である可能性が高い場合に活性化するニューロンなど,特定の次のトークンと一致する状況で活性化するように見えるニューロンが多数存在することに気づかされた.

当初は,これらのニューロンは他の信号に基づいて次のトークンを予測しているのではと考えた.

しかし,これらのニューロンのいくつかをアブレーションすると,この話とは一致しない.

「from」ニューロンは,「from」が出力される確率をわずかに減少させているように見える.

同時に,「form」という単語のバリエーションが出力される確率を高めており,このニューロンが行っていることの1つは,タイプミスの可能性を考慮することであると考えられる.

このニューロンは後期層(48層中44層)にあるため,ネットワークがすでに「from」という単語を高い確率で出力している状況に対応しているのかもしれない.

まだ十分に調査していないので,何が起こっているのかはっきりしないが,多くのニューロンは,その活性化によって示唆される明らかな機能を果たすのではなく,特定の入力に条件付けられた出力分布の特定の微妙なバリエーションをエンコードしている可能性がある.

我々は,特定の種類の繰り返しに反応するニューロンの興味深い例を発見した.

トークンの繰り返し出現に対して活性化するニューロンを発見し,出現回数に応じてより強い活性化を示した.

多義性ニューロンの興味深い例として,「over and over again」(何度も何度も)というフレーズと「things repeated right before a non-repeated number」(繰り返されない数字の直前に繰り返されるもの)の両方で発火するニューロンがある.

おそらく「over and over again」というフレーズ自体が繰り返しを含んでいるからだと思われる.

また,ある姓を別の姓と組み合わせた場合に,その姓の2回目の言及にほとんど反応すると思われる2つのニューロンも発見した.

これらのニューロンは,誘導尋問に反応している可能性がある[42].

全体的に,より高性能なモデルのニューロンがより興味深いというのが我々の主観的な感覚だが,我々は最新のモデルよりもGPT-2 XLのニューロンを見ることに大半の時間を費やした.

もっと興味深いニューロンを知りたい方は,ニューロンビジュアライゼーションサイトを参照されたい.

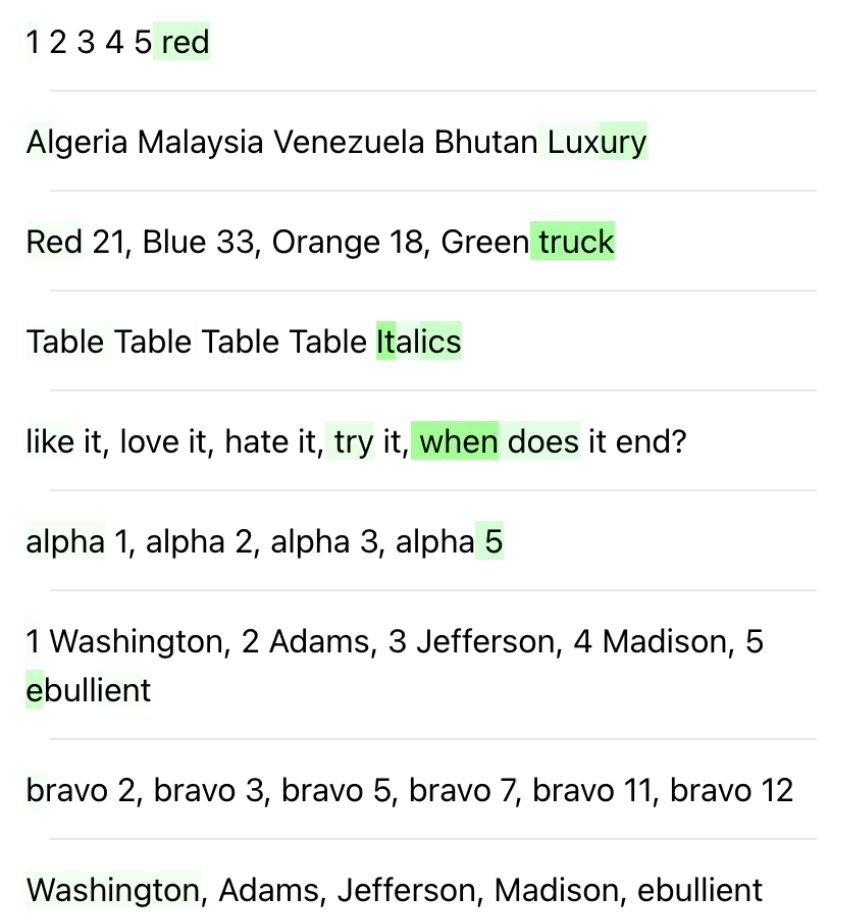

3.7.2項:Explaining constructed puzzles(構築されたパズルのExplanation)

我々のExplanationの方法論を定性的に理解する方法を考えるとき,しばしば2つの問題にぶつかった.

まず,Explanationsやスコアの根拠となる真実がないことである.

人間が書いたExplanationsでも,間違いや,少なくとも行動を完全にExplanationsできていない可能性がある.

さらに,より良いExplanationsが存在するかどうかを判断するのは困難な場合が多い.

第2に,ニューロンがエンコードするパターンの複雑さや種類を制御することはできず,単純なExplanationが存在するという保証もない.

このような欠点に対処するため,我々は「neuron puzzles」(ニューロンパズル)を作成した.

これは,人間が書いたExplanationsとキュレーションした証拠を持つ合成ニューロンである.

ニューロンパズルを作成するには,まず,人間が書いたExplanation(グランドトゥルースとする)を用意する.

次に,テキストの抜粋を収集し,そのトークンにExplanationに従って「活性化」(合成ニューロンであるため,実際のネットワークの活性化には対応しない)のラベルを手動で付ける.

このように,各パズルは,ExplanationとそのExplanationを裏付ける証拠(すなわち,活性化されたテキスト抜粋のセット)から形成される.

Explainerを評価するために,トークンと合成活性化をExplainerに提供し,モデルが生成したExplanationがオリジナルのパズルのExplanationと一致するかどうかを観察する.

パズルの難易度を変えたり,新しいパズルを作ったりして,興味のあるパターンがあるかどうかをテストすることができる.

したがって,これらのパズルのコレクションは,我々のExplainerの技術を反復するための有用な評価となる.

我々は合計19個のパズルを作りました.

その多くは我々や他の人が見つけたニューロンから着想を得たもので,先述した「not all」ニューロンやGPT-2 Largeの「an」予測ニューロンに基づくパズルも含まれている[43].

パズルの例は以下になる.

※訳注:原文の図のPrevとNextボタンを押すと表示が変わります!

各パズルについて,人間がオリジナルのExplanationを復元するのに十分な証拠があることを確認した.

※このパズルをプロジェクトに参加していない研究者に渡したところ,「an」以外の予測パズルをすべて解いた.後から考えると,同じようなエビデンスレベルの次のトークンを予測するパズルを認識できたのだと思われる.

しかし,超人的なExplainer技術を評価するために,人間が一般的に解けないパズルを作ることも考えられる.

我々のベースラインExplainer手法は,19個のパズルのうち5個を解くことができた.

このExplainerは,高い活性化を持つトークンの中から大まかなパターンを見つけ出すことに長けているが,トークンを文脈の中で考えたり,基礎的な知識を適用したりすることには一貫して失敗している.

また,Explainerは否定的な証拠をExplanationsの中に取り込むことも苦手である.

例えば,「incorrect historical years」(歴史的な年号が正しくない)パズルでは,Explainerはニューロンが数字年号で活性化していることを認識しているが,ニューロンが活性化していないテキストの抜粋に数字年号の証拠を取り入れることができない.

このような失敗例は,我々が改訂実験を行う動機となった.

実際,我々の改訂技術をパズルに適用すると,さらに4つのパズルを解くことができた.

また,これらのニューロンパズルは,スコアラーが,現在見つかっているニューロンよりも複雑なニューロンについての提案されたExplanationsを効果的に識別することができるかどうかについての弱いシグナルを提供するものである.

我々は,各パズルのために,一連の誤ったExplanationsを書くことによって,多肢選択式のバージョンを作成した.

例えば,「this neuron responds to important years in American or European history」(このニューロンはアメリカやヨーロッパの歴史の重要な年に回答する)というのは,「incorrect historical years」(誤った歴史年号)のパズルのための偽のExplanationだった.

偽のExplanationsの1つは,常に,高い活性化を持つ3つの最も一般的なトークンのベースラインである.

各パズルについて,そのパズルのシーケンスと活性化について,グランドトゥルースのExplanationとすべての偽のExplanationsをスコアし,グランドトゥルースのExplanationが最も高いスコアを獲得した回数を記録する.

16/19のパズルでは,グランドトゥルースのExplanationが最も高く,18/19のパズルでは,グランドトゥルースのExplanationがトップ2位にランクインしている.

Explainerが解いたパズルが5/19であることと比較すると,この評価から,現在,Explainerはスコアラーよりもボトルネックになっていることが示唆された.

これは,パターンを検出することが,Explanationが与えられたパターンを検証することよりも難しいという事実を反映していると考えられる.

しかし,このシミュレータには系統的なエラーもある.

例えば,「words related to Canada」(カナダに関連する単語)のような孤立したトークンを見るだけのパターンのシミュレーションは得意だが,位置情報を含むパターンや,ある量を正確に把握するパターンのシミュレーションは困難なことが多い.

例えば,「an」ニューロン(「文中の「an」という単語が続きそうな位置に対して活性化するニューロン」)をシミュレーションしたところ,非常に多くの偽陽性を示す結果となった.

我々が構築したニューロンパズルを試すためのコードを公開している.

4章:Discussion(ディスカッション)

4.1節:Limitations and caveats(制限と注意事項)

我々の方法にはいくつかの制限があり,将来の研究で対処できることを期待している.

4.1.1項:Neurons may not be explainable(ニューロンはExplainableではないかもしれない)

我々の研究は,ニューロンの動作が短い自然言語のExplanationで要約できることを前提としている.

この仮定は,多くの理由で問題がある可能性がある.

ニューロンは多くの特徴を表すことができる

これまでの研究で,ニューロンは計算の単位として特権的でない可能性が示唆されている[44].

特に,複数の意味概念に対応する多義的なニューロンが存在する可能性がある[25][26].

我々のExplanation技術は,「X and sometimes Y」(Xと時々Y)のようなExplanationsを生成することは可能であり,また実際に生成しているが,多義性の複雑な事例を捉えるには適していない.

トップ活性化データセットの例を分析することは,過去の研究で実際に有用であることが証明されているが[45][12],潜在的に解釈可能性の錯覚をもたらす可能性もある[46].

トップ活性化に焦点を当てることで,極端な活性化におけるニューロンの動作の最も重要な側面にモデルを集中させ,ニューロンが異なる動作をする可能性のある低いパーセンタイルではモデルを集中させないことを意図している.

多義性の低減や回避のためのアプローチとして,ニューロン空間[47]に何らかの因数分解を適用する方法(NMF[48][49],SVD[50][51],辞書学習[52]など)があることは,今回検討しなかった.

これは,方向性の発見や解釈可能なモデルの訓練と相補的な関係にあると考えられる.

エイリアンの特徴

さらに,言語モデルは,人間が言葉を持たない異質な概念を表現することもある.

これは,言語モデルが異なるもの,例えば次のトークン予測タスクに有用な統計的構成要素に関心を持つため,あるいは,モデルが人間がまだ発見していない自然な抽象化,例えば異なるドメインにおける類似概念のファミリーを発見したために起こり得る.

4.1.2項:We explain correlations, not mechanisms(メカニズムではなく,相関関係をExplanationsする)

我々は現在,ネットワーク入力と解釈されるニューロンとの間の相関を固定分布でExplanationsしている.

過去の研究により,これは両者の間の因果的な振る舞いを反映していない可能性があることが示唆されている[53][45].

また,我々のExplanationsは,機械論的なレベルで動作の原因をExplanationsしていないため,我々の理解が誤って一般化される可能性がある.

希少なモデルや分布外のモデルの挙動を予測するためには,モデルをより機械的に理解する必要があるかもしれない.

4.1.3項:Simulations may not reflect human understanding(シミュレーションは人間の理解を反映しない可能性がある)

我々のスコア方法は,理想的な人間がExplanationに対してどのように回答するかをシミュレータモデルが忠実に再現していることに依存している.

しかし,実際には,シミュレータモデルは,人間が拾わないようなExplanationsの側面を拾っている可能性がある.

最悪の場合,Explainerモデルとシミュレータモデルは,Explanationsの際に暗黙のうちにある種のステガノグラフィ(steganography)[54]を行っている可能性がある.

例えば,Explainerモデルとシミュレータモデルの両方が,同じ偽の特徴を実際の特徴と混同している場合(対象は特徴Xに回答しているのに,ExplainerはYと偽り,シミュレーションはたまたまXを高く評価している可能性がある),このようなことが起こり得る.

理想的には,人間のシミュレーションラベルを模倣するようにシミュレータモデルを訓練することで,これを軽減することができる.

将来的には,このような方法を採用する予定である.

これはまた,我々のシミュレーションの品質を向上させ,モデルをプロンプトする方法を簡素化する可能性がある.

4.1.4項:Limited hypothesis space(限られた仮説空間)

Transformerモデルをより完全に理解するためには,単一ニューロンの解釈から回路の解釈へと移行する必要がある[25][1][10][55].

これは,ニューロンの下流効果に関する仮説,Attention Headsやロジットに関する仮説,複数の入力と出力を伴う仮説などを含むことを意味する.

最終的には,解釈可能性の研究者がそうであるように,Explainerモデルも豊富な仮説の空間から導き出されるようになるだろう.

4.1.5項:Computational requirements(計算上の要件)

我々の方法論は,かなり計算量が多い.

対象モデルの活性化数(ニューロン,Attention Headの次元,残差の次元)は,\(\mathcal{O}(n^{2/3})\)としておおよそスケールし,ここでnは対象モデルパラメータの数である.

各活性化を解釈するために一定数のフォワードパスを使用する場合,対象モデルとExplainerモデルが同じサイズである場合,全体の計算量は\(\mathcal{O}(n^{5/3})\)のようにスケールする.

一方,このことは,事前訓練そのものと比較すると,おそらく有利である.

もし,事前訓練がパラメータに対してほぼ線形にデータをスケーリングする場合[56],\(\mathcal{O}(n^2)\)の計算を行うことになる.

4.1.6項:Context Length(コンテキストの長さ)

もう一つの計算上の問題は,コンテキストの長さである.

現在の手法では,Explainerモデルは,対象モデルに渡されるテキスト抜粋の少なくとも2倍の長さのコンテキストを持つ必要がある.

つまり,Explainerモデルと対象モデルのコンテキストの長さが同じであった場合,対象モデルの行動をExplanationsできるのは,コンテキストの長さの最大半分までであり,後のトークンでしか現れない行動を捕捉できない可能性がある.

4.1.7項:Tokenization issues(トークン化の課題)

トークン化によって,我々の方法論に問題が生じることがいくつかある.

- Explainerモデルと対象モデルは,異なるトークン化スキームを使用することができる.活性化データセットのトークンは対象モデルの推論によるもので,そのモデルのトークン化スキームが使用される.関連する文字列がExplainerモデルに送信されるプロンプトに表示されるとき,それらは複数のトークンに分割されるか,Explainerモデルにとって与えられたテキスト抜粋に自然に表示されない部分トークンである可能性がある.

- バイトペアエンコーダを使用しているため,トークンを1つずつモデルに供給すると,トークンが文字として感覚的に表示できないことがある.個々のトークンをデコードすることに意味があると仮定したが,必ずしもそうとは限らない.原理的には,対象とExplainerモデルのエンコードが同じであれば,正しいトークンを使うことができたが,今回の作業ではそれを怠ってしまった.

- トークンとそれに対応する活性化の間にはデリミタ(区切り文字)を使用する.理想的には,Explainerモデルはトークン,デリミタ,活性化をそれぞれ別のトークンと見なすことである.しかし,これらが融合しないことを保証することはできない.実際,タブ区切り記号は改行記号と融合してしまい,アシスタントのタスクを難しくしている可能性がある.

このようなトークン化の癖が,オリジナルのテキストにどのようなトークンが含まれているかというモデルの理解に影響を与える限り,Explanationsやシミュレーションの質を低下させる可能性がある.

4.2節:Outlook(展望)

我々の手法の現在のバージョンには多くの制限があることを解説したが,我々の研究は大きく改善でき,他の既存のアプローチと効果的に統合できると信じている.

例えば,多義性についての研究が成功すれば,直ちに我々の手法でより高いスコアを得ることができる.

逆に,ニューロンの挙動を分布全体にわたってカバーする複数のExplanationsを見つけようとしたり,残差ストリームで解釈可能な方向のセットを見つけるために最適化したりすることで,我々の手法は重ね合わせに関する理解を深めることができる(おそらく辞書学習などのアプローチと組み合わせる).

また,Attention Headsの研究,検証のためのアブレーションの使用など,より幅広い一般的な解釈可能性の技術を自動化された方法論に統合できることを期待している.

思考の連鎖(chain-of-thought)の方法,ツールの使用法,会話アシスタントの改善も,Explanationsの改善に利用できる.

長期的には,Explainerモデルは,今日の解釈可能性の研究者のように,対象モデルに関する豊富な仮説空間を生成し,テストし,反復することができると想定している.

これには,回路の機能に関する仮説や,分布外動作に関する仮説が含まれる.

Explainerモデルの環境には,コード実行,対象モデルの視覚化,研究者との対話などのツールへのアクセスが含まれる.

このようなモデルは,専門家の反復学習や強化学習を使って訓練し,シミュレータや判定モデルが報酬を設定することができる.

また,競合する2つのアシスタントモデルがExplanationsを提案し,互いのExplanationsを批評する,ディベートによる訓練も可能である.

我々は,我々の方法が,変換言語モデル内部で何が起こっているのかのhigh-level picture(訳注:高レベル(おおまか)な全体像)の理解に貢献し始めることができると信じている.

Explanationsのデータベースにアクセスできるユーザインターフェースは,研究者が何千,何百万ものニューロンを視覚化して,それら全体のハイレベルなパターンを見るのに役立つ,よりマクロに焦点を当てたアプローチを可能にするかもしれない.

報酬モデルにおける顕著な特徴量の検出や,ファインチューニングされたモデルとそのベースモデルとの間の質的な変化の理解など,単純なアプリケーションについてもすぐに進展させることができるかもしれない.

最終的には,言語モデルの監査[3]をアシスタントするために,自動解釈可能性を利用できるようにしたいと考えている.

そこでは,モデルのミスアラインメントを検出し,理解することを試みる.

特に重要なのは,目標の誤般化や欺瞞的なアライメントを検出することである[57][58][59].

評価時にはアライメントされたモデルが,デプロイ時には異なる目標を追求するような場合である.

このためには,すべての内部動作を徹底的に理解する必要がある.

また,アシスタント自体が信頼できるかどうかがわからない場合,強力なモデルをアシストに使うのは複雑なことになるかもしれない.

我々は,より小さな信頼できるモデルをアシスタントに使うことで,完全な解釈可能性監査にスケールアップするか,これらのモデルを解釈可能性に適用することで,モデルがどのように機能するかについて十分に学ぶことができ,より強固な監査手法の開発に役立てることができる.

この研究は,強力なモデルを用いてアライメント研究者をアシスタントするという,OpenAIの広範なアライメント計画の具体的な事例を示すものである[60].

将来的には,より複雑で高性能なモデルを包括的に理解するために,解釈可能性を拡大する第一歩となることを期待している.

References(参考文献)

- Interpretability in the Wild: a Circuit for Indirect Object Identification in GPT-2 small

Wang, K., Variengien, A., Conmy, A., Shlegeris, B. and Steinhardt, J., 2022. arXiv preprint arXiv:2211.00593. - A Toy Model of Universality: Reverse Engineering How Networks Learn Group Operations

Chughtai, B., Chan, L. and Nanda, N., 2023. arXiv preprint arXiv:2302.03025. - Automating Auditing: An ambitious concrete technical research proposal [link]

Hubinger, E., 2021. - CLIP-Dissect: Automatic Description of Neuron Representations in Deep Vision Networks

Oikarinen, T. and Weng, T., 2022. arXiv preprint arXiv:2204.10965. - The Singular Value Decompositions of Transformer Weight Matrices are Highly Interpretable [link]

Millidge, B. and Black, S., 2022. - Describing differences between text distributions with natural language

Zhong, R., Snell, C., Klein, D. and Steinhardt, J., 2022. International Conference on Machine Learning, pp. 27099--27116. - Explaining patterns in data with language models via interpretable autoprompting

Singh, C., Morris, J.X., Aneja, J., Rush, A.M. and Gao, J., 2022. arXiv preprint arXiv:2210.01848. - GPT-4 Technical Report

OpenAI,, 2023. arXiv preprint arXiv:2303.08774. - Network dissection: Quantifying interpretability of deep visual representations

Bau, D., Zhou, B., Khosla, A., Oliva, A. and Torralba, A., 2017. Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 6541--6549. - Causal scrubbing: a method for rigorously testing interpretability hypotheses [link]

Chan, L., Garriga-Alonso, A., Goldowsky-Dill, N., Greenblatt, R., Nitishinskaya, J., Radhakrishnan, A., Shlegeris, B. and Thomas, N., 2022. - Natural language descriptions of deep visual features

Hernandez, E., Schwettmann, S., Bau, D., Bagashvili, T., Torralba, A. and Andreas, J., 2022. International Conference on Learning Representations. - Softmax Linear Units

Elhage, N., Hume, T., Olsson, C., Nanda, N., Henighan, T., Johnston, S., ElShowk, S., Joseph, N., DasSarma, N., Mann, B., Hernandez, D., Askell, A., Ndousse, K., Jones, A., Drain, D., Chen, A., Bai, Y., Ganguli, D., Lovitt, L., Hatfield-Dodds, Z., Kernion, J., Conerly, T., Kravec, S., Fort, S., Kadavath, S., Jacobson, J., Tran-Johnson, E., Kaplan, J., Clark, J., Brown, T., McCandlish, S., Amodei, D. and Olah, C., 2022. Transformer Circuits Thread. - Language models are unsupervised multitask learners

Radford, A., Wu, J., Child, R., Luan, D., Amodei, D., Sutskever, I. and others,, 2019. OpenAI blog, Vol 1(8), pp. 9. - Activation atlas

Carter, S., Armstrong, Z., Schubert, L., Johnson, I. and Olah, C., 2019. Distill, Vol 4(3), pp. e15. - The language interpretability tool: Extensible, interactive visualizations and analysis for NLP models

Tenney, I., Wexler, J., Bastings, J., Bolukbasi, T., Coenen, A., Gehrmann, S., Jiang, E., Pushkarna, M., Radebaugh, C., Reif, E. and others,, 2020. arXiv preprint arXiv:2008.05122. - Neuroscope [link]

Nanda, N.. - Visualizing higher-layer features of a deep network

Erhan, D., Bengio, Y., Courville, A. and Vincent, P., 2009. University of Montreal, Vol 1341(3), pp. 1. - Understanding neural networks through deep visualization

Yosinski, J., Clune, J., Nguyen, A., Fuchs, T. and Lipson, H., 2015. arXiv preprint arXiv:1506.06579. - Feature Visualization

Olah, C., Mordvintsev, A. and Schubert, L., 2017. Distill. DOI: 10.23915/distill.00007 - Gaussian error linear units (gelus)

Hendrycks, D. and Gimpel, K., 2016. arXiv preprint arXiv:1606.08415. - Causal mediation analysis for interpreting neural nlp: The case of gender bias

Vig, J., Gehrmann, S., Belinkov, Y., Qian, S., Nevo, D., Sakenis, S., Huang, J., Singer, Y. and Shieber, S., 2020. arXiv preprint arXiv:2004.12265. - Locating and editing factual associations in GPT

Meng, K., Bau, D., Andonian, A. and Belinkov, Y., 2022. Advances in Neural Information Processing Systems, Vol 35, pp. 17359--17372. - Training language models to follow instructions with human feedback

Ouyang, L., Wu, J., Jiang, X., Almeida, D., Wainwright, C., Mishkin, P., Zhang, C., Agarwal, S., Slama, K., Ray, A. and others,, 2022. Advances in Neural Information Processing Systems, Vol 35, pp. 27730--27744. - Glu variants improve transformer

Shazeer, N., 2020. arXiv preprint arXiv:2002.05202. - Zoom In: An Introduction to Circuits

Olah, C., Cammarata, N., Schubert, L., Goh, G., Petrov, M. and Carter, S., 2020. Distill. DOI: 10.23915/distill.00024.001 - Toy Models of Superposition

Elhage, N., Hume, T., Olsson, C., Schiefer, N., Henighan, T., Kravec, S., Hatfield-Dodds, Z., Lasenby, R., Drain, D., Chen, C., Grosse, R., McCandlish, S., Kaplan, J., Amodei, D., Wattenberg, M. and Olah, C., 2022. Transformer Circuits Thread. - AI safety via debate

Irving, G., Christiano, P. and Amodei, D., 2018. arXiv preprint arXiv:1805.00899. - interpreting GPT: the logit lens [link]

nostalgebraist,, 2020. - Analyzing transformers in embedding space

Dar, G., Geva, M., Gupta, A. and Berant, J., 2022. arXiv preprint arXiv:2209.02535. - Chain of thought prompting elicits reasoning in large language models

Wei, J., Wang, X., Schuurmans, D., Bosma, M., Chi, E., Le, Q. and Zhou, D., 2022. arXiv preprint arXiv:2201.11903. - Self-critiquing models for assisting human evaluators

Saunders, W., Yeh, C., Wu, J., Bills, S., Ouyang, L., Ward, J. and Leike, J., 2022. arXiv preprint arXiv:2206.05802. - Finding Neurons in a Haystack: Case Studies with Sparse Probing

Gurnee, W., Nanda, N., Pauly, M., Harvey, K., Troitskii, D. and Bertsimas, D., 2023. arXiv preprint arXiv:2305.01610. - Problems of monetary management: the UK experience in papers in monetary economics

Goodhart, C., 1975. Monetary Economics, Vol 1. - Scaling Laws for Reward Model Overoptimization

Gao, L., Schulman, J. and Hilton, J., 2022. - Eliciting latent knowledge: How to tell if your eyes deceive you [link]

Christiano, P., Cotra, A. and Xu, M., 2021. - Chris Olah’s views on AGI safety [link]

Hubinger, E., 2019. - Language models are few-shot learners

Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J.D., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., Askell, A. and others,, 2020. Advances in neural information processing systems, Vol 33, pp. 1877--1901. - Input switched affine networks: An rnn architecture designed for interpretability

Foerster, J.N., Gilmer, J., Sohl-Dickstein, J., Chorowski, J. and Sussillo, D., 2017. International conference on machine learning, pp. 1136--1145. - Re-training deep neural networks to facilitate Boolean concept extraction

Gonzalez, C., Loza Menc{\'\i}a, E. and Furnkranz, J., 2017. Discovery Science: 20th International Conference, DS 2017, Kyoto, Japan, October 15--17, 2017, Proceedings 20, pp. 127--143. - Spine: Sparse interpretable neural embeddings

Subramanian, A., Pruthi, D., Jhamtani, H., Berg-Kirkpatrick, T. and Hovy, E., 2018. Proceedings of the AAAI conference on artificial intelligence, Vol 32(1). - Learning effective and interpretable semantic models using non-negative sparse embedding

Murphy, B., Talukdar, P. and Mitchell, T., 2012. Proceedings of COLING 2012, pp. 1933--1950. - In-context Learning and Induction Heads

Olsson, C., Elhage, N., Nanda, N., Joseph, N., DasSarma, N., Henighan, T., Mann, B., Askell, A., Bai, Y., Chen, A., Conerly, T., Drain, D., Ganguli, D., Hatfield-Dodds, Z., Hernandez, D., Johnston, S., Jones, A., Kernion, J., Lovitt, L., Ndousse, K., Amodei, D., Brown, T., Clark, J., Kaplan, J., McCandlish, S. and Olah, C., 2022. Transformer Circuits Thread. - We Found An Neuron in GPT-2 [link]

Miller, J. and Neo, C., 2023. - Intriguing properties of neural networks

Szegedy, C., Zaremba, W., Sutskever, I., Bruna, J., Erhan, D., Goodfellow, I. and Fergus, R., 2013. arXiv preprint arXiv:1312.6199. - Curve Detectors

Cammarata, N., Goh, G., Carter, S., Schubert, L., Petrov, M. and Olah, C., 2020. Distill. DOI: 10.23915/distill.00024.003 - An interpretability illusion for bert

Bolukbasi, T., Pearce, A., Yuan, A., Coenen, A., Reif, E., Viegas, F. and Wattenberg, M., 2021. arXiv preprint arXiv:2104.07143. - The Building Blocks of Interpretability

Olah, C., Satyanarayan, A., Johnson, I., Carter, S., Schubert, L., Ye, K. and Mordvintsev, A., 2018. Distill. DOI: 10.23915/distill.00010 - Learning the parts of objects by non-negative matrix factorization

Lee, D.D. and Seung, H.S., 1999. Nature, Vol 401(6755), pp. 788--791. Nature Publishing Group UK London. - Nonnegative matrix factorization with mixed hypergraph regularization for community detection

Wu, W., Kwong, S., Zhou, Y., Jia, Y. and Gao, W., 2018. Information Sciences, Vol 435, pp. 263--281. Elsevier. - Svcca: Singular vector canonical correlation analysis for deep learning dynamics and interpretability

Raghu, M., Gilmer, J., Yosinski, J. and Sohl-Dickstein, J., 2017. Advances in neural information processing systems, Vol 30. - The Singular Value Decompositions of Transformer Weight Matrices are Highly Interpretable [link]

Millidge, B. and Black, S., 2022. - Taking features out of superposition with sparse autoencoders [link]

Sharkey, L., Braun, D. and Millidge, B., 2022. - On interpretability and feature representations: an analysis of the sentiment neuron

Donnelly, J. and Roegiest, A., 2019. Advances in Information Retrieval: 41st European Conference on IR Research, ECIR 2019, Cologne, Germany, April 14--18, 2019, Proceedings, Part I 41, pp. 795--802. - Cyclegan, a master of steganography

Chu, C., Zhmoginov, A. and Sandler, M., 2017. arXiv preprint arXiv:1712.02950. - N2G: A Scalable Approach for Quantifying Interpretable Neuron Representations in Large Language Models

Foote, A., Nanda, N., Kran, E., Konstas, I. and Barez, F.. ICLR 2023 Workshop on Trustworthy and Reliable Large-Scale Machine Learning Models. - Training compute-optimal large language models

Hoffmann, J., Borgeaud, S., Mensch, A., Buchatskaya, E., Cai, T., Rutherford, E., Casas, D.d.L., Hendricks, L.A., Welbl, J., Clark, A. and others,, 2022. arXiv preprint arXiv:2203.15556. - Goal Misgeneralization: Why Correct Specifications Aren't Enough For Correct Goals

Shah, R., Varma, V., Kumar, R., Phuong, M., Krakovna, V., Uesato, J. and Kenton, Z., 2022. - The alignment problem from a deep learning perspective

Ngo, R., Chan, L. and Mindermann, S., 2023. - Risks from Learned Optimization in Advanced Machine Learning Systems

Hubinger, E., Merwijk, C.v., Mikulik, V., Skalse, J. and Garrabrant, S., 2021. - Our approach to alignment research [link]

Leike, J., Schulman, J. and Wu, J., 2022.

まとめ

Language models can explain neurons in language modelsの日本語訳を紹介しました.

OpenAIの「言語モデルのニューロンを言語モデルで説明できる」という主張がわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.