Gemini: A Family of Highly Capable Multimodal Modelsの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Assembler (x64,ARM).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Gemini: A Family of Highly Capable Multimodal Modelsの日本語訳を紹介します.

グーグルのGeminiがわかります.

※図表を含む論文の著作権はGemini: A Family of Highly Capable Multimodal Modelsの著者に帰属します.

Gemini: A Family of Highly Capable Multimodal Modelsの目次は以下になります.

- Abstract

- 1章:Introduction

- 2章:Model Architecture

- 3章:Training Infrastructure

- 4章:Training Dataset

- 5章:Evaluation

- 6章:Responsible Deployment

- 7章:Discussion and Conclusion

- References

- 8章:Contributions and Acknowledgments

- 9章:Appendix

Gemini: A Family of Highly Capable Multimodal Modelsを解説しつつ,私の考えも語ります.

Gemini: A Family of Highly Capable Multimodal Modelsの概要と私の日本語訳は以下になります.

This report introduces a new family of multimodal models, Gemini, that exhibit remarkable capabilities across image, audio, video, and text understanding.

本レポートでは,画像,音声,ビデオ,テキスト理解において卓越した能力を発揮するマルチモーダルモデルの新ファミリー「Gemini」を紹介する.The Gemini family consists of Ultra, Pro, and Nano sizes, suitable for applications ranging from complex reasoning tasks to on-device memory-constrained use-cases.

GeminiファミリーはUltra,Pro,Nanoサイズで構成され,複雑な推論タスクからデバイス上のメモリに制約のあるユースケースまで幅広いアプリケーションに適している.Evaluation on a broad range of benchmarks shows that our most-capable Gemini Ultra model advances the state of the art in 30 of 32 of these benchmarks — notably being the first model to achieve human-expert performance on the well-studied exam benchmark MMLU, and improving the state of the art in every one of the 20 multimodal benchmarks we examined.

広範なベンチマークを評価した結果,我々の最も能力の高いGemini Ultraモデルは,32のベンチマークのうち30において最先端技術を進歩させたことが分かった.特に,よく研究された試験ベンチマークMMLUにおいて,人間の専門家によるパフォーマンスを達成した最初のモデルであり,我々が調査した20のマルチモーダルベンチマークのすべてにおいて最先端技術を改善した.We believe that the new capabilities of Gemini models in cross-modal reasoning and language understanding will enable a wide variety of use cases and we discuss our approach toward deploying them responsibly to users.

我々は,クロスモーダル推論と言語理解におけるGeminiモデルの新しい能力は,様々なユースケースを可能にすると信じており,ユーザに責任を持ってデプロイするための我々のアプローチについて議論する.https://paperswithcode.com/paper/gemini-a-family-of-highly-capable-multimodal

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Contributions and Acknowledgments」(貢献と謝辞)は省略していること

- 本文中に登場する表記「(Anil et al., 2023; Brown et al., 2020; Chowdhery et al., 2023; Hoffmann et al., 2022; OpenAI, 2023a; Radford et al., 2019; Rae et al., 2021)」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Gemini: A Family of Highly Capable Multimodal Modelsの本文を読みすすめましょう!

1章:Introduction(はじめに)

我々は,Googleで開発された非常に高性能なマルチモーダルモデルファミリーであるGeminiを紹介する.

Geminiは,画像,音声,動画,テキストデータに対して共同で訓練させ,モダリティを横断する強力なジェネラリスト能力と,それぞれのドメインにおける最先端の理解・推論性能を併せ持つモデルを構築することを目的としている.

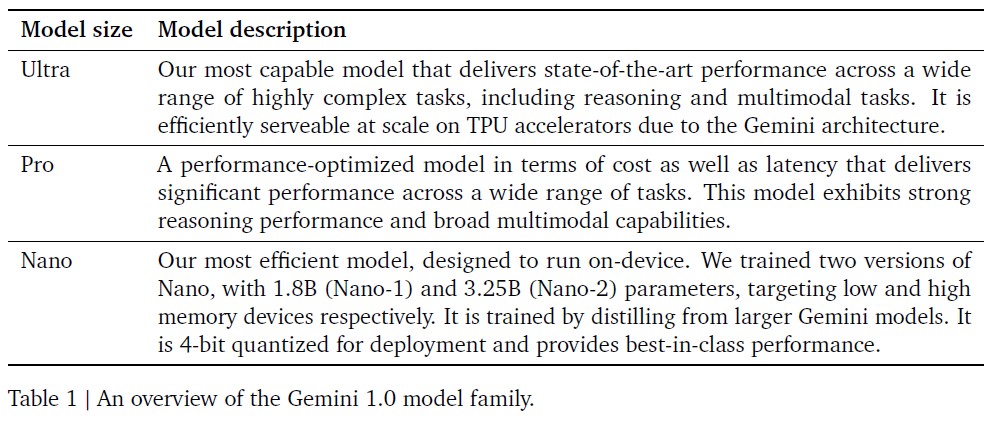

最初のバージョンであるGemini 1.0には3つのサイズがある.

高度に複雑なタスク向けのUltra,拡張されたパフォーマンスと大規模なデプロイが可能なPro,そしてオンデバイスアプリケーション向けのNanoである.

各サイズは,異なる計算限界とアプリケーション要件に対応するように特別に調整されている.

我々は,言語,コーディング,推論,およびマルチモーダルタスクの広い範囲をカバーする,内部および外部の包括的な一連のベンチマークでGeminiモデルの性能を評価している.

Geminiは,大規模言語モデリング(Anil et al., 2023; Brown et al., 2020; Chowdhery et al., 2023; Hoffmann et al., 2022; OpenAI, 2023a; Radford et al., 2019; Rae et al., 2021),画像理解(Alayrac et al., 2022; Chen et al., 2022; Dosovitskiy et al., 2020; OpenAI, 2023b; Reed et al., 2022; Yu et al., 2022a),音声処理(Radford et al., 2023; Zhang et al., 2023),ビデオ理解(Alayrac et al., 2022; Chen et al., 2023)の最先端を前進させる.

また,シーケンスモデル(Sutskever et al., 2014),ニューラルネットワークに基づくディープラーニング(LeCun et al., 2015),大規模訓練を可能にする機械学習分散システム(Barham et al., 2022; Bradbury et al., 2018; Dean et al., 2012)の長い歴史も基盤となっている.

我々の最も有能なモデルであるGemini Ultraは,我々が報告する32のベンチマークのうち30において新しい最先端の結果を達成した.

そのベンチマークには,人気のあるテキストと推論のベンチマーク12個中の10個,画像理解のベンチマーク9個中の9個,ビデオ理解のベンチマーク6個中の6個,音声認識と音声翻訳のベンチマーク5個中の5個が含まれる.

Gemini Ultraは,MMLU(Hendrycks et al., 2021a)(一連の試験を通じて知識と推論をテストする著名なベンチマーク)において,90%を超えるスコアで人間の専門家によるパフォーマンスを達成した最初のモデルである.

テキストだけでなく,Gemini Ultraは難易度の高いマルチモーダル推論タスクにおいても顕著な進歩を遂げている.

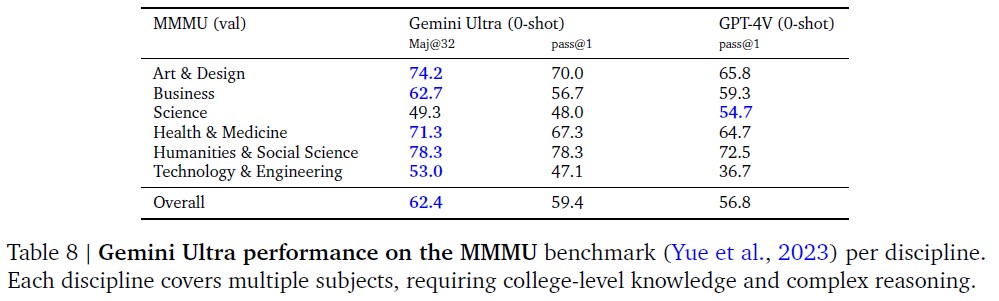

例えば,最近のMMMUベンチマーク(Yue et al., 2023)では,画像に関する問題で構成され,大学レベルの主題知識と熟慮された推論を必要とする複数分野のタスクにおいて,Gemini Ultraは62.4%という最新のスコアを達成し,以前の最高モデルを5ポイント以上上回った.

また,ビデオ質問回答および音声理解ベンチマークにおいても,一様にパフォーマンスが向上している.

定性的な評価では,印象的なクロスモーダル推論能力が示され,モデルは音声,画像,テキストの入力シーケンスをネイティブに理解し推論することができる(図5と表13を参照).

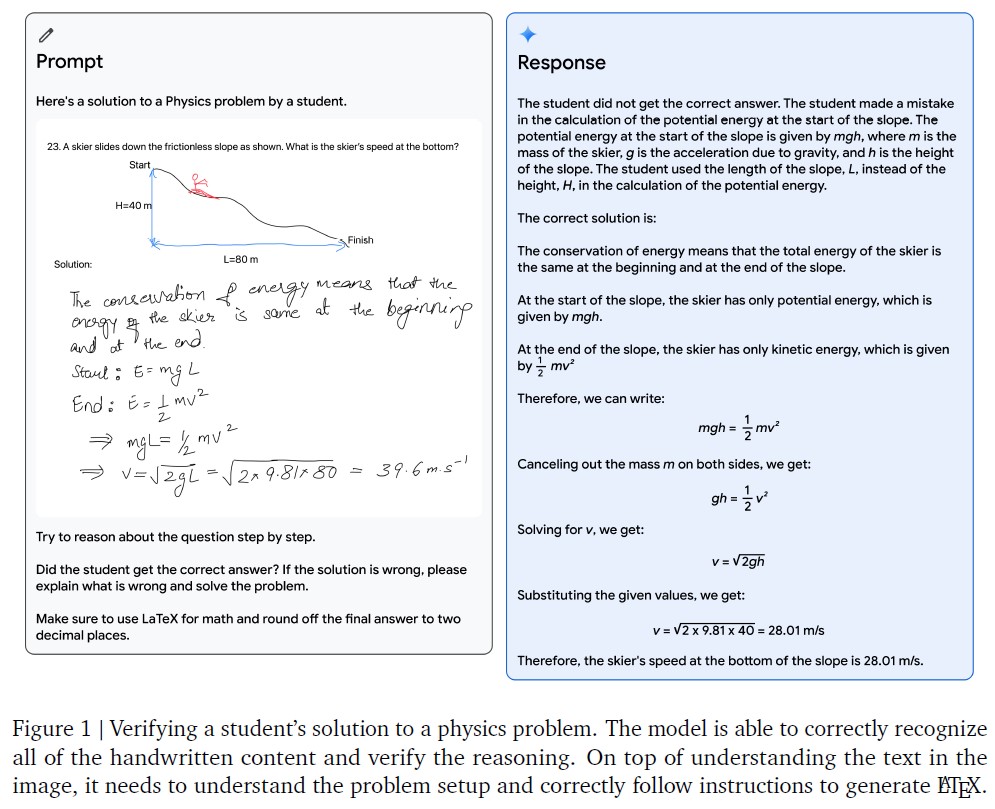

例として,図1に描かれた教育設定を考えてみる.

教師が,スキーヤーが斜面を下るという物理の問題を描き,学生がその解答に取り組んでいる.

Geminiのマルチモーダル推論機能を使用することで,このモデルは,乱雑な手書きを理解し,問題の定式化を正しく理解し,問題と解答の両方を数学的なタイプセットに変換し,学生が問題を解く際に間違った推論の具体的なステップを特定し,そして問題に対する正しい解答を示すことができる.

これは,エキサイティングな教育の可能性を開くものであり,Geminiモデルの新しいマルチモーダルおよび推論機能は,多くの分野にわたって劇的な応用が可能であると信じている.

大規模言語モデルの推論能力は,より複雑なマルチステップ問題に取り組むことができるジェネラリストエージェントの構築に向けて有望である.

AlphaCodeチームは,AlphaCode 2(Leblond et al., 2023)を構築した.

AlphaCode 2は,Geminiの推論機能と検索およびツールの使用を組み合わせた,Geminiを搭載した新しいエージェントであり,競技プログラミング問題を解くことに優れている.

AlphaCode 2は,Codeforces競技プログラミングプラットフォームにおいて上位15%にランクインしている.

これは,上位50%にランクされた最新鋭の前身を大きく上回るものである(Li et al., 2022).

同時に,デバイス上でのデプロイをターゲットとした一連の小型モデルであるGemini Nanoにより,効率的フロンティアを前進させる.

これらのモデルは,要約,読解,テキスト補完タスクなどのオンデバイスタスクに優れており,推論,STEM,コーディング,マルチモーダル,多言語タスクにおいて,そのサイズに比して素晴らしい能力を発揮する.

以下の章では,まずモデルアーキテクチャ,訓練インフラ,訓練データセットの概要を説明する.

次に,Geminiモデルファミリーの詳細な評価について,よく研究されたベンチマークと,テキスト,コード,画像,音声,ビデオにわたる人間による嗜好性評価(英語パフォーマンスと多言語機能の両方を含む)を紹介する.

また,影響評価,モデルポリシーの開発,評価,およびデプロイ決定前の弊害緩和のプロセスなど,責任あるデプロイに対する我々のアプローチについても説明する.

※Gemini Ultraモデルの一般公開に先駆けて,より詳細なレポートを更新する予定である.

最後に,AIにおける研究とイノベーションの新時代への道を切り開く,Geminiの広範な意味合いとその限界,そして潜在的な応用について議論する.

2章:Model Architecture(モデルアーキテクチャ)

GeminiモデルはTransformerデコーダー(Vaswani et al., 2017)の上に構築され,アーキテクチャとモデルの最適化の改善により,大規模で安定した訓練とGoogleのTensor Processing Units上での最適化された推論を可能にする.

これらは,32kの文脈長をサポートするように訓練され,効率的なアテンションメカニズム(例えばマルチクエリーアテンション(Shazeer, 2019))を採用している.

我々の最初のバージョンであるGemini 1.0は,表1で議論されているように,幅広いアプリケーションをサポートするために3つの主要なサイズで構成されている.

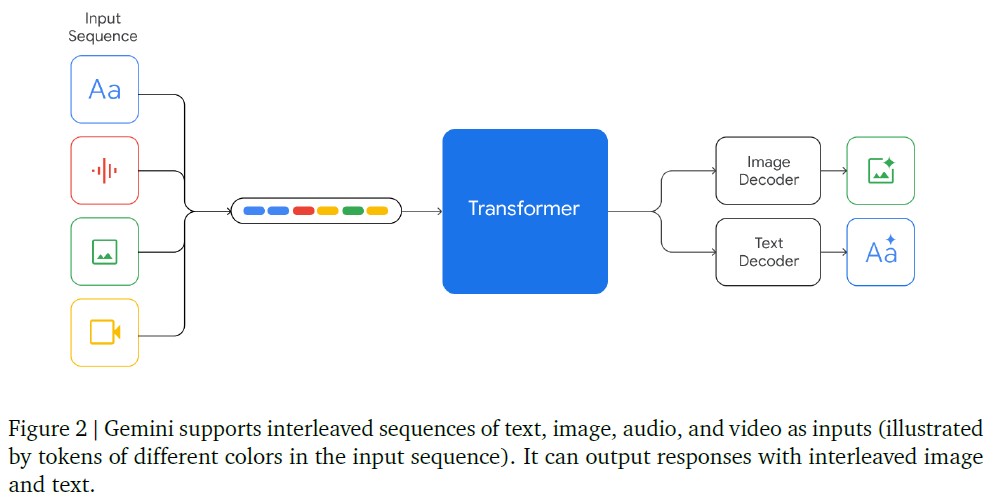

Geminiモデルは,自然画像,チャート,スクリーンショット,PDF,動画など,多種多様な音声・視覚入力を織り交ぜたテキスト入力に対応できるように訓練されており,テキストと画像の出力を生成することができる(図2参照).

Geminiモデルの視覚的エンコーディングは,Flamingo(Alayrac et al., 2022),CoCa(Yu et al., 2022a),PaLI(Chen et al., 2022)に関する我々の基礎研究にインスパイアされている.

ただし,これらのモデルは最初からマルチモーダルであり,離散画像トークン(Ramesh et al., 2021; Yu et al., 2022b)を使ってネイティブに画像を出力できるという重要な違いがある.

ビデオ理解は,ビデオを大きな文脈ウィンドウ内のフレームのシーケンスとしてエンコードすることで達成される.

ビデオフレームや画像は,モデル入力の一部として,テキストや音声と自然にインターリーブすることができる.

モデルは,きめ細かい理解を必要とするタスクにより多くの計算を費やすために,可変の入力解像度を扱うことができる.

さらに,Geminiは,ユニバーサルスピーチモデル(USM:Universal Speech Model)機能(Zhang et al., 2023)から16kHzのオーディオ信号を直接取り込むことができる.

これにより,音声をテキスト入力に素朴にマッピングした場合に通常失われるニュアンスを,モデルで捉えることができる(例えば,ウェブサイトの音声理解デモを参照).

Geminiモデルの訓練には,訓練アルゴリズム,データセット,インフラの革新が必要だった.

Proモデルでは,当社のインフラと学習アルゴリズム固有のスケーラビリティにより,Ultraモデルのリソースのほんの一部を活用して,数週間で事前訓練を完了することができる.

Nanoシリーズのモデルは,蒸留と訓練アルゴリズムのさらなる進歩を活用して,さまざまなタスクに対応するクラス最高の小規模言語モデルを生成する.

要約や読解など,次世代オンデバイス体験の原動力となる.

3章:Training Infrastructure(訓練インフラ)

TPUv5eとTPUv4(Jouppi et al., 2023)を,そのサイズと構成に応じて使い,Geminiモデルを訓練した.

Gemini Ultraの訓練には,複数のデータセンターにまたがるTPUv4アクセラレーターの大規模なフリートを使用した.

これは,我々の以前のフラッグシップモデルであるPaLM-2よりも規模が大きくなったことを意味する.

アクセラレーターの数を増やすと,システム全体のハードウェアの平均故障間隔が短くなる.

我々は計画された再スケジュールやプリエンプションの発生率を最小限に抑えたが,このような大規模なハードウェアアクセラレーターでは,宇宙線などの外的要因によって,本物のマシン故障が発生することはよくあることである(Michalak et al., 2012).

TPUv4アクセラレーターは,4096個のチップからなる「スーパーポッド」に配置され,それぞれが専用の光スイッチに接続され,4x4x4のチップキューブを約10秒で任意の3Dトーラスのトポロジーに動的に再構成することができる(Jouppi et al., 2023).

Gemini Ultraでは,ホットスタンバイとローリングメンテナンスを可能にするため,スーパーポッドごとに少数のキューブを保持することにした.

TPUアクセラレーターは主に高速のチップ間インターコネクトを介して通信するが,Gemini Ultraスケールでは,Googleのクラスタ内ネットワークとクラスタ間ネットワークを使用して,複数のデータセンターでスーパーポッドを組み合わせる(Poutievski et al., 2022; Wetherall et al., 2023; yao Hong et al., 2018).

Googleのネットワークレイテンシーと帯域幅は,スーパーポッド内のモデル並列性とスーパーポッド間のデータ並列性を利用する,一般的に使用される同期訓練パラダイムをサポートするのに十分である.

Jax(Bradbury et al., 2018)とPathways(Barham et al., 2022)の「シングルコントローラー」プログラミングモデルにより,単一のPythonプロセスで訓練実行全体をオーケストレーションできるため,開発ワークフローが劇的に簡素化される.

XLAコンパイラのGSPMDパーティショナー(Xu et al., 2021)は,訓練ステップの計算を分割し,MegaScale XLAコンパイラ(XLA, 2019)は,ステップ時間の変動がほとんどなく,計算と最大に重なるように,適切なコレクティブを静的にスケジュールする.

この大規模で高いgoodputを維持することは,永続的なクラスタストレージに重みを定期的にチェックポイントするという従来のアプローチでは不可能であっただろう.

※goodputは,訓練ジョブの経過時間に対して,有用な新しいステップの計算に費やされた時間と定義する.

Geminiでは,その代わりに,モデル状態の冗長なメモリ内コピーを利用し,予定外のハードウェア障害が発生した場合,無傷のモデルレプリカから直接迅速に復旧する.

PaLMとPaLM-2(Anil et al., 2023)と比較すると,かなり大きな訓練リソースを使用しているにもかかわらず,回復時間が大幅に短縮された.

その結果,最大規模の訓練ジョブの全体的なgoodputは85%から97%に増加した.

前例のない規模での訓練では,必ず新しく興味深いシステム障害モードが表面化する.

今回の例では,「Silent Data Corruption(SDC)」(Dixit et al., 2021; Hochschild et al., 2021; Vishwanathan et al., 2015)に対処する必要があった.

このようなことは極めてまれであるが,Geminiの規模からすると,SDCの事象が1~2週間ごとに訓練に影響を与えることが予想される.

欠陥のあるハードウェアを迅速に検出し除去するためには,決定論的リプレイを利用して不正な計算を分離し,アイドル状態のマシンやホットスタンバイのSDCスキャナをプロアクティブに組み合わせる,いくつかの新しいテクニックが必要だった.

完全に決定論的なインフラのおかげで,Ultraモデルに至るまでの開発期間中に(ハードウェア障害を含む)根本原因を迅速に特定することができた.

これは安定した訓練に向けた重要な要素だった.

4章:Training Dataset(訓練データセット)

Geminiモデルは,マルチモーダルかつ多言語のデータセットで訓練される.

我々の事前訓練データセットは,ウェブドキュメント,書籍,コードのデータを使用し,画像,音声,動画データを含む.

我々は,SentencePieceトークナイザー(Kudo and Richardson, 2018)を使用し,訓練コーパス全体の大きなサンプルでトークナイザーを訓練することで,推測される語彙が改善され,モデルの性能が向上することを発見した.

例えば,Geminiモデルは非ラテン語スクリプトを効率的にトークン化することができ,その結果,モデルの品質だけでなく,訓練や推論の速度にも寄与することがわかった.

最大のモデルの学習に使用されるトークン数は,(Hoffmann et al., 2022)のアプローチに従って決定された.

(Touvron et al., 2023a)で提唱されたアプローチと同様に,与えられた推論バジェットで性能を向上させるために,小さいモデルはかなり多くのトークンで訓練される.

ヒューリスティックルールとモデルベースの分類器の両方を用いて,すべてのデータセットに品質フィルターを適用する.

また,有害なコンテンツを除去するための安全性フィルタリングも行う.

評価セットは訓練コーパスからフィルタリングする.

最終的なデータの混合と重みは,より小さなモデルでのアブレーションによって決定される.

訓練中に混合構成を変化させるために,訓練の終盤にドメインに関連するデータの重みを増加させるような段階的訓練を行っている.

我々は,高性能なモデルにはデータの質が重要であることを発見し,事前訓練に最適なデータセット分布を見つけることに関して多くの興味深い疑問が残されていると考えている.

5章:Evaluation(評価)

Geminiモデルは,テキスト,画像,音声,およびビデオにまたがって共同訓練されるため,ネイティブのマルチモーダルである.

1つの未解決の疑問は,このような共同訓練により,1つのドメインに特化したモデルやアプローチと比較しても,各ドメインで強力な能力を持つモデルが得られるかどうかということである.

我々は,これが事実であることを発見した.

Geminiは,テキスト,画像,オーディオ,ビデオの幅広いベンチマークにおいて,新しい技術的地位を確立している.

5.1節:Text(テキスト)

5.1.1項:Academic Benchmarks(アカデミックベンチマーク)

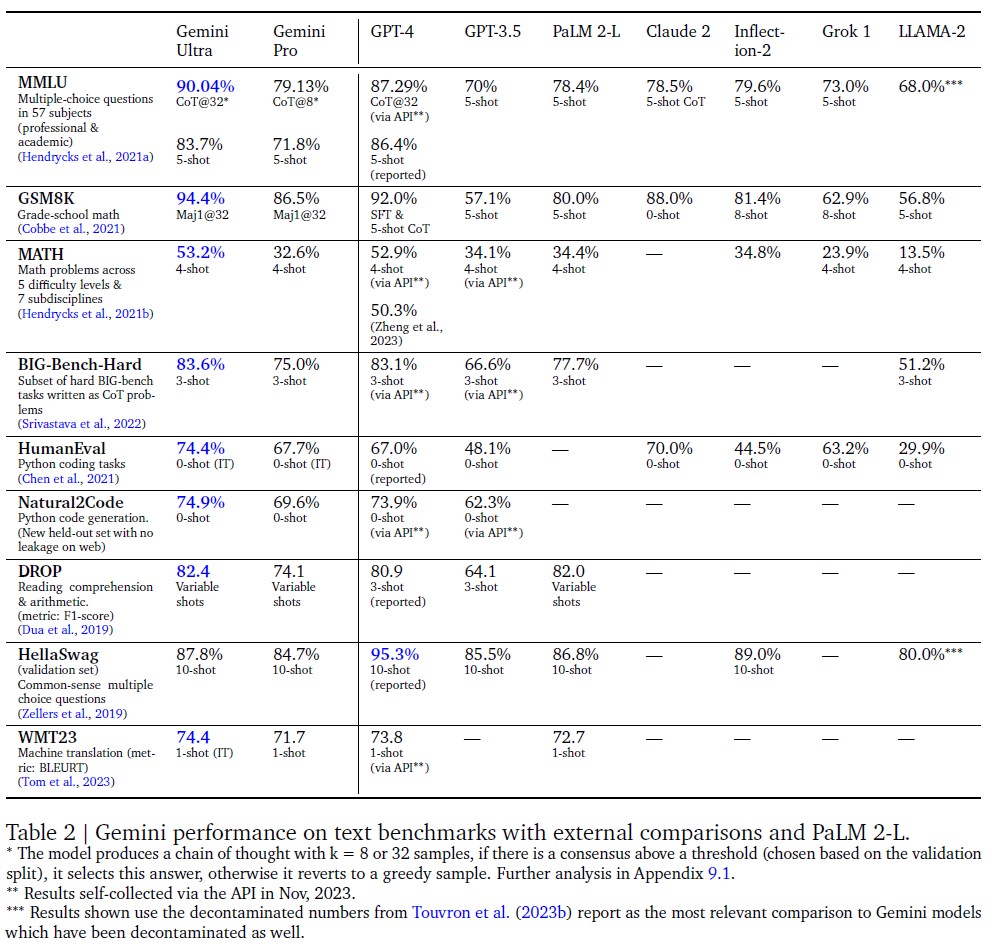

∗:モデルはk = 8または32のサンプルで思考連鎖を生成し,(検証分割に基づいて選択された)閾値以上のコンセンサスがあれば,この答えを選択し,そうでなければ貪欲なサンプルに戻る.さらなる分析は付録9.1参照.

∗∗:結果は2023年11月にAPI経由で自己収集.

∗∗∗:結果は,同様にデコンタミネーションされたGeminiモデルとの最も関連性のある比較として,(Touvron et al., 2023b)のレポートからデコンタミネーションされた数値を使用している.

推論,読解,STEM,コーディングをカバーする一連のテキストベースのアカデミックベンチマークにおいて,Gemini ProとUltraを,一連の外部LLMおよび我々の以前の最高モデルPaLM 2と比較した.

これらの結果を表2に示す.

大まかには,Gemini Proの性能はGPT-3.5のような推論に最適化されたモデルを凌駕し,利用可能な最も高性能なモデルのいくつかと遜色ない性能を発揮していることが分かる.

Gemini Ultraはすべての現行モデルを上回る.

この章では,これらの発見のいくつかを検証する.

MMLU(Hendrycks et al., 2021a)において,Gemini Ultraは90.04%の正解率を達成し,すべての既存モデルを上回ることができた.

MMLUは総合的な試験ベンチマークであり,57科目の知識を測定する.

人間の専門家の性能は,ベンチマーク作成者によって89.8%と評価されており,Gemini Ultraはこの閾値を超えた最初のモデルである(以前の最先端の結果は86.4%).

高いパフォーマンスを達成するためには,読解や推論に加えて,多くの領域(法律,生物学,歴史など)の専門知識が必要とされる.

我々は,Gemini Ultraが,モデルの不確実性を考慮した思考連鎖プロンプトアプローチ(Wei et al., 2022)と組み合わせて使用された場合に,最高の正解率を達成することを発見した.

モデルはk個のサンプル,例えば8個や32個のサンプルで思考の連鎖を生成する.

事前に設定された閾値(検証分割に基づいて選択される)以上のコンセンサスがあれば,この答えを選択し,そうでなければ,思考の連鎖なしに,最尤選択に基づく貪欲なサンプルに戻る.

このアプローチと,思考連鎖プロンプトのみ,または貪欲サンプリングのみとの比較の詳細な内訳については,付録を参照されたい.

モデルの分析能力のベンチマークによく使われる数学の分野では,Gemini Ultraは,初級試験と競技グレードの問題セットの両方で強力な性能を示している.

小学校の数学のベンチマークであるGSM8K(Cobbe et al., 2021)では,Gemini Ultraは,思考連鎖プロンプトと自己一貫性(Wang et al., 2022)を用いて94.4%の正解率を達成した(同じプロンプト技術による前回の最高正解率は92%).

同様の良い傾向は,中高生の数学コンテスト(MATHベンチマーク)から抽出された難易度の高い数学問題でも観察され,Gemini Ultraモデルは,4-Shot Promptを使用して53.2%に達し,すべての競合モデルを凌駕している.

このモデルはまた,American Mathematical Competitions(2022年と2023年の150問)由来のさらに難しい課題においても,最先端の技術を凌駕している.

小型のモデルでは,この難易度の高いタスクではランダムスコアに近い低いスコアしか出せないが,Gemini Ultraは32%の問題を解くことができ,GPT-4の解答率が30%であるのと対照的である.

Gemini Ultraは,現在のLLMの一般的な使用例であるコーディングにおいても優れている.

我々は,多くの従来型および内部ベンチマークでモデルを評価し,AlphaCode 2のようなより複雑な推論システム(複雑な推論システムについては5.1.7項を参照)の一部としての性能も測定した.

例えば,関数記述をPython実装にマッピングする標準的なコード補完ベンチマークであるHumanEval(Chen et al., 2021)では,命令チューニングされたGemini Ultraは74.4%の問題を正しく実装した.

Pythonコード生成タスクのための新しい評価ベンチマークであるNatural2Codeでは(ここではウェブ流出がないことを保証),Gemini Ultraは74.9%の最高スコアを達成した.

これらのベンチマークでの評価は困難であり,データのコンタミネーションによって影響を受ける可能性がある.

ここで報告する結果が可能な限り科学的に確かなものであることを確認するため,訓練後に広範なリークデータ分析を行ったが,それでもいくつかの軽微な問題が見つかったため,例えばLAMBADA(Paperno et al., 2016)の結果は報告しないことにした.

評価プロセスの一環として,一般的なベンチマークであるHellaSwag(Zellers et al., 2019)において,HellaSwag訓練セット(Geminiの事前訓練セットには含まれていない)に対応する特定のWebサイト抽出物に対する100の追加ファインチューニングステップが,1-Shot Promptで測定した場合,Gemini Proの検証正解率を89.6%に,Gemini Ultraの検証正解率を96.0%に向上させることがわかった(APIを介して1-Shot評価した場合,GPT-4は92.3%を得た).

これは,ベンチマーク結果が事前訓練データセットの構成に影響されやすいことを示唆している.

我々はHellaSwagのデコンタミネーションの結果を10-Shot評価設定でのみ報告することにした.

我々は,流出データのない,より頑健でニュアンスのある標準化された評価ベンチマークが必要であると考えている.

そこで,WMT23やMath-AMC 2022-2023のような最近リリースされた新しい評価データセットや,Natural2Codeのような非ウェブソースから内部的に生成されたデータセットでGeminiモデルを評価した.

我々の評価ベンチマークの包括的なリストについては,付録を参照されたい.

たとえそうであっても,これらのベンチマークにおけるモデルの性能は,モデルの能力と,それが実世界のタスクにどのような影響を与えるかを示している.

例えば,Gemini Ultraの優れた推論能力とSTEM能力は,教育分野におけるLLMの進歩に道を開くものである.

※ウェブサイトhttps://deepmind.google/geminiのデモを参照されたい.

複雑な数学的・科学的概念に取り組む能力は,パーソナライズされた学習やインテリジェントな個別指導システムにエキサイティングな可能性を開く.

5.1.2項:Trends in Capabilities(能力の傾向)

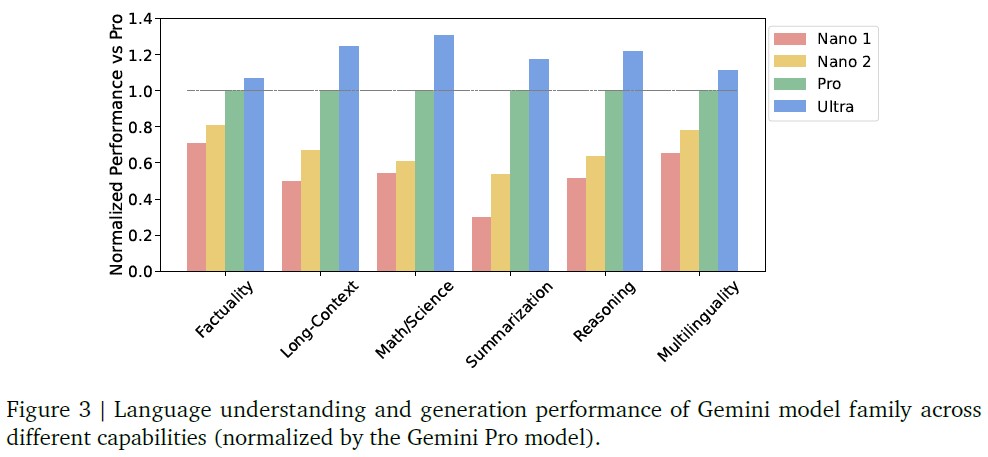

我々は,6つの異なる能力における50以上のベンチマークを総合的に評価することにより,Geminiモデルファミリー全体の能力の傾向を調査する.

最も注目すべきベンチマークのいくつかは前項で述べたとおりである.

これらの能力は以下の通りである.

- Factuality(事実性):オープン/クローズドブック検索と質問応答タスク

- Long-Context:長文要約,検索,質問回答タスク

- Math/Science:数学的問題解決,定理証明,科学的試験などのタスク

- Summarization:要約タスク

※訳注:原文には説明がなかったため,独自に追加しました. - Reasoning:算数,科学,常識的な推論を必要とするタスク

- Multilingual:多言語での翻訳,要約,推論のためのタスク

各能力に含まれるタスクの詳細リストは,付録を参照されたい.

図3では,特に推論,数学/科学,要約,長い文脈において,モデルサイズが大きくなるにつれて一貫した品質の向上が見られる.

Gemini Ultraは,6つの能力すべてにおいて最高のモデルである.

Geminiファミリーの中で2番目に大きなモデルであるGemini Proも,かなり競争力がある一方で,より効率的にサービスを提供することができる.

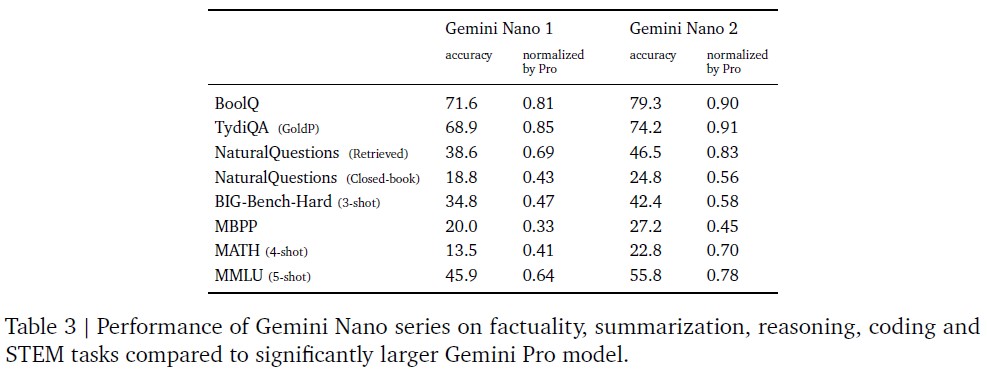

5.1.3項:Nano

AIをユーザにより身近なものにするために,デバイス上にデプロイするために設計されたGemini Nano 1およびNano 2モデルについて説明する.

これらのモデルは,タスクごとのファインチューニングが可能な要約と読解のタスクに優れている.

図3は,これらの事前訓練済みモデルのパフォーマンスを,より大規模なGemini Proモデルと比較して示している.

また,表3は,特定の事実性,コーディング,数学/科学,および推論のタスクに深く掘り下げている.

Nano-1とNano-2のモデルサイズはそれぞれ1.8Bと3.25Bのパラメータしかない.

そのサイズにもかかわらず,事実性,すなわち検索関連のタスクでは非常に強力な性能を示し,推論,STEM,コーディング,マルチモーダル,多言語タスクでは大きな性能を発揮する.

より広範なプラットフォームとデバイスにアクセス可能な新機能により,Geminiモデルは誰にでもアクセシビリティを拡大する.

5.1.4項:Multilinguality(多言語性)

Geminiモデルの多言語能力は,多言語理解,多言語汎化,多言語でのテキスト生成を必要とする様々なタスクを用いて評価される.

これらのタスクには,機械翻訳ベンチマーク(高-中-低リソース翻訳用のWMT 23,低-超低リソース言語用のFlores,NTREX),要約ベンチマーク(XLSum,Wikilingua),一般的なベンチマークの翻訳版(MGSM:専門的に11言語に翻訳)が含まれる.

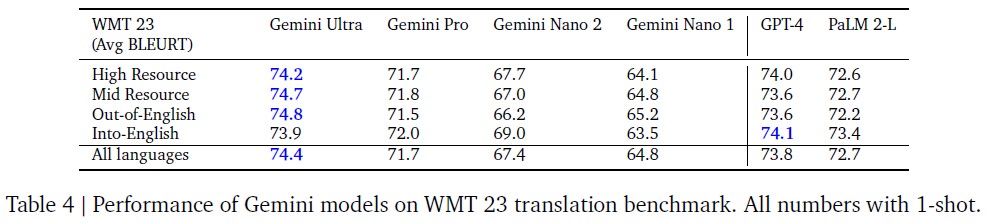

※訳注:表4は原文では参照されていませんが,こちらに記載しておきます.

機械翻訳:

翻訳は,豊かな歴史を持つ機械学習の代表的なベンチマークである.

我々は,WMT 23翻訳ベンチマークの全言語ペアセットに対して,命令チューニング(6.4.2項を参照)を適用したGemini UltraをFew-Shot設定で評価した.

全体として,Gemini Ultra(および他のGeminiモデル)は,英語から他の言語への翻訳において非常に優れた性能を発揮し,高リソース,中リソース,低リソースの言語において,英語以外への翻訳ではLLMベースの翻訳手法を上回ることがわかった.

WMT 23の英語以外の言語への翻訳タスクにおいて,Gemini Ultraは,平均BLEURT(Sellam et al., 2020)スコア74.8と,GPT-4の73.6,PaLM 2の72.2に対し,LLMベースの翻訳品質で最高を達成した.

WMT 23のすべての言語ペアと方向で平均すると,このベンチマークでのBLEURT平均スコアはGemini Ultra 74.4,GPT-4 73.8,PaLM 2-L 72.7となり,同様の傾向が見られた.

上記の言語と翻訳タスクに加えて,超低リソース言語についてもGemini Ultraを評価した.

これらの言語は,以下の言語セットの末尾からサンプリングした.

- Flores-200(Tamazight and Kanure)

- NTREX(North Ndebele)

- 内部ベンチマーク(Quechua)

これらの言語に対して,英語からの翻訳と英語への翻訳において,Gemini Ultraは,1-Shotセットアップで平均27.0のchrFスコアを達成し,次善のモデルであるPaLM 2-Lは25.3のスコアを達成した.

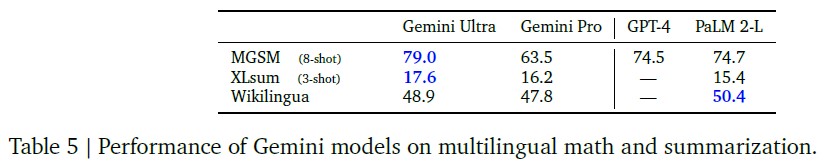

多言語数学と要約:

翻訳だけでなく,Geminiが様々な言語の難しいタスクでどの程度の性能を発揮するかも評価した.

特に,数学ベンチマークGSM8K(Cobbe et al., 2021)の翻訳バライアントである数学ベンチマークMGSM(Shi et al., 2023)を調査した.

その結果,Gemini Ultraは79.0%の正解率を達成し,8-Shotのセットアップで全言語を平均した場合,PaLM 2-Lの74.7%を上回った.

また,多言語要約ベンチマークであるXLSum(Hasan et al., 2021)とWikiLingua(Ladhak et al., 2020)でもGeminiのベンチマークを行った.

XLSumでは,Gemini Ultraは平均17.6 rougeL scoreに達したのに対し,PaLM 2は15.4であった.

Wikilinguaでは,Gemini Ultra(5-Shot)はPaLM 2(3-Shot)のBLEURTスコアの後塵を拝した.

全結果は表5を参照されたい.

全体として,多言語ベンチマークの多様なセットは,Geminiファミリーのモデルが幅広い言語カバレッジを持ち,低リソース言語の国や地域にも対応できることを示している.

5.1.5項:Long Context(長い文脈)

Geminiモデルは32,768トークンのシーケンス長で訓練され,文脈の長さを効果的に利用していることがわかる.

まず,合成検索テストを実行してこれを検証する.

キーと値のペアを文脈の先頭に置き,長いフィラーテキストを追加し,特定のキーに関連する値を求める.

その結果,Ultraモデルは文脈の全長にわたって検索を行った場合,98%の正解率で正しい値を検索することがわかった.

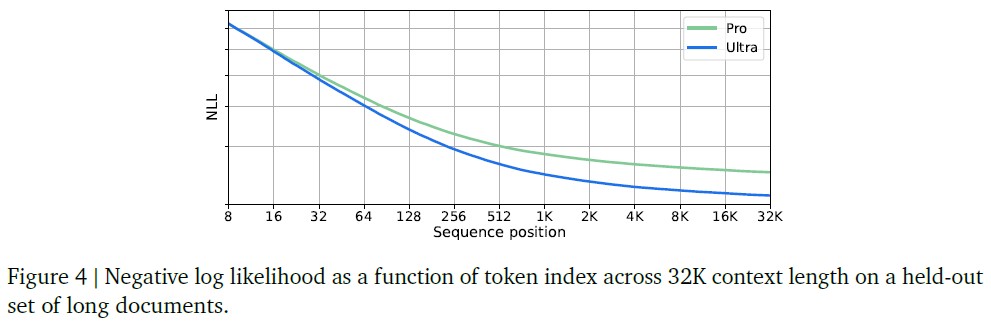

さらに,図4で,長い文書のHold-Outセットにわたって,トークンインデックスに対する負対数尤度(NLL:Negative Log Likelihood)をプロットすることによって,これを調査する.

その結果,NLLは32Kの文脈長まで,シーケンスの位置とともに減少することがわかった.

Geminiモデルのより長い文脈長は,5.2.2項で議論される文書検索やビデオ理解のような新しいユースケースを可能にする.

5.1.6項:Human Preference Evaluations(人間の嗜好評価)

モデルの出力に対する人間の嗜好は,自動化された評価を補完する品質に関する重要な指標を提供する.

我々は,同じプロンプトに対する2つのモデルの応答を人間の評価者が判定する,サイドバイサイドのブラインド評価でGeminiモデルを評価した.

我々は,6.4.2項で議論した技術を用いて,事前訓練させたモデルを命令チューニングした(Ouyang et al., 2022).

命令チューニングバージョンのモデルは,命令に従うこと,創造的な文章を書くこと,マルチモーダルな理解,長い文脈の理解,安全性など,さまざまな特定の能力について評価される.

これらの能力は,現在のユーザニーズから着想を得たユースケースと,研究から着想を得た将来の潜在的なユースケースの範囲を包含している.

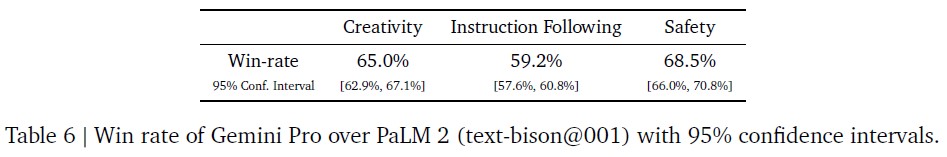

命令チューニングされたGemini Proモデルは,表6に示すように,PaLM 2モデルのAPIよりもGemini Proモデルの方が好まれ,創造的な文章を書くのに65.0%,命令に従うのに59.2%,そしてより安全な回答に68.5%の時間がかかるなど,さまざまな能力において大きな改善をもたらす.

これらの改善は,より役に立ち,より安全なユーザエクスペリエンスに直結する.

5.1.7項:Complex Reasoning Systems(複雑な推論システム)

Geminiはまた,探索やツールの使用などの追加技術と組み合わせることで,より複雑なマルチステップ問題に取り組むことができる強力な推論システムを作成することができる.

そのようなシステムの一例として,AlphaCode 2がある.

AlphaCode 2は,競技プログラミング問題を解くことに優れた,新しい最先端のエージェントである(Leblond et al., 2023).

AlphaCode 2は,(Li et al., 2022)で使用されたデータと同様の競合プログラミングデータでチューニングされたGemini Proの特別バージョンを使用して,可能なプログラムの空間上で大規模な探索を行う.

これに続いて,調整されたフィルタリング,クラスタリング,再ランク付けメカニズムが行われる.

Gemini Proは,提案ソリューション候補を生成するコーディングモデルと,最も有望なコード候補を認識し抽出するために活用される報酬モデルの両方としてファインチューニングされている.

AlphaCode 2は,AlphaCodeと同じプラットフォームであるCodeforces上で,ディビジョン1と2の12のコンテスト,合計77の問題で評価されている.

AlphaCode 2は,これらのコンペティションの43%の問題を解いた.

これは,25%の問題を解いた記録的なAlphaCodeシステムの1.7倍の改善である.

この結果をコンペティションの順位にマッピングすると,Gemini Proの上に構築されたAlphaCode 2は,平均で推定85パーセンタイルに位置する.

すなわち,85%の参加者よりも優れたパフォーマンスを示している.

これは,競合他社の50%しか上回ることができなかったAlphaCodeを大きく上回るものである.

強力な事前訓練済みモデルと探索・推論メカニズムとの組み合わせは,より一般的なエージェントに向けたエキサイティングな方向性である.

もう一つの重要な要素は,次の節で議論する,様々なモダリティにわたる深い理解である.

5.2節:Multimodal(マルチモーダル)

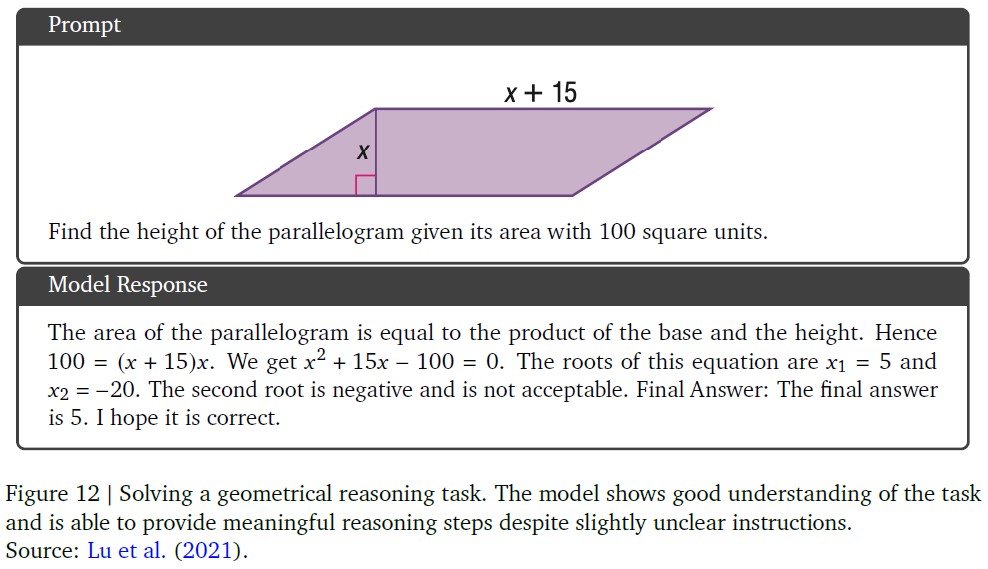

Geminiモデルはネイティブにマルチモーダルである.

これらのモデルは,図5と図12の例に見られるように,モダリティを横断する能力(例えば,表,チャート,図から情報と空間レイアウトを抽出する)と,言語モデルの強力な推論能力(例えば,数学とコーディングにおける最先端の性能)をシームレスに組み合わせるユニークな能力を示す.

このモデルはまた,入力のきめ細かな詳細を識別し,空間と時間にわたって文脈を集約し,ビデオフレームおよび/またはオーディオ入力の時間的に関連するシーケンスにわたってこれらの能力を適用する際に,強力な性能を示す.

以下の項では,異なるモダリティ(画像,ビデオ,音声)にまたがるモデルのより詳細な評価と,画像生成に対するモデルの能力と異なるモダリティにまたがる情報を組み合わせる能力に関する定性的な例を示す.

5.2.1項:Image Understanding(画像理解)

我々は4つの異なる能力でモデルを評価する.

- VQAv2のようなキャプションや質問応答タスクを使用した高レベルのオブジェクト認識

- TextVQAやDocVQAなどのタスクを使用したきめ細かな文字起こし

- ChartQAタスクやInfographicVQAタスクを使用した,入力レイアウトの空間的理解を必要とするチャート理解

- Ai2D,MathVista,MMMUなどのタスクを使用したマルチモーダル推論.

Zero-Shot QA評価では,特定のベンチマークに沿った短い回答を提供するようモデルに命令する.

すべての数値は,貪欲なサンプリングを使用し,外部のOCRツールを使用せずに得られたものである.

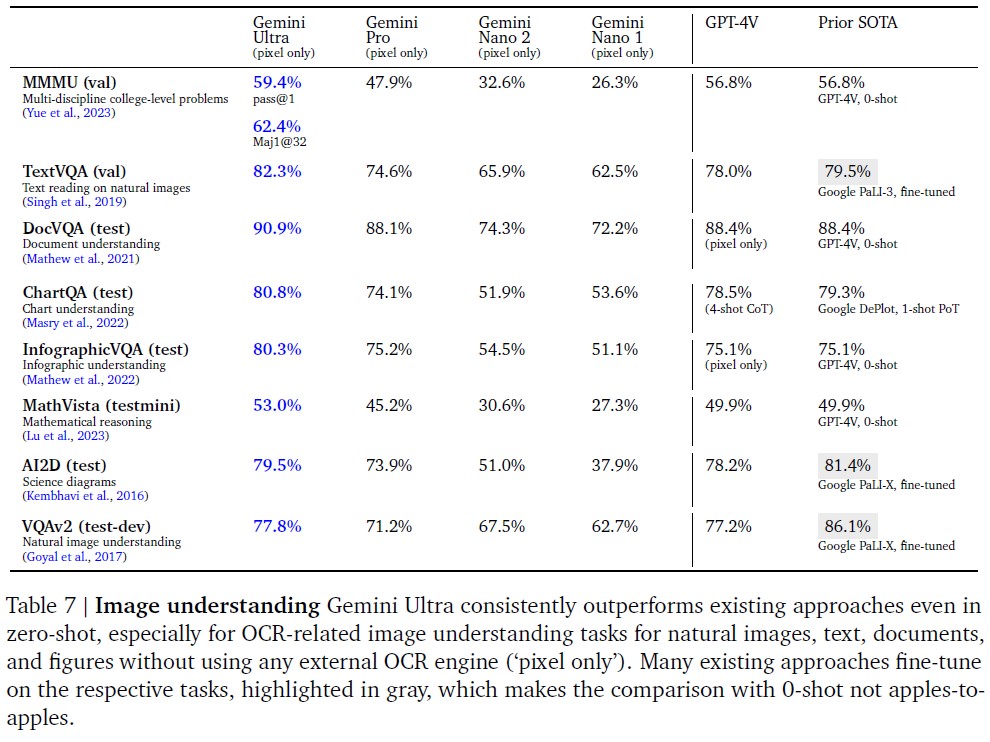

表7に示すように,Gemini Ultraは幅広い画像理解ベンチマークにおいて最先端であることが分かる.

Gemini Ultraは,インフォグラフィックス,チャート,科学ダイアグラムの理解だけでなく,自然画像やスキャンされた文書に関する質問への回答など,多様なタスクにおいて高いパフォーマンスを達成している.

公に報告されている他のモデル(特にGPT-4V)の結果と比較すると,GeminiはZero-Shot評価においてかなりの差をつけて優れている.

また,大半のタスクにおいて,ベンチマークの訓練セットで特別にファインチューニングされたいくつかの既存モデルを上回っている.

Geminiモデルの能力は,MathVista (+3.1%)やInfographicVQA (+5.2%)のようなアカデミックベンチマークにおける最先端技術の大幅な向上につながる.

※MathVistaは,過去に発表された28のマルチモーダルデータセットと,新たに作成された3つのデータセットから構成される包括的な数学的推論ベンチマークである.我々のMathVistaの結果は,MathVistaの著者の評価スクリプトを実行することで得られた.

MMMU(Yue et al., 2023)は最近発表された評価ベンチマークで,6つの分野にわたる画像に関する問題で構成される.

各分野に複数の科目があり,これらの問題を解くには大学レベルの知識が必要とされる.

Gemini Ultraは,このベンチマークにおいて,最先端の結果を5ポイント以上上回るベストスコアを達成し,6分野中5分野で前回のベストスコアを上回った(表8参照)ことから,マルチモーダル推論の能力が実証された.

Geminiモデルはまた,画像理解タスク(例:アイスランド語のテキストを含む画像)と生成タスク(例:幅広い言語の画像説明文の生成)の両方において,モダリティと多様なグローバル言語のセットを同時に操作することができる.

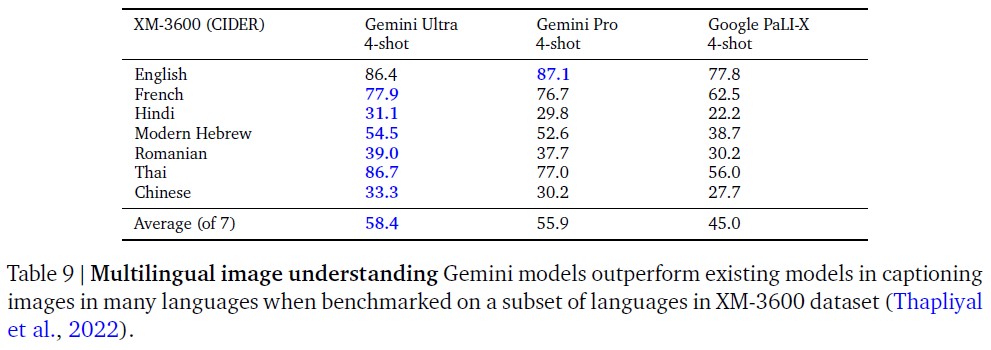

Flamingo評価プロトコル(Alayrac et al., 2022)を用いて,4-Shot設定で,Crossmodal-3600(XM-3600)ベンチマークの選択された言語のサブセットに対する画像説明文生成の性能を,全モデルに対してファインチューニングなしで評価する.

表9に示すように,Geminiモデルは,既存の最良モデルであるGoogle PaLI-Xに対して大幅な改善を達成している.

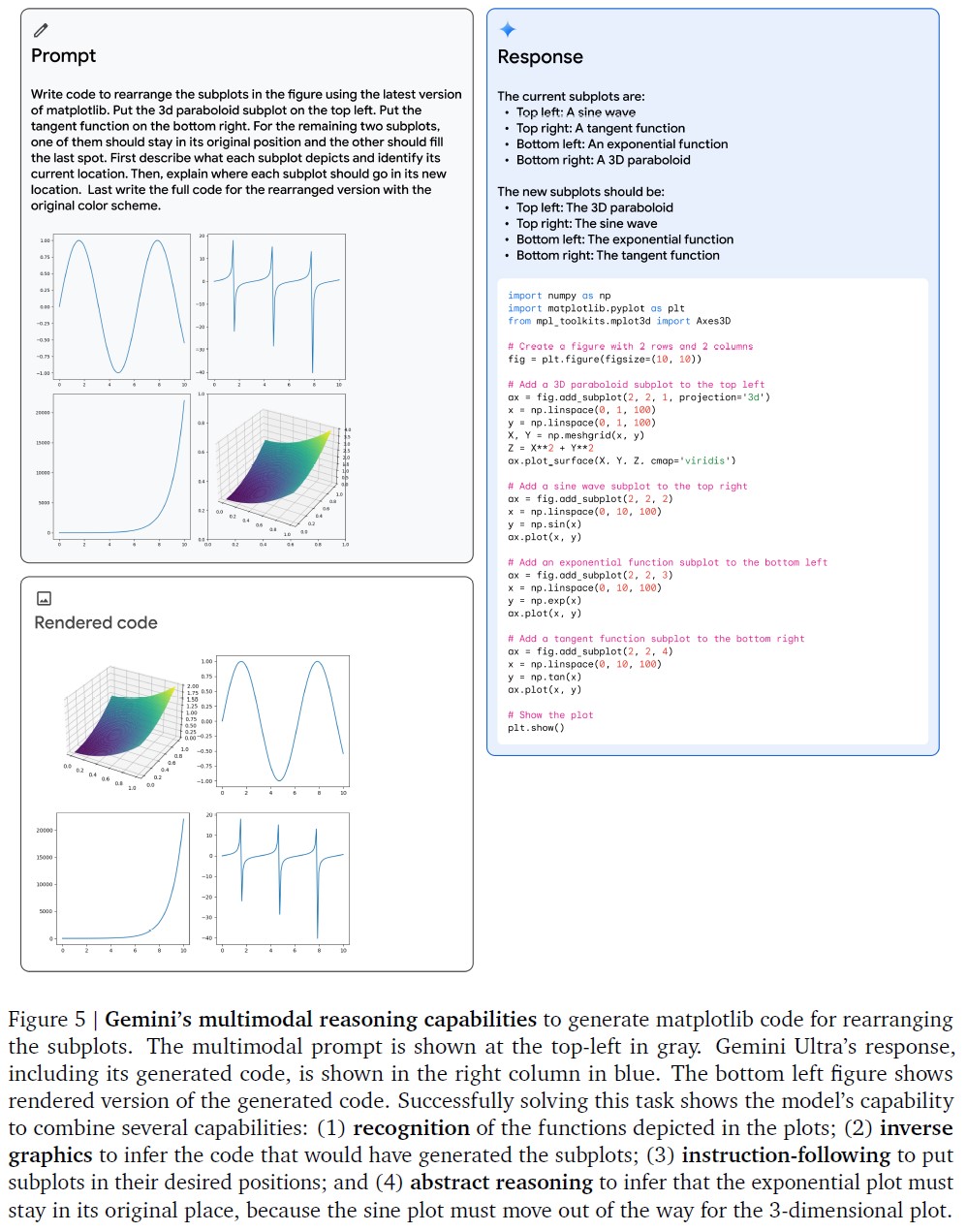

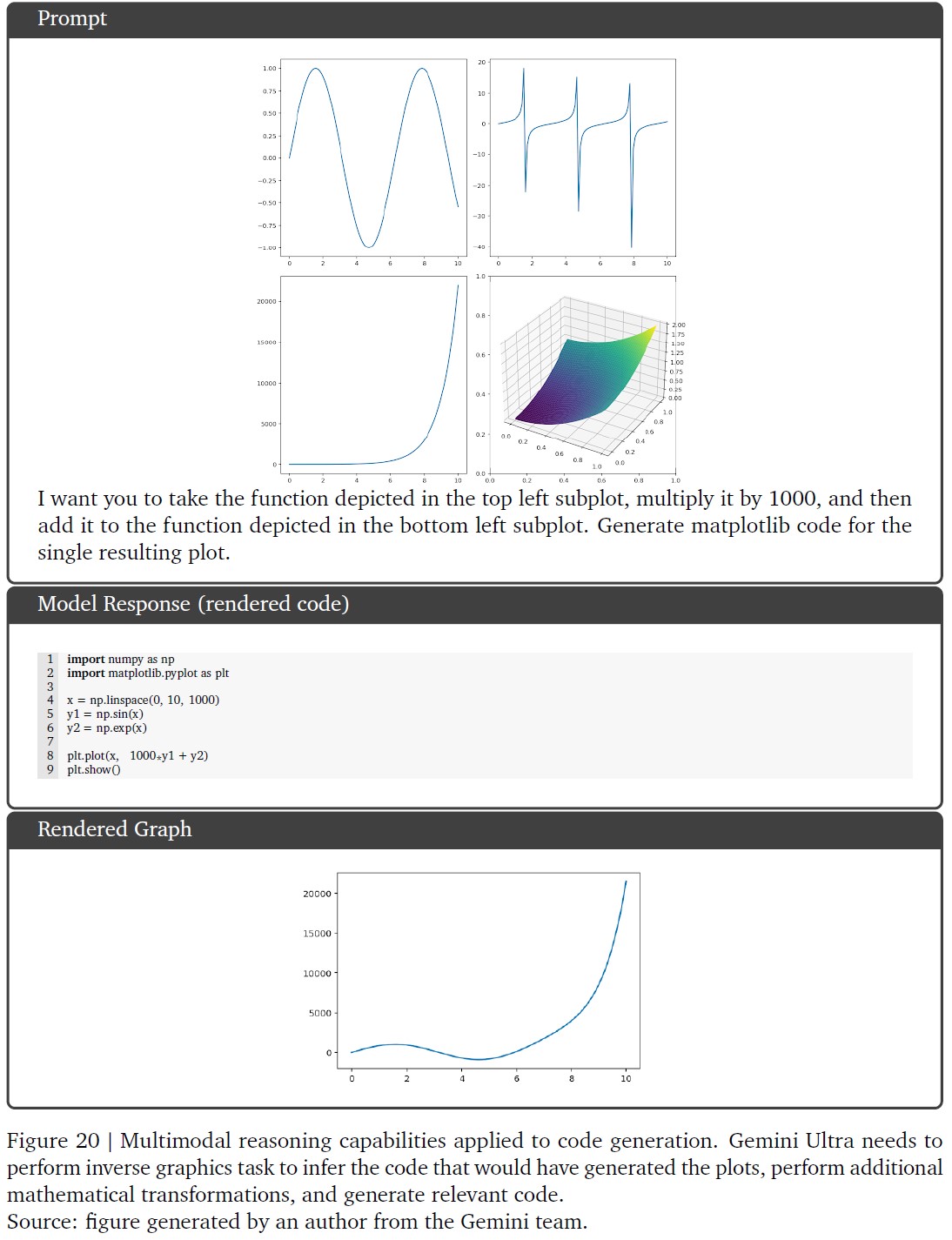

図5の定性的評価は,Gemini Ultraのマルチモーダル推論機能の例を示している.

このモデルは,ユーザによって提供されたサブプロットのセットを再配置するmatplotlibコードを生成するタスクを解決する必要がある.

モデルの出力は,ユーザのプロットを理解し,それを生成するために必要なコードを推測し,サブプロットを希望する位置に配置するためにユーザの命令に従い,出力プロットに関する抽象的な推論を行うという複数の機能を組み合わせて,このタスクをうまく解決していることを示している.

これは,Gemini Ultraのネイティブなマルチモダリティを強調し,画像とテキストのインターリーブされたシーケンスにまたがる,より複雑な推論能力を示している.

より定性的な例については,付録を参照されたい.

5.2.2項:Video Understanding(ビデオ理解)

ビデオ入力を理解することは,有用なジェネラリストエージェントへの重要なステップである.

我々は,訓練からHold-Outされたいくつかの確立されたベンチマークにわたってビデオ理解能力を測定する.

これらのタスクは,モデルが時間的に関連した一連のフレームを理解し,推論できるかどうかを測定する.

各ビデオタスクについて,各ビデオクリップから16の等間隔フレームをサンプリングし,Geminiモデルに与える.

YouTubeの動画データセット(NextQAとPerceptionテスト以外のすべてのデータセット)については,2023年11月にまだ公開されていた動画でGeminiモデルを評価する.

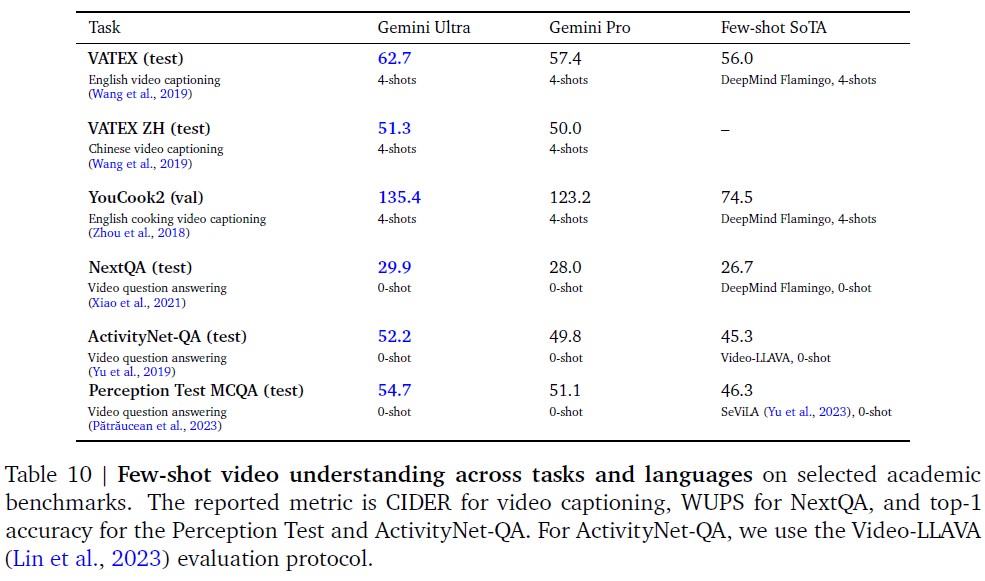

Gemini Ultraは,表10に示すように,様々なFew-ShotのビデオキャプションタスクおよびZero-Shotのビデオ質問応答タスクにおいて,最先端の結果を達成している.

これは,数フレームにわたる強力な時間的推論の能力を示している.

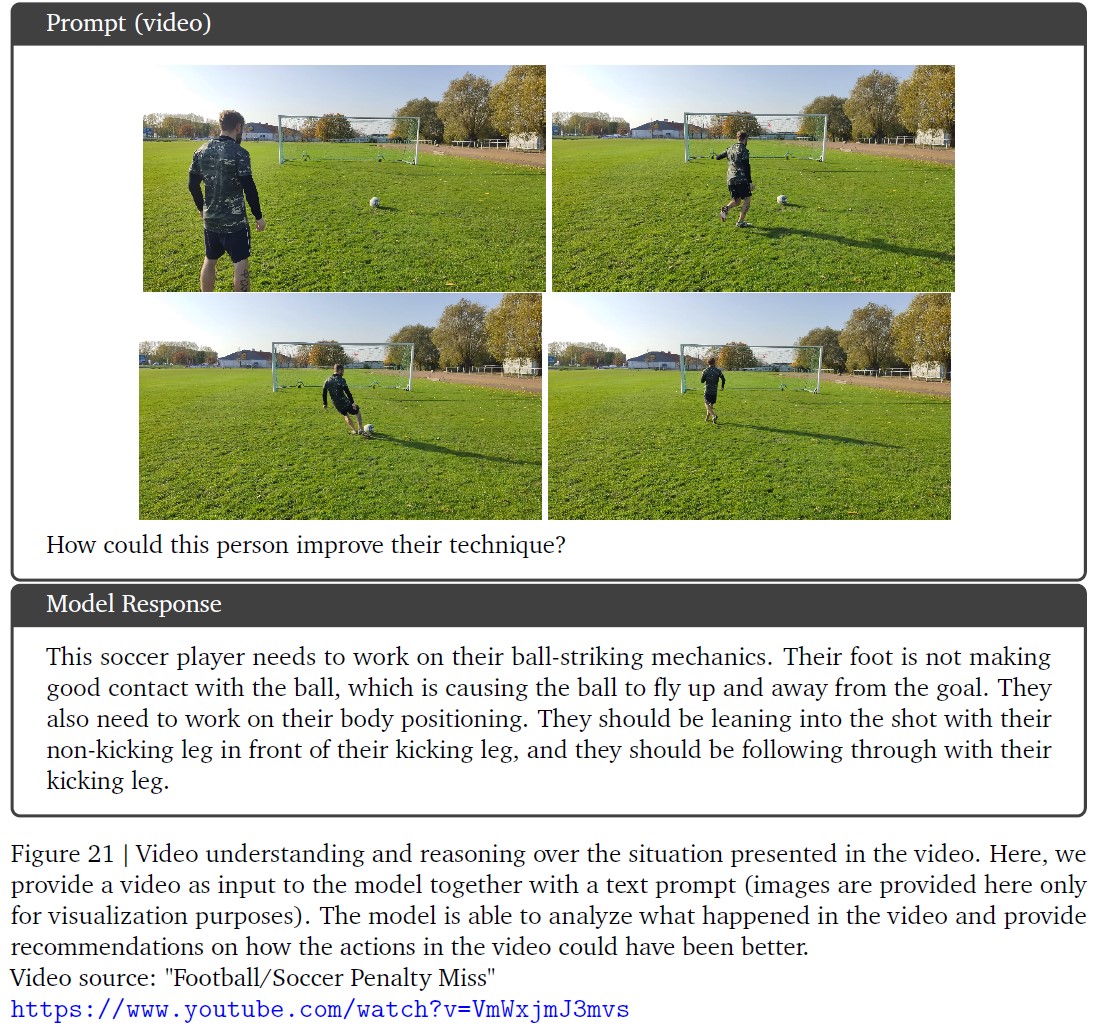

付録の図21は,サッカー選手のボールを打つメカニズムのビデオを理解し,その選手がゲームを向上させることができることを推論する定性的な例を示している.

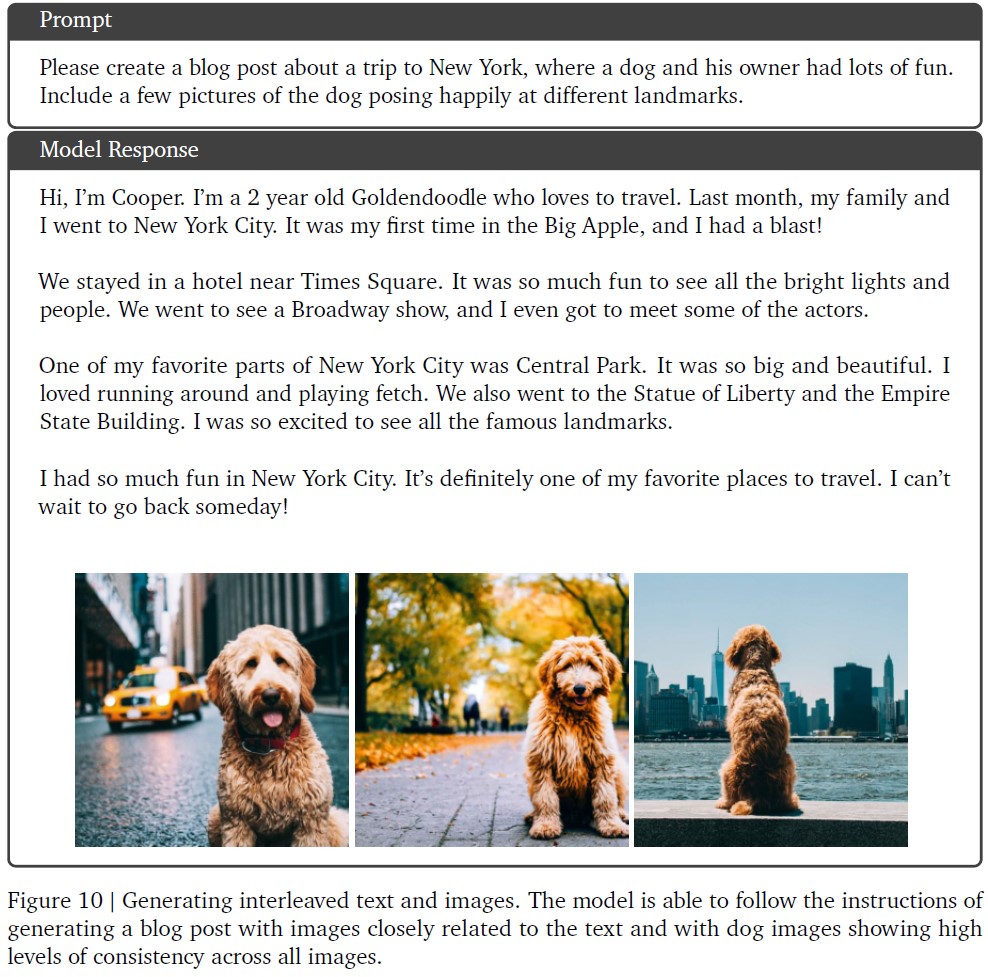

5.2.3項:Image Generation(画像生成)

Geminiは,モデルの画像表現能力のボトルネックとなる中間的な自然言語記述に依存することなく,ネイティブに画像を出力することができる.

このユニークな機能により,モデルは,画像とテキストのインターリーブシーケンスを使用して,プロンプトとともに画像を生成することができる.

例えば,ユーザは,ブログ記事またはウェブサイトのための画像とテキストの提案をデザインするようモデルにプロンプトすることができる(付録の図10を参照).

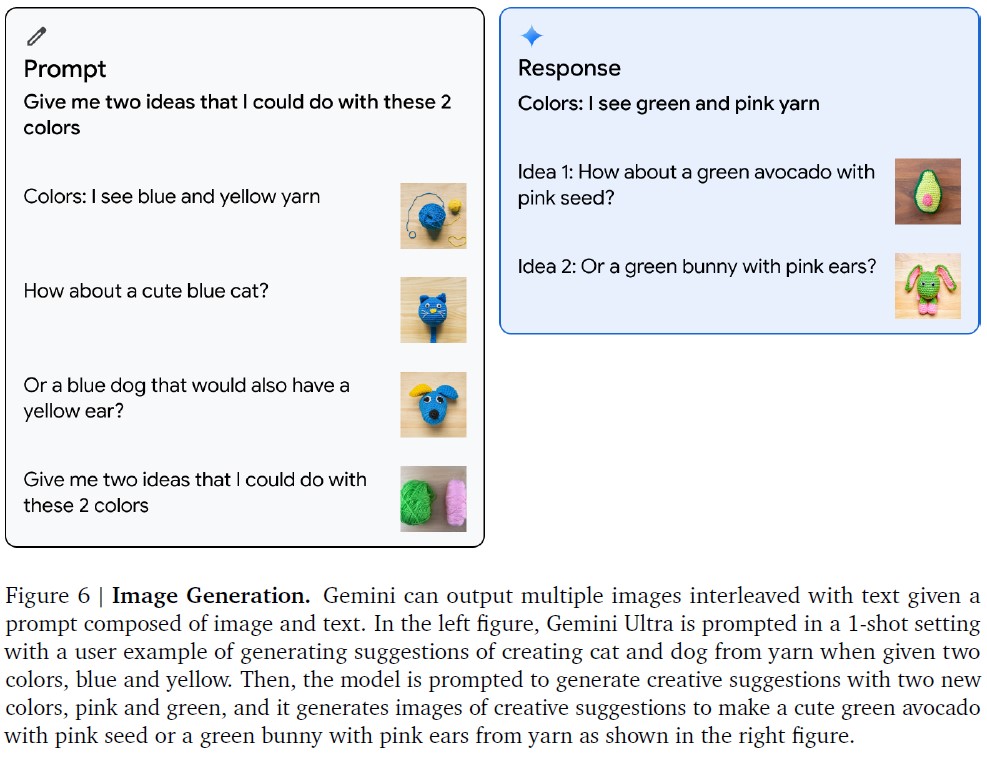

図6は,1-Shot設定での画像生成の例を示している.

Gemini Ultraのモデルには,画像とテキストがインターリーブされた1つの例がプロンプトされ,ユーザは2つの色(青と黄色)と,毛糸からかわいい青い猫または黄色い耳を持つ青い犬を作成する画像案を提供する.

モデルには次に2つの新しい色(ピンクと緑)が与えられ,これらの色を使って何を作るかについての2つのアイデアが求められる.

このモデルは,ピンクの種を持つかわいい緑のアボカドや,ピンクの耳を持つ緑のウサギを毛糸から作るという提案とともに,画像とテキストのインターリーブシーケンスを生成することに成功する.

5.2.4項:Audio Understanding(音声理解)

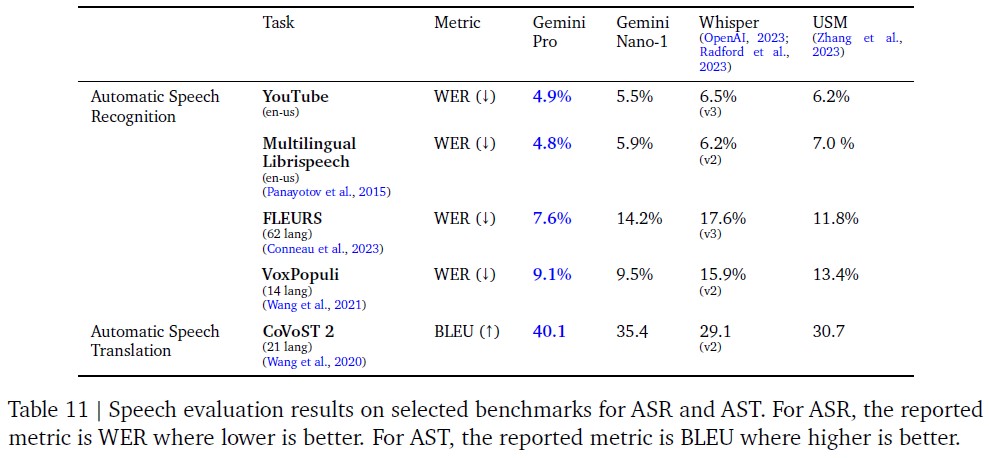

Gemini Nano-1とGemini Proモデルを様々な公開ベンチマークで評価し,Universal Speech Model(USM)(Zhang et al., 2023)やWhisper(large-v2(Radford et al., 2023)やlarge-v3(OpenAI, 2023))と比較する.

これらのベンチマークには,FLEURS(Conneau et al., 2023),VoxPopuli(Wang et al., 2021),Multi-lingual Librispeech(Panayotov et al., 2015)などの自動音声認識(ASR:Automatic Speech Recognition)タスクや,異なる言語を英語に翻訳する音声翻訳タスクCoVoST 2(Wang et al., 2020)が含まれる.

また,内部ベンチマークのYouTubeテストセットについても報告する.

ASRタスクは,単語誤り率(WER:Word Error Rate)を報告し,数値が低いほど優れている.

翻訳タスクは(BiLingual Evaluation Understudy(BLEU)スコアを報告し,数値が高いほど優れている.

FLEURSは,訓練データと言語が重複する62の言語について報告されている.

4つのセグメンテーション言語(北京語,日本語,韓国語,タイ語)は,Whisper(Radford et al., 2023)と同様に,WERの代わりに文字誤り率(CER:Character Error Rate)を報告する.

表11に示すように,我々のGemini Proモデルは,英語と多言語のテストセットの両方において,全てのASRとASTタスクでUSMとWhisperモデルを大幅に上回っている.

我々のモデルもFLEURS訓練データセットで訓練されているため,USMやWhisperと比較して,FLEURSでは大きな利得があることに注意されたい.

しかし,FLEURSデータセットを使用せずに同じモデルを訓練させた場合,WERは15.8となり,Whisperを上回る.

Gemini Nano-1モデルもFLEURSを除く全てのデータセットにおいてUSMとWhisperを上回る.

なお,Gemini Ultraの音声に対する評価はまだ行っていないが,モデル規模の拡大による性能向上が期待される.

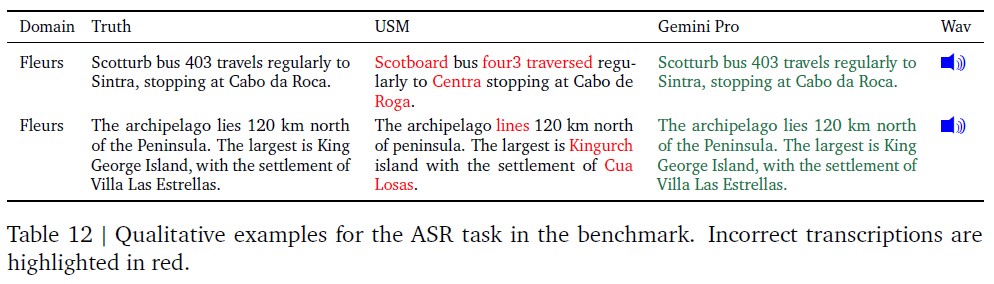

表12は,USMとGemini Proを使ったさらなるエラー分析を示している.

Gemini Proは,特に希少語や固有名詞において,より理解しやすい回答を生成することがわかる.

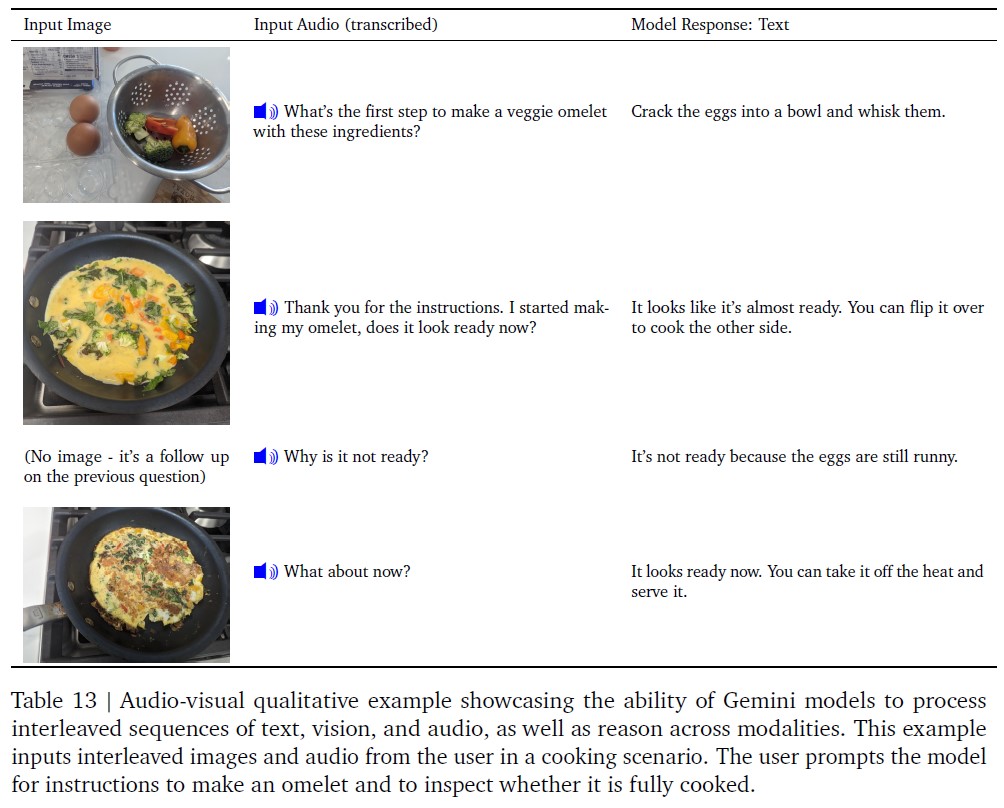

5.2.5項:Modality Combination(モダリティの組み合わせ)

マルチモーダルデモンストレーションでは,テキストと単一モダリティ(通常は画像)の組み合わせがよく使われる.

我々は,音声と画像のシーケンスをネイティブに処理する能力を実証する.

オムレツを作るという料理のシナリオを考え,音声と画像のシーケンスでモデルをプロンプトする.

表13は,画像を提供し,オムレツを調理するための次のステップについて口頭で質問する,モデルとのターンバイターンのインタラクションを示している.

我々は,モデルの応答テキストが適度に正確であり,モデルがきめ細かい画像の詳細を処理して,オムレツが完全に調理されたときを評価することを示していることに注意されたい.

ウェブサイトのデモを参照されたい.

6章:Responsible Deployment(責任あるデプロイ)

Geminiモデルの開発中,我々はGoogleのAI技術の過去のリリース(Kavukcuoglu et al., 2022)と同様に,我々のモデルの予測可能な下流の社会的影響を特定し,測定し,管理するために,責任あるデプロイへの構造的アプローチに従う.

プロジェクトのライフサイクルを通じて,我々は以下の構成に従う.

この章では,このプロセスを通じた我々の大まかなアプローチと主な発見を概説する.

この詳細については,次回のレポートで紹介する予定である.

6.1節:Impact Assessment(影響評価)

我々は,先進的なGeminiモデルの開発に関連する主要な下流の社会的便益と害を特定,評価,文書化するためのモデル影響評価を開発する.

これらは,言語モデルのリスクに関する先行学術文献(Weidinger et al., 2021),業界全体で実施された同様の先行演習から得られた知見(Anil et al., 2023; Anthropic, 2023; OpenAI, 2023a),社内外の専門家との継続的な関わり,新しいモデルの脆弱性を発見するための非構造的な試みから情報を得ている.

重点分野には,事実性,子どもの安全性,有害コンテンツ,サイバーセキュリティ,バイオリスク,表現,包括性が含まれる.

これらの評価は,モデルの開発と同時に更新される.

影響評価は,緩和策と製品提供の努力の指針を示し,デプロイの決定を知らせるために使用される.

Geminiの影響評価は,Geminiモデルのさまざまな機能にまたがり,グーグルのAI原則(Google, 2023)を用いてこれらの機能の潜在的な影響を評価した.

6.2節:Model Policy(モデルポリシー)

このような既知の効果や予想される効果についての理解に基づいて,我々はモデル開発と評価の方向性を示すための「モデルポリシー」一式を開発した.

モデルポリシーの定義は,責任ある開発のための標準化された基準と優先順位付けのスキーマとして,またローンチ準備の指標として機能する.

Geminiのモデルポリシーは,子どもの安全,ヘイトスピーチ,事実の正確さ,公正さと包摂,ハラスメントなど,多くの領域をカバーしている.

6.3節:Evaluations(評価)

Geminiのモデルを,政策分野および影響評価の中で特定されたその他の主要なリスク分野に照らして評価するために,我々はモデル開発のライフサイクルにわたる一連の評価を開発した.

開発評価は,Geminiモデルの訓練とファインチューニングを通して「山登り法」(hill-climbing)を行う目的で行われる.

これらの評価は,Geminiのチームによって設計されるか,または外部の学術的ベンチマークに対する評価である.

評価では,有用性(命令への従順さ,創造性),安全性,事実性などが考慮される.

結果のサンプルについては,5.1.6項および緩和策に関する次の節を参照されたい.

保証評価は,ガバナンスとレビューの目的で,通常,重要なマイルストーンや訓練の終了時に,モデル開発チーム以外のグループによって実施される.

保証評価はモダリティごとに標準化され,データセットは厳重にHold-Outされる.

高レベルの洞察のみが訓練プロセスにフィードバックされ,緩和に役立てられる.

保証評価には,Geminiのポリシー全般にわたるテストが含まれ,潜在的なバイオハザード,説得,サイバーセキュリティなどの危険な能力に関する継続的なテストが含まれる(Shevlane et al., 2023).

外部評価は,盲点を特定するためにグーグル社外のパートナーによって実施される.

外部グループは,ホワイトハウスのコミットメントに記載されている分野を含む,さまざまな問題に対してグーグルのモデルをストレステストし,構造化された評価と構造化されていないレッドチーム編成を組み合わせてテストを実施する.

これらの評価の設計は独立しており,結果は定期的にGoogle DeepMind チームに報告される.

このような一連の外部評価に加えて,社内の専門チームが,Geminiポリシーやセキュリティなどの分野にわたって,当社モデルの継続的なレッドチーム活動を行っている.

これらの活動には,新たな脆弱性を特定するための洗練された敵対的攻撃を含む,あまり構造化されていないプロセスが含まれる.

潜在的な弱点の発見は,リスクを緩和し,社内で評価アプローチを改善するために利用することができる.

我々は,継続的なモデルの透明性にコミットしており,時間をかけて我々の評価スイート全体から得られた追加的な結果を共有する予定である.

6.4節:Mitigations(緩和)

緩和は,上記のアセスメント,政策,評価アプローチの結果に応じて策定される.

評価と緩和は,緩和の後に評価を再実行するというように,反復的に使用される.

以下では,データ,指導のチューニング,事実性など,モデルの弊害を緩和するための取り組みについて述べる.

6.4.1項:Data(データ)

訓練に先立ち,我々はデータキュレーションとデータ収集の段階で,潜在的な下流の害を緩和するために様々なステップを踏む.

「訓練データセット」の4章で説明したように,我々は訓練データをフィルタリングしてリスクの高いコンテンツを排除し,すべての訓練データが十分に高品質であることを確認する.

※訳注:原文のTraining DataはTraining Datasetのことです.

フィルタリングだけでなく,収集したすべてのデータが,Partnership on AIの「Responsible Sourcing of Data Enrichment Services」に基づいて策定されたGoogle DeepMindのデータエンリッチメントに関するベストプラクティスを満たすようにするための措置も講じている.

これには,すべてのデータエンリッチメント労働者に少なくとも現地の生活賃金が支払われるようにすることも含まれる.

6.4.2項:Instruction Tuning(命令チューニング)

命令チューニングは,教師ありファインチューニング(SFT:Supervised Fine Tuning)と報酬モデルを用いた人間フィードバックによる強化学習(RLHF:Reinforcement Learning through Human Feedback)を含む.

命令チューニングは,テキストとマルチモーダルの両方の設定に適用される.

命令チューニングのレシピは,安全性と幻覚に関連するモデルの害の減少と有用性の増加のバランスをとるように注意深く設計されている(Bai et al., 2022a).

「質の高い」データのキュレーションは,SFT,報酬モデルの異訓練,およびRLHFにとって重要である.

データ混合比は,有用性(命令への追従性,創造性など)とモデル弊害の削減に関するメトリクスのバランスをとるために,より小さなモデルで切除され,これらの結果はより大きなモデルにもよく一般化される.

また,特に大規模なモデルの場合,データの質は量よりも重要であることが観察されている(Touvron et al., 2023b; Zhou et al., 2023).

同様に,報酬モデルの訓練では,安全上の理由からモデルが「それは手伝えない」と言うことを好む例と,モデルが役に立つ応答を出力する例とで,データセットのバランスをとることが重要であることがわかる.

我々は,役に立つ,事実である,安全である,の報酬スコアの加重和を用いた多目的関数最適化を用いて,Multi-Head報酬モデルを訓練する.

有害なテキスト生成のリスクを緩和するためのアプローチをさらに詳しく説明する.

我々は,様々なユースケースにおいて,約20の弊害タイプ(例:ヘイトスピーチ,医療アドバイスの提供,危険な行動の提案)を列挙する.

政策専門家やMLエンジニアが手作業で,あるいは話題のキーワードをシードとして高機能言語モデルにプロンプトを送ることで,これらのカテゴリーにおける潜在的な弊害を誘発するクエリのデータセットを生成する.

害をもたらすクエリが与えられた場合,我々はGeminiモデルをプローブし,サイドバイサイド評価によってモデルの応答を分析する.

先述したように,我々は,モデルの出力レスポンスが無害であることと有用であることのバランスをとる.

検出されたリスク領域から,望ましいレスポンスを示すために,さらに教師ありのファインチューニングデータを作成する.

このような応答を大規模に生成するために,我々は,Constitutional AI(Bai et al., 2022b)に緩くインスパイアされたカスタムデータ生成レシピに大きく依存し,Googleのコンテンツポリシー言語のバライアントを「構成」として注入し,言語モデルの強力なZero-Shot推論能力(Kojima et al., 2022)を利用して,応答を修正し,複数の応答候補の中から選択する.

我々は,このレシピが効果的であることを発見した.

例えば,Gemini Proにおいて,この全体的なレシピは,応答の有用性を知覚できるほど低下させることなく,我々が特定したテキスト弊害事例の大部分を緩和することができた.

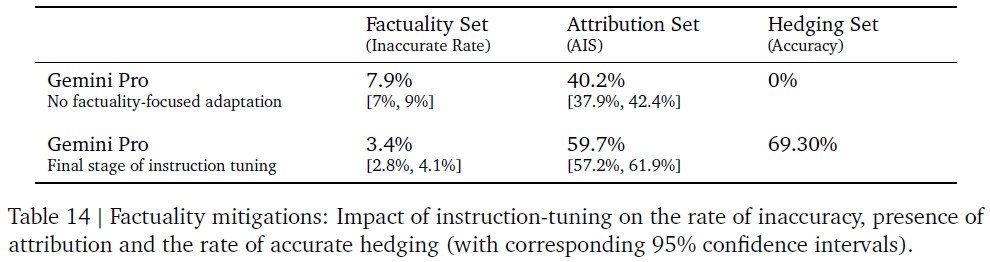

6.4.3項:Factuality(事実性)

我々のモデルは,様々なシナリオにおいて事実に基づいた回答を生成し,幻覚の頻度を減らすことが重要である.

我々は,実世界のシナリオを反映した,3つの主要な望ましい行動に焦点を当てて,命令チューニングを行った.

- 帰属:Geminiは,プロンプトで与えられた文脈に完全に帰属する回答を生成するよう命令された場合,文脈に最も忠実な回答を生成する(Rashkin et al., 2023).これには,ユーザが提供したソースの要約,(Menick et al., 2022; Peng et al., 2023)のように質問と提供されたスニペットが与えられた場合のきめ細かな引用の生成,書籍のような長文のソースからの質問への回答(Mihaylov et al., 2018),与えられたソースを所望の出力に変換すること(例:会議記録の一部からの電子メール)などが含まれる.

- クローズドブックの応答生成:出典を示さずに事実を探すプロンプトが提供された場合,Geminiは間違った情報を幻覚してはならない(定義については(Roberts et al., 2020)の2章を参照).このようなプロンプトには,情報を求めるプロンプト(例:「インドの首相は誰ですか」)から,事実情報を求める半創造的なプロンプト(例:「再生可能エネルギーの採用に賛成する500語のスピーチを書いてください」)まである.

- ヘッジ:「答えられない」入力を求められた場合,Geminiは幻覚してはならない.むしろ,ヘッジをかけることで,回答を提供できないことを認めるべきである.これには,入力プロンプトに偽の想定問題が含まれている場合((Hu et al., 2023)の例を参照),入力プロンプトはモデルにオープンブックQAを実行するよう命令するが,その答えは与えられた文脈から導出できない場合などのシナリオが含まれる.

我々は,対象となる教師ありファインチューニングデータセットを作成し,RLHFを実行することで,Geminiモデルからこれらの望ましい振る舞いを引き出した.

なお,ここで得られた結果には,Geminiに事実性を高めるとされるツールや検索を付与することは含まれていないことに注意されたい(Menick et al., 2022; Peng et al., 2023).

以下に,それぞれのチャレンジセットに関する3つの重要な結果を示す.

- 事実性セット:事実を求めるプロンプト(主にクローズドブック)を含む評価セット.これは,各回答を手作業で事実確認する人間のアノテーターによって評価される.アノテーターが判断した事実と異なる回答の割合を報告する.

- 帰属セット:プロンプト内の出典への帰属を要求するさまざまなプロンプトを含む評価セット.これは,プロンプト内の出典への帰属を手動で確認する人間のアノテーターによって評価される.報告される評価指標はAISである(Rashkin et al., 2023).

- ヘッジセット:Geminiモデルが正確にヘッジしているかどうかを測定する自動評価セットアップ.

表14で,Gemini Proと,事実性に焦点を当てた適応を行わず,命令チューニングを行ったGemini Proモデルを比較する.

事実性セットでは不正解率の割合が半減し,帰属セットでは帰属の正解率が50%向上し(※訳注:40.2%から59.7%に向上),提供されたヘッジセットのタスクでは70%(0%から増加)のヘッジに成功していることが観察される.

6.5節:Deployment(デプロイ)

レビューの完了後,承認されたGeminiの各モデルのモデルカードが作成され,重要なパフォーマンスと責任の測定基準を構造的かつ一貫性のある形で社内に文書化するとともに,これらの測定基準を長期にわたって適切に社外に伝えるために使用される.

6.6節:Responsible Governance(責任あるガバナンス)

責任ある開発プロセス全体にわたって,Google DeepMind の責任と安全性評議会(RSC:Responsibility and Safety Council)と共に倫理と安全のレビューを実施している.

RSCは,GoogleのAI原則に照らしてGoogle DeepMindのプロジェクト,論文,および共同研究を評価する学際的なグループである.

RSCは,影響評価,方針,評価,および緩和の取り組みについて意見を提供し,フィードバックを行う.

Geminiプロジェクトでは,RSCは主要な政策領域(子供の安全など)にわたって具体的な評価目標を設定した.

7章:Discussion and Conclusion(議論と結論)

我々は,テキスト,コード,画像,音声,ビデオにおけるマルチモーダルモデルの能力を進化させる新しいモデルファミリーであるGeminiを発表した.

本テクニカルレポートでは,広く研究されている多様なベンチマークを対象にGeminiの能力を評価しており,我々の最も能力の高いモデルであるGemini Ultraは,全体的に大きな進歩を遂げている.

自然言語領域では,大規模なデータとモデル訓練の入念な開発による性能向上が,いくつかのベンチマークで新たな最先端を打ち立て,品質の向上をもたらし続けている.

特に,Gemini Ultraは,2020年に初めてリリースされて以来,LLMの進歩の事実上の指標となっている試験ベンチマークMMLUにおいて,90.0%を記録し,人間の専門家のパフォーマンスを上回った.

マルチモーダル領域では,Gemini Ultraは,タスク固有の修正やチューニングを行うことなく,画像理解,ビデオ理解,音声理解のベンチマークのほとんどで新しい最先端技術を打ち立てた.

特に,Gemini Ultraのマルチモーダル推論能力は,最近のMMMUベンチマーク(Yue et al., 2023)における最先端の性能から明らかである.

MMMUベンチマークは,大学レベルの主題知識と意図的な推論を必要とする画像に関する問題で構成されている.

ベンチマークにおける最先端の結果だけでなく,我々が最も期待しているのは,Geminiモデルによって可能になる新しいユースケースである.

チャートやインフォグラフィックスのような複雑な画像を解析し,画像,音声,テキストのインターリーブシーケンスを推論し,応答としてインターリーブされたテキストと画像を生成するGeminiモデルの新しい機能は,多種多様な新しいアプリケーションを開く.

レポートおよび付録の図に示されているように,Geminiは,教育,日常的な問題解決,多言語コミュニケーション,情報の要約,抽出,および創造性といった分野における新しいアプローチを可能にする.

我々は,これらのモデルのユーザが,我々自身の調査では表面しか見ていないような,あらゆる種類の有益な新しい用途を見つけることを期待している.

その素晴らしい能力にもかかわらず,LLMの使用には限界があることに注意すべきである.

LLMが生成する「幻覚」について,モデル出力の信頼性と検証可能性を高めるための継続的な研究開発が必要である.

また,LLMは,試験のベンチマークで素晴らしい成績を収めているにもかかわらず,因果関係の理解,論理的演繹,反事実推論といった高度な推論能力を必要とするタスクに苦戦している.

このことは,現在の最先端のLLMが多くのベンチマークで飽和しているため,LLMの真の理解度を測定するためのより挑戦的で頑健な評価の必要性を強調している.

Geminiは,知性を解決し,科学を発展させ,人類に利益をもたらすという我々の使命へのさらなる一歩である.

我々は,これらのモデルがGoogleの同僚やそれ以外の人々によってどのように使用されるかを見ることに熱中している.

我々は,機械学習,データ,インフラ,責任ある開発における多くのイノベーションを基盤としている.

これらは,Googleが10年以上追求してきた分野である.

本レポートで紹介するモデルは,多くのモダリティにまたがる広範な汎化能力を持つ,大規模でモジュール化されたシステムを開発するという,我々のより広い将来の目標に向けた強力な基盤となる.

References(参考文献)

- (Alayrac et al., 2022) Jean-Baptiste Alayrac, Jeff Donahue, Pauline Luc, Antoine Miech, Iain Barr, Yana Hasson, Karel Lenc, Arthur Mensch, Katherine Millican, Malcolm Reynolds, et al. Flamingo: a visual language model for few-shot learning. Advances in Neural Information Processing Systems, 35:23716–23736, 2022.

- (Anil et al., 2023) Rohan Anil, Andrew M. Dai, Orhan Firat, Melvin Johnson, Dmitry Lepikhin, Alexandre Passos, Siamak Shakeri, Emanuel Taropa, Paige Bailey, Zhifeng Chen, Eric Chu, Jonathan H. Clark, Laurent El Shafey, Yanping Huang, Kathy Meier-Hellstern, Gaurav Mishra, Erica Moreira, Mark Omernick, Kevin Robinson, Sebastian Ruder, Yi Tay, Kefan Xiao, Yuanzhong Xu, Yujing Zhang, Gustavo Hernandez Abrego, Junwhan Ahn, Jacob Austin, Paul Barham, Jan Botha, James Bradbury, Siddhartha Brahma, Kevin Brooks, Michele Catasta, Yong Cheng, Colin Cherry, Christopher A. Choquette-Choo, Aakanksha Chowdhery, Clément Crepy, Shachi Dave, Mostafa Dehghani, Sunipa Dev, Jacob Devlin, Mark Díaz, Nan Du, Ethan Dyer, Vlad Feinberg, Fangxiaoyu Feng, Vlad Fienber, Markus Freitag, Xavier Garcia, Sebastian Gehrmann, Lucas Gonzalez, Guy Gur-Ari, Steven Hand, Hadi Hashemi, Le Hou, Joshua Howland, Andrea Hu, Jeffrey Hui, Jeremy Hurwitz, Michael Isard, Abe Ittycheriah, Matthew Jagielski, Wenhao Jia, Kathleen Kenealy, Maxim Krikun, Sneha Kudugunta, Chang Lan, Katherine Lee, Benjamin Lee, Eric Li, Music Li, Wei Li, YaGuang Li, Jian Li, Hyeontaek Lim, Hanzhao Lin, Zhongtao Liu, Frederick Liu, Marcello Maggioni, Aroma Mahendru, Joshua Maynez, Vedant Misra, Maysam Moussalem, Zachary Nado, John Nham, Eric Ni, Andrew Nystrom, Alicia Parrish, Marie Pellat, Martin Polacek, Alex Polozov, Reiner Pope, Siyuan Qiao, Emily Reif, Bryan Richter, Parker Riley, Alex Castro Ros, Aurko Roy, Brennan Saeta, Rajkumar Samuel, Renee Shelby, Ambrose Slone, Daniel Smilkov, David R. So, Daniel Sohn, Simon Tokumine, Dasha Valter, Vijay Vasudevan, Kiran Vodrahalli, Xuezhi Wang, Pidong Wang, Zirui Wang, Tao Wang, John Wieting, Yuhuai Wu, Kelvin Xu, Yunhan Xu, Linting Xue, Pengcheng Yin, Jiahui Yu, Qiao Zhang, Steven Zheng, Ce Zheng, Weikang Zhou, Denny Zhou, Slav Petrov, and Yonghui Wu. Palm 2 technical report, 2023.

- (Anthropic, 2023) Anthropic. Model Card and Evaluations for Claude Models, 2023.

- (Bai et al., 2022a) Yuntao Bai, Andy Jones, Kamal Ndousse, Amanda Askell, Anna Chen, Nova DasSarma, Dawn Drain, Stanislav Fort, Deep Ganguli, Tom Henighan, Nicholas Joseph, Saurav Kadavath, Jackson Kernion, Tom Conerly, Sheer El-Showk, Nelson Elhage, Zac Hatfield-Dodds, Danny Hernandez, Tristan Hume, Scott Johnston, Shauna Kravec, Liane Lovitt, Neel Nanda, Catherine Olsson, Dario Amodei, Tom Brown, Jack Clark, Sam McCandlish, Chris Olah, Ben Mann, and Jared Kaplan. Training a helpful and harmless assistant with reinforcement learning from human feedback. April 2022a. URL https://arxiv.org/abs/2204.05862.

- (Bai et al., 2022b) Yuntao Bai, Saurav Kadavath, Sandipan Kundu, Amanda Askell, Jackson Kernion, Andy Jones, Anna Chen, Anna Goldie, Azalia Mirhoseini, Cameron McKinnon, et al. Constitutional ai: Harmlessness from ai feedback. arXiv preprint arXiv:2212.08073, 2022b.

- (Barham et al., 2022) Paul Barham, Aakanksha Chowdhery, Jeff Dean, Sanjay Ghemawat, Steven Hand, Daniel Hurt, Michael Isard, Hyeontaek Lim, Ruoming Pang, Sudip Roy, et al. Pathways: Asynchronous distributed dataflow for ml. Proceedings of Machine Learning and Systems, 4:430–449, 2022.

- (Bradbury et al., 2018) James Bradbury, Roy Frostig, Peter Hawkins, Matthew James Johnson, Chris Leary, Dougal Maclaurin, George Necula, Adam Paszke, Jake VanderPlas, Skye Wanderman-Milne, and Qiao Zhang. JAX: composable transformations of Python+NumPy programs, 2018. URL https://github.com/google/jax.

- (Brown et al., 2020) Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert- Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel Ziegler, Jeffrey Wu, Clemens Winter, Chris Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, and Dario Amodei. Language models are few-shot learners. In H. Larochelle, M. Ranzato, R. Hadsell, M.F. Balcan, and H. Lin, editors, Advances in Neural Information Processing Systems, volume 33, pages 1877–1901. Curran Associates, Inc., 2020. URL https://proceedings.neurips.cc/paper_files/paper/2020/file/1457c0d6bfcb4967418bfb8ac142f64a-Paper.pdf.

- (Chen et al., 2021) Mark Chen, Jerry Tworek, Heewoo Jun, Qiming Yuan, Henrique Ponde de Oliveira Pinto, Jared Kaplan, Harri Edwards, Yuri Burda, Nicholas Joseph, Greg Brockman, Alex Ray, Raul Puri, Gretchen Krueger, Michael Petrov, Heidy Khlaaf, Girish Sastry, Pamela Mishkin, Brooke Chan, Scott Gray, Nick Ryder, Mikhail Pavlov, Alethea Power, Lukasz Kaiser, Mohammad Bavarian, Clemens Winter, Philippe Tillet, Felipe Petroski Such, Dave Cummings, Matthias Plappert, Fotios Chantzis, Elizabeth Barnes, Ariel Herbert-Voss, William Hebgen Guss, Alex Nichol, Alex Paino, Nikolas Tezak, Jie Tang, Igor Babuschkin, Suchir Balaji, Shantanu Jain, William Saunders, Christopher Hesse, Andrew N. Carr, Jan Leike, Josh Achiam, Vedant Misra, Evan Morikawa, Alec Radford, Matthew Knight, Miles Brundage, Mira Murati, Katie Mayer, Peter Welinder, Bob McGrew, Dario Amodei, Sam McCandlish, Ilya Sutskever, and Wojciech Zaremba. Evaluating large language models trained on code. arXiv preprint arXiv:2107.03374, 2021. URL https://arxiv.org/abs/2107.03374.

- (Chen et al., 2022) Xi Chen, Xiao Wang, Soravit Changpinyo, A J Piergiovanni, Piotr Padlewski, Daniel Salz, Sebastian Goodman, Adam Grycner, Basil Mustafa, Lucas Beyer, Alexander Kolesnikov, Joan Puigcerver, Nan Ding, Keran Rong, Hassan Akbari, Gaurav Mishra, Linting Xue, Ashish Thapliyal, James Bradbury, Weicheng Kuo, Mojtaba Seyedhosseini, Chao Jia, Burcu Karagol Ayan, Carlos Riquelme, Andreas Steiner, Anelia Angelova, Xiaohua Zhai, Neil Houlsby, and Radu Soricut. PaLI: A jointlyscaled multilingual language-image model. arXiv preprint arXiv:2209.06794, 2022. URL https://arxiv.org/abs/2209.06794.

- (Chen et al., 2023) Xi Chen, Josip Djolonga, Piotr Padlewski, Basil Mustafa, Soravit Changpinyo, Jialin Wu, Carlos Riquelme Ruiz, Sebastian Goodman, Xiao Wang, Yi Tay, Siamak Shakeri, Mostafa Dehghani, Daniel Salz, Mario Lucic, Michael Tschannen, Arsha Nagrani, Hexiang Hu, Mandar Joshi, Bo Pang, Ceslee Montgomery, Paulina Pietrzyk, Marvin Ritter, AJ Piergiovanni, Matthias Minderer, Filip Pavetic, Austin Waters, Gang Li, Ibrahim Alabdulmohsin, Lucas Beyer, Julien Amelot, Kenton Lee, Andreas Peter Steiner, Yang Li, Daniel Keysers, Anurag Arnab, Yuanzhong Xu, Keran Rong, Alexander Kolesnikov, Mojtaba Seyedhosseini, Anelia Angelova, Xiaohua Zhai, Neil Houlsby, and Radu Soricut. PaLI-X: On Scaling up a Multilingual Vision and Language Model. arXiv preprint arXiv:2305.18565, 2023.

- (Chowdhery et al., 2023) Aakanksha Chowdhery, Sharan Narang, Jacob Devlin, Maarten Bosma, Gaurav Mishra, Adam Roberts, Paul Barham, Hyung Won Chung, Charles Sutton, Sebastian Gehrmann, Parker Schuh, Kensen Shi, Sasha Tsvyashchenko, Joshua Maynez, Abhishek Rao, Parker Barnes, Yi Tay, Noam Shazeer, Vinodkumar Prabhakaran, Emily Reif, Nan Du, Ben Hutchinson, Reiner Pope, James Bradbury, Jacob Austin, Michael Isard, Guy Gur-Ari, Pengcheng Yin, Toju Duke, Anselm Levskaya, Sanjay Ghemawat, Sunipa Dev, Henryk Michalewski, Xavier Garcia, Vedant Misra, Kevin Robinson, Liam Fedus, Denny Zhou, Daphne Ippolito, David Luan, Hyeontaek Lim, Barret Zoph, Alexander Spiridonov, Ryan Sepassi, David Dohan, Shivani Agrawal, Mark Omernick, Andrew M. Dai, Thanumalayan Sankaranarayana Pillai, Marie Pellat, Aitor Lewkowycz, Erica Moreira, Rewon Child, Oleksandr Polozov, Katherine Lee, Zongwei Zhou, Xuezhi Wang, Brennan Saeta, Mark Diaz, Orhan Firat, Michele Catasta, Jason Wei, Kathy Meier-Hellstern, Douglas Eck, Jeff Dean, Slav Petrov, and Noah Fiedel. Palm: Scaling language modeling with pathways. Journal of Machine Learning Research, 24(240): 1–113, 2023. URL https://jmlr.org/papers/v24/22-1144.html.

- (Clark et al., 2019) Christopher Clark, Kenton Lee, Ming-Wei Chang, Tom Kwiatkowski, Michael Collins, and Kristina Toutanova. BoolQ: Exploring the surprising difficulty of natural yes/no questions. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), pages 2924–2936, 2019. URL https://aclanthology.org/N19-1300.

- (Clark et al., 2020) Jon Clark, Eunsol Choi, Michael Collins, Dan Garrette, Tom Kwiatkowski, Vitaly Nikolaev, and Jennimaria Palomaki. TydiQA: A benchmark for information-seeking question answering in typologically diverse languages. Transactions of the Association for Computational Linguistics, 2020. URL https://storage.googleapis.com/tydiqa/tydiqa.pdf.

- (Cobbe et al., 2021) Karl Cobbe, Vineet Kosaraju, Mohammad Bavarian, Jacob Hilton, Reiichiro Nakano, Christopher Hesse, and John Schulman. Training verifiers to solve math word problems. arXiv preprint arXiv:2110.14168, 2021. URL https://arxiv.org/abs/2110.14168.

- (Conneau et al., 2023) Alexis Conneau, Min Ma, Simran Khanuja, Yu Zhang, Vera Axelrod, Siddharth Dalmia, Jason Riesa, Clara Rivera, and Ankur Bapna. Fleurs: Few-shot learning evaluation of universal representations of speech. In 2022 IEEE Spoken Language Technology Workshop (SLT), pages 798–805. IEEE, 2023.

- (Dean et al., 2012) Jeffrey Dean, Greg Corrado, Rajat Monga, Kai Chen, Matthieu Devin, Mark Mao, Marc’aurelio Ranzato, Andrew Senior, Paul Tucker, Ke Yang, et al. Large scale distributed deep networks. Advances in neural information processing systems, 25, 2012.

- (Dixit et al., 2021) Harish Dattatraya Dixit, Sneha Pendharkar, Matt Beadon, Chris Mason, Tejasvi Chakravarthy, Bharath Muthiah, and Sriram Sankar. Silent data corruptions at scale. arXiv preprint arXiv:2102.11245, 2021.

- (Dosovitskiy et al., 2020) Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, and Neil Houlsby. An image is worth 16x16 words: Transformers for image recognition at scale. In ICLR, 2020.

- (Dua et al., 2019) Dheeru Dua, Yizhong Wang, Pradeep Dasigi, Gabriel Stanovsky, Sameer Singh, and Matt Gardner. DROP: A reading comprehension benchmark requiring discrete reasoning over paragraphs. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), pages 2368–2378, 2019. URL https://aclanthology.org/N19-1246.

- (Federmann et al., 2022) Christian Federmann, Tom Kocmi, and Ying Xin. NTREX-128 – news test references for MT evaluation of 128 languages. In Proceedings of the First Workshop on Scaling Up Multilingual Evaluation, pages 21–24, Online, nov 2022. Association for Computational Linguistics. URL https://aclanthology.org/2022.sumeval-1.4.

- (Google, 2023) Google. Google’s AI Principles. 2023. URL https://ai.google/responsibility/principles/.

- (Goyal et al., 2017) Yash Goyal, Tejas Khot, Douglas Summers-Stay, Dhruv Batra, and Devi Parikh. Making the V in VQA matter: Elevating the role of image understanding in visual question answering. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 6904–6913, 2017.

- (Hasan et al., 2021) Tahmid Hasan, Abhik Bhattacharjee, Md. Saiful Islam, Kazi Mubasshir, Yuan-Fang Li, Yong-Bin Kang, M. Sohel Rahman, and Rifat Shahriyar. XL-sum: Large-scale multilingual abstractive summarization for 44 languages. In Findings of the Association for Computational Linguistics: ACL-IJCNLP 2021, pages 4693–4703, Online, August 2021. Association for Computational Linguistics. doi: 10.18653/v1/2021.findings-acl.413. URL https://aclanthology.org/2021.findings-acl.413.

- (Hendrycks et al., 2021a) Dan Hendrycks, Collin Burns, Steven Basart, Andy Zou, Mantas Mazeika, Dawn Song, and Jacob Steinhardt. Measuring massive multitask language understanding. Proceedings of the International Conference on Learning Representations (ICLR), 2021a.

- (Hendrycks et al., 2021b) Dan Hendrycks, Collin Burns, Saurav Kadavath, Akul Arora, Steven Basart, Eric Tang, Dawn Song, and Jacob Steinhardt. Measuring mathematical problem solving with the MATH dataset. arXiv preprint arXiv:2103.03874, 2021b. URL https://arxiv.org/abs/2103.03874.

- (Hochschild et al., 2021) Peter H Hochschild, Paul Turner, Jeffrey C Mogul, Rama Govindaraju, Parthasarathy Ranganathan, David E Culler, and Amin Vahdat. Cores that don’t count. In Proceedings of the Workshop on Hot Topics in Operating Systems, pages 9–16, 2021.

- (Hoffmann et al., 2022) Jordan Hoffmann, Sebastian Borgeaud, Arthur Mensch, Elena Buchatskaya, Trevor Cai, Eliza Rutherford, Diego de Las Casas, Lisa Anne Hendricks, Johannes Welbl, Aidan Clark, Tom Hennigan, Eric Noland, Katie Millican, George van den Driessche, Bogdan Damoc, Aurelia Guy, Simon Osindero, Karen Simonyan, Erich Elsen, Jack W. Rae, Oriol Vinyals, and Laurent Sifre. Training computeoptimal large language models. arXiv preprint arXiv:2203.15556, 2022.

- (Hu et al., 2023) Shengding Hu, Yifan Luo, Huadong Wang, Xingyi Cheng, Zhiyuan Liu, and Maosong Sun. Won’t get fooled again: Answering questions with false premises. arXiv preprint arXiv:2307.02394, 2023.

- (Hwang and Shwartz, 2023) EunJeong Hwang and Vered Shwartz. Memecap: A dataset for captioning and interpreting memes, 2023.

- (Jouppi et al., 2023) Norm Jouppi, George Kurian, Sheng Li, Peter Ma, Rahul Nagarajan, Lifeng Nai, Nishant Patil, Suvinay Subramanian, Andy Swing, Brian Towles, et al. Tpu v4: An optically reconfigurable supercomputer for machine learning with hardware support for embeddings. In Proceedings of the 50th Annual International Symposium on Computer Architecture, pages 1–14, 2023.

- (Kalyan et al., 2021) Ashwin Kalyan, Abhinav Kumar, Arjun Chandrasekaran, Ashish Sabharwal, and Peter Clark. How much coffee was consumed during emnlp 2019? fermi problems: A new reasoning challenge for ai, 2021.

- (Kasai et al., 2022) Jungo Kasai, Keisuke Sakaguchi, Yoichi Takahashi, Ronan Le Bras, Akari Asai, Xinyan Yu, Dragomir Radev, Noah A. Smith, Yejin Choi, and Kentaro Inui. RealTime QA: What’s the answer right now?, 2022. URL https://arxiv.org/abs/2207.13332.

- (Kavukcuoglu et al., 2022) K Kavukcuoglu, P Kohli, L Ibrahim, D Bloxwich, and S Brown. How our principles helped define alphafold’s release. google deepmind, 2022.

- Aniruddha Kembhavi, Mike Salvato, Eric Kolve, Minjoon Seo, Hannaneh Hajishirzi, and Ali Farhadi. A diagram is worth a dozen images. In ECCV, 2016.

- (Kočiský et al., 2018) Tomáš Kočiský, Jonathan Schwarz, Phil Blunsom, Chris Dyer, Karl Moritz Hermann, Gábor Melis, and Edward Grefenstette. The NarrativeQA reading comprehension challenge. Transactions of the Association for Computational Linguistics, 6:317–328, 2018. doi: 10.1162/tacl_a_00023. URL https://aclanthology.org/Q18-1023.

- (Kocmi et al., 2022) Tom Kocmi, Rachel Bawden, Ondřej Bojar, Anton Dvorkovich, Christian Federmann, Mark Fishel, Thamme Gowda, Yvette Graham, Roman Grundkiewicz, Barry Haddow, Rebecca Knowles, Philipp Koehn, Christof Monz, Makoto Morishita, Masaaki Nagata, Toshiaki Nakazawa, Michal Novák, Martin Popel, and Maja Popović. Findings of the 2022 conference on machine translation (WMT22). In Proceedings of the Seventh Conference on Machine Translation (WMT), December 2022. URL https://aclanthology.org/2022.wmt-1.1.

- (Kojima et al., 2022) Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, and Yusuke Iwasawa. Large language models are zero-shot reasoners. NeurIPS, 2022. URL https://arxiv.org/abs/2205.11916.

- (Kudo and Richardson, 2018) Taku Kudo and John Richardson. SentencePiece: A simple and language independent subword tokenizer and detokenizer for neural text processing. EMNLP (System Demonstrations), 2018. doi: 10.18653/v1/D18-2012. URL https://aclanthology.org/D18-2012.

- (Kwiatkowski et al., 2019) Tom Kwiatkowski, Jennimaria Palomaki, Olivia Redfield, Michael Collins, Ankur Parikh, Chris Alberti, Danielle Epstein, Illia Polosukhin, Jacob Devlin, Kenton Lee, Kristina Toutanova, Llion Jones, Matthew Kelcey, Ming-Wei Chang, Andrew M. Dai, Jakob Uszkoreit, Quoc Le, and Slav Petrov. Natural questions: A benchmark for question answering research. Transactions of the Association for Computational Linguistics, 7:452–466, 2019. doi: 10.1162/tacl_a_00276. URL https:// aclanthology.org/Q19-1026.

- (Ladhak et al., 2020) Faisal Ladhak, Esin Durmus, Claire Cardie, and Kathleen McKeown. WikiLingua: A new benchmark dataset for cross-lingual abstractive summarization. In Findings of the Association for Computational Linguistics: EMNLP 2020, pages 4034–4048, Online, November 2020. Association for Computational Linguistics. doi: 10.18653/v1/2020.findings-emnlp.360. URL https://www.aclweb.org/anthology/2020.findings-emnlp.360.

- (Leblond et al., 2023) Leblond et al. AlphaCode 2 Technical Report. 2023. URL https://storage.googleapis.com/deepmind-media/AlphaCode2/AlphaCode2_Tech_Report.pdf.

- (LeCun et al., 2015) Yann LeCun, Yoshua Bengio, and Geoffrey Hinton. Deep learning. nature, 521(7553):436–444, 2015.

- (Li et al., 2022) Yujia Li, David Choi, Junyoung Chung, Nate Kushman, Julian Schrittwieser, Rémi Leblond, Tom Eccles, James Keeling, Felix Gimeno, Agustin Dal Lago, et al. Competition-level code generation with alphacode. Science, 378(6624):1092–1097, 2022.

- (Lin et al., 2023) Bin Lin, Bin Zhu, Yang Ye, Munan Ning, Peng Jin, and Li Yuan. Video-llava: Learning united visual representation by alignment before projection. arXiv preprint arXiv:2311.10122, 2023.

- (Lu et al., 2021) Pan Lu, Ran Gong, Shibiao Jiang, Liang Qiu, Siyuan Huang, Xiaodan Liang, and Song-Chun Zhu. Inter-gps: Interpretable geometry problem solving with formal language and symbolic reasoning. In The Joint Conference of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (ACL-IJCNLP 2021), 2021.

- (Lu et al., 2023) Pan Lu, Hritik Bansal, Tony Xia, Jiacheng Liu, Chunyuan Li, Hannaneh Hajishirzi, Hao Cheng, Kai- Wei Chang, Michel Galley, and Jianfeng Gao. Mathvista: Evaluating mathematical reasoning of foundation models in visual contexts. arXiv preprint arXiv:2310.02255, 2023.

- (Masry et al., 2022) Ahmed Masry, Do Long, Jia Qing Tan, Shafiq Joty, and Enamul Hoque. ChartQA: A benchmark for question answering about charts with visual and logical reasoning. In Findings of ACL, 2022.

- (Mathew et al., 2021) Minesh Mathew, Dimosthenis Karatzas, and CV Jawahar. Docvqa: A dataset for vqa on document images. In Proceedings of the IEEE/CVF winter conference on applications of computer vision, pages 2200–2209, 2021.

- (Mathew et al., 2022) Minesh Mathew, Viraj Bagal, Rubèn Tito, Dimosthenis Karatzas, Ernest Valveny, and CV Jawahar. Infographicvqa. In Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, pages 1697–1706, 2022.

- (Menick et al., 2022) Jacob Menick, Maja Trebacz, Vladimir Mikulik, John Aslanides, Francis Song, Martin Chadwick, Mia Glaese, Susannah Young, Lucy Campbell-Gillingham, Geoffrey Irving, et al. Teaching language models to support answers with verified quotes. arXiv preprint arXiv:2203.11147, 2022.

- (Michalak et al., 2012) Sarah E. Michalak, Andrew J. DuBois, Curtis B. Storlie, Heather M. Quinn, William N. Rust, David H. DuBois, David G. Modl, Andrea Manuzzato, and Sean P. Blanchard. Assessment of the impact of cosmic-ray-induced neutrons on hardware in the roadrunner supercomputer. IEEE Transactions on Device and Materials Reliability, 12(2):445–454, 2012. doi: 10.1109/TDMR.2012.2192736.

- (Mihaylov et al., 2018) Todor Mihaylov, Peter Clark, Tushar Khot, and Ashish Sabharwal. Can a suit of armor conduct electricity? a new dataset for open book question answering. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, pages 2381–2391, Brussels, Belgium, October- November 2018. Association for Computational Linguistics. doi: 10.18653/v1/D18-1260. URL https://aclanthology.org/D18-1260.

- (Narayan et al., 2018) Shashi Narayan, Shay B. Cohen, and Mirella Lapata. Don’t give me the details, just the summary! topic-aware convolutional neural networks for extreme summarization. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, pages 1797–1807, Brussels, Belgium, October-November 2018. Association for Computational Linguistics. doi: 10.18653/v1/ D18-1206. URL https://aclanthology.org/D18-1206.

- (Oktatási Hivatal, 2023) Oktatási Hivatal. Matematika írásbéli vizsga. Középszintű Írásbéli Vizsga, May 2023. URL https://dload-oktatas.educatio.hu/erettsegi/feladatok_2023tavasz_kozep/k_matang_23maj_fl.pdf. Angol Nyelven.

- (OpenAI, 2023a) OpenAI. GPT-4 Technical Report. 2023a.

- (OpenAI, 2023b) OpenAI. GPT-4V(ision) System Card, 2023b.

- (OpenAI, 2023) OpenAI. Whisper, 2023. URL https://github.com/openai/whisper.

- (Ouyang et al., 2022) Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Peter Welinder, Paul Christiano, Jan Leike, and Ryan Lowe. Training language models to follow instructions with human feedback. Preprint, 2022. URL https://cdn.openai.com/papers/Training_language_models_to_follow_instructions_with_human_feedback.pdf.

- (Panayotov et al., 2015) Vassil Panayotov, Guoguo Chen, Daniel Povey, and Sanjeev Khudanpur. Librispeech: an asr corpus based on public domain audio books. In 2015 IEEE international conference on acoustics, speech and signal processing (ICASSP), pages 5206–5210. IEEE, 2015.

- (Paperno et al., 2016) Denis Paperno, Germán Kruszewski, Angeliki Lazaridou, Quan Ngoc Pham, Raffaella Bernardi, Sandro Pezzelle, Marco Baroni, Gemma Boleda, and Raquel Fernández. The LAMBADA dataset: Word prediction requiring a broad discourse context. arXiv preprint arXiv:1606.06031, 2016.

- (Pătrăucean et al., 2023) Viorica Pătrăucean, Lucas Smaira, Ankush Gupta, Adrià Recasens Continente, Larisa Markeeva, Dylan Banarse, Skanda Koppula, Joseph Heyward, Mateusz Malinowski, Yi Yang, et al. Perception test: A diagnostic benchmark for multimodal video models. arXiv preprint arXiv:2305.13786, 2023.

- (Peng et al., 2023) Baolin Peng, Michel Galley, Pengcheng He, Hao Cheng, Yujia Xie, Yu Hu, Qiuyuan Huang, Lars Liden, Zhou Yu, Weizhu Chen, et al. Check your facts and try again: Improving large language models with external knowledge and automated feedback. arXiv preprint arXiv:2302.12813, 2023.

- (Poutievski et al., 2022) Leon Poutievski, Omid Mashayekhi, Joon Ong, Arjun Singh, Mukarram Tariq, RuiWang, Jianan Zhang, Virginia Beauregard, Patrick Conner, Steve Gribble, et al. Jupiter evolving: transforming google’s datacenter network via optical circuit switches and software-defined networking. In Proceedings of the ACM SIGCOMM 2022 Conference, pages 66–85, 2022.

- (Radford et al., 2019) Alec Radford, Jeffrey Wu, Rewon Child, David Luan, Dario Amodei, and Ilya Sutskever. Language models are unsupervised multitask learners. OpenAI blog, 1(8):9, 2019. URL https://d4mucfpksywv.cloudfront.net/better-language-models/language_models_are_unsupervised_multitask_learners.pdf.

- (Radford et al., 2023) Alec Radford, Jong Wook Kim, Tao Xu, Greg Brockman, Christine McLeavey, and Ilya Sutskever. Robust speech recognition via large-scale weak supervision. In International Conference on Machine Learning, pages 28492–28518. PMLR, 2023.

- (Rae et al., 2021) Jack W. Rae, Sebastian Borgeaud, Trevor Cai, Katie Millican, Jordan Hoffmann, H. Francis Song, John Aslanides, Sarah Henderson, Roman Ring, Susannah Young, Eliza Rutherford, Tom Hennigan, Jacob Menick, Albin Cassirer, Richard Powell, George van den Driessche, Lisa Anne Hendricks, Maribeth Rauh, Po-Sen Huang, Amelia Glaese, Johannes Welbl, Sumanth Dathathri, Saffron Huang, Jonathan Uesato, John Mellor, Irina Higgins, Antonia Creswell, Nat McAleese, Amy Wu, Erich Elsen, Siddhant M. Jayakumar, Elena Buchatskaya, David Budden, Esme Sutherland, Karen Simonyan, Michela Paganini, Laurent Sifre, Lena Martens, Xiang Lorraine Li, Adhiguna Kuncoro, Aida Nematzadeh, Elena Gribovskaya, Domenic Donato, Angeliki Lazaridou, Arthur Mensch, Jean- Baptiste Lespiau, Maria Tsimpoukelli, Nikolai Grigorev, Doug Fritz, Thibault Sottiaux, Mantas Pajarskas, Toby Pohlen, Zhitao Gong, Daniel Toyama, Cyprien de Masson d’Autume, Yujia Li, Tayfun Terzi, Vladimir Mikulik, Igor Babuschkin, Aidan Clark, Diego de Las Casas, Aurelia Guy, Chris Jones, James Bradbury, Matthew Johnson, Blake A. Hechtman, Laura Weidinger, Iason Gabriel, William S. Isaac, Edward Lockhart, Simon Osindero, Laura Rimell, Chris Dyer, Oriol Vinyals, Kareem Ayoub, Jeff Stanway, Lorrayne Bennett, Demis Hassabis, Koray Kavukcuoglu, and Geoffrey Irving. Scaling language models: Methods, analysis & insights from training Gopher. CoRR, abs/2112.11446, 2021.

- (Ramesh et al., 2021) Aditya Ramesh, Mikhail Pavlov, Gabriel Goh, Scott Gray, Chelsea Voss, Alec Radford, Mark Chen, and Ilya Sutskever. Zero-shot text-to-image generation. In International Conference on Machine Learning, pages 8821–8831. PMLR, 2021.

- (Rashkin et al., 2023) Hannah Rashkin, Vitaly Nikolaev, Matthew Lamm, Lora Aroyo, Michael Collins, Dipanjan Das, Slav Petrov, Gaurav Singh Tomar, Iulia Turc, and David Reitter. Measuring attribution in natural language generation models. Computational Linguistics, pages 1–64, 2023.

- (Reed et al., 2022) Scott Reed, Konrad Zolna, Emilio Parisotto, Sergio Gomez Colmenarejo, Alexander Novikov, Gabriel Barth-Maron, Mai Gimenez, Yury Sulsky, Jackie Kay, Jost Tobias Springenberg, et al. A generalist agent. arXiv preprint arXiv:2205.06175, 2022.

- (Riley et al., 2023) Parker Riley, Timothy Dozat, Jan A Botha, Xavier Garcia, Dan Garrette, Jason Riesa, Orhan Firat, and Noah Constant. Frmt: A benchmark for few-shot region-aware machine translation. Transactions of the Association for Computational Linguistics, 2023.

- (Ritchie et al., 2023) Hannah Ritchie, Veronika Samborska, and Max Roser. Plastic pollution. Our World in Data, 2023. https://ourworldindata.org/plastic-pollution.

- (Roberts et al., 2020) Adam Roberts, Colin Raffel, and Noam Shazeer. How much knowledge can you pack into the parameters of a language model? In Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), pages 5418–5426, Online, November 2020. Association for Computational Linguistics. doi: 10.18653/v1/2020.emnlp-main.437. URL https://aclanthology.org/2020.emnlp-main.437.

- (Sellam et al., 2020) Thibault Sellam, Dipanjan Das, and Ankur Parikh. BLEURT: Learning robust metrics for text generation. In Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, pages 7881–7892, Online, July 2020. Association for Computational Linguistics. doi: 10.18653/v1/2020.acl-main.704. URL https://aclanthology.org/2020.acl-main.704.

- (Shaham et al., 2022) Uri Shaham, Elad Segal, Maor Ivgi, Avia Efrat, Ori Yoran, Adi Haviv, Ankit Gupta, Wenhan Xiong, Mor Geva, Jonathan Berant, and Omer Levy. SCROLLS: Standardized CompaRison over long language sequences. In Proceedings of the 2022 Conference on Empirical Methods in Natural Language Processing, pages 12007–12021, Abu Dhabi, United Arab Emirates, December 2022. Association for Computational Linguistics. URL https://aclanthology.org/2022.emnlp-main.823.

- (Shazeer, 2019) Noam Shazeer. Fast transformer decoding: One write-head is all you need. arXiv preprint arXiv:1911.02150, 2019.

- (Shevlane et al., 2023) Toby Shevlane, Sebastian Farquhar, Ben Garfinkel, Mary Phuong, Jess Whittlestone, Jade Leung, Daniel Kokotajlo, Nahema Marchal, Markus Anderljung, Noam Kolt, et al. Model evaluation for extreme risks. arXiv preprint arXiv:2305.15324, 2023.

- (Shi et al., 2023) Freda Shi, Mirac Suzgun, Markus Freitag, Xuezhi Wang, Suraj Srivats, Soroush Vosoughi, Hyung Won Chung, Yi Tay, Sebastian Ruder, Denny Zhou, et al. Language models are multilingual chain-ofthought reasoners. ICLR, 2023.

- (Singh et al., 2019) Amanpreet Singh, Vivek Natarajan, Meet Shah, Yu Jiang, Xinlei Chen, Dhruv Batra, Devi Parikh, and Marcus Rohrbach. Towards VQA models that can read. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, pages 8317–8326, 2019.

- (Srivastava et al., 2022) Aarohi Srivastava, Abhinav Rastogi, Abhishek Rao, Abu Awal Md Shoeb, Abubakar Abid, Adam Fisch, Adam R. Brown, et al. Beyond the imitation game: Quantifying and extrapolating the capabilities of language models. arXiv preprint arXiv:2206.04615, 2022. URL https://arxiv.org/abs/2206.04615.

- (Sutskever et al., 2014) Ilya Sutskever, Oriol Vinyals, and Quoc V Le. Sequence to sequence learning with neural networks. Advances in neural information processing systems, 27, 2014.

- (Tafjord et al., 2020) Oyvind Tafjord, Bhavana Dalvi, and Peter Clark. ProofWriter: Generating implications, proofs, and abductive statements over natural language. In Findings, 2020. URL https://api.semanticscholar.org/CorpusID:229371222.

- (Team et al., 2022) NLLB Team, Marta R. Costa-jussà, James Cross, Onur Çelebi, Maha Elbayad, Kenneth Heafield, Kevin Heffernan, Elahe Kalbassi, Janice Lam, Daniel Licht, Jean Maillard, Anna Sun, Skyler Wang, Guillaume Wenzek, Al Youngblood, Bapi Akula, Loic Barrault, Gabriel Mejia Gonzalez, Prangthip Hansanti, John Hoffman, Semarley Jarrett, Kaushik Ram Sadagopan, Dirk Rowe, Shannon Spruit, Chau Tran, Pierre Andrews, Necip Fazil Ayan, Shruti Bhosale, Sergey Edunov, Angela Fan, Cynthia Gao, Vedanuj Goswami, Francisco Guzmán, Philipp Koehn, Alexandre Mourachko, Christophe Ropers, Safiyyah Saleem, Holger Schwenk, and Jeff Wang. No language left behind: Scaling human-centered machine translation. 2022.

- (Thapliyal et al., 2022) Ashish V. Thapliyal, Jordi Pont-Tuset, Xi Chen, and Radu Soricut. Crossmodal-3600: A massively multilingual multimodal evaluation dataset. In EMNLP, 2022.

- (Tom et al., 2023) Kocmi Tom, Eleftherios Avramidis, Rachel Bawden, Ondřej Bojar, Anton Dvorkovich, Christian Federmann, Mark Fishel, Markus Freitag, Thamme Gowda, Roman Grundkiewicz, et al. Findings of the 2023 conference on machine translation (wmt23): Llms are here but not quite there yet. In WMT23-Eighth Conference on Machine Translation, pages 198–216, 2023.

- (Touvron et al., 2023a) Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971, 2023a.

- (Touvron et al., 2023b) Hugo Touvron, Louis Martin, Kevin Stone, Peter Albert, Amjad Almahairi, Yasmine Babaei, Nikolay Bashlykov, Soumya Batra, Prajjwal Bhargava, Shruti Bhosale, et al. Llama 2: Open foundation and fine-tuned chat models. arXiv preprint arXiv:2307.09288, 2023b.

- (Vaswani et al., 2017) Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, and Illia Polosukhin. Attention is all you need. CoRR, abs/1706.03762, 2017. URL https://arxiv.org/abs/1706.03762.

- (Veličković et al., 2022) Petar Veličković, Adrià Puigdomènech Badia, David Budden, Razvan Pascanu, Andrea Banino, Misha Dashevskiy, Raia Hadsell, and Charles Blundell. The clrs algorithmic reasoning benchmark. arXiv preprint arXiv:2205.15659, 2022.

- (Vishwanathan et al., 2015) Manoj Vishwanathan, Ronak Shah, Kyung Ki Kim, and Minsu Choi. Silent data corruption (sdc) vulnerability of gpu on various gpgpu workloads. In 2015 International SoC Design Conference (ISOCC), pages 11–12, 2015. doi: 10.1109/ISOCC.2015.7401681.

- (Wang et al., 2020) Changhan Wang, Anne Wu, and Juan Pino. Covost 2 and massively multilingual speech-to-text translation. arXiv preprint arXiv:2007.10310, 2020.

- (Wang et al., 2021) Changhan Wang, Morgane Riviere, Ann Lee, Anne Wu, Chaitanya Talnikar, Daniel Haziza, Mary Williamson, Juan Pino, and Emmanuel Dupoux. Voxpopuli: A large-scale multilingual speech corpus for representation learning, semi-supervised learning and interpretation. arXiv preprint arXiv:2101.00390, 2021.

- (Wang et al., 2019) Xin Wang, Jiawei Wu, Junkun Chen, Lei Li, Yuan-Fang Wang, and William Yang Wang. VATEX: A large-scale, high-quality multilingual dataset for video-and-language research. In ICCV, 2019.

- (Wang et al., 2022) Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc Le, Ed Chi, and Denny Zhou. Self-consistency improves chain of thought reasoning in language models. arXiv preprint arXiv:2203.11171, 2022.

- (Wei et al., 2022) Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, and Denny Zhou. Chain-of-thought prompting elicits reasoning in large language models. NeurIPS, 2022. URL https://arxiv.org/abs/2201.11903.

- (Weidinger et al., 2021) Laura Weidinger, John Mellor, Maribeth Rauh, Conor Griffin, Jonathan Uesato, Po-Sen Huang, Myra Cheng, Mia Glaese, Borja Balle, Atoosa Kasirzadeh, Zac Kenton, Sasha Brown, Will Hawkins, Tom Stepleton, Courtney Biles, Abeba Birhane, Julia Haas, Laura Rimell, Lisa Anne Hendricks, William S. Isaac, Sean Legassick, Geoffrey Irving, and Iason Gabriel. Ethical and social risks of harm from language models. CoRR, abs/2112.04359, 2021. URL https://arxiv.org/abs/2112.04359.

- (Wetherall et al., 2023) David Wetherall, Abdul Kabbani, Van Jacobson, Jim Winget, Yuchung Cheng, Brad Morrey, Uma Parthavi Moravapalle, Phillipa Gill, Steven Knight, and Amin Vahdat. Improving network availability with protective reroute. In SIGCOMM 2023, 2023. URL https://dl.acm.org/doi/10.1145/3603269.3604867.

- (Xiao et al., 2021) Junbin Xiao, Xindi Shang, Angela Yao, and Tat-Seng Chua. NExT-QA: Next phase of question-answering to explaining temporal actions. In CVPR, 2021.

- (XLA, 2019) XLA. XLA: Optimizing compiler for TensorFlow. https://www.tensorflow.org/xla, 2019. [Online; accessed December-2023].

- (Xu et al., 2021) Yuanzhong Xu, HyoukJoong Lee, Dehao Chen, Blake Hechtman, Yanping Huang, Rahul Joshi, Maxim Krikun, Dmitry Lepikhin, Andy Ly, Marcello Maggioni, et al. Gspmd: general and scalable parallelization for ml computation graphs. arXiv preprint arXiv:2105.04663, 2021.

- (yao Hong et al., 2018) Chi yao Hong, Subhasree Mandal, Mohammad A. Alfares, Min Zhu, Rich Alimi, Kondapa Naidu Bollineni, Chandan Bhagat, Sourabh Jain, Jay Kaimal, Jeffrey Liang, Kirill Mendelev, Steve Padgett, Faro Thomas Rabe, Saikat Ray, Malveeka Tewari, Matt Tierney, Monika Zahn, Jon Zolla, Joon Ong, and Amin Vahdat. B4 and after: Managing hierarchy, partitioning, and asymmetry for availability and scale in google’s software-defined wan. In SIGCOMM’18, 2018. URL https: //conferences.sigcomm.org/sigcomm/2018/program_tuesday.html.

- (Yu et al., 2022a) Jiahui Yu, Zirui Wang, Vijay Vasudevan, Legg Yeung, Mojtaba Seyedhosseini, and Yonghui Wu. Coca: Contrastive captioners are image-text foundation models, 2022a.

- (Yu et al., 2022b) Jiahui Yu, Yuanzhong Xu, Jing Yu Koh, Thang Luong, Gunjan Baid, Zirui Wang, Vijay Vasudevan, Alexander Ku, Yinfei Yang, Burcu Karagol Ayan, et al. Scaling autoregressive models for content-rich text-to-image generation. arXiv preprint arXiv:2206.10789, 2(3):5, 2022b.

- (Yu et al., 2023) Shoubin Yu, Jaemin Cho, Prateek Yadav, and Mohit Bansal. Self-chained image-language model for video localization and question answering. arXiv preprint arXiv:2305.06988, 2023.

- (Yu et al., 2019) Zhou Yu, Dejing Xu, Jun Yu, Ting Yu, Zhou Zhao, Yueting Zhuang, and Dacheng Tao. ActivityNet-QA: A dataset for understanding complex web videos via question answering. In AAAI, 2019.

- (Yue et al., 2023) Xiang Yue, Yuansheng Ni, Kai Zhang, Tianyu Zheng, Ruoqi Liu, Ge Zhang, Samuel Stevens, Dongfu Jiang, Weiming Ren, Yuxuan Sun, Cong Wei, Botao Yu, Ruibin Yuan, Renliang Sun, Ming Yin, Boyuan Zheng, Zhenzhu Yang, Yibo Liu, Wenhao Huang, Huan Sun, Yu Su, and Wenhu Chen. Mmmu: A massive multi-discipline multimodal understanding and reasoning benchmark for expert agi, 2023.

- (Zellers et al., 2019) Rowan Zellers, Ari Holtzman, Yonatan Bisk, Ali Farhadi, and Yejin Choi. Hellaswag: Can a machine really finish your sentence? arXiv preprint arXiv:1905.07830, 2019.

- (Zhang et al., 2023) Yu Zhang, Wei Han, James Qin, Yongqiang Wang, Ankur Bapna, Zhehuai Chen, Nanxin Chen, Bo Li, Vera Axelrod, Gary Wang, et al. Google usm: Scaling automatic speech recognition beyond 100 languages. arXiv preprint arXiv:2303.01037, 2023.

- (Zheng et al., 2023) Chuanyang Zheng, Zhengying Liu, Enze Xie, Zhenguo Li, and Yu Li. Progressive-hint prompting improves reasoning in large language models, 2023.

- (Zhou et al., 2023) Kun Zhou, Yutao Zhu, Zhipeng Chen, Wentong Chen, Wayne Xin Zhao, Xu Chen, Yankai Lin, Ji-Rong Wen, and Jiawei Han. Don’t make your llm an evaluation benchmark cheater. arXiv preprint arXiv:2311.01964, 2023.

- (Zhou et al., 2018) Luowei Zhou, Chenliang Xu, and Jason J Corso. Towards automatic learning of procedures from web instructional videos. In AAAI Conference on Artificial Intelligence, pages 7590–7598, 2018.

9章:Appendix

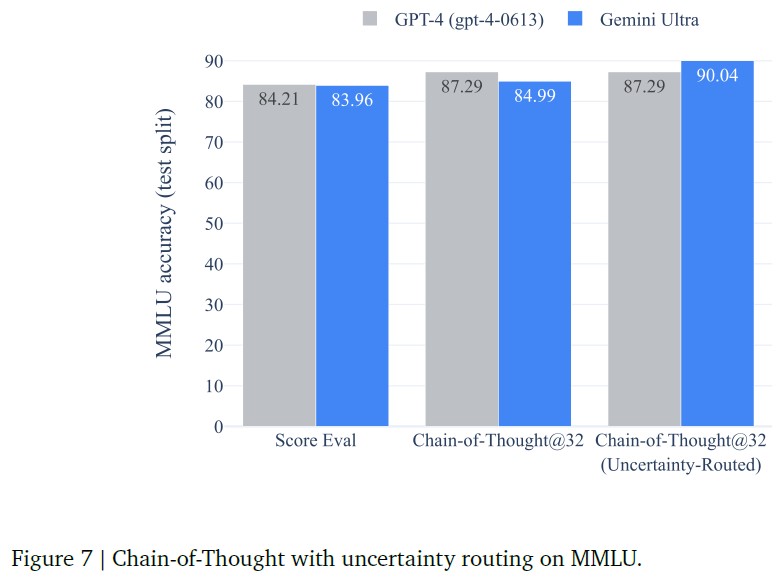

9.1節:Chain-of-Thought Comparisons on MMLU benchmark(MMLUベンチマークにおける思考連鎖の比較)

本節では,MMLUに関するいくつかの連鎖的思考アプローチを対比し,その結果について議論する.

我々は,モデルがk個の連鎖思考サンプルを生成し,モデルが閾値以上の確信度を持つ場合は多数決を選択し,そうでない場合は貪欲なサンプル選択に委ねる新しいアプローチを提案する.

閾値は各モデルの検証分割パフォーマンスに基づいて最適化される.

提案されたアプローチは不確実性ルーティング思考連鎖(uncertainty-routed chain-of-thought)と呼ばれる.

このアプローチの背後にある直感は,モデルが明らかに矛盾している場合,思考連鎖サンプルは最尤決定に比べて性能が低下する可能性があるということである.

図7で,Gemini UltraとGPT-4の両方で提案されたアプローチによる利益を比較する.

Gemini Ultraは,連鎖思考サンプルのみを使用する場合と比較して,このアプローチからより多くの利益を得ていることがわかる.

GPT-4の性能は,貪欲なサンプリングによる84.2%から,32サンプルの不確実性ルーティングされた思考連鎖型アプローチによる87.3%に向上するが,すでに32サンプルの思考連鎖型サンプルを使用することでこれらの利点を達成している.

対照的に,Gemini Ultraは,32サンプルの不確実性ルーティング思考連鎖型アプローチにより,貪欲なサンプリングによる84.0%から90.0%へと大幅に性能が向上するが,32サンプルの思考連鎖型サンプルのみを使用した場合は85.0%へとわずかに向上する.

9.2節:Capabilities and Benchmarking Tasks(能力とベンチマークタスク)

我々は,テキスト,画像,音声,ビデオにまたがるGeminiモデルを評価するための総合的な手法として,50以上のベンチマークを使用する.

テキスト理解と生成における6つの異なる能力(事実性,長い文脈,数学/科学,推論,要約,多言語性)のベンチマークタスクの詳細なリストを提供する.

また,画像理解,ビデオ理解,音声理解タスクに使用されるベンチマークも列挙する.

- 事実性:5つのベンチマークを使用

- BoolQ(Clark et al., 2019)

- NaturalQuestions-Closed(Kwiatkowski et al., 2019)

- NaturalQuestions-Retrieved(Kwiatkowski et al., 2019)

- RealtimeQA(Kasai et al., 2022)

- TydiQA-noContextおよびTydiQA-goldP(Clark et al., 2020).

- 長い文脈:6つのベンチマークを使用

- NarrativeQA(Kočiský et al., 2018)

- Scrolls-Qasper

- Scrolls-Quality(Shaham et al., 2022)

- XLsum(En)

- XLSum(non-English languages)(Hasan et al., 2021)

- その他1つの内部ベンチマーク.

- 数学/科学:8つのベンチマークを使用

- GSM8k(with CoT)(Cobbe et al., 2021)

- Hendryck's MATH pass@1(Hendrycks et al., 2021b)

- MMLU(Hendrycks et al., 2021a)

- Math-StackExchange

- Math-AMC 2022-2023年問題

- その他3つの内部ベンチマーク.

- 推論:7つのベンチマークを使用

- BigBench Hard(with CoT)(Srivastava et al., 2022)

- CLRS (Veličković et al., 2022)

- ProofWriter (Tafjord et al., 2020)

- Reasoning-Fermi problems (Kalyan et al., 2021)

- Lambada (Paperno et al., 2016)

- HellaSwag (Zellers et al., 2019)

- DROP (Dua et al., 2019).

- 要約:5つのベンチマークを使用

- XL Sum(English)

- XL Sum(non-English languages)(Hasan et al., 2021)

- WikiLingua(non-English languages)

- WikiLingua(English)(Ladhak et al., 2020)

- XSum(Narayan et al., 2018)

- 多言語性:11のベンチマークを使用(※訳注:原文では10になっています.)

- XLSum(Non-English languages)(Hasan et al., 2021)

- WMT22(Kocmi et al., 2022)

- WMT23(Tom et al., 2023)

- FRMT(Riley et al., 2023)

- WikiLingua(Non-English languages)(Ladhak et al., 2020)

- TydiQA(no context)

- TydiQA(GoldP)(Clark et al., 2020)

- MGSM(Shi et al., 2023)

- 翻訳MMLU(Hendrycks et al., 2021a)

- NTREX(Federmann et al., 2022)

- FLORES-200(Team et al., 2022).

- 画像と動画:

- 画像理解には9つのベンチマークを使用

- MMMU(Yue et al., 2023)

- TextVQA(Singh et al., 2019)

- DocVQA(Mathew et al., 2021)

- ChartQA(Masry et al., 2022)

- InfographicVQA(Mathew et al., 2022)

- MathVista(Lu et al., 2023)

- AI2D(Kembhavi et al., 2016)

- VQAv2(Goyal et al., 2017)

- 多言語画像理解のためのXM3600 (Thapliyal et al., 2022)

- 動画理解には5つのベンチマークを使用(※訳注:原文では6つになっています.)

- VATEX(Wang et al., 2019)(2つの異なる言語でのキャプション)

- YouCook2(Zhou et al., 2018)

- NextQA(Xiao et al., 2021)

- ActivityNet-QA(Yu et al., 2019)

- Perception Test MCQA(Pătrăucean et al., 2023)

- 画像理解には9つのベンチマークを使用

- 音声:4つのベンチマークを使用(※訳注:原文では4つになっています.)

- FLEURS(Conneau et al., 2023)

- VoxPopuli(Wang et al., 2021)

- Multi-lingual Librispeech(Panayotov et al., 2015)などの自動音声認識(ASR:Automatic Speech Recognition)タスク

- CoVoST 2 (Wang et al., 2020)のような自動音声翻訳タスク.

9.3節:Qualitative Examples(定性的な例)

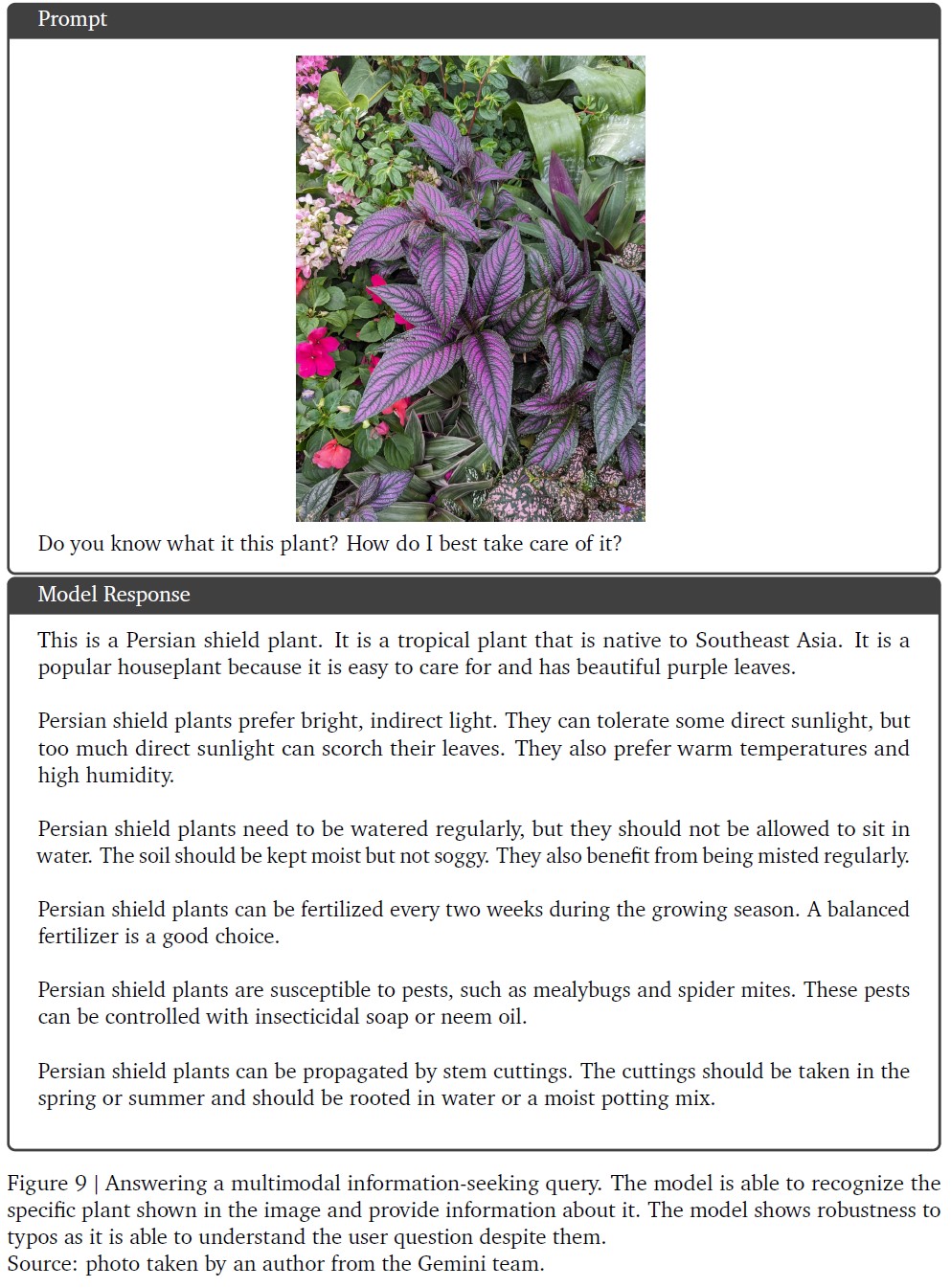

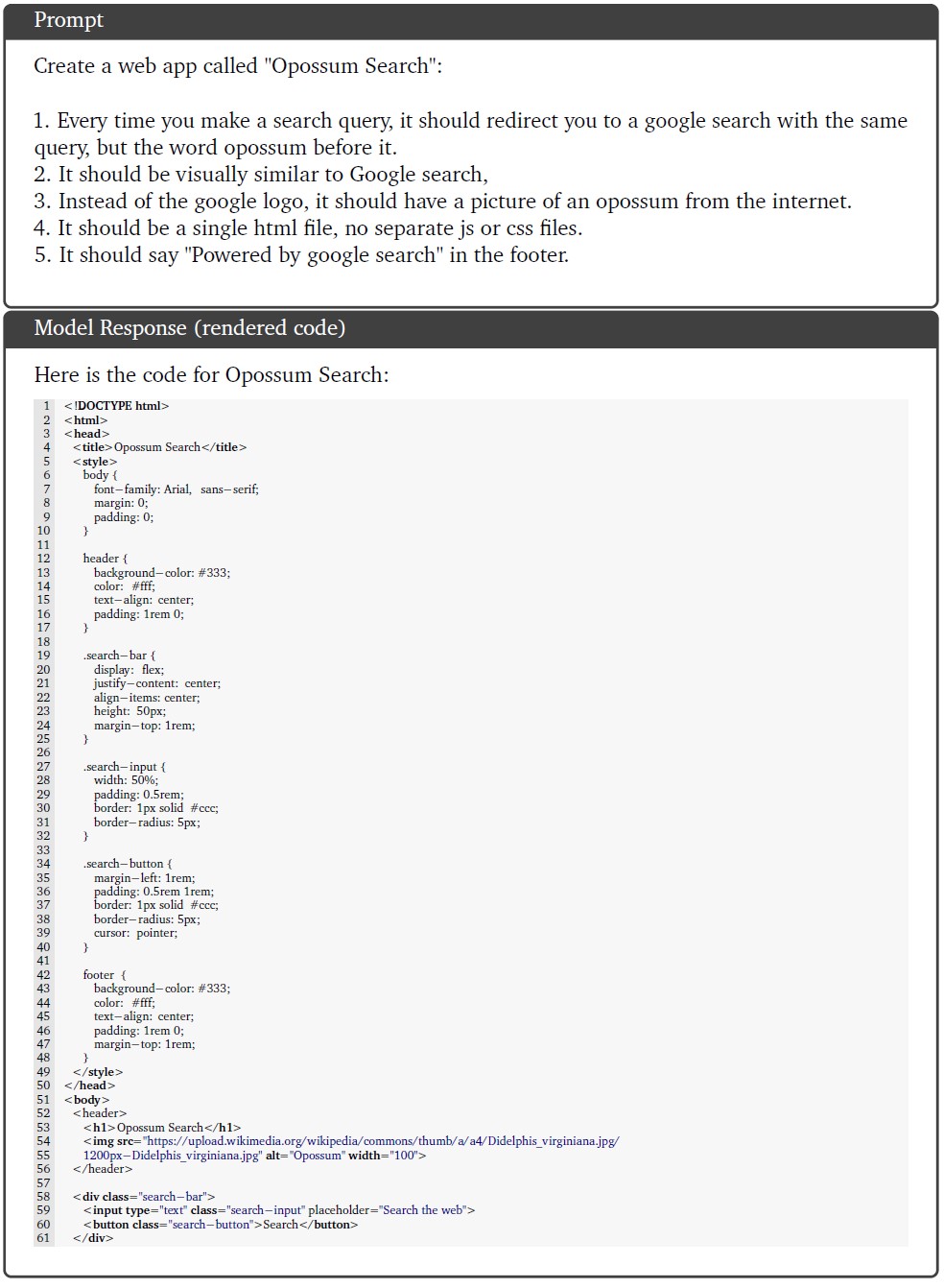

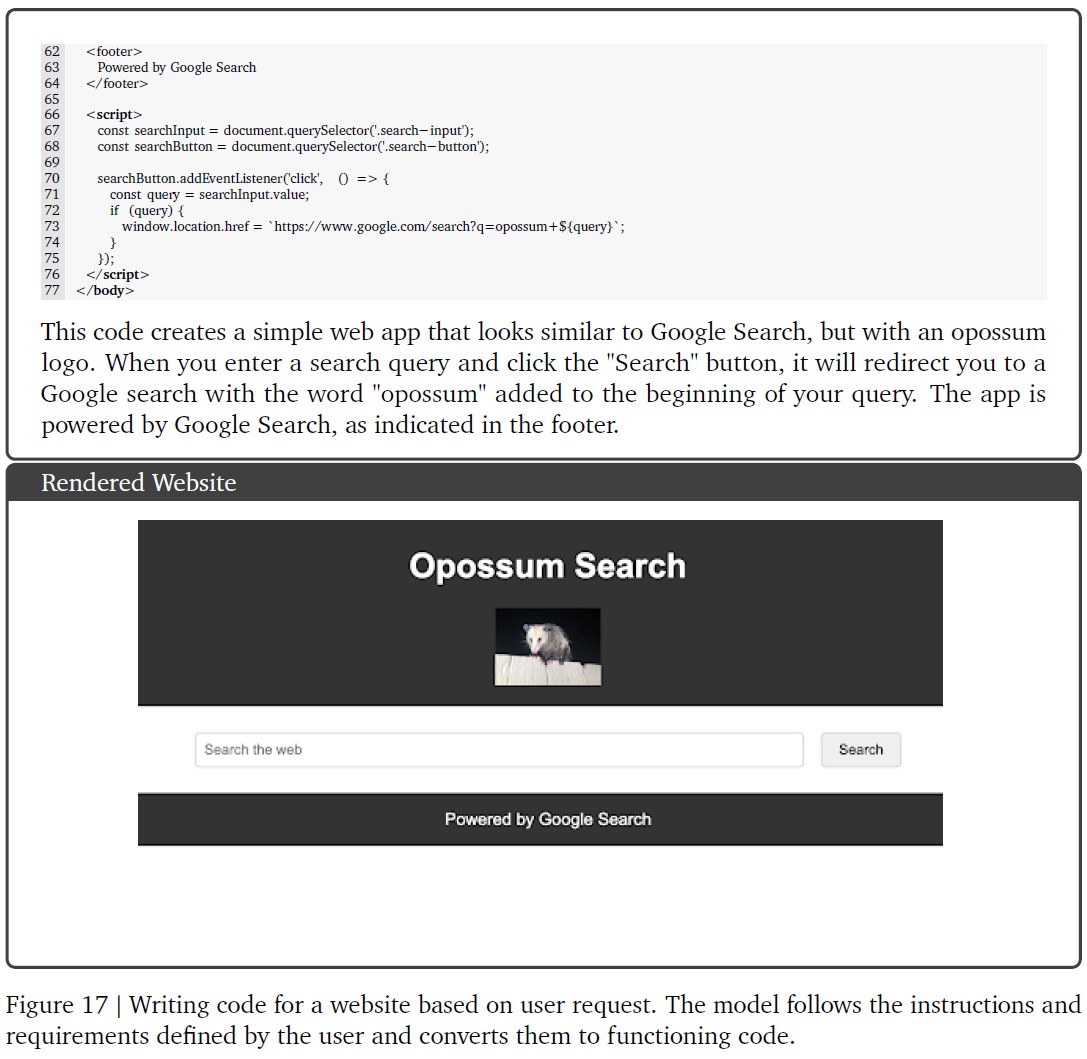

この章では,Gemini Ultraモデルのプロンプトによる定性的な例を示す.

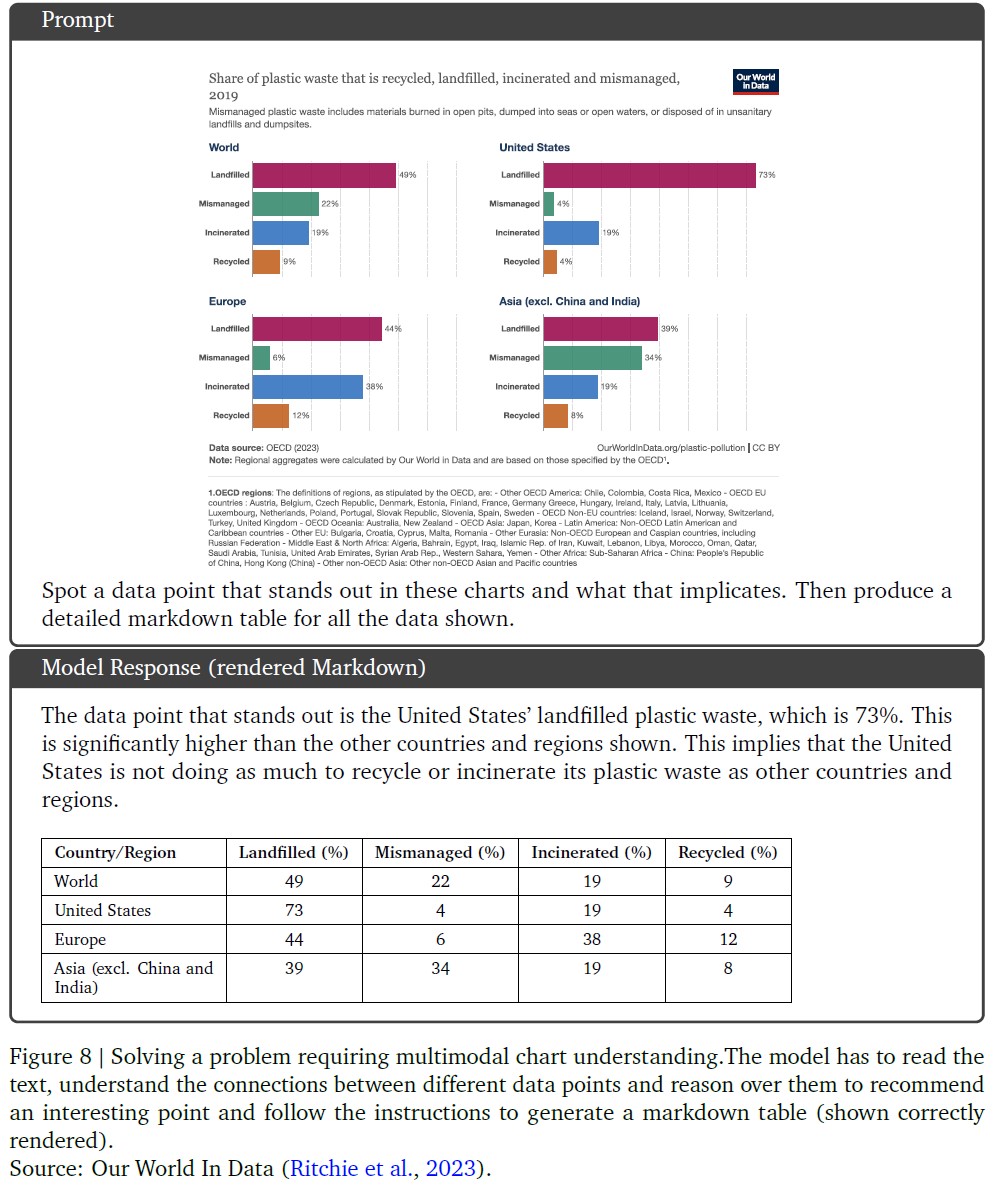

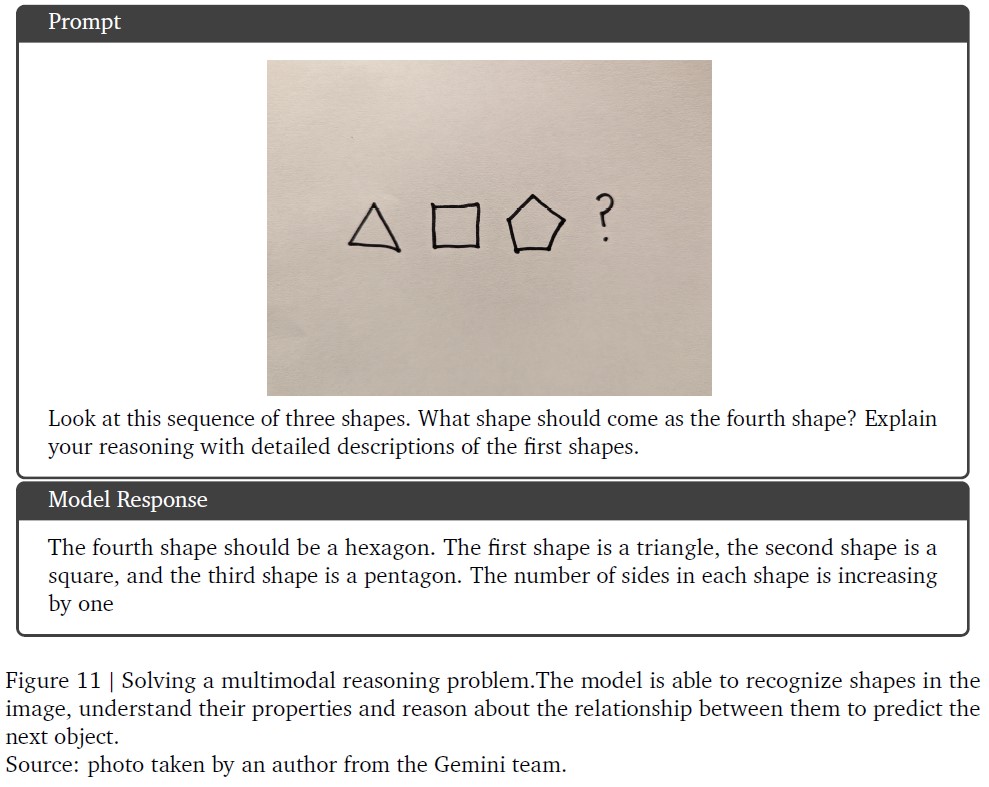

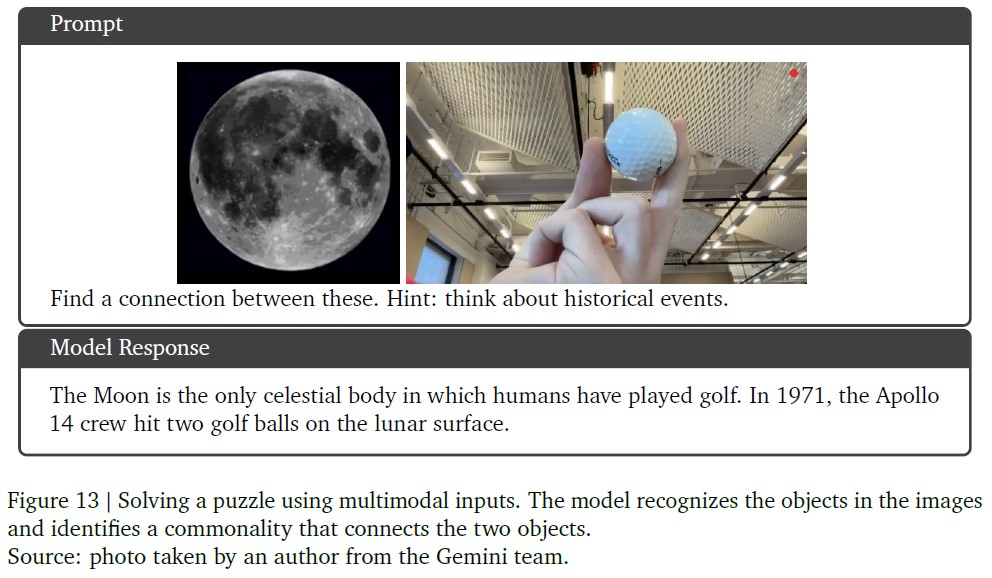

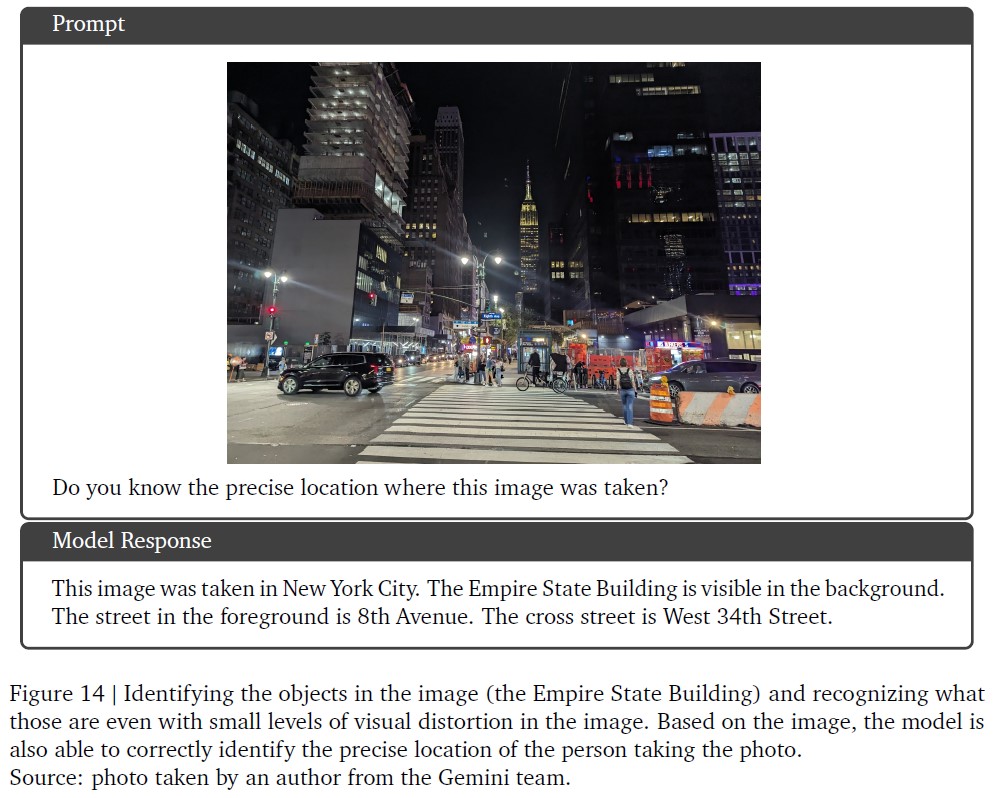

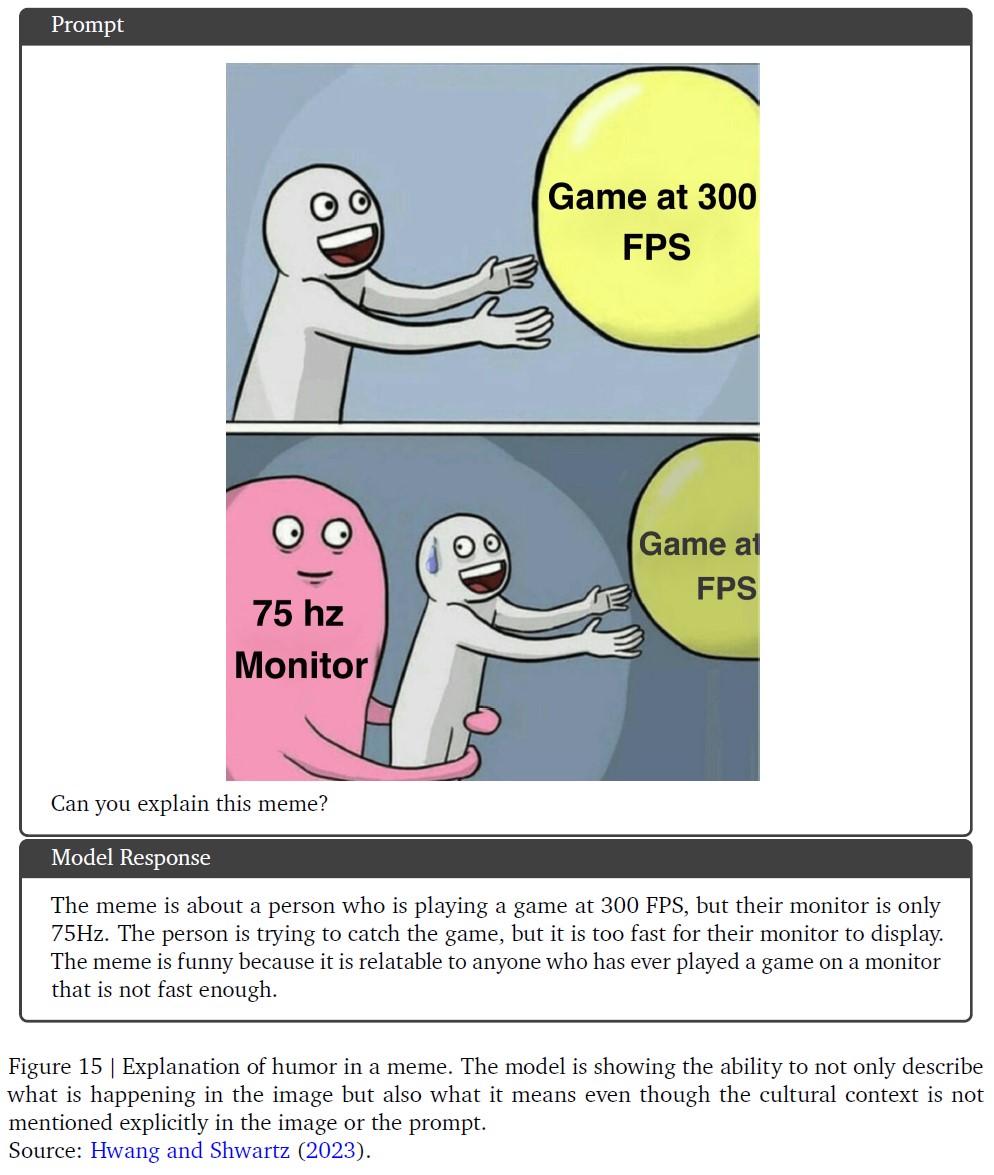

図8,9,11,13,14,15に,チャート,自然画像,ミームに対する画像理解タスクのマルチモーダル推論の例を示す.

図10は,ユーザがブログ記事をデザインするために画像とテキストのインターリーブシーケンスを生成するGemini Ultraの画像生成機能の例を示している.

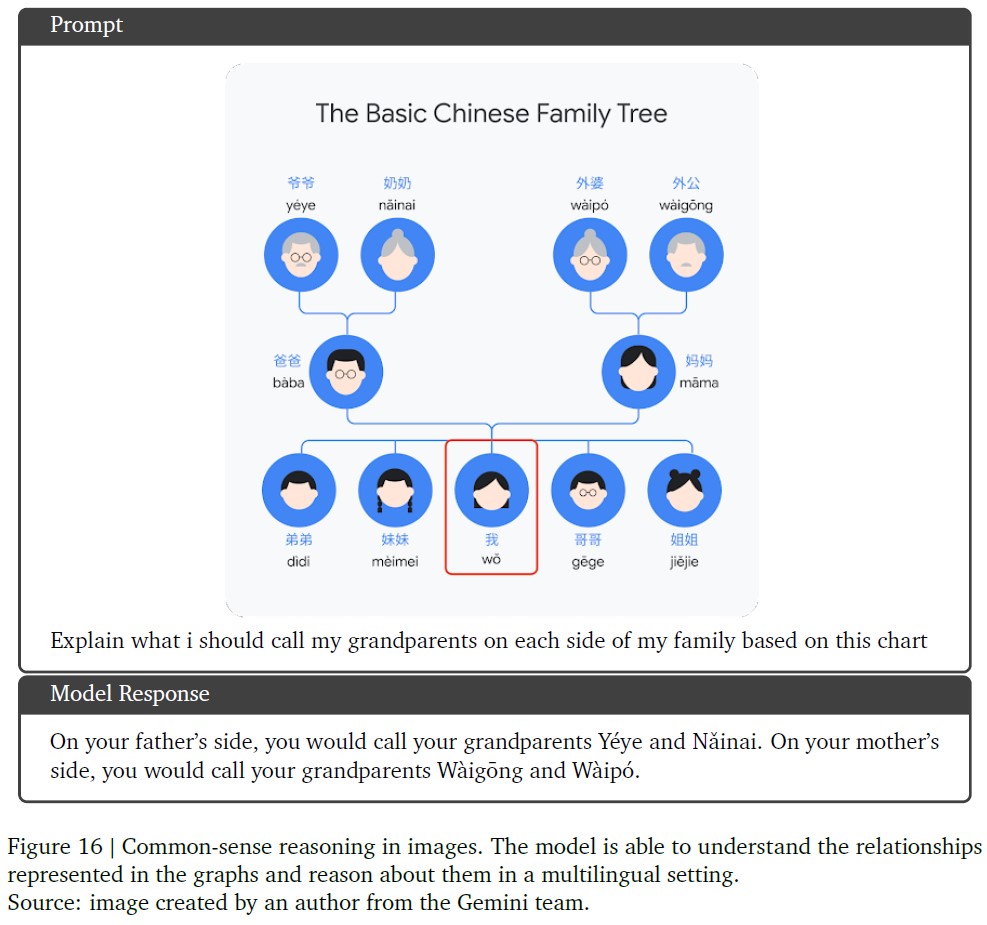

図16は,英語だけでなく,多言語環境における画像を理解するモデルの能力を示している.

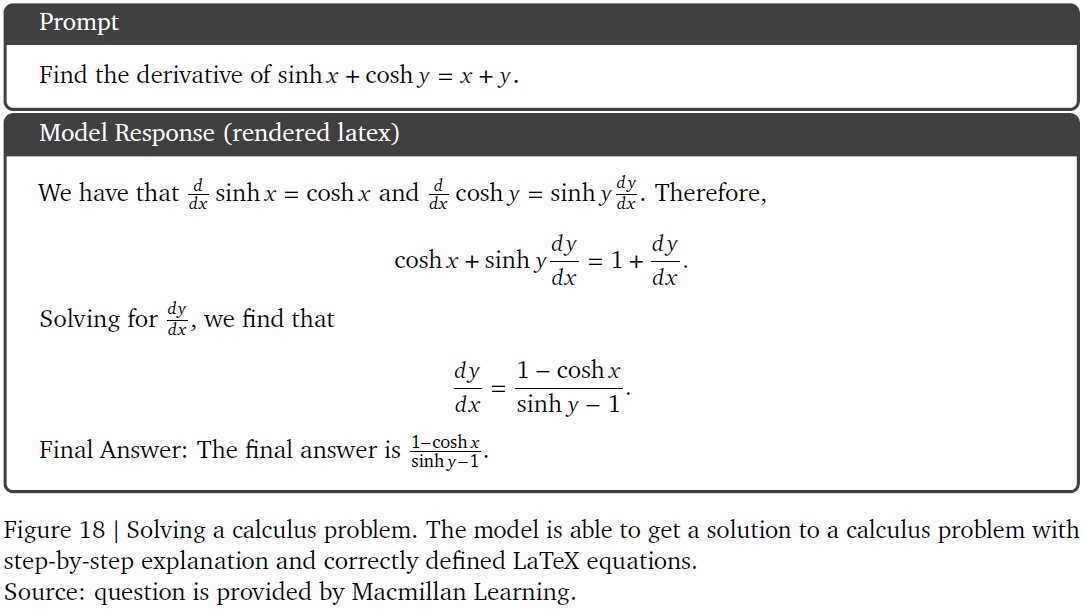

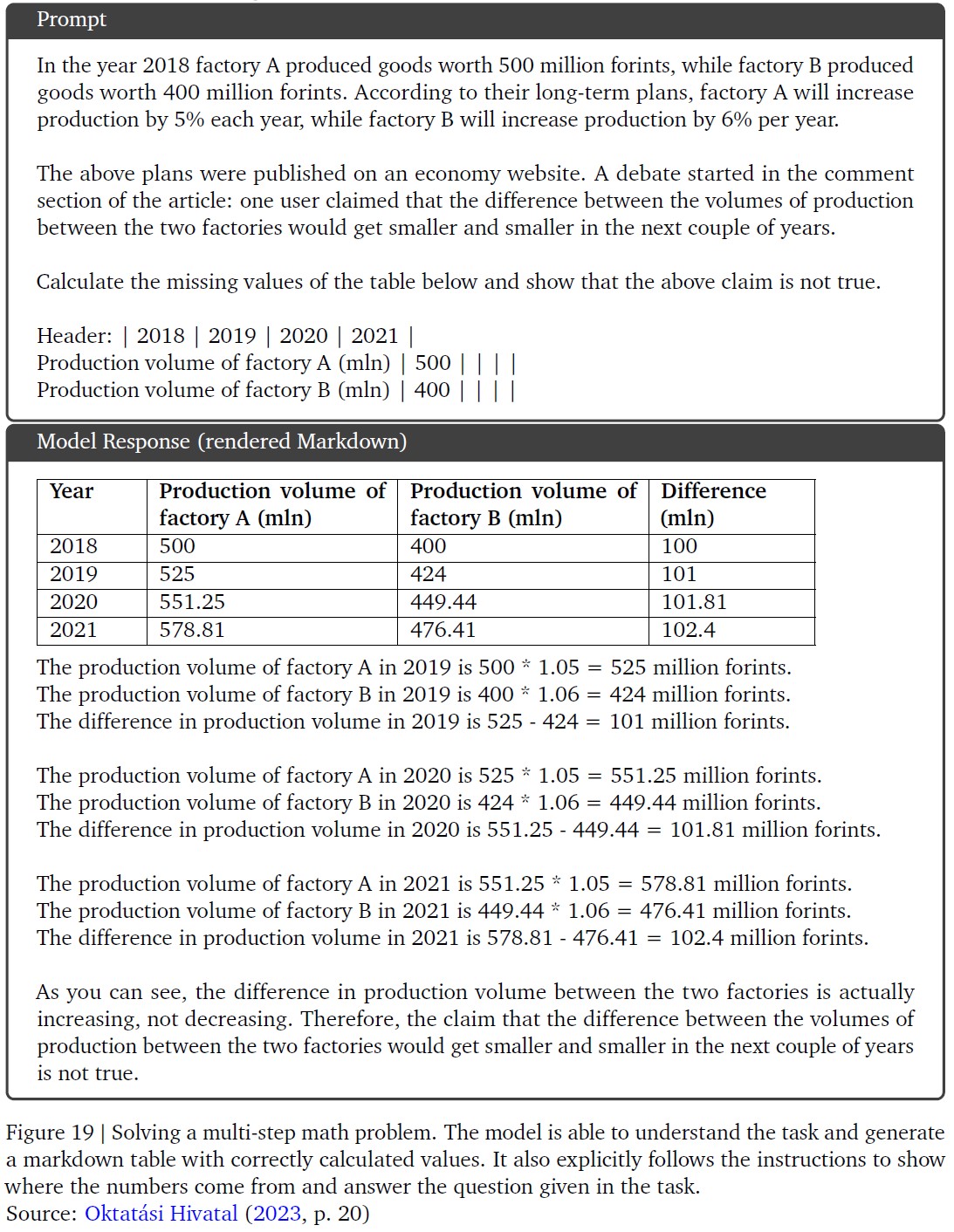

Geminiのモデルは,図12,18,19に示すように,マルチモーダルな画像理解と数学の推論においても強力な性能を示す.

図20は,複雑なマルチモーダル推論の例であり,与えられたユーザタスクに対して,モデルがどのように複雑な画像理解,コード生成,および命令追従能力を構成するかを示している.

図17では,モデルが動作するコードを生成し,複雑なユーザの命令に従うことができる別の例を示している.

最後に,図21は,時間的に接続されたフレームセットに対する推論によってビデオを理解するGemini Ultraの能力の例を示している.

9.3.1項:Chart understanding and reasoning over data(データのチャート理解と推論)

出典:Our World In Data(Ritchie et al., 2023).

9.3.2項:Multimodal question answering(マルチモーダルな質問応答)

出典:Geminiチームの著者が撮影した写真.

9.3.3項:Interleaved image and text generation(画像とテキストのインターリーブ生成)

9.3.4項:Image understanding and reasoning(画像の理解と推論)

出典:Geminiチームの著者が撮影した写真.

9.3.5項:Geometrical reasoning(幾何学的推論)

出典:(Lu et al., 2021).

9.3.6項:Information seeking about objects(オブジェクトに関する情報探索)

出典:Geminiチームの著者が撮影した写真.

9.3.7項:Multimodal reasoning based on visual cues(視覚的手がかりに基づくマルチモーダル推論)

出典:Geminiチームの著者が撮影した写真.

9.3.8項:Multimodal humor understanding(マルチモーダルなユーモア理解)

出典:(Hwang and Shwartz, 2023).

9.4項:Commonsense reasoning in a multilingual setting(多言語環境におけるコモンセンス推論)

出典:Geminiチームの著者が作成した画像.

9.4.1項:Reasoning and code generation(推論とコード生成)

9.4.2項:Mathematics: Calculus(数学:微積分)

出典:問題はMacmillan Learningから提供されている.

9.5節:Multi-step reasoning and mathematics(多段階推論と数学)

出典:(Oktatási Hivatal, 2023)のp. 20.

9.5.1項:Complex image understanding, code generation, and instruction following(複雑な画像理解,コード生成,命令追従)

出典:Geminiチームの著者が作成した図.

9.5.2項:Video understanding and reasoning(ビデオの理解と推論)

ビデオの出典:「フットボール/サッカーのペナルティミス」

https://www.youtube.com/watch?v=VmWxjmJ3mvs

参考:Gemini: A Family of Highly Capable Multimodal Modelsの解説動画

Gemini: A Family of Highly Capable Multimodal Modelsの解説動画です.

まとめ

Gemini: A Family of Highly Capable Multimodal Modelsの日本語訳を紹介しました.

グーグルのGeminiがわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.