Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの日本語訳を紹介します.

DragGANがわかります.

※図表を含む論文の著作権はACMに帰属します.

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの目次は以下になります.

- Abstract

- 1章:INTRODUCTION

- 2章:RELATED WORK

- 3章:METHOD

- 4章:EXPERIMENTS

- 5章:CONCLUSION

- ACKNOWLEDGMENTS

- REFERENCES

- APPENDIX(論文中に章のタイトルはないですが,わかりやすくするために追加)

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldを解説しつつ,私の考えも語ります.

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの概要と私の日本語訳は以下になります.

Synthesizing visual content that meets users’ needs often requires flexible and precise controllability of the pose, shape, expression, and layout of the generated objects.

ユーザのニーズに合ったビジュアルコンテンツを合成するためには,生成されるオブジェクトのポーズ,形状,表情,レイアウトを柔軟かつ正確に制御できることが必要である.Existing approaches gain controllability of generative adversarial networks (GANs) via manually annotated training data or a prior 3D model, which often lack flexibility, precision, and generality.

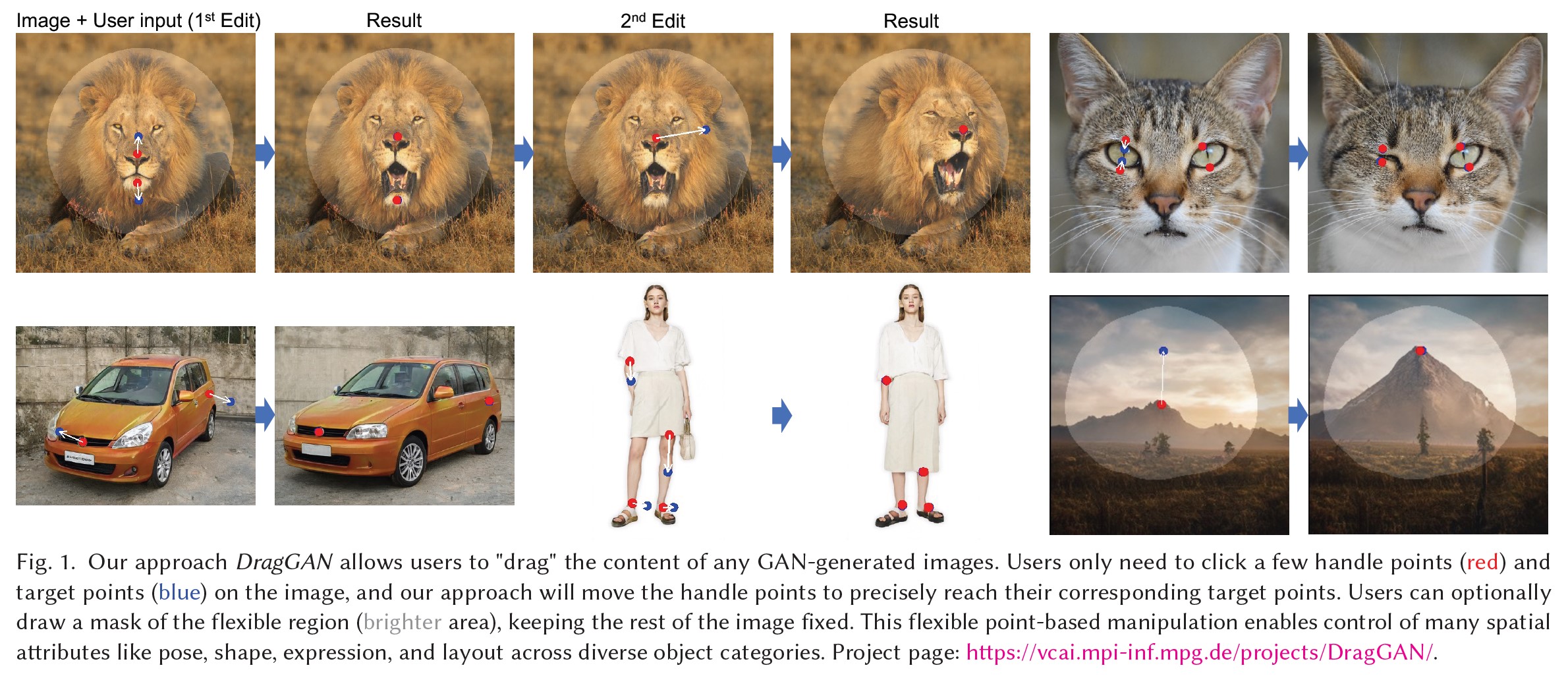

既存のアプローチでは,手動でアノテーションされた訓練データや事前の3Dモデルによって生成的敵対ネットワーク(GANs:Generative Adversarial Networks)の制御性を得ているが,柔軟性,精度,汎用性に欠けることが多い.In this work, we study a powerful yet much less explored way of controlling GANs, that is, to "drag" any points of the image to precisely reach target points in a user-interactive manner, as shown in Fig.1.

本研究では,GANを制御する強力な方法として,図1に示すように,画像の任意のポイントを「ドラッグ」して,ユーザと対話しながら目標ポイントに正確に到達させるという,まだあまり知られていない方法を研究する.To achieve this, we propose DragGAN, which consists of two main components: 1) a feature-based motion supervision that drives the handle point to move towards the target position, and 2) a new point tracking approach that leverages the discriminative generator features to keep localizing the position of the handle points.

これを実現するために,我々は2つの主要コンポーネントからなるDragGANを提案する:(1)ハンドルポイントを目標位置に向けて移動させる特徴に基づく動作監視,(2)ハンドルポイントの位置を特定し続けるために,識別可能なジェネレータの特徴を活用する新しいポイントトラッキングのアプローチ.Through DragGAN, anyone can deform an image with precise control over where pixels go, thus manipulating the pose, shape, expression, and layout of diverse categories such as animals, cars, humans, landscapes, etc.

DragGANは,ピクセルの位置を正確に制御しながら画像を変形させることができるため,動物,車,人間,風景など様々なカテゴリーのポーズ,形状,表情,レイアウトを操作することができる.As these manipulations are performed on the learned generative image manifold of a GAN, they tend to produce realistic outputs even for challenging scenarios such as hallucinating occluded content and deforming shapes that consistently follow the object’s rigidity.

これらの操作は,学習されたGANの生成画像多様体上で行われるため,オクルージョンのハルシネーションや,物体の剛性に一貫して従う形状の変形など,困難なシナリオでもリアルな出力が得られる傾向にある.Both qualitative and quantitative comparisons demonstrate the advantage of DragGAN over prior approaches in the tasks of image manipulation and point tracking.

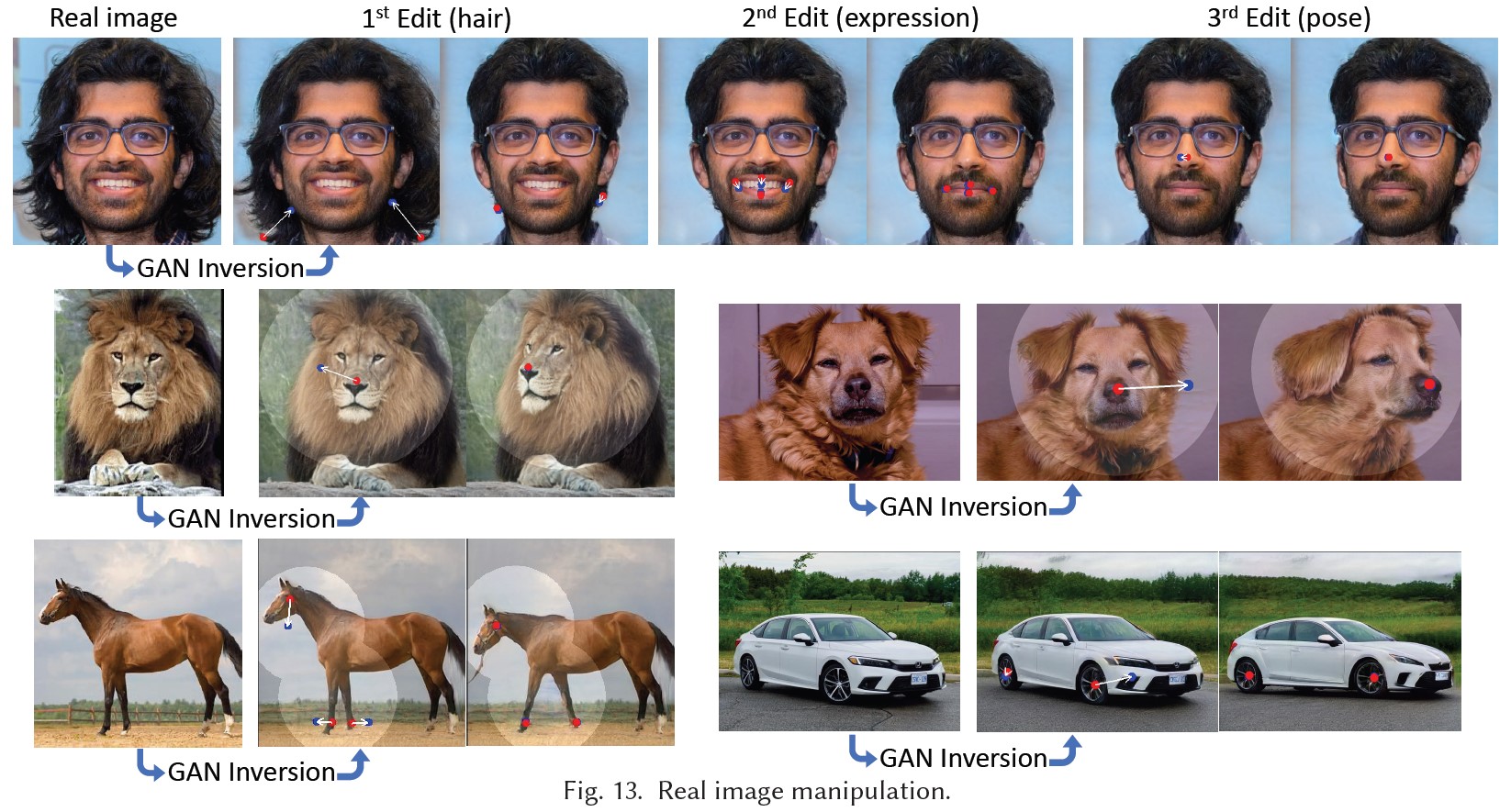

定性的・定量的な比較の両方から,画像操作とポイントトラッキングのタスクにおいて,先行アプローチに対するDragGANの優位性が実証されている.We also showcase the manipulation of real images through GAN inversion.

また,GAN反転による実画像の操作についても紹介する.https://arxiv.org/abs/2305.10973

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「ACKNOWLEDGMENTS」(謝辞)は省略していること

- 本文中に登場する表記「[Goodfellow et al. 2014]」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの本文を読みすすめましょう!

目次

1章:INTRODUCTION(はじめに)

敵対的生成ネットワーク(GANs:Generative Adversarial Networks)[Goodfellow et al. 2014]などの深層生成モデルは,ランダムなフォトリアリスティック(スーパーリアリスティック)な画像の合成において前例のない成功を収めている.

実世界のアプリケーションでは,このような学習ベースの画像合成手法の重要な機能要件は,合成されたビジュアルコンテンツを制御できることである.

例えば,ソーシャルメディアユーザは,何気なく撮影した写真に写っている人間や動物の位置,形,表情,体のポーズを調整したいと考えるかもしれない.

映画のプリビジュアライゼーションやメディア編集では,あるレイアウトのシーンのスケッチを効率的に作成することが求められる.

また,カーデザイナーは,作品の形状をインタラクティブに変更したいと考えるかもしれない.

このような多様なユーザの要求を満たすために,理想的な制御可能な画像合成アプローチは,以下の特性を備えている必要がある.

- 柔軟性:生成される物体や動物の位置,姿勢,形状,表情,レイアウトなど,さまざまな空間属性を制御できること.

- 精度:空間属性を高い精度で制御できること.

- 汎用性:特定のカテゴリーに限定されず,様々なオブジェクトのカテゴリーに適用できること.

これまでの研究では,これらの特性のうち1つか2つしか満たしていなかったが,本研究ではこれらすべてを達成することを目標とする.

これまでのアプローチのほとんどは,事前の3Dモデル[Deng et al. 2020; Ghosh et al. 2020; Tewari et al. 2020]または手動アノテーションデータに依存する教師あり学習[Abdal et al. 2021; Isola et al. 2017; Ling et al. 2021; Park et al. 2019; Shen et al. 2020]を介してGANの制御性を獲得している.

したがって,これらのアプローチは,新しいオブジェクトカテゴリーへの一般化に失敗し,多くの場合,限られた範囲の空間属性を制御し,または編集プロセスに対する制御をほとんど提供しない.

最近,テキストガイドによる画像合成が注目されている[Ramesh et al. 2022; Rombach et al. 2021; Saharia et al. 2022].

しかし,テキストガイドでは,空間属性の編集の精度と柔軟性に欠けている.

例えば,オブジェクトを特定のピクセル数だけ移動させるような使い方はできない.

GANの柔軟で精密かつ汎用的な制御性を実現するために,本研究では,強力でありながらあまり検討されていない対話的なポイントベースの操作を探求する.

具体的には,画像上のハンドルポイントとターゲットポイントをユーザが任意にクリックできるようにし,ハンドルポイントを駆動して対応するターゲットポイントに到達させることを目標とする.

図1に示すように,このポイントベースの操作により,ユーザは多様な空間属性を制御することができ,オブジェクトのカテゴリーにとらわれないことができる.

我々と最も近い設定を持つアプローチはUserControllableLT[Endo 2022]であり,同じくドラッグベースの操作を研究している.

それと比べると,本論文で研究する問題には,さらに2つの課題がある.

- 我々は,複数のポイントの制御を考えており,彼らのアプローチはこれをうまく扱えない.

- 我々は,ハンドルポイントがターゲットポイントに正確に到達することを要求しているが,彼らのアプローチはそうしていない.

実験により,複数のポイントを正確に位置制御することで,より多様で正確な画像操作が可能になることが示される.

このようなポイントベースのインタラクティブな操作を実現するために,我々はDragGANを提案し,1)ハンドルポイントがターゲットに向かって移動するように監督する,2)編集ステップごとにハンドルポイントの位置がわかるようにトラッキングする,という2つのサブ問題に取り組む.

本技術は,GANの特徴空間が,モーションの監視と正確なポイントのトラッキングの両方を可能にする十分な識別性を持っているという重要な洞察に基づいて構築されている.

具体的には,モーション監視は,潜在コードを最適化するシフトされた特徴パッチ損失によって達成される.

各最適化ステップでは,ハンドルポイントがターゲットに近づくようにシフトされる.

そして,特徴空間における最近傍探索により,ポイントトラッキングが実行される.

この最適化プロセスは,ハンドルポイントがターゲットに到達するまで繰り返される.

また,DragGANでは,オプションで関心領域(ROI:Region Of Interest)を描画し,領域に応じた編集を行うことができる.

DragGANはRAFT[Teed and Deng 2020]のような追加のネットワークに依存しないため,効率的な操作を実現し,ほとんどの場合,単一のRTX 3090 GPUで数秒しかかからない.

これにより,ライブでインタラクティブな編集セッションが可能になり,ユーザは希望する出力が得られるまで,さまざまなレイアウトを素早く反復することができる.

動物(ライオン,犬,猫,馬),人間(顔,全身),車,風景などの多様なデータセットを用いて,DragGANの評価を行った.

図1に示すように,本アプローチは,ユーザが定義したハンドルポイントをターゲットポイントに効果的に移動させ,多くのオブジェクトカテゴリーで多様な操作効果を実現している.

本アプローチは,単にワーピングを適用する従来の形状変形アプローチ[Igarashi et al. 2005]とは異なり,GANの学習した画像多様体に対して変形を行うため,基本的にオブジェクト構造に従う傾向がある.

例えば,ライオンの口の中の歯のような閉塞したコンテンツをハルシネーションしたり,馬の脚の曲げのような物体の剛性に従った変形を行うことができるようになる.

また,ユーザが画像をクリックするだけでインタラクティブに操作を行えるGUIを開発した.

定性的・定量的な比較により,本アプローチがUserControllableLTよりも優れていることが確認された.

さらに,我々のGANベースのポイントトラッキングアルゴリズムは,GAN生成フレームに対するRAFT[Teed and Deng 2020]やPIPs[Harley et al. 2022]といった既存のポイントトラッキングアプローチも凌駕している.

さらに,GAN反転技術と組み合わせることで,本アプローチは実画像編集のための強力なツールとしても機能する.

2章:RELATED WORK(関連研究)

2.1節:Generative Models for Interactive Content Creation(インタラクティブなコンテンツ制作のための生成モデル)

現在の手法の多くは,制御可能な画像合成に敵対的生成ネットワーク(GANs:Generative Adversarial Networks)や拡散モデル(Diffision Model)を用いている.

無条件GAN(Unconditional GANs):

GANは,低次元のランダムにサンプリングされた潜在ベクトルをフォトリアリスティックな画像に変換する生成モデルである.

それらは敵対的学習を使用して訓練され,高解像度のフォトリアリスティックな画像を生成するために使用することができる[Creswell et al. 2018; Goodfellow et al. 2014; Karras et al. 2021, 2019].

StyleGAN[Karras et al. 2019]のようなほとんどのGANモデルは,生成された画像の制御可能な編集を直接可能にしない.

条件付きGAN(Conditional GANs):

この限界に対処するために,いくつかの方法が条件付きGANを提案している.

ここでは,ネットワークは,フォトリアリスティックな画像を生成するために,ランダムにサンプリングされた潜在ベクトルに加えて,セグメンテーションマップ[Isola et al. 2017; Park et al. 2019]や3D variables [Deng et al. 2020; Ghosh et al. 2020]など,条件付きの入力を受け取る.

EditGAN[Ling et al. 2021]は,条件分布をモデル化する代わりに,まず画像とセグメンテーションマップの共同分布をモデル化し,編集されたセグメンテーションマップに対応する新しい画像を計算することで編集を可能にする.

無条件GANを用いた制御可能性:

入力潜在ベクトルを操作して無条件GANを編集する方法はいくつか提案されている.

いくつかのアプローチは,手動アノテーションや事前の3Dモデルから教師あり学習によって意味のある潜在的な方向を見つける[Abdal et al. 2021; Leimkühler and Drettakis 2021; Patashnik et al. 2021; Shen et al. 2020; Tewari et al. 2020].

他のアプローチでは,教師なし方式で潜在空間における重要な意味方向を計算する[Härkönen et al. 2020; Shen and Zhou 2020; Zhu et al. 2023].

最近では,中間的な「blobs」(ブロブ)[Epstein et al. 2022]やヒートマップ[Wang et al. 2022b]を導入することで,粗いオブジェクト位置の制御可能性を実現している.

これらのアプローチはすべて,外観のような画像に沿った意味属性,またはオブジェクトの位置や姿勢のような粗い幾何学的属性のいずれかを編集することができる.

Editing-in-Style[Collins et al. 2020]は空間属性の編集機能を示しているが,異なるサンプル間でローカルセマンティクスを転送することによってのみこれを実現できる.

これらの方法とは対照的に,我々のアプローチは,ポイントベースの編集を使用して,ユーザが空間属性に対する細粒度の制御を実行することができる.

GANWarping[Wang et al. 2022a]もポイントベースの編集を使用するが,分布外画像編集しかできない.

生成されたすべての画像が同様のワープを示すように,いくつかのワープ画像を用いて生成モデルを更新することができる.

しかし,この方法では,現実的な画像につながるワープを保証することはできない.

また,オブジェクトの3Dポーズを変更するような制御もできない.

我々と同様に,UserControllableLT[Endo 2022]は,GANの潜在ベクトルを変換することで,ポイントベースの編集を可能にする.

しかし,このアプローチは,画像上でドラッグされる1ポイントを用いた編集にのみ対応しており,複数ポイントの制約をうまく扱うことができない.

また,制御の精度が低く,編集後,目標ポイントに到達しないことが多い.

3D-aware GANs:

いくつかの方法は,3D制御を可能にするためにGANのアーキテクチャを変更する[Chan et al. 2022, 2021; Chen et al. 2022; Gu et al. 2022; Pan et al. 2021; Schwarz et al. 2020; Tewari et al. 2022; Xu et al. 2022].

ここでは,モデルは,物理ベースの解析レンダラーを使用してレンダリングできる3D表現を生成する.

しかし,我々のアプローチとは異なり,制御はグローバルなポーズまたは照明に限定される.

拡散モデル:

最近では,拡散モデル[Sohl-Dickstein et al. 2015]により,高品質での画像合成が可能になった[Ho et al. 2020; Song et al. 2020, 2021].

これらのモデルは,ランダムにサンプリングされたノイズを反復的にノイズ除去して,フォトリアリスティックな画像を作成する.

最近のモデルでは,テキスト入力を条件とした表現力豊かな画像合成が示されている[Ramesh et al. 2022; Rombach et al. 2021; Saharia et al. 2022].

しかし,自然言語は画像の空間属性を細粒度で制御することができないため,すべてのテキスト条件付き手法はハイレベルの意味編集に制限される.

また,現在の拡散モデルは,複数のノイズ除去ステップを必要とするため,速度が遅い.

効率的なサンプリングは進歩しているが,GANの方が圧倒的に効率的である.

2.2節:Point Tracking(ポイントトラッキング)

動画中のポイントをトラッキングするためには,連続するフレーム間のオプティカルフロー推定を行うのが一般的なアプローチである.

オプティカルフロー推定は,2つの画像間のモーション場を推定する古典的な問題である.

従来のアプローチは,手作業で作られた基準で最適化問題を解くが[Brox and Malik 2010; Sundaram et al. 2010],近年は,より優れた性能のため,深層学習ベースのアプローチがこの分野を支配し始めた[Dosovitskiy et al. 2015; Ilg et al. 2017; Teed and Deng 2020].

これらの深層学習ベースのアプローチは,通常,深層ニューラルネットワークを訓練するために,グランドトゥルースのオプティカルフローを持つ合成データを使用する.

その中でも,現在最も広く使われているのは,反復アルゴリズムによってオプティカルフローを推定するRAFT[Teed and Deng 2020]である.

最近,[Harley et al. 2022]は,この反復アルゴリズムと従来の「particle video」(粒子ビデオ)アプローチを組み合わせ,PIPsという新しいポイントトラッキング方法を生み出した.

PIPsは複数のフレームにまたがる情報を考慮するため,従来のアプローチよりも長距離のトラッキングを扱うことができる.

本研究では,GANで生成された画像に対するポイントトラッキングが,前述のアプローチや追加のニューラルネットワークを用いることなく実行可能であることを示す.

GANの特徴空間は十分な識別性を持っており,特徴マッチングを行うだけでトラッキングが可能であることを明らかにする.

いくつかの先行研究は,セマンティックセグメンテーションにおいても識別的特徴を活用しているが[Tritrong et al. 2021; Zhang et al. 2021],ポイントベースの編集問題を識別的GAN特徴の直感に結びつけ,具体的方法を設計したのは我々が初めてである.

追加のトラッキングモデルを取り除くことで,我々のアプローチはインタラクティブな編集をサポートするために,より効率的に実行することができる.

本アプローチのシンプルさにもかかわらず,RAFTやPIPを含む最先端のポイントトラッキングアプローチを凌駕することを実験により示すことができた.

3章:METHOD(方法)

本研究は,GANのための対話型画像操作法を開発することを目的としており,ユーザは画像をクリックするだけで,いくつかのペア(ハンドルポイント,ターゲットポイント)を定義し,ハンドルポイントを駆動して対応するターゲットポイントに到達させることができる.

本研究では,StyleGAN2アーキテクチャ[Karras et al. 2020]に基づいている.

ここでは,このアーキテクチャの基本を簡単に紹介する.

StyleGANの用語:

StyleGAN2アーキテクチャでは,512次元の潜在コード\(z \in N(0, I)\)はマッピングネットワークを介して中間潜在コード\(w \in \mathbb{R}^{512}\)にマッピングされる.

wの空間は一般に\(W\)と呼ばれる.

wは次に生成器に送られ,出力画像\(I = G(w)\)を生成する.

このプロセスでは,wは複数回コピーされ,生成器Gの異なる層に送られ,異なるレベルの属性を制御する.

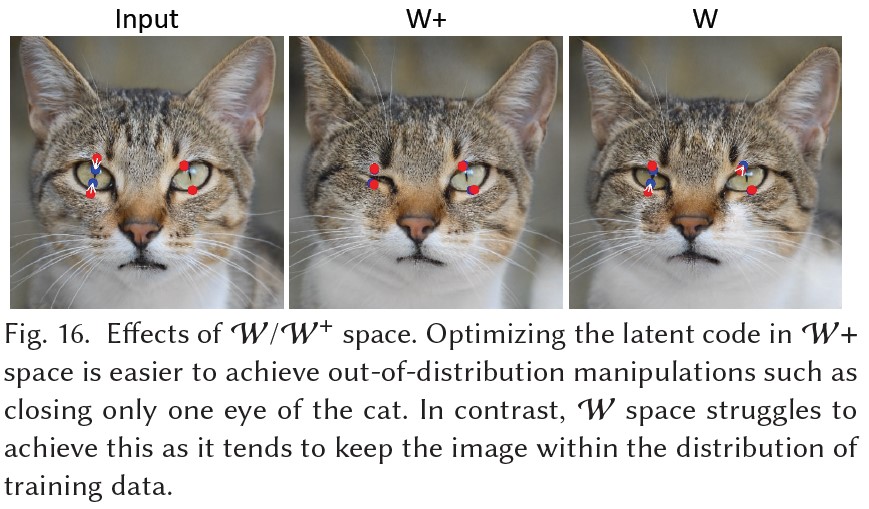

また,異なる層に対して異なるwを使用することもでき,その場合,入力は\(w \in R^{l*512} = W^+\)となり,lは層の数である.

この制約の少ない\(W^+\)空間は,より表現力が高いことが示されている[Abdal et al. 2019].

生成器Gは低次元の潜在空間からはるかに高次元の画像空間へのマッピングを学習するので,画像多様体をモデル化していると見ることができる[Zhu et al. 2016].

3.1節:Interactive Point-based Manipulation(インタラクティブなポイントベースの操作)

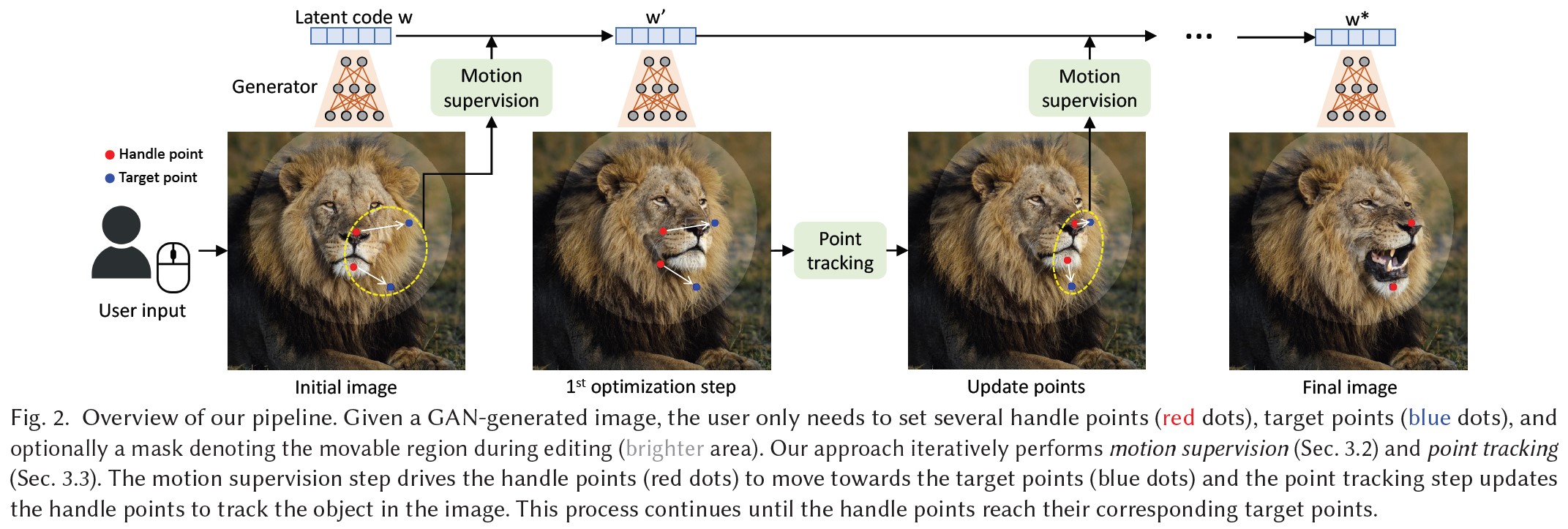

我々の画像操作パイプラインの概要を図2に示す.

潜在コード\(w\)を持つGANによって生成された任意の画像\(I \in \mathbb{R}^{3*H*W}\)に対して,ユーザがハンドルポイント\(\{p_i = (x_{p,i}, y_{p,i})|i=1, 2, …\}\)と,それらに対応する目標ポイント\(\{t_i = (x_{t,i}, y_{t,i})|i=1, 2, …\}\)(つまり,\(p_i\)の対応する目標ポイントは\(t_i\))を多数入力できるようにしている.

目標は,ハンドルポイントの意味的位置(例えば,図2の鼻と顎)が対応する目標ポイントに到達するように,画像内のオブジェクトを移動させることである.

また,画像のどの領域が移動可能かを示すバイナリマスクMをオプションで描けるようにしている.

これらのユーザ入力を受けて,最適化手法で画像操作を行う.

図2に示すように,各最適化ステップは,1)モーション監視と2)ポイントトラッキングの2つのサブステップで構成される.

モーション監視では,ハンドルポイントが目標ポイントに向かって移動するように強制する損失を用いて,潜在コードwを最適化する.

1回の最適化ステップの後,新しい潜在コードw'と新しい画像I'を得ることができる.

この更新により,画像内のオブジェクトがわずかに移動することになる.

なお,モーション監視ステップは,各ハンドルポイントを目標に向かって小さなステップだけ移動させるが,複雑な最適化ダイナミクスに従うため,オブジェクトやパーツによって異なるため,ステップの正確な長さは不明である.

そこで,次にハンドルポイントの位置\(\{p_i\}\)を更新して,オブジェクト上の対応するポイントをトラッキングする.

ハンドルポイント(例えばライオンの鼻)が正確にトラッキングされないと,次のモーション監視ステップで間違ったポイント(例えばライオンの顔)が監視され,望ましくない結果につながるため,このトラッキングプロセスは必要である.

トラッキング後,新しいハンドルポイントと潜在コードに基づき,上記の最適化ステップを繰り返す.

この最適化処理は,ハンドルポイント\(\{p_i\}\)がターゲットポイント\(\{t_i\}\)の位置に到達するまで続けられ,我々の実験では通常30~200回の反復を要する.

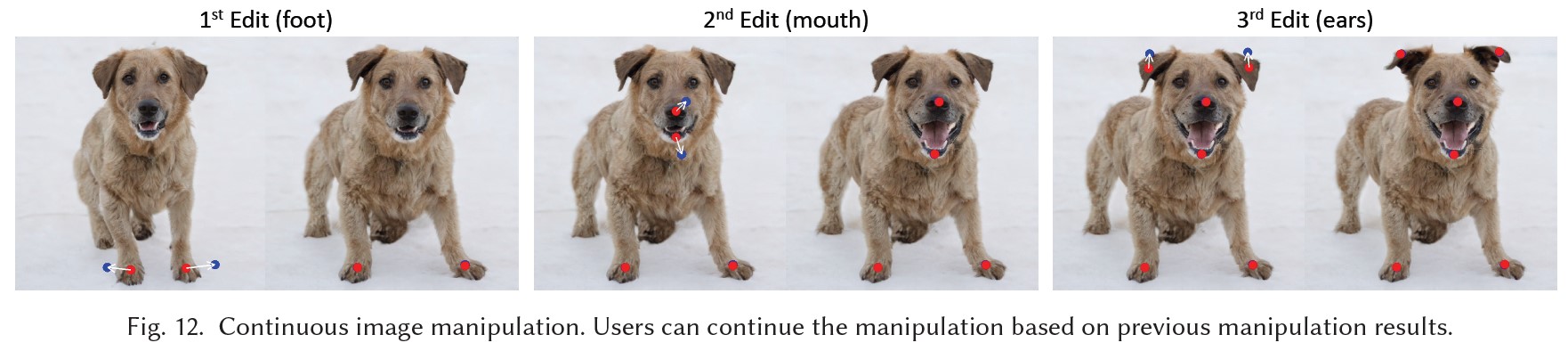

また,ユーザは任意の中間ステップで最適化を停止することができる.

編集後,ユーザは新しいハンドルポイントと目標ポイントを入力し,結果に満足するまで編集を続けることができる.

3.2節:Motion Supervision(モーション監視)

GANで生成された画像に対して,ポイントのモーションをどのように監視するかは,これまであまり検討されてこなかった.

本研究では,追加のニューラルネットワークに依存しない,モーション監視のための損失を提案する.

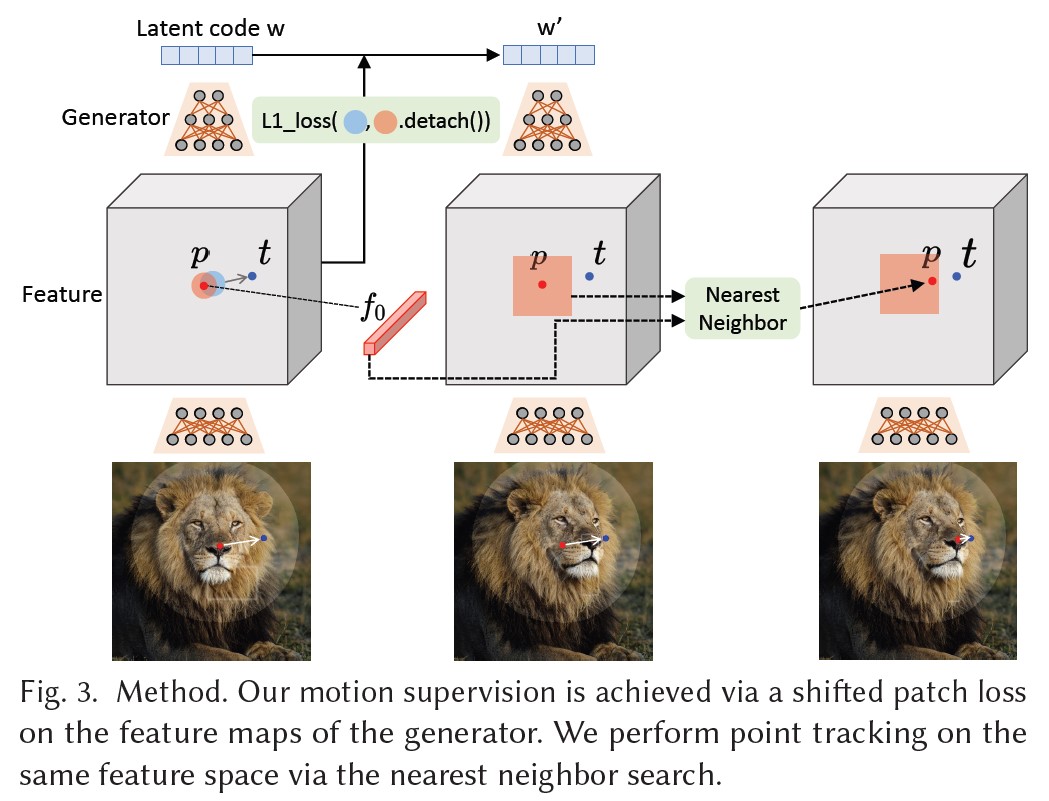

重要な考え方は,GANの中間特徴量は非常に識別性が高く,単純な損失でモーションを監視するのに十分であるということである.

具体的には,StyleGAN2の6番目のブロックの後の特徴マップFを考える.

このマップは,解像度と識別性の間の良いトレードオフにより,全ての特徴の中で最も良い性能を発揮する.

Fはバイリニア補間により最終画像と同じ解像度になるようリサイズする.

図3に示すように,ハンドルポイント\(p_i\)を目標ポイント\(t_i\)に移動させるために,我々のアイデアは\(p_i\)の周りの小さなパッチ(赤丸)を監視し,小さなステップ(青丸)で\(t_i\)に向かって移動することである.

\(\Omega_1(p_i, r_1)\)を使って,\(p_i\)との距離が\(r_1\)より小さい画素を表すと,モーション監視の損失は次のようになる.

$$L = \sum_{i=0}^n \sum_{q_i \in \Omega_1 (p_i, r_1)} || F(q_i) - F(q_i + d_i)||_1 + \lambda||(F - F_0) \cdot (1 - M)||_1$$

ここで,\(F(q)\)は画素qにおけるFの特徴量,\(d_i = \frac{t_i - p_i}{||t_i - p_i||_2}\)は\(p_i\)から\(t_i\)へ向けた正規化ベクトル(\(t_i = p_i\)の場合\(d_i = 0\)),\(F_0\)は初期画像に対応する特徴マップを表している.

なお,第1項はすべてのハンドルポイント\(\{p_i\}\)について合計される.

\(q_i + d_i\)の成分は整数ではないので,バイリニア補間により\(F(q_i + d_i)\)を得る.

重要なのは,この損失を用いてバックプロパゲーションを行う場合,勾配は\(F(q_i)\)を介してバックプロパゲートされないことである.

これにより,\(p_i\)が\(p_i + d_i\)に移動する動機付けとなるが,その逆はない.

バイナリマスクMが与えられた場合,マスクされていない領域を固定し,第2項として示される再構成損失がある.

各モーション監視ステップにおいて,この損失は1ステップ分の潜在コードwを最適化するために使用される.

wは,ユーザがより制約のある画像多様体を望むかどうかに応じて,W空間または\(W^+\)空間のいずれかで最適化することができる.

\(W^+\)空間の方が分布外操作(例えば図16の猫)を実現しやすいので,編集性を高めるために本研究では\(W^+\)を使用する.

実際には,画像の空間属性は主に最初の6層のwによって影響され,残りの層は外観にのみ影響されることが観察された.

したがって,Style-Mixing手法[Karras et al. 2019]に触発されて,最初の6層のwだけを更新し,他のものは固定して外観を維持する.

この選択的な最適化は,画像コンテンツの望ましいわずかなモーションをもたらす.

3.3節:Point Tracking(ポイントトラッキング)

前回のモーション監視の結果,新しい潜在コードw',新しい特徴マップF',そして新しい画像I'が得られる.

モーション監視ステップはハンドルポイントの正確な新しい位置を容易に提供しないので,ここでの目標は,各ハンドルポイント\(p_i\)がオブジェクト上の対応するポイントをトラッキングするように更新することである.

ポイントトラッキングは,一般的にオプティカルフロー推定モデルまたは粒子ビデオアプローチ[Harley et al.2022]によって実行される.

ここでも,これらの追加モデルは効率を著しく損ない,特にGANにおけるエイリアスアーティファクトの存在下で,蓄積エラーに悩まされる可能性がある.

そこで我々は,GANのための新しいポイントトラッキングアプローチを提案する.

GANの識別的な特徴は,密な対応関係をよく捉え,その結果,特徴パッチにおける最近傍探索によってトラッキングを効果的に行うことができる,という洞察である.

具体的には,初期ハンドルポイントの特徴を\(f_i = F_0(p_i)\)とする.

また,\(p_i\)の周りのパッチを\(\Omega_2 (p_i, r_2) = \{ (x, y)\ |\ |x - x_{p,i}| < r_2, |y - y_{p,i}| < r_2 \}\)と表す.

そして,\(\Omega_2 (p_i, r_2)\)で\(f_i\)の最近傍を検索することでトラッキングするポイントを得ることができる.

$$ p_i := \underset{q_i \in \Omega_2 (p_i, r_2)}{\rm arg \ min} || F'(q_i) - f_i ||_1 $$

このようにして,\(p_i\)はオブジェクトをトラッキングするように更新される.

複数のハンドルポイントの場合,各ポイントに対して同じ処理を適用する.

なお,ここではStyleGAN2の6ブロック目以降の特徴マップF'も考慮している.

この特徴マップは256*256の解像度を持ち,必要に応じて画像と同じサイズにバイリニア補間されるが,これは我々の実験において正確なトラッキングを行うのに十分である.

この選択については4.2節で分析する.

3.4節:Implementation Details(実装の詳細)

我々は,PyTorch[Paszke et al. 2017]に基づいて我々のアプローチを実装する.

Adam optimizer[Kingma and Ba 2014]を使用して,FFHQ[Karras et al. 2019],AFHQCat[Choi et al. 2020],LSUN Car[Yu et al. 2015]datasetsでは2e-3のステップサイズで,その他では1e-3で潜在コードwを最適化する.

ハイパーパラメータは\(\lambda = 20, r_1 = 3, r_2 = 12\)とする.

我々の実装では,全てのハンドルポイントが対応するターゲットポイントからdピクセル以上離れていない時に最適化プロセスを停止する.

ここで,dはハンドルポイントが5つ以上ない場合は1に,それ以外は2に設定される.

また,対話的な画像操作をサポートするGUIを開発した.

本アプローチの計算効率により,ユーザは編集のたびに数秒待つだけでよく,満足するまで編集を続けることができる.

インタラクティブなセッションのライブ記録については,補足ビデオを参照されることを強くお勧めする.

※訳注:補足ビデオはDragGANのプロジェクトページにあります.

4章:EXPERIMENTS(実験)

データセット:

以下のデータセットで事前訓練したStyleGAN2[Karras et al. 2020]に基づいて,我々のアプローチを評価する(括弧内は事前訓練したStyleGAN2の解像度を示している).

- FFHQ(512)[Karras et al. 2019]

- AFHQCat(512)[Choi et al. 2020]

- SHHQ(512)[Fu et al. 2022]

- LSUN Car(512)[Yu et al. 2015]

- LSUN Cat(256)[Yu et al. 2015]

- Landscapes HQ(256)[Skorokhodov et al. 2021]

- microscope(512)[Pinkney 2020]

- [Mokady et al. 2022]のデータセットから,ライオン(512),犬(1024),象(512)を含む自己蒸留されたデータセット.

ベースライン:

我々の主なベースラインはUserControllableLT[Endo 2022]で,これは我々の手法と最も近い設定になっている.

UserControllableLTはマスク入力をサポートしないが,ユーザが多数の固定ポイントを定義することができる.

そこで,マスク入力を伴うテストケースでは,画像上に16*16の正グリッドをサンプリングし,マスクの外側のポイントをUserControllableLTの固定ポイントとして使用する.

さらに,ポイントトラッキングのためのRAFT[Teed and Deng 2020]とPIPs[Harley et al. 2022]との比較も行っている.

そのために,我々のアプローチの2つのvariantsを作成し,ポイントトラッキング部分(3.3節)をこれら2つのトラッキング手法に置き換える.

4.1節:Qualitative Evaluation(定性的評価)

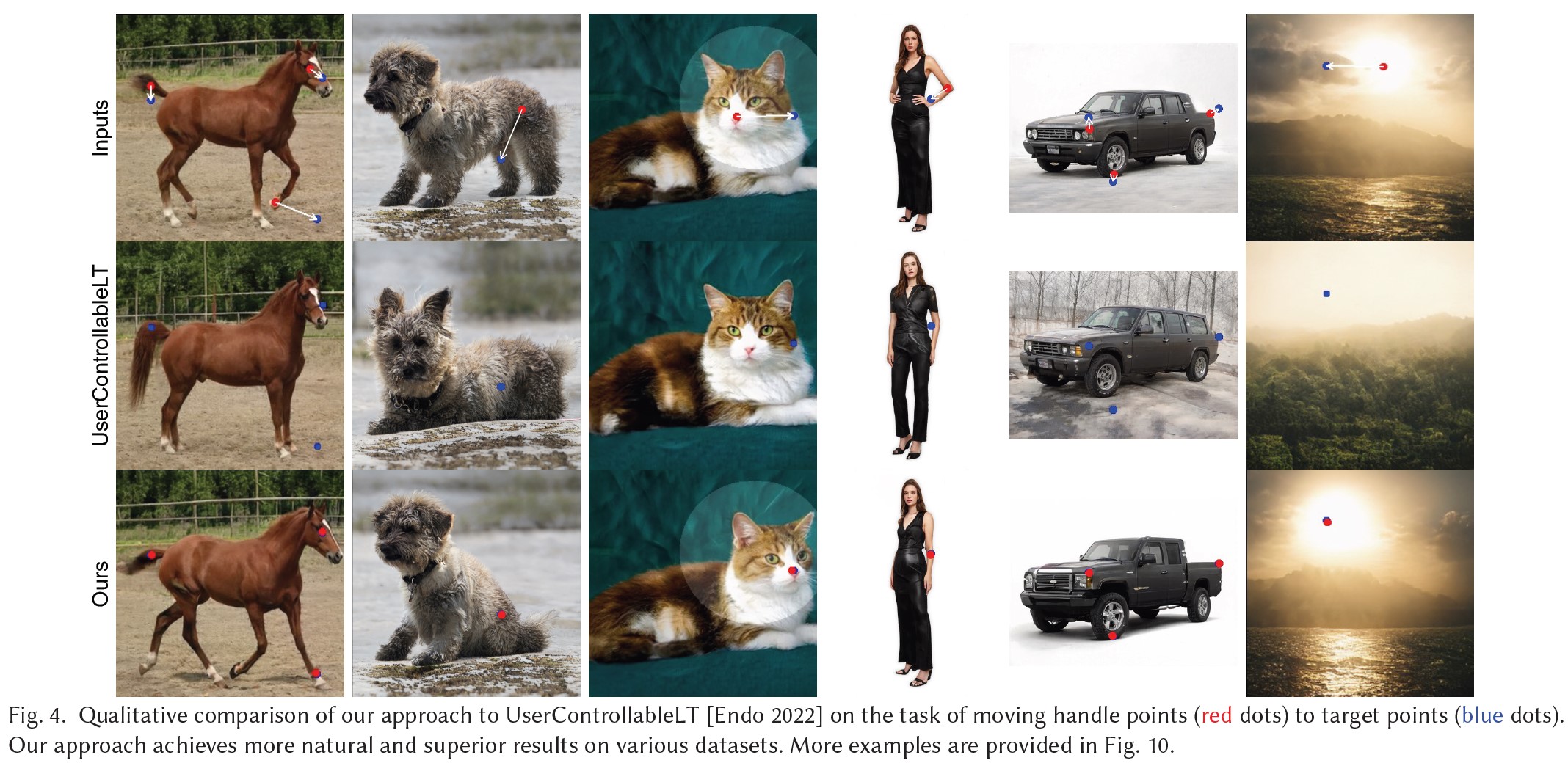

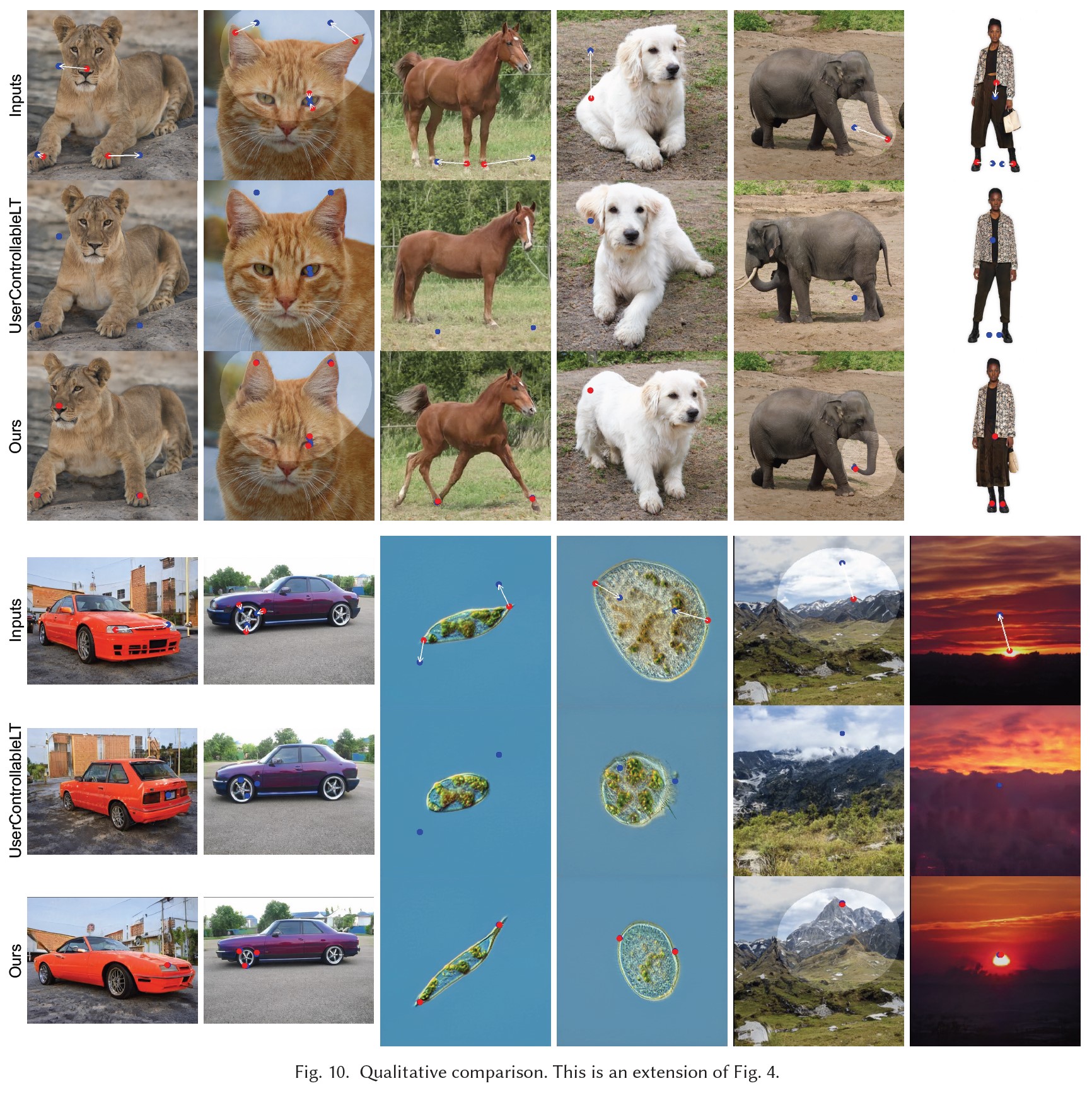

図4は,本手法とUserControllableLTの定性的な比較を示したものである.

複数の異なるオブジェクトカテゴリーとユーザ入力に対する画像操作の結果を示している.

本手法は,ハンドルポイントを正確に移動させて目標ポイントに到達させ,動物のポーズや車の形,風景のレイアウトを変えるなど,多様で自然な操作効果を実現している.

一方,UserControllableLTは,ハンドルポイントを忠実に目標ポイントに移動させることができず,人間の服装や車の背景など,画像に好ましくない変化を与えることが多い.

また,猫画像で示されるように,我々のようにマスクされていない領域を固定することもできない.

図10では,より多くの比較を示している.

※訳注:図5は図6の後に参照しています.

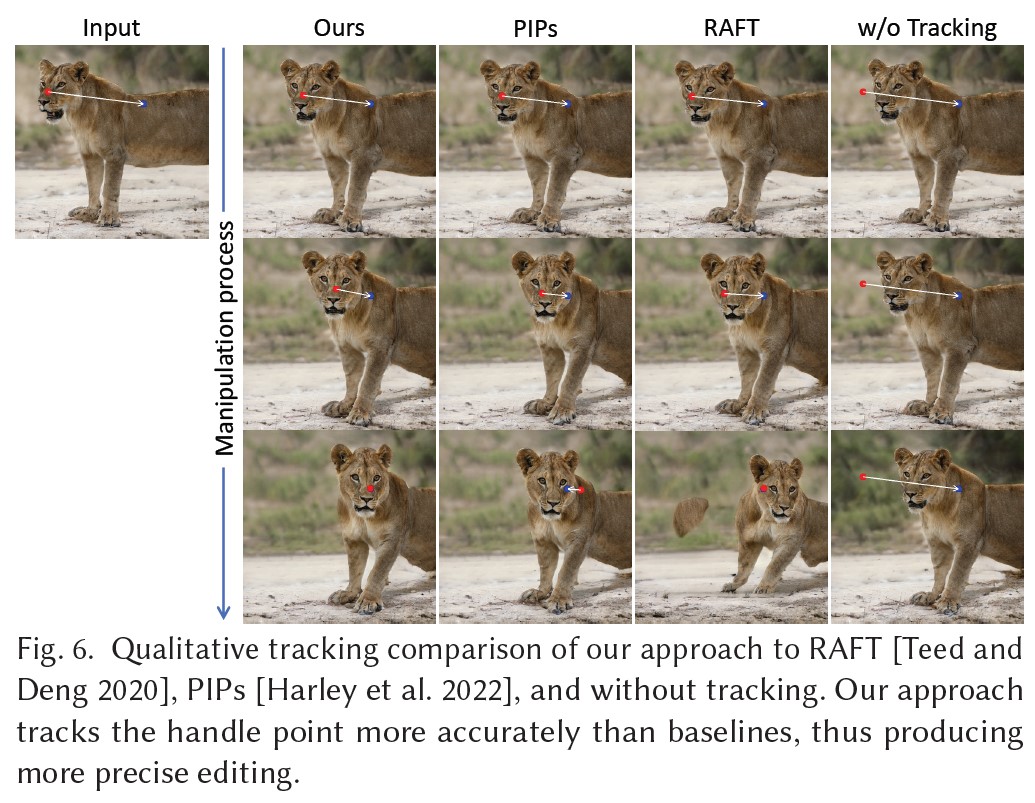

図6に,本アプローチとPIPs,RAFTの比較を示す.

本アプローチは,ライオンの鼻の上にあるハンドルポイントを正確にトラッキングし,ライオンを目標位置まで誘導することに成功している.

一方,PIPsとRAFTでは,操作の過程でトラッキングポイントが鼻からずれ始めている.

その結果,間違ったパーツを目標位置まで移動させてしまっている.

また,トラッキングを行わない場合,固定ハンドルポイントは数ステップですぐに画像の別の部分(背景など)を駆動し始め,停止するタイミングがわからず,編集の目的を達成することができない.

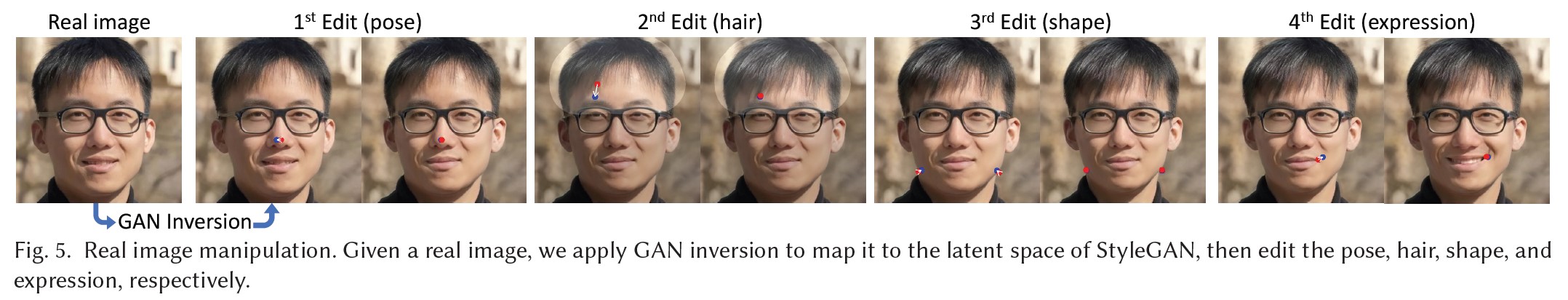

実画像の編集:

StyleGANの潜在空間に実画像を埋め込むGAN反転技術を用いると,実画像を操作するアプローチも適用できる.

図5はその例で,実画像にPTI反転[Roich et al. 2022]を適用し,画像中の顔のポーズ,髪型,形状,表情を編集する一連の操作を行ったものである.

図13では,さらに多くの実画像編集例を示している.

4.2節:Quantitative Evaluation(定量的評価)

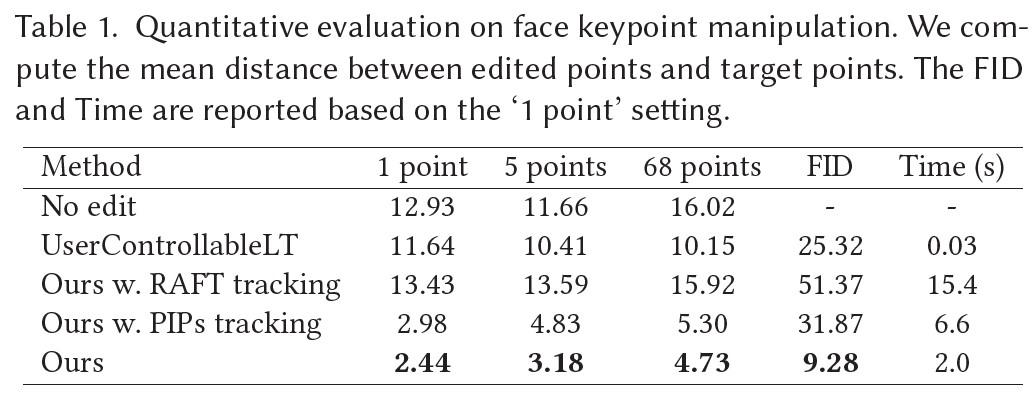

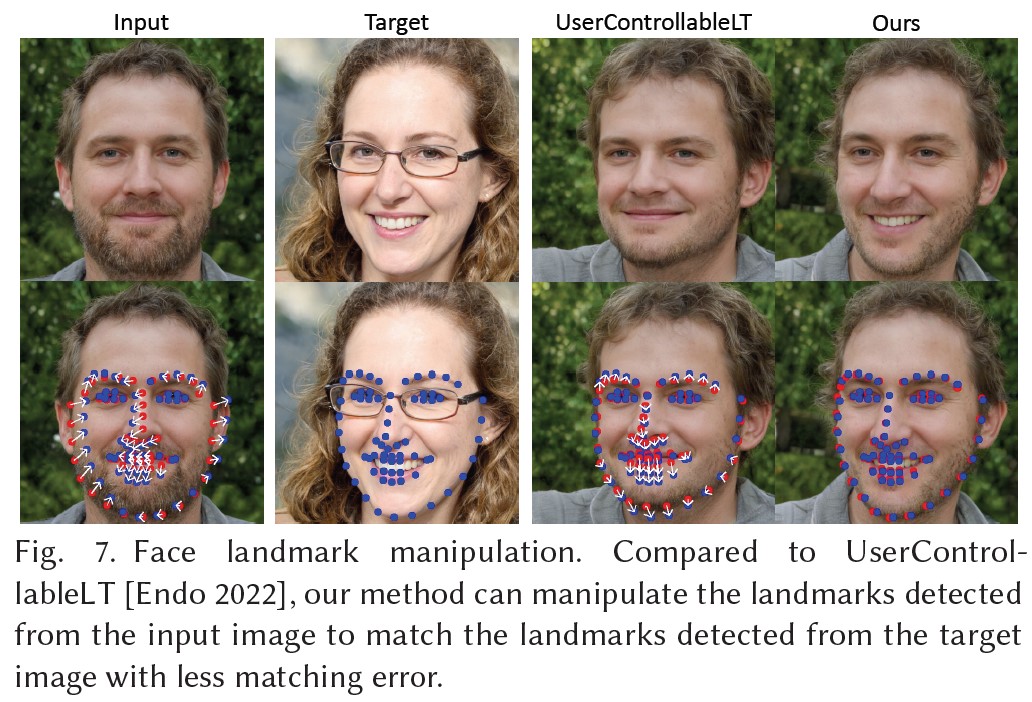

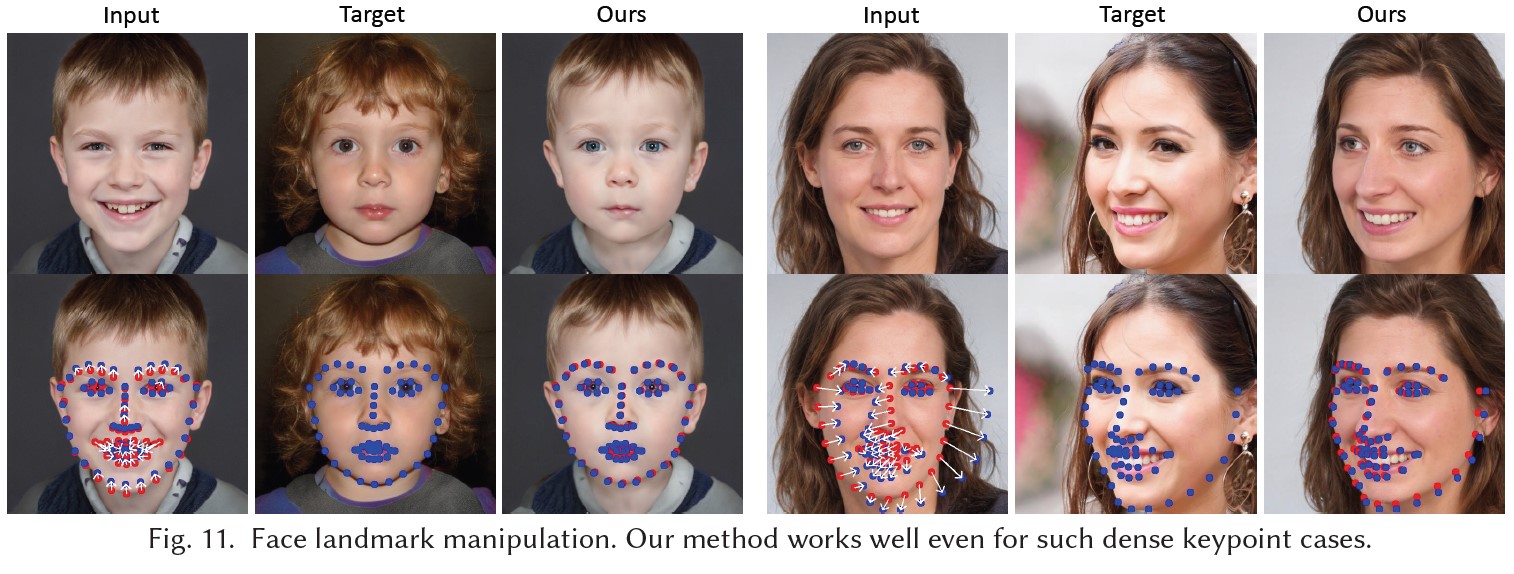

顔ランドマーク操作とペア画像再構成の2つの設定で,本手法を定量的に評価する.

顔のランドマーク操作:

顔のランドマーク検出は,市販のツール[King 2009]を用いて非常に信頼性が高いため,その予測値をグランドトゥルースのランドマークとして使用する.

具体的には,FFHQで訓練させたStyleGANを用いてランダムに2つの顔画像を生成し,そのランドマークを検出する.

その目的は,1枚目の画像のランドマークを操作して,2枚目の画像のランドマークと一致させることである.

操作後,最終画像のランドマークを検出し,目標のランドマークまでの平均距離(MD:Mean Distance)を計算する.

結果は1000回のテストで平均化される.

すべての方法を評価するために,同じテストサンプルのセットを使用する.

このように,最終的なMDスコアは,方法がどれだけランドマークを目標位置に移動させることができるかを反映する.

ランドマークの数が異なる3つの設定(1,5,68)で評価を行い,ハンドルポイントの数が異なる場合の本手法の頑健性を示した.

また,画質の指標として,編集後の画像と初期画像との間のFIDスコアも報告する.

本アプローチとそのvariantsでは,最適化ステップの最大値は300に設定されている.

結果は表1に示す通りである.

本手法は,異なるポイント数において,UserControllableLTを大幅に上回っている.

図7に定性的な比較を示すが,UserControllableLTが失敗したのに対し,我々の手法は口を開き,顎の形状を調整し,ターゲット顔に一致させている.

さらに,FIDスコアで示されるように,本手法はより良い画質を保持している.

また,より優れたトラッキング能力により,RAFTやPIPsよりも正確な操作を実現している.

不正確なトラッキングは,過剰な操作にもつながり,FIDスコアに示されるように画質を悪化させる.

UserControllableLTはより高速だが,我々のアプローチはこのタスクの上限を大きく押し上げ,ユーザにとって快適な実行時間を維持しながら,より忠実な操作を達成した.

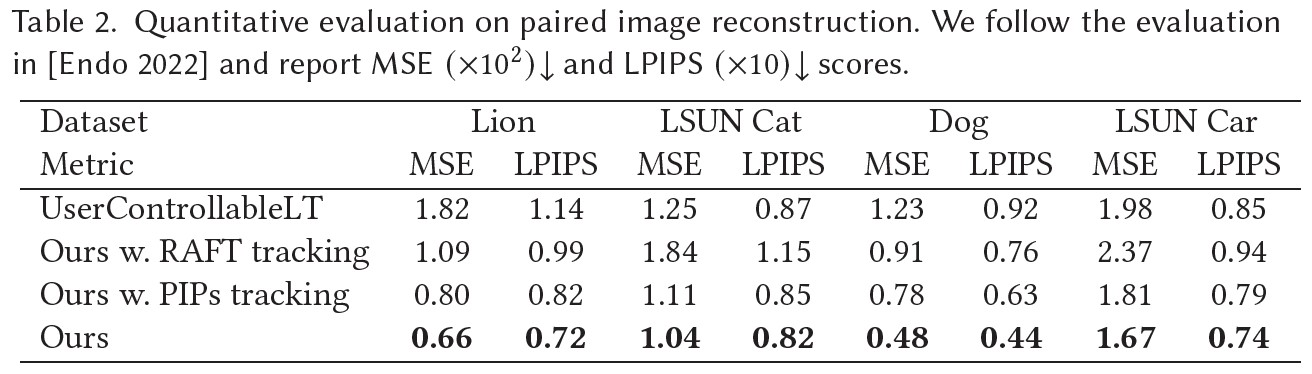

ペア画像再構成:

この評価では,UserControllableLT[Endo 2022]と同じ設定に従う.

具体的には,潜在コード\(w_1\)をサンプリングし,[Endo 2022]と同じ方法でランダムに摂動して\(w_2\)を取得する.

2つの潜在コードから生成されたStyleGAN画像を\(I_1\),\(I_2\)とする.

そして,\(I_1\)と\(I_2\)の間のオプティカルフローを計算し,フローフィールドから32ピクセルをユーザ入力Uとしてランダムにサンプリングする.

目標は,\(I_1\)とUから\(I_2\)を再構成することである.

MSEとLPIPS[Zhang et al. 2018]を報告し,1000サンプルの結果を平均する.

最大最適化ステップは,我々のアプローチとそのvariantsでは100に設定されている.

表2に示すように,我々のアプローチは,異なるオブジェクトカテゴリーですべてのベースラインを上回り,これは以前の結果と一致する.

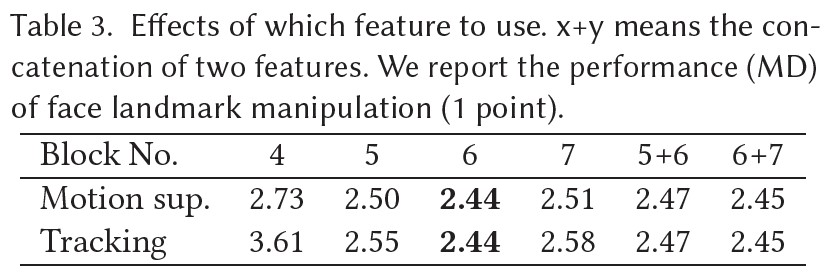

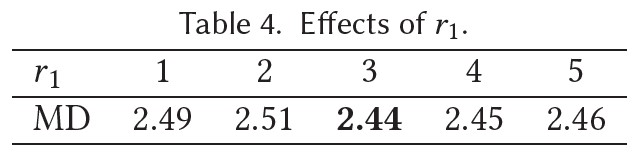

アブレーション研究:

ここでは,モーション監視とポイントトラッキングにおいて,どの特徴を使うかの効果を研究している.

異なる特徴量を用いた顔ランドマーク操作のパフォーマンス(MD)を報告する.

表3からわかるように,モーション監視とポイントトラッキングの両方において,StyleGANの6ブロック目以降の特徴マップが最も性能が良く,解像度と識別性のバランスが最も良いことを示している.

また,\(r_1\)の効果を表4で示す.

性能は\(r_1\)の選択に対してあまり敏感ではなく,\(r_1 = 3\)がわずかに良い性能を示すことが観察される.

4.3節:Discussions(ディスカッション)

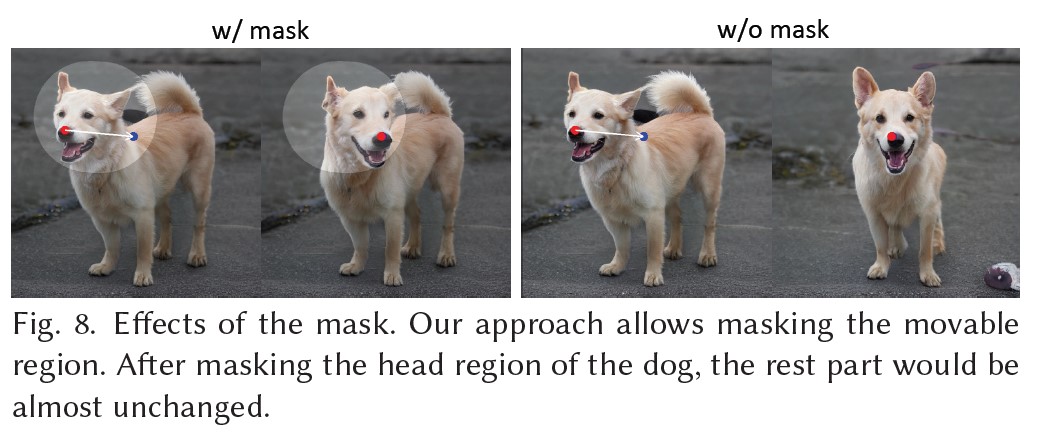

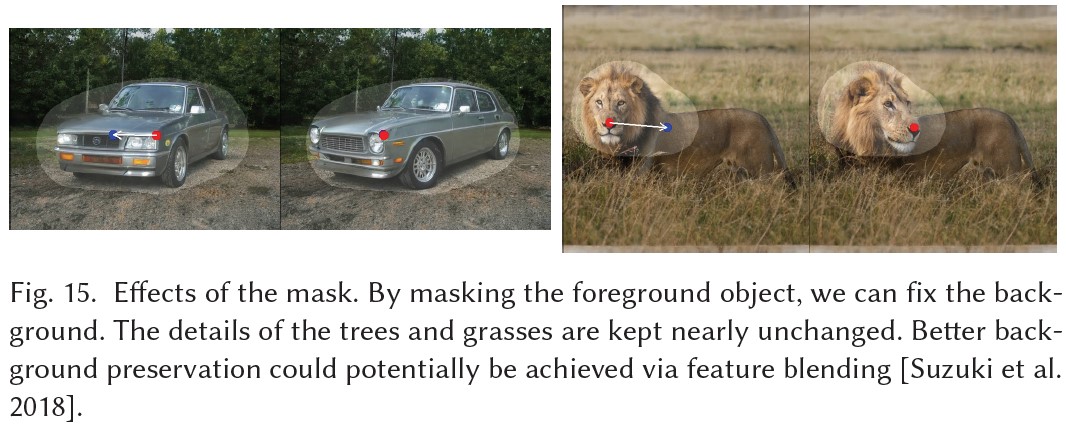

マスクの効果:

本手法では,可動領域を示す2値のマスクをユーザが入力することができる.

その効果を図8に示す.

犬の頭部を覆うマスクを与えると,他の領域はほぼ固定され,頭部のみが動く.

マスクがない場合は,犬の体全体を動かす操作となる.

このことから,ポイントベースの操作には複数の解が存在することが多く,GANは訓練データから学習した画像多様体の中から最も近い解を見つける傾向があることがわかる.

マスク機能は,曖昧さを減らし,特定の領域を固定化するのに役立つ.

分布外でのマニピュレーション:

これまで紹介してきたポイントベースの操作は,「分布内」操作,つまり,訓練データセットの画像分布の中にある自然な画像で操作要件を満たすことが可能であった.

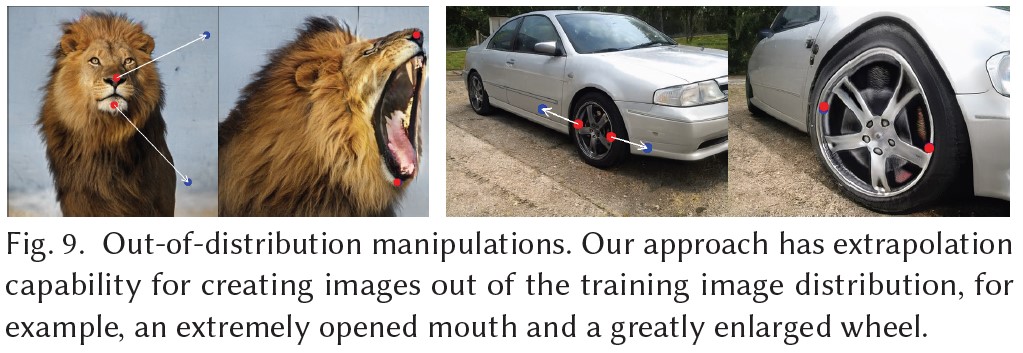

ここでは,図9に示すような分布外での操作を紹介する.

極端に開いた口や大きな車輪など,訓練用画像分布から外れた画像を作成することで,本アプローチがある程度の外挿機能を有していることがわかる.

場合によっては,ユーザは画像を常に訓練分布内に保ち,このような分布外操作に至らないようにしたいと思うかもしれない.

これを実現する方法として,潜在コードwに追加の正則化を加えることが考えられるが,これは本論文の主眼ではない.

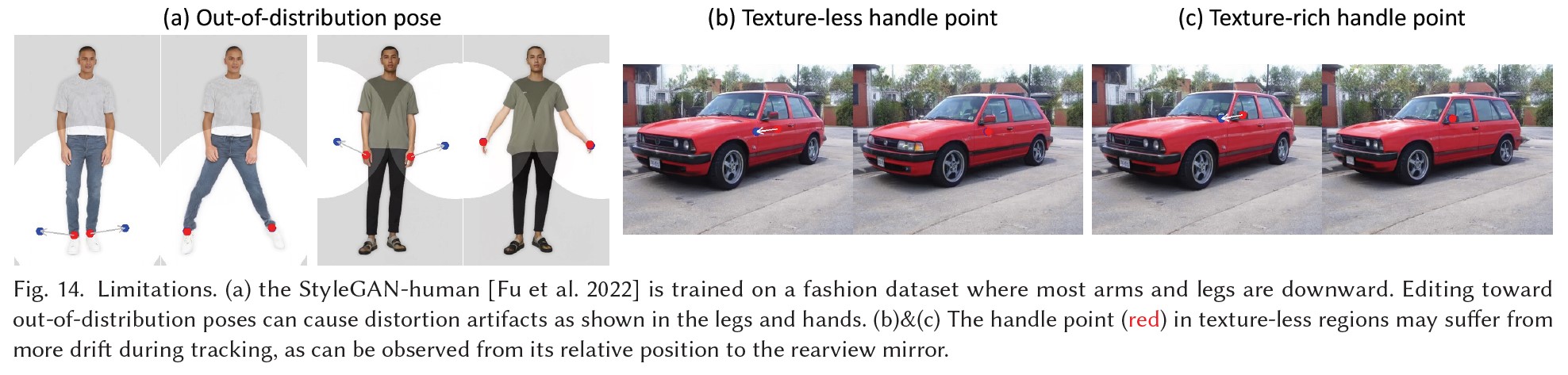

限界:

外挿機能があるにもかかわらず,編集品質は学習データの多様性に影響される.

図14(a)に示すように,訓練分布から外れた人物ポーズを作成すると,アーティファクトが発生する可能性がある.

また,図14(b)(c)に示すように,テクスチャのない領域のハンドルポイントは,トラッキングにおいてよりドリフトに悩まされることがある.

したがって,可能であれば,テクスチャの豊富なハンドルポイントを選ぶことをお勧めする.

社会的な影響:

本手法は画像の空間属性を変化させることができるため,実在する人物のポーズや表情,形状を偽った画像を作成するために悪用される可能性がある.

そのため,本手法を利用したアプリケーションや研究は,人格権やプライバシーに関する規制を厳格に遵守する必要がある.

5章:CONCLUSION(結論)

我々は,直感的なポイントベースの画像編集のための対話型アプローチであるDragGANを発表した.

本手法は,事前訓練されたGANを活用し,ユーザの入力に正確に従うだけでなく,現実的な画像の多様体に留まる画像を合成する.

従来の多くのアプローチとは対照的に,我々は,ドメイン固有のモデリングや補助的なネットワークに依存しない,一般的なフレームワークを提示する.

これは,2つの新しい要素を用いて達成されている.

すなわち,複数のハンドルポイントを目標位置に向けて段階的に移動させる潜在コードの最適化と,ハンドルポイントのトラッキングを忠実にトレースするポイントトラッキングの手順である.

両要素は,GANの中間特徴マップの識別性を利用し,ピクセル精度の画像変形と対話的なパフォーマンスを実現する.

我々は,本アプローチがGANベースの操作の最先端技術を凌駕することを実証し,Generative Priors(生成事前)を用いた強力な画像編集の新たな方向性を切り開くことができた.

今後の課題としては,ポイントベース編集を3次元生成モデルに拡張する予定である.

REFERENCES(参考文献)

- [Abdal et al. 2019] Rameen Abdal, Yipeng Qin, and Peter Wonka. 2019. Image2stylegan: How to embed images into the stylegan latent space?. In ICCV.

- [Abdal et al. 2021] Rameen Abdal, Peihao Zhu, Niloy J Mitra, and Peter Wonka. 2021. Styleflow: Attribute-conditioned exploration of stylegan-generated images using conditional continuous normalizing flows. ACM Transactions on Graphics (ToG) 40, 3 (2021), 1–21.

- [Brox and Malik 2010] Thomas Brox and Jitendra Malik. 2010. Large displacement optical flow: descriptor matching in variational motion estimation. IEEE transactions on pattern analysis and machine intelligence 33, 3 (2010), 500–513.

- [Chan et al. 2022] Eric R. Chan, Connor Z. Lin, Matthew A. Chan, Koki Nagano, Boxiao Pan, Shalini De Mello, Orazio Gallo, Leonidas Guibas, Jonathan Tremblay, Sameh Khamis, Tero Karras, and Gordon Wetzstein. 2022. Efficient Geometry-aware 3D Generative Adversarial Networks. In CVPR.

- [Chan et al. 2021] Eric R Chan, Marco Monteiro, Petr Kellnhofer, Jiajun Wu, and Gordon Wetzstein. 2021. pi-gan: Periodic implicit generative adversarial networks for 3d-aware image synthesis. In CVPR.

- [Chen et al. 2022] Anpei Chen, Ruiyang Liu, Ling Xie, Zhang Chen, Hao Su, and Jingyi Yu. 2022. Sofgan: A portrait image generator with dynamic styling. ACM Transactions on Graphics (TOG) 41, 1 (2022), 1–26.

- [Choi et al. 2020] Yunjey Choi, Youngjung Uh, Jaejun Yoo, and Jung-Woo Ha. 2020. StarGAN v2: Diverse Image Synthesis for Multiple Domains. In CVPR.

- [Collins et al. 2020] Edo Collins, Raja Bala, Bob Price, and Sabine Susstrunk. 2020. Editing in style: Uncovering the local semantics of gans. In CVPR. 5771–5780.

- [Creswell et al. 2018] Antonia Creswell, Tom White, Vincent Dumoulin, Kai Arulkumaran, Biswa Sengupta, and Anil A Bharath. 2018. Generative adversarial networks: An overview. IEEE signal processing magazine 35, 1 (2018), 53–65.

- [Deng et al. 2020] Yu Deng, Jiaolong Yang, Dong Chen, Fang Wen, and Xin Tong. 2020. Disentangled and Controllable Face Image Generation via 3D Imitative-Contrastive Learning. In CVPR.

- [Dosovitskiy et al. 2015] Alexey Dosovitskiy, Philipp Fischer, Eddy Ilg, Philip Hausser, Caner Hazirbas, Vladimir Golkov, Patrick Van Der Smagt, Daniel Cremers, and Thomas Brox. 2015. Flownet: Learning optical flow with convolutional networks. In ICCV.

- [Endo 2022] Yuki Endo. 2022. User-Controllable Latent Transformer for StyleGAN Image Layout Editing. Computer Graphics Forum 41, 7 (2022), 395–406. https://doi.org/10.1111/cgf.14686

- [Epstein et al. 2022] Dave Epstein, Taesung Park, Richard Zhang, Eli Shechtman, and Alexei A Efros. 2022. Blobgan: Spatially disentangled scene representations. In ECCV. 616–635.

- [Fu et al. 2022] Jianglin Fu, Shikai Li, Yuming Jiang, Kwan-Yee Lin, Chen Qian, Chen-Change Loy, Wayne Wu, and Ziwei Liu. 2022. StyleGAN-Human: A Data-Centric Odyssey of Human Generation. In ECCV.

- [Ghosh et al. 2020] Partha Ghosh, Pravir Singh Gupta, Roy Uziel, Anurag Ranjan, Michael J Black, and Timo Bolkart. 2020. GIF: Generative interpretable faces. In International Conference on 3D Vision (3DV).

- [Goodfellow et al. 2014] Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, DavidWarde-Farley, Sherjil Ozair, Aaron Courville, and Yoshua Bengio. 2014. Generative adversarial nets. In NeurIPS.

- [Gu et al. 2022] Jiatao Gu, Lingjie Liu, Peng Wang, and Christian Theobalt. 2022. StyleNeRF: A Style-based 3D-Aware Generator for High-resolution Image Synthesis. In ICLR.

- [Härkönen et al. 2020] Erik Härkönen, Aaron Hertzmann, Jaakko Lehtinen, and Sylvain Paris. 2020. GANSpace: Discovering Interpretable GAN Controls. arXiv preprint arXiv:2004.02546 (2020).

- [Harley et al. 2022] Adam W. Harley, Zhaoyuan Fang, and Katerina Fragkiadaki. 2022. Particle Video Revisited: Tracking Through Occlusions Using Point Trajectories. In ECCV.

- [Ho et al. 2020] Jonathan Ho, Ajay Jain, and Pieter Abbeel. 2020. Denoising diffusion probabilistic models. In NeurIPS.

- [Igarashi et al. 2005] Takeo Igarashi, Tomer Moscovich, and John F Hughes. 2005. As-rigid-as-possible shape manipulation. ACM transactions on Graphics (TOG) 24, 3 (2005), 1134–1141.

- [Ilg et al. 2017] Eddy Ilg, Nikolaus Mayer, Tonmoy Saikia, Margret Keuper, Alexey Dosovitskiy, and Thomas Brox. 2017. Flownet 2.0: Evolution of optical flow estimation with deep networks. In CVPR.

- [Isola et al. 2017] Phillip Isola, Jun-Yan Zhu, Tinghui Zhou, and Alexei A Efros. 2017. Image-to-image translation with conditional adversarial networks. In CVPR.

- [Karras et al. 2021] Tero Karras, Miika Aittala, Samuli Laine, Erik Härkönen, Janne Hellsten, Jaakko Lehtinen, and Timo Aila. 2021. Alias-Free Generative Adversarial Networks. In NeurIPS.

- [Karras et al. 2019] Tero Karras, Samuli Laine, and Timo Aila. 2019. A style-based generator architecture for generative adversarial networks. In CVPR. 4401–4410.

- [Karras et al. 2020] Tero Karras, Samuli Laine, Miika Aittala, Janne Hellsten, Jaakko Lehtinen, and Timo Aila. 2020. Analyzing and improving the image quality of stylegan. In CVPR. 8110–8119.

- [King 2009] Davis E. King. 2009. Dlib-ml: A Machine Learning Toolkit. Journal of Machine Learning Research 10 (2009), 1755–1758.

- [Kingma and Ba 2014] Diederik P Kingma and Jimmy Ba. 2014. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980 (2014).

- [Leimkühler and Drettakis 2021] Thomas Leimkühler and George Drettakis. 2021. FreeStyleGAN: Free-view Editable Portrait Rendering with the Camera Manifold. 40, 6 (2021). https://doi.org/10.1145/3478513.3480538

- [Ling et al. 2021] Huan Ling, Karsten Kreis, Daiqing Li, Seung Wook Kim, Antonio Torralba, and Sanja Fidler. 2021. Editgan: High-precision semantic image editing. In NeurIPS.

- [Mokady et al. 2022] Ron Mokady, Omer Tov, Michal Yarom, Oran Lang, Inbar Mosseri, Tali Dekel, Daniel Cohen-Or, and Michal Irani. 2022. Self-distilled stylegan: Towards generation from internet photos. In ACM SIGGRAPH 2022 Conference Proceedings. 1–9.

- [Pan et al. 2021] Xingang Pan, Xudong Xu, Chen Change Loy, Christian Theobalt, and Bo Dai. 2021. A Shading-Guided Generative Implicit Model for Shape-Accurate 3D-Aware Image Synthesis. In NeurIPS.

- [Park et al. 2019] Taesung Park, Ming-Yu Liu, Ting-Chun Wang, and Jun-Yan Zhu. 2019. Semantic image synthesis with spatially-adaptive normalization. In CVPR.

- [Paszke et al. 2017] Adam Paszke, Sam Gross, Soumith Chintala, Gregory Chanan, Edward Yang, Zachary DeVito, Zeming Lin, Alban Desmaison, Luca Antiga, and Adam Lerer. 2017. Automatic differentiation in PyTorch. (2017).

- [Patashnik et al. 2021] Or Patashnik, Zongze Wu, Eli Shechtman, Daniel Cohen-Or, and Dani Lischinski. 2021. Styleclip: Text-driven manipulation of stylegan imagery. In ICCV.

- [Pinkney 2020] Justin N. M. Pinkney. 2020. Awesome pretrained StyleGAN2. https://github.com/justinpinkney/awesome-pretrained-stylegan2.

- [Ramesh et al. 2022] Aditya Ramesh, Prafulla Dhariwal, Alex Nichol, Casey Chu, and Mark Chen. 2022. Hierarchical text-conditional image generation with clip latents. arXiv preprint arXiv:2204.06125 (2022).

- [Roich et al. 2022] Daniel Roich, Ron Mokady, Amit H Bermano, and Daniel Cohen-Or. 2022. Pivotal tuning for latent-based editing of real images. ACM Transactions on Graphics (TOG) 42, 1 (2022), 1–13.

- [Rombach et al. 2021] Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, and Björn Ommer. 2021. High-Resolution Image Synthesis with Latent Diffusion Models. arXiv:2112.10752 [cs.CV]

- [Saharia et al. 2022] Chitwan Saharia, William Chan, Saurabh Saxena, Lala Li, Jay Whang, Emily Denton, Seyed Kamyar Seyed Ghasemipour, Burcu Karagol Ayan, S Sara Mahdavi, Rapha Gontijo Lopes, et al. 2022. Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding. arXiv preprint arXiv:2205.11487 (2022).

- [Schwarz et al. 2020] Katja Schwarz, Yiyi Liao, Michael Niemeyer, and Andreas Geiger. 2020. GRAF: Generative Radiance Fields for 3D-Aware Image Synthesis. In NeurIPS.

- [Shen et al. 2020] Yujun Shen, Jinjin Gu, Xiaoou Tang, and Bolei Zhou. 2020. Interpreting the latent space of gans for semantic face editing. In CVPR.

- [Shen and Zhou 2020] Yujun Shen and Bolei Zhou. 2020. Closed-Form Factorization of Latent Semantics in GANs. arXiv preprint arXiv:2007.06600 (2020).

- [Skorokhodov et al. 2021] Ivan Skorokhodov, Grigorii Sotnikov, and Mohamed Elhoseiny. 2021. Aligning Latent and Image Spaces to Connect the Unconnectable. arXiv preprint arXiv:2104.06954 (2021).

- [Sohl-Dickstein et al. 2015] Jascha Sohl-Dickstein, Eric Weiss, Niru Maheswaranathan, and Surya Ganguli. 2015. Deep unsupervised learning using nonequilibrium thermodynamics. In International Conference on Machine Learning. PMLR, 2256–2265.

- [Song et al. 2020] Jiaming Song, Chenlin Meng, and Stefano Ermon. 2020. Denoising Diffusion Implicit Models. In ICLR.

- [Song et al. 2021] Yang Song, Jascha Sohl-Dickstein, Diederik P Kingma, Abhishek Kumar, Stefano Ermon, and Ben Poole. 2021. Score-Based Generative Modeling through Stochastic Differential Equations. In International Conference on Learning Representations.

- [Sundaram et al. 2010] Narayanan Sundaram, Thomas Brox, and Kurt Keutzer. 2010. Dense point trajectories by gpu-accelerated large displacement optical flow. In ECCV.

- [Suzuki et al. 2018] Ryohei Suzuki, Masanori Koyama, Takeru Miyato, Taizan Yonetsuji, and Huachun Zhu. 2018. Spatially controllable image synthesis with internal representation collaging. arXiv preprint arXiv:1811.10153 (2018).

- [Teed and Deng 2020] Zachary Teed and Jia Deng. 2020. Raft: Recurrent all-pairs field transforms for optical flow. In ECCV.

- [Tewari et al. 2022] Ayush Tewari, MalliKarjun B R, Xingang Pan, Ohad Fried, Maneesh Agrawala, and Christian Theobalt. 2022. Disentangled3D: Learning a 3D Generative Model with Disentangled Geometry and Appearance from Monocular Images. In CVPR.

- [Tewari et al. 2020] Ayush Tewari, Mohamed Elgharib, Gaurav Bharaj, Florian Bernard, Hans-Peter Seidel, Patrick Pérez, Michael Zollhofer, and Christian Theobalt. 2020. StyleRig: Rigging StyleGAN for 3D Control over Portrait Images. In CVPR.

- [Tritrong et al. 2021] Nontawat Tritrong, Pitchaporn Rewatbowornwong, and Supasorn Suwajanakorn. 2021. Repurposing gans for one-shot semantic part segmentation. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 4475–4485.

- [Wang et al. 2022b] Jianyuan Wang, Ceyuan Yang, Yinghao Xu, Yujun Shen, Hongdong Li, and Bolei Zhou. 2022b. Improving gan equilibrium by raising spatial awareness. In CVPR. 11285–11293.

- [Wang et al. 2022a] Sheng-Yu Wang, David Bau, and Jun-Yan Zhu. 2022a. Rewriting Geometric Rules of a GAN. ACM Transactions on Graphics (TOG) (2022).

- [Xu et al. 2022] Yinghao Xu, Sida Peng, Ceyuan Yang, Yujun Shen, and Bolei Zhou. 2022. 3D-aware Image Synthesis via Learning Structural and Textural Representations. In CVPR.

- [Yu et al. 2015] Fisher Yu, Ari Seff, Yinda Zhang, Shuran Song, Thomas Funkhouser, and Jianxiong Xiao. 2015. Lsun: Construction of a large-scale image dataset using deep learning with humans in the loop. arXiv preprint arXiv:1506.03365 (2015).

- [Zhang et al. 2018] Richard Zhang, Phillip Isola, Alexei A Efros, Eli Shechtman, and Oliver Wang. 2018. The Unreasonable Effectiveness of Deep Features as a Perceptual Metric. In CVPR.

- [Zhang et al. 2021] Yuxuan Zhang, Huan Ling, Jun Gao, Kangxue Yin, Jean-Francois Lafleche, Adela Barriuso, Antonio Torralba, and Sanja Fidler. 2021. DatasetGAN: Efficient Labeled Data Factory with Minimal Human Effort. In CVPR.

- [Zhu et al. 2023] Jiapeng Zhu, Ceyuan Yang, Yujun Shen, Zifan Shi, Deli Zhao, and Qifeng Chen. 2023. LinkGAN: Linking GAN Latents to Pixels for Controllable Image Synthesis. arXiv preprint arXiv:2301.04604 (2023).

- [Zhu et al. 2016] Jun-Yan Zhu, Philipp Krähenbühl, Eli Shechtman, and Alexei A Efros. 2016. Generative visual manipulation on the natural image manifold. In ECCV.

APPENDIX(付録)

参考:Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの解説動画

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの解説動画です.

まとめ

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifoldの日本語訳を紹介しました.

DragGANがわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.