AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの日本語訳を教えて!

こういった悩みにお答えします.

本記事の信頼性

- リアルタイムシステムの研究歴12年.

- 東大教員の時に,英語でOS(Linuxカーネル)の授業.

- 2012年9月~2013年8月にアメリカのノースカロライナ大学チャペルヒル校(UNC)コンピュータサイエンス学部で客員研究員として勤務.C言語でリアルタイムLinuxの研究開発.

- プログラミング歴15年以上,習得している言語: C/C++,Python,Solidity/Vyper,Java,Ruby,Go,Rust,D,HTML/CSS/JS/PHP,MATLAB,Verse(UEFN), Assembler (x64,aarch64).

- 東大教員の時に,C++言語で開発した「LLVMコンパイラの拡張」,C言語で開発した独自のリアルタイムOS「Mcube Kernel」をGitHubにオープンソースとして公開.

- 2020年1月~現在はアメリカのノースカロライナ州チャペルヒルにあるGuarantee Happiness LLCのCTOとしてECサイト開発やWeb/SNSマーケティングの業務.2022年6月~現在はアメリカのノースカロライナ州チャペルヒルにあるJapanese Tar Heel, Inc.のCEO兼CTO.

- 最近は自然言語処理AIとイーサリアムに関する有益な情報発信や,Unreal Editor for Fortnite(UEFN)でゲーム開発に従事.

- (AI全般を含む)自然言語処理AIの論文の日本語訳や,AIチャットボット(ChatGPT,Auto-GPT,Gemini(旧Bard)など)の記事を50本以上執筆.アメリカのサンフランシスコ(広義のシリコンバレー)の会社でChatGPT/Geminiを訓練するプロンプトエンジニア・マネージャー・Quality Assurance(QA)の業務委託の経験あり.

- (スマートコントラクトのプログラミングを含む)イーサリアムや仮想通貨全般の記事を200本以上執筆.イギリスのロンドンの会社で仮想通貨の英語の記事を日本語に翻訳する業務委託の経験あり.

- UEFNで10本以上のゲームを開発し,フォートナイト上で公開(Fortnite,Fortnite.GG).

こういった私から学べます.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの日本語訳を紹介します.

画像から動画を生成するAI「AnimateDiff」がわかります.

※図表を含む論文の著作権はAnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの著者に帰属します.

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの目次は以下になります.

- Abstract

- 1章:Introduction

- 2章:Related Work

- 3章:Preliminary

- 4章:AnimateDiff

- 5章:Experiments

- 6章:Conclusion

- 7章:Ethics Statement

- 8章:Reproducibility Statement

- Acknowledgement

- References

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningを解説しつつ,私の考えも語ります.

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの概要と私の日本語訳は以下になります.

With the advance of text-to-image (T2I) diffusion models (e.g., Stable Diffusion) and corresponding personalization techniques such as DreamBooth and LoRA, everyone can manifest their imagination into high-quality images at an affordable cost.

テキストから画像への拡散(T2I)モデル(例:Stable Diffusion)や,それに対応するDreamBoothやLoRAのようなパーソナライズ技術の進歩により,誰もが手頃なコストで自分の想像力を高品質な画像に現すことができるようになった.However, adding motion dynamics to existing high-quality personalized T2Is and enabling them to generate animations remains an open challenge.

しかしながら,既存の高品質なパーソナライズドT2Iにモーションダイナミクスを追加し,アニメーションを生成できるようにすることは,依然として未解決の課題である.In this paper, we present AnimateDiff, a practical framework for animating personalized T2I models without requiring model-specific tuning.

本論文では,モデル固有のチューニングを必要とせずに,パーソナライズされたT2Iモデルをアニメーション化するための実用的なフレームワークであるAnimateDiffを紹介する.At the core of our framework is a plug-and-play motion module that can be trained once and seamlessly integrated into any personalized T2Is originating from the same base T2I.

本フレームワークの中核をなすのは,プラグアンドプレイのモーションモジュールであり,一度訓練させるだけで,同じベースT2Iから生成されたパーソナライズドT2Iにシームレスに統合することができる.Through our proposed training strategy, the motion module effectively learns transferable motion priors from real-world videos.

我々の提案する訓練戦略により,モーションモジュールは,実世界の動画から転送可能な事前知識(Motion Prior)を効果的に学習する.Once trained, the motion module can be inserted into a personalized T2I model to form a personalized animation generator.

一旦訓練されたモーションモジュールは,パーソナライズされたT2Iモデルに挿入され,パーソナライズされたアニメーションジェネレータを形成することができる.We further propose MotionLoRA, a lightweight fine-tuning technique for AnimateDiff that enables a pre-trained motion module to adapt to new motion patterns, such as different shot types, at a low training and data collection cost.

さらに,AnimateDiffのための軽量なファインチューニング技術であるMotionLoRAを提案する.これは,事前訓練されたモーションモジュールが,低い訓練コストとデータ収集コストで,異なるショットタイプなどの新しいモーションパターンに適応することを可能にする.We evaluate AnimateDiff and MotionLoRA on several public representative personalized T2I models collected from the community.

AnimateDiffとMotionLoRAを,コミュニティから収集されたいくつかの一般的な代表的パーソナライズドT2Iモデルで評価する.The results demonstrate that our approaches help these models generate temporally smooth animation clips while preserving the visual quality and motion diversity.

その結果,我々のアプローチが,視覚的品質と動きの多様性を保持しながら,これらのモデルが時間的に滑らかなアニメーションクリップを生成するのに役立つことが実証された.Codes and pre-trained weights are available at https://github.com/guoyww/AnimateDiff.

コードと事前訓練された重みは,https://github.com/guoyww/AnimateDiffで入手可能である.https://arxiv.org/abs/2307.04725

私の日本語訳の注意点は以下になります.

- 概要は英語と日本語を両方掲載しましたが,本文は私の日本語訳のみを掲載していること(英語で読みたいあなたは原文を読みましょう!)

- 基本的には原文の直訳ですが,わかりにくい箇所は意訳や説明を追加している箇所があること

- 原文の「Acknowledgements」(謝辞)は省略していること

- 本文中に登場する表記「(Nichol et al., 2021; Ramesh et al., 2022; Saharia et al., 2022; Rombach et al., 2022)」などは参考文献ですので,興味がある方は本記事の参考文献を参照されたいこと

それでは,AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの本文を読みすすめましょう!

目次

1章:Introduction(はじめに)

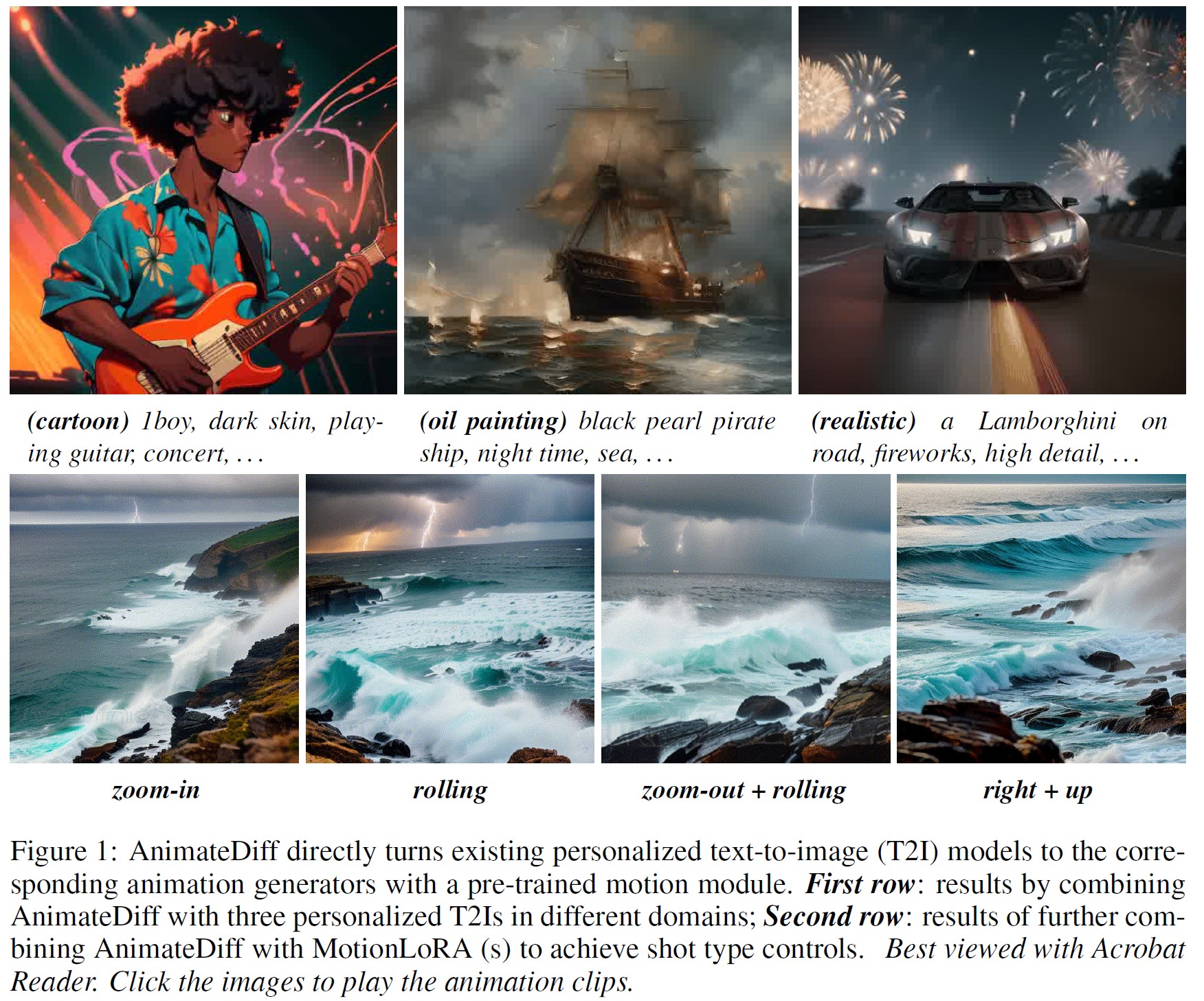

※訳注:原文で図1のアニメーションを観ましょう!

テキストから画像への(T2I:Text-to-Image)拡散モデル(Nichol et al., 2021; Ramesh et al., 2022; Saharia et al., 2022; Rombach et al., 2022)は,アーティストやアマチュアがテキストプロンプトを使用してビジュアルコンテンツを作成することを大いに支援してきた.

既存のT2Iモデルの創造性をさらに刺激するために,DreamBooth(Ruiz et al., 2023)やLoRA(Hu et al., 2021)などの軽量なパーソナライゼーション手法が提案されている.

これらの手法は,RTX3080を搭載したラップトップなどの民生グレードのハードウェアを使用して,小規模なデータセット上でカスタマイズされたファインチューニングを可能にし,それによってユーザは,比較的低コストで新しいドメインに基本T2Iモデルを適応させ,視覚的品質を向上させることができる.

その結果,AIアーティストやアマチュアの大規模なコミュニティが,Civitai(Civitai, 2022)やHugging Face(Hugging Face, 2022)などのモデル共有プラットフォーム上に,数多くのパーソナライズドモデルを提供している.

これらのパーソナライズされたT2Iモデルは,顕著な視覚的品質を生成することができるが,その出力は静止画像に限られている.

一方,アニメーションを生成する能力は,映画やアニメ業界などの実世界での制作において,より望ましいものである.

本研究では,モデル固有のファインチューニングを必要とせず,既存の高品質なパーソナライズドT2Iモデルをアニメーションジェネレータに直接変換することを目指す.

これは,アマチュアユーザにとっては,計算コストやデータ収集コストの点で非現実的であることが多い.

AnimateDiffは,パーソナライズされたT2Iを,その視覚的品質とドメイン知識を保持しながらアニメーション化するという問題に対処するための効果的なパイプラインである.

AnimateDiffの中核は,WebVid-10M(Bain et al., 2021)などの動画データセットから妥当な事前知識(Motion Prior)を学習するプラグアンドプレイモーションモジュールを訓練するアプローチである.

訓練されたモーションモジュールは,推論時に,パーソナライズされたT2Iに直接統合され,特別なチューニングを必要とせずに,滑らかで視覚的に魅力的なアニメーションを生成することができる.

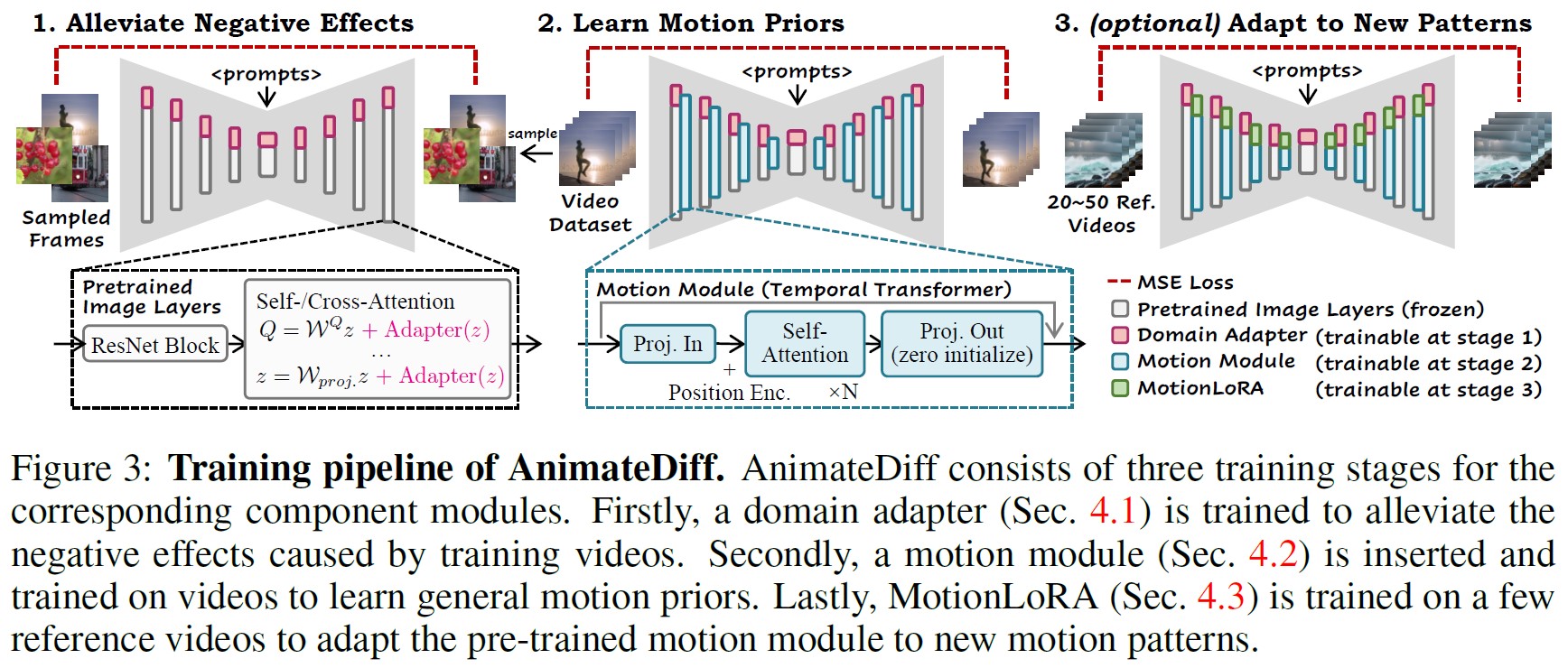

AnimateDiffにおけるモーションモジュールの訓練は,3つの段階から構成される.

まず,ベースT2Iのドメインアダプタをファインチューニングし,ターゲット動画データセットの視覚分布に合わせる.

この予備段階により,モーションモジュールは訓練動画からのピクセルレベルの詳細ではなく,事前知識の学習に集中することが保証される.

次に,ベースT2Iをドメインアダプタとともに膨張させ,モーションモデリング用に新たに初期化されたモーションモジュールを導入する.

そして,ドメインアダプタとベースT2Iの重みを固定したまま,このモジュールを動画上で最適化する.

そうすることで,モーションモジュールは一般化された事前知識を学習し,モジュールの挿入によって,他のパーソナライズされたT2Iが,パーソナライズされたドメインに沿った滑らかで魅力的なアニメーションを生成できるようになる.

AnimateDiffの第3段階は,MotionLoRAと呼ばれ,少ない数の参照動画と訓練の繰り返しで,事前訓練されたモーションモジュールを特定のモーションパターンに適応させることを目的としている.

これは,Low-Rank Adaptation(LoRA)(Hu et al., 2021)の助けを借りてモーションモジュールをファインチューニングすることで達成される.

驚くべきことに,新しいモーションパターンへの適応は,わずか50の参照動画で達成できる.

さらに,MotionLoRAモデルは,約30Mの追加ストレージスペースしか必要とせず,モデル共有の効率をさらに高める.

この効率性は,事前訓練の高価なコストを負担できないが,特定の効果のためにモーションモジュールをファインチューニングしたいユーザにとって特に価値がある.

モデル共有プラットフォーム(Civitai, 2022; Hugging Face, 2022)から収集した,パーソナライズされたT2Iモデルの多様なセットを用いて,AnimateDiffとMotionLoRAの性能を評価する.

これらのモデルは,2Dアニメからリアルな写真まで,幅広い領域を網羅しており,評価のための包括的なベンチマークを形成している.

実験の結果,有望な結果が得られた.

実際には,時間軸に沿ったTransformer(Vaswani et al., 2017)アーキテクチャが,適切な事前知識を捕捉するのに十分であることも分かった.

我々はまた,我々のモーションモジュールが,追加の訓練を必要とすることなく,ControlNetのような既存のコンテンツ制御アプロー(Zhang et al., 2023; Mou et al., 2023)とシームレスに統合できることを実証し,制御可能なアニメーション生成のためのAnimateDiffを可能にする.

要約すると,以下になる.

- 特定のファインチューニングを行うことなく,任意のパーソナライズされたT2Iのアニメーション生成能力を可能にする実用的なパイプラインであるAnimateDiffを紹介する.

- Transformerアーキテクチャが事前知識のモデリングに適切であることを検証する.これは,動画制作のための貴重な洞察を提供する.

- 新しいモーションパターンに事前訓練されたモーションモジュールを適応させるための軽量なファインチューニング技術であるMotionLoRAを提案する.

- 代表的なコミュニティモデルを用いて我々のアプローチを総合的に評価し,学術ベースラインと,Gen-2(Gen-2, 2023)やPika Labs(Pika Labs, 2023)のような商用ツールの両方と比較する.

さらに,制御可能な生成のための既存の作品との互換性を示す.

2章:Related Work(関連研究)

テキストから画像への(Text-to-Image)拡散モデル:

テキストから画像(T2I:Text-to-Image)生成のための拡散モデル(Ho et al., 2020; Dhariwal & Nichol, 2021; Song et al., 2020)は,最近,学術界と非学術界の両方で大きな注目を集めている(Gu et al., 2022; Mokady et al., 2023; Podell et al., 2023; Ding et al., 2021; Zhou et al., 2022b; Ramesh et al., 2021; Li et al., 2022).

GLIDE(Nichol et al., 2021)は,テキスト条件を導入し,分類器ガイダンスを組み込むことで,より好ましい結果が得られることを実証した.

DALL-E2(Ramesh et al., 2022)は,CLIP(Radford et al., 2021)の結合特徴空間を活用することで,テキストと画像のアライメントを改善する.

Imagen(Saharia et al., 2022)は,大規模言語モデル(Raffel et al., 2020)とカスケードアーキテクチャを組み込んで,フォトリアリスティックな結果を実現する.

Stable Diffusionとしても知られるLatent Diffusion Model(Rombach et al., 2022)は,拡散プロセスをオートエンコーダの潜在空間に移動して効率を高める.

eDiff-I(Balaji et al., 2022)は,異なる生成段階に特化した拡散モデルのアンサンブルを採用している.

T2Iモデルのパーソナライズ:

事前訓練されたT2Iでの作成を容易にするために,多くの研究が効率的なモデルのパーソナライゼーション(Shi et al., 2023; Lu et al., 2023; Dong et al., 2022; Kumari et al., 2023),すなわち参照画像を用いてベースT2Iに概念やスタイルを導入することに焦点を当てている.

これを達成するための最も簡単なアプローチは,モデルの完全なファインチューニングである.

全体的な品質を大幅に向上させる可能性があるにもかかわらず,参照画像セットが小さい場合,この方法は破滅的忘却につながる可能性がある(Kirkpatrick et al., 2017; French, 1999).

その代わりに,DreamBooth(Ruiz et al., 2023)は保存性を損なわずにネットワーク全体をファインチューニングし,数枚の画像のみを使用する.

Textual Inversion(Gal et al., 2022)は,新しい概念ごとにトークン埋め込みを最適化する.

Low-Rank Adaptation (LoRA)(Hu et al., 2021)は,ベースとなるT2IにLoRA層を追加導入し,重み残差のみを最適化することで,上記のファインチューニングプロセスを容易にする.

パーソナライゼーション問題に対処するエンコーダーベースのアプローチもある(Gal et al., 2023; Jia et al., 2023).

我々の研究では,全体的なファインチューニング,DreamBooth(Ruiz et al., 2023),LoRA(Hu et al., 2021)を含むチューニングベースの手法に注目する.

これらはベースとなるT2Iの元の特徴空間を保持するためである.

パーソナライズされたT2Iのアニメーション:

パーソナライズされたT2Iのアニメーション化に関する既存の研究は多くない.

Text2Cinemagraph(Mahapatra et al., 2023)は,フロー予測によってシネマトグラフを生成することを提案している.

動画生成の分野では,事前訓練されたT2Iを時間構造で拡張することが一般的である.

既存の研究(Esser et al., 2023; Zhou et al., 2022a; Singer et al., 2022; Ho et al., 2022b,a; Ruan et al., 2023; Luo et al., 2023; Yin et al., 2023b,a; Wang et al., 2023b; Hong et al., 2022; Luo et al., 2023)は,ほとんどの場合,全てのパラメータを更新し,オリジナルのT2Iの特徴空間を変更するものであり,パーソナライズされたものとは互換性がない.

Align-Your-Latents(Blattmann et al., 2023)は,一般的な動画生成の凍結画像層をパーソナライズできることを示している.

最近,パーソナライズされたT2Iモデルのアニメーションにおいて,いくつかの動画生成アプローチが有望な結果を示している.

Tune-a-Video(Wu et al., 2023)は,1つの動画上で少数のパラメータをファインチューニングする.

Text2Video-Zero(Khachatryan et al., 2023)は,事前訓練されたT2Iを,事前定義されたアフィン行列に基づく潜在的なラッピングによってアニメーション化する,訓練不要の手法を導入している.

3章:Preliminary(予備)

ここでは,AnimateDiffのドメインアダプタ(4.1節)とMotionLoRA(4.3節)の理解に役立つ,我々の研究で使用されているT2Iの基本モデルであるStable Diffusion(Rombach et al., 2022)とLow-Rank Adaptation(LoRA)(Hu et al., 2021)の予備知識を紹介する.

Stable Diffusion:

本論文では,オープンソースであり,評価のための多くの高品質なパーソナライズドT2Iモデルを持つコミュニティが発達していることから,ベースとなるT2IモデルとしてStable Diffusion(SD)を選択した.

SDは,事前訓練されたオートエンコーダ\(\mathcal{E(\cdot)}\)と\(\mathcal{D(\cdot)}\)の潜在空間内で拡散処理を行う.

訓練では,符号化された画像\(\mathcal{z}_0 = \mathcal{E}(x_0)\)はフォワード拡散によって\(z_t\)に摂動される.

$$ \mathcal{z}_t = \sqrt{\bar{\alpha}_t}z_0 + \sqrt{1 - \bar{\alpha}_t} \epsilon,\ \ \ \epsilon \sim \mathcal{N}(0, I) \tag{1} $$

\(t = 1,…,T\)において,ここで予め定義された,\(\bar{\alpha}_t\)はステップtにおけるノイズ強度を決定する.

ノイズ除去ネットワーク\(\epsilon \Theta(\cdot)\)は,MSE損失によって励まされながら,追加されたノイズを予測することによって,このプロセスを逆転させることを学習する.

$$ \mathcal{L} = \mathbb{E}_{\mathcal{E}(x_0), y, \epsilon \sim \mathcal{N}(0, I), t}\ \ \ [||\epsilon - \epsilon_\theta(z_t, t, \tau_\theta (y)) ||_2^2] \tag{2} $$

ここで,yはx0に対応するテキストプロンプトであり,\(\tau_\Theta(\cdot)\)はプロンプトをベクトル列にマッピングするテキストエンコーダである.

SDでは,\(\epsilon \Theta(\cdot)\)は4つの解像度レベルのダウン/アップサンプルブロックのペアと中間ブロックからなるUNet(Ronneberger et al., 2015)として実装される.

各ネットワークブロックは,ResNet(He et al., 2016),空間的Self-Attention層,およびテキスト条件を導入するCross-Attention層で構成される.

Low-Rank Adaptation(LoRA):

LoRA(Hu et al., 2021)は大規模モデルのファインチューニングを加速するアプローチであり,言語モデル適応のために初めて提案された.

全てのモデルパラメータを再訓練する代わりに,LoRAはランク分解行列のペアを追加し,これらの新しく導入された重みのみを最適化する.

訓練可能なパラメータを制限し,元の重みを凍結しておくことで,LoRAは破滅的忘却を起こしにくくなる(Kirkpatrick et al., 2017).

具体的には,ランク分解行列は,事前訓練されたモデル重み\(\mathcal{W} \in \mathbb{R}^{m*n}\)の残差として機能する.

LoRAを用いた新しいモデル重みは以下である.

$$ \mathcal{W}' = \mathcal{W} + \Delta \mathcal{W} = \mathcal{W} + AB^T $$

ここで,\(A \in \mathbb{R}^{m * r}\),\(B \in \mathbb{R}^{n * r}\)はランク分解行列のペアであり,rはハイパーパラメータで,LoRA層のランクと呼ばれる.

実際には,LoRAはAttention層にのみ適用され,モデルのファインチューニングのためのコストとストレージをさらに削減する.

4章:AnimateDiff

我々の手法の中核は,動画データから伝達可能な事前知識を学習することである.

これは,特にチューニングすることなく,パーソナライズされたT2Iに適用することができる.

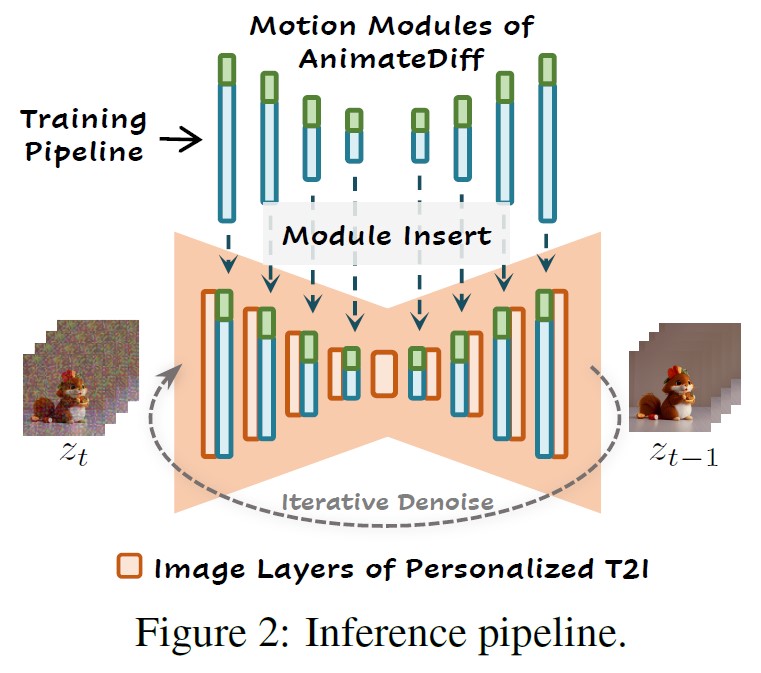

図2に示すように,推論時に,我々のモーションモジュール(青)とオプションのMotionLoRA(緑)をパーソナライズドT2Iに直接挿入し,アニメーションジェネレータを構成することができる.

その後,反復的なノイズ除去処理によってアニメーションが生成される.

これは,AnimateDiffの3つのコンポーネント,すなわち,ドメインアダプタ,モーションモジュール,MotionLoRAを訓練することにより達成される.

4.1節のドメインアダプタは,T2Iの事前訓練データと我々の動画訓練データ間の視覚分布のギャップによる悪影響を軽減するためにのみ使用される.

4.2節のモーションモジュールは,事前知識を学習するためのものである.

そして,4.3節のMotionLoRAは,一般的なアニメーションの場合はオプションであるが,事前訓練されたモーションモジュールを新しいモーションパターンに適応させるためのものである.

4.4節では,AnimateDiffの訓練(図3)と推論について詳しく説明する.

4.1節:Alleviate Negative Effects from Training Data with Domain Adapter(ドメインアダプタで訓練データからの悪影響を軽減)

収集が困難なため,一般に公開されている動画訓練データセットの視覚的品質は,画像データセットよりもはるかに低い.

例えば,動画データセットWebVid(Bain et al., 2021)のコンテンツは,ほとんどが実世界の録画であるのに対し,画像データセットLAION-Aesthetic(Schuhmann et al., 2022)には,芸術的な絵画やプロの写真など,より質の高いコンテンツが含まれている.

さらに,画像として個別に扱う場合,各動画フレームには事前知識,圧縮アーチファクト,透かしが含まれる可能性がある.

そのため,ベースとなるT2Iの訓練に用いる高品質な画像データセットと,事前知識の学習に用いるターゲット動画データセットの間には,無視できない品質領域のギャップが存在する.

このようなギャップは,生の動画データで直接訓練した場合,アニメーション生成パイプラインの品質を制限する可能性があると我々は主張する.

モーションモジュールの一部としてこの品質の不一致を学習することを避け,ベースとなるT2Iの知識を保持するために,我々はドメインアダプタと呼ばれる別のネットワークにドメイン情報を適合させることを提案する.

我々は推論時にドメインアダプタを削除し,この方法が上述のドメインギャップによる悪影響を軽減するのに役立つことを示す.

図3に示すように,LoRA(Hu et al., 2021)を用いてドメインアダプタ層を実装し,ベースT2IのSelf-/Cross-Attention層に挿入する.

クエリー(Q)射影を例とする.

射影後の内部特徴zは次のようになる.

$$ Q = \mathcal {W}^Qz + \text {AdapterLayer}(z) = \mathcal {W}^Qz + \alpha \cdot AB^Tz \tag{3} $$

ここで,\(\alpha = 1\)はスカラーであり,推論時に他の値に調整することができる(ドメインアダプタの影響を完全に取り除くには0に設定する).

次に,式(2)と同じ目的で,動画データセットからランダムにサンプリングした静的フレームに対して,ドメインアダプタのパラメータのみを最適化する.

4.2節:Learn Motion Priors with Motion Module(モーションモジュールで事前知識を学習)

事前訓練されたT2Iの上に,時間軸に沿った運動ダイナミクスをモデル化するためには,(1)3次元動画データを扱うために2次元拡散モデルを膨らませ,(2)時間軸に沿った効率的な情報交換を可能にするサブモジュールを設計しなければならない.

ネットワークの拡大:

ベースとなるT2Iモデルの事前訓練された画像層は,高品質な事前コンテンツをキャプチャしている.

この知識を活用するために,ネットワークインフレーションの望ましい方法は,これらの画像層に独立して動画フレームを扱わせることである.

これを実現するために,最近の研究(Ho et al., 2022b; Wu et al., 2023; Blattmann et al., 2023)と同様の方法を採用し,5次元動画テンソル\(x \in \mathbb{R}^{b*c*f*h*w}\)を入力とするようにモデルを修正する.

ここで,bとfはそれぞれバッチ軸とフレーム時間軸を表す.

内部特徴マップが画像層を通過するとき,時間軸fはb軸に再形成されることで無視され,ネットワークが各フレームを独立に処理できるようにする.

そして,画像層の後で特徴マップを5次元テンソルに再形成する.

一方,新しく挿入された動きモジュールは,h,wをb軸にリシェイプすることで空間軸を無視し,モジュールの後でリシェイプし直す.

モジュールの設計:

動画生成に関する最近の研究では,時間的モデリングのための多くの設計が検討されている.

AnimateDiffでは,モーションモジュールの設計としてTransformer(Vaswani et al., 2017)アーキテクチャを採用し,それを時間軸に沿って動作するように適合させるために若干の修正を加える.

これを,以下の章では「Temporal Transformer」と呼ぶ.

我々は,この設計が運動プリオールをモデル化するのに適切であることを実験的に発見した.

図3に示すように,Temporal Transformerは,アニメーションの各フレームの位置をエンコードするための正弦波位置エンコードと,時間軸に沿ったいくつかのSelf-Attentionブロックから構成される.

上述したように,動きモジュールの入力は,空間次元がバッチ軸にマージされたリシェイプされた特徴マップである.

リシェイプされた特徴マップを時間軸に沿って分割すると,長さがfのベクトル列,すなわち\(\{z_1, …, z_f; z_i \in \mathbb{R}^{(b*h*w)*c}\}\)とみなすことができる.

ベクトルは投影され,いくつかのSelf-Attentionブロックを通過する.

$$ z_{out} = \text {Attention}(Q,K,V)=\text {Softmax}(QK^T / \sqrt{c})\cdot V $$

ここで,\(Q = W^Q z\),\(K = W^K z\),\(V = W^V z\)は3つの分離された投影である.

Attentionメカニズムは,現在のフレームの生成に他のフレームからの情報を取り込むことを可能にする.

その結果,各フレームを個別に生成する代わりに,モーションモジュールで膨らませたT2Iモデルは,時間経過に伴う視覚コンテンツの変化を捉えるように学習する.

これはアニメーションクリップのモーションダイナミクスを構成する.

Self-Attentionの前に追加される正弦波位置エンコーディングが不可欠であることに注意されたい.

そうでなければ,モジュールはアニメーションのフレーム順序を認識できない.

追加モジュールがもたらすかもしれない有害な影響を避けるために,我々はTemporal Transformerの出力投影層をゼロ初期化し(Zhang et al., 2023),モーションモジュールが訓練開始時に同一性マッピングとなるように残余接続を追加する.

4.3節:Adapt To New Motion Patterns with MotionLoRA(MotionLoRAで新しいモーションパターンに適応する)

事前訓練されたモーションモジュールは,一般的な事前知識をキャプチャするが,カメラのズーム,パン,ローリングなどの新しいモーションパターンに効果的に適応させる必要がある場合,少数の参照動画と訓練の繰り返しで問題が発生する.

このような効率性は,高価な事前訓練のコストはかけられないが,特定のエフェクトのためにモーションモジュールをファインチューニングしたいユーザにとって不可欠である.

AnimateDiffの最後の段階は,MotionLoRA(図3)とも呼ばれ,モーションのパーソナライゼーション(Motion Personalization)のための効率的なファインチューニングアプローチである.

モーションモジュールのアーキテクチャと,限られた数の参照動画を考慮し,4.2節で説明した膨張モデルのモーションモジュールのSelf-Attention層にLoRA層を追加し,新しいモーションパターンの参照動画でこれらのLoRA層を訓練する.

いくつかのショットタイプを実験し,ルールに基づいたデータ拡張によって参照動画を得る.

例えば,ズーム効果を持つ動画を得るために,時間軸に沿って動画フレームの切り出し領域を徐々に縮小(ズームイン)または拡大(ズームアウト)することで動画を拡張する.

我々のMotionLoRAは,20〜50の参照動画,2,000回の学習反復(約1〜2時間),約30Mのストレージ容量でも有望な結果を達成できることを実証し,効率的なモデルチューニングとユーザ間の共有を可能にする.

低ランクの特性により,MotionLoRAには合成機能もある.

すなわち,個別に訓練されたMotionLoRAモデルを組み合わせることで,推論時に合成されたモーション効果を得ることができる.

4.4節:AnimateDiff in Practice

ここでは訓練と推論について詳しく説明し,詳細な構成は補足資料に掲載する.

※訳注:補足資料は,https://github.com/guoyww/AnimateDiffにあります.

訓練:

図3に示すように,AnimateDiffは,伝達可能な事前知識を学習するための3つの訓練可能なコンポーネントモジュールで構成されている.

それぞれの訓練目的関数は若干異なる.

ドメインアダプタは,式(2)のようなオリジナルの目的関数で訓練される.

アニメーションジェネレータの一部であるモーションモジュールとMotionLoRAは,より高次元の動画データに対応するために若干の修正を加えた同様の目的関数を使用する.

具体的には,動画データバッチ\(x_0^{1:f} \in \mathbb{R}^{b*c*f*h*w}\)は,まずSDの事前訓練されたオートエンコーダを介して,潜在コード\(z_0^{1:f}\)にフレーム単位でエンコードされる.

次に,潜在符号は,式(1)のように定義された順拡散スケジュールを用いて雑音化される.

$$ z_t^{1:f} = \sqrt{\bar{\alpha}_t} z_0^{1:f} + \sqrt{1 - \bar{\alpha}_t} \epsilon^{1:f} $$

膨張したモデルは,ノイズの入った潜在コードと対応するテキストプロンプトを入力し,追加されたノイズを予測する.

我々のモーションモデリングモジュールの最終的な訓練目的関数は以下の通りである.

$$ \mathcal{L} = \mathbb{E}_{\mathcal{E} (x_0^{1:f}), y, \epsilon^{1:f} \sim \mathcal{N}(0, I), t} \left[ || \epsilon - \epsilon_\theta (z_t^{1:f}, t, \tau_\theta (y))||_2^2 \right] $$

ドメインアダプタ,モーションモジュール,MotionLoRAを訓練する際,訓練可能な部分以外のパラメータは凍結したままであることは注目に値する.

推論:

推論時(図2)には,パーソナライズドT2Iモデルは,まず4.2節で説明したのと同じ方法で膨張され,一般的なアニメーション生成のためのモーションモジュールと,パーソナライズされたモーションを持つアニメーションを生成するためのオプションのMotionLoRAが注入される.

ドメインアダプタについては,推論時に単純に削除するのではなく,実際にはパーソナライズドT2Iモデルに注入し,式(3)のスケーラ\(\alpha\)を変更することで寄与を調整することもできる.

\(\alpha\)の値に関するアブレーション研究が実験で実施されている.

最後に,逆拡散処理を行い,潜在符号を復号することで,アニメーションフレームを得ることができる.

5章:EXPERIMENTS(実験)

Stable Diffusion V1.5を用いてAnimateDiffを実装し,WebVid-10M(Bain et al., 2021)データセットを用いてモーションモジュールを訓練する.

詳細な設定は補足資料にある.

※訳注:補足資料は,https://github.com/guoyww/AnimateDiffにあります.

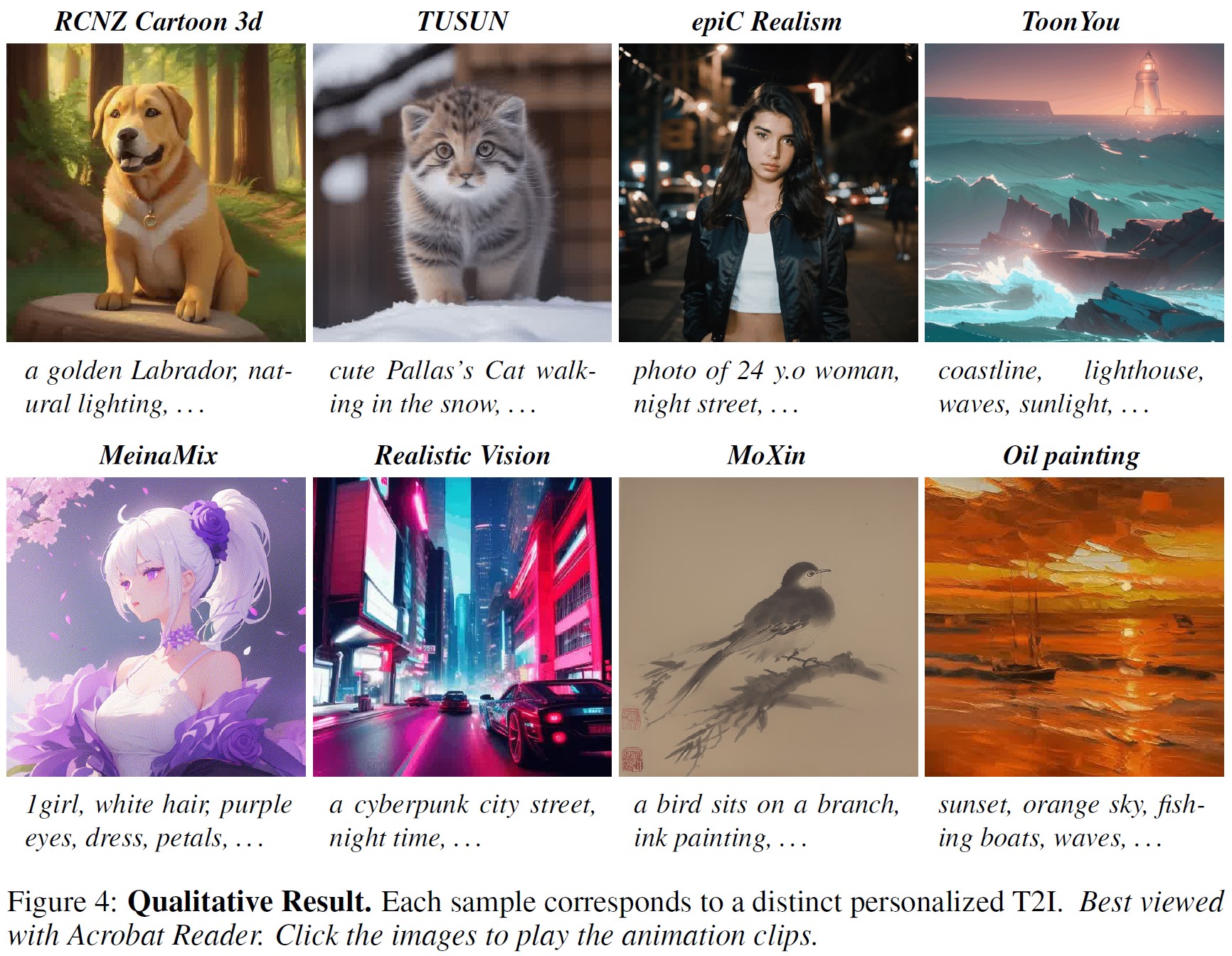

5.1節:Qualitative Results(定性的結果)

※訳注:原文で図4のアニメーションを観ましょう!

コミュニティモデルでの評価:

Civitai(Civitai, 2022)から収集された代表的なパーソナライズドT2Iの多様なセットを用いて,AnimateDiffを評価した.

これらのパーソナライズドT2Iは幅広いドメインを網羅しており,包括的なベンチマークとして機能する.

これらのT2Iに含まれるパーソナライズドドメインは,特定の「トリガーワード」にのみ反応するため,一般的なテキストプロンプトの使用は避け,評価プロンプトを構築するためにモデルホームページを参照する.

図4に,AnimateDiffの8つの定性的結果を示す.

各サンプルは,個別のパーソナライズされたT2Iに対応している.

図1の2行目では,AnimateDiffとMotionLoRAを統合し,ショットタイプの制御を実現した結果を示している.

最後の2つのサンプルは,MotionLoRAの合成能力を示しており,個別に訓練された重みを線形に結合することによって達成される.

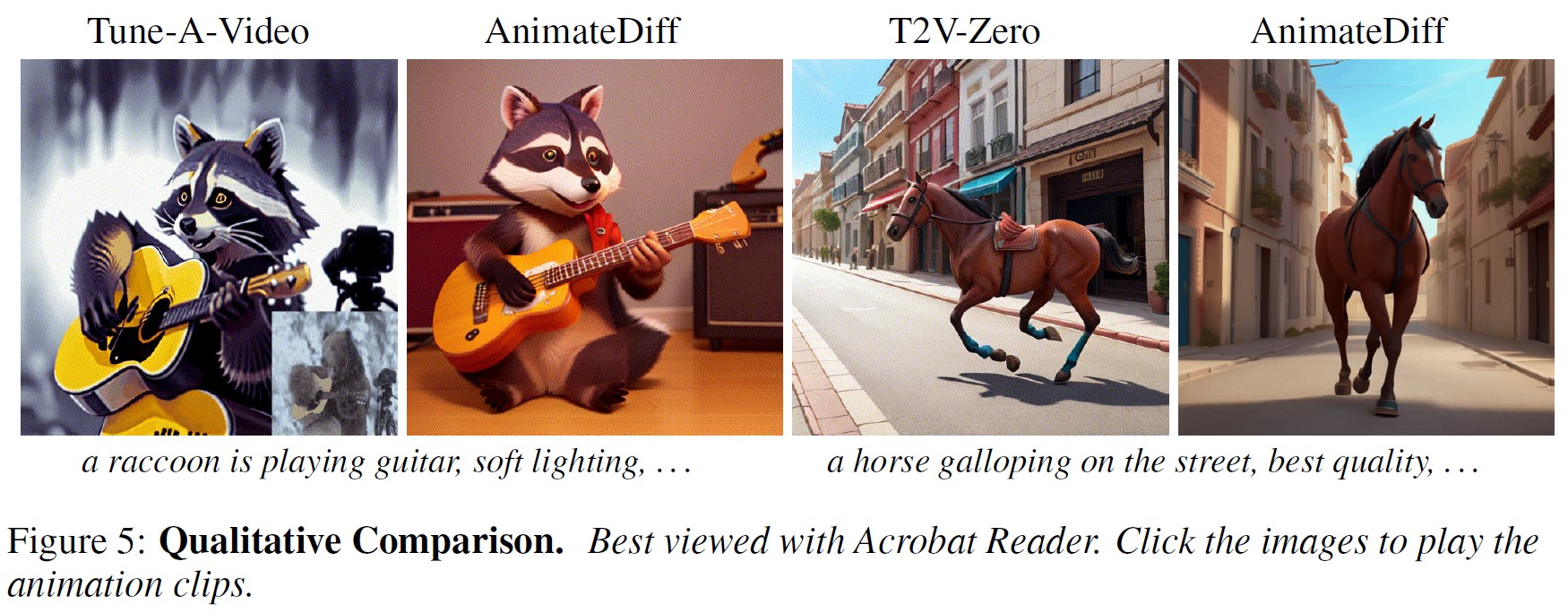

※訳注:原文で図5のアニメーションを観ましょう!

ベースラインとの比較:

パーソナライズされたT2Iをアニメーション化するために特別に設計された既存の方法がないため,このタスクに適応可能な動画生成の2つの最近の作品と我々の方法を比較する.

(1)Text2Video-Zero(Khachatryan et al., 2023)と(2)Tune-a-Video(Wu et al., 2023)である.

また,AnimateDiffを2つの商用ツールと比較する.

(3)Gen-2(Gen-2, 2023)はテキストから動画生成,(4)Pika Labs(Pika Labs, 2023)は画像アニメーションである.

結果を図5に示す.

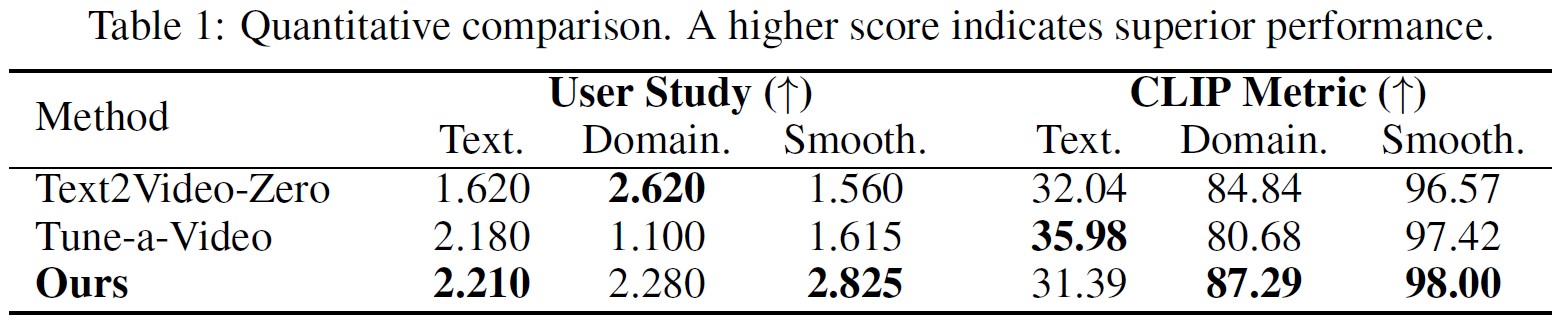

5.2節:Quantitative Comparison(定量的比較)

我々は,ユーザ調査とCLIPメトリクスを通して定量的な比較を行う.

比較は3つの主要な側面(テキストの整列,ドメインの類似性,動きの滑らかさ)に焦点を当てている.

結果を表1に示す.

詳細な実装は補足資料にある.

※訳注:補足資料は,https://github.com/guoyww/AnimateDiffにあります.

ユーザ調査:

ユーザ調査では,同じパーソナライズされたT2Iモデルに基づいて,3つの方法すべてを用いてアニメーションを生成する.

その後,参加者は,上記の3つの側面に基づいて,結果を個々にランク付けするよう求められる.

ここでは,平均ユーザランキング(AUR:Average User Ranking)を嗜好性の指標として使用し,スコアが高いほど優れたパフォーマンスであることを示す.

対応するプロンプトと画像は,テキストアライメントとドメイン類似性評価の参考のために提供されていることに注意されたい.

CLIP指標:

また,先行研究(Wu et al., 2023; Khachatryan et al., 2023)のアプローチに従い,CLIP(Radford et al., 2021)指標を採用した.

領域の類似性を評価する際,CLIPスコアはアニメーションフレームとパーソナライズされたT2Iを使用して生成された参照画像との間で計算されたことに注意することが重要である.

5.3節:Ablative Study(アブレーション研究)

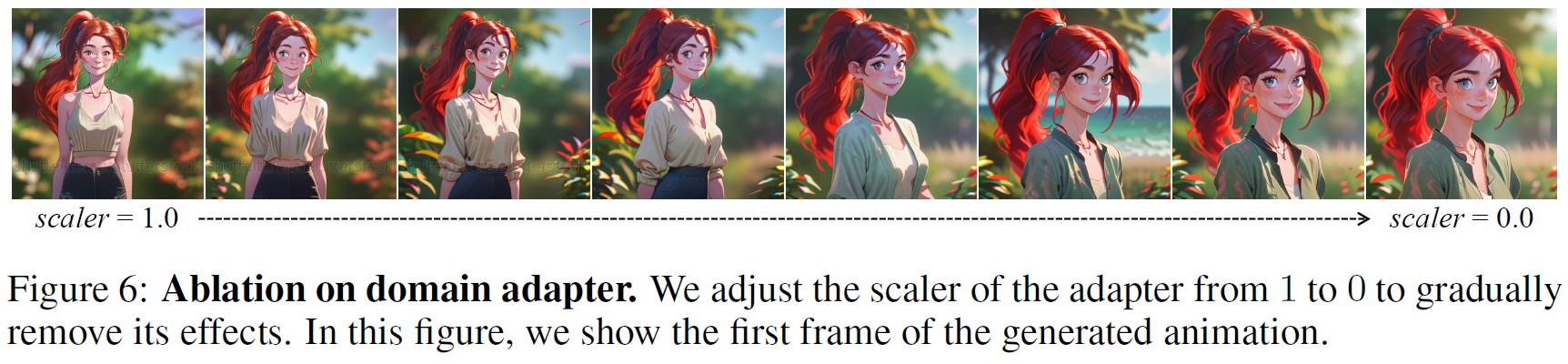

ドメインアダプタ:

AnimateDiffにおけるドメインアダプタの影響を調査するため,推論中にアダプタ層のスケーラーを1(完全な影響)から0(完全な除去)の範囲で調整する調査を実施した.

図6に示すように,アダプタのスケーラーが小さくなるにつれて,全体的な視覚的品質の向上が見られ,動画データセットから学習された視覚的コンテンツ分布(WebVidの場合は透かし(Bain et al., 2021))の減少が伴う.

これらの結果は,モーションモジュールが視覚的分布ギャップの学習から解放されることにより,AnimateDiffの視覚的品質を向上させる上で,ドメインアダプタの役割が成功していることを示している.

モーションモジュールの設計:

Temporal Transformerのモーションモジュールの設計を,その完全な畳み込みと比較する.

これは,両方の設計が動画生成に関する最近の研究で広く採用されているという事実が動機となっている.

我々はTemporal Attentionを1次元時間的畳み込みに置き換え,2つのモデルパラメータが密接に整合していることを確認した.

補足資料に描かれているように,畳み込み動きモジュールは全てのフレームを同一に揃えるが,Transformerアーキテクチャと比較すると,動きを取り込まない.

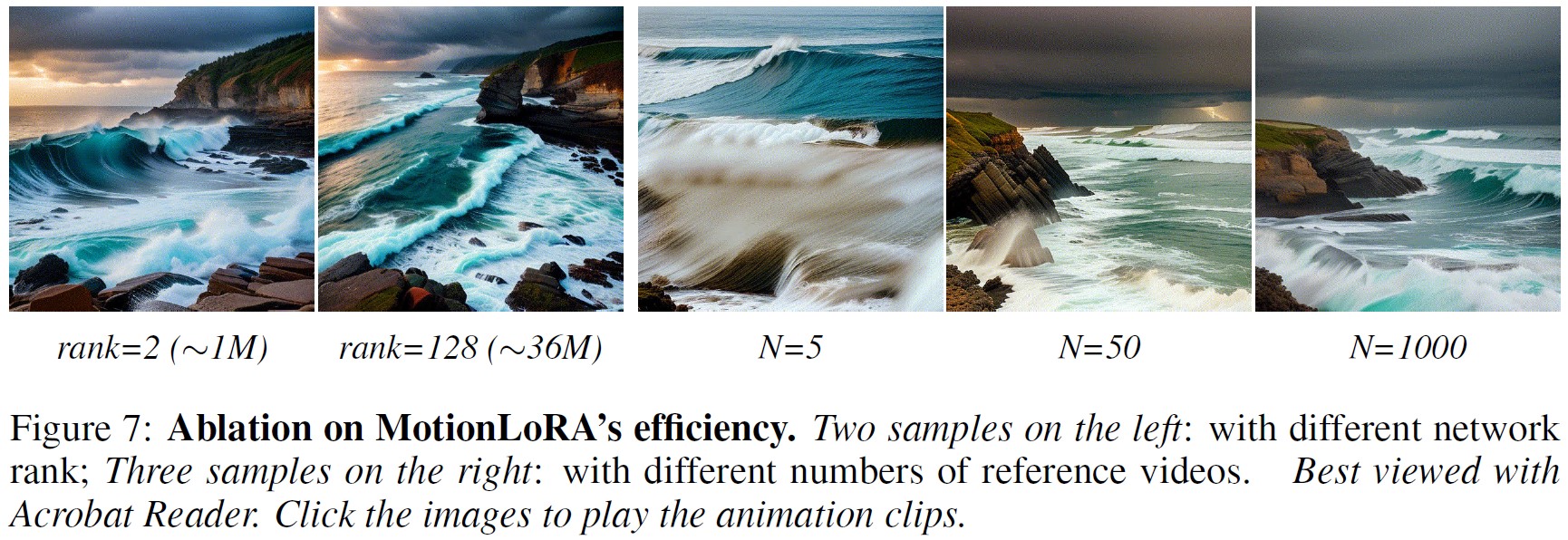

MotionLoRAの効率:

AnimateDiffにおけるMotionLoRAの効率性は,パラメータ効率性とデータ効率性の観点から検証された.

パラメータ効率は,効率的なモデル訓練とユーザ間での共有に不可欠である.

データ効率は,特定のモーションパターンについて十分な数の参照動画を収集することが困難な実世界のアプリケーションに不可欠である.

※訳注:原文で図7のアニメーションを観ましょう!

これらの側面を調査するために,パラメータスケールと参照動画量を変化させて複数のMotionLoRAモデルを訓練した.

図7において,最初の2つのサンプルは,MotionLoRAが同等のモーション品質を維持しながら,小さなパラメータスケールで新しいカメラモーション(ズームインなど)を学習できることを示している.

さらに,参照動画の数が少ない場合(例えば,N = 50)でも,このモデルは所望のモーションパターンを学習することに成功している.

しかしながら,参照動画の数が過度に制限された場合(例えば,N = 5),品質の著しい劣化が観察され,これは,MotionLoRAが共有モーションパターンの学習で困難に遭遇し,代わりに参照動画からテクスチャ情報をキャプチャすることに依存していることを示唆している.

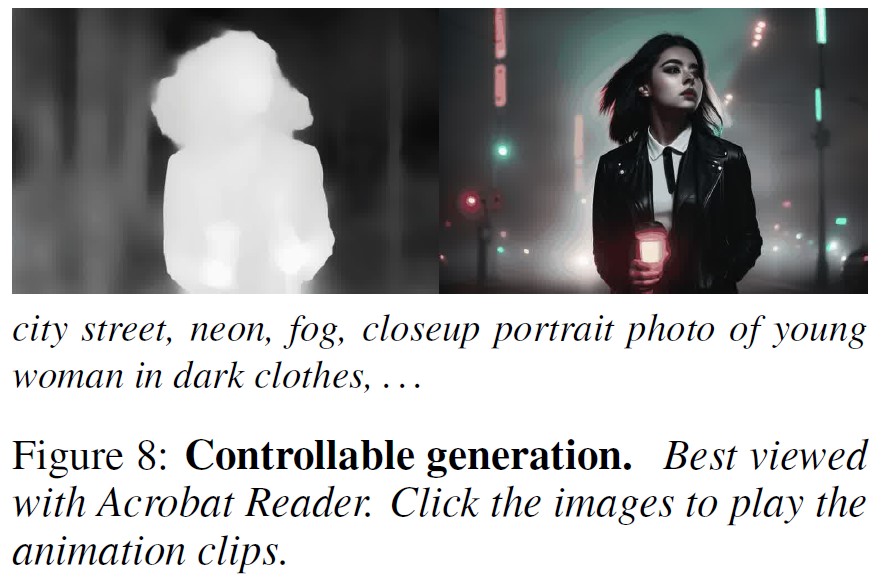

5.4節:Controllable Generation(制御可能な生成)

※訳注:原文で図8のアニメーションを観ましょう!

AnimateDiffにおける視覚コンテンツと事前知識の分離学習は,制御可能な生成のために,既存のコンテンツ制御アプローチを直接適用することを可能にする.

この能力を実証するため,AnimateDiffとControlNet(Zhang et al., 2023)を組み合わせ,抽出された深度マップシーケンスで生成を制御した.

DDIM(Song et al., 2020)反転を採用して平滑化された潜在シーケンスを得る最近の動画編集技術(Ceylan et al., 2023; Wang et al., 2023a)とは対照的に,我々はランダムにサンプリングされたノイズからアニメーションを生成する.

図8に示すように,我々の結果は,(髪や顔の表情などの)詳細な動きと高い視覚的品質を示す.

6章:Conclusion(結論)

本論文では,AnimateDiffを紹介する.

AnimateDiffは,アニメーション生成のためのT2Iモデルを,品質を損なうことなく,また事前に学習されたドメイン知識を失うことなく,一度きりで作成する実用的なパイプラインである.

これを達成するために,我々はAnimateDiffの3つのコンポーネントモジュールを設計し,視覚的な品質劣化を緩和しながら,意味のある事前知識を学習し,MotionLoRAと名付けられた軽量なファインチューニング技術により,モーションのパーソナライズを可能にする.

一度訓練されたモーションモジュールは,他のパーソナライズされたT2Iに統合することができ,パーソナライズされた領域に忠実でありながら,自然で首尾一貫したモーションを持つアニメーション画像を生成することができる.

また,様々なパーソナライズドT2Iモデルを用いた広範な評価により,我々のAnimateDiffとMotionLoRAの有効性と汎用性が検証された.

さらに,既存のコンテンツ制御アプローチと本手法の互換性を実証し,追加の訓練コストを発生させることなく制御可能な生成を可能にしている.

全体として,AnimateDiffは,パーソナライズされたアニメーションのための効果的なベースラインを提供し,幅広いアプリケーションのための大きな可能性を秘めている.

7章:Ethics Statement(倫理声明)

我々は,個人を傷つけたり,誤情報を広めたりするコンテンツを作成するために,生成AIが悪用されることを強く非難する.

しかしながら,我々の手法は主にアニメーションに焦点を当て,人間に関連するコンテンツを生成することができるため,悪用される可能性があることを認める.

また,我々の手法が,他のアーティストによって開発されたパーソナライズされたテキストから画像へのモデルを組み込んでいることを強調することも重要である.

これらのモデルには不適切なコンテンツが含まれている可能性があり,我々の手法で使用することができる.

このような懸念に対処するため,我々は,法的枠組みの遵守,プライバシーの権利の尊重,ポジティブなコンテンツの生成の奨励など,研究において最高の倫理基準を支持している.

さらに,Stable Diffusion(Rombach et al., 2022)と同様の追加的なコンテンツ安全性チェッカーを導入することで,この問題を解決できる可能性があると考えている.

8章:Reproducibility Statement(再現性の声明)

本アプローチの再現性を高めることを目的として,本手法の学習と推論に関する包括的な実装の詳細を補足資料として提供する.

また,さらなる調査と探求を容易にするために,コードと事前訓練された重みの両方をオープンソースにしている.

※訳注:補足資料やソースコードは,https://github.com/guoyww/AnimateDiffにあります.

References(参考文献)

- (Bain et al., 2021) Max Bain, Arsha Nagrani, G¨ul Varol, and Andrew Zisserman. Frozen in time: A joint video and image encoder for end-to-end retrieval. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pp. 1728–1738, 2021.

- (Balaji et al., 2022) Yogesh Balaji, Seungjun Nah, Xun Huang, Arash Vahdat, Jiaming Song, Karsten Kreis, Miika Aittala, Timo Aila, Samuli Laine, Bryan Catanzaro, et al. ediffi: Text-to-image diffusion models with an ensemble of expert denoisers. arXiv preprint arXiv:2211.01324, 2022.

- (Blattmann et al., 2023) Andreas Blattmann, Robin Rombach, Huan Ling, Tim Dockhorn, Seung Wook Kim, Sanja Fidler, and Karsten Kreis. Align your latents: High-resolution video synthesis with latent diffusion models. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 22563–22575, 2023.

- (Ceylan et al., 2023) Duygu Ceylan, Chun-Hao Paul Huang, and Niloy J Mitra. Pix2video: Video editing using image diffusion. arXiv preprint arXiv:2303.12688, 2023.

- (Civitai, 2022) Civitai. Civitai. https://civitai.com/, 2022.

- (Dhariwal & Nichol, 2021) Prafulla Dhariwal and Alexander Nichol. Diffusion models beat gans on image synthesis. Advances in Neural Information Processing Systems, 34:8780–8794, 2021.

- (Ding et al., 2021) Ming Ding, Zhuoyi Yang, Wenyi Hong, Wendi Zheng, Chang Zhou, Da Yin, Junyang Lin, Xu Zou, Zhou Shao, Hongxia Yang, et al. Cogview: Mastering text-to-image generation via transformers. Advances in Neural Information Processing Systems, 34:19822–19835, 2021.

- (Dong et al., 2022) Ziyi Dong, Pengxu Wei, and Liang Lin. Dreamartist: Towards controllable one-shot text-to-image generation via contrastive prompt-tuning. arXiv preprint arXiv:2211.11337, 2022.

- (Esser et al., 2023) Patrick Esser, Johnathan Chiu, Parmida Atighehchian, Jonathan Granskog, and Anastasis Germanidis. Structure and content-guided video synthesis with diffusion models. arXiv preprint arXiv:2302.03011, 2023.

- (French, 1999) Robert M French. Catastrophic forgetting in connectionist networks. Trends in cognitive sciences, 3(4):128–135, 1999.

- (Gal et al., 2022) Rinon Gal, Yuval Alaluf, Yuval Atzmon, Or Patashnik, Amit H Bermano, Gal Chechik, and Daniel Cohen-Or. An image is worth one word: Personalizing text-to-image generation using textual inversion. arXiv preprint arXiv:2208.01618, 2022.

- (Gal et al., 2023) Rinon Gal, Moab Arar, Yuval Atzmon, Amit H Bermano, Gal Chechik, and Daniel Cohen- Or. Designing an encoder for fast personalization of text-to-image models. arXiv preprint arXiv:2302.12228, 2023.

- (Gen-2, 2023) Gen-2. Gen-2: The next step forward for generative ai. https://research.runwayml.com/gen2/, 2023.

- (Gu et al., 2022) Shuyang Gu, Dong Chen, Jianmin Bao, Fang Wen, Bo Zhang, Dongdong Chen, Lu Yuan, and Baining Guo. Vector quantized diffusion model for text-to-image synthesis. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 10696–10706, 2022.

- (He et al., 2016) Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 770–778, 2016.

- (Ho et al., 2020) Jonathan Ho, Ajay Jain, and Pieter Abbeel. Denoising diffusion probabilistic models. Advances in Neural Information Processing Systems, 33:6840–6851, 2020.

- (Ho et al., 2022a) Jonathan Ho, William Chan, Chitwan Saharia, Jay Whang, Ruiqi Gao, Alexey Gritsenko, Diederik P Kingma, Ben Poole, Mohammad Norouzi, David J Fleet, et al. Imagen video: High definition video generation with diffusion models. arXiv preprint arXiv:2210.02303, 2022a.

- (Ho et al., 2022b) Jonathan Ho, Tim Salimans, Alexey Gritsenko, William Chan, Mohammad Norouzi, and David J Fleet. Video diffusion models. arXiv preprint arXiv:2204.03458, 2022b.

- (Hong et al., 2022) Wenyi Hong, Ming Ding, Wendi Zheng, Xinghan Liu, and Jie Tang. Cogvideo: Large-scale pretraining for text-to-video generation via transformers. arXiv preprint arXiv:2205.15868, 2022.

- (Hu et al., 2021) Edward J Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, and Weizhu Chen. Lora: Low-rank adaptation of large language models. arXiv preprint arXiv:2106.09685, 2021.

- (Hugging Face, 2022) Hugging Face. Huggingface. https://huggingface.co/, 2022.

- (Jia et al., 2023) Xuhui Jia, Yang Zhao, Kelvin CK Chan, Yandong Li, Han Zhang, Boqing Gong, Tingbo Hou, Huisheng Wang, and Yu-Chuan Su. Taming encoder for zero fine-tuning image customization with text-to-image diffusion models. arXiv preprint arXiv:2304.02642, 2023.

- (Khachatryan et al., 2023) Levon Khachatryan, Andranik Movsisyan, Vahram Tadevosyan, Roberto Henschel, Zhangyang Wang, Shant Navasardyan, and Humphrey Shi. Text2video-zero: Text-to-image diffusion models are zero-shot video generators. IEEE International Conference on Computer Vision (ICCV), 2023.

- (Kirkpatrick et al., 2017) James Kirkpatrick, Razvan Pascanu, Neil Rabinowitz, Joel Veness, Guillaume Desjardins, Andrei A Rusu, Kieran Milan, John Quan, Tiago Ramalho, Agnieszka Grabska-Barwinska, et al. Overcoming catastrophic forgetting in neural networks. Proceedings of the national academy of sciences, 114(13):3521–3526, 2017.

- (Kumari et al., 2023) Nupur Kumari, Bingliang Zhang, Richard Zhang, Eli Shechtman, and Jun-Yan Zhu. Multi-concept customization of text-to-image diffusion. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 1931–1941, 2023.

- (Li et al., 2022) Wei Li, Xue Xu, Xinyan Xiao, Jiachen Liu, Hu Yang, Guohao Li, Zhanpeng Wang, Zhifan Feng, Qiaoqiao She, Yajuan Lyu, et al. Upainting: Unified text-to-image diffusion generation with cross-modal guidance. arXiv preprint arXiv:2210.16031, 2022.

- (Lu et al., 2023) Haoming Lu, Hazarapet Tunanyan, Kai Wang, Shant Navasardyan, Zhangyang Wang, and Humphrey Shi. Specialist diffusion: Plug-and-play sample-efficient fine-tuning of text-to-image diffusion models to learn any unseen style. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 14267–14276, 2023.

- (Luo et al., 2023) Zhengxiong Luo, Dayou Chen, Yingya Zhang, Yan Huang, Liang Wang, Yujun Shen, Deli Zhao, Jingren Zhou, and Tieniu Tan. Videofusion: Decomposed diffusion models for high-quality video generation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 10209–10218, 2023.

- (Mahapatra et al., 2023) Aniruddha Mahapatra, Aliaksandr Siarohin, Hsin-Ying Lee, Sergey Tulyakov, and Jun-Yan Zhu. Text-guided synthesis of eulerian cinemagraphs, 2023.

- (Mokady et al., 2023) Ron Mokady, Amir Hertz, Kfir Aberman, Yael Pritch, and Daniel Cohen-Or. Null-text inversion for editing real images using guided diffusion models. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 6038–6047, 2023.

- (Mou et al., 2023) Chong Mou, Xintao Wang, Liangbin Xie, Jian Zhang, Zhongang Qi, Ying Shan, and Xiaohu Qie. T2i-adapter: Learning adapters to dig out more controllable ability for text-to-image diffusion models. arXiv preprint arXiv:2302.08453, 2023.

- (Nichol et al., 2021) Alex Nichol, Prafulla Dhariwal, Aditya Ramesh, Pranav Shyam, Pamela Mishkin, Bob McGrew, Ilya Sutskever, and Mark Chen. Glide: Towards photorealistic image generation and editing with text-guided diffusion models. arXiv preprint arXiv:2112.10741, 2021.

- (Pika Labs, 2023) Pika Labs. Pika labs. https://www.pika.art/, 2023.

- (Podell et al., 2023) Dustin Podell, Zion English, Kyle Lacey, Andreas Blattmann, Tim Dockhorn, Jonas M¨uller, Joe Penna, and Robin Rombach. Sdxl: improving latent diffusion models for high-resolution image synthesis. arXiv preprint arXiv:2307.01952, 2023.

- (Radford et al., 2021) Alec Radford, Jong Wook Kim, Chris Hallacy, Aditya Ramesh, Gabriel Goh, Sandhini Agarwal, Girish Sastry, Amanda Askell, Pamela Mishkin, Jack Clark, et al. Learning transferable visual models from natural language supervision. In International conference on machine learning, pp. 8748–8763. PMLR, 2021.

- (Raffel et al., 2020) Colin Raffel, Noam Shazeer, Adam Roberts, Katherine Lee, Sharan Narang, Michael Matena, Yanqi Zhou, Wei Li, and Peter J Liu. Exploring the limits of transfer learning with a unified text-to-text transformer. The Journal of Machine Learning Research, 21(1):5485–5551, 2020.

- (Ramesh et al., 2021) Aditya Ramesh, Mikhail Pavlov, Gabriel Goh, Scott Gray, Chelsea Voss, Alec Radford, Mark Chen, and Ilya Sutskever. Zero-shot text-to-image generation. In International Conference on Machine Learning, pp. 8821–8831. PMLR, 2021.

- (Ramesh et al., 2022) Aditya Ramesh, Prafulla Dhariwal, Alex Nichol, Casey Chu, and Mark Chen. Hierarchical textconditional image generation with clip latents. arXiv preprint arXiv:2204.06125, 2022.

- (Rombach et al., 2022) Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, and Bj¨orn Ommer. High-resolution image synthesis with latent diffusion models. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 10684–10695, 2022.

- (Ronneberger et al., 2015) Olaf Ronneberger, Philipp Fischer, and Thomas Brox. U-net: Convolutional networks for biomedical image segmentation, 2015.

- (Ruan et al., 2023) Ludan Ruan, Yiyang Ma, Huan Yang, Huiguo He, Bei Liu, Jianlong Fu, Nicholas Jing Yuan, Qin Jin, and Baining Guo. Mm-diffusion: Learning multi-modal diffusion models for joint audio and video generation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 10219–10228, 2023.

- (Ruiz et al., 2023) Nataniel Ruiz, Yuanzhen Li, Varun Jampani, Yael Pritch, Michael Rubinstein, and Kfir Aberman. Dreambooth: Fine tuning text-to-image diffusion models for subject-driven generation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 22500– 22510, 2023.

- (Saharia et al., 2022) Chitwan Saharia, William Chan, Saurabh Saxena, Lala Li, Jay Whang, Emily L Denton, Kamyar Ghasemipour, Raphael Gontijo Lopes, Burcu Karagol Ayan, Tim Salimans, et al. Photorealistic text-to-image diffusion models with deep language understanding. Advances in Neural Information Processing Systems, 35:36479–36494, 2022.

- (Schuhmann et al., 2022) Christoph Schuhmann, Romain Beaumont, Richard Vencu, Cade Gordon, Ross Wightman, Mehdi Cherti, Theo Coombes, Aarush Katta, Clayton Mullis, Mitchell Wortsman, et al. Laion-5b: An open large-scale dataset for training next generation image-text models. arXiv preprint arXiv:2210.08402, 2022.

- (Shi et al., 2023) Jing Shi, Wei Xiong, Zhe Lin, and Hyun Joon Jung. Instantbooth: Personalized text-to-image generation without test-time finetuning. arXiv preprint arXiv:2304.03411, 2023.

- (Singer et al., 2022) Uriel Singer, Adam Polyak, Thomas Hayes, Xi Yin, Jie An, Songyang Zhang, Qiyuan Hu, Harry Yang, Oron Ashual, Oran Gafni, et al. Make-a-video: Text-to-video generation without text-video data. arXiv preprint arXiv:2209.14792, 2022.

- (Song et al., 2020) Jiaming Song, Chenlin Meng, and Stefano Ermon. Denoising diffusion implicit models. arXiv preprint arXiv:2010.02502, 2020.

- (Vaswani et al., 2017) Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser, and Illia Polosukhin. Attention is all you need. Advances in neural information processing systems, 30, 2017.

- (Wang et al., 2023a) Wen Wang, Kangyang Xie, Zide Liu, Hao Chen, Yue Cao, XinlongWang, and Chunhua Shen. Zeroshot video editing using off-the-shelf image diffusion models. arXiv preprint arXiv:2303.17599, 2023a.

- (Wang et al., 2023b) Yaohui Wang, Xinyuan Chen, Xin Ma, Shangchen Zhou, Ziqi Huang, YiWang, Ceyuan Yang, Yinan He, Jiashuo Yu, Peiqing Yang, Yuwei Guo, Tianxing Wu, Chenyang Si, Yuming Jiang, Cunjian Chen, Chen Change Loy, Bo Dai, Dahua Lin, Yu Qiao, and Ziwei Liu. Lavie: High-quality video generation with cascaded latent diffusion models, 2023b.

- (Wu et al., 2023) Jay Zhangjie Wu, Yixiao Ge, Xintao Wang, Weixian Lei, Yuchao Gu, Wynne Hsu, Ying Shan, Xiaohu Qie, and Mike Zheng Shou. Tune-a-video: One-shot tuning of image diffusion models for text-to-video generation. IEEE International Conference on Computer Vision (ICCV), 2023.

- (Yin et al., 2023a) Shengming Yin, Chenfei Wu, Jian Liang, Jie Shi, Houqiang Li, Gong Ming, and Nan Duan. Dragnuwa: Fine-grained control in video generation by integrating text, image, and trajectory. arXiv preprint arXiv:2308.08089, 2023a.

- (Yin et al., 2023b) Shengming Yin, ChenfeiWu, Huan Yang, JianfengWang, XiaodongWang, Minheng Ni, Zhengyuan Yang, Linjie Li, Shuguang Liu, Fan Yang, et al. Nuwa-xl: Diffusion over diffusion for extremely long video generation. arXiv preprint arXiv:2303.12346, 2023b.

- (Zhang et al., 2023) Lvmin Zhang, Anyi Rao, and Maneesh Agrawala. Adding conditional control to text-to-image diffusion models. IEEE International Conference on Computer Vision (ICCV), 2023.

- (Zhou et al., 2022a) Daquan Zhou, Weimin Wang, Hanshu Yan, Weiwei Lv, Yizhe Zhu, and Jiashi Feng. Magicvideo: Efficient video generation with latent diffusion models. arXiv preprint arXiv:2211.11018, 2022a.

- (Zhou et al., 2022b) Yufan Zhou, Ruiyi Zhang, Changyou Chen, Chunyuan Li, Chris Tensmeyer, Tong Yu, Jiuxiang Gu, Jinhui Xu, and Tong Sun. Towards language-free training for text-to-image generation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 17907–17917, 2022b.

参考:AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの解説動画

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの解説動画です.

まとめ

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuningの日本語訳を紹介しました.

画像から動画を生成するAI「AnimateDiff」がわかりました.

AIのプログラミング言語「C++/Python言語」を学べるおすすめのWebサイトを知りたいあなたはこちらからどうぞ.

独学が難しいあなたは,AIを学べるオンラインプログラミングスクール3社で自分に合うスクールを見つけましょう.後悔はさせません!

国内・海外のAIエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ. こういった悩みにお答えします. こういった私が解説していきます. 国内・海外のAIエンジニアのおすすめ求人サイト(転職エージェント)を紹介します. AIエンジニアになるためには,主にC++/Pytho ... 続きを見る

国内・海外のAIエンジニアのおすすめ求人サイト【転職エージェント】【C++/Python言語】

国内・海外のプロンプトエンジニアのおすすめ求人サイトを知りたいあなたはこちらからどうぞ.